網絡謠言敏感詞庫的構建研究

夏松 林榮蓉 劉勘

摘要:[目的/意義]網絡謠言嚴重影響網絡正常信息的傳播,對網絡謠言進行識別有著重要的現實意義。筆者構建一個基于微博的網絡謠言敏感詞庫,以提高網絡謠言的識別精度。[方法/過程]針對微博類社交平臺短文本的特點,首先舍棄傳統的分詞算法,設計LBCP抽詞算法,并結合位置信息和改進的TF-IDF權重來提取敏感詞庫的種子詞集,然后通過聚類算法將種子詞的近義詞補充到詞庫中,再將常用的替代詞也加入到詞庫中,從而得到最終的敏感詞庫。[結果/結論]利用敏感詞特征對謠言進行判斷,在提取微博的內容特征、用戶特征、傳播特征以及情感分析特征的基礎上,新增敏感詞特征以后謠言識別率有明顯提升,得到較好的識別效果。

關鍵詞:敏感詞庫;詞向量;特征空間;網絡謠言

分類號:G202

引用格式:夏松, 林榮蓉, 劉勘. 網絡謠言敏感詞庫的構建研究: 以新浪微博謠言為例[J/OL]. 知識管理論壇, 2019, 4(5): 267-275[引用日期]. http://www.kmf.ac.cn/p/185/.

1? 引言

對網絡謠言進行深入分析有助于及時判斷真實或虛假的信息,創造一個健康的網絡環境。目前網絡謠言的識別多是從用戶特征、傳播特征的角度進行分析,而事實上,謠言敏感詞是識別網絡謠言的一個重要特征,謠言敏感詞分析有助于提高對謠言的判別,遏制謠言的蔓延和傳播。

詞庫是詞匯的集合體,通常包括基本詞庫以及專業詞庫,應用較廣的專業詞庫包括流行詞庫、專業本體詞庫、敏感詞庫,情感詞庫等。其中,現有的敏感詞庫主要有反動敏感詞庫、暴恐敏感詞庫、色情敏感詞庫、垃圾廣告敏感詞庫等,被廣泛地應用在各類貼吧、論壇以及垃圾郵件檢測中。

但目前還沒有一個完備的網絡謠言敏感詞庫。本文的謠言敏感詞庫是應用于微博微信這類平臺的,專門用于謠言的識別,包括:①失實的事件,比如某地發生地震、騷亂等子虛烏有的事件;②夸大事實真相,比如廠商對自身產品的過度或虛假宣傳、對同行產品的詆毀; ③過期信息的使用及詐騙,比如將小女孩走失的消息更改時間地點或者電話號碼之后再次發送,誘導人們撥打有詐騙嫌疑的電話等。這些謠言會在一定時期一定程度上引發了社會各領域人們的關注甚至成為焦點,如果不及時處理,其潛在的安全威脅也是不可估量的,而對于這些謠言涉及的敏感詞,傳統的詞庫并不能很好地識別。因此,筆者所構建的敏感詞庫是基于微博謠言而建立的,有較強的實用價值,為社交平臺的謠言識別提供速度和質量的保證。

2? 相關工作

敏感詞庫的構建主要在于敏感詞匯信息的識別、敏感詞匯的提取以及擴展。其中,敏感信息的提取目前大多通過人工標記與挑選或者基于傳統權重計算方法[1]去衡量與選擇,再基于參考詞林,去迭代地識別敏感信息,最后通過相關算法進行敏感詞的擴充[2],如劉耕等[3]采用基于廣義的jaccard系數方法來計算得到敏感詞的相關聯詞匯。

針對敏感事件和熱點話題的很多研究從敏感詞庫和熱點詞集入手,取得了較好的效果。詞庫的構建類似于提取文本中的關鍵字,多以已有的專業詞匯為基礎,采用計算特征詞權重的方法。徐琳宏[4]根據情感分類現狀,確定分類的體系,再綜合各種情感詞匯的資源來構造情感詞匯的本體,采用了手工分類以及自動獲取結合的方法獲取詞匯本體;侯麗[5]采用N-Gram及各種過濾規則結合的術語識別公眾日志數據,能較好地識別發現健康類詞集;C. Quan等[6]從情感類別符號、情緒強度、情感詞、程度詞、否定詞、連詞、修辭等識別情感種子詞,從而完成情感詞典的構建;F. Peng等[7]利用線性鏈條件隨機場(CRFs)來進行基于字、詞、多詞等形式的領域集成的中文分詞,并通過基于概率的新詞檢測方法進行新詞識別;周強[8]提出一種多資源融合自動構建漢語謂詞組合范疇語法(CCG)詞庫的方法,不同句法語義分布特征,融合形成CCG原型范疇表示,將它們指派給各資源信息完全重合的謂詞形成核心詞庫;K. J. Chen等[9]實現了通過一個未知詞提取系統來在線識別新詞,主要通過統計信息以及語法語義上下文等信息進行新詞識別;彭云等[10]在商品情感詞的提取過程中,基于商品評論文本,從詞義理解、句法分析等角度獲得詞語間語義關系,并將其嵌入到主題模型,提出基于語義關系約束的主題模型SRC-LDA,從而實現主題詞的提取。

在構造詞庫時,只是確定了基本詞集往往是不夠的,需要對其進行擴充從而得到較為完整的詞庫。詞匯擴展與關鍵字擴展相似,通過詞義近似或語義近似展開。H. Chen等[11]從詞典中提取了近似語義信息的詞作為擴展。S. Yu等[12]利用VIPS(VIsion-based Page Segmentation)算法進行查詢擴展,該算法主要是通過調用嵌入在Web瀏覽器中的分析器來獲取DOM結構以及視覺相關信息(所有視覺信息都來自HTML元素和屬性)進行查詢擴展。J. M. Pnote和W. B. Croft[13]提出了將統計語言模型和信息檢索相結合,使用詞頻和文檔頻率按綜合頻率對詞信息進行排序;T. Pedersen和A. Kulkarni[14]通過聚類實現類似的詞的識別,然后將它們應用到語義擴展;P. D. Turney和M. L. Litham[15]通過計算傾向性基準詞與目標詞匯間相似度的方法識別詞匯語義傾向性;A. Neviarouskaya等[16]通過同義詞和反義詞的關系、上下文語義關系、推導關系以及與已知的詞匯單位復合來進行情感詞典的擴展。

但是上述敏感詞庫的構建方法應用于網絡謠言語料庫建設并不完全合適,首先目前謠言并沒有可參考的詞林。而且傳謠變化形式多樣,擴展和傳播方式多種多樣。某些詞匯出現在網絡謠言中的頻率高,同時存在于正常微博中的頻率也高,不能單獨用來判定謠言。針對以上謠言敏感詞的特點,筆者設計了一個抽詞算法提取敏感詞并進行多級擴充,旨在建立一個實用的網絡謠言敏感詞庫。

3? 謠言敏感詞庫設計

3.1? 謠言敏感詞庫構建的困難

針對謠言特征所構建的微博謠言敏感詞庫是一個專業性偏向性較強的專業詞庫,需要有大量的微博謠言語料,同時在構建敏感詞庫的過程中會遇到下述困難:

(1)人工干擾。謠言發布者常常會采取多種方法來逃避關鍵詞的匹配過濾。例如在敏感組合詞匯間夾雜了一些無意義的數字與符號,如“抵@制!共&$產&0黨”。然而這類復雜多變的形式,卻并不影響人們正常的閱讀,這種情況直接進行敏感詞庫匹配是無法解決的。

(2)準確性。部分在謠言微博中出現的敏感詞,很多時候也會出現在正常微博的文本中致使對文本敏感得分的判定很容易出現偏差。即大多詞匯只有在特定的語境中才會顯示出其謠言的特性。

(3)分詞問題。網絡用語越來越隨意,新詞、未登錄詞等層出不窮以及謠言具有時效性等使得傳統的分詞工具不適用于此類文本,從而對謠言識別帶來影響。

對于第一類人工干擾的謠言文本,即夾雜符號的敏感詞的檢測與識別,筆者將通過擴充停用詞解決,對待測文本分詞之后進行去停用詞等預處理方法來解決;對于第二類準確性的問題,筆者引入位置權重以及敏感度權重來抽取敏感詞,將詞匯在謠言與正常微博中的詞頻比以及位置權重(詞匯是否處于標題中)作為衡量的因素,同時對種子詞集進行相似詞、關聯詞擴展;對于第三類分詞問題,筆者提出基于敏感熱度的L-CPBL抽詞算法摒棄了傳統的分詞工具,基于內聚度以及外聚度來提取文本片段,以更加適用于網絡社交文本。

3.2? 總體設計

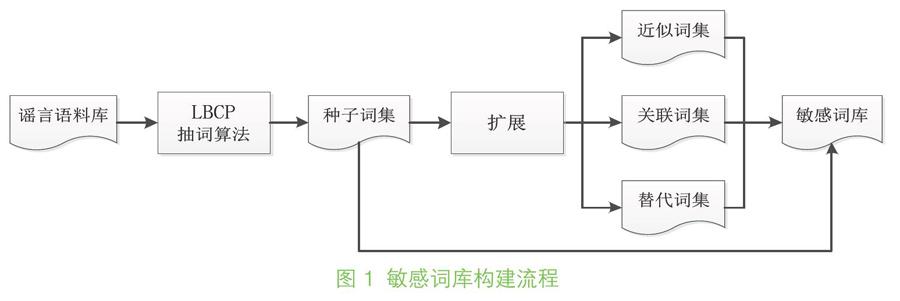

本研究中網絡謠言敏感詞庫構建的基本思路是:首先收集網絡謠言語料,然后利用抽詞算法構建種子詞集,進而對種子詞集進行擴展得到完備的謠言敏感詞庫,其總體流程如圖1所示:

圖1? 敏感詞庫構建流程

因為目前的分詞軟件大多具有普適性,用來針對某一領域發現特定詞、敏感詞、新詞效果不佳,因此種子詞采集沒有直接分詞,而是設計了LBCP(Location- Based Cohesion and Polymerization)算法進行抽詞,通過計算詞的內聚度和外聚度,結合詞權重和位置權重得到種子詞集;然后對種子詞集從近似詞、關聯詞和替代詞等方面進行擴展,最終合并成為謠言敏感詞庫。

3.3? LBCP抽詞算法

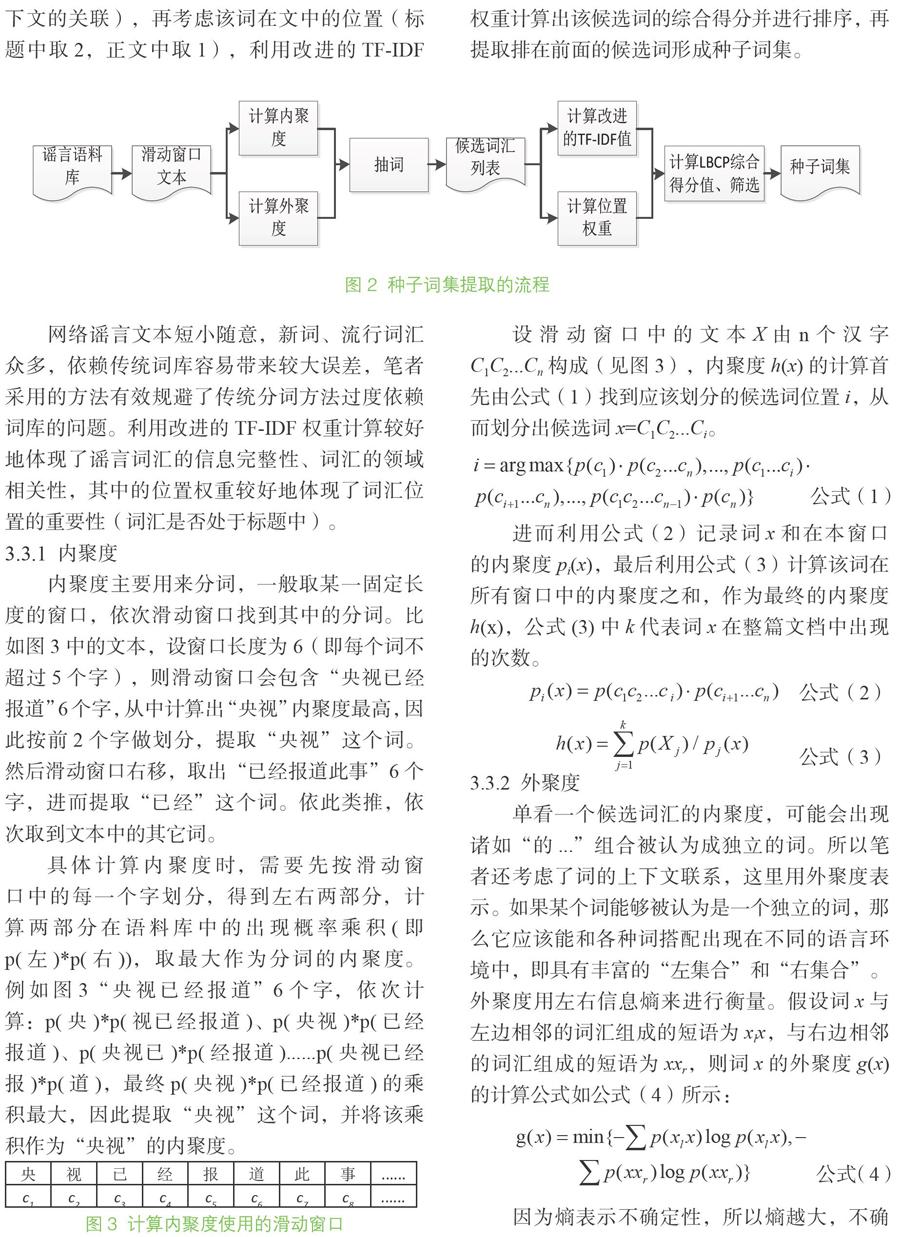

LBCP抽詞算法是考慮了詞語位置和上下文信息的抽詞過程,其提取謠言種子詞集的流程如圖2所示。

LBCP抽詞算法首先設置一個滑動窗口,從中提取候選詞匯,計算候選詞匯的內聚度(表示該詞的聚合程度)、外聚度(描述該詞與上下文的關聯),再考慮該詞在文中的位置(標題中取2,正文中取1),利用改進的TF-IDF權重計算出該候選詞的綜合得分并進行排序,再提取排在前面的候選詞形成種子詞集。

圖2? 種子詞集提取的流程

網絡謠言文本短小隨意,新詞、流行詞匯眾多,依賴傳統詞庫容易帶來較大誤差,筆者采用的方法有效規避了傳統分詞方法過度依賴詞庫的問題。利用改進的TF-IDF權重計算較好地體現了謠言詞匯的信息完整性、詞匯的領域相關性,其中的位置權重較好地體現了詞匯位置的重要性(詞匯是否處于標題中)。

3.3.1? 內聚度

內聚度主要用來分詞,一般取某一固定長度的窗口,依次滑動窗口找到其中的分詞。比如圖3中的文本,設窗口長度為6(即每個詞不超過5個字),則滑動窗口會包含“央視已經報道”6個字,從中計算出“央視”內聚度最高,因此按前2個字做劃分,提取“央視”這個詞。然后滑動窗口右移,取出“已經報道此事”6個字,進而提取“已經”這個詞。依此類推,依次取到文本中的其它詞。

具體計算內聚度時,需要先按滑動窗口中的每一個字劃分,得到左右兩部分,計算兩部分在語料庫中的出現概率乘積(即p(左)*p(右)),取最大作為分詞的內聚度。例如圖3“央視已經報道”6個字,依次計算:p(央)*p(視已經報道)、p(央視)*p(已經報道)、p(央視已)*p(經報道)......p(央視已經報)*p(道),最終p(央視)*p(已經報道)的乘積最大,因此提取“央視”這個詞,并將該乘積作為“央視”的內聚度。

央 視 已 經 報 道 此 事 ......

c1 c2 c3 c4 c5 c6 c7 c8 ......

圖3? 計算內聚度使用的滑動窗口

設滑動窗口中的文本X由n個漢字C1C2...Cn構成(見圖3),內聚度h(x)的計算首先由公式(1)找到應該劃分的候選詞位置i,從而劃分出候選詞x=C1C2...Ci。

公式(1)

進而利用公式(2)記錄詞x和在本窗口的內聚度pi(x),最后利用公式(3)計算該詞在所有窗口中的內聚度之和,作為最終的內聚度h(x),公式(3)中k代表詞x在整篇文檔中出現的次數。

公式(2)

公式(3)

3.3.2? 外聚度

單看一個候選詞匯的內聚度,可能會出現諸如“的...”組合被認為成獨立的詞。所以筆者還考慮了詞的上下文聯系,這里用外聚度表示。如果某個詞能夠被認為是一個獨立的詞,那么它應該能和各種詞搭配出現在不同的語言環境中,即具有豐富的“左集合”和“右集合”。外聚度用左右信息熵來進行衡量。假設詞x與左邊相鄰的詞匯組成的短語為xlx,與右邊相鄰的詞匯組成的短語為xxr,則詞x的外聚度g(x)的計算公式如公式(4)所示:

公式(4)

因為熵表示不確定性,所以熵越大,不確定越大,也就是這對詞左右搭配越豐富,選擇越多。計算一個文本片段的左信息熵和右信息熵,如果該文本片段的信息熵偏大,就可以把它看作一個獨立的、可以抽取出來的高頻謠言詞匯。

3.3.3? 改進的TF-IDF權重

通過內聚度和外聚度得到基于謠言語料的大量新舊詞匯,然后可以利用這些詞的權重進行篩選。本文權重基于TF-IDF計算,但是做了如下改進:①由于舊新聞重復散播或者同一條謠言僅僅修改了人名、地名、手機號碼等張冠李戴型的謠言比較多,因此對文檔頻率要求較高,而對于逆文檔頻率要求并不高,不要求詞語對文檔有獨特的標識性,因此對于TF-IDF公式中TF和IDF給予不同的權重(公式(5)中增加λ,使得TF的權重值大于IDF的權重值); ②消除了文檔長度的不同對詞權重的影響(公式(5)中增加分母,進行余弦歸一化處理),同時通過對詞頻取對數來消除詞頻大小差異對權重計算的影響。詞x改進的TF-IDF權重計算如公式(5)所示:

公式(5)

其中,N為微博總條數,λ是詞頻TF的權重,tf和idf分別表示詞x的TF值和IDF值,公式(5)右邊的分母利用謠言微博中出現的每個詞x的TF值tfi和IDF值idfi進行余弦歸一化處理。

3.3.4? 位置權重

針對微博謠言來說,微博標題或者話題中的詞匯比內容詞匯更具有代表性,更能反映出微博的主題,也就更能反映出微博主題的謠言敏感度。對微博文本中詞x的單個位置權重值定義如公式(6)所示:

公式(6)

對微博內容進行掃描,如果有“【】”或者“[]”或者#,則將其視為微博的標題或者話題,將其單個位置權重值為2,否則為1。詞x位置權重為公式(7)所示:

公式(7)

其中,w2(x)為詞匯的位置權重。Li表示某條微博i中詞x的位置權重值,D表示包含詞x的微博總條數。

3.3.5? 抽詞算法流程

LBCP抽詞算法的步驟如下:

Step 1: 利用公式(1)、公式(2)、公式(3)進行分詞(詞的長度不大于某個閾值t),并計算各分詞x的內聚度h(x);

Step 2: 利用公式(4)計算各分詞x的外聚度g(x),求得每個詞的內聚度和外聚度之和,篩選出其和大于某閾值θ的詞匯;

Step 3: 對篩選出的詞計算其改進的TF-IDF權重w1(x)和位置權重w2(x),根據公式(8)計算綜合得分值;

LBCP(x)=w1(x)×w2(x)? ? ? ? 公式(8)

Step 4:按綜合得分LBCP(x)進行排序,取前M個詞匯作為種子詞集。

3.4? 擴展詞集

為了實現對謠言敏感詞的有效擴展,筆者主要從種子詞集的近似詞、關聯詞以及替代詞3個方面進行詞庫的擴展。

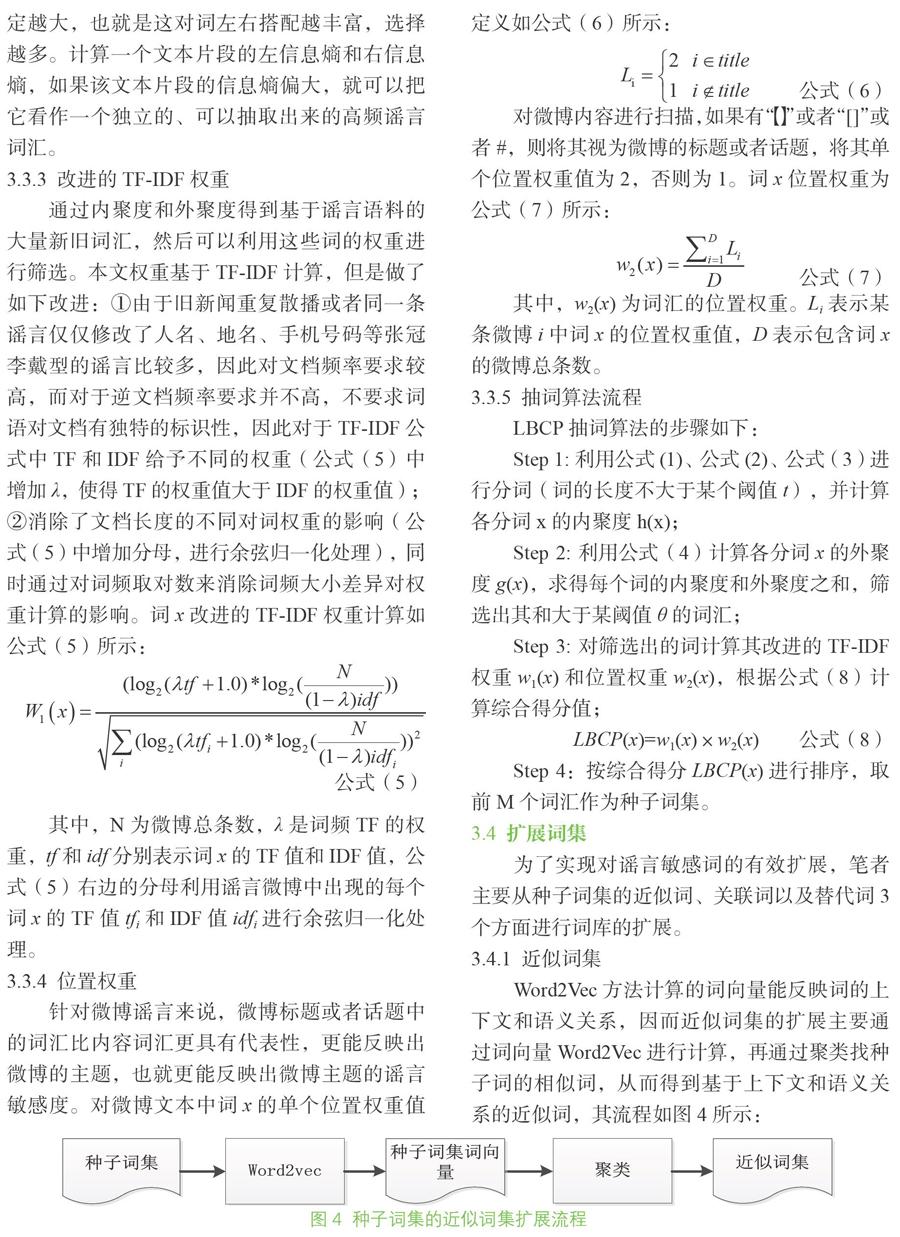

3.4.1? 近似詞集

Word2Vec方法計算的詞向量能反映詞的上下文和語義關系,因而近似詞集的擴展主要通過詞向量Word2Vec進行計算,再通過聚類找種子詞的相似詞,從而得到基于上下文和語義關系的近似詞,其流程如圖4所示:

圖4? 種子詞集的近似詞集擴展流程

3.4.2? 關聯詞集

單個敏感種子詞可能出現在謠言中,也可能出現在正常微博中,比如“免費”這個詞,它既可能出現在不良廠商的微博謠言中,也可能出現在正規商家的微博宣傳中,但當“免費”和“轉發”共現時,它就極大可能是謠言。因此,對于每個種子詞計算其高頻率共現的詞匯,即與之相關度高的詞匯,這些詞匯有助于提高謠言的識別率。

筆者采用互信息的方法來尋找種子詞關聯詞集。種子詞的關聯詞集的構造流程如圖5所示:

圖5? 種子詞的關聯詞集的構造流程

但是謠言中這樣產生的成對詞互信息較高,詞頻卻較低,這樣對于謠言的識別作用不大,因此在互信息計算上加入了詞頻信息,計算如公式(9)所示:

公式(9)

其中,p(x,y)為詞x和y的詞頻。

3.4.3? 替代詞集

謠言信息發布者通常會采取多種方式來逃避敏感詞匹配過濾,比如把謠言敏感詞進行中英文的轉換或者縮寫等,因此也需要找出種子詞的替代詞集。這樣的詞處理量并不多,本研究通過人工來完成,比如:

(1)拼音:拼音代替漢字,如“拐走”——“guai走”。

(2)英文:英文代替漢字,為種子詞的英文翻譯。

(3)縮寫或簡寫:種子詞的常用縮寫形式,如“神州六號”——“神6”。

經過以上3種擴展,最終將種子詞集與各擴展詞集合并構建了網絡謠言的敏感詞庫。

4? 實驗

4.1? 數據集

實驗爬取了新浪微博社區管理中心、“謠言粉碎機”以及各地區辟謠平臺上發布的30 034條謠言。同時爬取了包括中國新聞網、央視新聞等35 000余條正常微博作為正類數據。這些數據都經過了包括去噪聲、去停用詞等處理過程。去噪主要是刪除了總長度不足5個字的微博,這類微博多攜帶信息較少,處理的意義不大,刪除后可提高處理效率。

4.2? 提取種子詞集

利用第3.2節中種子詞的抽取思路,將微博謠言文本中長度不超過閾值t(本文取值為9)的文本都當作潛在的詞,通過樣例數據實驗確定內聚度和外聚度的閾值,最后提取出所有不大于閾值t的候選詞。在處理過程中,把全部微博謠言語料作為一個整體,利用LBCP抽詞算法提取候選詞43 363個。候選詞的內聚度、外聚度及其在謠言微博和正常微博中的詞頻如圖6所示:

圖6? 候選詞匯的內聚度、外聚度及詞頻

在上述結果的基礎上,結合位置權重因子,根據LBCP綜合值進行排序,取前300個作為謠言種子詞集。通過LBCP抽詞算法挑選出來的部分種子詞集如表1所示:

4.3? 種子詞集的擴展

(1)近似詞集擴展。利用Word2Vec工具計算得到300個種子詞集的詞向量,再分別計算各個詞向量維度上的均值,計算得到種子詞集的均值向量。用詞集的平均向量利用KNN模型聚類,得到300個種子詞最相近的詞。實驗中共取到與種子詞集同屬一類的1 785個詞作為擴展的近似詞,形成的近似詞集如表2所示:

(2)關聯詞集擴展和替代詞集。計算種子詞集與語料庫中其他詞的互信息的大小,并降序排列,得到最終有175個詞匯的關聯詞集。如“拐走”的擴展詞包括:找到、造謠、逝去、倒霉、最近、詛咒、資助、真相、折磨等。

種子詞替代詞集包含了300個種子詞的拼音、英文以及縮寫簡寫形式,如幫忙的替代詞有:Help、bangmang、bm等,酬金的替代詞有:Remuneration、fee、pay、choujin、cj等。

至此,整個謠言敏感詞庫構建完成,敏感詞庫包含種子詞集300個,近似詞集1 785個,關聯詞集175個,替代詞集300個,共計2 260個。

4.4? 微博謠言識別

實驗另外爬取了2018年1月到2018年3月期間,新浪微博“謠言粉碎機”以及各地區辟謠平臺上發布的5 000條謠言數據,同時爬取了包括中國新聞網、今日頭條、央視新聞在內的微博大V賬號的正常微博5 000條。將這? ? 10 000條微博作為測試數據,以驗證敏感詞庫對謠言識別的提升作用。

從混合的10 000條微博數據中提取傳統特征和敏感詞特征,將其作為輸入數據。傳統特征包括發布該微博的用戶信息(用戶粉絲數、關注數、注冊事件、已發布微博數量、是否驗證用戶)、微博的結構特征(轉發數量、微博的長度、是否包含”@”、是否包含標簽、是否包含URL、是否含有表情符號、標點符號的使用情況、是否含有第一人稱等)以及每條微博所有詞的詞向量加和平均值。敏感詞特征包括敏感詞的個數和敏感詞得分總和。

利用以上提取的微博特征,通過隨機森林、SVM、GBRT、CNN、BiLSTM、TextCNN等分類模型構建微博謠言分類器。由于重點在謠言的識別,因此,本文要求謠言的召回率(本身是謠言且被正確識別出來的比例)盡量大,準確率盡量高。實驗中采用十折交叉驗證,多種算法的準確率和召回率在加入敏感詞庫特征前后的對比結果如表3所示:

通過實驗可知,當敏感詞特征和傳統特征融合之后,各種分類方法的準確率和召回率都有大幅的提升,其中BiLSTM的準確率超過95%,召回率也接近90%。可以看出,謠言敏感詞庫的構建在提升微博謠言的識別率方面達到了預期的效果。

5? 結語

網絡謠言敏感詞庫是謠言識別的重要基礎,筆者旨在構建敏感詞庫并用輔助實驗證明對謠言微博識別的有效性。利用大量語料庫,筆者構建了一個基于敏感熱度L-CPBL抽詞算法及其相似詞和擴展詞的謠言敏感詞庫。第一步是種子詞集的提取,L-CPBL抽詞算法是一種無詞典參考的快速抽詞算法,同時結合改進的LTC權重以及位置權重因子,對謠言敏感詞庫的種子詞集的提取更準確;然后基于詞向量模型空間優化以及聚類算法對種子詞集進行擴展,綜合得到適用于謠言的敏感詞庫。筆者構建的敏感詞庫適用于微博類社交短文本,并且構建過程不依賴于人工專家的識別挑選,可基于語料庫同步更新,因此節省了時間與費用,提高了效率。

筆者創建的謠言敏感詞庫具有時效性,需要不斷收集大量謠言語料,而謠言語料需依賴官方公布的謠言信息作為標注語料,使得敏感詞庫的更新需要消耗較多的時間和資源,可對敏感詞庫的更新進行進一步研究,引入時序算法或者從傳播的方面進行研究,以便更好地解決時效性問題。

參考文獻:

[1] 徐建民,王金花,馬偉瑜.利用本體關聯度改進的TF-IDF特征詞提取方法[J].情報科學,2011, 29(2): 279-283.

[2] 周曉. 基于互聯網的情感詞庫擴展與優化研究[D]. 沈陽: 東北大學, 2011.

[3] 劉耕,方勇,劉嘉勇.基于關聯詞和擴展規則的敏感詞庫設計[J].四川大學學報(自然科學版), 2009, 46(3): 667-671.

[4] 徐琳宏,林鴻飛,潘宇,等.情感詞匯本體的構造[J]. 情報學報, 2008,27(2): 180-185

[5] 侯麗,李姣,侯震,等.基于混合策略的公眾健康領域新詞識別方法研究[J].圖書情報工作, 2015,59(23):115-123.

[6] QUAN C, REN F. Construction of a blog emotion corpus for Chinese emotional expression analysis[C]//Proceedings of conference on empirical methods in natural language processing. Stroudsburg:Association for Computational Linguistics,2009:1446-1454.

[7] PENG F, FENG F, MCCALLUM A. Chinese segmentation and new word detection using conditional random fields[C]//Proceedings of international conference on computational linguistics. Stroudsburg: Association for Computational Linguistics,2004:562-569.

[8] 周強.漢語謂詞組合范疇語法詞庫的自動構建研究[J].中文信息學報, 2016,30(3): 196-203.

[9] CHEN K J, MA W Y. Unknown word extraction for Chinese documents[C]// Proceedings of international conference on DBLP. Taipei: Morgan Kaufmann Publishers, 2002:169-175.

[10] 彭云,萬常選,江騰蛟,等.基于語義約束LDA的商品特征和情感詞提取[J].軟件學報, 2017,28(3):676-693.

[11] CHEN H, LYNCH K, BASU K, et al. Generating, integrating and activating thesauri for concept-based document retrieval[J]. IEEE intelligent systems and their applications, 1993,8(2):25-34.

[12] YU S,CAI D,WEN J,et al. Improving pseudo-relevance feedback in web information retrieval using Web page segmentation[C]//Proceedings of the 12th international conference on World Wide Web. New York: ACM, 2003:11-18.

[13] PNOTE J M,CROFT W B. A language modeling approach to information retrieval[C]//Proceeding of the 21st International ACM SIGIR conference on research and development in information retrieval. New York: ACM, 1998:275-281.

[14] PEDERSEN T, KULKARNI A. Identifying similar words and contexts in natural language with sense clusters[C]// Proceedings of the 20th national conference on artificial intelligence. Pittsburgh: AAAI Press, 2010:1694-1695.

[15] TURNEY P D, LITTMAN M L. Measuring praise and criticism: inference of semantic orientation from association[J]. ACM transactions on information systems, 2003, 21(4):315-346.

[16] NEVIAROUSKAYA A,PRENDINGER H,ISHIZUKA M. SentiFul: a lexicon for sentiment? analysis[J].IEEE transactions on affective computing,2011,2(1):22-36.

作者貢獻說明:

夏? 松:設計模型, 完成實驗,修改論文;

林榮蓉:采集數據,進行實驗,撰寫論文初稿;

劉? 勘:提出研究思路,設計研究方案,修改論文與定稿。

Construction of Sensitive Thesaurus for Network Rumors

——Taking the Microblog Rumors as an Example

Xia Song? Lin Rongrong? Liu Kan

School of Information and Safety Engineering, Zhongnan University of Economics and Law, Wuhan 430074

Abstract: [Purpose/significance] The network rumors seriously influent the spread of normal information on the internet. The purpose of this paper is to construct a sensitive lexicon on microblog rumors and to improve the recognition accuracy of the network rumors. [Method/process] According to the characteristics of microblogs short text on social networking platforms, this paper focuses on construction of the microblog sensitive thesaurus, which is built up through LBCP algorithm and extension of multiple level words. At first, the method directly extracts words through LBCP algorithm, which considers the cohesion and polymerization of rumor words. And then, based on the core words, multiple level words are expanded to get sensitive thesaurus. [Result/conclusion] In addition to the features of the text, user characteristics, propagation characteristics, emotional analysis, and rumor features based on sensitive thesaurus are exploited. Experimental results show that the accuracy of microblogs rumor recognition can be improved greatly based on sensitive thesaurus.

Keywords: sensitive thesaurus? ? word embedding? ? feature space? ? network rumors

基金項目:本文系國家社會科學基金資助項目“基于文本挖掘的網絡謠言預判研究”(項目編號:14BXW033)研究成果之一。

作者簡介:夏松(ORCID:0000-0001-7700-6185),講師,博士;林榮蓉(ORCID:0000-0002-5141-6503),碩士研究生;劉勘(ORCID:0000-0002-9686-9768),教授,博士,通訊作者, E-mail: liukan@zuel.edu.cn。

收稿日期:2019-06-18? ? ? ? 發表日期:2019-09-11? ? ? ? 本文責任編輯:劉遠穎