基于孿生檢測網絡的實時視頻追蹤算法

鄧楊 謝寧 楊陽

摘要:目前,在視頻追蹤領域中,大部分基于孿生網絡的追蹤算法只能對物體的中心點進行定位,而在定位快速形變的物體時會出現定位不準確的問題。為此,提出基于孿生檢測網絡的實時視頻追蹤算法——SiamRFC。SiamRFC算法可直接預測被追蹤物體位置,來應對快速形變的問題。首先,通過判斷相似性來得到被追蹤物體的中心點位置;然后,運用目標檢測的思路,通過選取一系列的預選框來回歸最優的位置。實驗結果表明,所提SiamRFC算法在VOT2015|16|17的測試集上均有很好的表現。

關鍵詞:孿生網絡;物體檢測;實時視頻追蹤;相似性學習;卷積神經網絡

中圖分類號: TP391.4文獻標志碼:A

Siamese detection network based real-time video tracking algorithm

DENG Yang1,2, XIE Ning1,2*, YANG Yang1,2

(1. School of Computer Science and Engineering, University of Electronic Science and Technology of China, Chengdu Sichuan 611731, China;

2. Center for Future Media, University of Electronic Science and Technology of China, Chengdu Sichuan 611731, China)

Abstract: Currently, in the field of video tracking, the typical Siamese network based algorithms only locate the center point of target, which results in poor locating performance on fast-deformation objects. Therefore, a real-time video tracking algorithm based on Siamese detection network called Siamese-FC Region-convolutional neural network (SiamRFC) was proposed. SiamRFC can directly predict the center position of the target, thus dealing with the rapid deformation. Firstly, the position of the center point of the target was obtained by judging the similarity. Then, the idea of object detection was used to return the optimal position by selecting a series of candidate boxes. Experimental results show that SiamRFC has good performance on the VOT2015|16|17 test sets.

Key words: Siamese network; objection detection; real-time video tracking; similarity learning; Convolutional Neural Network (CNN)

0引言

在計算機視覺中,視頻追蹤領域是一個非常重要且具有挑戰性的問題。由于被追蹤物體會產生遮擋、形變和外觀等變化,精確定位目標物體顯得較為困難。另外,在大量的應用中,比如自動駕駛、視頻監控等,都具有實時性的要求。因此,設計具有實時性且高精度追蹤算法就成為視頻追蹤領域主要的挑戰。

在視頻追蹤領域,基于相關濾波器方法[1-4]被廣泛地應用。相關濾波器方法是訓練學習一個濾波器,用于從背景中分離出被追蹤物體。但是基于濾波器的方法具有很多缺點,比如需要在線更新;另外,對于背景較為復雜和快速形變的物體則不能很準確地定位。近年來,由于硬件性能的提升和可利用的標注數據的增多,為深度卷積神經網絡在計算機視覺中的快速應用奠定了基礎。目前,基于學習深度特征的相關濾波器能夠持續提高算法的精確度[1,5-6];文獻[7-9]則是直接利用深度學習的方法進行追蹤。但是這些方法通常需要在線更新,所以很難達到實時性。

目前,基于深度卷積神經網絡[10-12]的實時追蹤方法被廣泛應用于目標追蹤領域中。如文獻[11]把追蹤看成是一個回歸問題,通過卷積神經網絡(Convolutional Neural Network, CNN)直接回歸出被追蹤物體的位置;Siamese-FC(Fully-Convolutional Siamese network)[10] 把追蹤看成相似性學習,通過深度卷積神經網絡學習一個判別模型來定位物體中心點的位置,但是對物體形狀的預測只是通過初始幀中物體的形狀和相應的形變約束來控制。Siamese-RPN(Siamese Region Proposal Network)[12]把追蹤看成一個檢測問題,利用Faster R-CNN(Faster Region-CNN)[13]中區域回歸的思想來定位被追蹤物體的位置。盡管Siamese-RPN具有很高的追蹤能力,但是需要比文獻[10-11]方法設置更多的參數,因此會增加大量訓練數據。

為解決以上問題,本文提出一種基于孿生檢測網絡的實時視頻追蹤算法——SiamRFC(Siamese-FC Region-convolution neural network)。SiamRFC算法分為兩部分:第一部分跟Siamese-FC相似,通過學習CNN來得到一個判斷物體相關性的關系網絡,該網絡可以定位被追蹤物體的中心點位置;第二部分則是利用這個中心點的位置,提取一系列預選框,然后通過回歸和分類網絡來定位被追蹤物體。SiamRFC算法結合了Siamese-FC和Faster R-CNN的優勢:一方面Siamese-FC具有很好的判別能力,能過定位被追蹤物體的中心點;另一方面利用區域回歸的思想進一步定位目標。本文的算法與Siamese-RPN區別在于不是全局定位物體位置,最大的優勢是模型參數少,使用少量的數據仍然可以得到很好的追蹤效果。

在VOT2015[14]、VOT2016[15]和VOT2017[16]評估提出本文提出的追蹤算法SiamRFC。在VOT系列的測試集上的實驗結果表明,本文算法能達到很好的性能。由于SiamRFC是在Siamese基礎上進一步定位目標,會增加一些追蹤時間,但是仍然滿足實時性的要求。

1相關工作

1.1視頻追蹤

基于孿生網絡的追蹤算法由兩部分組成,首先提取第一幀中被追蹤物體的特征,然后和候選區域特征進行比較,得到相似性信息。基于這種方法的追蹤器通常在一個域上學習信息,然后遷移到其他域中。這種方法并不需要在線更新,滿足實時追蹤的要求。

最近幾年,孿生網絡引起極大的關注[10-12,17-21]。文獻[11]是一個基于孿生網絡的回歸方法。Siamese-FC[10]則是通過學習候選區域特征和目標特征之間的關系來得到相似圖譜。Siamese-FC使用全卷積網絡來進行學習,全卷積網絡的優點在于目標補丁的大小和候選補丁大小可以不相同,因此可以向網絡提供更大的搜索特征,然后生成一個密集相似性圖來評估特征之間的關系。文獻[20]則是在Siamese-FC基礎上增加濾波器方法,盡管最終的算法性能和Siamese-FC不相上下,但是卻可以使得Siamese-FC模型參數更少并且更加健壯。Siamese-RPN[12]則是在孿生網絡中引入區域回歸思想來追蹤物體位置。文獻[19]則嘗試在孿生網絡中添加在線學習的方法,盡管精度大幅度提高,但是損失速度。

基于孿生網絡的追蹤算法Siamese-FC[10]主要缺點只是學習物體的中心點信息,對于物體的大小變化信息則并沒有進行相應的學習,因此,本文嘗試在孿生網絡Siamese-FC[10]添加分類和回歸網絡來進一步學習物體的空間信息。

物體檢測是計算機視覺的一個重要分支,最近幾年取得極大的進展。從R-CNN(Region-CNN)[22]開始,物體檢測的方法可以分為兩個階段,即:通過生成的感興趣的區域來進行分類和回歸。Fast-RCNN[23]則是通過在共享的卷積層特征上提取感興趣區域來解決R-CNN冗余計算的問題。Faster R-CNN[13]則是通過CNN來自動生成相對較少但質量更高的感興趣區域來進一步減少冗余計算,不僅提高了檢測質量,還提高了檢測速度。

1.3Faster R-CNN

由于本文的追蹤算法跟Faster R-CNN算法相關,因此,在這里簡要介紹Faster R-CNN:首先提取圖片的特征,對于提取到的特征選取一系列的預選框,即具有不同面積和寬高比的矩形框;然后通過區域回歸網絡(RPN)來預定位圖片中所有物體的位置;最后對于選出的建議框通過非極大值抑制(Non-Maximum Suppression, NMS)進一步減少建議框的數量。池化層則把這些建議框統一到相同的空間維度,以便于輸入到后續的網絡中進一步進行預測。

本文的算法思想與Faster R-CNN的算法思想類似,都是生成預選框進行定位。不同之處在于本文算法并不需要全局搜索,而是局部搜索,即在孿生網絡預定位的基礎上生成預選框。

2本文算法

2.1孿生網絡

在第一階段定位被追蹤物體中心點的過程中,使用來自Siamese-FC[10]的網絡結構,Siamese-FC是一個全卷積的網絡結構,如圖1(a)所示。假如Lτ表示轉換操作(Lτx)[u]=x[u-τ],如果操作是全卷積則需要滿足以下條件:

h(Lkτx)=Lτh(x)(1)

其中k表示網絡的步長。

孿生網絡中可以通過學習一個關系函數f(z,z′)來比較兩張圖片的關系,其中z和z′圖片尺寸相同。由于Siamese-FC是全卷積網絡,候選圖片和目標圖片不需要具有相同空間維度。若x表示被搜索的圖片,則兩個圖片之間的關系可表示為:

f(z,x)=Φ(z)*Φ(x)+b·1(2)

其中:“*”表示卷積操作; f(z,x)表示分數圖譜。分數圖譜的真實標記可以表示如下:

y[u]=+1,k‖u-c‖≤R

-1,其他(3)

其中:k是網絡步長;R是分數圖譜的半徑。

2.2檢測網絡

第二階段的區域回歸網絡圖1(b)所示。從圖1可以看到,區域回歸網絡可以分為兩個分支:一個分支是區別前景背景的分類網絡;另一個是用來定位目標位置的回歸網絡。若(z)表示通過CNN的目標圖像特征,則(z)分為兩個部分:[(z)]cls和[(z)]reg,分別擁有相較于(z)的2倍和4倍的通道數量。若(x)表示通過CNN的搜索區域的特征,從圖1可以看到,(x)基于預測的中心點位置選取K個不同比例、不同面積的特征區域。這些特征被歸一化到相同的空間大小[x′]1,2,…,k,最后通過和(z)操作得到相應的分類和被追蹤物體的位置。

Lcls2k=[(z)]cls*(x′)1,2,…,k

Lreg4k=[(z)]reg*(x′)1,2,…,k(4)

其中:Lcls2k表示的是模板z和x′卷積之后得到的分類結果,z和x′具有相同的空間特征;k表示預選框的數量;Lreg4k表示k個預選框和預測的物體位置之間的正則化距離。

在訓練的過程中,本文使用和Faster R-CNN[13]相同的損失函數,對于分類網絡使用交叉熵損失,對于回歸網絡使用L1正則化損失函數。假設Ax、Ay、Aw、Ah表示預選框的中心點位置和目標大小,Gx、Gy、Gw、Gh表示實際物體的中心點位置和大小。則正則化距離為:

δ0=Gx-AxAx

δ1=lnGwAw

δ2=Gy-AyAy

δ3=lnGhAh(5)

其中L1正則化損失函數表示如下:

smoothL1(x,α)=0.5x2α2,|x|<1/α2

|x|-1/(2α2),|x|≥1/α2(6)

其中α是一個超參數,用來調節損失。

則最終損失函數為:

L=∑iLcls(pi,qi)+λ∑iqiLreg(di,δi)(7)

其中:pi表示預測的前景和背景的概率;qi表示該預選框是背景還是前景;λ是一個超參數用來平衡兩個損失。Lcls表示交叉熵損失函數,Lreg表示如下:

Lreg=∑3i=0smoothL1(δ[i],α)(8)

2.3追蹤階段

和Siamse-FC一樣,在該階段首先用第一幀中目標區域來初始化網絡,得到目標圖像特征,并在追蹤階段一直保持不變。接下來用不同范圍的搜索區域通過網絡得到搜索區域的圖像特征,用目標圖像特征作為卷積核,預測目標中心點位置。基于這個中心點,對于當前幀特征選取不同的預選框,并把它們規整到相同空間大小的特征維度,最后得到分類和回歸結果。

由于選取的錨點的數量并不會影響網絡參數,因此盡可能多地選取預選框以保證目標被包含。在推測階段,對于分類的結果,可能會有較多的錨點會產生較高的前景分數,因此需要對這些分數施加一定的約束。使用初始幀目標物體的大小和預選框的大小計算交并比(Intersection over Union, IoU)作為約束條件:

iou=area(ROIT∩ROIG)area(ROIT∪ROIG)(9)

pcls1,2,…,k=cls1,2,…,k·iou1,2,…,k(10)

其中:ROIT表示初始幀中目標區域;ROIG代表預選框的區域;“·”表示對應元素相乘;最終從pcls1,2,…,k中選取最大的分數作為當前幀分類的預測結果。用col、row作為第一階段預測的被追蹤物體的中心點,wan、han表示預選框的寬和長,則最后預測被追蹤目標的位置如下:

xpred=col+dx*wan

ypred=row+dy*han

wpred=wan*edw

hpred=han*edh(11)

另外,由于在訓練階段使用同一剪裁方式的候選圖片作為訓練集,而在推測階段,選用不同范圍的候選區域進行推測,因此回歸結果會產生偏差。對預測的{wpred,hpred}進行相應彌補:

wfi=wpred*p

hfi=hpred*p;p=1+c*(s-1)(12)

其中:s表示選取的比例;c表示約束條件。

3實驗與結果分析

3.1實驗方法

3.1.1數據集

實驗在目前非常具有挑戰性的三個數據集VOT2015、VOT2016和VOT2017上進行測試,VOT系列的數據集包含60個序列的視頻,并且每年數據集中的視頻會進行更新。

3.1.2數據維度

數據預處理和Siamse-FC保持一樣,假如某幀中被追蹤物體的大小為(w,h),則通過以下方式剪裁圖片:

A=2B;B=(w+p)×(h+p)(13)

其中:p=(w+h)/2;A是最終需要剪裁出的區域,然后將A調整到255×255。

3.1.3 預選框

本文預選框選擇的方式與Faster R-CNN選擇方式不同。Faster R-CNN選擇方式是根據不同的面積和寬高比進行選擇,而本文是根據步長來增加寬和高。在本文的實驗中這個步長設定為15,即輸入圖像的尺寸和輸出的相似性圖譜的大小的比例。另外為了平衡算法的速度和精度,最終挑選出15個不同的預選框來做最后的定位。

3.1.4訓練階段

本文的方法在ILSVRC-2015[24]和GOT-10K[25]數據集上進行離線訓練,其中:ILSVRC-2015包含了超過4000個序列,并且又分為30個基本類別;而在GOT-10K中大約包含563個不同的類別和87種不同的運動模式,但是相較ILSVRC-2015有更少的可訓練幀數。在這兩個數據集上進行相同的數據處理,隨機選取同一個視頻中兩幀作為訓練對,且這兩幀的時序間隔不超過100幀。隨后使用隨機梯度下降(Stochastic Gradient Descent, SGD)法對式(7)進行優化。訓練50個循環,初始學習率為10-2,隨后緩慢降低學習率到10-6。實驗在i5-6500 3.2GHz CPU上和GeForce GTX 1060 GPU上執行,在VOT中測試速度約為35frame/s。

3.2實驗結果

3.2.1VOT2015實驗結果

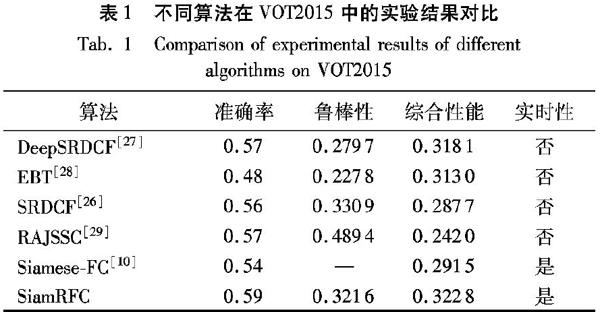

VOT系列是一個認可度比較高并且在追蹤領域非常受歡迎的單目標追蹤標準。 VOT2015中主要有兩個測量標準:重疊率和失敗次數。EAO(Expected Average Overlap)是考慮重疊率和失敗次數這兩個標準之后給出的算法綜合性能評估。將本文算法SiamRFC與目前在VOT2015排名靠前的算法進行對比,測試結果如表1所示。

表1中:SRDCF(learning Spatially RegularizeD Correlation Filters for visual tracking)[26]主要解決濾波器存在的邊界效應問題;DeepSRDCF[27]則是在SRDCF的基礎上,將手動的特征換為卷積網絡提取的特征;EBT算法[28]則結合區域檢測的思想;RAJSSC(Joint Scale-Spatial Correlation tracking with Adaptive Rotation estimation)[29]從目標旋轉的角度對跟蹤算法進行改進,從而可以減少由于目標轉動導致對于追蹤性能的影響。

從表1可以看出,本文的算法SiamRFC在準確率和綜合性能都優于其他算法,且與Siamese-FC相比各項性能都較大地超過了Siamese-FC算法,表明本文算法在實時性和性能方面都有較好的表現。

3.2.2VOT2016實驗結果

VOT2016和VOT2015具有相同的序列集,不同的是VOT2016使用了自動的方法對樣本進行重新標定。將本文算法SiamRFC和在VOT2016上排名靠前的追蹤算法進行比較,測試結果如表2所示。

表2中:CCOT(learning Continuous Convolution Operators for visual Tracking)[6]將學習檢測過程推廣到連續空間域(使用插值方法),可以獲得亞像素精度的位置; Staple[30]則是在同一回歸框架中融合互補因子,從而能夠很好處理光照變化對于目標追蹤效果的影響;MDNet_N[31]提出了一個基于卷積神經網絡的多領域學習框架,它將域無關的信息與域相關的信息分開,從而進行有效的追蹤。

從表2可以看出,本文的算法SiamRFC在準確率方面優于其他算法,表明了本文算法的優勢,可利用回歸方法直接得到被追蹤物體精確位置。

3.2.3VOT2017實驗結果

VOT2017和VOT2016不同的是,VOT2017將其中10個視頻替換成10個難度相對較大的序列;與此同時,還對所有的視頻進行重新標定。將本文算法SiamRFC和在VOT2017上排名靠前的追蹤算法進行比較,測試結果如表3所示。

表3中:其中SiamDCF(Discriminant Correlation Filters network for visual tracking)[32]把濾波器作為孿生網絡中特殊相關濾波器層;ECOhc(Efficient Convolution Operators for tracking)[1]則是在ECO算法的基礎上加入手動提取的特征;UCT(learning Unified Convolutional networks for real-time visual Tracking)[33]提出了一個基于卷積神經網絡的端到端的目標追蹤模型。從表3可以看出,盡管SiamDCF、CCOT在綜合性能EAO方面優于本文算法,但是本文算法的準確率大幅度優于這兩個算法,這也表明本文算法具有利用回歸的方法直接定位被追蹤物體方面的能力。另外,相較于Siamese-FC,本文算法在測試中各方面的能力都有較大提升。

4結語

本文算法結合了孿生網絡和檢測網絡:一方面具有孿生網絡在追蹤領域定位和實時性的優勢;另一方面,檢測網絡可以得到更精確的位置。本文算法在ILSVRC和GOT-10K進行離線訓練。在VOT系列上的測試結果表明,本文算法的性能都達到或者優于其他對比的實時性算法,驗證了本文算法的優越性。由于追蹤網絡依賴孿生網絡的預定位,因此,在接下來的工作中,我們將會嘗試利用注意力機制的方法提高孿生網絡的預定位精度。

參考文獻 (References)

[1]DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6931-6939.

[2]ZHANG M, XING J, GAO J, et al. Robust visual tracking using joint scale-spatial correlation filters [C]// Proceedings of the 2015 IEEE International Conference on Image Processing. Piscataway: IEEE, 2015: 1468-1472.

[3]LUKEzIC A, VOJIR T, ZAJC L C, et al. Discriminative correlation filter with channel and spatial reliability [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 4847-4856.

[4]GALOOGAHI H K, FAGG A, LUCEY S. Learning background-aware correlation filters for visual tracking [C]// Proceedings of the 2017 IEEE Conference on Computer Vision. Piscataway: IEEE, 2017: 1135-1143.

[5]QI Y, ZHANG S, QIN L, et al. Hedged deep tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4303-4311.

[6]DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9909. Cham: Springer, 2016: 472-488.

[7]NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4293-4302.

[8]NAM H, BAEK M, HAN B. Modeling and propagating CNNs in a tree structure for visual tracking [EB/OL]. [2019-01-22]. https://arxiv.org/pdf/1608.07242.pdf.

[9]WANG L, OUYANG W, WANG X, et al. STCT: sequentially training convolutional networks for visual tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 1373-1381.

[10]BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional Siamese networks for object tracking [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9914 . Cham: Springer, 2016: 850-865.

[11]HELD D, THRUN S, SAVARESE S. Learning to track at 100 fps with deep regression networks [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9905. Cham: Springer, 2016: 749-765.

[12]LI B, YAN J, WU W, et al. High performance visual tracking with Siamese region proposal network [C]// Proceedings of the 2018 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2018: 8971-8980.

[13]REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks [C]// Proceedings of the 2015 International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2015: 91-99.

[14]KRISTAN M, MATAS J, LEONARDIS A, et al. The visual object tracking VOT2015 challenge results [C]// Proceedings of the 2015 IEEE International Conference on Computer Vision Workshop. Piscataway: IEEE, 2015: 564-586.

[15]KRISTAN M, LEONARDIS A, MATAS J, et al. The visual object tracking VOT2016 challenge results? [C]// Proceedings of the 2016 IEEE International Conference on Computer Vision Workshop. Piscataway: IEEE, 2016: 777-823.

[16]KRISTAN M, LEONARDIS A, MATAS J, et al. The visual object tracking VOT2017 challenge results [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision Workshop. Piscataway: IEEE, 2017: 1949-1972.

[17]WANG Q, ZHANG M, XING J, et al. Do not lose the details: reinforced representation learning for high performance visual tracking [C]// Proceedings of the 2018 27th International Joint Conference on Artificial Intelligence. Menlo Park: AAAI Press, 2018: 985-991. http://www.dcs.bbk.ac.uk/~sjmaybank/VisualTrackingIJCAI2018.pdf.

[30]BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 1401-1409.

[31]NAM H, HAN B. Learning multi-domain convolutional neural networks for visual tracking [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 4293-4302.

[32]WANG Q, GAO J, XING J, et al. DCFNet: discriminant correlation filters network for visual tracking [EB/OL]. [2019-01-22]. https://arxiv.org/pdf/1704.04057.pdf.

[33]ZHU Z, HUANG G, ZOU W, et al. UCT: learning unified convolutional networks for real-time visual tracking [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision Workshop. Piscataway: IEEE, 2017: 1973-1982.

This work is partially supported by the National Natural Science Foundation of China (61602088), the Major Special Plan for Science and Technology of Guizhou Province (20183002).

DENG Yang, born in 1993, M. S. candidate. His research interests include computer vision, deep learning.

XIE Ning, born in 1983, Ph. D., associate professor. His research interests include machine learning, computer graphics.

YANG Yang, born in 1983, Ph. D., professor. His research interests include artificial intelligence, multimedia information processing.

收稿日期:2019-04-29;修回日期:2019-07-26;錄用日期:2019-08-16。

基金項目:國家自然科學基金資助項目(61602088);貴州省科技重大專項計劃項目(20183002)。

作者簡介:鄧楊(1993—),男,安徽六安人,碩士研究生,主要研究方向:計算機視覺、深度學習;謝寧(1983—),男,吉林長春人,副教授,博士,CCF會員,主要研究方向:機器學習、計算機圖形學;楊陽(1983—),男,遼寧大連人,教授,博士,CCF會員,主要研究方向:人工智能、多媒體信息處理。

文章編號:1001-9081(2019)12-3440-05DOI:10.11772/j.issn.1001-9081.2019081427