基于OpenPose-slim模型的人體骨骼關鍵點檢測方法

汪檢兵 李俊

摘 要:相較于2017年提出的在當時檢測效果近乎最優的RMPE模型與Mask R-CNN模型,原用于人體骨骼關鍵點檢測的OpenPose模型有著在保持精度近乎不變的情況下能大幅縮短檢測周期的優勢,但同時該模型也存在著參數共享率低、冗余度高、耗時長、模型規模太大等問題。針對上述問題,提出了新的OpenPose-slim模型。該模型減小網絡寬度,減少卷積塊層數,將原并列式結構改成序列式結構并于內模塊加入Dense連接機制,其處理過程主要分為3個模塊:1)關鍵點定位模塊,檢測出人體骨骼關鍵點的位置坐標;2)關鍵點聯系模塊,把關鍵點位置連接成肢體;3)肢體匹配模塊,進行肢體匹配得到人體輪廓。每一個處理階段之間關聯緊密。在MPII數據集、COCO數據集和AI Challenger數據集上的實驗結果表明,所提模型使用4個定位模塊和2個聯系模塊,并于每一個模塊內部使用Dense連接機制是最佳結構,與OpenPose模型相比,在保持檢測精度基本不變的基礎上,測試周期縮短為原來的近1/6,參數量縮小了近50%,模型規模縮小為近1/27。

關鍵詞:人體骨骼關鍵點檢測;姿態檢測;肢體;Dense連接機制;序列式結構

中圖分類號: TP183文獻標志碼:A

Human skeleton key point detection method based on OpenPose-slim model

WANG Jianbing1,2, LI Jun1,2*

(1. College of Computer Science and Technology, Wuhan University of Science and Technology, Wuhan Hubei 430065, China;

2. Hubei Province Key Laboratory of Intelligent Information Processing and Real-time Industrial System

(Wuhan University of Science and Technology), Wuhan Hubei 430065, China)

Abstract: The OpenPose model originally used for the detection of key points in human skeleton can greatly shorten the detection cycle while maintaining the accuracy of the Regional Multi-Person Pose Estimation (RMPE) model and the Mask Region-based Convolutional Neural Network (R-CNN) model, which were proposed in 2017 and had the near-optimal detection effect at that time. At the same time, the OpenPose model has the problems such as low parameter sharing rate, high redundancy, long time-consuming and too large model scale. In order to solve the problems, a new OpenPose-slim model was proposed. In the proposed model, the network width was reduced, the number of convolution block layers was decreased, the original parallel structure was changed into sequential structure and the Dense connection mechanism was added to the inner module. The processing process was mainly divided into three modules: 1) the position coordinates of human skeleton key points were detected in the key point localization module; 2) the key point positions were connected to the limb in the key point association module; 3) limb matching was performed to obtain the contour of human body in the limb matching module. There is a close correlation between processing stages. The experimental results on the MPII dataset, Common Objects in COntext (COCO) dataset and AI Challenger dataset show that, the use of four localization modules and two association modules as well as the use of Dense connection mechanism inside each module of the proposed model is the best structure. Compared with the OpenPose model, the test cycle of the proposed model is shortened to nearly 1/6, the parameter size is reduced by nearly 50%, and the model size is reduced to nearly 1/27.

Key words: human skeleton key point detection; attitude detection; limb; Dense connection mechanism; sequential structure

0 引言

隨著人工智能(Artificial Intelligence, AI)時代的到來,描述人體姿態、預測人體行為的應用研究在不斷進行。人體姿態檢測,實現關鍵物體分析,自動還原人體姿態,在行為檢測(利用深度學習技術可以精確檢測人物異常行為)、行為識別(快速精確識別人體動作中的各種姿態)、視頻捕捉(精確捕捉視頻的精彩瞬間)和計算機圖形學等領域都有著廣泛的應用價值和豐富的業務場景。

在人體骨骼關鍵點檢測的任務中,傳統模型方法存在以下一些難題:1)每張圖片的人數及出現位置不定,姿態各異,無法提前預知,給空間信息的獲取帶來困難;2)檢測周期會隨著識別人數的增加而不斷變長;3)檢測的魯棒性不強,泛化能力差,無法將對人體的檢測系統方便移植到其他的檢測系統中。 Cao等[1]提出了最新的OpenPose模型,相較于到2017年為止檢測性能各項指標近乎最優的RMPE(Regional Muti-person Pose Estimation)模型[2]和Mask R-CNN(Region-based Convolutional Neural Network)模型[3]有著在保持檢測精度基本不變的情況下能夠大幅度縮短關鍵點檢測周期的優勢,但是也存在著參數共享率低、冗余度高、耗時長、模型太大等不足之處。

本文在OpenPose模型[1]基礎上進行改進,并提出了新的OpenPose-slim模型,對原模型的結構主要作出如下改進:1)減小網絡結構的寬度;2)減少3×3卷積核,增加1×1卷積核,不僅可以緩和降維,而且可以突出非線性,減少計算量;3)改并列式結構為序列式結構,降低模型的復雜度;4)使用6個階段(4個關鍵點定位階段和2個肢體連接階段);5)前4個階段和后2個階段分別使用Dense連接機制,大幅提高了參數之間的共享率,并降低了參數冗余度。在MPII數據集、COCO(Common Objects in COntext)數據集和AI Challenger數據集[4]上的實驗結果表明,與OpenPose模型相比,所提模型在保持檢測精度基本不變的基礎上,測試周期縮短為原來的近1/6,參數量縮小了近50%,模型規模縮小為近1/27。

1 相關工作

傳統的姿態檢測算法是基于模板匹配的幾何計算方法,關鍵是利用多種模板控件進行多維度建模做出適用性更強的模板以適配整個人體結構,但都是基于人工或簡單算法實現的匹配,其工作量非常大,精度也很難達到預期要求。近幾年來,姿態檢測方法主要分為兩類:自頂向下方式(順序是先確定出人的位置,再檢測每人的可見關鍵點)和自底向上方式(順序是先檢測可見關鍵點,再確定其屬于哪個人)。近年來的姿態研究主要分為單人姿態研究和多人姿態研究。

單人姿態方面,Ke等[5]在視頻多幀人體姿態檢測系統研究中提出姿態檢測本質上是檢測模型的思想,組合兩個AlexNet模型的特征圖作為輸出,使用簡單數據增強的方法在

FLIC數據集上的實驗結果表明相較于傳統檢測算法精度提高了5%;Newell等[6]提出Stacked Hourglass網絡結構,將自頂向下方向的下采樣與自底向上方向的上采樣進行綜合處理,每個漏斗樣式的結構按照一定模式組合在一起,該模型以正確估計關鍵點比例PCKh(Percentage of Correct Keypoints of head)@0.5=90.9%的優異成績在2016年MPII競賽中暫居榜首。Chen等[7]對其做出了改進,采用生成對抗網絡 (Generative Adversarial Network, GAN)的方法進行微調,整體精度提高0.2%。

多人姿態方面,不同于單人姿態,多人姿態另需考慮肢體匹配到人體的誤差,比較好的多人姿態研究在單人姿態應用上的效果并不好。Rajchl等[8]提出了自頂向下的DeepCut網絡結構,首先找出候選的關鍵點,使用空間聯系優化算法得到每一對關鍵點屬于哪個人,找到其內在聯系;Insafutdinov等[9]又提出DeeperCut結構,添加殘差模塊,在MPII多人姿態數據集上表現出mAP(mean Average Precision)[10]為60.5%。Insafutdinov等[11]提出了名為ArtTrack的無約束多人跟蹤模型,使用稀疏體簡化圖結構相較于DeeperCut不僅速度快20%,而且關鍵點匹配準確率高5%。2017年, Fang等[2]提出了自頂向下RMPE模型,多人姿態檢測精度mAP [10]在MPII數據集上達到了76.7%;同年, He等[3]提出了自頂向下的Mask R-CNN新模型,該模型在實例語義分割任務中和關鍵點檢測任務中表現優異,截至2017年,這兩種模型檢測評估結果近乎達到最優。后來, Cao等[1]提出了自底向上全新的OpenPose模型,使用一種對關鍵點聯系的非參數表示方法——部分親和字段(Part Affinity Fields, PAFs )方法 [1,12],完成了從關鍵點檢測到肢體連接再到人體骨架的構建過程,相較于前兩種模型,在MPII數據集和COCO數據集上的實驗結果表明檢測精度基本一致,但該模型在檢測周期上表現出了不隨人數的增加而延長的魯棒性;但與此同時,該模型也存在參數共享率低、冗余度高、耗時長、模型太大等不足之處。2 OpenPose模型

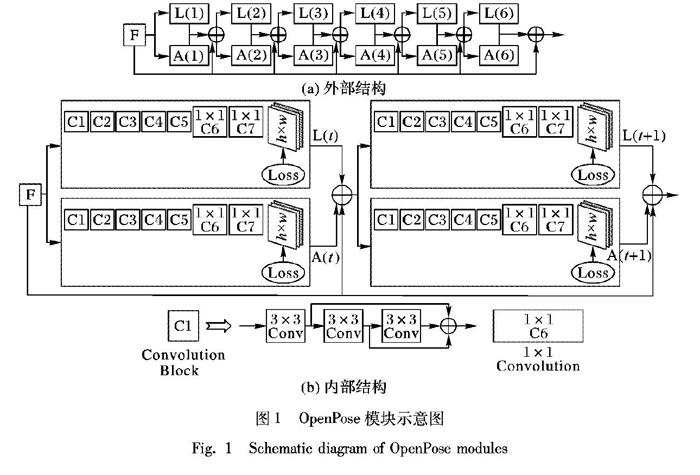

OpenPose模塊示意圖如圖1所示。

圖1(a)描述了OpenPose[1]的外部框架結構。首先,輸入圖片經過VGG-19結構的前10層得到特征圖(feature map)F, 接著由特征圖作為多階段輸入,每一個階段分為兩部分:一部分是Localization模塊(圖1中的L(·)部分),用于關鍵點定位;另一個是Association模塊(圖1中的A(·)部分),用于連接候選關鍵點組成連接肢體。大體結構共分為12(2×6)個階段,過多階段數會耗費更多計算資源,而且沒有參數跨層共享機制,容易生成較多冗余數據。

圖1(b)描述了OpenPose[1]內部網絡層結構,其中Convolution Block部分是3個3×3卷積核所組成的小殘差網絡結構,每隔一層都有跳躍連接。為了在提取高層特征信息和空間紋理信息的同時,也不會使得底層的信息被全部忽略,于是將底層的特征信息與高層的特征進行一定程度上的連接,可解決層數過多時導致的梯度消失問題,使用多個3×3卷積核代替5×5或7×7卷積核也可一定程度上減少參數。其后使用1×1卷積核,不僅可用于升維和降維,并且可以增強非線性趨勢,使得網絡變得更深以提取更高層特征。

3 OpenPose-slim模型

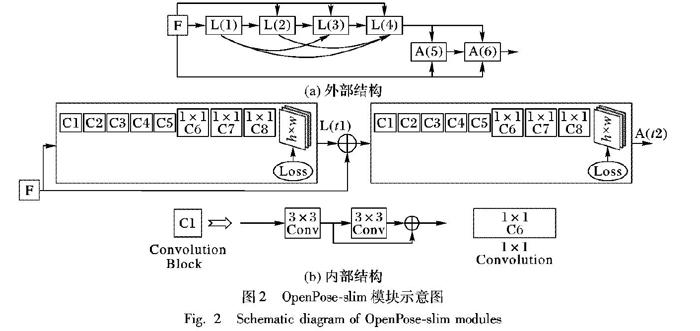

圖2(a)描述了OpenPose-slim的外部框架結構,與OpenPose模型[1]在外部細節結構上大體相同,不同之處在于外部結構中使用序列式L-A結構,而不是并列式L-A結構,大體結構只有6個小階段,相較于OpenPose模型[1]的12個大階段而言,大幅減小了參數使用量,也縮短了檢測處理時間;且參考文獻[13-14]提出的DenseNet,在Localization模塊和Assocation模塊中分別使用Dense連接結構,如此能提高參數的共享性,減少參數冗余量和模型大小。如實驗5.3節所示,在COCO數據集上的實驗結果表明:總計使用6個階段(分別在4個Localization階段與2個Association階段使用Dense連接機制)的效果最好,相較于(3-L,3-A)結構精度高,表明Localization的過程優化所需要的層數比Association所需的層數更重要;相較于(4-L,2-A)和(4-L(Dense),2-A)結構精度也略高,表明Dense連接對精度提高和參數傳遞很有幫助。后面的實驗都是默認在基于6階段(4-L,2-A)(Dense)的基礎上進行。

圖2(b)描述了OpenPose-slim模型的內部結構,在原OpenPose模型[1]基礎上做出的改進是每個Convolution Block中去掉了一個3×3卷積核,并在L-Block和A-Block中添加一個1×1卷積核分別用于升維和降維。該模型是原OpenPose模型[1]的改進模型,在保持精度基本不變的前提下,大幅縮短了檢測周期且縮小了模型規模。

表1詳細描述了OpenPose-slim模型每一個階段卷積核數目,R*與Y*分別代表左邊的Convolution Block與右邊的Convolution塊,OUTPUT代表該階段輸出的通道數。由表1可知,Localization模塊輸出的通道數高達1408,Association模塊輸出的通道數只有896,最后Detector的輸出通道數為(關鍵點數×關鍵點狀態),即14×3=42。

4 模型整體研究過程

本文模型整體研究過程主要分為三個模塊,如圖3所示,分別是:Localization(關鍵點定位模塊)、Association(關鍵點聯系模塊)和Matching(肢體匹配模塊)。關鍵點定位模塊主要是為了從圖像數據中獲取到每類候選關鍵點位置以及該關鍵點的置信度,關鍵點聯系模塊主要是為了從各個候選關鍵點中得到每一對異類關鍵點之間的候選肢體以及該肢體的置信度值,肢體匹配模塊是在候選肢體中進行匹配以期選出合適的肢體構建整個人體的骨架。

4.1 Localization

模型輸入端為彩色圖像數據,從VGG-19的前10層提取高層特征信息得到特征圖Feature map,接著輸入到用作關鍵點分類和回歸的模型L(t)中,再經過非極大值抑制 (Non-Maximum Suppression, NMS)算法[15]得到離散化的候選關鍵點集合和每個候選關鍵點的置信度圖Confidence map,每一個關鍵點的置信度圖分為x與y兩個方向上的向量,包括x方向上的向量信息和y方向上的向量信息,兩個方向上的合向量表示該關鍵點的置信度Confidence。除此之外,還有對每一個關鍵點的定位信息。

4.2 Association

根據從關鍵點定位階段輸出的每個候選關鍵點相對于第j號關鍵點的置信度,輸入A(t)中經過PAFs算法[1,12]處理得到每一對候選關鍵點之間的候選肢體集合及每條候選肢體的置信度圖。

首先,計算任意一點p在肢體c上的置信度,如式(1)所示:如果點p在肢體c上,則點p相對于肢體c的置信度為肢體c方向上的單位向量;否則為零向量。其中,判斷點p是否在肢體c上的方法如圖4(a)和式(2)~(3)所示。

Ac(p)=ν, 點p在肢體c上

0,其他 (1)

0≤ν·(p-xj1)≤lc(2)

|νT·(p-xj1)|≤σc(3)

其中: j1與j2為兩個不同類的關鍵點;定義ν向量為從j1指向j2方向上的單位向量,νT向量為ν向量的垂直向量;lc為肢體c的長度;σc為肢體c的寬度;xj1表示候選關鍵點j1的位置坐標。

接著,使用定積分求出肢體c上所有點的置信度圖和代表肢體c的置信度Ec,由肢體c上所有點置信度在c上求定積分后單位化所得,目的是為了在后面作匹配的時候可以統一度量,如式(4)~(5):

Ec=∫u=1u=0Ac(p(u))·dj2-dj1‖dj2-dj1‖2 du(4)

p(u)=(1-u)·dj1+u·dj2(5)

式中:p(u)代表取遍j1到j2之間的任意一點,其中0≤u≤1。

4.3 Matching

獲得每一條肢體置信度后,就按照某一種方案去作匹配,本文提供兩種匹配方案,分別是全連接匹配方式和最大二分圖匹配方式。將匹配結果中所有肢體置信度求和,找出最大的匹配結果為最終的候選匹配集合。

三類關鍵點之間的兩種匹配方案如圖4(b)所示,圖中左右框代表兩個人,每一組關鍵點之間四條線(粗實線和細虛線)中的某一種線是一種匹配結果,其中粗實線是正確匹配方式,細虛線是錯誤匹配方式。全連接匹配方式是四條線全部考慮在內的匹配方式,而最大二分圖匹配方式是粗實線或細虛線的兩條線匹配方式,它要求任意兩條線沒有公共節點。所以,含有公共點的細虛線是錯誤的匹配方式,其邊權和Ec為0;粗實線是正確的匹配方式,其邊權和Ec為2ν。

不同模型在COCO數據集上的測試結果如圖5所示。圖5(a)是四種模型隨著關鍵點數目增加而引起的mAP[10]指標在關鍵點上的平均加權變化曲線,圖中OpenPose-slim的關鍵點檢測數目略小于OpenPose模型[1] ,其檢測的mAP[10]指標相較于OpenPose模型[1]僅差0.01。圖5(b)是四種模型隨著幀數不斷增加而計算出的FPS指標的平均加權變化曲線,OpenPose-slim模型的FPS指標約是OpenPose模型[1]的5倍,且不會隨著檢測幀數的增加而明顯減小(即檢測周期明顯變長),而Mask R-CNN模型[3]與RMPE模型[2]會隨著檢測幀數的變化而導致檢測周期變長。

5.3 結構對比實驗

不同階段數分配方案的結果對比如表5所示。表5結果表明:6個Stages(4個的Localization 模塊和2個Association模塊分別使用Dense連接)效果最佳。由Stages=3和Stages=4所知,當Stages使用較少時,表現出精度明顯不夠的情況;但是當Stages過多時,如Stages=7,mAP [10]表現出下降趨勢。宏觀方面,原因是:隨著階段越來越多,后面的階段會不斷作局部參數優化,而導致“斷層”現象,即高層特征提取器提取的信息和低層特征提取器提取的信息不能綜合起來,將閾值設置為0.90,則對于更高層信息的獲取就更難,表現出平均精度(AP)也會下降得非常大。微觀方面,原因是:隨著階段數的增加,梯度容易消失,在反向傳播過程中,參數更新非常細微以至于沒有變化,即使使用一定的殘差結構,但也只能解決部分問題,其根本性問題還是沒有完全解決。實驗結果中,使用(4-L 2-A)(Dense)結構比包括(4-L 2-A)和(4-L(Dense) 2-A)在內的其他結構效果都好,表明Dense結構對參數的共享效果相較于普通的殘差神經網絡ResNet(Residual Network)要好,對精度的提高也會表現得更優異。

5.4 系統不足

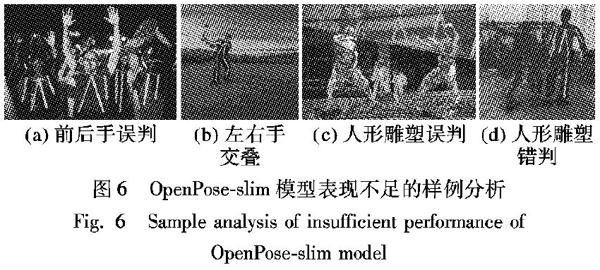

如圖6所示,OpenPose-slim模型也存在一些表現不足的問題:1)圖6(a)中,站在前面的人的手無法檢測出來,而被誤判為后面的人手;圖6(b)中,左右手錯亂交疊在一起,模型沒能準確區分開。2)圖6(c)和圖6(d)中,人與人形雕塑出現判誤問題。

6 結語

本文提出的人體骨骼關鍵點檢測OpenPose-slim模型,是在先前研究的OpenPose模型[1]基礎上進行的改進,可對人體骨骼關鍵點進行精準定位,并以連線的方式將人物的動作用計算機的視覺呈現出來。本文主要解決了以下問題:1)對原模型OpenPose[1]做出多處改進,在保證精度基本不變的情況下,大幅提高了時間效率,減少了參數計算量,縮小了模型規模,進一步滿足了嚴任務高需求。2)從模型結構角度分析使用何種模型結構對本文模型最有利,實驗分析得出,使用Dense連接的6個階段(4個關鍵點定位階段+2個肢體連接階段)最為合適,不僅精度達到了最高要求,而且耗時相對較短。3)本文從三個大階段去分析整個姿態檢測的過程,包括關鍵點定位階段、關鍵點聯系階段和肢體匹配階段,這三個階段緊緊相連、相互制約、相互影響。

與此同時,該檢測系統也存在一些局限性,有些問題沒有給出較好的解決方案:1)不足案例表現出多種待解決問題,如多姿態雜亂的圖片中肢體交疊在一起的問題,人物和人形雕塑無法分辨問題,占比面積較小的人體關鍵點無法精準定位和檢測問題等。2)階段數過多會導致設備內存溢出,故在結構分析過程中只設計到7個階段,受到設備硬件要求,只能暫時對3~7個階段進行分析對比,找到局部性最優解。3)隨著Slim-Block的不斷增多和層數的不斷深入,使用DenseNet連接結構的復雜性帶來高精度和參數共享優化的同時也會帶來參數傳遞的冗余問題。4)模型僅限于有大量優質數據集的人體姿態檢測,對無大量優質數據集的其他類別無法完成檢測。5)模型規模還是偏大,仍然有可縮小優化的空間。

針對以上5個問題,接下來分別可從以下方向進行研究:1)由于本文所述的關鍵點匹配方案存在由多節點姿態形式各異導致的關鍵點與其他人關鍵點之間出現錯配問題時有發生,可以從關鍵點匹配階段對模型進一步優化。2)可使用更優的GPUs計算資源進行實驗,找到該模型的最優結構。3)Veit等[20]提出新的可行的Adaptive-Inference領域,對于不同的應用,通過合適的自適應推理算法獲得最合適的模型。4)可在GAN研究領域和半監督學習與無監督學習[21]研究領域做到高質量數據增強效果,給姿態研究領域乃至深度學習領域的數據問題做出根本性貢獻。5)在保持精度和耗時基本不變的前提條件下或在滿足基本要求的范圍內,將模型慢慢做小,以適用于更底層的超低內存容量,應用在高需求的芯片硬件設備應用場景,比如自動監控等基礎設施中。

參考文獻 (References)

[1]CAO Z, HIDALGO G, SIMON T, et al. OpenPose: realtime multi-person 2D pose estimation using part affinity fields [EB/OL]. [2018-12-30]. https://arxiv.org/pdf/1812.08008.pdf.

[2]FANG H, XIE S, TAI Y W, et al. RMPE: regional multi-person pose estimation [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 2353-2362.

[3]HE K, GKIOXARI G, DOLLR P, et al. Mask R-CNN [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 2980-2988.

[4]WU J, ZHENG H, ZHAO B, et al. AI challenger: a large-scale dataset for going deeper in image understanding [EB/OL]. [2018-12-30]. https://arxiv.org/pdf/1711.06475.pdf.

[5]KE L, QI H, CHANG M C, et al. Multi-scale supervised network for human pose estimation [C]// Proceedings of the 2018 IEEE International Conference on Image Processing. Piscataway: IEEE, 2018: 564-568.

[6]NEWELL A, YANG K, DENG J. Stacked hourglass networks for human pose estimation [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9912. Cham: Springer, 2016: 483-499.

[7]CHEN Y, SHEN C, WEI X, et al. Adversarial PoseNet: a structure-aware convolutional network for human pose estimation [C]// Proceedings of the 2017 IEEE International Conference on Computer Vision. Piscataway: IEEE, 2017: 1212-1230.

[8]RAJCHL M , LEE M C H, OKTAY O , et al. DeepCut: object segmentation from bounding box annotations using convolutional neural networks [J]. IEEE Transactions on Medical Imaging, 2017, 36(2): 674-683.

[9]INSAFUTDINOV E, PISHCHULIN L, ANDRES B, et al. DeeperCut: a deeper, stronger, and faster multi-person pose estimation model [C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9910. Cham: Springer, 2016: 34-50.

[10]HENDERSON P, FERRARI V. End-to-end training of object class detectors for mean average precision[C]// Proceedings of the 2016 Asian Conference on Computer Vision, LNCS 10115. Cham: Springer, 2016: 198-213.

[11]INSAFUTDINOV E, ANDRILUKA M, PISHCHULIN L, et al. ArtTrack: articulated multi-person tracking in the wild [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 1293-1301.

[12]ZHU X, JIANG Y, LUO Z. Multi-person pose estimation for posetrack with enhanced part affinity fields [EB/OL]. [2018-12-30]. https://posetrack.net/workshops/iccv2017/pdfs/ML_Lab.pdf. // Proceedings of the 2017 IEEE International Conference on Computer Vision PoseTrack Workshop. Cham: Springer, 2017,1-4.

[13]HUANG G, LIU Z, VAN DER MAATEN L, et al. Densely connected convolutional networks [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 2261-2269.

[14]黃奕暉,馮前進.基于三維全卷積DenseNet的腦膠質瘤MRI分割[J].南方醫科大學學報,2018,38(6):661-668.(HUANG Y H, FENG Q J. Segmentation of brain tumor on magnetic resonance images using 3D full-convolutional densely connected convolutional networks [J]. Journal of Southern Medical University, 2018, 38(6): 661-668.)

[15]HOSANG J, BENENSON R, SCHIELE B. Learning non-maximum suppression [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 6469-6477.

[16]李默涵,王宏志,李建中,等.一種基于二分圖最優匹配的重復記錄檢測算法[J].計算機研究與發展,2009,46(S2):339-345.(LI M H, WANG H Z, LI J Z, et al. Duplicate record detection method based on optimal bipartite graph matching [J]. Journal of Computer Research and Development, 2009, 46(S2): 339-345.)

[17]WANG Z, FENG Z, ZHANG P. An iterative Hungarian algorithm based coordinated spectrum sensing strategy [J]. IEEE Communications Letters, 2011, 15(1): 49-51.

[18]PAPANDREOU G, ZHU T, KANAZAWA N, et al. Towards accurate multi-person pose estimation in the wild [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2017: 3711-3719.

[19]黃龍,楊媛,王慶軍,等.結合全卷積神經網絡的室內場景分割[J].中國圖象圖形學報,2019,24(1):64-72.(HUANG L, YANG Y, WANG Q J, et al. Indoor scene segmentation based on fully convolutional neural networks [J]. Journal of Image and Graphics, 2019, 24(1): 64-72.)

[20]VEIT A, BELONGIE S. Convolutional networks with adaptive inference graphs [C]// Proceedings of the 2018 European Conference on Computer Vision, LNCS 11205. Cham: Springer, 2018: 3-18.

[21]徐毅瓊,葛臨東,王波,等.基于非監督學習神經網絡的自動調制識別研究與實現[J].計算機應用與軟件,2011,28(1):79-81,95.(XU Y Q, GE L D, WANG B, et al. On automatic modulation recognition based on unsupervised learning neural networks and its implementation [J]. Computer Applications and Software, 2011, 28(1): 79-81, 95.)

This work is partially supported by the National Natural Science Foundation of China (61572381), the Fund from Hubei Province Key Laboratory of Intelligent Information Processing and Real-time Industrial System (Wuhan University of Science and Technology) (znxx2018QN06).

WANG Jianbing, born in 1998. His research interests include computer vision, adaptive reasoning.

LI Jun, born in 1978, Ph. D., associate professor. His research interests include intelligent computing, machine learning.

收稿日期:2019-06-06;修回日期:2019-07-30;錄用日期:2019-07-31。基金項目:國家自然科學基金資助項目(61572381);武漢科技大學智能信息處理與實時工業系統湖北省重點實驗室基金資助項目(znxx2018QN06) 。

作者簡介:汪檢兵(1998—),男,江西九江人,CCF會員,主要研究方向:計算機視覺、自適應推理; 李俊(1978—),男,湖北黃石人,副教授,博士,主要研究方向:智能計算、機器學習。

文章編號:1001-9081(2019)12-3503-07DOI:10.11772/j.issn.1001-9081.2019050954