基于RPN與B-CNN的細粒度圖像分類算法研究

趙浩如 張 永 劉國柱

(青島科技大學信息科學技術學院 山東 青島 266000)

0 引 言

作為計算機視覺的重要研究方向,圖像分類[1]問題一直備受學者關注。圖像分類又包括對象級分類,如對貓和狗進行分類。還包括細粒度分類[2],如對狗的不同品種進行分類。由于細微的類內差異,往往只能借助微小的局部差異才能分出不同的子類別,使得細粒度分類十分具有挑戰性。細粒度分類的方法主要包括兩種:一種是基于強監督的分類模型,如Part-based R-CNN[3]不僅需要物體級標注,還需要局部區域的標注,這大大限制了在實際場景的應用;另一種是基于弱監督的分類模型,如B-CNN[4]僅僅需要圖像級別的標注,不需要局部信息的標注。因此,基于弱監督的分類模型在識別精度上要比基于強監督的分類模型差一些。Huang等[5]提出了Part-Stacked CNN進行細粒度分類。這個網絡需要提供對象及部位級標簽,它分為定位網絡和分類網絡兩個子網絡,采用經典的AlexNet網絡結構作為整個網絡的基本結構。Shen等[6]提出一種迭代的傳遞策略來優化目標框,借助對象及部分級標注框進行細粒度分類。Yao等[7]提出了多級的由粗到細的目標描述方法進行細粒度分類,不需借助標注框,但識別率不如最前沿的算法。Liu等[8]提出了基于全連接的注意力機制的網絡結構進行細粒度分類,未考慮各層特征間的聯系。Murabito等[9]提出顯著性特征分類網絡(SalClassNet)。它包括兩個子網絡,網絡A計算輸入圖片的顯著性特征,網絡B計算網絡A輸出的顯著性特征進行細粒度分類,計算顯著性特征首先要計算圖像像素對應正確分類標準化分數梯度的絕對值,然后取三個顏色通道的最大值,因此,計算成本太高。綜上,為避免人工標注部位級標簽花費的巨大時間,以及減少計算成本。本文提出利用soft-nms和OHEM優化RPN算法得到更精確的對象級標注,以防止背景的干擾,同時改進B-CNN網絡,加強不同層特征間的空間聯系,提高識別精度。

1 算法描述

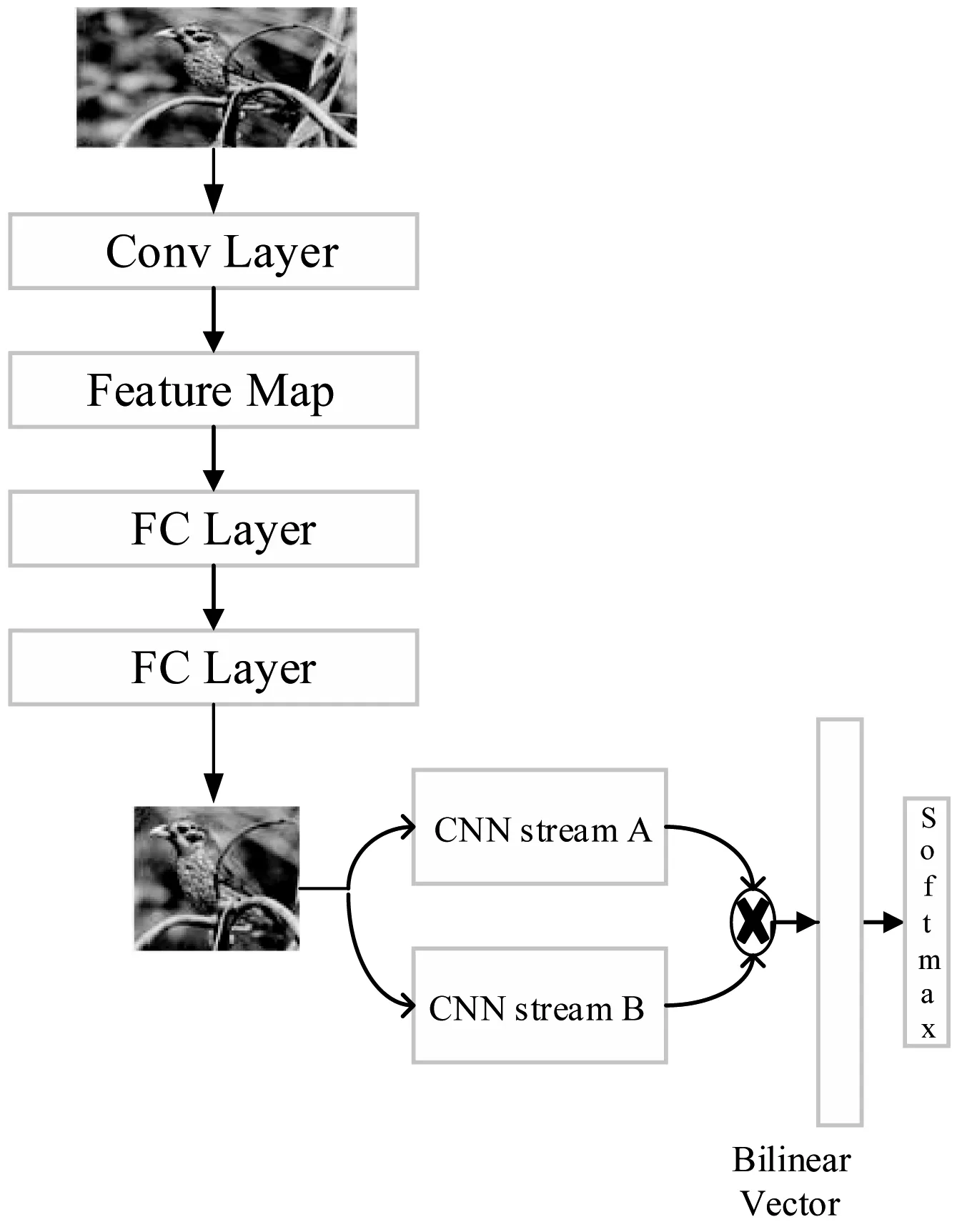

為利用細微的類內差異,本文采用OHEM[10]篩選出對識別結果影響大的數據,可以有效防止無關信息的干擾。然后,利用soft-nms[11]優化RPN[12]網絡,選擇出置信度更高的目標所在區域。最后,改進B-CNN網絡結構對目標區域進行細粒度分類,具體的算法流程如圖1所示。

圖1 算法流程圖

1.1 獲取目標區域

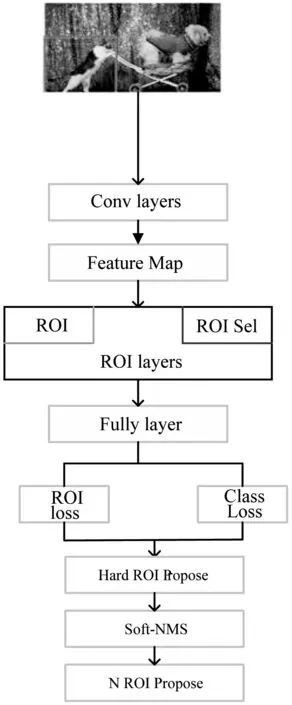

RPN網絡的作用是輸入一張圖像,輸出置信度排名前N個目標可能在的區域。本文利用OHEM篩選出對最終識別結果影響大的樣本,并用篩選后樣本進行隨機梯度下降。去除了對識別結果影響小的樣本后,有效防止過擬合,具體算法流程如圖2所示。

圖2 獲取目標區域算法描述圖

圖2中,OHEM有兩個不同的ROI網絡。左邊的ROI網絡只負責前向傳播計算誤差,右邊的ROI網絡從左邊的ROI網絡中通過對誤差排序,選出誤差大的樣本作為右邊ROI網絡的輸入。RPN網絡輸出的矩形目標框Di,其得分fi的計算如下:

(1)

式中:Si是重疊框的交集的面積;S是重疊框的并集的面積。

NMS(Non-maximum suppression)是RPN中重要的組成部分。RPN輸出一系列的檢測框Di以及對應的分數fi。NMS設置常數閾值τ,當檢測框的得分大于閾值τ,將其放入最終的檢測結果集合D。同時,集合D中任何與檢測框M的重疊部分大于重疊閾值τ的檢測框,被強制歸零并移除。非最大抑制算法中的最大問題就是將相鄰檢測框的分數均強制歸零后,如果真實的物體在重疊區域出現,則將導致對該物體的檢測失敗并降低了算法的平均檢測率。soft-nms不將大于閾值τ的相鄰目標框得分重置為0,而是乘以一個衰減函數。選取所有的目標框中得分最高的N個,這樣可以有效減少假陰性的概率,提高平均識別率。具體計算如下:

(2)

1.2 基于深度學習進行細粒度分類

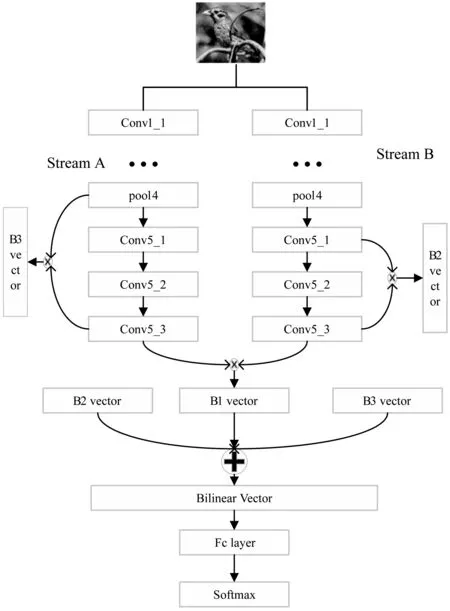

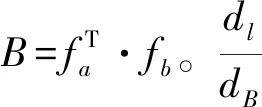

Bilinear CNN模型包括Stream A和Stream B,Stream A和Stream B的網絡結構都是采用的VGGNet。Stream A的作用是對物體的局部信息進行定位,而Stream B則是對Stream A檢測到的局部信息進行特征提取。兩個網絡相互協調作用,完成了細粒度圖像分類過程中兩個最重要的任務:物體、局部區域的檢測與特征提取。本文在B-CNN基礎上增加了兩個外積操作,外積計算如下:

B=fTA·fB

(3)

雙線性特征B2、B3分別是conv4_3的特征與conv5_3的特征,conv5_1的特征與conv5_3的特征進行點乘得到的。然后將雙線性特征B2、B3與原有的conv5_3層特征與conv5_3層特征點乘得到的雙線性特征B1拼接起來,以加強不同層特征間的空間聯系。最后,將拼接后的特征B送進全連接層,進行softmax分類。具體算法流程如圖3所示。

圖3 改進的B-CNN算法流程圖

(4)

(5)

2 實驗仿真

2.1 實驗背景

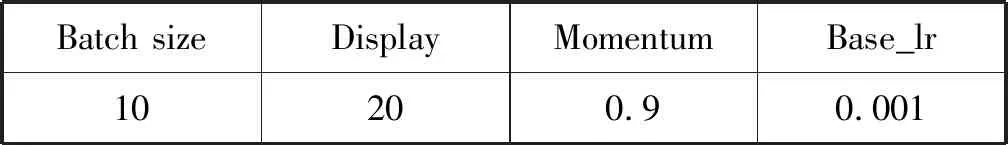

為驗證本算法的有效性,與文獻[5-9]中的算法的結果進行對比。文獻[5-9]分別采用CUB200-2011數據集[14]與Standford Dogs數據集[15]。因此本文也在兩組數據集上進行兩組實驗,來證明本算法的識別精度比文獻[5-9]中的結果高。第一組實驗是在CUB200-2011數據集進行的測試和驗證。該數據集是最常用和經典的細粒度分類數據集,包括200中不同類別,共11 788張不同鳥類圖片,不僅提供了對象級標注框而且還提供了局部級標注框。第二組實驗是在Standford Dogs數據集[15]進行測試和驗證。該數據集包括120類狗的圖像數據,共有20 580張圖片,只提供對象級標注框。基于RPN與B-CNN的細粒度分類過程中所用到的主要參數如表1所示。

表1 B-CNN主要參數表

2.2 實驗結果與分析

本文利用OHEM與soft-nms優化RPN,獲取對象級標注,然后輸入到改進的B-CNN。在RPN階段,訓練集、驗證集和測試集的比例是7∶2∶1。采取的Anchor的尺度是(128,256,512),比例為(0.5,1,2),共九種。將一張圖片輸入到RPN就會產生大量的Anchor,對這些Anchor進行soft-nms,最終輸出得分最高的目標框。在目標框提供的位置上剪貼圖片,剪貼后的圖片只含有目標對象,沒有背景的干擾。B-CNN階段中訓練集,驗證集與測試集的比例是7∶1.5∶1.5。在ImageNet中1 000類分類訓練好的參數的基礎上,在CUB200-2011數據集進行微調。將圖片輸入到B-CNN后,Stream A的作用是對圖像中對象的特征部位進行定位,而Stream B則是用來對Stream A檢測到的特征區域進行特征提取。兩個網絡相互協調作用,完成了細粒度圖像分類過程中兩個最關鍵的任務。

本文采用softmax函數做分類函數輸出一個概率值,計算公式如下:

(6)

式中:Si是第i個類別的概率值;ei是第i個類別的得分。

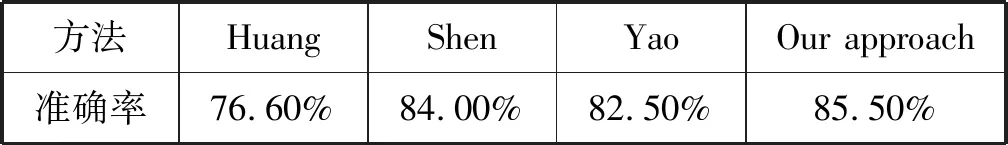

與文獻[5-6]借助對象級及部位級標注框進行細粒度分類對比,本文僅僅采用了對象級標注框。與文獻[7]利用迭代的方法獲取對象級與部位級標注框對比,本文利用RPN提取目標區域,并將深度學習框架的注意力[16]全放在目標區域,防止無關信息的干擾,提高識別速度與精度。實驗結果如表2所示。實驗表明,本文的算法識別率為85.5%,比文獻[5-7]中的方法分別高了8.90%、1.5%、3.0%。證明本文提出的基于RPN與B-CNN的細粒度分類算法,將識別的重心放在目標區域內。利用B-CNN優化目標區域的同時,在目標區域內提取特征,不僅不需要提供額外的部位級標注框,并且準確率有較大提高。

表2 不同方法在CUB200-2011數據集的識別率

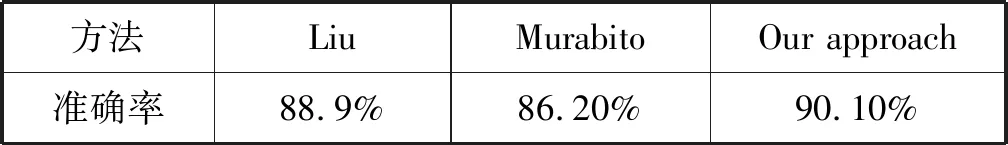

Standford Dogs數據集是從ImageNet數據集中提取狗的類別組成的。本文在第一組實驗獲取的參數基礎上進行微調,實驗結果如表3所示。與文獻[8]基于對象級與部位級標注框與注意力機制相比,雖然兩者都將識別重心放在目標區域,但本文在僅僅使用對象級標注框的前提下,利用外積將B-CNN的Strean A與Stream B統一成一個端到端的訓練模型。與文獻[9]使用SalClassNet網絡提取顯著性特征,并對顯著性特征進行細粒度分類相比,本文使用對象級標注框在ROI區域上進行特征提取。因此,識別率分別比文獻[8]和文獻[9]的方法高了1.2%和3.9%。這表明同時對標注框與類別進行端到端的訓練能有效提高識別率。

表3 不同方法在Standford Dogs數據集的識別率

此外,對本文提出的算法,增加了5組對比實驗分別為:方案一,不使用OHEM優化RPN,不改變B-CNN網絡結構;方案二,不使用soft-nms優化RPN,不改變B-CNN網絡結構;方案三,在使用OHEM及soft-nms的前提下,不增加B-CNN 的外積操作;方案四,僅增加B-CNN的外積操作;方案五,使用OHEM及soft-nms,同時增加B-CNN的外積操作。實驗對比結果如表4所示。實驗結果表明,方案五的識別率為90.10%,比方案一、方案二、方案三、方案四分別高了2.9%、2.3%、1.6%、1.1%。方案一僅使用OHEM,僅有效地防止了過擬合;方案二僅使用soft-nms,使輸出的對象級標注更加準確,并減少了假陰性概率;方案三則結合了方案一與方案二,識別率有所提升;方案四僅增加B-CNN的外積操作,加強了不同層之間的空間聯系。這表明使用OHEM與soft-nms改進RPN,能讓獲得的對象級標注更加精確,既可以避免背景的干擾,減少假陰性,又能有效防止過擬合。而增加B-CNN的外積操作,增加了不同層特征間的空間聯系。這是因為不同層關注的特征不同并且感受野大小也不同,這可以有效地提高識別率。

表4 對比實驗結果圖

3 結 語

本文針對細粒度分類子類別間細微的類間差異、較大的類內差異、依賴大量人工標注信息等問題,提出了基于RPN與B-CNN的細粒度分類算法。本文的主要貢獻如下:(1) 利用RPN網絡自動輸出對象級標注,不需要部位級標注,避免標注對象部位花費的精力。(2) 使用soft-nms和OHEM算法改進RPN,輸出更加精確的區域提議,可以有效防止過擬合并減少假陰性概率。(3) 改進B-CNN網絡,增加不同層間的外積操作,以融合不同層的特征,并將雙線性特征級聯在一起加強空間的聯系。實驗結果證明,基于RPN與B-CNN的細粒度分類算法能顯著提高識別率。但由于增加了RPN網絡以及OHEM與soft-nms操作,程序的運行時間相比其他算法有所增加。并且,未將RPN網絡與B-CNN網絡聯合起來,也是本文的不足。接下來,我們的工作重心將放在使RPN與B-CNN網絡聯合成一個端到端的模型,并提取同類物體不同子類的差異特征,作為深度網絡的輸入來提高準確率。