基于深度學習的行人檢測技術研究進展

黃同愿,向國徽,楊雪姣

(重慶理工大學 計算機科學與工程學院, 重慶 400054)

目標檢測是計算機視覺領域的重要研究內容之一,它從給定圖像中檢測出特定類物體實例(例如“汽車”“飛機”等)[1],近年來引起了學術界和工業界的廣泛關注。行人檢測作為目標檢測的典型任務,其發展歷程與目標檢測一致,在大數據驅動發展的今天,機遇與挑戰并存[2-58]。行人檢測的目標是在一張給定圖片或視頻幀中,精確定位出每一個在檢測范圍內的行人。如果存在行人,給出該行人的空間范圍信息。行人檢測可以與行人跟蹤相結合應用于輔助駕駛系統的視覺場景感知,并進一步對行人目標進行測距和測速,計算碰撞時間TTC(Time to Collsion)。此外,行人檢測結合行人重識別后能廣泛應用于智能視頻監控和智能安保等領域。

作為無人駕駛的基礎任務,無論是從數據集的發布、公開挑戰賽的舉辦,還是從各大頂會(CVPRICCVECCVIJCV等)和學術期刊的關鍵詞分布來看,行人檢測無疑都是重頭戲。目前,對行人檢測領域的綜述研究較少。例如,文獻[2,12-13]主要調研行人檢測的傳統算法,未涉及目前焦點的深度學習技術;文獻[4,11]等因時間節點關系,并未談及近一兩年來的研究進展。在近兩年以深度學習技術為主導的目標檢測領域快速發展背景下,行人檢測未再被作為單獨的方向綜合研究。然而,行人作為現實世界中形態和姿態最變化多端的特殊目標,是目標檢測中最具挑戰的檢測任務。本文主要針對行人檢測在近兩年與深度學習技術結合的研究進展進行綜合討論,為該領域前沿綜合研究提供參考和依據。

1 背景

社交媒體網絡和移動/可穿戴設備的普及導致了對分析可視化數據的需求越來越大。然而,移動/可穿戴設備極大地限制了計算能力、存儲空間,因此高效的對象檢測器至關重要。受成像條件、個體差異和外界干擾以及實驗誤差等因素的影響,行人檢測的速度和精度很難做到雙高,只能達到某種平衡。行人檢測面對的主要挑戰總結見圖1。

圖1 行人檢測的挑戰總結

理想的行人檢測模型應滿足高精度和高效率要求。其中,精度包括定位精度和分類精度,效率可分為時間效率、存儲效率以及內存效率。一般情況下,行人檢測的研究可以分為學術類研究和工程研究,不同的團體可能的側重點也不同。學術研究多注重檢測器的性能(即精度),而工程研究則把效率放在第一位,但不能犧牲太多的精度。

一般而言,視覺圖像中的行人會受到來自外界(如光照、天氣、環境等)和行人本身(姿態、大小、遮擋等)的影響,行人之間也會造成嚴重的干擾。例如,密集行人的區分和同一行人的整合(受遮擋物的影響,行人整體被切割成不相連通的塊)。在現實生活中,海報、模具等具有高干擾性的對象區分極具挑戰性,加之噪聲等的干擾則進一步提升了區分難度。為了應對這些復合式的疊加干擾,行人檢測的模型必須具有高度的魯棒性和泛化能力,這種能力通常來自海量的可訓練參數,這就對行人檢測的效率提出了極高的要求。

2 相關研究

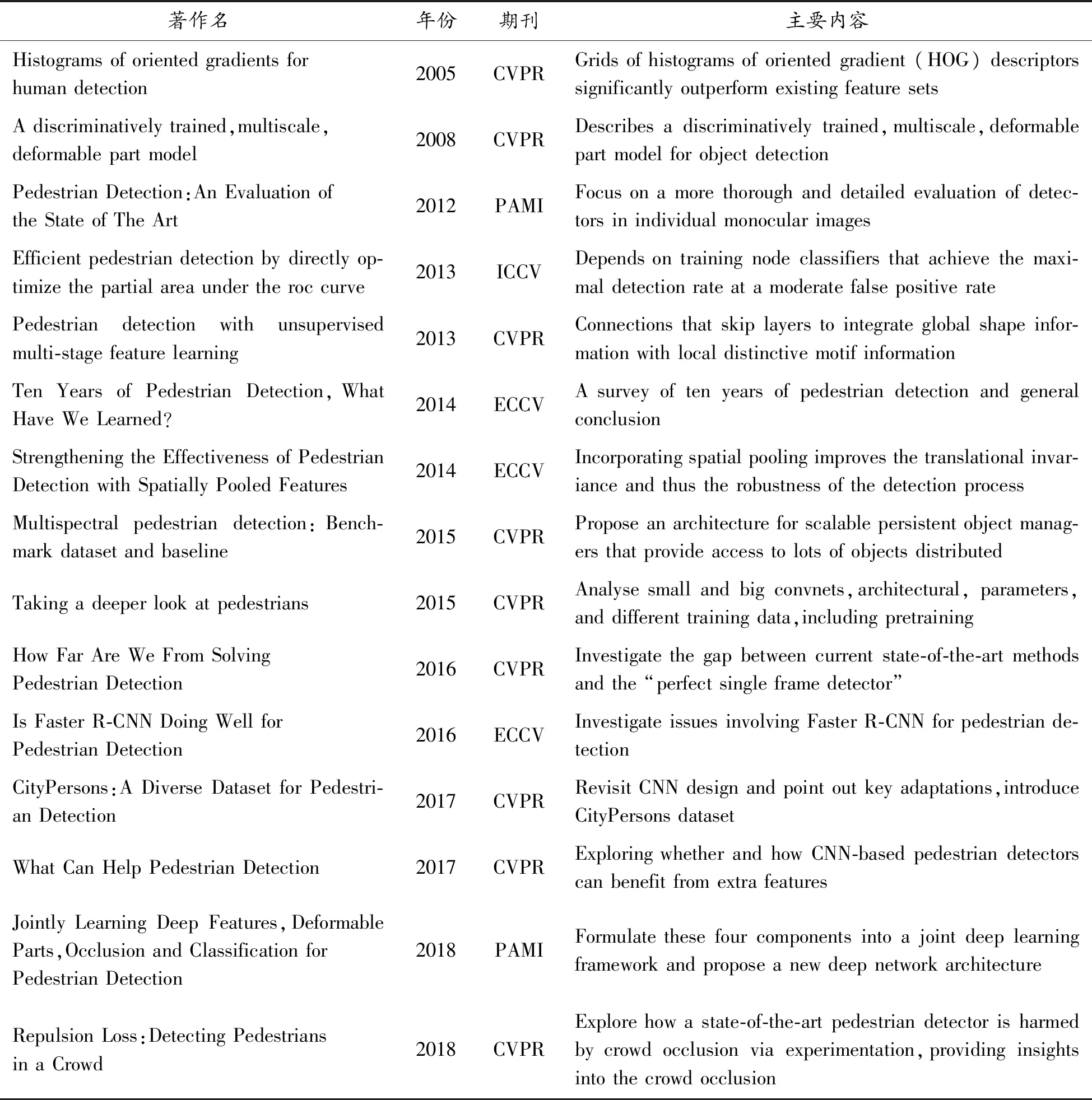

在過去的幾十年中,對于行人檢測的相關研究成果較多,本文主要關注基于計算機視覺的算法和模型,一些典型的研究總結見表1。

表1 行人檢測相關經典文章列表

早期的研究主要基于模板匹配和身體部件的思想[48]。在20世紀90年代以前,通用檢測器主要使用對象的幾何信息并設計先驗模型;之后,機器學習的浪潮使得基于表現特征的幾何分類器成為研究的熱點,例如神經網絡(neural network,NN)、支持向量機(support vector machine,SVM)和AdaBoost。1999年,具有尺度不變性的SIFT[49]特征的提出開啟了特征描述器的研究。特征檢測也從全局特征向局部特征演化,例如形狀上下文(shape context)[50]、方向梯度直方圖 (histogram of gradients,HOG)[51]、局部二值模式(local binary patterns,LBP)[52]等,使得分類器能更好地應對行人這類尺度和形態多樣的對象。

特征表達的相關研究極大地促進了行人檢測的發展,幾何特征[14-16]、形狀特征[19-21]、動作特征[22-23]以及多種特征的融合[24]是研究的主流。在特征提取發展的同時,學習框架的研究也有不少成果。Tuzel 等[25]利用協方差矩陣計算局部特征作為對象描述符, Boost框架被修改后可用于黎曼流形,從而提高了性能。Maji等[51]提出了一種與直方圖交叉內核近似的方法SVMs,允許大幅度加速,從而使非線性SVM能夠用于基于滑動窗口的檢測。

2008年,Felzenszwalb 等[52]描述了一種差異訓練、多尺度、可變形的目標檢測模型DPM。該模型在VOC挑戰賽中取得了2006年的最佳性能,并在2007年的20個項目中有10個超越最佳性能,Pedro Felzenszwalb也因此被VOC授予“終身成就獎”。DPM可以看做是HOG(histogrrams of oriented gradients)的擴展,它先計算梯度方向直方圖,然后用SVM訓練得到物體的梯度模型。

多年來,手工提取的特征一直制約著行人檢測的發展。直到2012年,Krizhevsky等[18]應用深度卷積神經網絡(deep convolutional neural networks,DCNN)模型取得了ILSVRC的冠軍,從此開啟了基于深度學習的行人檢測新篇章。

深度卷積神經網絡作為一種能自動直接從原始數據中提取抽象特征的特征提取器[3],在計算機視覺任務中取得了不少成果[4-10]。這類體系結構能夠應用在通用目標分類、通用目標檢測、特征匹配、立體匹配、場景識別、姿態估計、動作識別[11]等多項任務中,行人檢測也受益于DNN技術的發展。以DNN為基礎的深度學習技術擅長發現高維數據中錯綜復雜的結構,不需要太多的專業領域知識,從而降低了研究者的入門門檻。

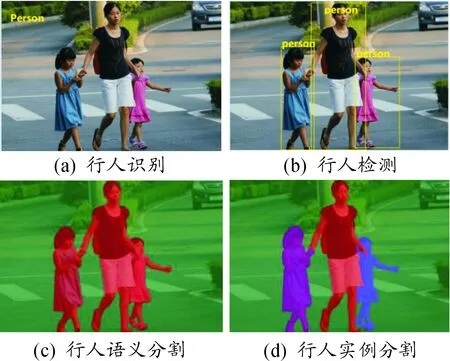

隨著檢測技術的不斷進步和應用場景的不斷拓展,行人檢測結果的表示方式也呈現多樣化,如基于更精準像素級分類的實例分割形式。實例分割與語義分割的區別在于前者要區分類內差異,即同種類別的不同個體用不同的掩碼標識,而后者不需要區分,具體示例如圖2所示。可以看出:行人實例分割不僅可以識別出每個行人,還能區分不同的個體,其相對于行人檢測的邊界框表示結果來說更精細。基于邊界框行人檢測可以包含非行人(背景、其他個體等)部分,而行人實例分割則完全貼合行人真實邊緣。

圖2 行人識別、行人檢測、行人語義分割和行人實例分割示例圖

Benenson 等[52]提出了一種新的行人檢測器,速度和質量都優于最先進的檢測器,能有效處理不同的尺度,提高了檢測速度。Sermanet 等[35]采用多級特征、跨層連接等方法,將全局形狀信息與局部特征信息融合在一起,并應用基于卷積稀疏編碼的無監督方法在每個階段對過濾器進行預訓練。P.Doll’ar等[54]通過對自然圖像的統計分析,證明了跨尺度預測的可靠性。R-CNN系列、SSD、Mask-RCNN以及YOLO系列[55-63]等通用對象檢測器的研究也促使了行人檢測的發展。Zhang等在文獻[44]中通過改進Faster R-CNN,并在共享的高分辨率的卷積特征圖上使用改進的隨機森林算法驗證了通用目標檢測器應用于行人檢測的可能性。目前,在著名行人檢測數據集Caltech上性能最好的是Wang等[70]應用邊界框回歸損失的方法,其在FPPI值為9時可達4.0%的對數平均誤檢率。在更加復雜的數據集KITTI上,行人Easy、Moderate和Hard的最好結果(AP)分別是87.81% 、78.29% 和74.46%。

3 數據集介紹

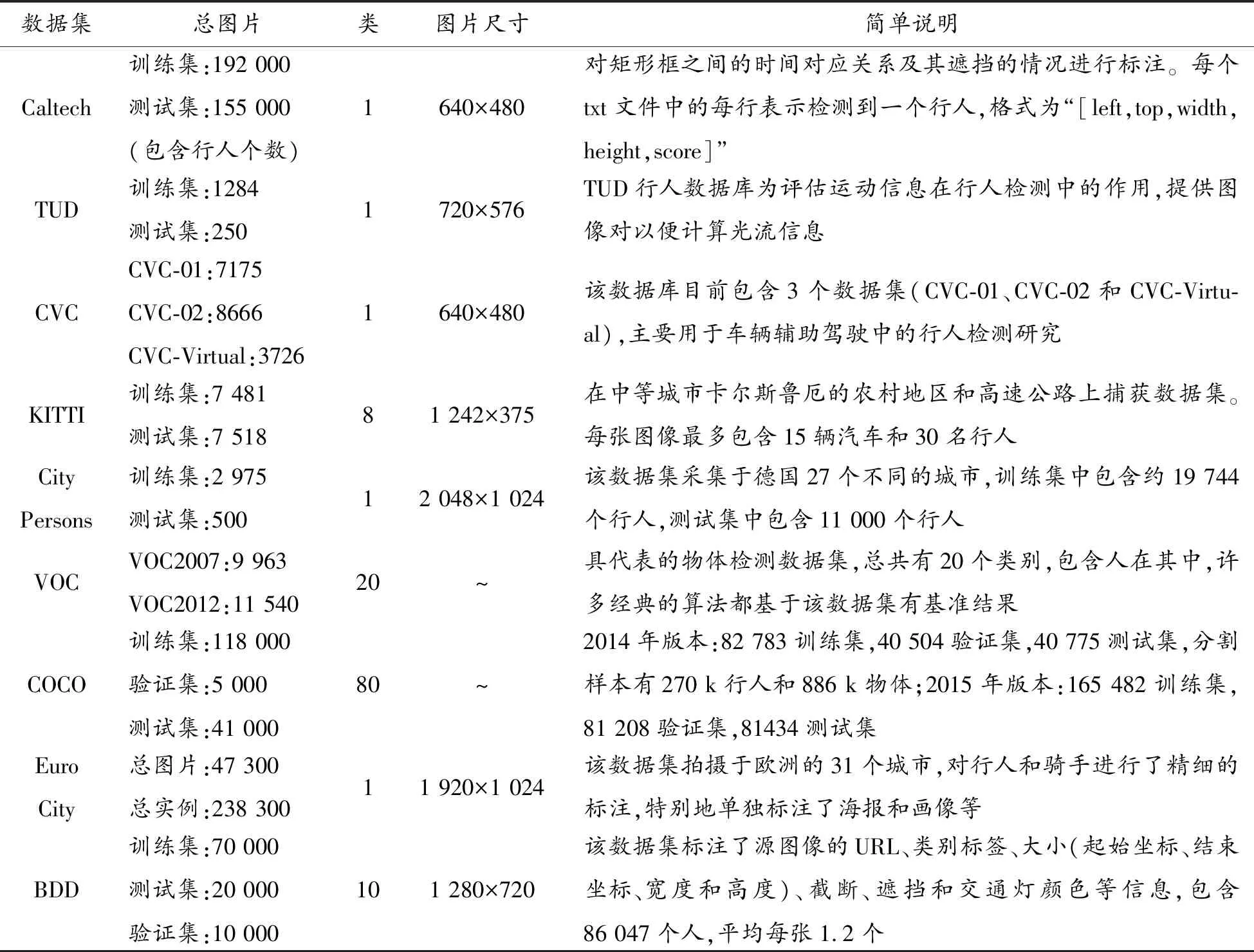

在深度學習的背景下,完善而標準的數據集在行人檢測的研究中至關重要。數據集不僅可以用來訓練模型的參數,評價模型的優劣,通常還作為一種挑戰賽的形式促進領域研究的發展。本文調查和統計的能用于行人檢測的常見數據集見表2。

數據集分為兩類:第一類是諸如Caltech這種專用于行人檢測的數據集,其他非行人類不進行標注;另一類是類似COCO和BDD這樣的數據集,標注文件中不僅對行人進行標注,其他類如車、飛機等也包括在內。兩類數據集的共同點是:單類行人的標注樣本較多,可以將行人樣本提取出來用于行人檢測的訓練。

在此,特別說明EuroCity數據集。該數據集拍攝于歐洲的31個城市,標注類別為行人,同時對自行車、手推車、摩托車、滑板車、三輪車和輪椅上的行人進行了區別標注,在47 300張圖像中手動標記了238 200個行人實例,平均每張圖片包含5.04個行人。特別地,區分了海報、廣告和商店櫥窗的模特等,額外信息如鏡頭光暈、運動模糊、雨滴或在相機前面的雨刷等也作為圖片標注。更多詳細的信息參考文獻[64]。

表2 能用于行人檢測的常見數據集

4 評價標準

評價檢測器性能的指標通常有對數平均漏檢率(log average miss-rate,LAMR)、幀率(frame per second,FPS)、查準率(average precision,AP)和查全率(recall)。幀率表征模型的效率、查準率、對數平均漏檢率和查全率反映模型的精度。對于行人檢測而言,給定一張測試圖片模型的輸出為{bi,ci,pi}i。bi為檢測框(bounding box,BBOX)的信息,通常由矩形框的中心點坐標(x,y)和寬、高w,h組成,也可以由矩形框的left、top、right、bottom表示。ci是類別信息,pi表示該矩形框的對象屬于ci的條件概率。對于一個檢測框,當它滿足下列條件時,可以視為一個真正例(true positive,TP):

1) 預測的類別信息c與標簽的類別相同。

2) 預測框與某個真實框之間的IOU(intersection over union)大于一定的閾值ε,

(1)

其中:bp為預測框,bg為真實框,area(bp∩bg)表示預測框與真實框相交部分的面積,area(bp∪bg)表示相并的面積。當2個框完全重疊且大小一致時,IOU值為1;當2個框無交叉部分時,IOU=0,說明位置預測完全錯誤,所以IOU的取值范圍是0~1。閾值ε為超參數,通常設置其值為0.5。不是真正例的框,都當作假正例(false positive,FP)。假正例的個數越多說明誤檢率越大。類別概率p通常也和超參數β進行比較,大于閾值則認為屬于該類,否則屬于其他類,β的取值通常為0.5。

一般情況下可通過繪制相對每張圖像誤檢數(false positive per image,FPPI)的漏檢率(miss rate,MS) 曲線或者P-R曲線來動態評估模型性能。

(2)

(3)

其中,給定閾值c,FN(c)表示假反例(false negative,FN)的個數,TP(c)表示真正例的個數,則可以定義對數平均漏檢率為:

fppi(c)≤f

(4)

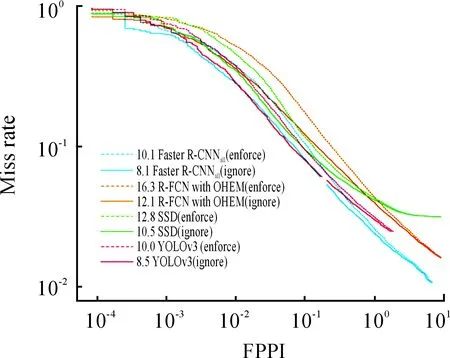

9 FPPI是參考[10-2,100]區間的等間隔分布,對于每一個FPPI,統計其對應的MR。例如,常見模型在EuroCity數據集的MR-FPPI圖如圖3所示。

圖3 常見模型EuroCity的MR-FPPI性能表現

同樣地,計算AP:

(5)

其中,給定閾值c,召回率re(c)為:

(6)

查準率AP為

(7)

選取不同的re,計算其對應的AP則可得到P-R曲線。

5 子問題研究

結合之前分析的行人檢測中的主要問題和挑戰,對影響行人檢測的子問題展開分析。例如檢測框架、特征表達、損失函數、上下文信息和訓練策略等。

5.1 檢測框架

目前基于深度學習的檢測框架可以分為兩類:

1) 兩階段檢測框架:包括生成候選區域和區域分類兩個階段。

2) 一階段檢測框架:分類和檢測一步到位,不需要預先生成候選區域。

一般而言,一階段的檢測框架相對于兩階段的檢測框架在模型檢測速度上較有優勢,但精度不足。典型的YOLO V3網絡在COCO數據集上mAP達到57.9%的同時,速度能保持20FPS,是經典的通用對象檢測框架,許多變體網絡也應用在了行人檢測中[42-43,65-66]。

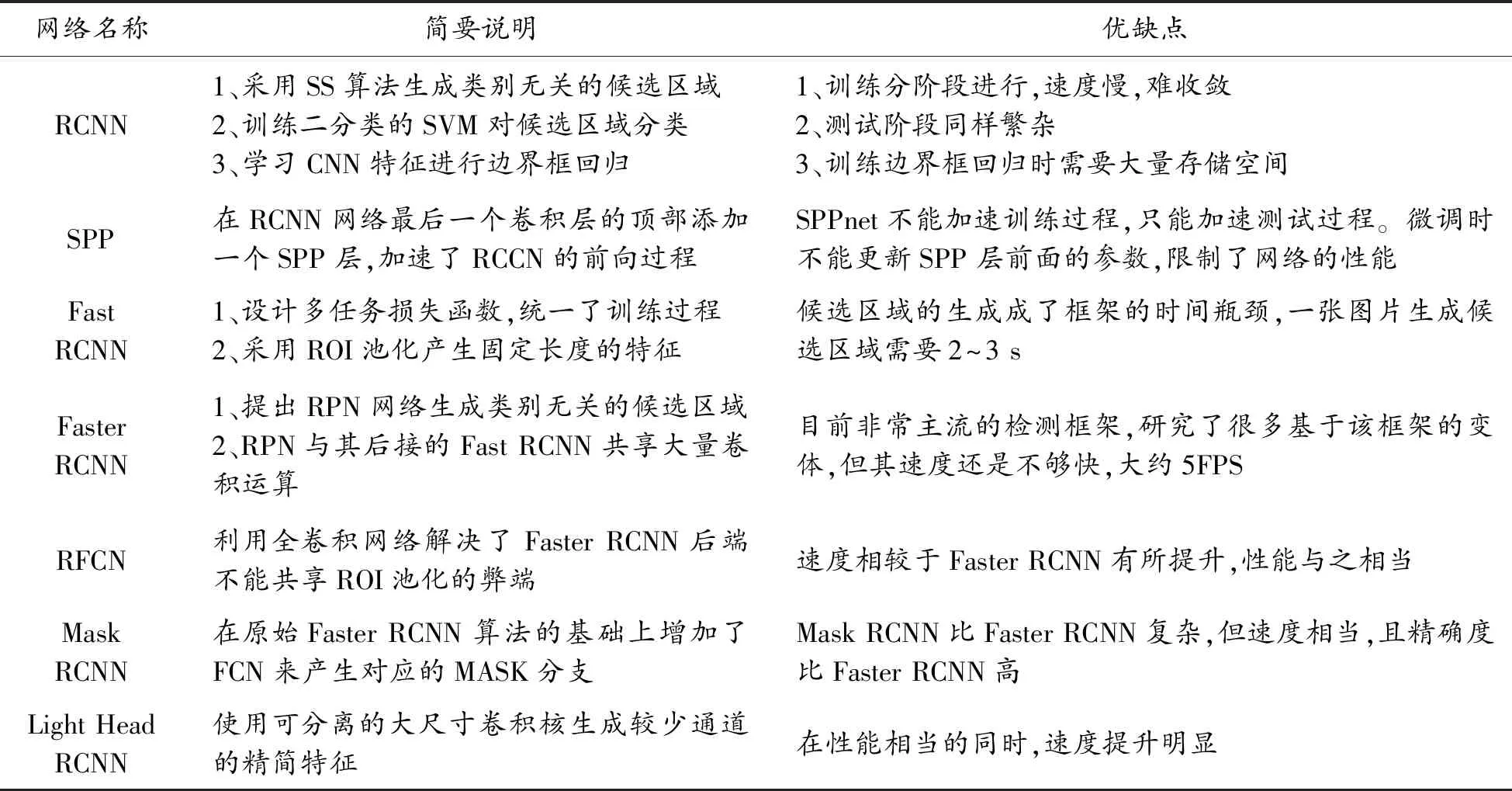

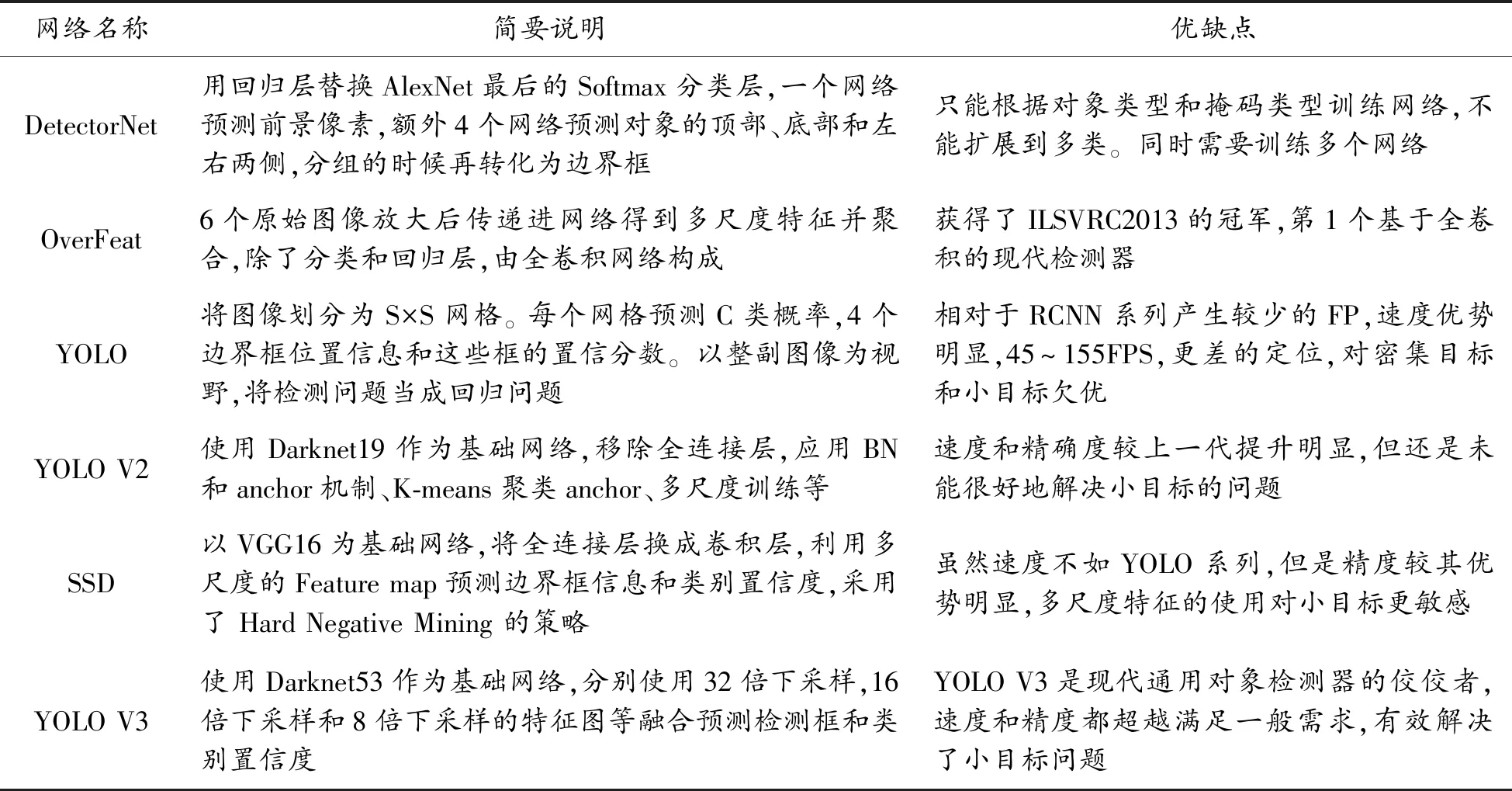

基于行人檢測框架通常由通用目標檢測框架改進而來。典型的兩階段和一階段檢測框架情況見表3和表4。

表3 典型2階段檢測框架列表

表4 典型1階段檢測框架列表

5.2 特征表達

基于深度學習的檢測框架通常使用VGG,AlexNet、GooleNet、ResNet50、RestNet101、DarkNet、MobileNet[18,26-31]等作為骨干網絡提取特征。基于滑動窗口的策略需要對每個像素均勻處理,在多個尺度的不同寬高比上窮舉搜索進一步增加搜索空間。為了解決不同尺度的問題,通常的做法是采用圖像金字塔的方法,例如檢測器[32]。但這種方案的測試時間和存儲開銷都極大。考慮到CNN提取的特征具有如下特性:

1) 低層的特征具有較小的感受野,對于小尺度的目標有更敏感的位置和細節信息,但是缺少語義信息。

2) 高層的特征感受野較大,語義信息更豐富,對光照、形變等的魯棒性更高,但由于幾何信息的丟失,導致對小目標檢測的效果較差。

在行人檢測的具體應用中,大部分行人目標為小目標,因此融合低層的具有較小感受野的特征更有利于行人目標檢測,尤其是針對距離較遠的行人效果更好。這種層次性的特征正好內在地形成了特征金字塔的分布,加之不同尺度對象的檢測需求,利用DNN多中間層特征的檢測器成為目前行人檢測的主流方法。對于這種多層次的特征使用方式一般有3種:

1) 使用多個DNN的層次特征組合進行檢測,典型的網絡如HyperNet和ION等[33-34]。

2) 在DNN的多層進行檢測。如SSD、MSCNN、RBFNet和DSOD[36-39]等網絡利用不同層次的特征來檢測不同大小的目標。

3) 混合上述兩種方法,如SharpMask、DSSD、FPN,YOLO V3[40-43]等,以YOLO V3為例,其網絡結構如圖4所示。

參照圖4,YOLO V3采用416×416的三通道彩色原圖作為輸入,首先經過一系列卷積塊和殘差塊進行32倍下采樣,得到13×13的特征圖,在此特征圖上預測輸出第1批檢測結果。此時對應大尺度的anchor,能夠檢測大目標,接著將此特征圖反卷積上采樣至26×26,與前面下采樣后同等大小的特征圖進行跨通道融合,在此基礎上預測輸出第2批結果。第3次上采樣至52×52后進行預測,對應小尺度anchor能夠較好地檢測小目標。類似YOLO V3這種綜合多個層次特征檢測的方法是現階段檢測框架的主流,對于其他網絡的設計有很強的借鑒意義。針對行人檢測還可以更改anchor的分配機制,分配更多的anchor給低層特征,同時鑒于行人大部分0.41的寬高比,可以微調anchor值以進一步提升效果。

5.3 上下文信息

在DNN檢測框架的設計中,目前越來越注重如何有效地利用上下文信息。上下文信息可以分為語義上下文、空間上下文和尺度上下文3類。從應用范圍又可以歸納為全局上下文和局部上下文信息。語義上下文描述了一個對象處在某個特定場景的可能性,例如:坦克不可能在天上跑,魚只能在水中游等;空間上下文限定了目標只能出現在特定的位置,例如:基于零部件的檢測限定,頭只能出現在脖子的上面;尺度上下文檢查檢測對象與它周圍物體的大小關系是否正常,例如:一個正常的行人是不會比緊挨著他的汽車大的。

Chen等[67]設計了多階上下文產生器(multi-order contextualco-occurrence,MOCO)明確地模擬上下文。Zeng等[68]提出一種新的DNN模型,該模型能夠通過反向傳播的幾個階段聯合訓練多階段分類器,通過訓練策略的特定設計,可以將其作用在上下文信息以支持下一階段訓練的決策。為了處理遮擋和復雜背景的干擾,Wang等[66]提出了部分和上下文網絡(part and context network,PCN),采用局部競爭機制進行自適應的上下文規模選擇。Yu等[69]提出IOU損失,使真實框與預測框之間的重疊最大化。

5.4 損失函數

損失函數的設計和選擇也影響著行人檢測的研究。在預測行人的定位信息時,通常會把它當作一個回歸問題。在RCNN中針對候選區域坐標的歐氏距離訓練了線性回歸模型。在Fast RCNN中,提出了SmoothL1損失替換了歐式距離。在Faster RCNN中,RPN的提出使邊界回歸使用了2次。為了解決遮擋和密集的行人檢測,Wang等[70]基于目標的吸引力和周圍目標的排斥力假設提出了排斥損失(repulsion loss)。對于樣本類別不均衡帶來的問題,Lin等通過重新設計標準的交叉熵損失來解決,從而降低分配給分類良好的樣本的損失。FocalLoss的使用在現有檢測器的基礎上提升了一定的檢測精度。

5.5 訓練策略

訓練DNN的首要條件是要有大量的標注樣本。標注的質量要盡可能地高,訓練樣本的多樣性和分布也同樣重要。行人檢測或目標檢測不同于圖像分類任務,標注的復雜度要高很多。現階段,如ImageNet和 Places數據集等是擁有大量分類任務的數據集,因此,通常的訓練策略是在ImageNet或Places上預訓練骨干網絡,以此作為檢測網絡的特征提取器,然后再在特定檢測任務如行人檢測數據集上進行微調,訓練其定位功能。這是遷移學習的典型應用,類似的成果有很多,如RPB+BF[70]、SA-Fast RCNN[71]、SDS-RCNN[17]等。

5.6 其他子問題

為了得到更豐富的特征表達,數據增強通常也作為訓練行人檢測模型中必不可少的手段。數據增強一般包括裁剪、旋轉、翻轉、縮放、調整寬高比、更改曝光、色調和對比度等手段。更復雜的做法還涉及背景切換、環境遷移、虛擬目標等,如原始圖像加霧、雨天效果等。

對于候選區域生成算法的研究也有不少代表。Chavali等在文獻 [47]中全面評估了已有各種算法,并發布工具箱集成了主流的算法實現。Hosang等提出一種新的度量標準——平均召回率AR,用以更好地選擇各種區域推薦算法[48]。其他一些研究則涉及了對非極大值抑制(nonmaximum suppression,NMS)算法的改進[53,45-48]。

6 結束語

行人檢測是通用對象檢測中一個典型且最具挑戰性的問題,受到了社會各界的廣泛關注。雖然深度學習的發展極大地促進了行人檢測的進步,但針對復雜場景和特殊環境的行人檢測仍有待提高。目前亟需解決的問題是需要更加豐富的數據集和更加高效的特征提取器。對于數據集來說,目前標準的大型數據集都基于國外的環境和場景,這在一定程度上影響了相關研究的進展。國內數據庫在大型行人目標檢測數據集的構建上還有很多發展空間。輕量化模型有利于設計高效的特征提取器,但精度的損失如何彌補也是未來研究的重點。綜上,行人檢測仍是一個機遇與挑戰并存的課題。