基于卷積神經網絡的弱光照圖像增強算法

程宇 鄧德祥 顏佳 范賜恩

摘 要:針對現有的弱光照圖像增強算法強烈依賴于Retinex理論、需人工調整參數等問題,提出一種基于卷積神經網絡(CNN)的弱光照圖像增強算法。首先,利用四種圖像增強手段處理弱光照圖像得到四張派生圖,分別為:限制對比度自適應直方圖均衡派生圖、伽馬變換派生圖、對數變換派生圖、亮通道增強派生圖;然后,將弱光照圖像及其四張派生圖輸入到CNN中;最后經過CNN的激活,輸出增強圖像。所提算法直接端到端地實現弱光照圖像到正常光照圖像的映射,不需要按照Retinex模型先估計光照圖像或反射率圖像,也無需調整任何參數。所提算法與NPEA(Naturalness Preserved Enhancement Algorithm for non-uniform illumination images)、LIME(Low-light image enhancement via Illumination Map Estimation)、LNET(LightenNet)等算法進行了對比。在合成弱光照圖像的實驗中,所提算法的均方誤差(MSE)、峰值信噪比(PSNR)、結構相似度(SSIM)指標均優于對比算法。在真實弱光照圖像實驗中,所提算法的平均自然圖像質量評價度量(NIQE)、熵指標為所有對比方法中最優,平均對比度增益指標在所有方法中排名第二。實驗結果表明:相對于對比算法,所提算法的魯棒性較好;經所提算法增強后,圖像的細節更豐富,對比度更高,擁有更好的視覺效果和圖像質量。

關鍵詞:弱光照圖像增強;Retinex模型;派生圖;卷積神經網絡;自然圖像質量評價

中圖分類號:TP391.4

文獻標志碼:A

文章編號:1001-9081(2019)04-1162-08

0?引言

在很多計算機視覺任務中,如目標檢測、圖像檢索、圖像分割等,都要求輸入圖像亮度合適、細節清晰。然而,在弱光照或者曝光不足的情況下,采集到的圖像存在亮度低、色彩不飽和、細節模糊等缺點,這些缺點將影響到后續的計算機視覺任務。因此,研究弱光照圖像的增強很有必要。為了改善這類圖像的視覺效果,需要對其進行增強處理,基本增強手段主要包括:1)通過調整對比度來增強圖像邊緣和細節;

2)通過調節動態范圍抑制噪聲等手段來改善圖像清晰度;

3)通過提高較暗區域的亮度,使圖像亮度保持均勻;

4)通過調整圖像的顏色飽和度使其獲得良好的視覺效果等。

近年來,深度學習發展迅速,在高層次視覺任務中應用非常廣泛,如圖像識別[1]、語義分割[2]等。

與此同時,也有一些研究人員嘗試用深度學習算法去解決低層次圖像領域問題,如圖像去噪[3]、圖像去霧[4-5]、圖像超分辨率[6]等,這些算法也取得了較好的成績。相對于傳統算法,深度學習算法具有不需要人工設計特征提取方法,可直接端到端地訓練和輸出結果等優勢。

因此,在深度學習廣泛應用的背景下,本文嘗試用卷積神經網絡(Convolutional Neural Network, CNN)算法對傳統的弱光照圖像增強問題進行改進。

1?Retinex理論和相關工作

1.1?Retinex理論

弱光照圖像增強是圖像處理領域的一個經典問題。該問題旨在從亮度偏暗、細節模糊、質量較低的圖像中恢復出亮度適中、細節明顯、有良好視覺效果的圖像。

Retinex理論模型[7]是弱光照圖像增強領域的一個基礎理論模型。模型的基本假設是原始圖像是光照圖像和反射率圖像的乘積,可表示為下式形式:

其中:x表示像素點;I(x)表示采集到的原始圖像;L(x)表示光照圖像;R(x)表示反射率圖像。基于Retinex模型的圖像增強算法的一般處理順序是先從原始圖像中估計出光照圖像L(x),進而算出反射率圖像R(x),消除L(x)中弱光照的影響后得到亮度適中的增強光照圖像Len(x),Len(x)與R(x)相乘得到增強圖像。目前大多數弱光照增強算法的研究都是基于Retinex理論模型,這類算法的主要難點在于利用人工提取的圖像特征和統計先驗估計光照圖像。

1.2?相關工作

弱光照圖像增強算法的相關研究一直在進行,從中發展出了許多不同類型的算法。例如,文獻[8-9]根據直方圖調整圖像的灰度動態范圍來增強圖像,此類算法計算簡單易于實現,但在圖像較暗區域的增強效果不足,較亮區域又容易過度增強,導致顏色失真。后來,很多研究者提出基于Retinex模型的算法,這類算法的一般步驟都是先從弱光照圖像中估計出光照圖像,然后根據式(1)得到反射率圖像,通過一定的增強手段增強光照圖像,最后與反射率圖像相乘得到增強圖像。Guo等[10]提出了LIME(Low-light image enhancement via Illumination Map Estimation)算法,該算法通過優化弱光照圖像的亮通道圖得到全局平滑且邊緣清晰的光照圖像,光照圖像經伽馬變換后得到增強的光照圖像。文獻[11-12]中均用高斯分布和拉普拉斯分布來擬合光照圖像和反射率圖像的分布規律,以弱光照圖像的V通道圖像為初始光照圖像,經ADMM(Alternating Direction Method of Multipliers)算法迭代求得光照圖像和反射率圖像的最優解;然后與文獻[10]一樣,使用伽馬變換得到增強的光照圖像。文獻[13]中提出了NPEA(Naturalness Preserved Enhancement Algorithm for non-uniform illumination images)算法,該算法設計了一個光照敏感的濾波器,使用該濾波器對弱光照圖像濾波得到光照圖像,然后用改進的對數變換對光照圖像進行調節得到增強的光照圖像。然而,根據式(1)可知,在反射率圖像R(x)未知的條件下,根據原始圖像I(x)估計光照圖像L(x)是一個病態問題,估計的光照圖像并不完全準確,光照圖像估計錯誤會導致增強圖像中出現亮度不自然的問題,這也是所有基于Retinex模型的算法的固有缺陷。

圖1是個典型例子,文獻[11]算法因為光照圖像估計錯誤導致增強失敗,本文算法則能得到視覺效果良好的增強圖像。

Fu等[14]提出了基于多派生光照圖像融合的算法MF(Multi-scale derived images Fusion)。首先根據亮通道方法得到光照圖像和反射率圖像,使用引導濾波優化光照圖像;然后用三種增強手段處理光照圖像得到三個派生光照圖像;最后根據人工設計的權重參數,融合三個派生光照圖像得到增強的光照圖像,反射率圖像和增強的光照圖像相乘得到增強圖像。該算法能有效改善圖像較暗區域的視覺效果,同時保持明亮區域不出現失真現象;但是該算法的融合權重參數需要人工設計,且融合權重參數不是基于學習的方法得到的,不具有統計規律,因而魯棒性不佳。

此外,有研究者發現弱光照圖像取反的結果類似于有霧圖片。

Dong等[15]提出的快速有效低光照視頻增強算法,將弱光照圖像取反后,用暗通道去霧算法對其進行處理,然后將結果再次取反得到增強圖像。這類算法的增強效果取決于去霧處理中透射率圖估計的準確程度。而由霧形成的物理模型可知,直接根據霧圖像估計透射率圖也是一個病態問題[4],所以基于Retinex模型的算法的缺陷同樣也存在于這類方法中。

有別于傳統增強算法,近年來發展出了一些基于學習的增強算法。Fotiadou等[16]提出一種基于稀疏表示的增強算法。首先,分別在暗光條件下和正常光照條件對相同場景采集圖像,將暗光圖像集和正常圖像集用于聯合字典學習,得到兩個圖像集的聯合字典及具有匹配關系的暗光條件編碼與正常光照條件編碼;然后,用聯合字典對輸入的弱光照圖像編碼,得到暗光條件編碼,根據匹配關系找到對應正常光照條件下的編碼;最后,再由正常光照條件下的編碼和聯合字典恢復出增強圖像。在深度學習廣泛運用于計算機視覺的各個領域的情況下,也有研究人員嘗試用深度學習來解決弱光照圖像增強問題。Li等[17]提出了卷積神經網絡弱光照圖像增強算法LNET(LightenNet),該算法使用卷積神經網絡來估計光照圖像,然后使用引導濾波優化光照圖像,最后根據Retinex模型得到增強圖像。Lore等[18] 受到深度學習在圖像去噪中應用的啟發,將一個經典的圖像去噪自編碼器SSDA(Stack Sparse Denoising Autoencoder)運用在弱光照圖像增強上。文獻[17-18]的嘗試表明深度學習算法在弱光照圖像增強問題上同樣適用,因此本文結合傳統圖像增強手段和卷積神經網絡,提出了基于卷積神經網絡的弱光照圖像增強算法。本文算法擺脫了Retinex模型的限制,不需要估計光照圖像或反射率圖像,直接端到端地實現弱光照圖像增強。

2?本文算法

本文提出的卷積神經網絡簡稱為MDIIN(Multiple Derived Image Inputs Network)。MDIIN的作用是激活原始弱光照圖像和由其生成的四張派生圖,輸出增強圖像。通過在合成數據集上的訓練,MDIIN成功學習到了映射規律,有效地實現了弱光照圖像的增強。

2.1?派生圖

弱光照條件下采集到的圖像存在以下問題:圖像的對比度低,整體亮度偏低,暗處區域的細節不清晰。針對以上的問題,本文算法首先采用傳統增強手段生成四種派生圖,這四種派生圖在對比度、亮度、顏色飽和度上均優于原圖。

1)限制對比度自適應直方圖均衡派生圖:直方圖均衡可提升圖像的對比度,提高圖像中弱光照區域的亮度。直方圖均衡的方法有很多種,簡單的直方圖均衡計算復雜度低、耗時短;但是由于這種方法是全局均衡,對于整體亮度偏低的圖像的增強效果有限,而且可能導致顏色失真。為了克服簡單直方圖均衡的缺點,文獻[9]中提出了限制對比度自適應直方圖均衡算法CLAHE(Contrast Limited Adaptive Histogram Equalization),CLAHE的分塊操作使圖像的整體亮度得到提升,亮度分布也更加均勻。CLAHE算法中帶閾值限制的圖像子塊直方圖均衡可適當地增強圖像的對比度。因此,本文選取CLAHE算法生成第一張派生圖Ich:Ich=CLAHE(I)(2)

2)伽馬變換派生圖:伽馬變換是一種非線性地改變圖像亮度的方法。本文選用伽馬變換生成第二張派生圖Igm:Igm=αIγ(3)

當γ<1時,伽馬變換可提升圖像的亮度,增強圖像暗處的細節。本文中α=1,γ=0.4。如圖2(c)所示,伽馬變換可有效提高圖像的整體亮度。

3)對數變換派生圖:與伽馬變換一樣,對數變換也是一種非線性地改變圖像亮度的方法。兩者的區別是伽馬變換對低亮度區域的亮度提升作用更大,對數變換對高亮度區域的亮度提升作用更大。本文算法中,兩種變換互為補充,能夠更合理地提升圖像亮度。對數變換公式如下:Ilog=c·log(1+v)(1+I·v)(4)

本文中c=1,v=10。

4)亮通道增強派生圖:首先將原始弱光照圖像的亮通道圖像當作光照圖像L[10],由式(1)可得到反射率圖像R。對原始圖像做α=1,γ=0.5的伽馬變換得到增強的光照圖像Len,Len和R相乘得到亮通道增強派生圖Ile:

如圖2(e)所示,相對于原圖,亮通道增強派生圖的顏色飽和度、亮度都有提升。

2.2?網絡結構

MDIIN是一個基于Encoder-Decoder結構的網絡。在圖像去噪[19]、顏色校正[20]、圖像去霧[21]、延時攝影視頻生成[22]等領域中,Encoder-Decoder結構得到了廣泛的應用,這說明Encoder-Decoder結構非常適用于圖像生成網絡。

MDIIN在Encoder-Decoder結構中增加了跳躍連接,將Encoder的特征圖和淺層Decoder的特征圖輸入到Decoder的最后一層。跳躍連接在網絡淺層和深層之間增加了通路,可以大幅加快網絡訓練的收斂速度[19],而且跳躍連接讓每一層的特征圖得到了更充分的利用,有助于生成細節更清晰的增強圖像。

圖3為MDIIN的結構。MDIIN包含15個卷積層和3個反卷積層,卷積操作的步長都為1,每個卷積層和反卷積層后面都連接著一個Leaky ReLU(Leaky Rectified Linear Unit)激活層,Leaky ReLU激活函數的負半區的斜率為0.1。MDIIN中的所有卷積操作都是空洞卷積,空洞卷積未增加網絡的計算量,卻能增大局部感受野的大小,利用更多的圖像信息。

MDIIN的網絡參數設置如表1所示,其中:Block表示卷積塊類型,Layer表示層類型,conv表示卷積層,deconv表示反卷積層,Weight Dimension表示卷積核參數維度,Dilation表示空洞卷積的間隔像素點個數,Padding表示卷積時邊緣補充像素的數量。網絡輸入為弱光照圖像及其四張派生圖,因此Encoder1的輸入通道數為15,輸出為增強圖像,因此Decoder3輸出通道數為3。將Encoder1、Encoder2、Encoder3、Decoder1、Decoder2的輸出和Decoder3中第二個卷積層的輸出聚合,然后全部輸入到Decoder3的最后一個卷積層,因此Decoder3的最后一個卷積層的輸入通道數為192。

2.3?損失函數

本文采用均方誤差(Mean Square Error, MSE)和L1范數損失作為MDIIN的損失函數。在圖像生成類任務中,MSE是最常用的損失函數。近期有研究顯示,訓練中使用復合形式的損失函數比使用單一的MSE損失函數能得到表現更好的網絡[23]。因此,除MSE外,本文還加入L1范數損失以提高增強結果的圖像質量。最終的損失函數公式如下:L(w)=

3?實驗與結果分析

3.1?實驗環境與參數設置

MDIIN訓練時,輸入圖像塊大小設置為128×128,優化算法為ADAM(Adaptive Moment Estimation)[24],批處理圖像塊數量為10,初始學習率為0.00001,每20000次迭代學習率衰減75%,總迭代次數為60000。訓練使用的GPU型號為Nvidia K80,在該環境下,訓練一次耗時12h。

3.2?訓練數據

訓練數據直接決定了卷積神經網絡能學習到什么映射規律。在弱光照圖像增強領域,目前還沒有既包含弱光照圖像又包含其對應正常光照圖像的數據集,因此,本文利用正常清晰光照的圖像合成弱光照圖像。

圖4是一個合成弱光照圖像的例子。首先,在互聯網和其他圖像數據集上找到600張光照正常對比度高的圖像;然后,將圖像轉換到HSV(Hue Saturation Value)空間,對V通道圖像V做伽馬變換得到合成弱光照圖像的V通道圖像Vdark:Vdark=αVγ,其中α∈(0.8,1),γ∈(1.8,3.4);然后用Vdark替換V,其他兩個通道不變,轉換回RGB(Red Green Blue)空間得到合成弱光照圖像。對每一張正常光照圖像,隨機選取7組參數,生成7張弱光照圖像,最終一共得到4200張訓練圖像。從中選取由100張正常光照圖像合成的700張合成圖像作為測試集,剩余的作為訓練集。

3.3?實驗結果分析

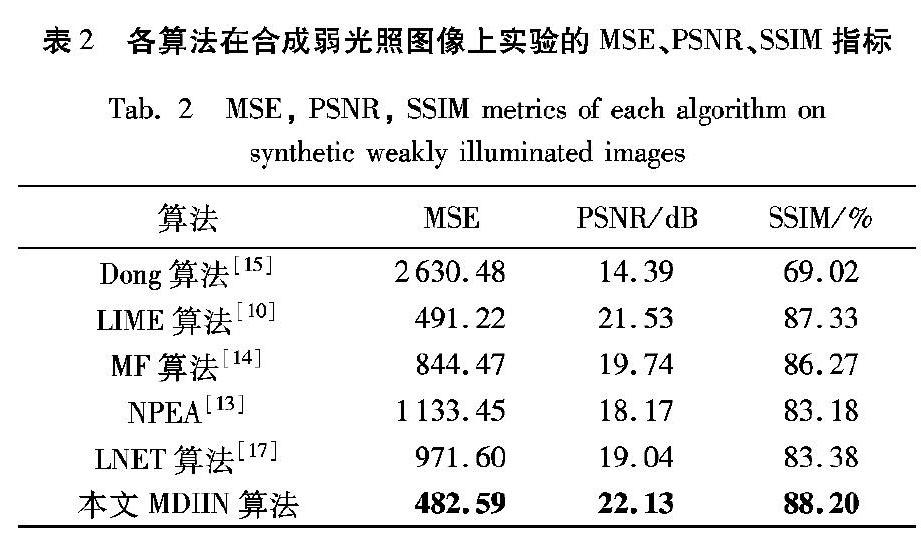

為了驗證本文算法的有效性,本文在真實弱光照圖像和合成弱光照圖像上均進行了對比實驗。對比的算法有:Dong算法[15]、LIME算法[10]、MF算法[14]、NPEA[13]、LNET算法[17]。各算法的參數值均為原文獻中的推薦值。

3.3.1?合成弱光照圖像增強對比實驗

首先,在合成弱光照圖像上將本文算法與其他算法對比。合成弱光照圖像的方法和3.2節中網絡訓練集的合成方法相同,總共選取50張合成圖片。為了保證實驗的公正性,這50張圖片都未在訓練集中出現過。為了說明本文算法在不同光照條件下的魯棒性,本文選取的合成圖像中場景包括室內、野外、圖像的光照條件有整體光照偏弱、光照不均勻等。

圖5是部分實驗結果。觀察圖5可看出,Dong算法對圖像的亮度有一定提升,但是提升能力不足,圖像整體亮度仍然很低,細節仍然不清晰。LIME算法的增強效果非常明顯,增強后圖像的平均亮度也是所有算法中最高的,但是這也帶來了增強過度的問題,圖像中出現過曝和失真現象,如圖5的station中火車頭左上角的光暈和ride中的石子路。LNET算法在station上增強效果較好,在owl上不明顯,owl增強后亮度仍然偏暗,在room中出現了過曝現象,如地板和窗簾的亮度。MF算法和NPEA的增強圖像的亮度介于Dong算法和LIME算法之間。由station的增強結果可看出,這兩種算法對光照不均勻但平均亮度較高的圖像的增強效果不錯,但是當圖像整體亮度都偏暗時,如owl和ride,增強后圖像亮度仍偏暗、視覺效果欠佳。這也說明MF,NPEA的魯棒性不夠好,需要針對不同場景和光照情況調整參數才能得到較為理想的結果。而本文算法是基于學習的算法,在訓練中學習了不同的場景和光照條件,對于光照各異的輸入圖片,無需調整任何參數就能輸出較理想的增強結果。圖5中也能看出,本文算法的增強結果最接近正常光照圖像,增強后的圖像亮度適中、顏色自然、細節清晰、具有最好的視覺效果。所以,從主觀視覺感受上來說,本文算法比其他算法更有優勢。

除了主觀評判外,本文還在MSE、峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)、結構相似度(Structural SIMilarity index, SSIM)三項客觀指標上對幾種算法進行對比。表2是幾種算法在50張合成樣本上實驗結果的平均指標。表2可看出,本文算法的平均MSE、PSNR指標是所有算法中最優的。而且,盡管本文算法在訓練時使用的損失函數是MSE和L1范數,但在SSIM指標對比中,本文算法仍然是所有算法中最優。在合成圖像上實驗結果表明,無論是從主觀視覺感受還是客觀評價指標來說,本文算法對弱光照圖像的增強能力均優于其他幾種算法。

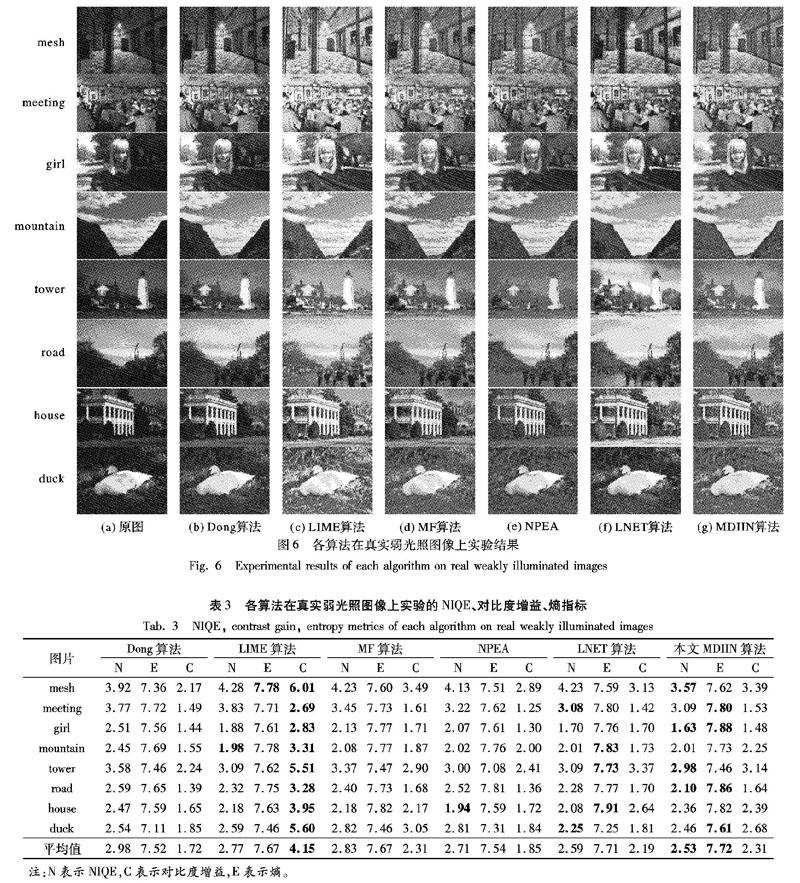

3.3.2?真實弱光照圖像增強對比實驗

為了進一步說明本文算法的優勢,本文也在真實弱光照圖像上進行了對比實驗,圖6是實驗結果。從圖6可看出,各算法在真實圖像上的增強表現跟合成圖像上的表現基本一致:Dong算法增強后圖像亮度整體偏暗,細節處的視覺效果提升不明顯,如girl中的車窗和mountain中的山體部分;MF算法的魯棒性一般,部分圖片增強后亮度較好,如girl、house、duck,其他剩余圖片仍然偏暗;NPEA的增強結果整體偏暗,且出現失真,如tower中右側樹枝的亮度不自然;從meeting和girl的增強結果可看出,LIME算法依然存在增強過度的問題,增強后圖像的光照不自然;LNET中增強過度的現象更明顯,如tower、house中的天空與road中的馬路,都出現了過曝問題;本文算法的增強結果較為自然,在提升原圖暗處的同時,很好地保持了原圖亮度區域不過曝,增強后的圖像有良好的視覺觀感。

為了更客觀地對比各算法的增強表現,還需要測試實驗結果的客觀評價指標。不同于合成圖像,真實弱光照圖像無對應的正常光照圖像,無法測試MSE、PSNR等指標。本文以圖像的自然圖像質量評價度量(Natural Image Quality Evaluator, NIQE)、熵(Entropy)、對比度增益(Contrast Gain)三項指標來對比各算法。NIQE是一個根據圖像的自然統計特征得到的圖像質量參考值,數值越小表示圖像質量越高;熵是度量圖像中信息量多少的指標,可以反映圖像細節豐富程度,熵越大,說明圖像包含信息越多,細節越豐富;對比度增益反映了圖像增強前后對比度提升的程度,值越大表示對比度提升越明顯。

表3中記錄了圖6實驗結果的三項指標。具體分析如下:1)在NIQE的對比中,本文算法在其中的四張圖片上排名第一,在其中三張圖片上排名第二,在其中一張圖片上排名第四,平均排名第一。排名第四的圖片名為house,觀察圖6可知,本文算法增強后,house中整體亮度過于平均,未形成較高的對比度,這可能是影響該圖片NIQE指標的因素。綜合比較NIQE指標可以說明,相對于其他方法,本文算法增強后圖像的有更高的圖像質量。

2)在熵的對比中,本文算法在其中的四張圖片上排名第一,在其中的兩張圖片上排名第二,另外兩張圖片mountain和tower分別排名第三和第四,平均排名第一。理論上熵最大的情況為圖像中每個像素的灰度值都不一樣,本文算法增強結果在圖片mountain中的山體部分和tower中的地面部分的灰度值分布變化很少,因此這兩張圖片的熵指標相對較低。但是,在八張圖片上熵指標的綜合比較中,本文算法仍然是最優的。這說明相對于其他方法,經本文算法增強后圖像的細節更豐富。

3)在對比度增益的對比中,本文算法的平均對比度增益排名第二,排名第一的為LIME算法。前文的主觀視覺感受對比中可以發現,LIME有過度增強的傾向,因此LIME算法的高對比度增益是建立在過度增強的基礎之上。

通過對比NIQE、熵、對比度增益三項指標,可以說明本文算法在真實弱光照圖像上的增強表現更好,本文算法增強后的圖像有較高的圖像質量與較豐富的細節;而且,本文算法在保持增強效果自然性的前提下,能較好地提升圖像對比度。

3.3.3?派生圖對增強結果的影響

本文針對各派生圖對增強結果的影響進行了分析。卷積神經網絡的映射作用不可用解析表達式表示,因此無法直接通過公式分析各派生圖的作用。最終,本文選擇使用替換方法對此進行分析。具體實施過程為:保持MDIIN的其他輸入不變,將其中一張派生圖用原始弱光照圖像代替,得到增強結果。

圖7中顯示了將四張派生圖依次用原始弱光照圖像代替后的增強結果:由圖7(a)~(b)中球面的紋路及衣服上的褶皺可看出,限制對比度自適應直方圖均衡派生圖影響到增強結果的局部對比度,將限制對比度自適應直方圖均衡派生圖用原圖代替后,圖像的局部對比度降低;圖7(c)與圖7(a)相比,圖像的整體亮度降低,這說明伽馬校正派生圖對增強結果的全局亮度有較大提升作用;圖7(d)與圖7(a)相比,顏色飽和度嚴重下降,這表明亮通道增強派生圖起到了提升增強結果顏色飽和度的作用,也間接影響到圖像的主觀視覺感受。圖7(e)是將對數變換派生圖用原圖替換后的增強結果,替換后,圖像出現過曝的現象,這說明在MDIIN的映射中,對數變換派生圖與最終增強結果的亮度為負相關關系。

3.3.4?時間復雜度分析

此外,本文也對各算法的時間復雜度進行了比較。表4中記錄了各算法分別處理mesh、meeting、girl、mountain四張圖片的時間。Dong算法、LIME、MF、NPEA、LNET算法均在Matlab2017中運行,本文算法在深度學習框架Pytorch中運行,代碼中使用GPU加速。電腦的CPU型號為Intel Core i7-7700HQ,GPU型號為Nvidia 1080TI。

從表4可看出:NPEA的處理時間最長;LNET算法由于未使用GPU加速,因此時間也較長;Dong算法、LIME、MF算法的處理時間較短,均在1s以內;本文算法的處理時間最短,只需0.1s左右。因此,在算法處理速度上本文算法也具有優勢。

5?結語

本文提出一種將傳統圖像增強手段與深度學習算法結合的弱光照圖像增強算法。與原始圖像相比,四種傳統增強手段生成的派生圖在對比度、亮度、顏色飽和度上均有提升。卷積神經網絡可充分激活各派生圖的優點從而輸出光照明亮視覺效果良好的增強圖像。本文算法不受Retinex模型約束,無需估計光照圖像和反射率圖像,直接端到端生成增強圖像。由于訓練數據集中包含豐富的場景和光照條件,因此本文算法也無需調整任何參數,在光照較弱和光照不均勻的情況下均表現突出。本文在合成弱光照圖像和真實弱光照圖像上均進行了對比實驗,實驗結果從主觀感受和客觀評價指標兩方面都驗證了本文算法的有效性。與對比算法相比,本文算法的增強圖像在圖像質量、圖像細節豐富程度、圖像對比度上均具有優勢。

在分析各派生圖作用時,本文算法中對數變換派生圖與最終增強結果的亮度之間為負相關關系,這有可能是伽馬變換派生圖與對數變換派生圖作用重疊導致的。因此,在下一步研究中,嘗試保留伽馬變換派生圖和對數變換派生圖中的一個進行實驗。

參考文獻(References)

[1] 康曉東, 王昊, 郭軍, 等.無監督深度學習彩色圖像識別方法[J]. 計算機應用, 2015, 35(9): 2636-2639. (TANG X D, WANG H, GUO J, et al. Unsupervised deep learning method for color image recognition[J]. Journal of Computer Applications, 2015, 35(9): 2636-2639.)

[2] 楊朔, 陳麗芳, 石瑀, 等.基于深度生成式對抗網絡的藍藻語義分割[J]. 計算機應用, 2018, 38(6): 1554-1561. (YANG S, CHEN L F, SHI Y, et al. Semantic segmentation of blue-green algae based on deep generative adversarial net[J]. Journal of Computer Applications, 2018, 38(6): 1554-1561.)

[3] LI H M. Deep learning for image denoising[J]. International Journal of Signal Processing, Image Processing and Pattern Recognition, 2014, 7(3): 171-180.

[4] CAI B, XU X, JIA K, et al. DehazeNet: an end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198.

[5] REN W, LIU S, ZHANG H, et al. Single image dehazing via multi-scale convolutional neural networks[C]// ECCV 2016: Proceedings of the 2016 European Conference on Computer Vision. Berlin: Springer, 2016: 154-169.

[6] LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Piscataway, NJ: IEEE, 2017: 136-144.

[7] LAND E H. The Retinex[J]. American Scientist, 1964, 52(2): 247-264.

[8] LEE C, LEE C, KIM C S. Contrast enhancement based on layered difference representation of 2D histograms[J]. IEEE Transactions on Image Processing, 2013, 22(12): 5372-5384.

[9] PISANO E D, ZONG S, HEMMINGER B M, et al. Contrast limited adaptive histogram equalization image processing to improve the detection of simulated spiculations in dense mammograms[J]. Journal of Digital Imaging, 1998, 11(4): 193-200.

[10] GUO X, LI Y, LING H. LIME: low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2017, 26(2): 982-993.

[11] FU X, LIAO Y, ZENG D, et al. A probabilistic method for image enhancement with simultaneous illumination and reflectance estimation[J]. IEEE Transactions on Image Processing, 2015, 24(12): 4965-4977.

[12] FU X, ZENG D, HUANG Y, et al. A weighted variational model for simultaneous reflectance and illumination estimation[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2016: 2782-2790.

[13] WANG S, ZHENG J, HU H M, et al. Naturalness preserved enhancement algorithm for non-uniform illumination images[J]. IEEE Transactions on Image Processing, 2013, 22(9): 3538-3548.

[14] FU X, ZENG D, HUANG Y, et al. A fusion-based enhancing method for weakly illuminated images[J]. Signal Processing, 2016, 129: 82-96.

[15] DONG X, WANG G, PANG Y, et al. Fast efficient algorithm for enhancement of low lighting video[C]// Proceedings of the 2011 IEEE International Conference on Multimedia and Expo. Piscataway, NJ: IEEE, 2011: 1-6.

[16] FOTIADOU K, TSAGKATAKIS G, TSAKALIDES P. Low light image enhancement via sparse representations[C]// ICIAR 2014: Proceedings of the 2014 International Conference on Image Analysis and Recognition. Berlin: Springer, 2014: 84-93.

[17] LI C, GUO J, PORIKLI F, et al. LightenNet: a convolutional neural network for weakly illuminated image enhancement[J]. Pattern Recognition Letters, 2018, 104: 15-22.

[18] LORE K G, AKINTAYO A, SARKAR S. LLNet: a deep autoencoder approach to natural low-light image enhancement[J]. Pattern Recognition, 2017, 61: 650-662.

[19] MAO X J, SHEN C, YANG Y B. Image restoration using very deep convolutional encoder-decoder networks with symmetric skip connections[C]// Proceedings of the 30th International Conference on Neural Information Processing Systems. New York: Curran Associates, 2016: 2810-2818.

[20] TSAI Y H, SHEN X, LIN Z, et al. Deep image harmonization[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2017: 2799-2807.

[21] REN W, MA L, ZHANG J, et al. Gated fusion network for single image dehazing[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2018: 3253-3261.

[22] XIONG W, LUO W, MA L, et al. Learning to generate time-lapse videos using multi-stage dynamic generative adversarial networks[C]// Proceedings of the 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE, 2018: 2364-2373.

[23] LIU Y, ZHAO G, GONG B, et al. Improved techniques for learning to dehaze and beyond: a collective study [EB/OL]. [2018-07-26]. https://arxiv.org/pdf/1807.00202.

[24] KINGMA D P, BA J L. ADAM: a method for stochastic optimization [EB/OL]. [2018-05-10]. https://simplecore.intel.com/nervana/wp-content/uploads/sites/53/2017/06/1412.6980.pdf.

[25] 王一寧, 秦品樂, 李傳朋, 等.基于殘差神經網絡的圖像超分辨率改進算法[J]. 計算機應用, 2018, 38(1): 246-254. (WANG Y N, QIN P L, LI C P, et al. Improved algorithm of image super resolution based on residual neural network[J]. Journal of Computer Applications, 2018, 38(1): 246-254.)

[26] 梁中豪, 彭德巍, 金彥旭, 等.基于交通場景區域增強的單幅圖像去霧方法[J]. 計算機應用, 2018, 38(5): 1420-1426. (LIANG Z H, PENG D W, JIN Y X, et al. Single image dehazing algorithm based on traffic scene region enhancement[J]. Journal of Computer Applications, 2018, 38(5): 1420-1426.)