基于社會視頻監控信息源的地震影響范圍快速勾畫

李東平 陳海鵬 張凱 劉倩倩

摘要:廣泛分布于城鄉各地的社會視頻監控是震后獲取地震災情的重要數據源。基于地震視頻災情判讀系統,對基于視頻運動估計方法的主要技術原理和分析處理過程進行改進,并將其應用于2017年浙江臨安4.2級地震影響場快速評估中。結果表明:利用該改進方法在震后4 h內得到了基于社會監控的烈度分布,計算得到的最高烈度與現場實際調查相同,等震線優勢方向與現場工作結果一致,V度面積和現場工作結果接近。

關鍵詞:地震影響場;視頻監控;地震應急;場景深度估算

中圖分類號:P315.941? ?文獻標識碼:A? ?文章編號:1000-0666(2019)02-0187-09

0 引言

破壞性地震發生后如何快速準確地了解災情范圍,準確繪制地震影響范圍分布圖,并在此基礎上做出快速災情評估,從而及時組織震后救災工作,是當前防震減災工作中一個亟待解決的科學問題。地震科技工作者一直努力研究地震烈度快速評估相關技術,當前主要方法包括:基于強震動觀測臺網獲得儀器烈度分布圖,利用無人機、遙感技術進行烈度圖的快速勾畫或采用歷史經驗公式生成地震影響場(周洋等,2017)。以上技術近年來取得了一定進展,但在實際地震應急中效果不盡理想,最直接的災情獲取手段仍有欠缺(李東平等,2017)。

近年來,隨著信息和大數據等各類高新技術的飛速發展,對信息采集傳感器的需求不斷增加,作為典型的信息采集終端,視頻監控得以大量布設,遍及城鄉各處。海量的社會視頻源可以真實記錄地震發生時的狀況,通過技術處理還可以提取災害空間分布情況。2015年9月,國家發布了《促進大數據發展行動綱要》,提出要“大力推動政府部門數據共享”;2016年12月,發布了《“十三五”國家信息化規劃》,將“推動信息跨部門跨層級共享共用”列入重點任務分工清單(劉艷,2017)。此后各級政府多次發文推進和落實部門間數據共享工作,這些都為數字政府的實施和推廣提供了強大推力,政府數據共享作為改革的重要內容,備受關注。由政府專業部門掌握的公共安全視頻監控聯網也是數據共享的重要內容之一。省級地震部門作為公益性政府部門,也開始獲取包括公共安全視頻監控聯網在內的大量社會視頻源數據。

目前在青海、浙江、四川等省都有通過社會視頻監控信息獲取震后災情分布的案例,許多學者開展了基于視頻監控的地震災情獲取和損失評估研究,取得了一定的成果。夏旻等(2008)使用監控錄像資料進行強地面運動參數估計,并在汶川地震中初步應用;田國偉等(2015)采用視頻圖像處理技術進行振動臺試驗、動態位移測量;日本千葉商業大學通過研究震后人們在社交媒體上討論的各種話題,基于視頻共享網站中的用戶評論數據,分析地震造成的破壞情況(Takako,Tesuji,2013),為地震災情獲取開拓了新思路。筆者在前人研究的基礎上,探索了基于規范建設的視頻監控信息源,利用模型算法提取震時的監控視頻運動估計值,以推斷地震影響范圍的方法。

1 基于場景深度估算地面強震動

1.1 前期的研究成果

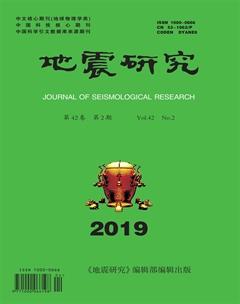

筆者自2013年以來開展了基于社會視頻源的地震影響場勾畫方法研究,基于多次震例探索了震后在海量的社會視頻監控信息源支持下,利用定性分析烈度經驗矩陣,建立監控視頻與地震烈度的相對關系,在視頻監控中通過模型提取震害和烈度信息,建立了基于視頻運動估計的地面強震動定量分析方法,目前利用該方法可計算出監控點的近似地震動峰值加速度值。基于該原理開發了地震視頻災情判讀系統(圖1),并應用于2014年浙江文成—泰順4.2級地震、2017年浙江磐安3.5級地震等應急處置工作(李東平等,2017)。

ASP是微軟公司開發的代替CGI腳本程序的一種應用,它可以與數據庫和其它程序進行交互,是一種簡單、方便的編程工具。ASP是一種服務器端腳本編寫環境,可以用來創建和運行動態網頁或web應用程序,它包含HTML標記、普通文本、腳本命令以及COM組件等(胡秀源,2011),ASP的以上特點比較適合應急指揮中心的工作環境。地震視頻災情判讀系統就是基于ASP開發的。

1.2 基于視頻運動估計方法的改進

在近年來的幾次地震應急中,筆者及團隊不斷改進視頻分析方法,總結了在不同烈度下的探頭晃動和人員反應表現形式,并推導出地震烈度經驗矩陣,進一步進行以視頻運動估計的精確定量計算。但該方法只對高烈度區、圖像抖動明顯的監控點識別較好,而低烈度區監控點的計算值與實際差距較大。在對算法進行了部分優化,引入場景深度估計方法后,圖像幀之間像素的運動距離和速度值計算準確性均有明顯提高。

地震視頻分析的步驟如下:①對地震視頻逐幀進行分析,利用宏塊分析法計算出相鄰幀之間發生位移的宏塊。②對幀間圖像發生位移的宏塊進行統計,近而可以計算出地震視頻中每一幀圖像發生震動的像素個數。例如:導入的視頻分辨率為320×384像素,每一幀圖像共有20×24個16×16宏塊。通過對地震發生時振動視頻某幀圖像進行運動計算分析,得出該幀圖像的振動宏塊為M塊,該幀圖像發生震動的像素為M×16×16個

③計算地震視頻片段所有圖像幀中上述運動像素的運動矢量均值,并將其作為該視頻地震烈度的參考值(常安琪,2015)

由于不同的地震視頻具有不同的地震加速度和速度值,為此需要構建地震視頻數據庫。在該數據庫中,每個地震視頻樣本均以預先通過地震設備得到的Ground Truth地震數據(烈度、速度和加速度等)作為人工標注值。將具有相似烈度(比如某一范圍內的烈度)的地震視頻歸為同一類,并通過支持向量機(Support Vector Machine,簡稱SVM)對不同烈度的地震視頻樣本進行學習,而輸入的特征值即為該視頻的運動矢量均值。利用訓練好的SVM模型,對不同特征值輸入的地震視頻樣本輸出其烈度的預測。筆者及團隊自2013年開始至今,已完成了1 000余個地震視頻的建庫工作。

通過地震視頻計算地震的速度和加速度,需要知道地震視頻中不同像素點之間代表的真實距離值。由于不同監控攝像機架設的高度和俯仰角都不同,因此像素之間的真實距離難以準確獲取,主要是因為:不同監控場景中任意2個像素點的距離所對應的真實世界中的距離都是不同的,并且隨著距離監控相機光心的距離變化而變化,無法通過參考圖像中的某些物體尺寸做等價距離推算。一種近似的解決方案是通過機器學習技術估計場景深度信息,而這可通過單幅圖像深度估計算法獲得。

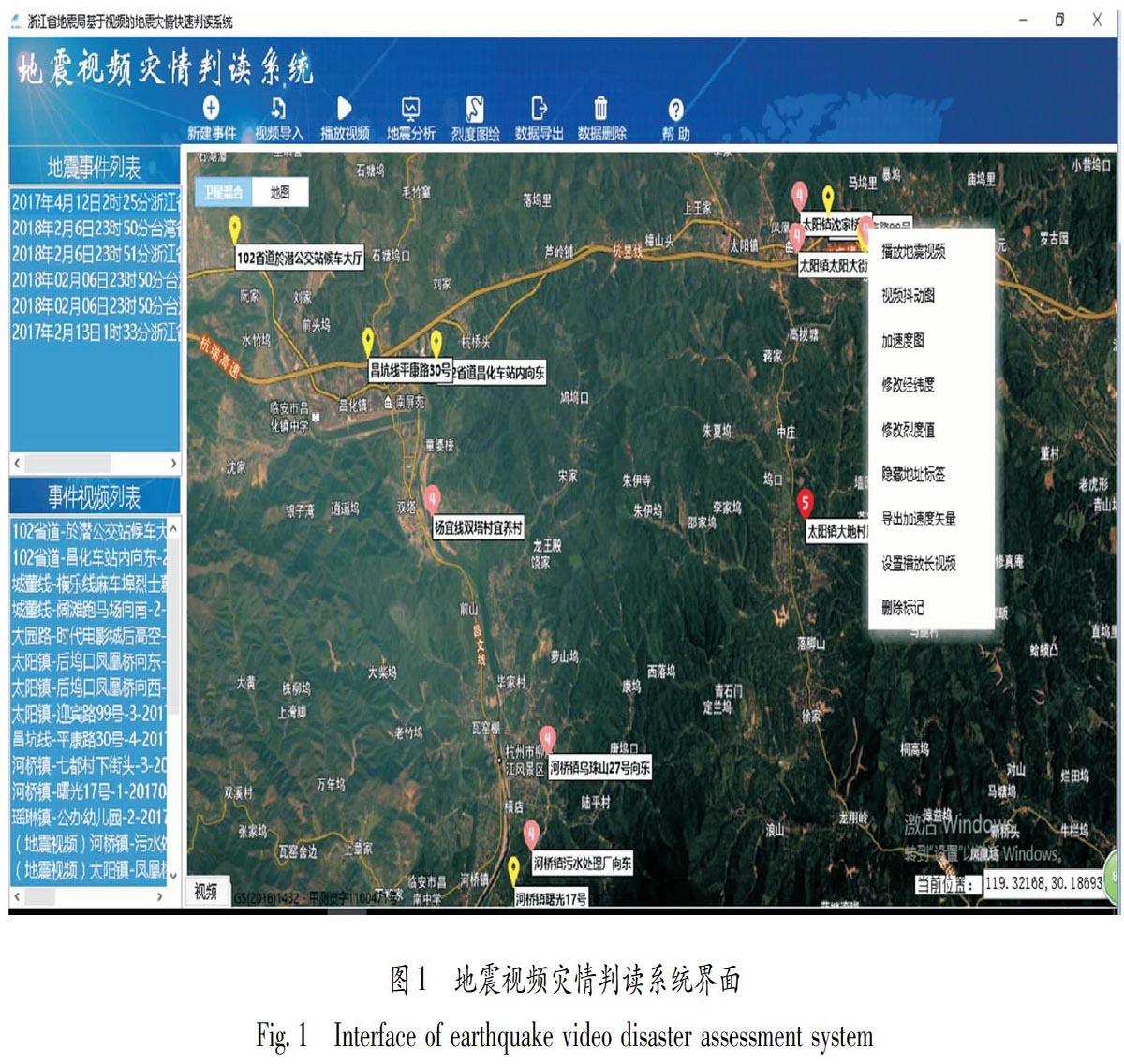

場景深度估計算法步驟如圖2所示。首先,對地震視頻中的每幅圖像進行無監督分割操作以生成超像素(Superpixel)區域。再以每個超像素為中心,尺寸為224×224像素的矩形圖像塊作為輸入,訓練一個具有5個卷積層和4個全連接層(5conv+4fc)的卷積神經網絡(Convolutional Neural Network,簡稱CNN),如圖3所示。在5個卷積層中分別使用了11×11,5×5和3×3的卷積模板,并采用修正線性單元(Rectified LinearUnits,簡稱ReLU)作為激活函數以及2×2的池化操作;在前2個全連接層中使用ReLU作為激活函數,第3個全連接層使用f(x)-(1+e-z)-1作為激活函數,而最后一個全連接層則沒有使用。最終的網絡輸出為對應每個超像素的一維深度值(楊宇翔等,2015)。

對該CNN模型進行訓練時,樣本采用的是NYU v2 Kinect 數據集和Make3D數據集,上述數據集不僅具有不同場景類別的圖像樣本,而且每個圖像樣本均有對應的采集自Kinect深度相機和激光雷達的真實距離數據。通過上述2個數據集訓練得到的CNN模型,可輸出每個超像素所對應的深度預測值ZP。

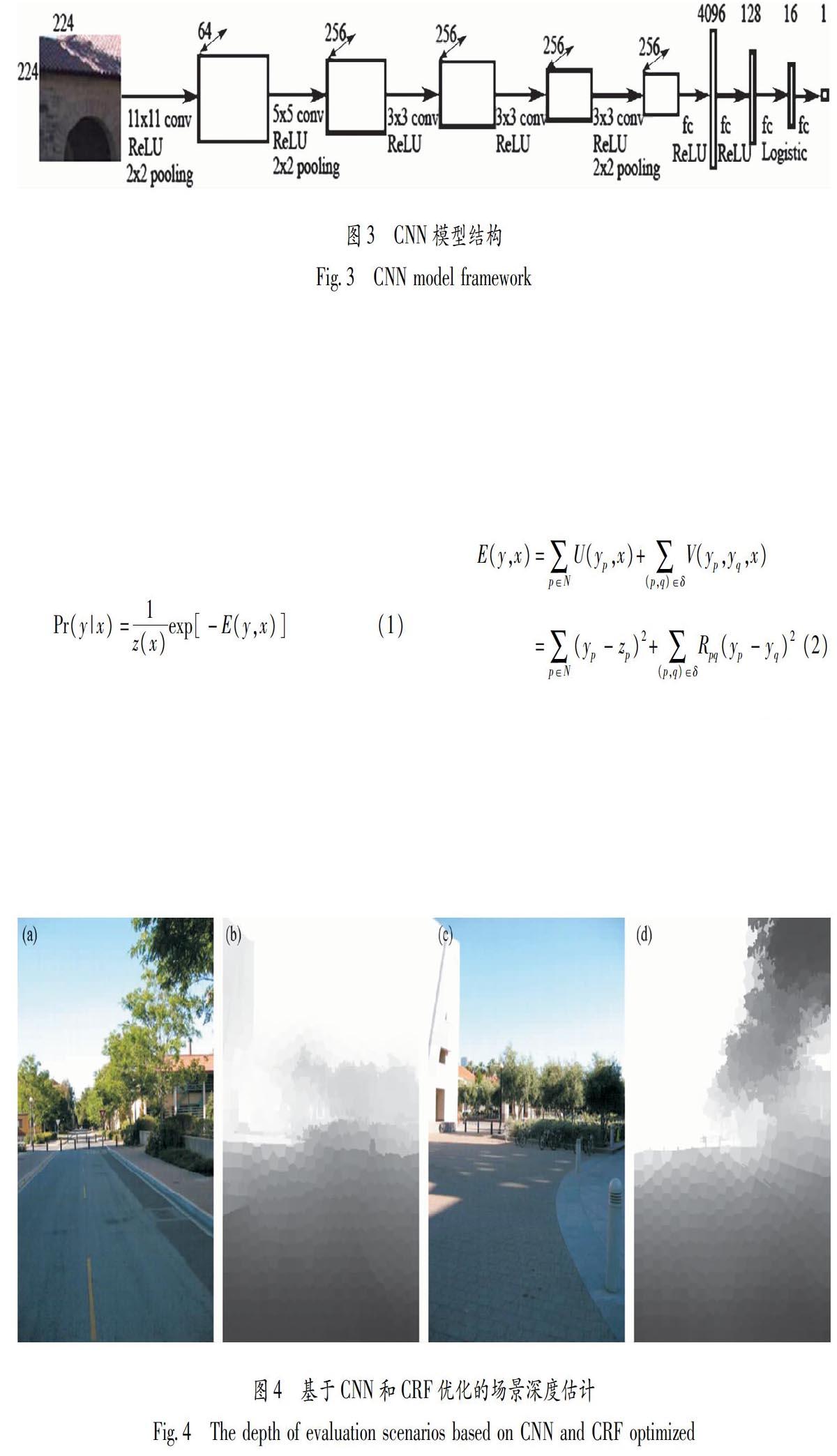

然而,僅通過CNN模型推理得到的深度圖通常存在相鄰超像素的深度跳躍的情況。為了獲取更為平滑而準確的深度圖,筆者采用了條件隨機場(Conditional Random Field,簡稱CRF)模型,通過最大后驗概率(Maximum A Posteriori,簡稱MAP)估計最小化條件概率分布Pr(y|x):

式中:z(x)是z以觀察序列x為條件的概率歸一化因子。將CNN模型輸出的每個超像素的深度預測值ZP作為數據項U(yp,x)(x為超像素特征,即超像素的深度值)的核心部分。在構建平滑項U(yp,yq,x)時,則通過一個具有全連接層的單層神經網絡模型訓練多種不同類型的超像素相似度Rpq,比如:相鄰超像素p和q顏色均值之差,顏色直方圖之差以及紋理特征值之差等。最后的能量函數E(y,x)定義為:

最終經過CRF優化得到的場景深度估計結果如圖4所示。在圖4a和4c所對應的場景深度圖4b和4d中,像素對比度越弱的代表距離相機越近,像素對比度越強則代表距離越遠。

在得到場景深度圖之后,便可以估計所得到圖像中像素之間所代表的大致真實距離。地震視頻片段中每幅圖像的地震速度和加速度均可由其運動矢量對應的真實運動距離分別計算得到。在地震視頻片段中,第N幀圖像中每個運動像素的速度VN可由其運動矢量MV所對應的真實距離DN(即運動矢量起點像素和終點像素所對應的深度值之差)除以時間T(即1/F,其中F為當前圖像幀率)計算得到:

地震視頻的加速度aN則是由相鄰圖像幀N和N+1之間的速度差除以時間T計算求得:

由于該模塊需要逐幀計算場景深度,因而運算速度較為緩慢。針對基于運動矢量統計截取的地震視頻中可能存在一些誤檢,比如夜間車輛的燈光以及白天的車輛移動等場景時常會因為存在較大的像素運動而被誤檢為地震。為此,我們加入一些處理方法將上述可能的誤檢場景剔除。

2 地震實例2.1 地震概況? 2017年4月12日2時25分,浙江省杭州市臨安區發生4.2級地震,微觀震中位于臨安區河橋鎮與潛川鎮交界處的九龍坑(30.08°N,119.34°E),震源深度15 km。震中附近區域震感強烈,部分房屋出現墻體裂縫、掉瓦等震害現象。地震發生后,浙江省地震局立即啟動Ⅲ級應急響應。現場震害評估與科學考察組通過對25個調查點資料的綜合整理分析,參考震源機制解和震中附近地震構造等資料,確定了此次地震的最高烈度為Ⅴ度,等震線呈橢圓形,長軸方向呈NE向,為7.4 km,短軸為3.8 km,V度區總面積約22.6 km2,主要涉及到臨安市潛川鎮和於潛鎮。

2.2 視頻監控資料的選取及分析流程

地震發生后,浙江省地震應急指揮中心通過視頻監控共享系統,在震后2 h內獲取了震中附近發震時刻77個視頻點位圖像數據,通過對比攝像數據中人員反應、鏡頭晃動等情況,對烈度做了初步判定,并利用地震視頻災情判讀系統對視頻點的地面強震動進行了定量分析。震后4 h內得到了基于社會視頻監控的烈度分布,計算得到的最高烈度與現場實際調查相同,等震線優勢方向與現場工作結果一致,V度區面積和現場工作結果接近。

工作流程如下:首先,浙江省地震應急指揮中心啟動了快速評估系統,繪制了基于經驗模型的地震影響場分布圖(圖5),在模型計算得出的IV度區及其以上區域進一步選取了監控探頭。浙江區域的烈度衰減模

型采用經過修正的經典模型(李東平,2011):

通過初步篩選,剔除了部分非高清視頻和受干擾視頻,選取了49個點位進行數據分析。個別攝像頭處理結果和現場科考調查隊得出的數據有一定差距,這是因為對比2013年以來的視頻資源發現,每年的高清監控比例在不斷增加,大量的高清探頭替代了非高清探頭(圖6),獲取的數據質量也大幅度提高。從第一時間獲取的視頻監控中,列出20個典型的攝像頭,獲取的資料包括標準的經緯度信息和視頻分析得出的烈度加速度、現場調查烈度值(表1)。由于在Ⅴ度區范圍內沒有強震臺,因此筆者采用的對比數據是現場調查數據。從表1可以看出視頻分析加速度與現場調查烈度值有一定差距,但已經比較接近(圖7)。