融合注意力機制的多通道卷積與雙向GRU模型的文本情感分析研究

袁和金,張 旭,牛為華,崔克彬

(華北電力大學 控制與計算機工程學院,河北 保定 071003)

0 引言

近年來,隨著互聯網技術的快速發展以及社交媒體的不斷涌現,越來越多的用戶習慣于通過社交媒體表達自己的觀點與想法,這就積累了大量的短文本數據。通過對這些信息利用情感分析的技術進行分析,可以發現用戶對特定產品、事件上的情感傾向,從而幫助研究機構掌握社會情緒動態[1]。情感傾向性分析,又稱主客觀分析,以挖掘文本信息中用戶表達的情感極性為目標。近年來,針對社交媒體的用戶觀點情感分析已經成為了自然語言處理(natural language processing, NLP)領域的熱點問題,具有非常高的研究與實用價值。因此本文的研究目的是提出一種文本情感分析模型,以提升文本情感分析的準確度。

目前,文本情感分析方法主要可以分為三種: 基于語義的情感詞典方法、基于傳統機器學習的方法以及基于深度學習的方法。基于語義的情感詞典方法的基礎是首先構建情感詞典,然后設定傾向性評價指標與方法,最后通過確定閾值來判定文本的傾向性。該方法實現較為簡單,不需要人工標注的數據集,但是由于情感詞典在構建時遇到的種種難題,其效果一般。基于機器學習的方法,首先需要人工對文本進行情感傾向性標注,其次通過人工設計特征,對文本情感特征進行提取,最后,使用相關機器學習方法,如樸素貝葉斯、支持向量機等構建分類器對文本情感進行分類[2]。該方法計算量小且易于實現,但需要人為進行特征工程操作,且泛化能力不足。

近年來興起的深度學習方法很好地彌補了上述方法的缺陷,已在圖像和語音識別中取得了巨大成就,并逐步應用到自然語言處理領域中。Bengio最早使用神經網絡構建語言模型。Kim等[3]使用卷積神經網絡(convolutional neural network, CNN)對短文本進行建模,完成了句子級別的文本情感分析任務。然而,這種方法也存在弊端,其忽視了待分類句子內部詞語之間的相互聯系。Irsoy等[4]使用循環神經網絡(recurrent neural network, RNN)為句子進行建模,從而進行情感分析,但CNN缺乏對文本提取特征的能力,同時會造成模型訓練耗時的問題。

本文利用深度學習模型,結合基于向量表示的語義合成原理,提出一種融合注意力機制的多通道卷積和雙向門限循環單元(bidirectional gated recurrent unit, BGRU)模型來解決文本情感分析問題。模型采用多通道卷積神經網絡進行有監督學習,在不同大小的窗口提取粒度不同的情感特征,從而識別更多的情感特征分類模式。雙向門限循環單元網絡能夠挖掘跨度更廣的語義依賴關系,從而更加充分地利用整個文本中的特征信息,有效識別文本情感極性。同時,在該模型中引入注意力機制(Attention Mechanism),更加有效地識別句子中信息表征量大的部分。

本文主要貢獻如下:

(1) 提出一種多通道卷積和雙向門限循環單元結合的網絡模型。該模型能夠利用不同尺寸的卷積核在不同通道內提取文本中粒度不同的特征信息,同時能夠保留文本信息間的序列關系,有效地獲取文本評論中句子內部及句子之間的相互聯系。

(2) 引入注意力機制。注意力機制能夠自適應地結合文本上下文信息,提取影響情感極性分類的關鍵文本特征,使模型能夠更關注于文本中重要的部分,有效提升模型分類準確度。

(3) 引入Maxout神經元,更好地提升模型抵抗梯度彌散的能力,加快模型收斂的速度;增強模型的泛化能力,提升模型魯棒性。

1 相關工作

1.1 情感分析

在過去的研究中,基于情感詞典的情感分析方法和基于傳統機器學習的監督學習方法,在情感分析任務中取得了很多成功。但是基于情感詞典的方法需要人為制定大量的判別規則,且泛化能力較差。基于傳統機器學習的方法需要對所輸入文本進行大量的預處理工作和復雜的特征工程。近年來,深度學習在情感分析工作中取得了重大的突破。一方面,深度學習方法不需要過多的預處理工作,緩解了模型對特征工程的依賴,極大地降低了人力成本;另一方面,基于深度學習的網絡模型能夠自學習提取文本情感特征,在情感分析任務中比傳統機器學習方法有更好的分類效果。

相較與一般前饋神經網絡而言,RNN引入了記憶單元使網絡具備了一定的記憶性,能夠較好地結合序列信息對數據進行建模。但其也存在一定的弊端,即會在訓練過程中出現梯度爆炸和梯度彌散等問題,從而造成訓練過程停滯。長短時記憶網絡(long short-term memory, LSTM)和門限循環單元在傳統RNN的基礎上引入門機制,較好地克服了RNN的弊端。基于此,很多模型在基本的LSTM、GRU模型上進行改進,取得了不錯的效果。Socher等[5]使用Tree-LSTM提取文本的語義特征。Ke等[6]在LSTM之上額外引入了外部記憶單元,提升了模型對歷史信息的處理能力,但由于外部記憶矩陣參數量較大,準確度提升有限。Schuster等提出的BRNN(bidirectional RNN)模型,通過采用雙向RNN的方式,同時處理正向與反向的信息,然后,將其輸出連接到同一個輸出層上,這樣便能夠記錄序列的雙向上下文信息。Tang等[7]在雙向LSTM的基礎上,引入注意力機制,提出CLSTM模型以此來解決文本級情感分析問題,取得了不錯的效果。依據上述分析可以得知,使用RNN模型能夠有效解決情感分析任務,其演化模型LSTM及GRU能夠在克服RNN弊端的基礎上捕捉文本長時依賴。然而LSTM和GRU模型是基于時序的,很難進行并行化訓練。對于大規模數據集而言,需要非常長的訓練時間。因此,基于CNN的方法開始受到廣泛的關注。

Kim[3]利用Word2Vec訓練得到詞向量,將句子映射成二維特征矩陣,使用一層卷積層對文本特征進行提取,之后連接池化層對最能代表文本情感詞匯的特征進行提取,提取后的結果作為全連接層的輸入,進而進行情感極性分類。Kalchbrenner等[8]提出了一種DCNN模型,這是一種動態的卷積神經網絡模型。在一次卷積操作之后,將序列中前K個最大的特征值進行保留,并送入分類器中進行分類。Santos等[9]提出一種神經網絡結構,該方法提取文本字符級的特征,不需要任何關于句子句法結構的輸入。Yin等[10]使用多通道不同尺寸的卷積神經網絡進行句子分類。基于CNN方法能夠有效提取文本內特征,同時大幅度降低模型訓練時間;其弊端在于無法考慮句子內部及句子間的依賴關系,丟失文本的序列性質的特征。

為了充分發揮CNN及RNN的各自優勢,越來越多的研究者將CNN與RNN相結合進行文本情感傾向性分析。Wang等[11]使用一層CNN和一層RNN構成融合模型,進行文本情感分析,實驗證明效果優于單純使用CNN和RNN模型。Wang等[12]提出區域CNN-LSTM網絡模型,其創新在于將文本按照句子為單位劃分區域,并行地進行卷積操作,之后將提取到的特征進行融合,作為LSTM的輸入,進而進行情感分類。Zhang等[13]使用基于Convolution-GRU模型對推特內容進行情感極性判別。

對上述模型進行分析,本文有如下思考:

(1) 對于詞語的向量化表示,高維分布式向量表示賦予具有相似詞義的詞語之間的高相似性。與此同時,與獨熱表示相比,詞嵌入方式可以更好地解決短文本的詞義冗余等問題,減少計算量。

(2) CNN在文本處理中能夠學習提取到位于文本不同位置上的局部特征。RNN模型能夠更好地考慮文本內的序列關系,并且能夠學習到較長序列文本依賴而不僅僅局限于局部特征之中。

(3) CNN與RNN模型的結合,一方面能夠充分利用CNN對文本特征較強的提取能力;另一方面可以發揮RNN在時間序列維度上強大的記憶能力及對文本的表征建模能力。這種結合方式對于提升情感分析準確度,具有較強的研究意義與研究價值。

1.2 卷積神經網絡

卷積神經網絡(CNN)最早應用于計算機視覺中,近年來,其在文本分類領域也有出色的表現[14]。CNN主要通過卷積層和池化層來學習輸入的局部特征,對表征的重要信息進行提取與保留。CNN無需過多的預處理工作便能夠達到預定效果,顯著地減輕了對特征工程的依賴。

CNN主要由輸入層、卷積層、池化層和全連接層組成。對于應用于自然語言處理領域的CNN而言,輸入層為詞匯的向量表示。對于給定長度為n的句子,輸入層矩陣的表示,如式(1)所示。

其中,m為詞向量維度。卷積層使用尺寸不同的卷積核對輸入矩陣進行卷積操作,提取輸入數據的局部特征,得到文本的特征向量,如式(2)所示。

其中,x為詞嵌入矩陣,W為權重矩陣,b為偏置量,f為卷積核激活函數。

經過卷積操作得到的特征向量,可以通過池化層進行進一步的下采樣,以提取序列中最重要的特征信息。池化后的輸出作為全連接層的輸入,進而對文本情感極性進行分類。

1.3 門限循環單元

門限循環單元是對循環神經網絡的改進。GRU通過引入更新門與重置門,有效地解決了RNN網絡在訓練過程的梯度爆炸與梯度彌散問題。相較LSTM而言,GRU精簡了網絡結構,減少了模型參數,提升了模型訓練速度。在自然語言處理任務中,GRU網絡可以學習詞語在句子中的長期依賴關系,更好地對文本進行表征建模。

GRU網絡通過記憶單元來記憶存儲句子中重要的特征信息,同時能夠對不重要信息進行遺忘。每一個GRU網絡神經元包括1個記憶單元和2個門單元。

在t時刻,對于給定的輸入xt,GRU的隱藏層輸出為ht,其具體的計算過程如式(3)~(5)所示。

其中,W為連接兩層的權重矩陣,σ和tanh為激活函數,z、r分別為更新門和重置門。

1.4 注意力機制

注意力機制的概念可以理解為從大量信息中有選擇地篩選出重要信息并且聚焦到這些內容上,同時忽略大多數不重要的信息。聚焦的過程體現在權重系數的計算上,權重越大則代表對該部分的關注度越高。在情感分析任務中引入注意力機制,可以使神經網絡更多地關注文本中包含情感信息較多的部分。

在自然語言處理領域, Bahdanau等[15]首次將注意力機制應用于自然語言處理領域,在機器翻譯任務上將翻譯和對齊同時進行,實驗證明了注意力機制在NLP任務中的有效性。Wang等[16]將多層注意力機制和卷積神經網絡結合用于句子關系分類任務中,模型在多個數據集上的實驗結果表明,使用注意力機制的模型比未使用的模型有更高的分類精度。Huang等[17]提出了一種結合注意力機制的LSTM網絡,通過對特定目標進行向量化處理,將特定目標作為注意力機制輸入LSTM網絡,提升了模型的準確度。鑒于融合注意力機制的神經網絡模型表現出色,本文在對文本進行情感分析的任務中,在使用深度神經網絡挖掘文本高層抽象語義的基礎上,引入注意力機制,使網絡模型能夠更多地關注能夠幫助識別文本情感極性的部分。

2 一種融合注意力機制的多通道CNN與雙向GRU的網絡模型

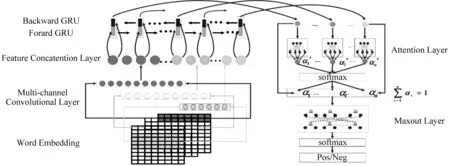

為了能夠提取更加有效的文本信息進行建模,本文提出了融合注意力機制的多通道卷積與雙向GRU模型(multi-channel convolution and bidirectional GRU with attention mechanism,ATT-MCNN-BGRUM)。模型主要包含詞向量層、多通道卷積層、特征融合層、雙向GRU層、注意力層、Maxout層。模型結構如圖1所示。

該模型首先使用GloVe預訓練詞向量將文本中的詞語映射成為低維的實數向量表示,建立表示文本的初始特征矩陣,將其作為模型的輸入。模型的多通道卷積層提取文本不同粒度的特征信息,并將特征信息進行融合送入雙向GRU層。雙向GRU層可以在保留序列信息的基礎上,有效獲取句子內部及句子間的相互聯系,對文本進行建模。在雙向GRU層上引入注意力機制,更好地把握文本中重要信息。最后將輸出送入分類器中,得到文本情感分類結果。

2.1 問題定義

對于給定文本的數據集D,其中包含有文本X{x1,x2,...,xm}和每個文本所包含的情感標簽Y{y1,y2,...,ym}。其中,每個文本句子Xi由n個詞組成,表示為Xi{xi1,xi2,...xin},則最終的目標函數,如式(7)所示。

其中:θ代表該模型中涉及到的所有參數,f(·)為該網絡模型的數學形式表達。

圖1 融合注意力機制的多通道卷積與雙向GRU模型

2.2 多通道卷積門限循環神經網絡

多通道卷積門限循環神經網絡(MCNN-BGRU)首先使用多通道卷積神經網絡提取文本不同粒度的特征信息。然后特征信息經融合,使用雙向GRU網絡順序集成文本特征,完成文本的特征表達。

多通道卷積神經網絡接收詞向量作為網絡的輸入。詞向量核心在于將詞語通過映射,用一種低維實數向量表示。定義數據集中句子最大長度為n,文本可表示為由n個d維的詞向量拼接而成的二維矩陣x∈Rd×n,如式(8)所示。

其中,⊕為拼接運算符,wi∈Rd為句子中第i個詞對應的詞向量。

CNN能夠高效提取詞匯在句中的局部上下文信息[18]。對于卷積操作,選擇不同尺寸的卷積核大小,可以提取廣度不同的上下文信息,即不同粒度的序列特征信息。

假定第i個通道卷積操作所使用的卷積核w∈Rh×d,其中h為濾波器窗口寬度,控制單詞的個數,則提取后的一個特征cij可以表示為式(9)。

式(9)中,b∈R為偏置項,f(·)為卷積核函數。

xi:i+h-1∈Rh×d代表h個詞構成的局部濾波窗口,濾波窗口逐步滑動至xn-h+1:n,{x1:h,x2:h+1,xn-h+1:n}所對應的第i個通道,所得到的特征序列如式(10)所示。

將文本經過多通道卷積層產生的特征序列進行連接,形成融合特征序列c。 假設通道個數為k,則如式(11)所示。

為了更有意義的充分利用粒度不同的序列特征,本文將多通道卷積操作提取到的特征序列進行融合,共同作為雙向GRU的輸入。使用共享權重的雙向GRU將粒度不同的特征信息映射到相同的向量空間內。

對于給定的n維輸入(x1,x2,...,xn),在t時刻,BGRU的隱藏層輸出ht,其具體的計算過程如式(12)~(13)所示。

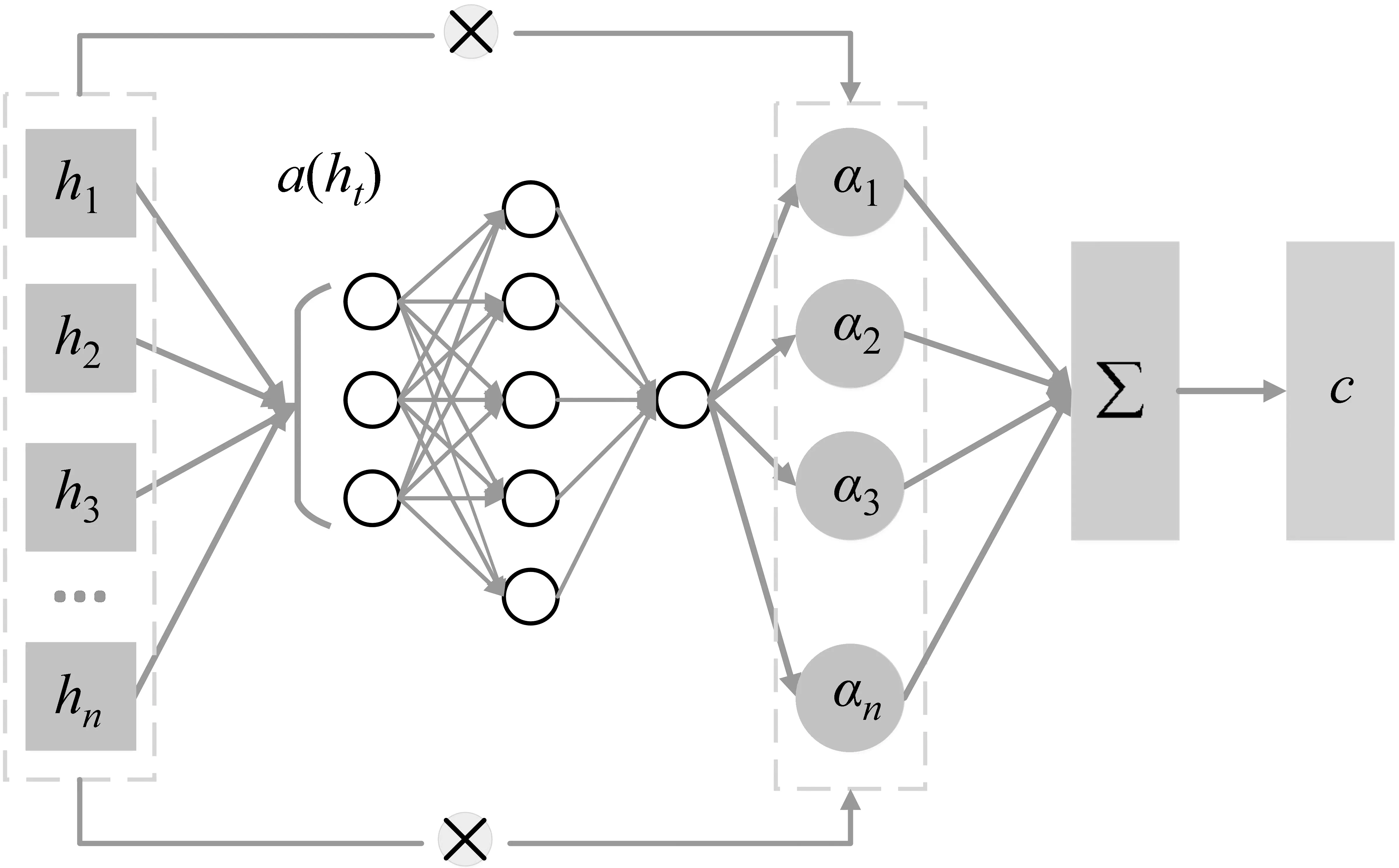

2.3 融合注意力機制的MCNN-BGRU網絡

MCNN-BGRU模型考慮了句子之間的語義信息,同時能夠處理文本序列的長依賴關系,實現對文本的充分表征與挖掘。為了使模型能夠高度關注文本中的重要信息,本文在上述模型的基礎上結合注意力機制構建ATT-MCNN-BGRU模型。注意力機制示意圖如圖2所示。

圖2 注意力機制示意圖

注意力機制的核心在于通過結合文本上下文信息,感知重要的語義特征。通過給序列層中各隱藏節點分配合適的注意力權重進行重要度的劃分。權重越大,代表對于情感極性分類越重要。構建注意力機制方式,如式(15)~(17)所示。

其中,a為學習函數,僅由隱藏狀態序列ht決定。BGRU層的隱層狀態序列ht送入到學習函數中,經過加權處理,得到注意力權值α。 依據注意力權值,對所有的序列層中所有節點的隱含向量進行加權,得到最終的文本特征向量s。

2.4 模型訓練

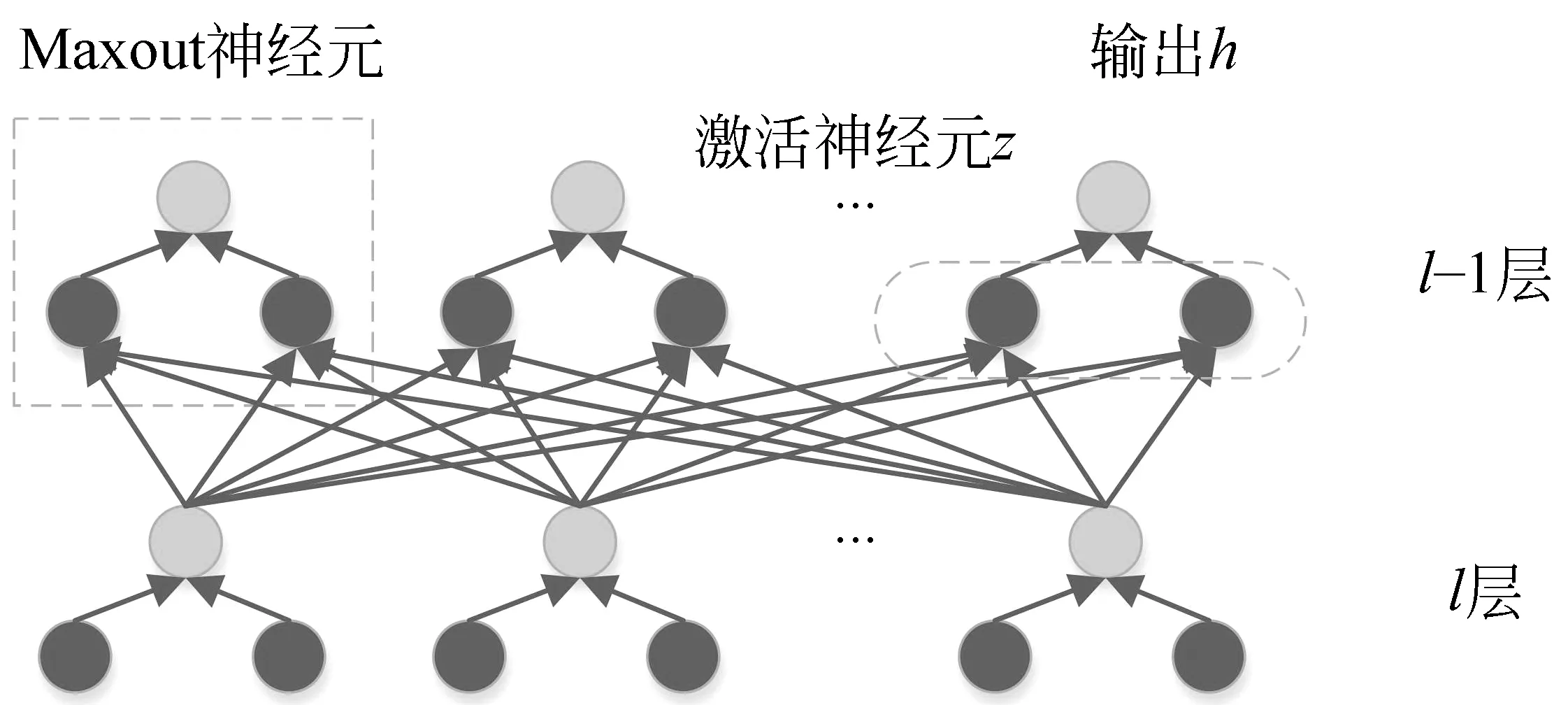

為了解決模型訓練中的梯度彌散問題,使得模型能夠更好的優化,具備更好的訓練效果,本文引入Maxout神經元,構成ATT-MCNN-BRGUM模型。Maxout神經元如圖3所示。

圖3 Maxout神經元示意圖

每一個Maxout神經元都由多個不同的激活函數神經元組成,其輸出是其中的最大值,如式(18)所示。

本文使用softmax函數接收ATT-MCNN-BGRUM模型的輸出,得到待分類句子的情感極性判別,如式(19)所示。

其中W為權重矩陣,b為偏置。

其中,i為句子索引,j表示類別的索引,λ表示L2正則化損失函數的懲罰項,θ表示模型設置的參數。

3 實驗與分析

本文將ATT-MCNN-BGRUM模型應用到情感分析任務上。在實驗中采用Pennington等[19]提出的預訓練好的300維GloVe詞向量進行初始化。對于詞典中不存在的詞,采用均勻分布U(-ε,ε)進行初始化設定,其中ε設置為0.01。該情感分析模型運行于Ubuntu 16.04系統,使用的深度學習框架為Keras 1.2.2。

3.1 實驗數據

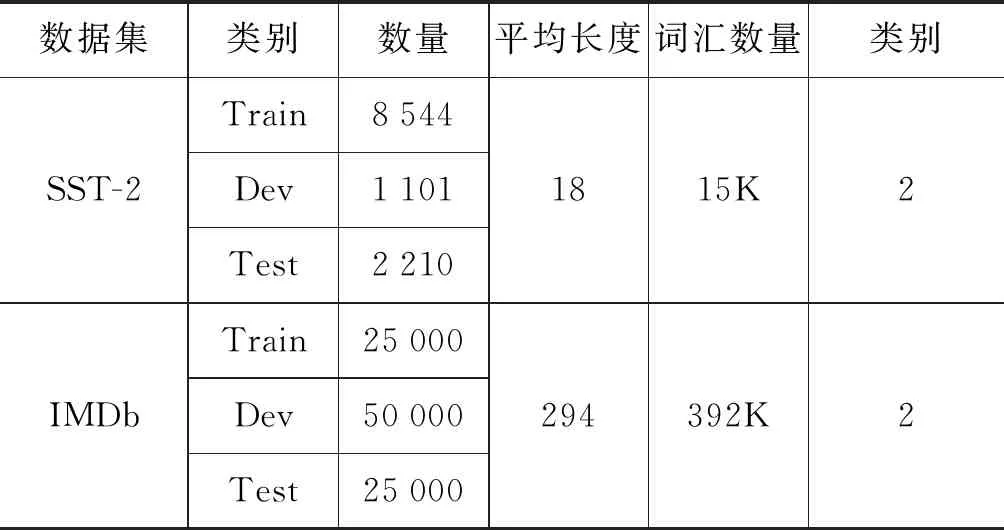

本實驗所采用的數據集為IMDb數據集和SST-2數據集。IMDb數據集共包含50 000條來自美國電影評價網站的數據集,文本平均長度為294,按照情感極性可以劃分為積極(Positive)和消極(Negative)兩種情感類別。SST-2數據集來自于Stanford Sentiment Treebank,是對電影評論數據集MR數據集的擴展[3],約有11 855條文本。本文的目標是區分不同文本的情感極性,即Positive和Negative。本文所需的實驗數據的統計如表1所示。

表1 實驗數據集統計信息

3.2 實驗參數設置

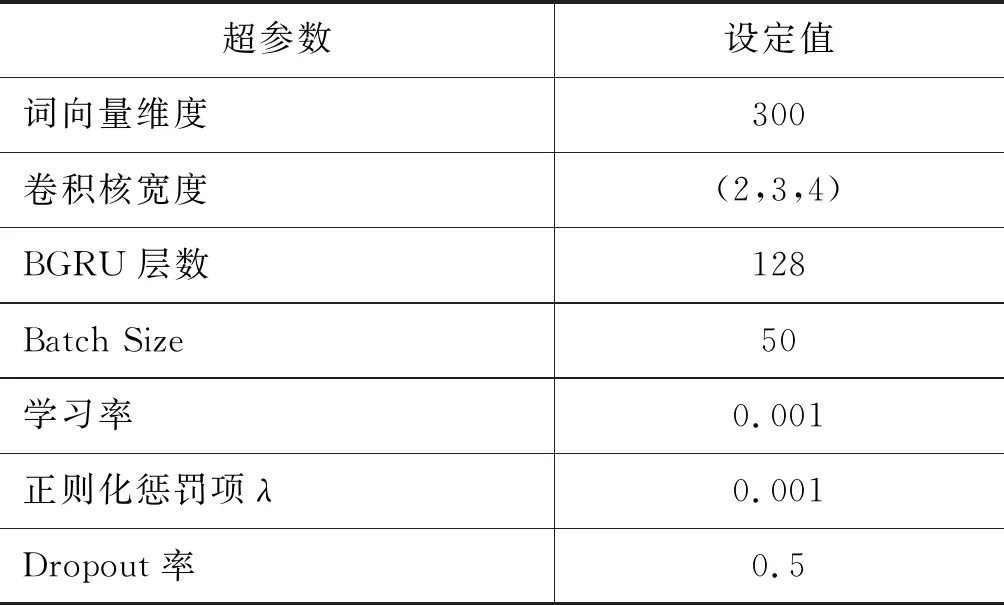

在本文實驗中,為了獲取豐富的特征信息,三通道所選取的卷積核窗口寬度分別為2,3,4。此外,為了防止訓練過度,出現過擬合的現象,本文在實驗過程中使用了dropout機制和權重正則化限制。模型的詳細超參數設置如表2所示。

表2 參數設置

3.3 實驗對比

將本文融合注意力機制的多通道卷積與雙向GRU混合模型方法ATT-MCNN-BGRUM,與以下方法在兩個不同的數據集上進行實驗。

本文的對照模型大致分為四組: 傳統機器學習方法組、CNN組、RNN組以及融合CNN、RNN模型方法組。下面對部分待對比模型進行簡要介紹。

① CNN-rand/CNN-static

該方法首先構建n×k詞向量矩陣,之后使用不同尺寸的濾波器對詞向量矩陣進行卷積操作,再將得到的特征序列進行最大池化操作,最后進行分類。CNN-rand與CNN-static兩種方法的區別在于CNN-rand的詞向量來自于隨機初始化設置而CNN-static來自于Word2Vec方法。

② CNN-multi-channel

該方法是對CNN-static的改進,其核心在于使用雙通道的詞匯矩陣對原始文本進行表示,兩通道經過卷積操作得到的特征經過拼接送入全連接層進行分類。

③ DCNN

該方法核心思想在于使用深度卷積神經網絡對文本進行建模。模型中包含兩組卷積。其中卷積使用寬卷積,很好地對文本的邊緣信息進行提取;采用k-max-pooling方法,降低了池化操作對序列信息的丟失。

④ LSTM/GRU

LSTM和GRU為RNN的兩種變體模型。

⑤ Bi-LSTM

該方法能夠結合序列正反兩個方向信息對文本進行建模,解決了文本長依賴問題。

⑥ ATT-BLSTM

該方法在Bi-LSTM的基礎上引入了注意力機制,能夠有效地捕獲文本中的關鍵信息。

⑦ CNN-LSTM-Word2vec/CNN-GRU-Word2vec

該方法將CNN與LSTM/GRU模型相結合,提出CNN-LSTM-Word2Vec/CNN-GRU-Word2Vec對短文本進行情感分析。該模型使用Word2Vec構建詞向量,卷積后進行最大池化,最后通過LSTM/GRU對文本序列進行建模,從而完成情感分析任務。

3.4 結果分析

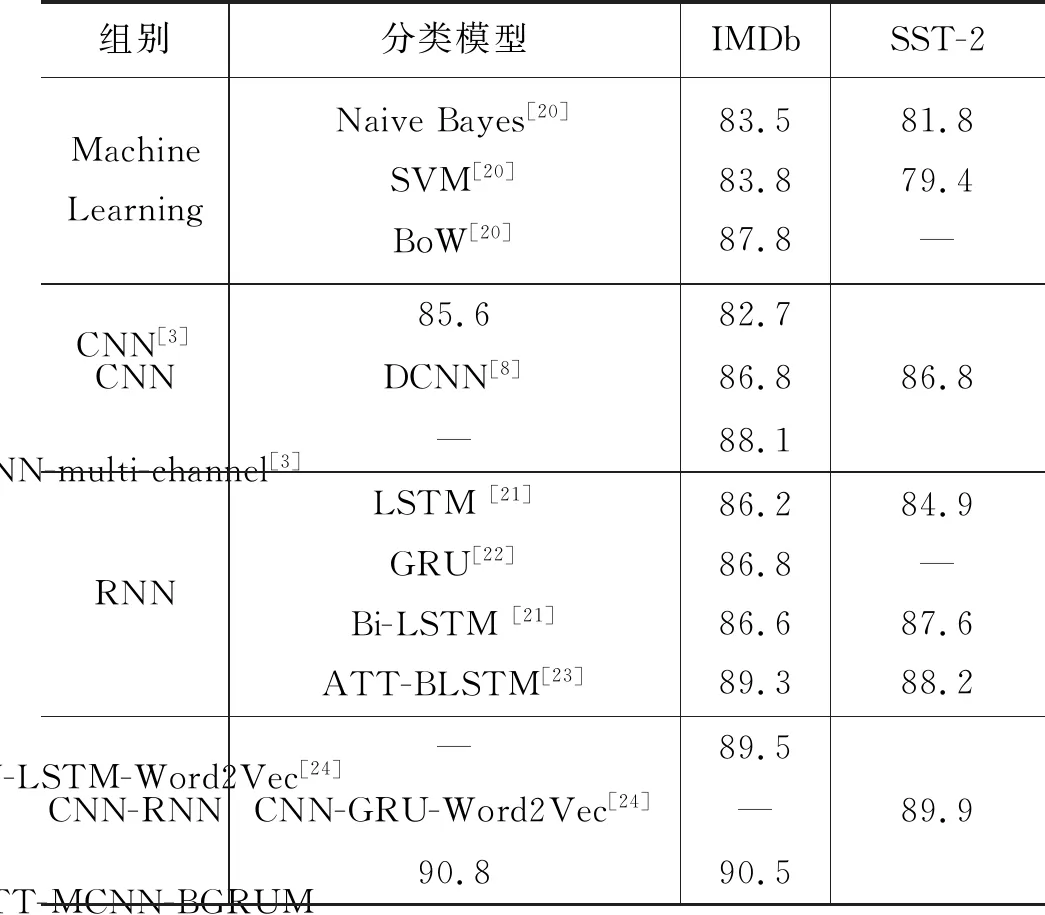

本文選取IMDb數據集及SST-2數據集中的積極和消極情感數據對比本文提出的模型和對比實驗,依據二分類準確率,驗證本文提出方法的有效性。實驗結果如表3所示。

表3 模型在不同數據集上的準確度統計(%)

從表3可以看出,本文提出的ATT-MCNN-BGRUM模型在兩個數據集上均取得了比其他網絡模型更好的分類效果。在IMDb數據集上,模型的分類效果達到90.8%,在SST-2數據集上,分類效果達到90.5%。分別比對照組的最優分類模型準確率提升1.5%和0.6%。

對于CNN組,CNN-multi-channel方法較CNN與DCNN方法在SST-2數據集上分類準確率提升5.4%和1.3%,這說明引入多通道卷積模型對文本進行不同粒度的特征提取的必要性。在IMDb數據集上引入注意力機制的LSTM模型較Bi-LSTM模型在IMDb和SST-2數據及上分別提升2.7%和0.6%。這說明雙向RNN模型能夠結合文本上下文信息,提升分類準確率;注意力機制能夠提升模型關注更重要序列信息的能力,進一步提升模型精度。本文模型較ATT-BLSTM模型在IMDb及SST-2數據集上分類精確度分別提升1.5%和2.3%,ATT-MCNN-GBRUM模型在SST-2上相較于CNN-LSTM-Word2Vec和CNN-GRU-Word2Vec模型提升1.0%和0.6%。

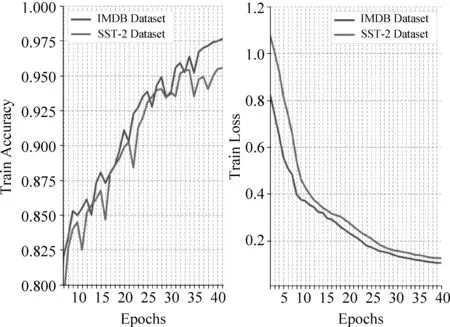

將本文模型在IMDb數據集上訓練過程進行分析。圖4展示了本文模型在IMDb數據集和SST-2數據集上40個epoch內的訓練過程,其中包含在訓練過程中準確率和Loss值的變化情況。本文模型在前25訓練輪次,訓練準確率有較大幅度的提升,在后15訓練輪次,訓練準確率呈小幅度波動上升,最終趨于平穩。本文模型在IMDb與SST-2數據集上初始Loss值分別為0.821 9與1.076 2,模型Loss值隨著迭代次數增加而不斷降低,模型對訓練數據的擬合程度不斷提升。在訓練階段的第40輪次,本文模型在IMDb及SST-2數據集上的Loss值分別下降至0.105 4和0.123 8。

圖4 模型訓練過程

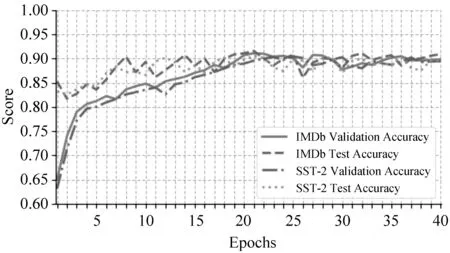

圖5展示了本文模型在兩數據集上驗證及測試過程。對于IMDb數據集,模型驗證準確率在前20輪穩步提升,在21-40輪次,模型在合理范圍內波動。對于SST-2數據集,模型在前25輪次驗證準確率呈平穩上升趨勢,在后15輪次,訓練準確率出現小幅度的震蕩,最終趨于平穩。將本文模型在兩數據集上進行測試,對于IMDb數據集,當運行至第23個epoch時,模型分類效果達到最優,此時的準確率為90.8%。對于SST-2數據集,模型在27個輪次分類效果達到最優,此時的分類準確率為90.5%。

圖5 模型驗證及測試過程

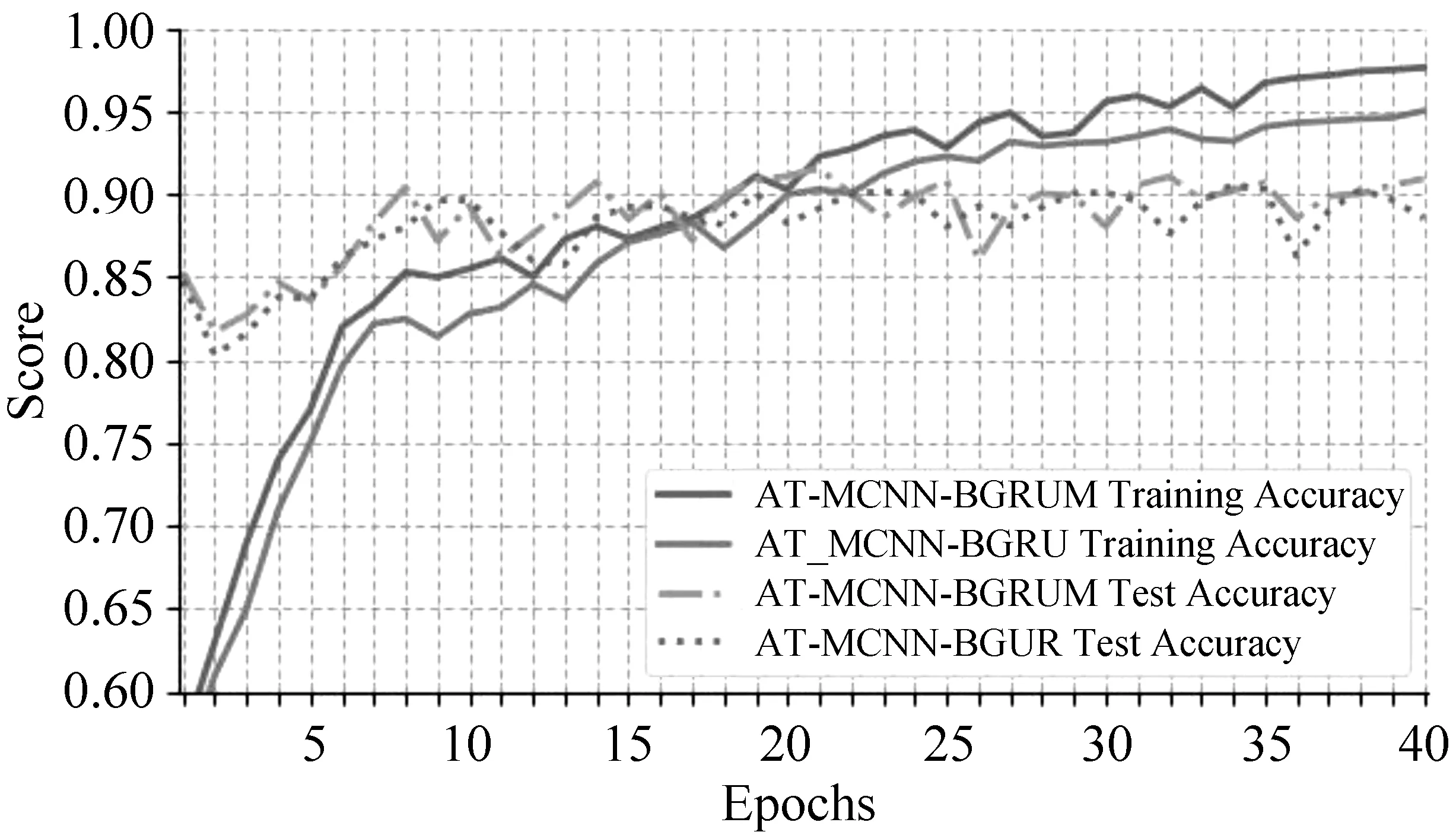

為了驗證Maxout神經元的有效性,將本文所提出的ATT-MCNN-BGRUM與去除Maxout神經元的ATT-MCNN-BGRU模型進行對比實驗。圖6對比了兩種模型在訓練及測試過程中的準確率的變化情況。通過對兩模型的訓練過程中準確率的變化進行分析,發現引入Maxout神經元的網絡模型相比之下能夠更快地收斂,發揮模型的分類性能。同時,引入Maxout神經元的模型在訓練準確率上較沒有引入的模型有了1.1%的提升,說明其能夠在模型的訓練過程中起到優化作用。

圖6 有無Maxout訓練及測試準確率對比

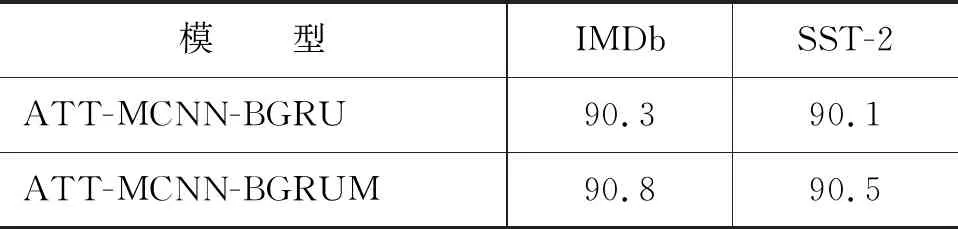

表4對比了兩種模型測試準確率,ATT-MCNN-BGRUM較ATT-MCNN-BGRU模型在IMDb、SSTB數據及上分別提升了0.5%與0.4%,這說明引入Maxout神經元有助于提升模型的性能,提高分類的準確率。

表4 模型有無Maxout分類準確度對比(%)

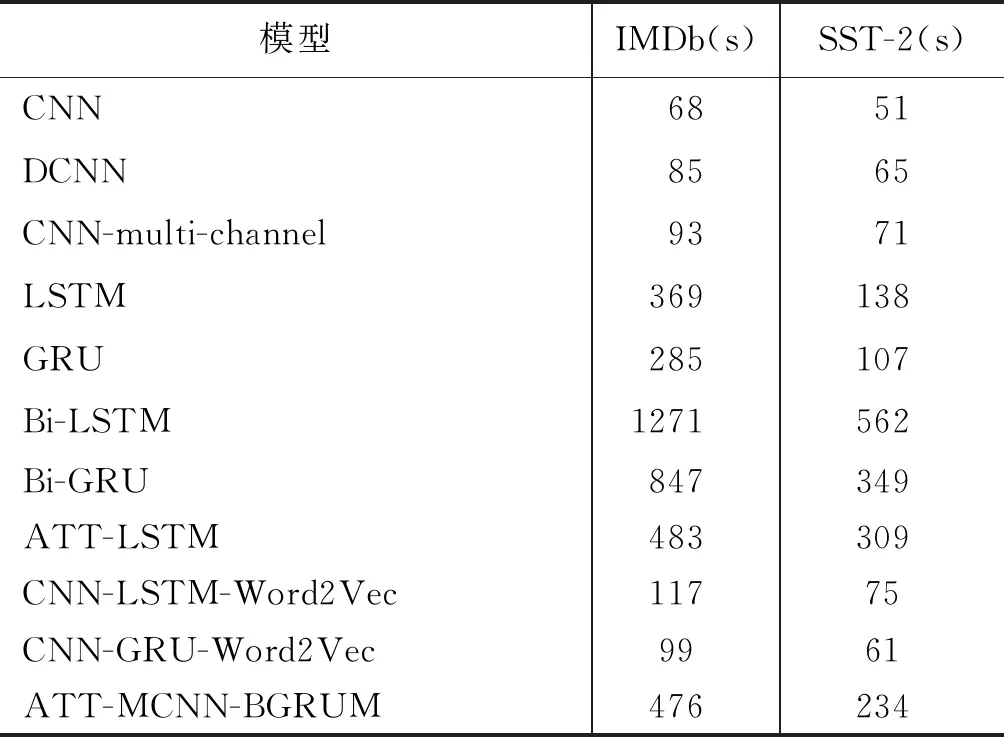

3.5 網絡訓練時間分析

本文在相同深度學習框架、相同硬件環境下對比分析不同網絡在IMDb和SST-2數據集上完成一次迭代的訓練時間,結果如表5所示。

表5 不同模型完成一次迭代的訓練時間

從表5結果可以看出,LSTM,GRU網絡訓練時間遠遠高于CNN訓練時間。在IMDb數據集上,GRU、LSTM模型的訓練時間分別為285秒和369秒,分別是CNN模型的4.19倍和5.43倍。這主要是因為RNN網絡接收的是序列化輸入,所以訓練時間要遠高于接收平行化輸入的CNN網絡。多通道CNN模型較傳統CNN模型訓練耗時略有增加,因此本文采用多通道卷積對文本提取粒度不同的特征信息,進而降低整個模型訓練耗時的做法是有依據的。采用雙向LSTM模型和雙向GRU模型對文本進行建模,進行情感分類會大幅提升神經網絡的訓練時間。其在IMDb和SST-2數據集較單向LSTM、GRU分別增長3.44倍、2.97倍和4.07倍、3.26倍。同時,引入注意力機制的LSTM模型在IMDb數據集上訓練時間提升30.89%,說明在模型中引入注意力機制也會在一定程度上增加模型訓練時間。

經過CNN提取特征后的GRU模型(CNN-GRU-Word2Vec)在IMDb和SST-2數據集上訓練一輪次的時間分別為99秒和61秒,較GRU模型的285秒和107秒有了大幅度的下降。同時結合表3準確率進行分析,CNN-LSTM-Word2Vec模型和CNN-GRU-Word2Vec模型較單一,RNN模型一方面能夠提升模型分類準確率,另一方面可以大幅縮短模型訓練時間。本文模型在引入了注意力機制和雙向GRU模型后,在兩個數據集上的訓練時間,均低于引入注意力機制的單向LSTM模型,從而說明了本文在一定程度降低了模型訓練時間,有更優的訓練性能。

4 結語

本文提出一種融合注意力機制的基于多通道卷積與雙向GRU模型用于文本情感分析任務。該方法采用多通道卷積方式對詞嵌入矩陣做粒度不同的特征提取,并將不同通道所提取的特征進行融合,作為雙向GRU的輸入,從而對文本進行建模。引入注意力機制,使模型能夠更加關注那些對判斷情感極性影響大的部分。將模型在不同的數據集上進行對比實驗,結果表明,該方法比本文提到的其他對比方法在情感極性分類的準確性上有了進一步的提升。

在下一步工作中,可以考慮將注意力機制進行改進;同時將集成學習的思想引入模型中,提升模型的穩定性及泛化能力。