基于5G移動邊緣計算的實驗室火災探測系統研究

孫海松

摘 要:提出了一種高效的基于卷積神經網絡(CNN)的火災探測系統,用于在實驗室的監控視頻中進行火災檢測。本系統使用了輕量級的深度神經網絡(DNN),該DNN沒有密集的全連接層,因此具有極低的計算開銷。實驗評估結果表明,與現有技術相比,該系統具有更好的綜合性能,適用于在資源受限的物聯網環境中實施火災探測。

關鍵詞: 移動邊緣計算;5G;實驗室火災檢測

【Abstract】 This paper presents an efficient convolutional neural network (CNN)-based fire detection system for fire detection in laboratory surveillance video. The system uses a lightweight deep neural network (DNN) that has no dense fully connected layers and has very low computational overhead. The experimental evaluation results show that the system has better comprehensive performance than the prior art, which is suitable for implementing fire detection in a resource-constrained Internet of Things environment.

【Key words】 ?mobile edge calculation; 5G; laboratory fire detection

0 引 言

觸覺互聯網可以通過移動邊緣計算和5G的數據傳輸實現智能化,并已應用于電子健康、智能監控等多種應用中[1-2]。在智能監控領域中,邊緣智能在安全和災難管理中發揮著重要作用,對于異常情況的快速預警有利于制定快速的應急響應行動。基于邊緣智能的CNN火災檢測方法具有較高的準確性。然而現有的方法未能在不確定的物聯網環境中準確地檢測火災,此外對于資源受限的設備而言,基于CNN的方法會帶來巨大的開銷,從而影響性能。本次研究探討在實驗室環境中的火災檢測系統,設計了輕量級的深度CNN,以實現高效的火災檢測。

1 系統框架

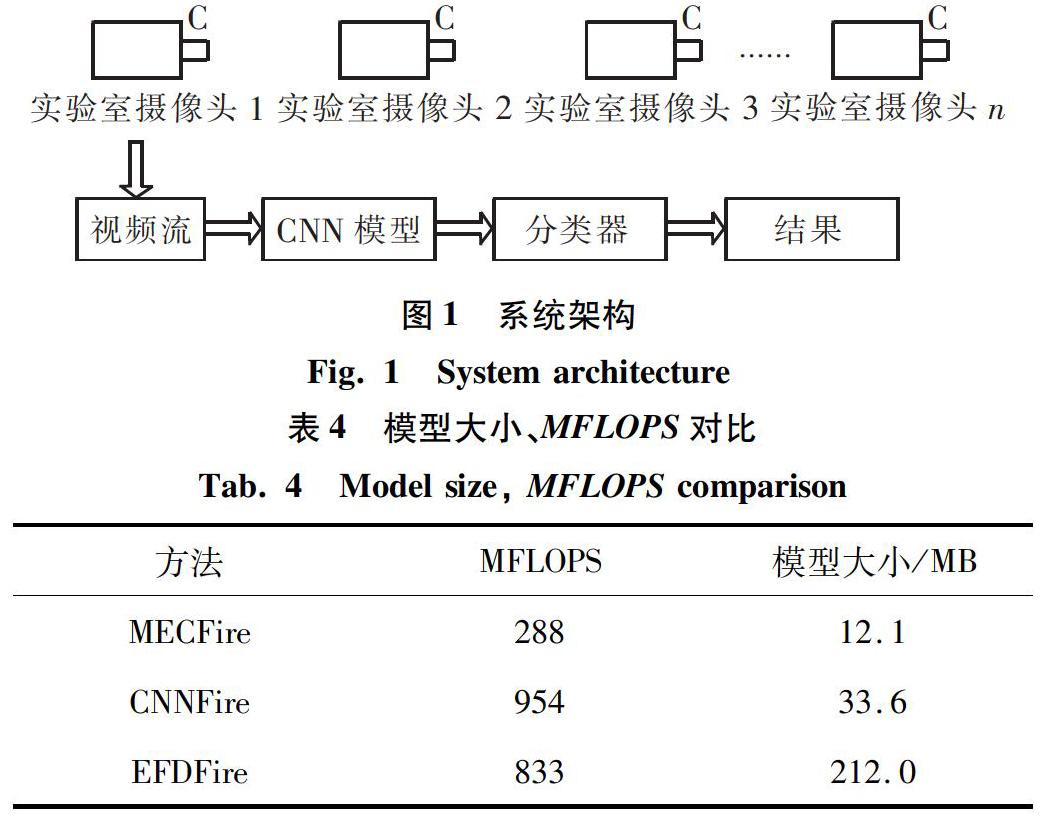

火災探測是一項繁瑣的工作,尤其是當監視環境有遮擋物或者火災很小時。在這種情況下,傳統的火災探測系統會產生大量的錯誤警報。研究者們提出了基于CNN的火災探測方法,但這些方法的運行時間、運算規模使得其不適用于資源受限的監控網絡。因此,提出了基于CNN的有效改進方法,利用監控視頻進行火災探測。使用輕量級的深度神經網絡,沒有密集的全連接層,系統架構如圖1所示。

CNN能夠很好地解決現實中的問題(如圖像分類、物體檢測、動作識別[3]。通過卷積層、池化層和全連接層,CNN可以自動從數據集中學習到豐富的特征。對于火災檢測,CNN中的全連接層具有2個類別:火災和非火災。

經過大量實驗,發現MobileNet比主流的CNN模型好(如AlexNet[4]和GoogleNet[5])。因此,針對火災探測問題,基于MobileNet進行改進。與AlexNet等模型類似,原始MobileNet模型在ImageNet數據集上進行訓練,并將對象劃分為1 000類。為此,將原始MobileNet模型最后一層的神經元數量修改為2,以此區分火災和非火災場景。通過添加擴展層來對MobileNet的體系結構進行修改,修改后的結構如圖2所示。

在將輸入數據傳遞到卷積層之前,擴展層會擴展輸入數據中的通道數。擴展量可以通過擴展因子控制,其默認值為6。第二個卷積層過濾輸入,投影層會減少通道數。對于每一層的輸出,采用線性整流函數ReLU6作為激活函數,對輸出進行歸一化。激活函數ReLU6在低精度的計算中具有魯棒性。投影層后面沒有任何激活函數,因為其輸出是低維數據,并且使用激活函數可能影響輸出結果。

在災害管理等關鍵應用中,輕微的延遲都會造成巨大損失。因此,模型選擇是一個關鍵問題。與其它CNN模型相比,MobileNet適用于內存和帶寬受限的硬件架構。例如, FPGA、智能傳感器和樹莓派(Raspberry Pi)。同時,MobileNet適用于基于5G的移動邊緣計算范式。

2 實驗評估與結果分析

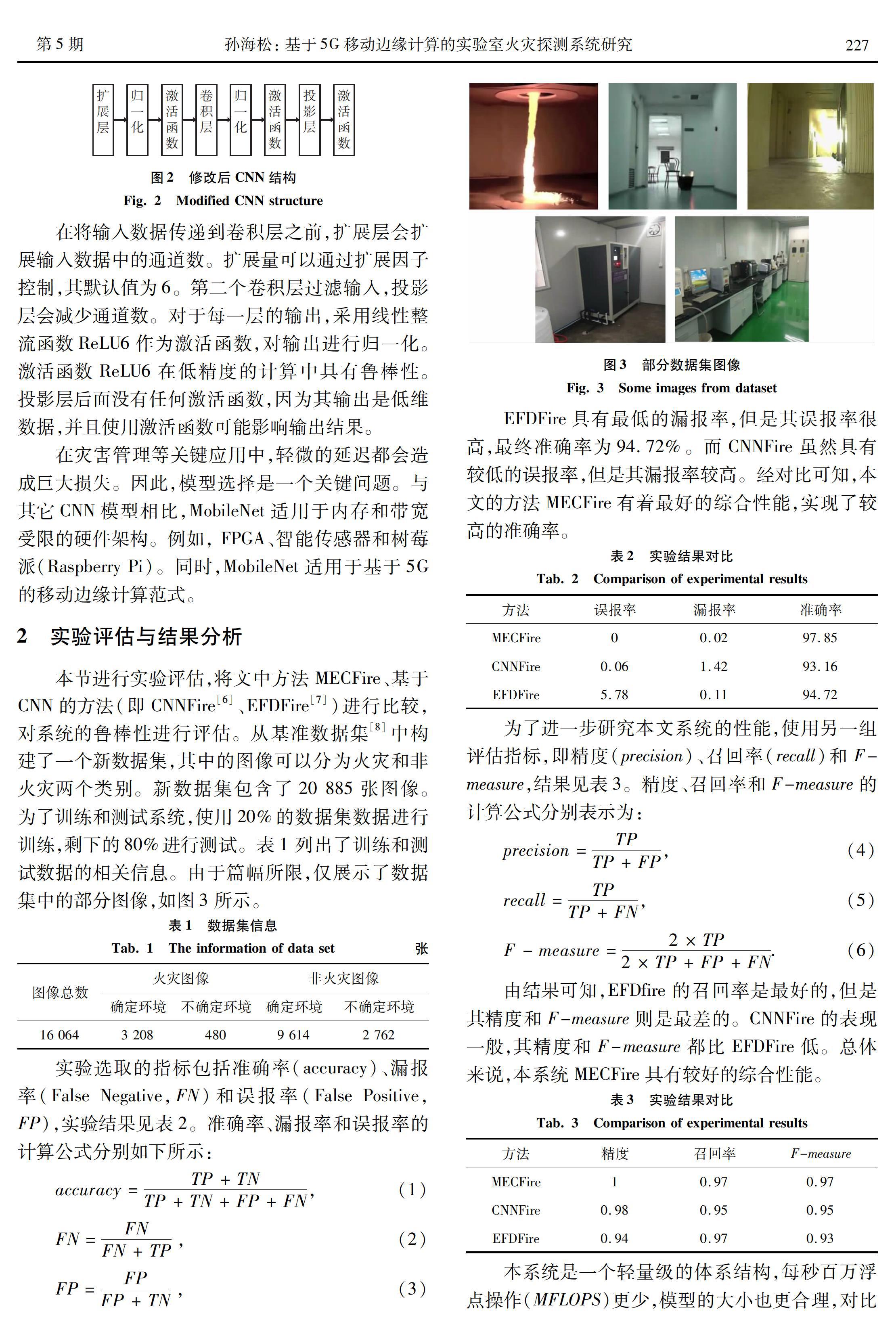

本節進行實驗評估,將文中方法MECFire、基于CNN的方法(即CNNFire[6]、EFDFire[7])進行比較,對系統的魯棒性進行評估。從基準數據集[8]中構建了一個新數據集,其中的圖像可以分為火災和非火災兩個類別。新數據集包含了20 885張圖像。為了訓練和測試系統,使用20%的數據集數據進行訓練,剩下的80%進行測試。表1列出了訓練和測試數據的相關信息。由于篇幅所限,僅展示了數據集中的部分圖像,如圖3所示。

本系統是一個輕量級的體系結構,每秒百萬浮點操作(MFLOPS)更少,模型的大小也更合理,對比結果見表4。與其它模型相比,本系統處理一個圖像所需的MFLOPS更少,因此在相同的時間內,本系統能處理更多的圖像。同樣,所采用的模型更小,易于在資源受限的設備上實施部署。本系統可以很容易地部署運行在諸如樹莓派這樣的設備上。綜上所述,在總體性能評估指標、模型大小和MFLOPS等方面,與現有的火災探測系統相比,本文研發的系統是早期火災探測的最佳選擇。

3 結束語

眾所皆知,CNN近年來在眾多問題的求解上取得了可觀進步,故而研究人員將其應用于火災等異常事件檢測。早期發現火災對于災害管理系統非常重要。本文提出了一種基于CNN的高效方法,用于實驗室監控視頻中的火災探測。與現有的方法相比,本系統具有更小的模型結構,并表現出較好的綜合性能。未來的研究工作將監控視頻與傳感器探測(如煙霧探測器)相結合,開發出混合檢測系統。后期則將本系統與工業系統物聯網相結合,以實現更高效的自動化檢測。

參考文獻

[1]MAIER M, CHOWDHURY M, RIMAL B P, et al. The tactile internet: vision, recent progress, and open challenges[J]. IEEE Communications Magazine, 2016, 54(5): 138-145.

[2]SIMSEK M, AIJAZ A, DOHLER M, et al. 5G-enabled tactile internet[J]. IEEE Journal on Selected Areas in Communications, 2016, 34(3): 460-473.

[3]ULLAH A, AHMAD J, MUHAMMAD K, et al. Action recognition in video sequences using deep bi-directional LSTM with CNN features[J]. IEEE Access, 2018, 6: 1155-1166.

[4]KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Image Net classification with deep convolutional neural networks[J]. Communications of the ACM, 2017,60(6): 84-90.

[5]SZEGEDY C, LIU Wei, JIA Yangqing, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Boston, MA, USA: IEEE,2015: 1-12.

[6]MUHAMMAD K, AHMAD J, LV Zhihan, et al. Efficient deep CNN-based fire detection and localization in video surveillance applications[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2018 (99): 1-16.

[7]MUHAMMAD K, AHMAD J, BAIK S W. Early fire detection using convolutional neural networks during surveillance for effective disaster management[J]. Neurocomputing, 2018, 288: 30-42.

[8]FOGGIA P, SAGGESE A, VENTO M. Real-time fire detection for video-surveillance applications using a combination of experts based on color, shape, and motion[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 25(9): 1545-1556.