基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的深度置信網(wǎng)絡(luò)?

張 楠 , 丁世飛,2,3 , 張 健 , 趙星宇

1(中國礦業(yè)大學(xué) 計算機科學(xué)與技術(shù)學(xué)院,江蘇 徐州 221116)

2(礦山數(shù)字化教育部工程研究中心(中國礦業(yè)大學(xué)),江蘇 徐州 221116)

3(中國科學(xué)院 計算技術(shù)研究所 智能信息處理重點實驗室,北京 100190)

玻爾茲曼機(Boltzmann machine,簡稱BM)是一種概率圖模型.該模型能夠?qū)W習(xí)到輸入數(shù)據(jù)的統(tǒng)計特性[1].Smolensky 在BM 的基礎(chǔ)上提出了受限玻爾茲曼機(restricted Boltzmann machine,簡稱RBM)[2].RBM 是一種產(chǎn)生式無監(jiān)督學(xué)習(xí)方法,它不僅能夠從數(shù)據(jù)中學(xué)習(xí)到有效的特征,而且能夠利用學(xué)習(xí)到的特征重構(gòu)出原始數(shù)據(jù).2006 年,Hinton 等人在《SCIENCE》上提出一種有效的深度網(wǎng)絡(luò)學(xué)習(xí)方法——深度置信網(wǎng)(deep belief network,簡稱DBN),掀起了深度學(xué)習(xí)的研究熱潮[3].其實,以受限玻爾茲曼機為基石的深度網(wǎng)絡(luò)模型除了深度置信網(wǎng)以外,還有深度Sigmoid 置信網(wǎng)[4]、深度玻爾茲曼機[5]等.

與RBM 相比,以RBM 為基石的深度網(wǎng)絡(luò)模型會表現(xiàn)出較好的分類能力.但是在處理噪聲圖像時,這些深度網(wǎng)絡(luò)并沒有展現(xiàn)出優(yōu)于RBM 的學(xué)習(xí)能力.如果數(shù)據(jù)中存在噪聲,那么RBM 學(xué)習(xí)到的特征也會蘊含噪聲信息.特征選擇方法可以從蘊含噪聲信息的特征中找到與分類有關(guān)的特征[6].Sohn 等人結(jié)合受限玻爾茲曼機與特征選擇方法提出了Point-wise Gated 受限玻爾茲曼機(point-wise gated RBM,簡稱pgRBM)[7].pgRBM不僅能夠得到與分類有關(guān)的特征,還能在噪聲數(shù)據(jù)中找到數(shù)據(jù)中與分類有關(guān)的部分.Zhang 等人結(jié)合pgRBM 提出了Pointwise Gated 深度置信網(wǎng)(point-wise gated deep belief network,簡稱pgDBN)和Point-wise Gated 深度玻爾茲曼機[8].這表明以RBM 為基石的深度網(wǎng)絡(luò)在處理噪聲時,傳統(tǒng)的RBM 學(xué)習(xí)到的特征中蘊含的噪聲信息影響了深度網(wǎng)絡(luò)的性能.但是當一組數(shù)據(jù)中有噪聲數(shù)據(jù)和干凈數(shù)據(jù)時,如何應(yīng)用干凈數(shù)據(jù)提升pgRBM 在噪聲數(shù)據(jù)中的學(xué)習(xí)能力,從而進一步提高深度網(wǎng)絡(luò)模型處理噪聲的能力,這是一個重要的研究問題.

本文在傳統(tǒng)的pgRBM 基礎(chǔ)上提出一種基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機(pgRBM based on random noisy data and clean data,簡稱pgrncRBM)方法.它可以利用干凈數(shù)據(jù)提升算法在隨機噪聲數(shù)據(jù)上的學(xué)習(xí)能力.pgRBM 把隱層節(jié)點分為與分類有關(guān)的和與分類無關(guān)的兩個部分,其連接權(quán)值的初值是用特征選擇的方法對RBM 學(xué)習(xí)的權(quán)值處理得到的.pgrncRBM 就是在傳統(tǒng)的pgRBM 基礎(chǔ)上對pgRBM 學(xué)習(xí)到的數(shù)據(jù)二次去噪,其與分類無關(guān)的隱層節(jié)點相連權(quán)值的初值是用特征選擇的方法對RBM 對一次降噪的數(shù)據(jù)學(xué)習(xí)到的權(quán)值處理得到的,但是其與分類有關(guān)的隱層節(jié)點相連權(quán)值的初值是用RBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的.這樣,pgrncRBM 在處理隨機噪聲數(shù)據(jù)時可以學(xué)習(xí)到更為“干凈”的數(shù)據(jù).如果噪聲是圖片時,pgrncRBM 不能很好地去除噪聲.傳統(tǒng)的RBM 一般只適于處理二值圖像.為了更好地處理實值圖像,提出了一系列的RBM 的變種算法,如均值與協(xié)方差受限玻爾茲曼機(mcRBM)[9]和Spike-and-Slab 受限玻爾茲曼機(ssRBM)[10].mcRBM 和ssRBM 都表現(xiàn)出較好的實質(zhì)圖像數(shù)據(jù)建模能力,但不同的是,當隱層節(jié)點狀態(tài)保持固定時,mcRBM 求取數(shù)據(jù)在可見層的聯(lián)合概率分布用的是混合蒙特卡洛算法(HMC),而ssRBM 采用的是簡單而有效的Gibbs 采樣方法.因此,本文將ssRBM 與pgRBM 相結(jié)合,提出了一種基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機(pgRBM based on image noisy data and clean data,簡稱pgincRBM)方法.該方法使用ssRBM 對噪聲建模,其在處理圖像噪聲數(shù)據(jù)時可以學(xué)習(xí)到更為“干凈”的數(shù)據(jù).然后,本文可以在pgrncRBM 和pgincRBM 的基礎(chǔ)上堆疊出深度置信網(wǎng)絡(luò)模型,如基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機(pgDBN based on random noisy data and clean data,簡稱pgrncDBN)以及基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機(pgDBN based on image noisy data and clean data,簡稱pgincDBN).

訓(xùn)練神經(jīng)網(wǎng)絡(luò)時常常會遇到過擬合問題,以RBM 為基石的深度網(wǎng)絡(luò)也是如此.目前,RBM 中常常用的解決過擬合問題有權(quán)值衰減、Dropout[11]、Dropconnect[12,13]、權(quán)值不確定性[14-16].Zhang 等人將權(quán)值不確定性引入pgRBM 和pgDBN,驗證了權(quán)值不確定性在這兩種網(wǎng)絡(luò)中的有效性[8].本文將權(quán)值不確定性引入pgrncRBM 和pgincRBM 中,把pgrncRBM 和pgincRBM 中與分類有關(guān)的權(quán)值看作一組符合高斯分布的變量而不是固定值.同樣地,本文還將權(quán)值不確定性引入以pgrncRBM 和pgincRBM 為基石的深度網(wǎng)絡(luò)pgrncDBN 和pgincDBN 中,并探究了這幾種算法的可行性.

本文第1 節(jié)簡述受限玻爾茲曼機算法、深度置信網(wǎng)算法和Point-wise Gated 受限玻爾茲曼機算法.第2 節(jié)詳述本文提出的基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機算法和以它們?yōu)榛腜ointwise Gated 深度置信網(wǎng)算法.第3 節(jié)介紹權(quán)值不確定性方法在pgncRBM 和pgncDBN 兩種網(wǎng)絡(luò)模型中的應(yīng)用.第4 節(jié)用含噪聲的手寫數(shù)據(jù)集測試本文提出的算法的性能.實驗結(jié)果表明,pgrncRBM 和pgincRBM 都是有效的神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)方法.

1 相關(guān)工作

1.1 受限玻爾茲曼機與深度置信網(wǎng)算法

受限玻爾茲曼機(RBM)是一種生成式隨機網(wǎng)絡(luò),由可見層和隱層組成.RBM 網(wǎng)絡(luò)的權(quán)值θ由可見層和隱層的連接權(quán)值矩陣W=(Wij)∈RD×J、可見層的偏置向量和隱層的偏置向量組成.當給定一組可見層狀態(tài)和隱層狀態(tài)時,RBM 的能量函數(shù)和似然函數(shù)分別表述為

其中,vi∈{0,1};hj∈{0,1};是配分函數(shù);P(v;θ)對應(yīng)P(v,h;θ)的邊緣分布,又稱為似然函數(shù).當可見層和隱層其中之一狀態(tài)固定時,RBM 的條件概率分布可以表述為

深度置信網(wǎng)(DBN)是一個概率生成模型.它是由RBM 堆疊構(gòu)成的深度網(wǎng)絡(luò)模型.首先,DBN 通過利用不帶標簽數(shù)據(jù),用RBM 算法自底向上逐層訓(xùn)練得到深度網(wǎng)絡(luò)的初值.在預(yù)訓(xùn)練之后,DBN 通過利用帶標簽數(shù)據(jù),用BP 算法對網(wǎng)絡(luò)的權(quán)值進行調(diào)整.

1.2 Point-wise Gated受限玻爾茲曼機算法

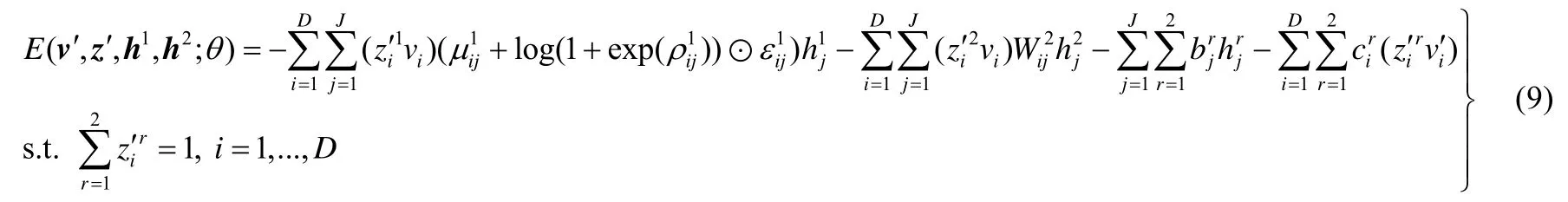

與RBM 不同,pgRBM 把隱層節(jié)點分為與分類有關(guān)的和與分類無關(guān)的兩個部分.pgRBM 的網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示.此時,pgRBM 的能量函數(shù)可表述為

其中,與分類有關(guān)的隱層h1對應(yīng)的權(quán)值為{W1,c1,b1},與分類無關(guān)的隱層對應(yīng)的權(quán)值為{W2,c2,b2}.

Fig.1 Network structure of pgRBM圖1 pgRBM 的網(wǎng)絡(luò)結(jié)構(gòu)

當可見層、轉(zhuǎn)換層和隱層任意兩層狀態(tài)固定時,pgRBM 的條件概率分布可以表述為

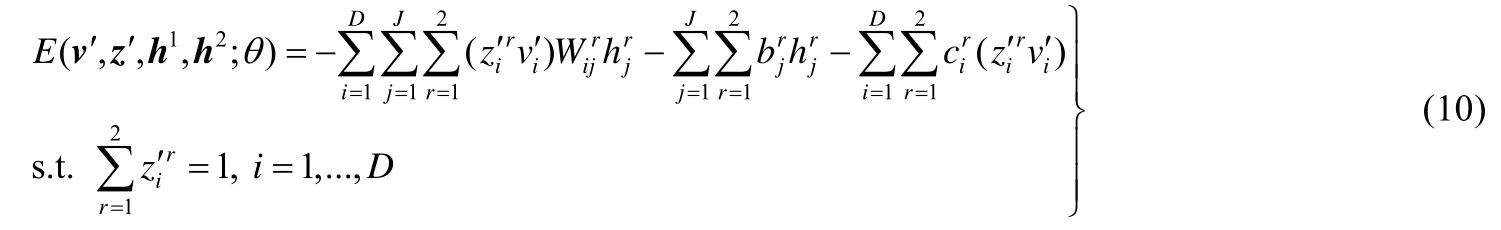

Zhang 等人將權(quán)值不確定性引入pgRBM,提出了權(quán)值不確定性Point-wise Gated 受限玻爾茲曼機(weight uncertainty pgRBM,簡稱pgwRBM)算法.與pgRBM 不同的是,pgwRBM 將與分類有關(guān)的隱層與可見層、轉(zhuǎn)換層的連接權(quán)值W1看作符合高斯分布的變量,其均值和標準差分別是μ1和σ1=log(1+exp(ρ1)).此時,pgwRBM 的能量函數(shù)可表述為

其中,⊙表示矩陣中的元素對位相乘.

pgwRBM 的學(xué)習(xí)過程詳見文獻[8].和RBM 一樣,pgRBM 和pgwRBM 也可以使用CD 等算法去計算權(quán)值的梯度,從而更新網(wǎng)絡(luò)的權(quán)值.

2 基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 深度置信網(wǎng)絡(luò)模型

2.1 基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated受限玻爾茲曼機算法

當數(shù)據(jù)中存在少量噪聲時,添加噪聲在某些情況下可以增加分類器的泛化能力.但是,如果數(shù)據(jù)中存在大量噪聲,噪聲的添加就降低了訓(xùn)練數(shù)據(jù)的分類準確率,并且還不能獲得更好的泛化能力.Point-wise Gated 受限玻爾茲曼機就是針對這種情況提出來的.它能夠在噪聲數(shù)據(jù)中找到數(shù)據(jù)中與分類有關(guān)的部分,從而提升分類器的分類準確率.但是,當一組訓(xùn)練數(shù)據(jù)中同時出現(xiàn)噪聲數(shù)據(jù)和干凈數(shù)據(jù)時,如何應(yīng)用干凈數(shù)據(jù)提升傳統(tǒng)的pgRBM 在噪聲數(shù)據(jù)上的學(xué)習(xí)能力,是一個重要的研究問題.針對這一問題,本文首先在傳統(tǒng)的pgRBM 基礎(chǔ)上提出一種基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機方法.它可以利用不含噪聲的數(shù)據(jù)提升算法在噪聲數(shù)據(jù)上的學(xué)習(xí)能力.和傳統(tǒng)的pgRBM 一樣,pgrncRBM 的網(wǎng)絡(luò)結(jié)構(gòu)同樣可以用圖1 來表示.當給定一組可見層狀態(tài)和隱層狀態(tài)時,pgrncRBM 的能量函數(shù)也可以表述為

其中,v′是pgRBM 對噪聲數(shù)據(jù)v處理之后得到的與分類有關(guān)的數(shù)據(jù)[7].我們可以看出,pgrncRBM 就是在傳統(tǒng)的pgRBM 基礎(chǔ)上對pgRBM 學(xué)習(xí)到的數(shù)據(jù)二次去噪.并且,pgrncRBM 網(wǎng)絡(luò)權(quán)值的賦初值的方法也與傳統(tǒng)的pgRBM 不同.pgncRBM 同樣把隱層節(jié)點分為與分類有關(guān)的和與分類無關(guān)的兩個部分,那么其與分類有關(guān)的隱層相連權(quán)值的初值是用RBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的,并且其與分類無關(guān)的隱層相連權(quán)值的初值還是用特征選擇的方法對RBM 對一次降噪的數(shù)據(jù)v′學(xué)習(xí)到的權(quán)值處理得到的.pgrncRBM 預(yù)訓(xùn)練完成后,通過利用帶標簽的噪聲數(shù)據(jù)與BP 算法對網(wǎng)絡(luò)的權(quán)值進行調(diào)整.在pgRBM 中,網(wǎng)絡(luò)的輸入數(shù)據(jù)是pgRBM 對噪聲數(shù)據(jù)v處理之后得到的“干凈”數(shù)據(jù),輸出是與數(shù)據(jù)對應(yīng)的標簽.同理,在pgrncRBM 中,網(wǎng)絡(luò)的輸入數(shù)據(jù)是pgrncRBM 對一次降噪的數(shù)據(jù)v′處理之后得到的更為“干凈”的數(shù)據(jù),輸出是與數(shù)據(jù)對應(yīng)的標簽.

2.2 基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated受限玻爾茲曼機算法

pgrncRBM 在處理隨機噪聲數(shù)據(jù)時可以學(xué)習(xí)到更為“干凈”的數(shù)據(jù),但當噪聲是圖片時,它不能很好地去除噪聲.針對這一問題,本文又將ssRBM 與pgRBM 相結(jié)合,提出一種基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機方法.該方法使用ssRBM 對噪聲建模,其在處理圖像噪聲數(shù)據(jù)時可以學(xué)習(xí)到更為“干凈”的數(shù)據(jù),可以利用不含噪聲的數(shù)據(jù),提升算法在圖像噪聲數(shù)據(jù)上的學(xué)習(xí)能力.當給定一組可見層狀態(tài)和隱層狀態(tài)時,pgincRBM 的能量函數(shù)也可以表述為

其中,v′是pgRBM 對噪聲數(shù)據(jù)v處理之后得到的與分類有關(guān)的數(shù)據(jù),αj是對懲罰項的系數(shù).我們可以看出,pgincRBM 中與分類無關(guān)的隱層相連的可見層節(jié)點并不像ssRBM 那樣使用對角矩陣對其加以懲罰,而是使用偏置.這是因為當轉(zhuǎn)換層和隱層兩層狀態(tài)固定時,只能推導(dǎo)出與分類有關(guān)的隱層相連的可見層節(jié)點被激活的概率,而不能得到其概率分布情況,這樣就只能推倒得到與分類無關(guān)的隱層相連的可見層節(jié)點被激活的概率.這樣,當可見層、轉(zhuǎn)換層和隱層任意兩層狀態(tài)固定時,剩余一層節(jié)點被激活的概率(或者概率分布)可以表述為

和pgrncRBM 一樣,pgincRBM 也可以使用CD 等算法去計算權(quán)值的梯度,從而更新網(wǎng)絡(luò)的權(quán)值.pgincRBM預(yù)訓(xùn)練完成后,通過利用帶標簽的噪聲數(shù)據(jù)和BP 算法對網(wǎng)絡(luò)的權(quán)值進行調(diào)整.在pgincRBM 中,網(wǎng)絡(luò)的輸入數(shù)據(jù)是pgincRBM 對一次降噪的數(shù)據(jù)v′處理之后得到的更為“干凈”的數(shù)據(jù),輸出是與數(shù)據(jù)對應(yīng)的標簽.

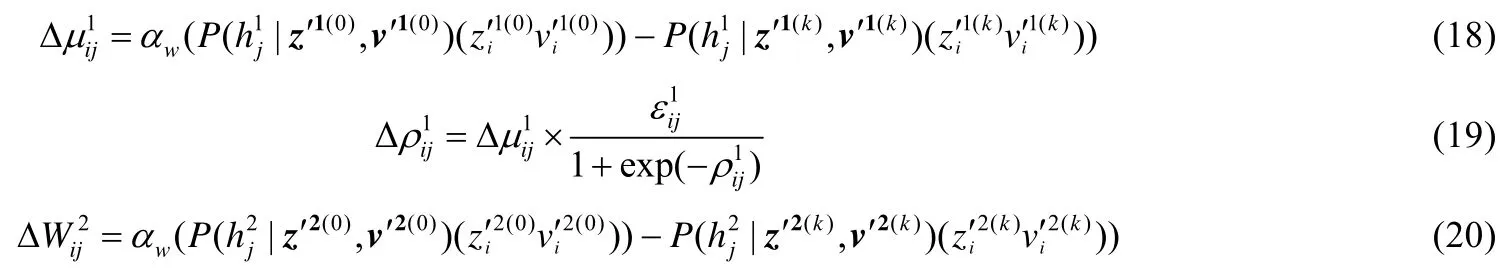

2.3 基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated深度置信網(wǎng)算法

在處理含噪聲的圖像時,DBN 并沒有展現(xiàn)出優(yōu)于RBM 的學(xué)習(xí)能力.Zhang 等人結(jié)合pgRBM 提出了Pointwise Gated 深度置信網(wǎng)(pgDBN),并且pgDBN 展示出優(yōu)于pgRBM 的分類能力.我們得出,以傳統(tǒng)的RBM 為基石的深度網(wǎng)絡(luò)在處理噪聲時,傳統(tǒng)的RBM 學(xué)習(xí)到的特征中蘊含的噪聲信息影響了深度網(wǎng)絡(luò)的性能.當一組數(shù)據(jù)中同時出現(xiàn)噪聲數(shù)據(jù)和干凈數(shù)據(jù)時,就可以利用干凈數(shù)據(jù)進一步提高深度網(wǎng)絡(luò)模型處理噪聲的能力.因此,本文堆疊pgrncRBM、pgincRBM、傳統(tǒng)的RBM,構(gòu)建出兩種基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 深度置信網(wǎng)(pgDBN based on noisy data and clean data,簡稱pgncDBN),包含基于隨機噪聲數(shù)據(jù)和干凈數(shù)據(jù)的Point-wise Gated 深度置信網(wǎng),以及基于圖像噪聲數(shù)據(jù)和干凈數(shù)據(jù)的Point-wise Gated 深度置信網(wǎng).以兩隱層pgrncDBN 為例,圖2 給出了pgrncDBN 的預(yù)訓(xùn)練過程.首先,pgrncDBN 和pgincDBN 分別用pgrncRBM 或者pgincRBM 對一次降噪的數(shù)據(jù)v′預(yù)訓(xùn)練,得到更為“干凈”的數(shù)據(jù);然后,它們都利用RBM 預(yù)訓(xùn)練隱層間的連接權(quán)值;最后,它們都隨機確定最后一層隱層與輸出層的連接權(quán)值,隨后用BP 算法微調(diào)整個網(wǎng)絡(luò)的權(quán)值.

Fig.2 Pre-training process of pgrncDBN圖2 pgrncDBN 的預(yù)訓(xùn)練過程

3 權(quán)值不確定性方法在pgrncDBN 與pgincDBN 深度網(wǎng)絡(luò)中的應(yīng)用

權(quán)值不確定性方法是一種神經(jīng)網(wǎng)絡(luò)中常見的解決過擬合現(xiàn)象的方法.它把神經(jīng)網(wǎng)絡(luò)中的每個權(quán)值看作一個可能值的概率分布,而不是以前的單一的固定值,這樣學(xué)習(xí)到的特征更為魯棒.Zhang 等人把權(quán)值不確定性方法引入RBM,提出了權(quán)值不確定性受限玻爾茲曼機(weight uncertainty RBM,簡稱wRBM),其將每個可見層與隱層間的連接權(quán)值看作一個可能值的概率分布.同時,Zhang 等人將權(quán)值不確定性引入pgRBM,提出了權(quán)值不確定性受限玻爾茲曼機,其將與分類有關(guān)的隱層節(jié)點相連的權(quán)值看作一個可能值的概率分布.wRBM 能夠有效地解決RBM 的過擬合問題,但它在處理含噪聲的數(shù)據(jù)時并不是都能達到理想的效果.權(quán)值不確定性中權(quán)值的波動也可以理解為訓(xùn)練數(shù)據(jù)的變化,這種數(shù)據(jù)中噪聲的波動可能在一定程度上影響了算法的性能,因此,pgwRBM 中與分類無關(guān)的隱層節(jié)點相連的權(quán)值還是實值.也就是說,我們可以將pgwRBM 中與分類有關(guān)的數(shù)據(jù)看作是變化的,將與分類無關(guān)的噪聲看作是不變的.本文同樣將權(quán)值不確定性引入pgrncRBM 和pgincRBM,提出了基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的 Point-wise Gated 權(quán)值不確定性受限玻爾茲曼機(weight uncertainty pgrncRBM,簡稱pgwrncRBM)以及基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 權(quán)值不確定性受限玻爾茲曼機(weight uncertainty pgincRBM,簡稱pgwincRBM).為了對比兩種模型引入權(quán)值不確定性前后的性能,pgwrncRBM 和pgwincRBM 也是在傳統(tǒng)的pgRBM 基礎(chǔ)上對pgRBM 學(xué)習(xí)到的數(shù)據(jù)二次去噪.

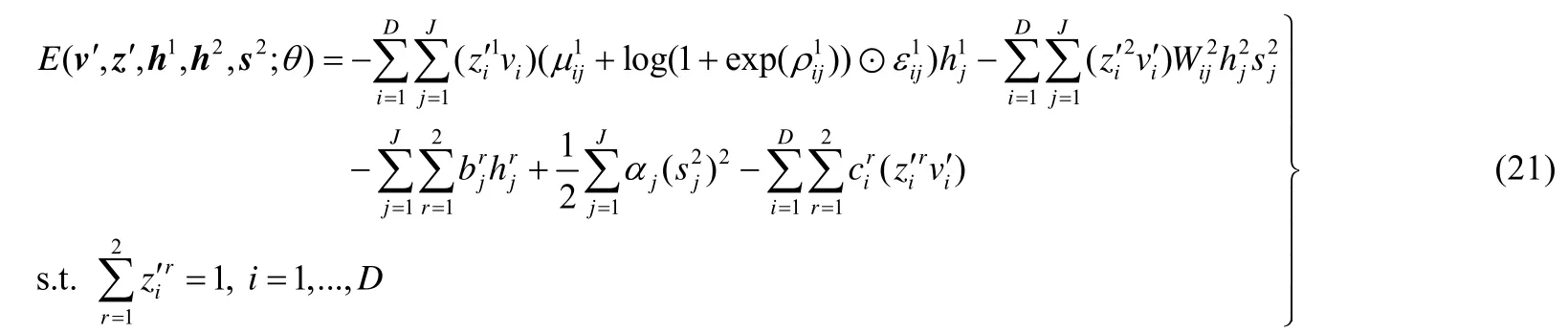

在pgwrncRBM 算法中,與分類有關(guān)的隱層與可見層、轉(zhuǎn)換層的連接權(quán)值W1被看作符合高斯分布的變量,其均值和標準差分別表述為μ1和σ1=log(1+exp(ρ1)).與pgwRBM 類似,當給定一組可見層狀態(tài)和隱層狀態(tài)時,pgwrncRBM 的能量函數(shù)可表述為

其中,與分類有關(guān)的隱層h1對應(yīng)的權(quán)值為{μ1,ρ1,c1,b1},與分類無關(guān)的隱層對應(yīng)的權(quán)值為{W2,c2,b2}.

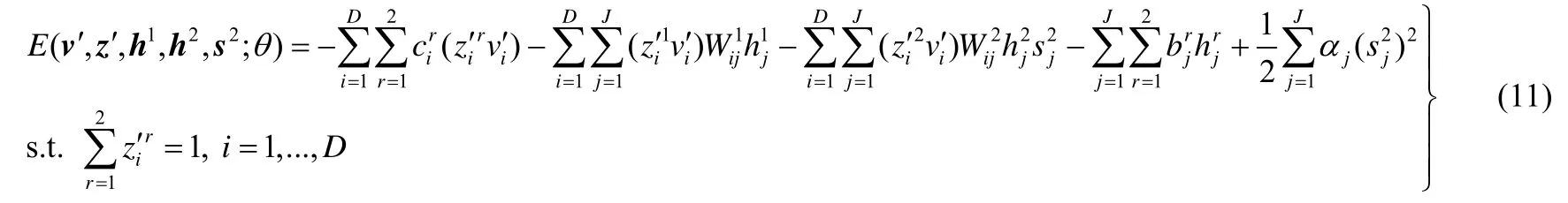

pgwrncRBM 與pgwRBM 的不同之處有:一是賦初值的方法不同,二是學(xué)習(xí)的數(shù)據(jù)不同.pgwrncRBM 與分類無關(guān)的隱層相連權(quán)值{W2,c2,b2}的初值還是用特征選擇的方法對一次降噪的數(shù)據(jù)v′學(xué)習(xí)到的RBM 權(quán)值處理得到的,但其與分類有關(guān)的隱層相連權(quán)值{μ1,c1,b1,ρ1}的初值有兩種方式:一是用wRBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的,二是權(quán)值{μ1,c1,b1}的初值用RBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的,權(quán)值ρ1的初始值是隨機賦值的.pgwrncRBM 是對pgRBM 學(xué)習(xí)到的數(shù)據(jù)v′二次去噪,而pgwRBM 是對原始的噪聲數(shù)據(jù)去噪.pgwrncRBM 的連接權(quán)值矩陣W1可以表述為W1=μ1+log(1+exp(ρ1))⊙ε1(其中,ε1~N(0,I)),則當可見層、轉(zhuǎn)換層和隱層任意兩層狀態(tài)固定時,pgwrncRBM 的條件概率分布可以用公式(6)~公式(8)表示.當pgwrncRBM 用CD-k算法調(diào)整權(quán)值時,參數(shù){μ1,ρ1,W2}的梯度分別為

用CD-k算法調(diào)整權(quán)值時,pgwrncRBM 的{c1,b1,W2,c2,b2}的梯度的計算方法與pgrncRBM 一致.

pgwincRBM 算法的能量函數(shù)與pgwrncRBM 和pgwRBM 略有不同,其使用ssRBM 對噪聲建模.假設(shè)pgwincRBM 與分類有關(guān)的隱層與可見層、轉(zhuǎn)換層的連接權(quán)值W1是符合高斯分布變量,其均值和標準差同樣可表述為μ1和σ1=log(1+exp(ρ1)).當給定一組可見層狀態(tài)和隱層狀態(tài)時,pgwincRBM 的能量函數(shù)可表述為

其中,與分類有關(guān)的隱層h1對應(yīng)的權(quán)值為{μ1,ρ1,c1,b1},與分類無關(guān)的隱層對應(yīng)的權(quán)值為{W2,c2,b2,α}.

與pgincRBM 相比,pgwincRBM 與分類無關(guān)的隱層相連權(quán)值{W2,c2,b2,α}的初值還是用特征選擇的方法對一次降噪的數(shù)據(jù)v′學(xué)習(xí)到的ssRBM 權(quán)值處理得到的,但其與分類有關(guān)的隱層相連權(quán)值{μ1,c1,b1,ρ1}的賦初值方式和pgwrncRBM 一樣.在pgwincRBM 算法中,當可見層、轉(zhuǎn)換層和隱層任意兩層狀態(tài)固定時,剩余一層節(jié)點被激活的概率(或者概率分布)可以用公式(12)~公式(16)表示.當pgwincRBM 用CD-k算法調(diào)整權(quán)值時,其參數(shù){μ1,ρ1,W2}的梯度分別為

用CD-k算法調(diào)整權(quán)值時,pgwincRBM 的{c1,b1,W2,c2,b2}的梯度的計算方法與pgincRBM 一致.

和pgrncDBN 與pgincDBN 類似,可以通過堆疊pgwrncRBM、pgwincRBM 和wRBM 分別構(gòu)造出包含基于隨機噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 權(quán)值不確定性深度置信網(wǎng)(pgwDBN based on random noisy data and clean data,簡稱pgwrncDBN)以及基于圖像噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 權(quán)值不確定性深度置信網(wǎng)(pgwDBN based on image noisy data and clean data,簡稱pgwincDBN).pgwrncDBN(pgwincDBN)首先用pgwrncRBM(pgwincRBM)對一次降噪的數(shù)據(jù)v′預(yù)訓(xùn)練,得到更為“干凈”的數(shù)據(jù).和pgrncDBN(pgincDBN)一樣,pgwrncDBN(pgwincDBN)網(wǎng)絡(luò)的輸入層與隱層,以及隱層與隱層間的連接權(quán)值的初值也有兩種賦初值方式:一是利用pgwrncRBM(pgwincRBM)對一次降噪的數(shù)據(jù)v′預(yù)訓(xùn)練得到轉(zhuǎn)換層、可見層與第1 層隱層的連接權(quán)值,隨后用wRBM 預(yù)訓(xùn)練隱層間的連接權(quán)值;二是利用wRBM 通過對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到轉(zhuǎn)換層、可見層與第1 層隱層的連接權(quán)值,隨后同樣用wRBM 預(yù)訓(xùn)練隱層間的連接權(quán)值.pgwrncDBN(pgwincDBN)最后隨機確定最后一層隱層與輸出層的連接權(quán)值,隨后用BP 算法微調(diào)整個網(wǎng)絡(luò)的權(quán)值.

4 實驗與分析

4.1 實驗設(shè)置與數(shù)據(jù)集

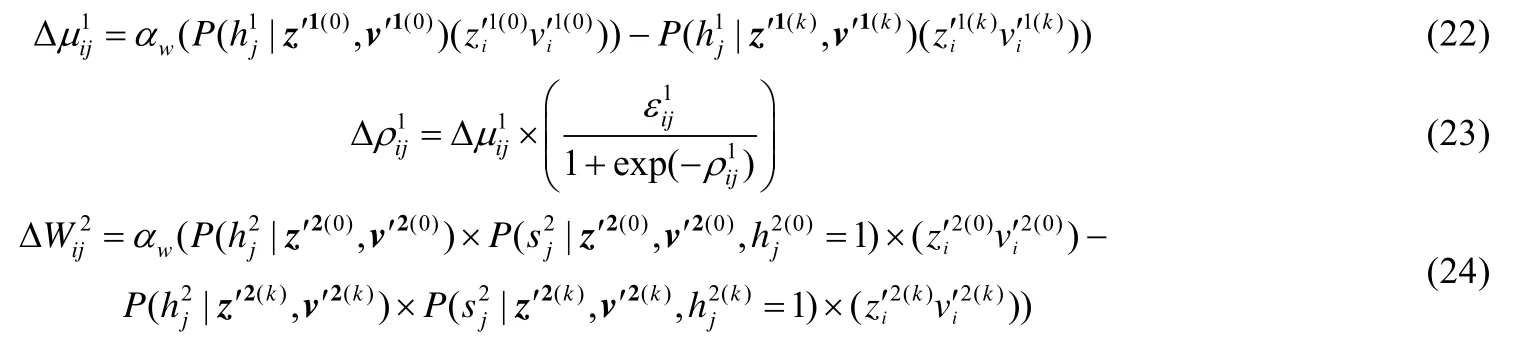

為了測試提出的算法的性能,將其與RBM、wRBM、pgRBM、pgwRBM、DBN、wDBN、pgDBN、pgwDBN和卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network,簡稱CNN)進行比較.以上幾種方法都是在Intel(R)Xeon(R)CPU E4500 0@3.6GHZ 處理器、18GB 內(nèi)存、Windows 7 64 位操作系統(tǒng)和MATLAB 2015B(其中,CNN 是通過Python3.5+TensorFlow 框架實現(xiàn)的)的環(huán)境中運行的.本文實驗所用的隨機噪聲數(shù)據(jù)集是依據(jù)文獻[18]的方法對MNIST basic 和MNIST rotated 處理得到的數(shù)據(jù)集.設(shè)置不同鄰域相關(guān)度值{0,0.2,0.4,0.6,0.8,1},使MNIST basic 中每個像素點的邊緣分布在(0,1),可以得到6 種不同的數(shù)據(jù)集MNIST basic-back-random-a/b/c/d/e/f.同樣可以對MNIST rotated 處理得到數(shù)據(jù)集MNIST rotated-back-random-a/b/c/d/e/f.本文實驗所用的圖像數(shù)據(jù)集是文獻[18]中的MNIST back-image 和MNIST rotated-back-image.在所有的數(shù)據(jù)集中,訓(xùn)練樣本都有10 000 個噪聲數(shù)據(jù)和10 000 個干凈數(shù)據(jù),驗證和測試樣本分別為2 000 個和50 000 個噪聲數(shù)據(jù),樣本維數(shù)是784,標簽數(shù)目為10.圖3 給出了若干數(shù)據(jù)集的部分樣本.

Fig.3 Legends of benchmark data sets圖3 基準數(shù)據(jù)集的圖例

在本文中,所有算法都采用mini-batch 方法學(xué)習(xí),并且批量的大小均為100.RBM 和wRBM 隱層節(jié)點數(shù)為500 或1 000.pgRBM 和pgwRBM 都是通過特征選擇的方法對隱層節(jié)點數(shù)為1 200 的RBM 學(xué)習(xí)到的權(quán)值處理得到初值,并且它們的與分類有關(guān)的隱層和與分類無關(guān)的隱層節(jié)點數(shù)均為500.

pgrncRBM、pgincRBM、pgwrncRBM 和pgwincRBM 都是在傳統(tǒng)的pgRBM 基礎(chǔ)上對pgRBM 學(xué)習(xí)到的數(shù)據(jù)二次去噪,并且它們的與分類有關(guān)的隱層和與分類無關(guān)的隱層節(jié)點數(shù)均為500.

pgrncRBM、pgincRBM、pgwrncRBM 和pgwincRBM 與分類有關(guān)的隱層相連權(quán)值的初值是用RBM 或wRBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的,其與分類無關(guān)的隱層相連權(quán)值的初值都是用特征選擇的方法對隱層節(jié)點數(shù)為1 200 的RBM 或者ssRBM 對一次降噪的數(shù)據(jù)v′學(xué)習(xí)到的權(quán)值處理得到的.

DBN、wDBN、pgDBN、pgwDBN、pgrncDBN、pgincDBN、pgwrncDBN 和pgwincDBN 的隱層結(jié)構(gòu)均為500-500-2 000.CNN 是五隱層網(wǎng)絡(luò)結(jié)構(gòu),依次為卷積層(32 個5×5 卷積核)、池化層(過濾器大小為2×2)、卷積層(64 個5×5 卷積核)、池化層(過濾器大小為2×2)和全連接層(1 024 個隱層節(jié)點).所有算法最后均使用梯度下降算法分類,最大迭代次數(shù)為200(其中,CNN 的最大的迭代數(shù)目為500),并且依據(jù)驗證數(shù)據(jù)集的錯誤率采用提前終止方法.

4.2 算法性能比較與分析

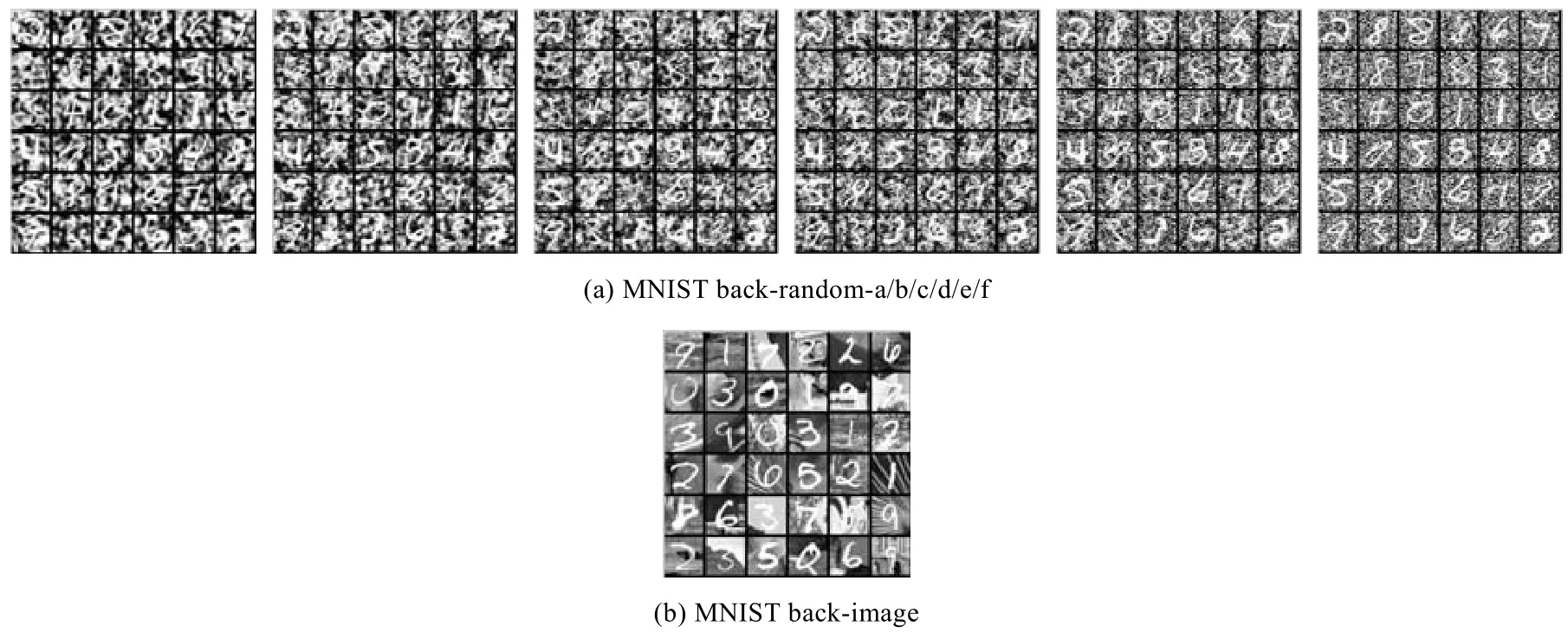

表1 給出了RBM、wRBM、pgRBM、pgwRBM、pgrncRBM 和pgwrncRBM 算法在含隨機噪聲的手寫數(shù)據(jù)集上的錯誤率.

Table 1 Error rates of shallow algorithms on random noisy data sets (%)表1 淺層算法在隨機噪聲數(shù)據(jù)集上的錯誤率 (%)

我們可以看出,pgwrncRBM 在所有數(shù)據(jù)集上都表現(xiàn)出優(yōu)于其他淺層學(xué)習(xí)算法的分類效果.

通過對比pgRBM 和pgrncRBM,我們可以看出,pgrncRBM 在所有數(shù)據(jù)集上的分類性能都優(yōu)于pgRBM.這說明利用不含噪聲的數(shù)據(jù)可以提升pgrncRBM在隨機噪聲數(shù)據(jù)上的學(xué)習(xí)能力.通過對比表1 中的算法,我們還可以發(fā)現(xiàn):

1)wRBM 基本上在所有隨機噪聲數(shù)據(jù)集上都表現(xiàn)出優(yōu)于RBM 的分類性能.

2)pgwRBM 僅在MNIST back-random-a、MNIST rotated-back-b 和MNIST rotated-back-d 這3 個數(shù)據(jù)集上的錯誤率略高于pgRBM.

3)pgwrncRBM 在所有數(shù)據(jù)集上都表現(xiàn)出優(yōu)于pgrncRBM 的分類性能.

4)隨機噪聲數(shù)據(jù)中噪聲結(jié)構(gòu)越簡單,與pgRBM 相比,pgrncRBM 提升的分類效果就越明顯.

表2 給出了RBM、wRBM、pgRBM、pgwRBM、pgincRBM 和pgwincRBM 算法在含圖像噪聲的手寫數(shù)據(jù)集上的錯誤率.同樣地,pgwincRBM 在所有圖像噪聲數(shù)據(jù)集上都表現(xiàn)出優(yōu)于其他淺層學(xué)習(xí)算法的分類效果.

Table 2 Error rates of shallow algorithms on image noisy data sets (%)表2 淺層算法在圖像噪聲數(shù)據(jù)集上的錯誤率 (%)

通過對比表2 中的算法,我們還可以發(fā)現(xiàn):

1)wRBM 在所有圖像噪聲數(shù)據(jù)集上的分類性能略優(yōu)于RBM.

2)pgwRBM 在MNIST rotated-back-image 數(shù)據(jù)集上的錯誤率略高于pgRBM.

3)pgwincRBM 在所有圖像噪聲數(shù)據(jù)集上都表現(xiàn)出優(yōu)于pgncRBM 的分類性能.

從表1 和表2 我們可以得出:1)權(quán)值不確定性方法能夠有效地解決RBM、pgRBM、pgrncRBM 和pgincRBM在處理含噪聲的數(shù)據(jù)時出現(xiàn)的過擬合問題;2)利用不含噪聲的數(shù)據(jù),可以提升pgrncRBM 和pgincRBM 在噪聲數(shù)據(jù)上的學(xué)習(xí)能力.

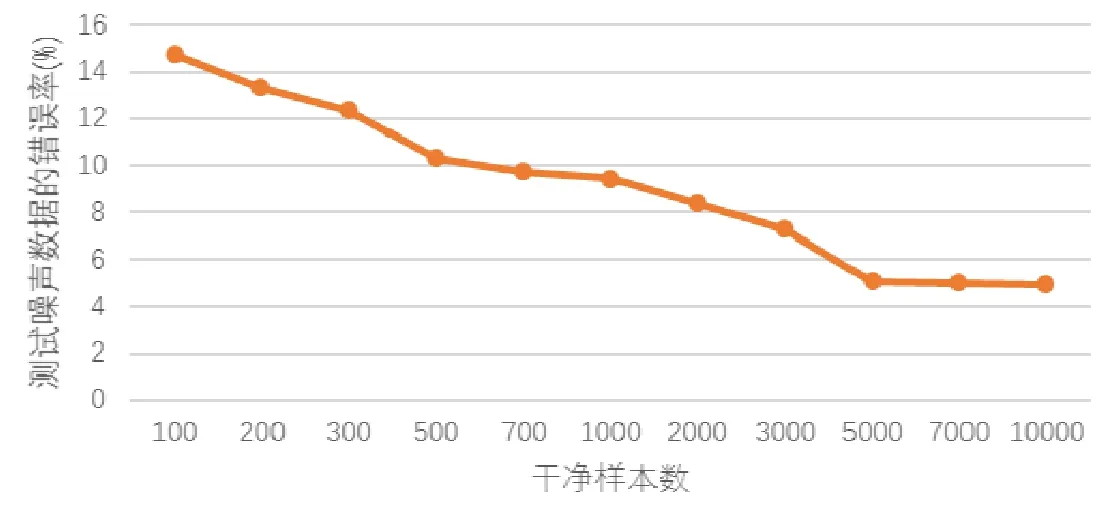

圖4 展示了pgrncRBM 在MNIST back-random-f 上的分類性能隨干凈樣本數(shù)目變化曲線.

Fig.4 Variations in the performance of pgrncRBM on MNIST back-random-/f,as we increase the number of the clean data圖4 pgrncRBM 在MNIST back-random-f 上的分類性能隨干凈樣本數(shù)目變化曲線

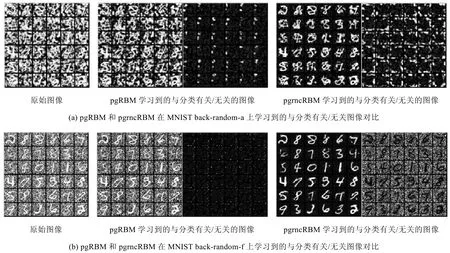

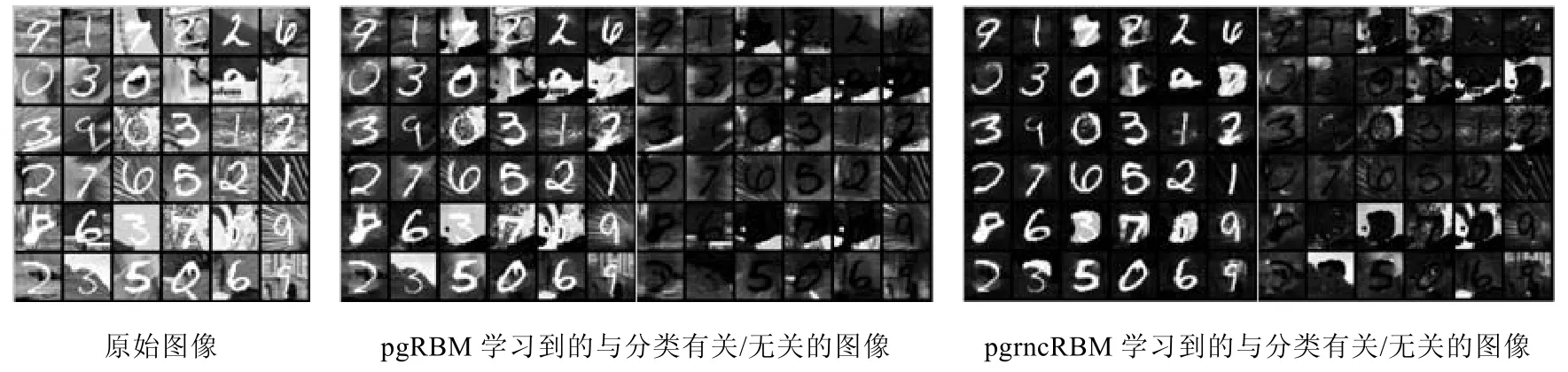

我們可以從圖4 中看出,當干凈樣本數(shù)目增大時,pgrncRBM 分類效果越來越好,這和我們的直觀理解是一致的.pgrncRBM 中與分類有關(guān)的隱層節(jié)點相連權(quán)值的初值是用RBM 對不含噪聲的數(shù)據(jù)學(xué)習(xí)得到的,干凈樣本越多,RBM 學(xué)習(xí)到的不含噪聲數(shù)據(jù)的信息就越多,pgrncRBM 也能更好地將噪聲數(shù)據(jù)中與分類有關(guān)的信息表示出來.圖5 給出了pgRBM 和pgrncRBM 在MNIST back-random-a/f 兩種數(shù)據(jù)集上的學(xué)習(xí)結(jié)果,圖6 給出了pgRBM和pgincRBM 在MNIST back-image 數(shù)據(jù)集上的學(xué)習(xí)結(jié)果.pgRBM、pgrncRBM 和pgincRBM 都把隱層節(jié)點分為與分類有關(guān)的和與分類無關(guān)的兩個部分,并且都能在含噪聲的數(shù)據(jù)中自適應(yīng)找到數(shù)據(jù)中與分類有關(guān)的部分.但是,我們可以從圖5 和圖6 中看出:

1)pgRBM 學(xué)習(xí)得到的與分類無關(guān)的圖像(也就是噪聲)中包含的噪聲信息很少,pgRBM 學(xué)習(xí)得到的與分類有關(guān)的圖像與原始的含噪聲圖像相差不是很大.

2)pgrncRBM 是在pgRBM 基礎(chǔ)上對其學(xué)習(xí)到的與分類有關(guān)的圖像二次去噪,但是pgrncRBM 可以很好地把圖像中與分類有關(guān)的信息(也就是手寫數(shù)字)和噪聲信息分別學(xué)習(xí)出來,特別是pgncRBM 在MNIST back-random-f 這個數(shù)據(jù)集上學(xué)習(xí)得到的與分類有關(guān)的圖像基本上沒有噪聲.

3)pgincRBM 是在pgRBM 基礎(chǔ)上對其學(xué)習(xí)到的與分類有關(guān)的圖像二次去噪,pgncRBM 可以把圖像中與分類有關(guān)的信息(也就是手寫數(shù)字)和圖像噪聲信息分別學(xué)習(xí)出來,但是有時也只能學(xué)習(xí)到部分與分類有關(guān)的信息,如第1 列中的數(shù)字2.

Fig.5 Learing results of pgRBM and pgncRBM on MNIST back-random-a/f data sets圖5 pgRBM 和pgncRBM 在MNIST back-random-a/f 數(shù)據(jù)集上的學(xué)習(xí)結(jié)果

Fig.6 Learing results of pgRBM and pgincRBM on MNIST back-image data set圖6 pgRBM 和pgincRBM 在MNIST back-image 數(shù)據(jù)集上的學(xué)習(xí)結(jié)果

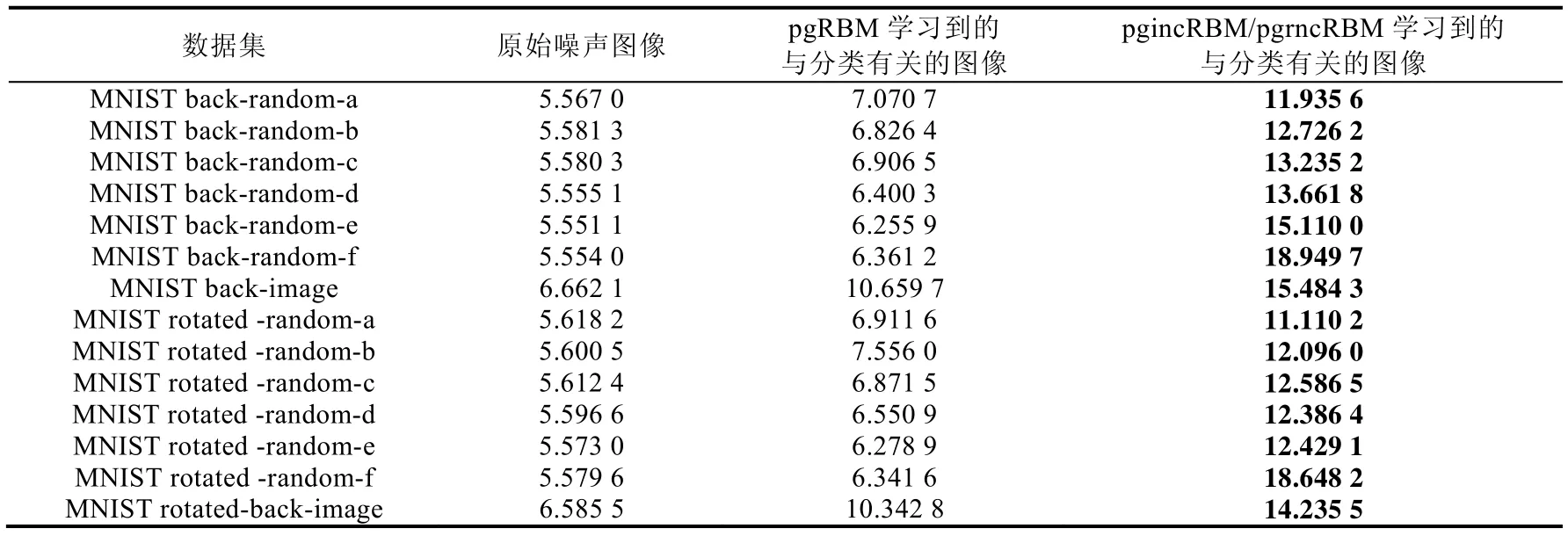

表3 給出了含噪聲的原始圖像、pgRBM 學(xué)習(xí)到的與分類有關(guān)的圖像和pgincRBM/pgrncRBM 學(xué)習(xí)到的與分類有關(guān)的圖像與干凈數(shù)據(jù)的信噪比.我們可以得出,pgrncRBM 和pgincRBM 可以在傳統(tǒng)的pgRBM 基礎(chǔ)上對pgRBM 學(xué)習(xí)到的數(shù)據(jù)二次去噪得到蘊含噪聲信息較少的圖像,從而達到更好的分類效果.pgrncRBM 在MNIST back-random-f 和MNIST rotated-random-f 上的錯誤率分別是5.03%和21.49%,而pgRBM 在這兩個數(shù)據(jù)集的錯誤率是pgrncRBM 的2 倍以上.并且,特別是在文獻[18]中,RBM 在MNIST basic 和MNIST rotated 的錯誤率分別是3.94%和14.69%,這與pgrncRBM 在MNIST back-random-f 和MNIST rotated-random-f 上的錯誤率還是比較接近的.

Table 3 Signal-noise ratios of learing results of pgRBM and pgincRBM/pgrncRBM on different valid data sets表3 pgRBM 和pgincRBM/pgrncRBM 學(xué)習(xí)結(jié)果在驗證數(shù)據(jù)集上的信噪比

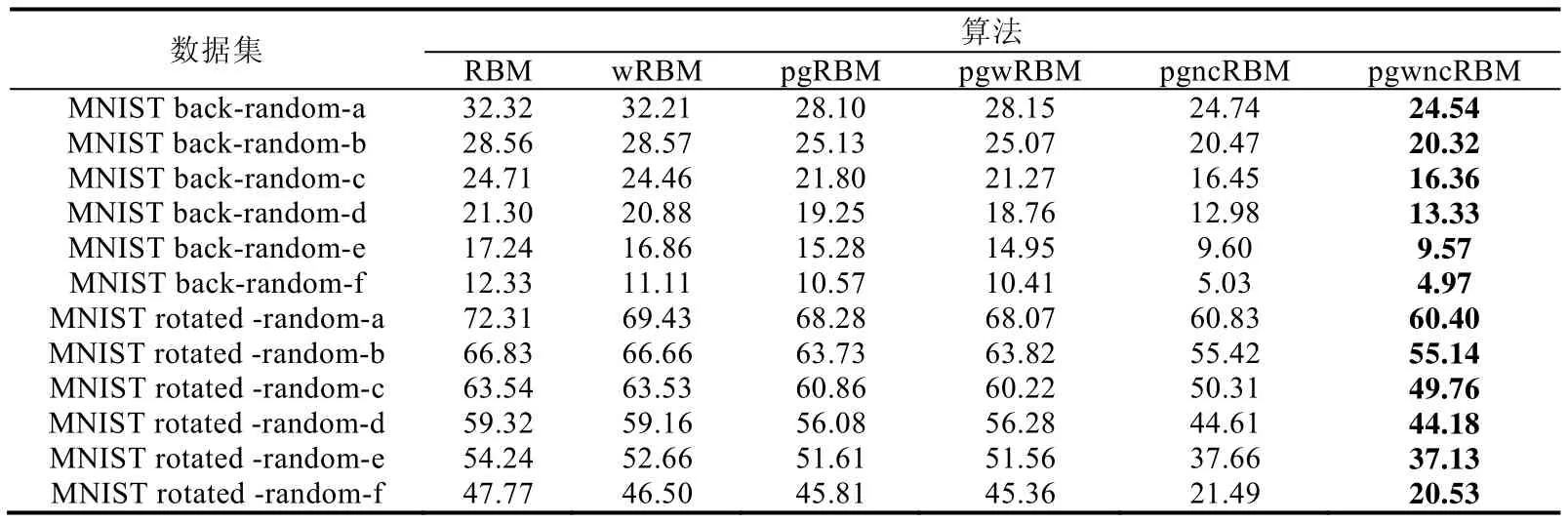

表4 給出了DBN、wDBN、pgDBN、pgwDBN、pgncDBN、pgwncDBN 和CNN 算法含隨機噪聲的手寫數(shù)據(jù)集上的錯誤率.我們從表4 可以看出,pgwrncDBN 在絕大多數(shù)數(shù)據(jù)集上的性能都表現(xiàn)出優(yōu)于其他深度學(xué)習(xí)算法的分類效果.通過對比pgDBN 和pgncDBN,我們可以看出,pgrncDBN 在所有隨機噪聲數(shù)據(jù)集上的分類性能都優(yōu)于pgDBN.實驗結(jié)果表明,pgrncDBN 還是一種有效的神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法.我們又可以發(fā)現(xiàn)以下結(jié)果.

1)wDBN 在所有數(shù)據(jù)集上都要表現(xiàn)出優(yōu)于DBN 的分類性能.

2)pgwDBN 在所有數(shù)據(jù)集上都要表現(xiàn)出優(yōu)于pgDBN 的分類性能.

3)pgwrncDBN 僅在MNIST rotated-back-f 數(shù)據(jù)集上的錯誤率略高于pgrncDBN.

4)CNN 僅在MNIST back-random-a、MNIST back-random-b 和MNIST rotated-random-a 這3 個數(shù)據(jù)集上的錯誤率低于pgrncDBN 和pgwrncDBN.

Table 4 Error rates of deep algorithms related to DBN on random noisy data sets (%)表4 與DBN 相關(guān)的深度算法在隨機噪聲數(shù)據(jù)集上的錯誤率 (%)

表5 給出了DBN、wDBN、pgDBN、pgwDBN、pgincDBN、pgwincDBN 和CNN 算法在含圖像噪聲的手寫數(shù)據(jù)集上的錯誤率.除了在MNIST back-image 上的錯誤率略高于CNN 以外,pgwincDBN 在所有圖像噪聲數(shù)據(jù)集上都表現(xiàn)出優(yōu)于深度淺層學(xué)習(xí)算法的分類效果.通過對比表5 中的算法,我們還可以發(fā)現(xiàn):

1)wDBN 在所有圖像噪聲數(shù)據(jù)集上的分類性能略優(yōu)于DBN.

2)pgwDBN 在所有圖像數(shù)據(jù)集上的錯誤率略高于pgDBN.

3)pgwincRBM 在所有圖像噪聲數(shù)據(jù)集上都表現(xiàn)出優(yōu)于pgncRBM 的分類性能.

4)CNN 僅僅在MNIST back-image 數(shù)據(jù)集上的錯誤率略低于pgincDBN 和pgwincDBN.

Table 5 Error rates of deep algorithms related to DBN on image noisy data sets (%)表5 與DBN 相關(guān)的深度算法在圖像噪聲數(shù)據(jù)集上的錯誤率 (%)

從表4 和表5 中我們可以得出:1)權(quán)值不確定性方法有效地解決了pgrncDBN 和pgincDBN 兩種深度網(wǎng)絡(luò)中出現(xiàn)的過擬合問題;2)pgrncDBN/pgwrncDBN 和pgincDBN/pgwincDBN 可以在絕大多數(shù)數(shù)據(jù)集上的性能超過CNN 的主要原因是pgrncRBM/pgwrncRBM 和pgincRBM/pgwincRBM 可以學(xué)習(xí)得到更為“干凈”的數(shù)據(jù).通過對比RBM、DBN 和wDBN,我們可以得出,DBN 在處理含噪聲數(shù)據(jù)時出現(xiàn)過擬合現(xiàn)象,并沒有展現(xiàn)出比RBM更好的學(xué)習(xí)能力,并且權(quán)值不確定性方法有效地解決了DBN 深度網(wǎng)絡(luò)中出現(xiàn)的過擬合問題.通過對比pgRBM與pgDBN、pgrncRBM 與pgrncDBN、pgincRBM 與pgincDBN,我們又可以發(fā)現(xiàn),堆疊pgRBM/pgrncRBM/pgincRBM 和RBM 構(gòu)造出的深度網(wǎng)絡(luò)(pgDBN、pgrncDBN 和pgincDBN)展現(xiàn)出優(yōu)于淺層網(wǎng)絡(luò)(pgRBM、pgrncRBM 和pgincRBM)的學(xué)習(xí)能力.

5 結(jié)束語

Point-wise Gated 受限玻爾茲曼機是一種針對噪聲數(shù)據(jù)的淺層學(xué)習(xí)算法.本文在此基礎(chǔ)上利用干凈數(shù)據(jù)提升其在噪聲數(shù)據(jù)上的學(xué)習(xí)能力,提出了兩種基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 受限玻爾茲曼機(pgrncRBM 和pgincRBM)方法,然后將它們學(xué)習(xí)到的與分類有關(guān)的數(shù)據(jù)子集用到深度置信網(wǎng)中,提出了兩種基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 深度置信網(wǎng)(pgrncDBN 和pgincDBN).pgrncRBM 和pgincRBM 在絕大多數(shù)手寫數(shù)據(jù)集上都表現(xiàn)出優(yōu)于pgRBM 的學(xué)習(xí)能力.同樣,以pgrncRBM 和pgincRBM 為基石的pgrncDBN和pgincDBN 一般都優(yōu)于pgDBN.然后,本文將權(quán)值不確定性方法用在所提出的4 種算法中,并將這幾種算法稱為基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 權(quán)值不確定性受限玻爾茲曼機(pgwrncRBM 和pgwincRBM)以及基于噪聲數(shù)據(jù)與干凈數(shù)據(jù)的Point-wise Gated 權(quán)值不確定性深度置信網(wǎng)(pgwrncDBN 和pgwincDBN).實驗結(jié)果表明,權(quán)值不確定性方法能夠有效地解決pgrncRBM、pgincRBM、pgrncDBN 和pgincDBN 在處理含噪聲數(shù)據(jù)時出現(xiàn)的過擬合問題.我們同時發(fā)現(xiàn),pgRBM、pgrncRBM 和pgincRBM 并不能在部分噪聲數(shù)據(jù)集(數(shù)據(jù)中與分類有關(guān)的部分被噪聲損壞時)上取得理想的結(jié)果.如何把它們應(yīng)用到更多的噪聲數(shù)據(jù)上,也是我們下一步的研究方向.