基于RGB和關節點數據融合模型的雙人交互行為識別

姬曉飛 秦琳琳 王揚揚

摘 要:基于RGB視頻序列的雙人交互行為識別已經取得了重大進展,但因缺乏深度信息,對于復雜的交互動作識別不夠準確。深度傳感器(如微軟Kinect)能夠有效提高全身各關節點的跟蹤精度,得到準確的人體運動及變化的三維關節點數據。依據RGB視頻和關節點數據的各自特性,提出一種基于RGB和關節點數據雙流信息融合的卷積神經網絡(CNN)結構模型。首先,利用Vibe算法獲得RGB視頻在時間域的感興趣區域,之后提取關鍵幀映射到RGB空間,以得到表示視頻信息的時空圖,并把圖送入CNN提取特征; 然后, 在每幀關節點序列中構建矢量,以提取余弦距離(CD)和歸一化幅值(NM)特征,將單幀中的余弦距離和關節點特征按照關節點序列的時間順序連接,饋送入CNN學習更高級的時序特征; 最后,將兩種信息源的softmax識別概率矩陣進行融合,得到最終的識別結果。實驗結果表明,將RGB視頻信息和關節點信息結合可以有效地提高雙人交互行為識別結果,在國際公開的SBU Kinect interaction 數據庫和NTU RGB+D數據庫中分別達到92.55%和80.09%的識別率,證明了提出的模型對雙人交互行為識別的有效性。

關鍵詞:RGB視頻;關節點數據;卷積神經網路;softmax;融合;雙人交互行為識別

中圖分類號:TP391

文獻標志碼:A

Human interaction recognition based on RGB and skeleton data fusion model

JI Xiaofei*, QIN Linlin, WANG Yangyang

College of Automation, Shenyang Aerospace University, Shenyang Liaoning 110136, China

Abstract:

In recent years, significant progress has been made in human interaction recognition based on RGB video sequences. Due to its lack of depth information, it cannot obtain accurate recognition results for complex interactions. The depth sensors (such as Microsoft Kinect) can effectively improve the tracking accuracy of the joint points of the whole body and obtain threedimensional data that can accurately track the movement and changes of the human body. According to the respective characteristics of RGB and joint point data, a convolutional neural network structure model based on RGB and joint point data dualstream information fusion was proposed. Firstly, the region of interest of the RGB video in the time domain was obtained by using the Vibe algorithm, and the key frames were extracted and mapped to the RGB space to obtain the spatialtemporal map representing the video information. The map was sent to the convolutional neural network to extract features. Then, a vector was constructed in each frame of the joint point sequence to extract the Cosine Distance (CD) and Normalized Magnitude (NM) features. The cosine distance and the characteristics of the joint nodes in each frame were connected in time order of the joint point sequence, and were fed into the convolutional neural network to learn more advanced temporal features. Finally, the softmax recognition probability matrixes of the two information sources were fused to obtain the final recognition result. The experimental results show that combining RGB video information with joint point information can effectively improve the recognition result of human interaction behavior, and achieves 92.55% and 80.09% recognition rate on the international public SBU Kinect interaction database and NTU RGB+D database respectively, verifying the effectiveness of the proposed model for the identification of interaction behaviour between two people.

Key words:

RGB video; skeleton data; Convolutional Neural Network (CNN); softmax; fusion; human interaction recognition

0?引言

基于視頻的交互行為識別具有較高的實用價值和廣闊的應用前景[1]。根據原始數據的不同,對于雙人交互行為識別的分析方法可以分為基于RGB視頻和基于關節點數據兩類。基于RGB視頻的研究開展比較早,Gavrila等[2]提出用時空體來描述人的行為,即利用人體行為的輪廓隨時間變化的過程來識別行為的類別。趙海勇等[3]將時變輪廓形狀轉換為對應的一維距離向量并提取行為序列的關鍵姿態,將關鍵姿態編碼為行為字符串進行交互行為識別; 韓磊等[4]提出一種基于時空單詞的雙人交互行為識別方法,該方法從包含雙人交互的視頻中提取時空興趣點,并通過投票生成單人原子行為的時空單詞,采用條件隨機場模型建模單人原子行為模型。在此基礎上并訓練馬爾可夫邏輯網用于雙人交互行為的推理。 Li等[5]提出一種多特征結合的描述方法,提取時空興趣點,并采用一系列描述子對其進行表示,采用時空匹配法和遺傳算法訓練隨機森林實現動作識別。這類基于RGB的算法對于簡單的雙人交互行為得到了較好的識別效果,但由于缺乏深度信息,對于復雜多變的交互動作識別不夠準確。

近幾年,隨著深度傳感器(如微軟Kinect)的快速發展,大幅提高了全身各關節點數據的跟蹤精度, Kinect相機共包括彩色攝像頭、深度攝像頭和紅外攝像機三個攝像頭,其中彩色攝像頭拍攝視角范圍內的彩色視頻圖像,同時深度攝像頭通過分析紅外光譜,創建可視范圍內的物體的深度圖像,利用深度圖轉化得到3D關節點數據。基于關節點的雙人交互識別獲得了越來越多研究者的關注。Yun等[6]利用當前幀中所有關節對的距離、當前幀中關節與前一幀中關節之間的距離以及當前幀中各關節點與中心點之間的距離來描述身體姿態,通過多實例學習方法得到每個動作的姿勢描述符。這種特征描述簡單易獲取,但缺少了上下文時序關系的描述。Slama等[7]將一個動作描述為時間序列中關節點三維坐標的集合,每個動作序列被表示為產生三維關節軌跡的線性動力系統,采用自回歸滑動平均模型來表示序列, 最后采用線性支持向量機(Support Vector Machine, SVM)進行分類。這種描述符同時包括時間和空間信息,但是對于相似動作的識別效果較差。

目前基于RGB視頻和關節點數據的雙人交互行為識別研究中,多數是依賴于低級或中級的手動獲取特征,在處理復雜數據時能力有限,適應性不強且動作識別準確率提升空間不大。近幾年,隨著卷積神經網絡(Convolutional Neural Network, CNN)在靜態圖像分類中獲得成功,其已經擴展到用于解決動作識別的研究中[8]。Simonyan等[9]提出基于RGB視頻時間空間結合的雙流卷積神經網絡模型,其中空間流是利用帶有視頻場景和對象的靜態視頻幀進行卷積,時間流是利用光流堆積法與軌跡追蹤法獲得光流圖進行卷積,最后將兩流做softmax的分數融合。分類結果表明,識別率較傳統傳統特征明顯提升,但基于多幀獲得的光流圖計算量較大。Li等[10]提出一種新穎的雙流卷積網絡結構,首先將原始的骨架信息直接送入CNN提取特征,另外將連續兩幀的骨架關節運動也送入網絡提取特征,將兩種特征連接并經過softmax融合獲得識別結果。該方法僅使用關節數據進行識別,計算量低,但是沒有很好地利用特征的時序關系。為了更好地建模關節點特征的時序關系,Liu 等[11]提出全局感知注意力長短期記憶(Long ShortTerm Memory, LSTM)網絡的動作識別方法。該網絡包括兩個LSTM網絡,第一個LSTM層用于編碼原始骨架序列并初始化全局存儲單元,然后將全局存儲單元的表示送入第二LSTM層,以選擇性地關注每個幀的信息性關節,經過多次迭代優化全局存儲信息,最后將精簡的全局信息送入softmax分類器識別動作類。Ke等[12]將骨架序列3D坐標的每個通道轉化為一個時空信息的片段,每個骨架序列轉換為三個片段,表示整個骨架序列的時間信息和骨架關節之間特定的空間關系,同時提出多任務卷積神經網絡(MultiTask Convolutional Neural Network, MTCNN),并行處理每個片段所有幀以學習骨架序列的時間和空間信息。Liu等[13]提出一個關節點序列的時空LSTM網絡,將LSTM的學習擴展到時空域,每個關節從相鄰關節以及前一幀接受信息編碼時空特征,采用樹狀結構表示關節點之間的相鄰特性和運動關系,最后將骨架數據的結果送入LSTM網絡進行建模與識別。Li等[14]提出基于骨架端到端的卷積共生特征學習框架,首先對每個關節點的點級信息獨立編碼,將骨架序列表示為張量,使用卷積和獨立學習點級別特征,然后轉換卷積層的輸出,分層聚合來自關節的全局特征,得到時間和空間域的語義表示,最后送入分層式共現網絡(Hierarchical Cooccurrence Network,HCN)學習。利用CNN在關節點和RGB視頻的雙人交互行為識別中均取得了良好的效果,識別的準確率較手動提取特征有了大幅度的提升。但將CNN應用在兩種特征互補的數據源結合中,還處于初始階段。因此,本文提出了一種RGB視頻和關節點數據雙流信息融合的CNN識別框架,該框架較好地利用了RGB信息和關節點信息的互補性,進一步提高了對于復雜交互行為識別的準確性。

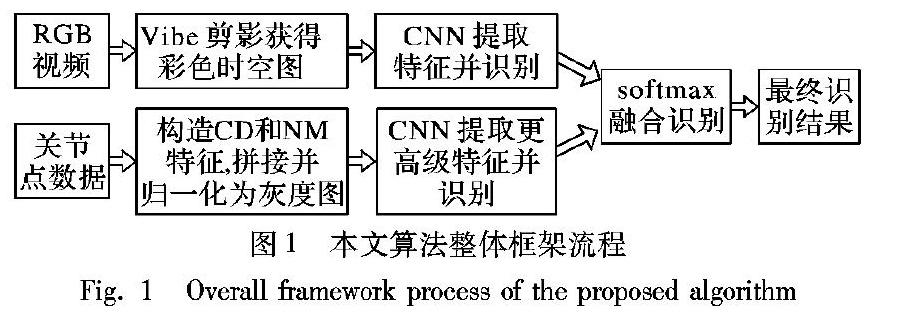

1?算法的整體框架

本文算法的整體框架如圖1所示,具體實現步驟如下:

1)基于RGB視頻的處理過程:首先判斷兩個交互個體的質心之間的距離,獲取交互幀的執行階段,從得到的RGB視頻幀中等間距選出三幀,利用Vibe算法做背景減除,分別得到三幀不包括背景信息的二值圖像,將代表視頻的三張圖片映射到RGB空間,并對三張圖片壓縮,得到表示視頻信息的時空圖。

2)基于關節點數據的處理過程:首先,構造交互個體及交互雙方之間的關節點矢量,然后構造基于矢量的具有平移、旋轉、縮放不變形的余弦距離(Cosine Distance, CD)和歸一化幅值(Normalized Magnitude, NM)特征表示骨架序列的空間結構信息,將兩種基礎特征分別連接起來并構造成灰度圖像,送入CNN用于提取更高級的時序特征和動作識別。

3)基于RGB視頻和關節點數據融合的識別過程:將處理好的RGB視頻數據和關節點數據分別送入深度學習網絡中,將各自得到的識別概率矩陣做權值融合送入softmax分類器得到最后的識別分數。

2?數據預處理

2.1?RGB視頻預處理

對于動作序列,一個動作流程可以分為準備、執行和結束階段,但有的動作如“握手”與“靠近”,在準備和結束有較大的相似性,為增加兩個動作的可區分性,通過測量交互動作雙方的質心距離D來得到動作視頻的執行階段。

c=1m1∑m1i=1ai,1m1∑m1i=1bi

d=1n1∑n1j=1aj,1n1∑n1j=1bj(1)

L=‖c-d‖-D≥0, 保留幀<0, 去除幀(2)

其中:c、d分別表示交互行為雙方的體心;m1和n1分別表示單個個體所包含的像素點個數;(ai,bi)和(aj,bj)表示單人的像素點坐標;D為設定的閾值;L為判別量。通過以上預處理過程得到更為精簡的RGB視頻信息,利用Vibe算法做背景減除,從去除背景的視頻幀中等間距選出三幀,并將這三幀圖像映射到RGB空間,得到表示視頻信息的時空圖。

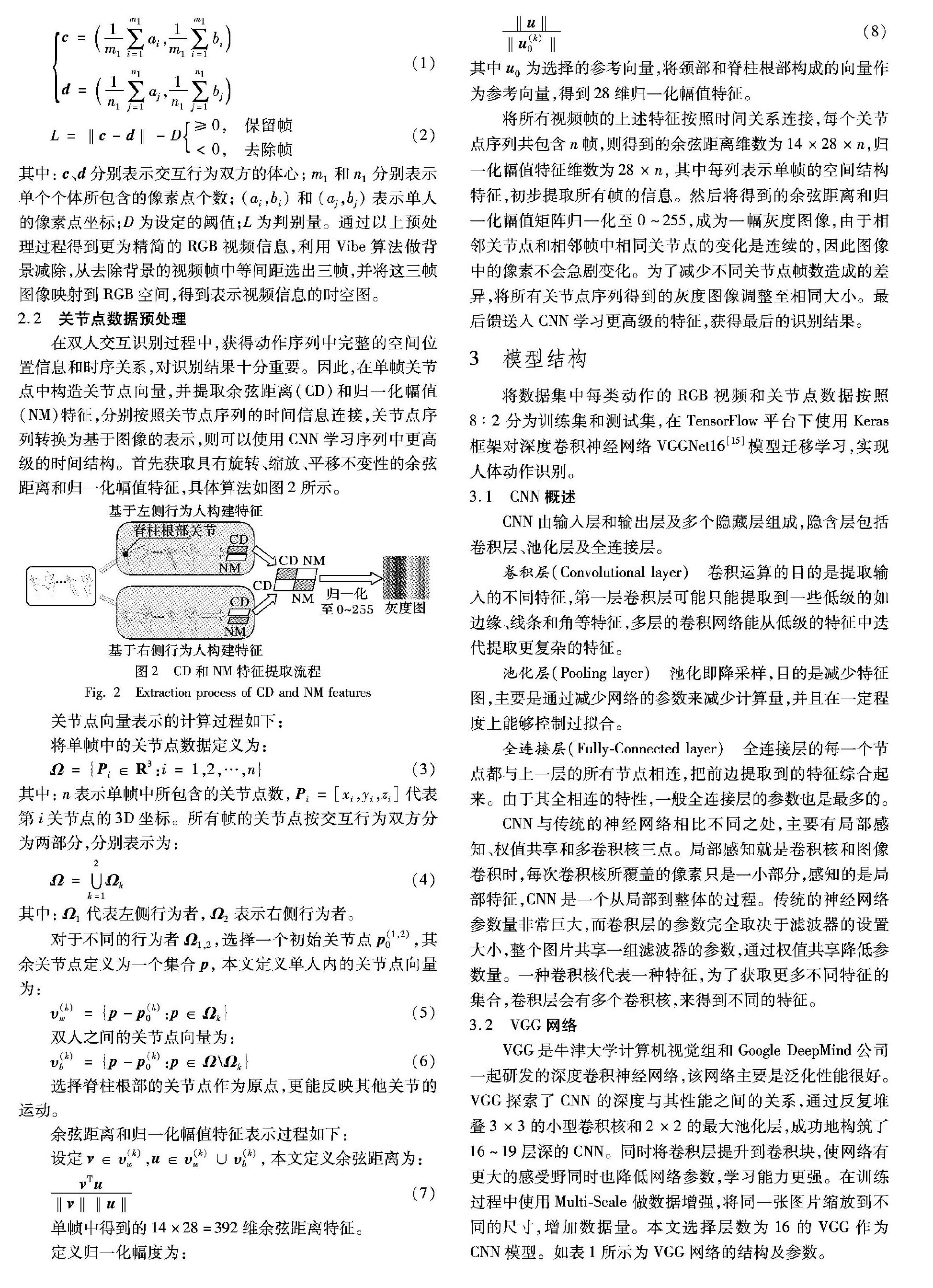

2.2?關節點數據預處理

在雙人交互識別過程中,獲得動作序列中完整的空間位置信息和時序關系,對識別結果十分重要。因此,在單幀關節點中構造關節點向量,并提取余弦距離(CD)和歸一化幅值(NM)特征,分別按照關節點序列的時間信息連接,關節點序列轉換為基于圖像的表示,則可以使用CNN學習序列中更高級的時間結構。首先獲取具有旋轉、縮放、平移不變性的余弦距離和歸一化幅值特征,具體算法如圖2所示。

關節點向量表示的計算過程如下:

將單幀中的關節點數據定義為:

Ω={Pi∈R3:i= 1,2,…,n}(3)

其中:n表示單幀中所包含的關節點數,Pi=[xi,yi,zi]代表第i關節點的3D坐標。所有幀的關節點按交互行為雙方分為兩部分,分別表示為:

Ω=∪2k=1Ωk(4)

其中:Ω1代表左側行為者,Ω2表示右側行為者。

對于不同的行為者Ω1,2,選擇一個初始關節點p(1,2)0,其余關節點定義為一個集合p,本文定義單人內的關節點向量為:

υ(k)w={p-p(k)0:p∈Ωk}(5)

雙人之間的關節點向量為:

υ(k)b={p-p(k)0:p∈Ω\Ωk}(6)

選擇脊柱根部的關節點作為原點,更能反映其他關節的運動。

余弦距離和歸一化幅值特征表示過程如下:

設定v∈υ(k)w,u∈υ(k)w∪υ(k)b,本文定義余弦距離為:

vTu‖v‖‖u‖(7)

單幀中得到的14×28=392維余弦距離特征。

定義歸一化幅度為:

‖u‖‖u(k)0‖(8)

其中u0為選擇的參考向量,將頸部和脊柱根部構成的向量作為參考向量,得到28維歸一化幅值特征。

將所有視頻幀的上述特征按照時間關系連接,每個關節點序列共包含n幀,則得到的余弦距離維數為14×28×n,歸一化幅值特征維數為28×n,其中每列表示單幀的空間結構特征,初步提取所有幀的信息。然后將得到的余弦距離和歸一化幅值矩陣歸一化至0~255,成為一幅灰度圖像,由于相鄰關節點和相鄰幀中相同關節點的變化是連續的,因此圖像中的像素不會急劇變化。為了減少不同關節點幀數造成的差異,將所有關節點序列得到的灰度圖像調整至相同大小。最后饋送入CNN學習更高級的特征,獲得最后的識別結果。

3?模型結構

將數據集中每類動作的RGB視頻和關節點數據按照8∶2 分為訓練集和測試集,在TensorFlow平臺下使用Keras框架對深度卷積神經網絡VGGNet16[15]模型遷移學習,實現人體動作識別。

3.1?CNN概述

CNN由輸入層和輸出層及多個隱藏層組成,隱含層包括卷積層、池化層及全連接層。

卷積層(Convolutional layer)?卷積運算的目的是提取輸入的不同特征,第一層卷積層可能只能提取到一些低級的如邊緣、線條和角等特征,多層的卷積網絡能從低級的特征中迭代提取更復雜的特征。

池化層(Pooling layer)?池化即降采樣,目的是減少特征圖,主要是通過減少網絡的參數來減少計算量,并且在一定程度上能夠控制過擬合。

全連接層(FullyConnected layer)?全連接層的每一個節點都與上一層的所有節點相連,把前邊提取到的特征綜合起來。由于其全相連的特性,一般全連接層的參數也是最多的。

CNN與傳統的神經網絡相比不同之處,主要有局部感知、權值共享和多卷積核三點。局部感知就是卷積核和圖像卷積時,每次卷積核所覆蓋的像素只是一小部分,感知的是局部特征,CNN是一個從局部到整體的過程。傳統的神經網絡參數量非常巨大,而卷積層的參數完全取決于濾波器的設置大小,整個圖片共享一組濾波器的參數,通過權值共享降低參數量。一種卷積核代表一種特征,為了獲取更多不同特征的集合,卷積層會有多個卷積核,來得到不同的特征。

3.2?VGG網絡

VGG是牛津大學計算機視覺組和Google DeepMind公司一起研發的深度卷積神經網絡,該網絡主要是泛化性能很好。VGG探索了CNN的深度與其性能之間的關系,通過反復堆疊3×3的小型卷積核和2×2的最大池化層,成功地構筑了16~19層深的CNN。同時將卷積層提升到卷積塊,使網絡有更大的感受野同時也降低網絡參數,學習能力更強。在訓練過程中使用MultiScale 做數據增強,將同一張圖片縮放到不同的尺寸,增加數據量。本文選擇層數為16的VGG作為CNN模型。如表1所示為VGG網絡的結構及參數。

3.3?融合結構

針對可視范圍內發生的動作,Kinect相機能夠同時獲取RGB視頻和3D關節點數據。將傳統RGB數據與3D關節點數據相結合,兩者信息互補,經過預處理,RGB獲得更精簡的信息,3D關節點數據得到具有旋轉、平移、縮放不變性的基礎特征。分別將處理得到的RGB視頻和關節點數據送入VGG16網絡模型,最終利用softmax分類器得到基于RGB視頻和關節點數據各動作類別的識別分數概率矩陣。然后,針對不同的原始數據流給予不同的權值融合softmax值,將融合得到的結果再次經過softmax分類器,最終得到融合識別結果分數矩陣,實現RGB視頻和3D關節點數據的決策集融合。總體流程如圖3所示。

4?實驗測試與分析

4.1?數據庫與測試環境介紹

為證明提出方法的有效性,采用國際標準的SBU Kinect數據庫和NTU RGB+D數據庫進行驗證。SBU Kinect交互數據集共有7名動作行為人,組成21對動作執行者,包括8個動作類別,分別為靠近、離開、踢腿、打、推、擁抱、握手和傳遞物品。在大多數的互動行為中,一個人做出動作另一個人做出反應動作,且均采用相同的室內背景錄制。每個人由15個關節點表示,每幀的關節點數據維度為15×3×2=90。該數據集包含的動作大多為非周期性行為,且包含相似動作,準確實現動作識別具有一定的難度。

NTU RGB+D Dateset數據集是目前包括雙人交互的RGB+D視頻和關節點數據最大的數據庫,包括56-880個視頻片段。本數據庫共有40名行為動作者,包括60個動作類別,包括日常動作、與健康相關的動作和雙人交互行為。本數據庫采用三個高度相同但角度不同的攝像機采集圖片。動作行為人執行兩次動作,一次面向左側攝像頭一次面向右側攝像頭。本數據庫提供兩種識別評估標準CS和CV, 本文采用CS的評估方式。

本實驗基于Tensorflow平臺利用keras深度學習庫在GPU處理器下進行,操作系統為Ubuntu16.04,內存和硬盤參數分別為32GB、256GB+2TB,編程環境為Python3.6,程序框架Keras2.1.3。

4.2?SBU 數據庫實驗測試結果

1)RGB視頻和關節點數據測試結果分析。

本實驗在國際公開的SBU數據集中的RGB視頻和關節點數據上分別做了測試,把每個動作按8∶2 的比例劃分為訓練集和測試集,用80%的數據訓練模型,將訓練好的模型用20%的視頻做測試。本實驗共采用200次迭代訓練,每次迭代訓練中訓練數據與測試數據對應的準確率如圖4所示。

從圖4中可知,隨著訓練次數增加,準確率不斷增加,模型的損失值不斷降低。利用RGB視頻數據在此模型下測試,得到的最優識別準確率為87.5%,將最終的識別結果用混淆矩陣表示如圖5所示。

從圖5混淆矩陣分析可知,誤識別動作主要為“推”和“握手”兩個動作,通過分析可知,這兩類動作在視頻的階段幀與幀之間的變化幅度小,導致Vibe背景減除后得到的動作區分性不足,導致模型的誤識別。

將關節點數據在構建的模型下進行測試,得到識別準確率為91.87%,把識別結果用歸一化混淆矩陣表示,如圖6。

從上述混淆矩陣分析可知,應用關節點數據進行識別,8種行為動作中有6種行為能達到準確識別,錯誤識別主要發生在握手(shaking hand)和傳遞物品(exchanging),因為關節點數據只對行為人的動作變化作出精確描述,不包含環境中的其他事物,對行為的外觀描述信息較少,因此容易造成包含環境中其他事物的動作識別不準確。

從圖5和圖6的分析可以看出,RGB視頻信息與關節點數據具有較好的互補性,為下一步的融合提供了依據。

2)RGB視頻和關節點數據信息融合。

本文將RGB視頻和關節點數據得到的識別分數作決策級融合,將兩種信息源得到的識別概率矩陣加權融合送入softmax分類器得到最終的識別分數,得到最終比較理想的識別結果,識別率為92.55%。

為驗證本文提出模型的有效性,本文將同樣在SBU Kinect interaction 數據庫上進行算法測試的結果與本文所得的實驗結果相比較,如表2所示。

從表2中可知,本文提出的基于CNN的RGB和關節點數據融合的雙人交互行為識別框架獲得了良好的識別結果。與文獻[5]和文獻[6]中利用單一數據源和手動提取特征相結合的處理方法相比較,識別準確率得到了大幅度的提升。本文的識別結果與文獻[13]相當,但文獻[13]中引入一個信任門消除關節點數據的噪聲,而本文的方法對原始含有噪聲的數據沒有作任何處理,采用原始的關節點數據構造基礎特征。文獻[12]是將每個關節點序列轉化為三個片段,采用多任務卷積神經網絡識別分類,但訓練多任務并行的CNN模型復雜度高,訓練過程復雜,而本實驗中采用16層的卷積網絡,迭代一次的訓練時長僅為2s,識別過程中處理一幀數據的時間約為27ms, 具有較好的實時性。本文采用的方法避免對原始的關節點數據進行處理,算法相對簡單,具有一定的實際應用前景。

4.3?NTU 數據庫實驗測試結果

1)RGB視頻和關節點數據測試結果分析。

本實驗在NTU RGB+D數據庫的RGB視頻和關節點數據上進行分別訓練與測試,采用原數據庫提供的CrossSubject測試模式,將動作行為人分為兩組,得到的行為動作分別作為訓練集和測試集。針對不同的數據源,RGB視頻數據采用100次的迭代訓練,關節點數據采用200次迭代訓練每次迭代訓練中訓練數據與測試數據對應的準確率和模型損失值如圖7所示。

從圖7中可知,隨著訓練次數增加,準確率增加,由于NTU數據庫很大且相機的變化角度和參與動作的人數較多,且在訓練時利用batch size調整一次學習的信息量,導致模型存在一些震蕩。利用RGB視頻數據在此模型下測試,得到的最優識別準確率為75.82%。利用關節點數據在此模型下得到的最優識別結果為74.37%。

3)RGB視頻和關節點數據信息融合。

單獨利用RGB視頻和關節點數據分別進行測試,結果發現“摸口袋”這個動作,在RGB視頻識別過程中得到的結果較差,而在關節點數據識別過程中得到了較為理想的識別結果。本文將RGB視頻和關節點數據得到的識別分數作決策級融合,將兩種信息源得到的識別概率矩陣加權融合送入softmax分類器得到最終的識別分數,得到的正確識別率為80.09%,較單一數據源的結果有了較大的提升。

為驗證本文提出模型的有效性,本文將同樣在NTU RGB+D數據庫CrossSubject測試模式下驗證的其他文獻得到的測試結果與本文所得的實驗結果相比較,如表3所示。

由表3可知,本文提出的RGB視頻和關節點數據融合并與CNN結合的網絡模型結構,比文獻[11]和文獻[13]中采用的方法得到的識別結果大幅度提高。文獻[10]采用雙流并行的CNN,模型復雜度高且訓練時間長; 文獻[14]使用CNN模型學習共生特征,并設計一種端到端的分層式學習網絡,獲得了較高的識別結果,但它將骨架表示為張量的過程計算量較大,同時使用卷積層獨立地為每個關節學習點層面的特征,卷積網絡設計復雜; 本文采用16層卷積結構,網絡模型簡單且參數較少,模型訓練時間短,每幀的處理時間約為27ms,同時也得到了較為理想的實驗結果。

5?結語

本文根據RGB視頻和關節點數據各自的優缺點,提出將RGB視頻和關節點數據在決策級中有效結合起來的雙人交互行為識別算法。本文充分地利用RGB視頻和關節點數據互補的特性,在對兩種原始數據作出合理的預處理的前提下,采用CNN的框架,進行更高級的特征提取與分類。本文采用國際公認的SBU Kinect深度數據庫和NTU RGB+D數據庫進行訓練與測試,結果表明識別結果良好,同時避免了復雜的預處理。下一步研究重點是在當前模型的基礎上引入時序建模,將兩種數據源更好地結合,進一步提高雙人交互行為識別的準確性。

參考文獻 (References)

[1]王世剛,孫愛朦,趙文婷,等. 基于時空興趣點的單人行為及交互行為識別[J]. 吉林大學學報(工學版), 2015, 45(1):304-308.(WANG S G, SUN A M, ZHAO W T, et al. Single and interactive human behavior recognition algorithm based on spatiotemporal interest point [J]. Journal of Jilin University (Engineering and Technology Edition), 2015, 45(1):304-308.)

[2]GAVRILA D M, DAVIS L S. 3D modelbased tracking of humans in action: a multiview approach[C]// Proceedings of the 1996 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 1996: 73-80.

[3]趙海勇,劉志鏡,張浩. 基于輪廓特征的人體行為識別[J]. 光電子·激光, 2010, 21(10):1547-1551. (ZHAO H Y, LIU Z J, ZHANG H. Human action recognition based on image contour [J]. Journal of Photoelectron·Laser, 2010, 21(10):1547-1551)

[4]韓磊,李軍峰,賈云得. 基于時空單詞的雙人交互行為識別方法[J].計算機學報, 2010, 33(4):776-784. (HAN L, LI J F, JIA Y D. Human interaction recognition method using spatiotemporal words[J]. Chinese Journal of Computers, 2010, 33(4):776-784.)

[5]LI N, CHENG X, GUO H, et al. Recognizing human interactions by genetic algorithmbased random forest spatiotemporal correlation[J]. Pattern Analysis and Applications, 2016, 19(1):267-282.

[6]YUN K, HONORIO J, CHATTOPADHYAY D, et al. Twoperson interaction detection using bodypose features and multiple instance learning[C]// Proceedings of the 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops. Piscataway: IEEE, 2012:28-35.

[7]SLAMA R, WANNOUS H, DAOUDI M, et al. Accurate 3D action recognition using learning on the Grassmann manifold[J]. Pattern Recognition, 2015, 48(2):556-567.

[8]GHORBEL E, BOUTTEAU R, BOONAERT J, et al. 3D realtime human action recognition using a spline interpolation approach[C]// Proceedings of the 2015 International Conference on Image Processing Theory, Tools and Applications. Piscataway: IEEE, 2015:61-66.

[9]SIMONYAN K, ZISSERMAN A. Twostream convolutional networks for action recognition in videos[C]// Proceedings of the 27th International Conference on Neural Information Processing Systems. Cambridge, MA: MIT Press, 2014:568-576.

[10]LI C, ZHONG Q, XIE D, et al. Skeletonbased action recognition with convolutional neural networks[C]// Proceedings of the 2017 IEEE International Conference on Multimedia & Expo Workshops. Piscataway: IEEE, 2017:597-600.

[11]LIU J, WANG G, DUAN L, et al. Skeletonbased human action recognition with global contextaware attention LSTM networks[J]. IEEE Transactions on Image Processing, 2018, 27(4):1586-1599.

[12]KE Q, BENNAMOUN M, AN S, et al. Learning clip representations for skeletonbased 3D action recognition[J]. IEEE Transactions on Image Processing, 2018, 27(6):2842-2855.

[13]LIU J, SHAHROUDY A, XU D, et al. Spatiotemporal LSTM with trust gates for 3D human act in recognition[C]// Proceedings of the 2016 European Conference on Computer Vision, LNCS 9907. Berlin: Springer, 2016:816-833.

[14]LI C, ZHONG Q, XIE D, et al. Cooccurrence feature learning from skeleton data for action recognition and detection with hierarchical aggregation[EB/OL].[2019-03-20].http://arxiv.org/pdf/1804.06055.

[15]SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for largescale image recognition[EB/OL]. [2019-01-10].https://arxiv.org/pdf/1409.1556.pdf.

This work is partially supported by National Natural Science Foundation of China (61602321), the Local Project of Scientific Research Service of Liaoning Education Department (L201708), the Scientific Research Youth Project of Liaoning Education Department (L201745).

JI Xiaofei, born in 1978, Ph. D., associate professor. Her research interests include video analysis and processing, pattern recognition.

QIN Linlin, born in 1994, M. S. candidate. Her research interests include video analysis and processing, biological characteristics and behavior analysis.

WANG Yangyang, born in 1979, Ph. D., engineer. Her research interests include video analysis and processing.