基于神經網絡的姿態識別算法

張劍書 楊煉鑫 王浩然 樊英澤

摘 要:公共場所視頻監控網絡部署日益完善,智能視頻監控技術在安防、交通等領域作用越來越大。針對視頻監控數據中的人類目標,提出一種基于計算機視覺的姿態識別方法。通過YOLO算法和AlphaPose模型完成對視頻中人類目標檢測識別以及姿態估計,在此基礎上分析人體關節之間的角度對姿態分類的影響,從中提取有效的分類特征,構造并訓練5層神經網絡模型,完成對站、坐、躺最常見3種姿態分類。實驗結果表明,訓練得到的神經網絡模型準確率達到85%以上,識別速率大約為每秒30幀,在安防監控、檢測人員摔倒、疾病報警等方面具有一定應用價值。

關鍵詞:神經網絡;目標檢測識別;人體姿態估計;姿態分類

DOI:10. 11907/rjdk. 201698

中圖分類號:TP312 ??? 文獻標識碼:A?????? 文章編號:1672-7800(2020)011-0033-04

Posture Recognition Algorithm Based on Neural Network

ZHANG Jian-shu, YANG Lian-xin, WANG Hao-ran, FAN Ying-ze

(School of Computer Engineering, Nanjing Institute of Technology, Nanjing 211167, China)

Abstract:With the development of video surveillance network in public places, intelligent video surveillance technology plays an important role in security, transportation and other fields. In this paper, a computer vision based posture recognition method is proposed for human targets in video surveillance data. The detection, recognition and pose estimationof human targets in the video can be done through the YOLO algorithm and the AlphaPose model. On this basis, the influence of angles between human joints on posture classification is analyzed, and effective classification features are extracted from these angles. A five layer neural network model is constructed and trained to complete the classification of the three most common postures: standing, sitting and lying. The experimental results show that the accuracy rate of the trained neural network model can reach more than 85%, and the recognition rate is about 30 frames per second, and this method has a certain application value in security monitoring, staff falling and disease detection.

Key Words:neural network; target detection and recognition; human pose estimation; pose classification

0 引言

人體姿態識別與動作分類在智能視頻監控、醫療健康、人機交互、安全認證等領域有著廣泛應用[1],一直以來都是學界和工業界的研究熱點。根據原始數據獲取方式的不同,常見的姿態識別方法分為兩類:傳統的基于可穿戴設備或傳感器設備的姿態識別和新興的基于計算機視覺的姿態識別[2]。傳統方法需要給目標對象穿戴多種傳感器或光學標志,并基于此采集目標對象動作信息,這種方法抗干擾能力強,但是會影響目標對象的運動且難以廣泛應用于公共場所[3];基于視覺的方法則是通過分析圖片數據中的目標對象各關節點位置,提取其關鍵節點信息和骨架信息,數據采集完全通過外部監控攝像頭完成,不會影響運動的舒適性,采集成本較低。

在基于計算機視覺方法中,通過姿態估計從二維圖像或深度圖像中獲取人體骨架關鍵點是實現姿態識別的基礎[4]。傳統的姿態估計基于圖結構[5]實現,用通過人工設定的特征(HOG[6]、SHIFT[7])匹配關節點,雖然效率較高但是算法的魯棒性和可擴展性較差[8]。近年深度學習在機器視覺領域大放異彩,Toshev等[9]在2013年提出的DeepPose利用CNN提取目標關節點坐標信息,是第一個基于深度學習方法的姿態估計模型,相比于傳統模型準確率更高。隨著DeepCut[10]、Mask Rcnn[11]以及AlpahPose[12]等一系列基于深度學習的姿態估計方法提出,目前深度學習方法成為基于視覺的姿態估計最常用方法。

本文采用YOLO算法[13]和AlphaPose模型提取圖像中的人類目標位置信息和骨骼關鍵點數據,針對Microsoft COCO數據集[14]中的目標和標記數據構建訓練數據集并從中提取出有效的人體關節之間的角度特征,在此基礎上通過神經網絡算法訓練人體姿態識別模型。本文提出的基于神經網絡的姿態識別算法是對基于計算機視覺的姿態估計結果的進一步分析與挖掘,判斷目標姿態的類別信息,相比于傳統的基于可穿戴設備的姿態分類,該方法不需要目標對象穿戴多種傳感器或光學標志,數據采集成本低且實時性高,處理效率很高。

1 基于神經網絡的姿態識別

姿態識別是通過一系列算法分析傳感器設備或攝像頭捕捉到的目標對象原始信息,從而得到目標對象姿態。基于計算機視覺的姿態識別步驟有姿態估計、構建姿態數據集、特征提取和模型訓練。

1.1 姿態估計

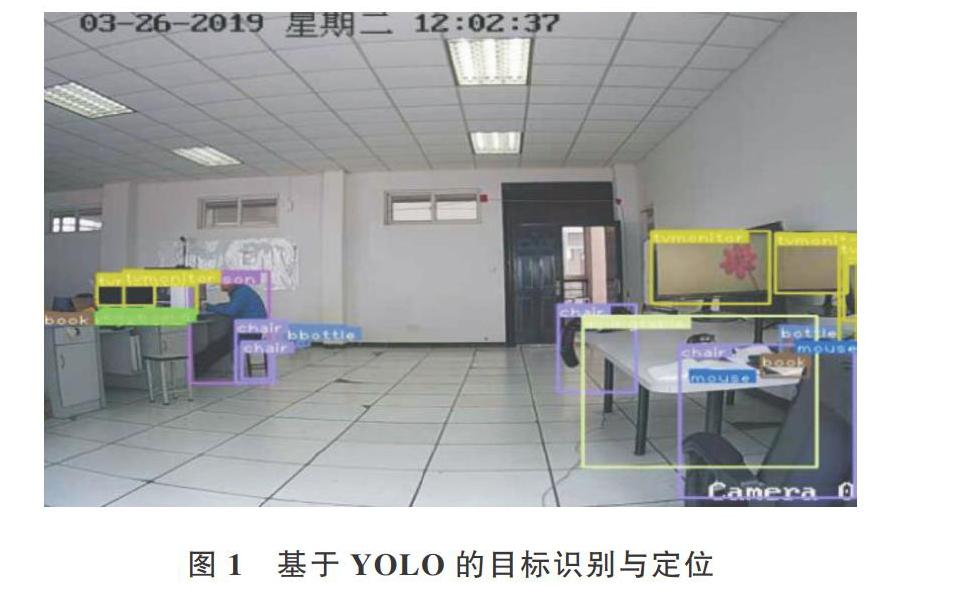

本文采用YOLO算法和AlphaPose模型從視頻或圖像中提取出人類目標并對其進行姿態估計。YOLO算法相比于RCNN系列算法[15]最大的特點就是速度快,它將目標檢測任務作為回歸問題解決,可以直接對輸入圖像應用算法進行目標檢測和識別,得到物體類別信息和位置信息,如圖1所示。

在完成目標識別和定位后,需要從識別出的目標中抽取出人類目標,并基于AlphaPose模型提取人體骨架信息。AlphaPose模型采用新的區域多人姿態估計框架,針對單人姿態估計(Single-Person Pose Estimator,SPPE)對目標定位結果非常敏感的問題,引入對稱空間變換網絡(Symmetric Spatial Transformer Network,SSTN)和參數化姿態非最大抑制(Parametric Pose Non-Maximum-Suppression,P-NMS),解決檢測框定位錯誤和檢測框冗余問題。最后通過姿態引導區域框生成器(Pose-guided Proposals Generator,PGPG)進行數據增強。通過AlphaPose模型實現多人姿態估計,得到圖2中每個目標的17個骨架關鍵點位置數據,如圖2所示。

1.2 姿態數據集構建

基于開源數據集Microsoft COCO構建姿態數據集。COCO數據集不僅包括目標的類別信息和位置信息,還包括人類目標的關節點數據。首先從所有圖片所對應的5張圖片說明文字標簽(captions.json)中篩選出包含“stand”、“sit”和“lie”這些與人體姿態相關的關鍵詞,然后將這些關鍵詞作為該圖片的姿態標簽。由于這些圖片中包含的人類目標數量不確定,因此姿態關鍵詞具體描述的哪個人目標也不確定。為排除多個目標干擾,根據每張圖片的實例標簽(instances.json)標記的所有目標類別信息,從這些圖片中剔除包含多個人類目標圖片。考慮到有些圖片中會存在遮擋或目標出現在邊緣顯示不全問題,需要檢查剩余圖片數據的關鍵點標簽(keypoints.json)中的17個關鍵點(鼻子、左/右眼、左/右耳、左/右肩、左/右肘、左/右手腕、左/右髖部、左/右膝、左/右腳踝)位置數據是否為有效數據,將關鍵點數據不全的圖片刪除,最后得到人體姿態數據集,共計3 000多張圖片和對應標簽,包含最常見的3種姿態。

1.3 特征提取

訓練數據集中人類目標位置標簽和目標關鍵點標簽是數據的原始特征,如圖3所示。這些特征并不適合直接應用到姿態識別中,因此需要從數據的原始特征中提取出姿態識別有效特征。

當人的姿態發生變化時,各關節之間角度相應也會發生一定變化,將圖1中的17個骨架關鍵點[xi,yi]兩兩相減得到136個向量,計算公式如下:

分別計算這136個向量相互之間的夾角,為了方便后續計算,這里計算這些夾角的余弦值,以此作為備選特征,計算公式如下:

根據公式(2)得到的余弦值共有9 180個,數據量較大,若直接基于這些特征構建神經網絡則網絡結構會很復雜,訓練過程會耗費很多時間,而這些特征是通過窮舉得到的,并沒有篩選,其中可能混雜很多無效特征。因此,需對這些余弦值特征進一步提取,分別計算不同姿態和相同姿態目標之間的余弦值方差,基于類內特征方差大同時類間特征方差小的原則,構造特征影響因子指標,篩選出特征影響因子最高的10個特征作為有效的人體姿態特征,如表1所示。

1.4 模型訓練

基于BP神經網絡構建姿態分類模型。BP神經網絡主要由輸入層、隱含層和輸出層3種結構組成。針對上述訓練數據集及提取出的10個有效姿態特征,構建五層結構的神經網絡模型如圖4所示。

圖2的網絡包含一個輸入層、3個隱含層和一個輸出層。其中,第一層是輸入層,輸入層的每個神經元代表一個特征,因此輸入層由10個神經元組成,采用[tanh]函數作為激活函數,其表達式為

第二層到第四層都是隱含層,第二層與第四層的作用類似,通過對輸入特征進行多層次抽象,線性劃分不同類型數據。在第二層與第四層分別設置15個神經元和12個神經元,同時采用線性整流函數relu作為激活函數避免梯度彌散問題,relu函數表達式如下:

另外,考慮到神經網絡模型的復雜性以及訓練數據量有限,在訓練過程中可能會出現過擬合問題,在第三層中引入dropout策略。在訓練過程中隨機使上一層部分神經元失活,以提高網絡的泛化能力。

最后一層為輸出層,輸出為該目標的姿態分別屬于不同類別的概率。輸出層的神經元個數代表分類標簽個數,輸出的類別標簽包括3類,因此輸出層的神經元個數為3。輸出層選擇分類效果較好的softmax函數作為激活函數。

神經網絡模型訓練就是確定初始參數,選擇合適的優化器,然后根據訓練數據集中的特征數據和標簽數據不斷優化網絡參數。

2 實驗結果分析

將訓練數據集中70%的數據作為訓練集,剩下30%數據作為測試集,設置網絡的第三層dropout丟棄概率為0.3,迭代6 000次,分別選擇SGD(學習率設置為0.001)和Adam(設置學習率為0.001,指數衰減率[β1]和[β2]分別設置為0.9和0.99)作為優化器,采用交叉熵誤差函數作為損失函數,訓練準確率曲線和損失曲線如圖5所示。

從圖5可以看出,采用Adam作為優化器時模型收斂速度很快,在迭代了2 000次后就收斂了,在訓練集上可以獲得更高的識別準確率。采用精確率、召回率、F1分數和準確率作為評估模型性能指標,計算得到基于Adam優化器訓練的模型性能指標如表2所示。

從表2可以看出,無論是在訓練集還是在測試集上,模型的準確率都在85%以上,同時精確率、召回率和F1分數也都在85%左右,具有較好的綜合性能。

3 結語

本文提出一種基于神經網絡的人體姿態識別算法,篩選Microsoft COCO數據集中的目標和標記數據構建訓練數據集,并結合特征工程獲取有效的人體姿態特征數據,通過構建和訓練神經網絡算法得到人體姿態識別模型。實驗結果表明,該模型具有較高的識別準確率和識別效率,可直接應用到智能視頻監控系統中,結合目標檢測、識別以及人體姿態估計算法,判斷視頻監控覆蓋范圍內所有人體目標姿態。但目前訓練樣本中的姿態類別有限,后期可通過手工標注方法擴展訓練樣本,通過引入更多的姿態標簽增強模型應用范圍。

參考文獻:

[1] 石躍祥,許湘麒. 基于改進DenseNet網絡的人體姿態估計[J]. 控制與決策,2019,18(12):1-8.

[2] 景元,吉愛紅,張曦元,等. 傳感器人體運動行為特征識別研究進展[J].? 計算機工程與應用,2019,18(1):23-28.

[3] 楊凱,魏本征,任曉強,等.? 基于深度圖像的人體運動姿態跟蹤和識別算法[J]. 數據采集與處理,2015,30(5):1043-1053.

[4] 鄧益儂,羅健欣,金鳳林. 基于深度學習的人體姿態估計方法綜述[J]. 計算機工程與應用,2019,55(19):22-42.

[5] FISCHLER M A,ELSCHLAGER R A.The representation and matching of pictorial structures[J].? IEEE Transactions on Computers,1973,11(1): 67-92.

[6] DALAL N,TRIGGS B.Histograms of oriented gradients for human detection[C]. Proceedings of International Conference on Computer Vision and Pattern Recognition,2005:886-893.

[7] LOWE D G.Object recognition from local scale-invariant features[C]. Proceedings of the International Conference on Computer Vision,1999:1150-1157.

[8] 李崤河,劉進鋒. 二維人體姿態估計研究綜述[J]. 現代計算機,2019,18(22):33-37.

[9] TOSHEV A,SZEGEDY C.Deeppose:human pose estimation via deep neural networks[J]. IEEExplore,2013,65(8):1524-1531.

[10] PISHCHULIN L,INSAFUTDINOV E,TANG S,et al. Deepcut:joint subset partition and labeling for multi person pose estimation[C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition,2016:4929-4937.

[11] HE K,GKIOXARI G,DOLLáR P,et al. Mask R-CNN[C].? Proceedings of the IEEE International Conference on Computer Vision,2017:2961-2969.

[12] FANG H S, XIE S, TAI Y W, et al. Rmpe: regional multi-person pose estimation[C]. Proceedings of the IEEE International Conference on Computer Vision,2017:2334-2343.

[13] REDMON J,DIVVALA S,GIRSHICK R,et al. You only look once: unified, real-time object detection[J]. Computer Science,2015,45(12):458-467.

[14] LIN T Y, MAIRE M, BELONGIE S, et al. Microsoft coco: common objects in context[C]. European conference on computer vision. Springer, Cham, 2014:740-755.

[15] REN S,HE K,GIRSHICK R,et al. Faster R-CNN: towards real-time object detection with region proposal networks[J].? IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 39(6):1841-1850.

(責任編輯:杜能鋼)

收稿日期:2020-06-25

基金項目:南京工程學院校級科研基金項目(QKJ201803);江蘇省高等學校大學生創新創業訓練計劃項目(201911276050Y)

作者簡介:張劍書(1992-),男,碩士,南京工程學院計算機工程學院助理實驗師,研究方向為視頻圖像處理;楊煉鑫(1998-),男,南京工程學院計算機工程學院學生,研究方向為機器學習;王浩然(2000-),男,南京工程學院計算機工程學院學生,研究方向為圖像處理;樊英澤(1998-),男,南京工程學院計算機工程學院學生,研究方向為爬蟲與數據采集。