自注意力與域適應對抗模板重建方法

賈可 趙錁 曾欣科 賈力 李孝杰

摘? 要:該文提出一種基于卷積神經網絡的模板重建方法,采用殘差學習方式逐級精細化得到重建結果,通過產品圖像與模板的比對完成對工業品的外觀質量檢測。在模板重建過程中,結合自注意力機制的關聯度檢索與編碼融合方式,在保持細節還原效果的同時大幅減少了計算量;并提出域適應對抗學習方法,避免重建過程對缺陷信息的還原,顯著控制了檢測漏報率。實驗結果表明了該方法的有效性與較強適應能力。

關鍵詞:卷積神經網絡;模板重建;缺陷檢測;自注意力;域適應對抗學習

中圖分類號:TP391.4 文獻標識碼:A? ? 文章編號:2096-4706(2020)18-0001-06

Abstract:This paper proposes a template reconstruction method based on convolutional neural network,which uses residual learning method to refine the reconstruction results step by step,and completes the appearance quality inspection of industrial products by comparing product images with templates. In the process of template reconstruction,adopting the self-attention mechanism via relevance retrieval and codes fusion method greatly cuts down the calculation while maintaining the advantage of detail restoration. A domain-adaptive adversarial learning strategy is further proposed to avoid the restoration of defect information in the reconstruction procedure,and significantly control the failure rate of defect detection. The experimental results prove the effectiveness and adaptability of this approach.

Keywords:convolutional neural network;template reconstruction;defect detection;self-attention;domain-adaptive adversarial learning

0? 引? 言

工業品的質量檢測是生產與維保過程中的一個關鍵環節,不僅直接影響到推向市場的合格產品的挑揀與品控,同時也是保證產品在使用過程中滿足有限損耗、保障安全生產運行的重要手段。隨著社會人力成本的提高與技術水平的發展,基于機器視覺方法的自動檢測手段在產品質量檢測中發揮出日益重要的作用,因其智能高效、成本低廉、穩定可靠等優點,在越來越多的領域逐步替代了傳統的人工檢測工藝。為了更好地適應日益提高的工業質量檢測高精度與低誤報現實需求,本文提出了一種結合自注意力機制與域適應對抗學習思想的模板重建方法,具有良好的表現和較高的適應能力。

1? 相關研究

按照所采用計算機視覺技術的不同,機器自動檢測技術大致可分為基于目標檢測與基于模板比對的兩類方法。

隨著以深度學習為代表的人工智能技術近年來的飛速發展,基于目標檢測算法的缺陷提取與質量控制方法引起了眾多研究者與產業人員的關注。基于學術界提出的一系列目標檢測算法模型如Faster R-CNN[1]、YOLO[2]、CenterNet[3]等,不少研究將其應用到具體的產品質量檢測場景中[4,5],以待檢測的產品外觀缺陷作為感興趣的目標區域,算法可對缺陷進行分類與定位。這類方法一般依賴于對帶有缺陷的殘次產品圖像的收集與標注,用監督式方法訓練相應目標檢測模型;這種方式雖然在檢測精度上具有一定的優勢,但在實際生產過程中,殘次品的數量本身相對較少,并且一定時間的數據收集并不能保證獲取到足夠數量與質量的缺陷數據從而充分涵蓋到缺陷外觀與特征的完整分布,因此在具體應用中,尤其是在“工業4.0”強調小批次、個性化生產的背景下,此類方法因采集與標注成本較高、迭代較慢而稍顯笨重。

所以,基于模板比對的缺陷檢測方法又重新引起學界與業界的重視,并在深度學習、人工智能發展的背景下得以完善和提高[6,7]。模板比對方法利用一張或多張不帶缺陷的產品圖像作為模板,將待檢產品圖像與模板進行比較,找出其中不一致的地方并標識為缺陷,該方法能夠提供較好的質量檢測靈活性。但由于產品之間的個體差異,模板比對方法更容易出現將非缺陷區域識別為缺陷的誤報問題,為了降低檢測誤報率,往往需要放寬對圖像差異的評判標準,但這又可能引起不能檢出缺陷的漏報問題。這兩種問題在實際應用過程中相互交織與制約,使得合適的差異評判標準難以抉擇,限制了模板比對方法的現實應用效果。

在汲取兩種機器自動檢測技術經驗的基礎上,本文以彌補兩類方法的弱點為目標,提出了一種以模板比對為基礎,綜合其他技術手段進行提升與改進的質量檢測方法,該方法的主要創新點:

(1)通過模板重建的方式更好地適應產品個體差異,降低檢測誤報率,并在模板重建過程中結合自注意力機制,在保持模板重建的細節還原效果的同時大幅減少了計算量;

(2)針對模板重建中可能引入的漏報問題,提出了域適應對抗學習方法,顯著控制了檢測漏報率;

(3)通過生產與維保環節的兩個具體案例和實驗,證明了該方法的有效性與適應性。

在本文以下部分,第2節中詳細介紹了本文提出的缺陷檢測方法,第3節通過具體實驗以及結果分析對本文方法的有效性進行了驗證,在第4節對本文工作進行了總結與展望。

2? 本文方法

為了降低缺陷檢測的誤報率,本文先利用待檢測圖像重建出一幅同等尺寸的模板圖像,由于模板是針對每一幅待檢測圖像獨立重建的,帶有其個體特征細節,因此能夠有效減少比較差異;為了防止在模板重建過程中,缺陷區域也被重建還原,導致漏檢的風險,本文在重建模型訓練過程中,引入域適應性損失函數與對抗學習機制,使得模型在保留圖像個體細節的同時,對于缺陷區域能夠重建出不帶缺陷的正常效果。在重建出檢測模板圖像后,將待檢測圖像與之進行差分對比,在采用傳統圖像處理的閾值過濾、連通域分析[8]等常規技術手段后,本文方法取得了良好的效果。

2.1? 基于自注意力的模板重建

模板重建方法在工業檢測的應用場景下具有天然的優勢,一方面重建模型的訓練可以僅利用正常產品數據,在一般生產過程中該數據是非常容易獲取的;另一方面重建模型一般可以采用自監督學習方式進行訓練,無需進行額外的人工標注,因此實施成本也很低廉。

圖像重建是機器視覺領域的一個經典問題,在深度學習框架下,如AutoEncoder[9]、VAE[10]、GAN[11]等一系列生成式方法均可用于圖像重建;同時圖像重建可被視作“像素-對-像素”的圖像變換問題,因此適用于這一問題的如圖像分割網絡結構(DeconvNet[12]、U-Net[13]等)也同樣可用于圖像重建。本文的模板重建主框架就以U-Net結構為基礎,并主要在下采樣特征提取、上采樣圖像重建與自注意力殘差補償三個方面進行改進,所提出的模板重建網絡結構如圖1所示。

2.1.1? 下采樣特征提取

針對模板重建問題,本文沒有采用直接通過特征計算還原圖像像素值的方式,而是借鑒殘差學習[14]的思想,將圖像下采樣后再進行上采樣,得到包含圖像低頻成分的粗重建結果,然后再通過特征計算圖像細節的高頻補償,將兩者相加得到精重建結果。這樣有利于降低重建問題的函數擬合難度,從而在更少參數量與計算量的條件下更好地恢復圖像細節,減少比較差異從而降低誤報率。因此,在U-Net結構左翼的下采樣過程中,包含了圖像下采樣與特征下采樣兩個數據流,其中圖像下采樣采取雙線性插值方式,每次將圖像縮小到上一級的1/2尺寸。為了在減少模型的整體計算量的同時保持良好特征提取效果,每一級特征均由上級下采樣特征與本級提取特征兩部分構成,下采樣特征采用3×3尺寸、步長(Stride)為2的卷積計算從上一級特征縮小一半的尺寸;本級特征則從相同尺寸的下采樣圖像中采用3×3卷積提取。這兩部分特征的通道數相同,可拼接為一體的特征張量(Tensor)。在本文的實驗中,如圖1所示均進行了4次下采樣,將原圖最小縮放到1/16的尺寸。

2.1.2? 上采樣圖像重建

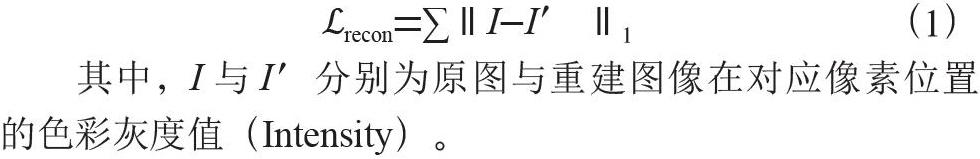

在U-Net結構右翼的上采樣過程中,本文先將下一級圖像采取最近鄰插值方式(采用雙線性插值等上采樣方法的效果亦無明顯差異)放大到2倍大小作為粗重建,然后將殘差補償計算得到的高頻細節與之相加得到精重建結果。重復使用該上采樣過程,最終得到與待檢測圖像尺寸一致的重建模板。在模型訓練過程中,本文采用自監督方法,約束重建圖像與原圖的像素差異盡可能小,并定義重建損失函數:

其中,I與I′分別為原圖與重建圖像在對應像素位置的色彩灰度值(Intensity)。

2.1.3? 自注意力殘差補償

如圖1灰色箭頭所示,在傳統U-Net的殘差補償快捷連接中,一般采用卷積計算的方式從特征計算出高頻細節的補償量,這就要求特征中必須包含能夠完成高頻細節重建的充足信息,因此對特征數量以及特征提取所反映的函數擬合過程提出了較高的要求。圍繞降低模型參數量與計算量的目標,本文借鑒自注意力機制[15]的算法思想,對殘差補償的計算過程進行了優化。

具體來說,對于每一級的殘差補償連接,建立一個q× d的二維鍵(Key)矩陣K,以及一個d×12的二維值(Value)矩陣V,可以將值矩陣V看作一個碼本(Codebook),其中包含了d個編碼,每個編碼具有3×2×2=12個值。鍵矩陣與值矩陣中的變量均作為網絡參數,通過訓練優化求解。從該級的特征出發,首先通過一個3×3的卷積計算將其轉換為具有q通道的查詢(Query)張量Q;其次,將查詢張量與鍵矩陣內積歸一化得到權重(Weight)張量W=softmax(QTK),權重張量中每一位置的d個值反映了這一位置的查詢特征與相應d個鍵特征的關聯度;然后將權重張量與值矩陣內積((WV)T)即加權融合碼本中的d個編碼得到具有12通道的張量。假設其維度為12×h×w(高為h,寬為w),則利用“亞像素卷積[16]”即像素重排可將其轉換為3×2h×2w的殘差張量R,將其與上采樣放大后的彩色圖像相加,這樣的上采樣計算方式可以有效消除如轉置卷積等上采樣計算中存在的棋盤格偽影效應。

經過對比實驗,在碼本數量d=4的情況下,采用自注意力殘差補償方式就已經能夠獲得等同傳統U-Net結構的殘差補償方式重建質量的結果,而查詢特征的長度一般選取在q∈[logd,d]的范圍,在對比實驗中一般直接取為q=d。因此,采用自注意力殘差補償方式能夠有效降低模型的計算量。若采用傳統U-Net的殘差補償方式,假設某級特征的維度為c×h×w,采用3×3卷積計算將其轉換為殘差細節所需的乘加計算(MAC)量為k×k×c×12×w×h,其中k為卷積核尺寸3,以工業應用場景下經過裁剪的特征通道典型數量c=32為例,則為3 456×w×h;而采用上述自注意力殘差補償方式,其乘加計算量:

該計算量約為對比方法的1/3,因此自注意力殘差補償方式在有效節省了模型計算量的同時取得了與對比方法等同的重建效果。

2.2? 域適應對抗學習

在采用模板重建方法進行缺陷檢測的過程中,模型重建能力的增強,也增大了重建出待檢測圖像中的缺陷區域,從而極大地降低了缺陷檢出率的風險。為了解決這一問題,本文提出域適應對抗學習方法。對抗學習方法在生成式對抗網絡GAN領域被廣泛使用,可用作數據分布擬合的重要約束手段,本文對該方法加以改進,以避免對圖像缺陷的重建還原。為了達到這一目的,本文的域適應對抗學習是一種監督式學習方法,因此在訓練圖片存在缺陷的情況下可以進行缺陷區域與類型的圖像分割標注。

首先,本文將重建模板的U-Net網絡作為生成器(Gen-erator),并利用一個ResNet18[14]的深度殘差網絡作為分類器(Discriminator),該分類器以原圖或重建圖像作為輸入。模板重建問題與圖像分類問題不同,更依賴于圖像的局部而非全局信息,因此本文在ResNet18中并未下采樣直至1×1的特征空間尺度,而是僅保留到conv4_x階段,并在此之后直接連接一個1×1卷積層變換為缺陷分類所需特征通道數。在最后得到的分類特征圖中,每一個特征位置均對應了原圖中一個感受野區域(Receptive Field)。利用圖像分割標注結果,若該區域中不存在缺陷,則其分類目標(Ground-truth)為0,否則以缺陷類別號作為其分類目標,這樣的分類結果可以看作一個具有較粗粒度的缺陷分割熱力圖[17]。

其次,按照對抗學習方法可將網絡訓練過程劃分為辨別式階段與生成式階段兩步。在辨別式階段,將原圖傳入分類器進行計算,反傳梯度并更新分類器參數,在辨別式階段訓練分類器時本文采用Focal Loss[18]來緩解類別不均衡問題,并在分類器參數初始化時使其初始分類結果均為0(無缺陷區域顯著多于缺陷區域);因此辨別式訓練階段的損失函數:

其中,t為該位置的分類目標ground-truth,pt為分類正確的概率,∝t為該類別的平衡權重即該類樣本數量的倒數(各類別整體歸一化),超參數γ在本文實驗中依據參考文獻[18]推薦設為2.0。

在生成式階段,首先前向計算U-Net生成器得到重建圖像,將其傳入分類器,在得到的分類結果中將所有位置的目標推向類別0(即無缺陷),此時可采用一般的交叉熵(Cross-entropy),則生成式訓練階段的分類器損失函數:

同時,修正重建損失函數(1)使其忽略缺陷區域的重建誤差:

將分類器損失(3)與重建損失(4)聯合進行多任務訓練,得到總的生成式損失函數:

其中,λ為平衡因子,在本文實驗中直接取作1.0。然后對U-Net與分類器均反傳梯度,但僅更新U-Net的網絡參數,而保持分類器參數不變。通過域適應對抗學習,U-Net網絡最終在重建模板的過程中,對于缺陷區域能夠產生出類似于正常區域的重建結果,從而保障對缺陷的穩定檢出。

2.3? 模板對比與缺陷檢測

在訓練得到模板重建模型并應用模型對待檢測圖像重建出模板后,即可采用傳統機器視覺技術手段進行缺陷檢測。一般來說,首先可將待檢測圖像與重建模板進行絕對值差分,將灰度絕對差大于一定閾值的像素標記為1,否則為0,從而得到二值化圖像;再在該圖像上運用連通域分析方法,過濾掉面積很小的噪聲點,從而得到最終的缺陷檢測結果。在缺陷檢出區域上,還可以進一步應用圖像分類的方法來對缺陷類型進行歸類判定。

3? 實驗結果分析

3.1? 動車線絕緣子狀態巡檢

首先,我們在一個現有的數據集上測試本文算法的效果。該數據集來源于鐵道線晚間巡檢動車拍攝的沿線電路立樁,原圖為4 400×6 600像素尺寸的灰度圖像,采用YOLO算法位出其中高壓線絕緣子后,經過旋轉矯正與縮放裁剪為256×512像素尺寸。數據集共包含500幅圖片,全部帶有絕緣子破損的缺陷,人工標注出576處破損缺陷,隨機選取其中300幅圖片作為訓練樣本,其余200幅留作測試。采用本文前述方法訓練模板重建模型,在PyTorch訓練框架下,優化器選用AdamW[19],初始學習率設置為1e-3,在訓練過程中線性遞減至1e-6,采用了隨機縮放、隨機裁剪、明暗變化的數據增強方式,在100epoch后訓練結束。然后利用該模型對200幅測試圖片進行檢測,選擇48作為灰度絕對差的過濾閾值,連通域分析閾值為50像素,抽取了三個圖例如圖2所示,其中圖2(a)~圖2(c)為測試原圖,圖2(d)~圖2(f)為采用本文方法重建出的模板圖像,圖2(g)~圖2(i)為檢測結果。由于原始圖像拍攝時經常帶有電樁的背景信息,且受型號、角度等因素影響具有較大差異不利于計算機處理,因此該數據集中每幅圖像均有絕緣子區域的mask蒙版信息,用以過濾背景干擾。在模板重建模型訓練過程中也利用了該蒙版信息,可以僅考慮絕緣子區域的重建誤差,所以圖2中重建模板的背景區域會有較強噪聲,我們在進行缺陷檢測時也利用蒙版過濾了背景噪聲,僅對絕緣子區域進行處理。

最終,對于測試集中的200幅圖片通過本文方法均成功檢出缺陷。在測試集中人工標注有234個缺陷區域,本文方法檢出251處缺陷,多報出的缺陷經過人工檢查,主要為兩種情況:其一如圖2(h)所示,同一處缺陷經連通域分析后被分為了多個區域重復報出;其二如圖2(i)圖中左上角白點處,原圖在該位置確實存在一定瑕疵,但標注人員認為其未達到缺陷標準。本文方法在動車線絕緣子狀態巡檢數據集中展現出優秀的效果。

3.2? 口服液瓶蓋質量檢測

上一實驗中一方面絕緣子缺損整體來說面積較大,較為顯著,易于檢出,另一方面該數據集全部為缺陷圖像,難以定量分析本文算法在實際應用中的效果,因此我們進一步在實際案例中驗證本文方法。本實驗數據來源于某口服液廠家在生產線封測環節的圖像采集,目的是對瓶蓋及封裝質量進行外觀檢測,原圖為1 942×2 590像素尺寸的彩色圖像,由于流水線生產夾具位置相對固定,因此直接從原圖中固定區域截取瓶蓋頂視區域并縮放為480×480像素尺寸。數據集共包含39 000張圖片,委托廠家質檢人員進行標注,其中前1 000張采取純人工標注方式,之后隨著本文模型迭代,逐漸過渡為機器初步標注、人工審核修正的半自動標注方式;最終審查出缺陷產品圖片861張,并將缺陷進一步區分為破損、油污、飛邊、夾絲等四種類型。在39 000張圖片收集整理完畢后,隨機選取了7 000幅作為本次實驗訓練數據,其余32 000幅留作測試,測試集中有/無缺陷圖像各為638和31 362幅。模型訓練優化器與學習率設置與上一實驗相同,根據數據特性選擇了隨機角度旋轉、色彩抖動的數據增強方式,在60epoch后訓練結束。測試階段灰度差分閾值設作25,連通域閾值取為20像素,抽取兩個檢測圖例如圖3所示,其中圖3(a)~圖3(b)為測試原圖,圖3(c)~圖3(d)為重建模板,圖3(e)~圖3(f)為檢測結果。

我們隨后對實驗結果進行了定量分析,統計結果如表1所示。在統計過程中,如果一個人工標注的缺陷區域,經過算法檢測后有至少1個像素點被標為缺陷,則計作成功檢出,否則視為漏檢;如果一張人工檢查未標注缺陷的圖像,經過算法檢測報出缺陷,則視為誤檢,否則計作檢出。從統計結果中可見,本文方法在該應用場景中總體能夠達到約97.72%的缺陷檢出率,可成功挑揀出絕大部分缺陷產品;同時該檢測方法僅有不足0.24%的誤檢率,即算法報出缺陷后人工復核確認無誤,該概率極為有限,能夠有效節省生產過程中因算法誤報而浪費的人力成本。其中對于夾絲類型缺陷的檢出率偏低,主要因為絲狀缺陷較細,因此模板比對后檢出區域容易斷開而不連續,進而導致其被連通域分析算法過濾。將神經網絡模型遷移到OpenVINO框架(https://github.com/openvinotoolkit/openvino)下進行部署,在Intel i5-8400(2.8 GHz,6核6線程)CPU上模板重建前向推理時間約28 ms,能夠滿足流水線的生產節拍實時性要求。

最后,針對檢出的缺陷,我們進一步開展了對缺陷分類的驗證。首先取得檢出缺陷最大連通區域的外接矩形框,并以長邊的1.5倍長度將其對稱擴展成正方形區域,將原圖與重建模板同時截取該區域并縮放至224×224像素尺寸,兩者拼接為6通道的數據,輸入一個ResNet18網絡行分類。缺陷分類結果的混淆矩陣如表2所示,從數據中可以觀察到,卷積神經網絡分類模型基本能夠勝任缺陷分類的任務,分類正確率在實際生產使用過程中尚可接受,其中飛邊與夾絲兩種類型的缺陷因在頂視角的2D投影方式下形態較為類似導致更容易區分錯誤,這也與人工的實際操作感受基本相符。

4? 結? 論

本文提出了一種基于模板重建與比對的工業品外觀缺陷檢測方法。在模板重建的過程中,通過結合U-Net圖像變換結構與自注意力機制,從而在有效降低模型計算復雜度的基礎上保持了重建模板中對圖像細節的高度還原,降低了缺陷檢測的誤報率;同時,本文進一步采用域適應對抗學習方法,解決了模板重建可能保留缺陷信息的問題,從而顯著控制了檢測算法的漏報率。一系列驗證實驗均證明了本文方法的有效性與適應性。

但在實驗過程中,仍然存在一定的問題,例如對于細小的缺陷,可能因后續傳統檢測方式的不足而導致遺漏,這些問題有待未來進一步深入研究與探索。

參考文獻:

[1] REN S Q,HE K M,GIRSHICK R,et al. Faster R-CNN:Towards Real-Time Object Detection with Region Proposal Networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[2] REDMON J,DIVVALA S,GIRSHICK R,et al. You Only Look Once:Unified,Real-Time Object Detection [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR 2016),New York:Curran Associates,Inc.,2016:779-788.

[3] ZHOU X Y,DEQUAN WANG D Q,KR?HENB?HL P.Objects as Points [J/OL].arXiv:1904.07850 [cs.CV].(2019-08-25).https://arxiv.org/abs/1904.07850v1.

[4] 顧佳晨,高雷,劉路璐.基于深度學習的目標檢測算法在冷軋表面缺陷檢測中的應用 [J].冶金自動化,2019,43(6):19-22+27.

[5] 岳慧慧,白瑞林.基于改進YOLOv3的木結缺陷檢測方法研究 [J].自動化儀表,2020,41(3):29-35.

[6] 劉村,李元祥,周擁軍,等.基于卷積神經網絡的視頻圖像超分辨率重建方法 [J].計算機應用研究,2019,36(4):1256-1260+1274.

[7] AKAGI M,NAKAMURA Y,HIGAKI T,et al.深度學習重建提高了腹部超高分辨力CT的影像質量 [J].國際醫學放射學雜志,2020,43(1):120-121.

[8] SZELISKI R.計算機視覺——算法與應用 [M].艾海舟,興軍亮,譯.北京:清華大學出版社,2012.

[9] MASCI J,MEIER U,CIRE?AN D,et al. Stacked Convolutional Auto-Encoders for Hierarchical Feature Extraction [C]//Artificial Neural Networksand Machine Learning-ICANN,Switzerland:Springer,2011:52-59.

[10] KINGMA D P,WELLING M.Auto-Encoding Variational Bayes [J/OL].arXiv:1312.6114 [stat.ML].(2014-05-01).http://export.arxiv.org/abs/1312.6114.

[11] GOODFELLOW I J,POUGET-ABADIE J,MIRZA M,et al.Generative Adversarial Networks [J/OL].arXiv:1406.2661 [stat.ML].(2014-06-10).https://export.arxiv.org/abs/1406.2661.

[12] NOH H,HONG S,HAN B.Learning Deconvolution Network for Semantic Segmentation [C]//2015 IEEE International Conference on Computer Vision(ICCV),New York:Curran Associates,Inc.,2016:1520-1528

[13] RONNEBERGER O,FISCHER P,BROX T. U-Net:Convolutional Networks for Biomedical Image Segmentation [C]//Medical Image Computing and Computer-Assisted Intervention – MICCAI 2015,Switzerland:Springer,2015:234-241

[14] HE K M,ZHANG X Y,REN S Q. Deep Residual Learning for Image Recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR 2016),New York:Curran Associates,Inc.,2016:770-778.

[15] VASWANI A,SHAZEER N,PARMAR N,et al. Attention is all you need [C]//Advances in Neural Information Processing Systems 30:31st Annual Conference on Neural Information Processing Systems(NIPS 2017).New York:Curran Associates,Inc.,2017:5998-6008.

[16] SHI W Z,CABALLERO J,HUSZ?R F. Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR 2016),New York:Curran Associates,Inc.,2017:1874-1883

[17] SHELHAMER E,LONG J,DARRELL T. Fully Convolutional Networks for Semantic Segmentation [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(4):640-651.

[18] LIN T,GOYAL P,GIRSHICK R.Focal Loss for Dense Object Detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(2):318-327.

[19] LOSHCHILOV I,HUTTER F. Fixing Weight Decay Regularization in Adam [J/OL]. arXiv:1711.05101 [cs.LG].(2019-01-04).https://arxiv.org/abs/1711.05101v1.

作者簡介:賈可(1983—),男,漢族,四川綿陽人,副教授,博士,研究方向:機器學習、圖像處理;趙錁(1996—),男,漢族,四川南充人,碩士研究生,研究方向:人工智能;曾欣科(1997—),男,漢族,四川達州人,碩士研究生,研究方向:人工智能;賈力(1996—),男,漢族,四川巴中人,碩士研究生,研究方向:人工智能;通訊作者:李孝杰(1981—),女,漢族,山東菏澤人,副教授,博士,研究方向:人工智能、機器學習。