基于雙詞語義增強的BTM主題模型研究

王云云 張云華

摘? 要:針對目前短文本在BTM主題模型建模過程中存在的共現雙詞之間語義聯系較弱的問題,提出一種結合cw2vec詞向量模型的改進BTM主題模型(cw2vec-BTM)。使用cw2vec模型來訓練短文本語料得到詞向量,并計算詞向量相似度。然后通過設置采樣閾值來改進BTM主題模型共現雙詞的采樣方式,增加語義相關詞語的被采樣概率。實驗結果證明,本文提出的改進模型能有效地提高主題模型的主題凝聚度和KL散度。

關鍵詞:短文本;BTM主題模型;詞向量;吉布斯采樣

中圖分類號:TP391.1? ? ?文獻標識碼:A

Abstract:Aimingat the problem of weak semantic relationship between co-occurrence words in the short text in the BTM topic model modeling process,an improved BTM topic model (cw2vec-BTM) combined with the cw2vec word vector model was proposed.This research uses the cw2vec model to train short text corpora to obtain word vectors and calculates the word vector similarity.Then by setting the sampling threshold,the sampling method for co-occurrence words in the BTM topic model is improved,while the sampling probability of semantically related words is increased.The experimental results prove that the improved model proposed in this paper can effectively improve the topic cohesion and KL divergence of the topic model.

Keywords:short text;BTM topic model;word vector;gibbs sampling

1? ?引言(Introduction)

短文本字數少、篇幅小,在分析短文本時,很難準確的挖掘出語義信息。但這些短文本數據反映了人們的日常生活,從中挖掘出有用的信息并應用到實際生活中是非常有意義的。近幾年,短文本挖掘的各項研究均取得較好的成果[1-3]。

Blei等人通過LDA模型提取文本的主題信息[4]。但Hong等人指出文檔太短不利于訓練LDA的情況[5]。針對該問題,Yan等人提出了BTM主題模型來進行短文本建模[6]。BTM通過語料級別詞共現來為短文本建模。Zheng等人針對缺少上下文語義信息的問題,提出TF-IWF和BTM融合的短文本分類方法[7]。張蕓等人用BTM進行特征擴展,然后用擴展的特征矩陣進行相似度計算[8]。

以上改進的BTM方法都沒有考慮到BTM自身存在的雙詞間缺乏語義聯系的問題,因此,本文提出融合cw2vec詞向量模型來改變BTM中的共現雙詞采樣方式的改進模型。

2? ?相關工作(Related work)

2.1? ?BTM主題模型

BTM是在雙詞項集層面上對詞共現建模,是基于整個語料庫的雙詞來學習文本的主題,即對雙詞進行建模,構成了雙詞—主題—詞語的三層結構,可以解決短文本稀疏問題。

設有語料庫L,語料庫L中有一個二元詞組集合|B|,表示語料中所有的詞對,圖模型如圖1所示。表示其中的任一詞對,、分別表示詞對中的詞語,表示詞語的主題,表示主題數目,,表示每篇文檔的主題分布,表示不同主題下的詞分布,兩者皆服從狄利克雷分布。和分別是先驗參數。

2.2? ?cw2vec詞向量模型

cw2vec模型是由Cao等人提出的一種基于n元筆畫的中文詞向量模型[9],是一種基于skip-gram模型的改進模型,cw2vec模型將筆畫信息作為特征,通過使用n-gram筆畫來捕捉漢字詞語的語義和結構層面的信息。

模型具體介紹如下:

(1)詞語分割為字符:為了獲取中文字符的筆畫信息,將中文詞語分割為單個字符。如:大人大、人。

(2)獲取筆畫特征:獲取中文字符的筆畫信息,并將其合并,得到詞語的筆畫信息。如:大:一ノ丶;人:ノ丶;大人:一ノ丶ノ丶。

(3)筆畫特征數字化:將中文筆畫分為五種不同的類型,用數字代表每一種筆畫信息,分別從1到5,如表1所示。

綜合以上四個步驟可得n元筆畫模型。最后將傳統Skip-gram中的詞語替換成詞語的n-gram筆畫特征信息進行訓練,以“霧霾治理刻不容緩”為例,cw2vec模型的總體架構如圖2所示,當前詞語為“霧霾”,上下文詞語為“治理”和“刻不容緩”。

3? ?cw2vec-BTM模型(cw2vec-BTM model)

cw2vec-BTM模型的主要改進思想是使用詞向量模型訓練短文本語料,利用訓練出的詞向量提取出語料中語義相似的詞語,然后結合BTM主題模型參數推理過程,根據詞語間的語義相似度閾值,決定出要在詞袋中添加的語義相似詞語的個數。這樣就可以提高相似詞語在詞袋中被采樣到的概率,增強主題的內聚性,以及主題之間的相異性,提高主題模型的主題聚類效果。主要算法模型框架如圖3所示。

該模型主要有以下幾個特點:第一,引入cw2vec模型訓練詞向量,并計算短文本語料中的詞向量相似度;第二,改進吉布斯采樣方式,添加語義相似度閾值用于模型采樣。

3.1? ?引入cw2vec詞向量模型

為了使本文研究的BTM主題模型中的共現雙詞的語義關聯達到最佳,本節對近幾年研究的幾大詞向量模型進行實驗對比。

(1)模型介紹及實驗設置

實驗的訓練數據采用中文維基百科訓練語料。具體參數設置如表2所示。

2013年,Mikolov等人[10]提出的word2vec實現了兩種模型skip-gram和CBOW,應用最為廣泛。2015年,Chen等人[11]提出了CWE模型,它是一個基于CBOW模型改進的字符級模型。2017年,Su等人[12]通過圖形字符來增強詞的表示,提出基于像素的GWE模型。2017年,Yu等人[13]提出了一個聯合學習詞、字符,以及更加細粒度的部首的方法來學習詞向量的模型,稱之為JWE模型。2018年,Cao等人[9]提出了基于漢字筆畫進行詞語信息捕獲的cw2vec模型。

(2)實驗結果

各模型在中文詞語相似度任務上進行了測評,測評的數據集是wordsim-240和wordsim-296,具體實驗結果如表3所示。

分析表3,可以得出以下幾點結論:

①CWE模型的實驗結果總體上要優于skip-gram和CBOW,這是因為word2vec的兩種模型是以詞為單位進行訓練的,相較于融入了字符級信息進行訓練的CWE模型,語義表示能力較弱。

②GWE和JWE這兩種模型在相似度任務上的表現較不穩定,這可能是由于模型中的像素信息或部首信息是不完整和嘈雜的,影響了模型訓練的穩定性。

③cw2vec模型在整體效果上要優于其他幾種模型,且是通過構造“n元筆畫”和上下文詞語之間的相似性函數,直接為每個詞語學習單個嵌入。在詞語相似度任務上表現最佳。

綜上,本文選取cw2vec模型來對語料中的雙詞進行詞向量訓練,利用余弦距離來度量詞向量的相似度,即和之間的語義距離。如公式(1)所示:

3.2? ?吉布斯采樣方法改進

BTM主題模型是直接對語料庫中所有的共現詞對進行建模。共現詞對就是對文本集語料預處理之后,同一個文檔中的任意兩個而且無序的詞的統稱。吉布斯方法直接采樣共現雙詞不利于短文本的主題聚類。

結合上節的詞向量相似度結果,本節將利用詞向量對主題模型的吉布斯采樣方法進行改進。主要是在每次的吉布斯采樣中,將采樣雙詞的語義距離與語義閾值C進行關系判斷,確定是否對雙詞數量進行擴展,即是否對進行擴展,表示詞對b在主題z下被采樣到的次數。具體如下:

3.3? ?算法描述

根據上節的改進思想,具體的算法流程如下,因為對傳統的采樣過程添加了一些額外的操作,會影響到采樣的平衡性,容易導致最后的主題矩陣值為負,即,此時,如公式(8)所示,直接將主題矩陣值取正,作為最終的主題矩陣值,使吉布斯采樣達到一種平衡穩態。

4? 實驗及結果分析(Experiments and results analysis)

4.1? ?實驗數據及參數設置

實驗數據主要是使用基于python的PySpider框架爬取各大電商網站的冰箱評價,集中于某一類商品評價是為了在測試主題模型的時候,能夠得到主題的大致范圍,便于分析。實驗中我們采集了共500000條評論,采用十折交叉驗證法來處理語料。經過去停用詞、分詞等預處理操作之后的部分實驗數據如圖4所示。

為了能充分證明融合cw2vec模型給主題模型帶來的積極效果,本文同時使用了word2vec進行了對比實驗,為了適應短文本,實驗參數設置如表4所示。

4.2? ?對照實驗及結果分析

(1)實驗測評標準

在評估主題模型時,大多采用主題凝聚度和KL散度這兩個指標。前者主要反映主題的內聚程度,而后者反映主題的差異性。本文具體所用指標如下:

①主題凝聚度

(2)定性評估

首先,隨機抽取冰箱的幾個屬性詞,然后通過cw2vec模型訓練這幾個屬性詞,確定余弦距離值最大的四個詞語,作為相關詞。部分結果展示如表5所示。

由上表可以看出,與中心詞“冰箱”語義相關度較高的有“電器”“家電”;而與“價格”語義相關較高的詞語有“便宜”“劃算”和“實惠”,表中可看出三者的余弦距離值差異很小,符合人們日常用語習慣。證明模型達到實際期望。

(3)定量評估

①不同距離閾值C對詞對采樣數量的對比

由本文前面的內容可知,閾值C決定了詞對的擴展數量。圖5表示在吉布斯采樣過程中,詞對采樣數量隨著閾值C的增長而呈下降趨勢的情況,且C=0時,語料中詞對的數量在左右,C=0.1時,數量增加到,證明基于語義閾值C的詞對數量擴展方式的有效性。

②不同距離閾值C的對比

由本文內容分析可知,最后主題的凝聚度不僅取決于改進模型的詞向量訓練過程,還受到語義閾值C的影響。那么到底閾值C取多少最為合適,我們通過取不同的閾值C來對改進的主題模型進行實驗,取最好的TC值所對應的閾值C為最佳閾值。實驗結果如圖6所示,在主題數量為5時,不同語義閾值C所對應的TC值最穩定。從圖中折線的走勢得出,在語義距離閾值C接近0.4時,所有TC值均呈上升趨勢,總體取得的效果最好。

③主題凝聚度

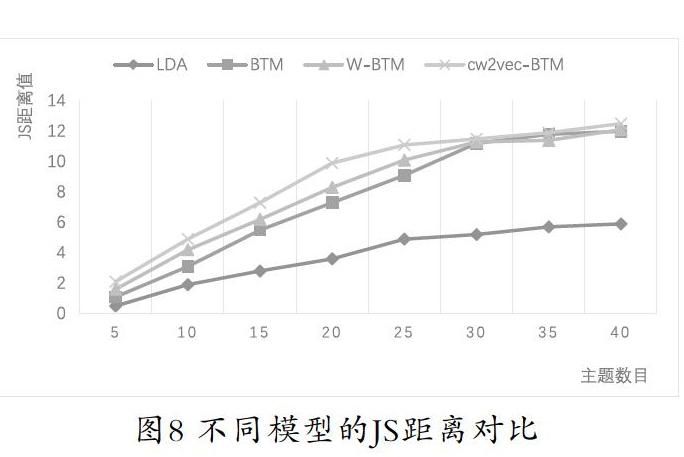

為了驗證改進的主題模型的有效性,我們將其與其他主題模型進行對比實驗,實驗中,先驗參數設置為,,由上節實驗結果得出距離閾值C=0.4。以上三個參數確定后,我們通過評測標準主題凝聚度TC來驗證主題模型的有效性。實驗時,我們將抽取主題數量定為5、10、15、20、25、30、35、40。對比實驗結果如圖7所示。

可以看出,主題數目為5、10時,改進模型與傳統模型的TC值幾乎相同,LDA模型的TC值略低于BTM模型及其改進模型,證明LDA模型不適合處理短文本,主題聚類效果差,所有模型的TC值都隨著主題數量的增加而增長,且不同模型之間的效果區分也越來越明顯;很明顯,融入了詞向量的改進模型的TC值都有所提升,其中結合cw2vec-BTM模型的改進模型的TC值是最高的,主題凝聚效果最好。

由圖8可以看出,BTM及改進模型的效果要優于LDA模型,比較BTM模型和改進模型可以看出,改進模型在主題數為30之前,JS距離值高于BTM模型,但隨著主題數目的增加,JS距離值被BTM反超。出現這種情況可能是由于隨著主題數目的增加,不斷擴展雙詞的數量,導致每個主題中語義相關的詞語越來越多,最終每個主題的內聚性越來越強,但主題之間的差異變得越來越不明顯;比較傳統模型及其改進模型,融入了詞向量后模型的JS距離明顯增大,其中cw2vec-BTM模型的效果最優。

5? ?結論(Conclusion)

針對BTM主題模型建模過程中,語料庫中的詞對之間沒有相互的語義聯系的問題,本文提出了一種改進的BTM主題模型算法,在BTM主題模型的基礎上,借助深度學習的cw2vec模型來訓練詞向量,給共現的雙詞融入更加精準的語義關系。最后,與傳統的LDA和BTM模型、融入word2vec模型BTM模型進行對比,取得了最優的主題聚類效果,證明了本文所提方法的通用性與有效性。

參考文獻(References)

[1] Zhu L,Wang G,Zou X.A Study of Chinese Document Representation and Classification with Word2vec[C].2016 9th International Symposium on Computational Intelligence and Design(ISCID).IEEE,2016.

[2] Ali M,Khalid S,Aslam M H.Pattern Based Comprehensive Urdu Stemmer and Short Text Classification[J].IEEE Access,2017(99):1.

[3] Li P,He L,Wang H,et al.Learning From Short Text Streams With Topic Drifts[J].Cybernetics IEEE Transactions on,2018,48(9):2697-2711.

[4] Blei D M,Ng A Y,Jordan M I,et al.Latent Dirichlet Allocation[J].Journal of Machine Learning Research,2003(3):993-1022.

[5] L.Hong and B.Davison.Empirical study of topic modeling in Twitter,in Proceedings of the First Workshop on Social Media Analytics.ACM,2010:80-88.

[6] Yan X,Guo J,Lan Y,et al.A biterm topic model for short texts[C].Proceedings of the 22nd international conference on World Wide Web.ACM,2013:1445-1456.

[7] Cheng Z,Wenxiu W U,Ning D.Improved short text classification method based on BTM topic features[J].Computer Engineering and Applications,2016,13(52):95-100.

[8] 張蕓.基于BTM主題模型特征擴展的短文本相似度計算[D].安徽大學,2014.

[9] Cao S,Lu W,Zhou J,et al.cw2vec:Learning chinese word embeddings with stroke n-gram information[C].Lousiana:Thirty-Second AAAI Conference on Artificial Intelligence,2018:1-8.

[10] Mikolov T,Chen K,Corrado G,et al.Efficient Estimation of Word Representations in Vector Space[Online].available:http://arxiv.org/abs/1301.3781,September 7,2013.

[11] Chen X,Xu L,Liu Z,et al.Joint learning of character and word embeddings[C].International Conference on Artificial Intelligence.AAAI Press,2015.

[12] Su T R,Lee H Y.Learning Chinese Word Representations From Glyphs Of Characters[C].Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing,2017:264-273.

[13] Yu J,Jian X,Xin H,et al.Joint embeddings of chinese words, characters,and fine-grained subcharacter components[C].Proceedings of the,2017 Conference on Empirical Methods in Natural Language Processing.2017:286-291.

作者簡介:

王云云(1992-),女,碩士生.研究領域:軟件工程技術.

張云華(1965-),男,博士,研究員.研究領域:軟件工程.