基于Scrapy框架京東網(wǎng)站筆記本電腦評(píng)論數(shù)據(jù)爬取和分析

方芳

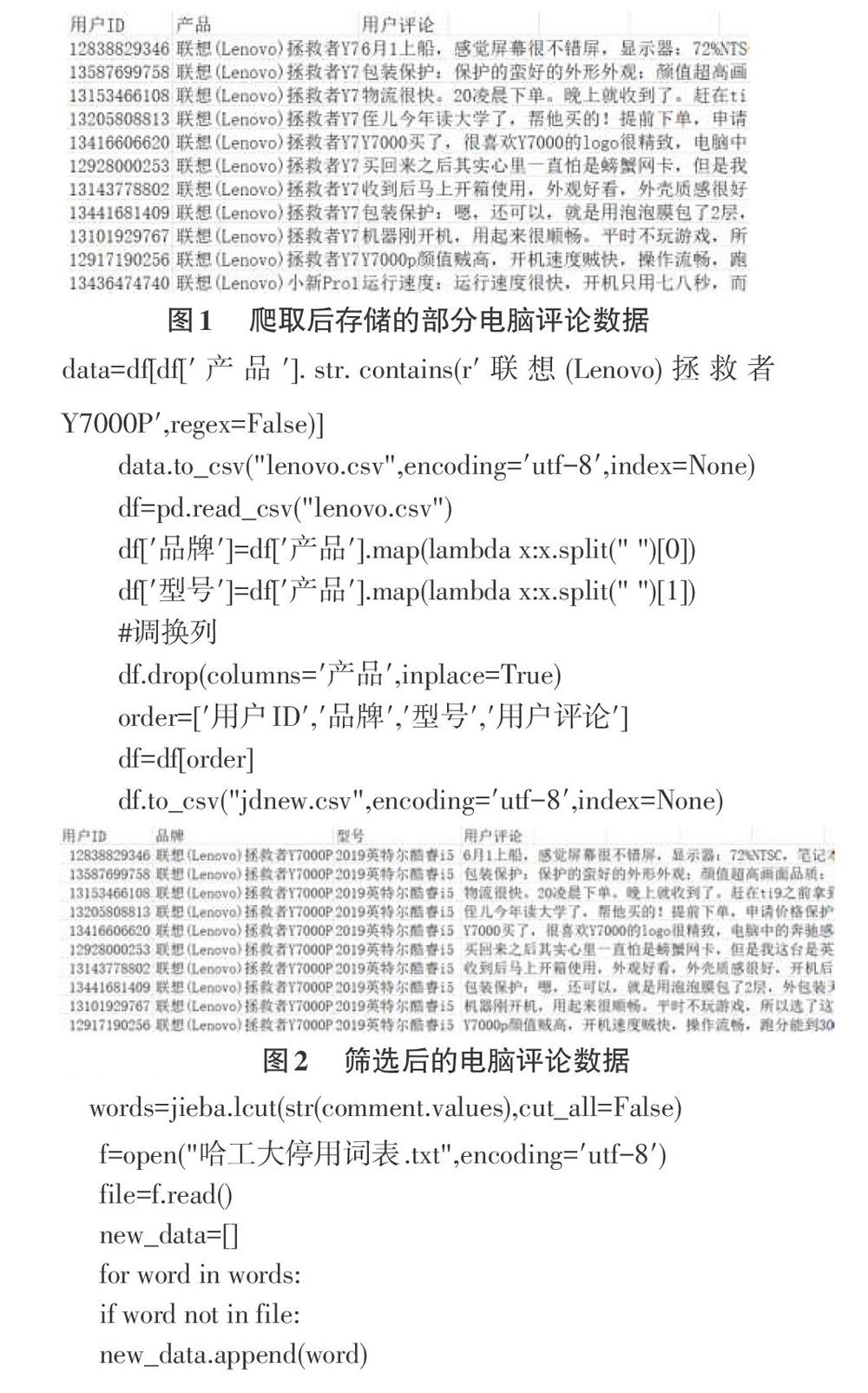

摘要:該文基于Scrapy框架對(duì)京東網(wǎng)站上筆記本電腦的評(píng)論數(shù)據(jù)進(jìn)行了爬取,共爬取了32種品牌,選取其中的“聯(lián)想(Leno-vo)拯救者Y7000P”筆記本電腦評(píng)論數(shù)據(jù)進(jìn)行分析,通過pandas提供的模糊匹配方法提取數(shù)據(jù),并對(duì)數(shù)據(jù)進(jìn)行去重、分詞和停用詞過濾等處理,使用wordcloud庫繪制詞云圖,呈現(xiàn)出的情感數(shù)據(jù)為商家和用戶提供進(jìn)一步的決策。

關(guān)鍵詞:Scrapy框架;Python;數(shù)據(jù)預(yù)處理;數(shù)據(jù)可視化

中圖分類號(hào):TP311 文獻(xiàn)標(biāo)識(shí)碼:A

文章編號(hào):1009-3044(2020)06-0007-03

1背景

1999年底,隨著互聯(lián)網(wǎng)高潮來臨。中國(guó)網(wǎng)絡(luò)購物的用戶規(guī)模不斷上升。2010年中國(guó)網(wǎng)絡(luò)購物市場(chǎng)延續(xù)用戶規(guī)模、交易規(guī)模的雙增長(zhǎng)態(tài)勢(shì)。智能手機(jī)的普及更使得網(wǎng)上購物越來越流行,足不出戶就能買到性價(jià)比高的商品,享受著帶來的各項(xiàng)便利和服務(wù)。

現(xiàn)在人們對(duì)于網(wǎng)上購物的需求變得越來越高,這讓京東,淘寶,蘇寧易購,當(dāng)當(dāng)網(wǎng)等電商平臺(tái)得到了很大的發(fā)展機(jī)遇。從近期的數(shù)據(jù)來看,天貓2017年“雙11”這一天的最終交易額就達(dá)到1682億,創(chuàng)下歷史新高。京東全球好物節(jié)從同年的11月1日到11月11日24時(shí)累計(jì)下單金額達(dá)1271億元。

巨大的交易額將產(chǎn)生大量的用戶評(píng)論數(shù)據(jù),多數(shù)消費(fèi)者熱衷于在網(wǎng)站上留下對(duì)產(chǎn)品的真實(shí)看法和體驗(yàn),很多消費(fèi)者也習(xí)慣于在購買產(chǎn)品之前先瀏覽下用戶的評(píng)論信息,從而幫助自己選擇合適的產(chǎn)品。而各大電商平臺(tái)也面臨著激烈的競(jìng)爭(zhēng)的同時(shí),除了提高商品質(zhì)量,壓低商品價(jià)格外,也需要得到用戶的反饋,而反饋信息可以從商品的評(píng)論區(qū)的文本數(shù)據(jù)信息得到。……

- 電腦知識(shí)與技術(shù)的其它文章

- 企業(yè)數(shù)字化培訓(xùn)存在的問題及對(duì)策研究

- “互聯(lián)網(wǎng)+”的健康醫(yī)療大數(shù)據(jù)應(yīng)用

- 基于聯(lián)盟區(qū)塊鏈的農(nóng)產(chǎn)品質(zhì)量安全高效追溯體系分析

- 三農(nóng)從業(yè)者與領(lǐng)域?qū)<医涣飨到y(tǒng)之肉雞產(chǎn)業(yè)子平臺(tái)的設(shè)計(jì)與實(shí)現(xiàn)

- 增強(qiáng)現(xiàn)實(shí)技術(shù)在移動(dòng)學(xué)習(xí)中的應(yīng)用

- 基于LoRa的多油氣井監(jiān)控系統(tǒng)