基于深度卷積神經網絡的生物醫學混合圖像檢測

張國標 李信 陸偉

摘 要:[目的/意義]通過混合圖像檢測對生物醫學學術文獻里的圖像進行分類,為進一步的生物醫學圖像研究提供支撐。[方法/過程]利用深度卷積神經網絡的經典模型VGG16網絡構建了混合圖像檢測模型,并對VGG16網絡的第1個卷積層的卷積核做了修改,對比了3種不同大小的卷積核的檢測效果。[結果/結論]通過對ImageCLEF2016混合圖像檢測測試數據集的檢測,使用5×5卷積核的VGG16模型的檢測正確率達到97.08%,準確率、召回率和F1值指標均優于對比網絡模型的檢測結果。通過對首層提取的特征圖進行可視化發現,在VGG16網絡中5×5的卷積核相比3×3的卷積核可以提取更多的邊緣特征,更適合混合圖像檢測任務。

關鍵詞:混合圖像檢測;生物醫學圖像;深度卷積神經網絡;VGG16;ImageCLEF2016

DOI:10.3969/j.issn.1008-0821.2020.07.008

〔中圖分類號〕G251 〔文獻標識碼〕A 〔文章編號〕1008-0821(2020)07-0074-08

Biomedical Compound Figure Detection Based on

Deep Convolutional Neural Network

Zhang Guobiao1,2 Li Xin1,2 Lu Wei1,2

(1.School of Information Management,Wuhan University,Wuhan 430072,China;

2.Institute for Information Retrieval and Knowledge Mining,Wuhan University,Wuhan 430072,China)

Abstract:[Purpose/Significance]Compound figure detection is used to classify the images in the biomedical academic literature to provide support for further biomedical image research.[Methods/Process]A classical deep convolutional neural network model of VGG16 was used for compound figure detection in the biomedical article domain.We used the large-size convolution kernel instead of the small-size convolution kernel in the first layer of VGG16 network.[Results/Conclusion]The proposed model obtained a best test accuracy of 97.08% outperforming traditional hand-crafted and other deep learning representations on the ImageCLEF2016 compound image detection dataset.By visualizing the feature map extracted from the first layer,it is found that 5×5 kernel in the first layer of VGG16 network can extract more edge features than 3×3 kernel,which was more suitable for compound figure detection tasks.

Key words:compound figure detection;biomedical images;deep convolutional neural network;VGG16;ImageCLEF2016

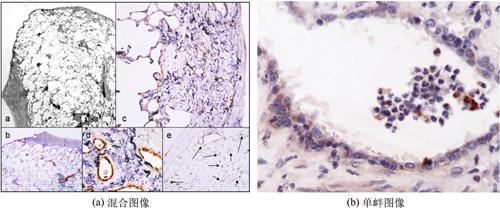

生物醫學圖像在生物醫學文獻中具有重要的地位,往往被視作“解釋現象的圖例”“證明觀點的證據”,是臨床醫生和醫學研究人員重點關注的信息資源[1]。隨著基于內容的圖像檢索和自動標注技術的發展,為醫學圖像的查找利用提供了便利的條件,同時研究發現通過對檢索結果的自動分類和過濾可以有效提升圖像檢索和標注的準確率[2]。然而,在生物醫學文獻中存在著大量的混合圖像(包含2個或2個以上子圖的圖像,如圖1所示),混合圖像包含多個子圖,而且子圖內容差異較大,現有算法無法準確提取其內容特征,這對基于內容的圖像檢索和自動標注等基于圖像內容的研究造成了巨大的阻礙[3]。這就需要我們在將生物醫學圖像存入圖像數據庫時對混合圖像進行檢測,并做進一步的分割,以便后續的研究利用。

深度卷積神經網絡是當代人工智能領域的基礎,不僅在機器視覺領域得到了廣泛應用,而且在文本分類、語音識別等領域中也得到越來越多的青睞。同時,不斷被加深與優化的網絡結構使得深度卷積神經網絡在圖像分類、圖像識別、語義分割、目標定位等任務的處理性能得到不斷提升。本文依據Image Cross-Language Evaluation Forum(ImageCLEF)會議提出的混合圖像檢測任務來對生物醫學文獻中的混合圖像進行檢測,利用深度卷積神經網絡方法實現混合圖像與單圖圖像的自動分類,為進一步的學術視覺資源理解研究提供支撐。

1 相關工作概述

生物醫學混合圖像檢測研究是一個關于生物醫學圖像空間排版組合模式識別及分類的問題,其研究受到機器視覺、深度學習等研究領域的深刻影響。針對這一檢測任務,可將之前的研究歸為兩類:基于傳統特征工程的檢測和基于深度神經網絡的檢測方法。醫學圖像組合分析最初主要采用邊緣檢測、形態學濾波以及構建形狀模型和模板匹配等方法[4]。這類分析方法通常針對特定任務而設計,被稱為手工定制式設計方法。如Taschwer M等[5]分別計算了圖像的像素密度均值、像素密度方差和一維霍夫曼變換3種特征,利用這3種特征來訓練支持向量機分類器,實現了76.9%的正確率。Wang X[6]使用連通域分析和峰值區域檢測兩種方法來提取圖像特征,將決策樹作為分類器,實現了82.82%的正確率。Pelka O等[7]用SIFT關鍵點和邊界輪廓線來表征圖像內容特征,同時結合圖像標題文本信息,使用隨機森林分類器,實現了85.4%的正確率。近年來,隨著深度神經網絡的快速發展,及其在圖像分類和內容識別方面均取得的突破性研究,將深度神經網絡應用于混合圖像檢測已引起了廣大研究者的興趣。隨著深度學習在圖像分類任務的準確率不斷提升,在2016年ImageCLEF混合圖像檢測任務比賽中,研究人員紛紛使用深度學習方法來檢測混合圖像,使得檢測正確率提升到了90%以上。Yu Y等[8]使用LSTM和GRU網絡構建的模型,檢測正確率達到了96.24%。Sheng L L等[9]使用在ImageNet數據集上訓練好的AlexNet、VGG16和VGG19模型,并用混合圖像檢測訓練數據進行微調來提取圖像特征,然后分別使用Softmax和支持向量機來對圖像進行分類,其中VGG16模型正確率達到了96.61%,VGG19模型正確率達到了96.76%,通過對3個網絡的分類結果進行融合得到了96.93%的正確率。

深度學習以數據驅動方式分析任務,能自動地從特定問題的大規模數據集中學習相關模型特征和數據特性。與針對特定問題而顯式地手工設計模型不同,深度學習方法可直接從數據樣本中隱式地自動學習醫學圖像特征,其學習過程本質上是一個優化問題的求解過程。通過學習,模型從訓練數據中選擇正確的特征,使分類器在測試新數據時做出正確決策。因此,深度學習在醫學圖像分析中起著至關重要的作用,已經成為最有前途的研究領域。

2 生物醫學混合圖像內容組合分析

多子圖混合圖像在科學出版中非常常見,使用混合圖像不僅能說明復雜的現象,而且可以提供對比說明[10]。在Pubmed Central數據庫中有40%~60%的論文插圖是混合圖像[11]。生物醫學混合圖像往往由統計圖表、實驗照片、模型圖、影像圖和顯微圖等組成,根據混合圖像各子圖是否屬于同一類型圖,可將混合圖像組合方式分為多模態組合和單一模態組合。

2.1 多模態組合

多模態組合是指混合圖像中的子圖屬于不同的圖類型,如圖2所示。多模態組合的混合圖像各子圖之間有明顯的分割線或空白區域,并且各子圖紋理信息差異較大,傳統手工特征分類模型可以較為簡單地識別出這一特性。針對這一類型的混合圖像可以通過紋理信息來判斷圖像是否是混合圖像。

2.2 單一模態組合

單一模態組合是指混合圖像中的子圖屬于相同的圖類型,如圖3所示。在生物醫學文獻中,這種組合模式經常用來對比說明文獻研究對象不同區域的差異或同一區域的發展變化信息。單一模態組合圖像其各子圖之間內容相似,顏色、紋理、形狀等特征無法對其進行有效檢測,只能利用邊緣信息來辨識各子圖的空間關系。

3 生物醫學混合圖像檢測模型

3.1 深度卷積神經網絡

為更好提取圖像空間結構信息,1989年Lecum Y等[12]提出了一種卷積神經網絡(Convolutional Neural Networks,CNN)。CNN可接受2D或3D圖像塊作為輸入,適于捕獲視覺的局部信息。CNN通常由多個交替出現的卷積層和池化(Pooling)層,以及末端的全連接層構成多層次人工神經網絡,其基本結構如圖4所示。其中,卷積層具有固定的輸入大小,感受局部區域上下文信息,具有權值共享和下采樣的特點,同時具有一定程度的位移、尺度和形變不變性,大大減少了模型的自由度。池化層針對卷積特征圖進行特征降維,通常與卷積層級聯出現。全連接層對池化特征圖進行矢量變換,將輸入的多維矩陣拉伸為一維的特征向量。輸出層是一個分類器,計算圖像的類別概率,將圖像歸類為概率最大的類別。

ILSVRC[13]比賽(Image Net Large Scale Visual Recognition Competition,ILSVRC)極大促進了CNN的發展,不斷有新發明的CNN模型刷新ImageNet成績。從2012的AlexNet[14],到2013年的ZFNet[15],2014年的VGGNet[16]、GoogLeNet[17],再到2015年的ResNet[18],網絡層數不斷增加,模型能力也不斷增強。AlexNet第一次展現了深度學習的強大能力,ZFNet是可視化理解卷積神經網絡的結果,VGGNet表明網絡深度能顯著提高深度學習的效果,GoogLeNet第一次打破了卷積層池化層堆疊的模式,ResNet首次成功訓練了深度達到152層的神經網絡。Sheng L L等[9]使用VGGNet在混合圖像檢測任務上取得了最優的成績,本文同樣選用16層的VGGNet模型來檢測混合圖像。

3.2 基于VGG16的混合圖像檢測模型結構

VGG16網絡是由牛津大學計算機視覺小組提出的深度卷積神經網絡模型,其中包含13層卷積層(Convolutional Layer)和3層全連接層(Full Connected Layer),所有卷積層均使用了3×3的卷積核,并把卷積層進行組合作為卷積序列處理。每層卷積層進行卷積后都采用修正線性單元(ReLU)作為激活函數,每一塊卷積計算結束后,進行最大值池化,聚合特征信息[19]。基于VGG16的混合圖像檢測模型結構如圖5所示,其輸入為224×224×3的彩色圖像,輸出為每個類別的概率。

由于首層卷積層與輸入圖像最近,后續操作都依賴于其輸出,其參數也最為敏感。現有的圖像分類研究傾向于使用更小的卷積核來表征圖像特征,實現更多次的非線性變換,提升網絡的特征學習能力。這一做法是因為在自然圖像中含有較為豐富的紋理信息,運用小尺寸卷積核可以提取到更多的細節變化,可以更好地表征眼睛、頭發等紋理特征。但是混合圖像檢測更注重圖像的空間位置信息,而且在生物醫學混合圖像中存在大量的統計類圖表,圖表內只包含少量線條和文字,大部分區域為空白背景。當使用小尺寸卷積核時,會導致大部分提取到的特征為空,使得傳遞給第2層卷積層的信息較少,信息丟失過快,不能很好地獲得混合圖像的關鍵特征信息。而使用較大尺寸的卷積核可以為后續操作傳遞更多的信息,因此我們對VGG16網絡的首層卷積層進行了修改,使用了更大尺寸的卷積核。

此外,為了提升模型的魯棒性,本文在全連接層添加了Dropout[20]。同時由于ImageCLEF2016數據集相比ImageNet數據集圖像數量小了很多,我們采用了更小的Dropout值進行補償,將Dropout值設為0.5。設置更小的Dropout值可以讓更多的節點權值暫時不工作。這一機制降低了神經元之間的相互適應,一個神經元不能依賴另一個神經元。由于選取了神經元的一個隨機子集,這樣模型會強制學習更好的魯棒的特征。

4 實驗及結果分析

4.1 數據處理

數據集采用ImageCLEF2016醫學任務提供的標準數據集,該數據集中包含混合圖像和單圖圖像兩類數據(如表1所示),其中訓練集包含12 350張混合圖像和8 650張單圖圖像,測試集包含3 456張測試圖像。為了更好地防止網絡的過擬合,對訓練數據集進行了增強處理(如圖6所示),分別對每張訓練圖像進行了內容縮放、垂直反轉、水平反轉和移動處理,將訓練數據集擴大到原始訓練數據集的15倍。

4.2 實驗過程

實驗環境可以概括為Ubuntu16.04+Python3.6,訓練過程使用了顯卡加速。在實驗過程中,使用谷歌開源的深度學習框架Tensorflow1.8構建VGG16網絡并對網絡進行訓練。最小批次設為64,學習速率方法采用了指數衰減法(初始值為0.001每訓練500步衰減5%),迭代次數設為60 000次。

4.3 結果分析

ImageCLEF2016醫學任務將測試正確率被用來作為評價模型好壞的唯一指標,然而正確率并非評價分類性能的最佳指標,本文增加了準確率、召回率和F1值指標,其計算公式如下:

正確率(Accuracy)=正確分類的圖像數測試集圖像數×100%(1)

準確率(Precision)=正確預測的混合圖像數所有預測為混合圖像數(2)

召回率(Recall)=正確預測的混合圖像數測試集中混合圖像數(3)

F1=2×Precision×RecallPrecision+Recall(4)

同時,選取Sheng L L等[9]提出的方法作為對比模型,該模型是目前已知正確率最高的模型。模型檢測結果如表2所示。

實驗結果顯示,5×5的卷積核取得了最好的結果,其正確率為97.08%,為目前已知的最高值。準確率為0.964,召回率為0.9797,F1值為0.9718,各項指標均超過了其他模型,說明的卷積核更適合生物醫學混合圖像檢測。

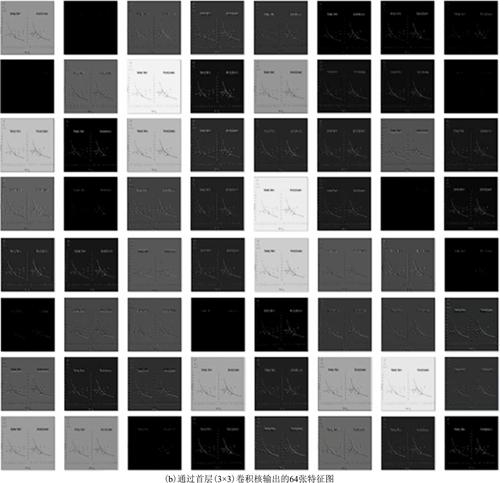

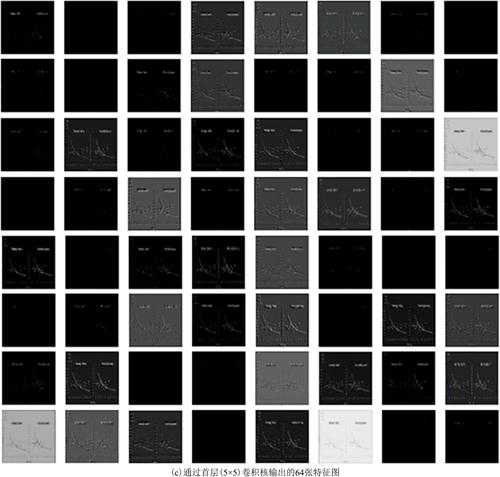

4.4 首層卷積特征可視化

深度學習的黑箱機制使我們很難對分類過程中發生的事情進行推斷。在模型訓練完成后,可以通過對輸入到該模型的圖像所生成的特征進行可視化分析,來理解深度卷積神經網絡的具體操作,以及反向解釋每一層的特征激活函數[21]。本文以圖7(a)作為輸入圖像,通過顯示首層卷積操作后的特征圖以觀察3×3的卷積核與5×5的卷積核對輸入圖像進行卷積操作的差異,并解釋5×5卷積核檢測結果為何優于3×3的卷積核檢測結果。

從圖7(b、c)中可以看出,訓練好的模型正在尋找各種各樣的模式。從第一層卷積層的特征圖中,能明顯地看到統計表的輪廓特征。通過對比圖7(b)和圖7(c),可以發現圖7(c)包含更多黑色的特征圖,說明5×5卷積核提取了更多的邊緣特征,白色背景部位的激活度基本很少。本文通過可視化發現5×5的卷積核相比3×3的卷積核提取到的特征忽視了背景,而是把關鍵的邊緣特征給提取出來了,更加聚焦于分類的核心特征。

4.5 錯誤分類案例分析

檢查模型的輸入和輸出可以幫助我們理解模型分類過程,特別是被錯誤分類的圖像,可以用來檢查模型并解釋什么樣的圖像容易使模型出錯。本文提出的模型預測的分類結果中有101張圖片分類錯誤(錯分案例見圖8),其中有65張是將混合圖像錯分為單一圖像,36張為將單一圖像錯分為混合圖像。65張錯分的混合圖像中有54張為單一組合混合圖像,占比為83.08%,單一組合混合圖像各子圖紋理特征相似,容易被誤判。其中錯分為混合圖像的單一圖像多為統計類圖表、流程圖和網頁或軟件截圖,這些圖中內容之間有明顯的邊界或空白區域。統計類圖表類型多變,圖表旁邊往往伴有被框起來的圖表內容說明信息,這一組合方式容易被誤判為混合圖像。流程圖內部各模塊之間有明顯的邊界,各模塊使用連線連接,在卷積運算過程中連線信息并不容易被捕捉到,這就造成了模塊之間的孤立,從而被錯判為混合圖像。網頁或軟件截圖往往是對多個頁面的截圖或一個頁面內有不同的區域內容,這一特性造成了模型誤判。

5 總 結

科技文獻中包含了大量的未被開發利用的圖像數據資源,這些圖像不僅數量龐大,還有文本描述信息,使其可以被自動地語義索引。學術圖像利用的一個巨大的阻礙就在于混合圖像的存在,多個子圖被整合在一幅圖片中,只被賦予了一個標題。針對學術圖像的研究工作而言,對混合圖像進行檢測并做進一步分割是一個必要的預處理工作。

針對混合圖像檢測問題,我們使用深度卷積神經網絡構建了一種檢測模型,可以自動區分單一圖像和混合圖像。分別對比了3×3、5×5和7×7 3種大小的卷積核,結果顯示5×5的卷積核的檢測效果要優于其他卷積核,正確率達到97.08%。通過對首層提取的特征圖進行可視化發現,5×5的卷積核相比3×3的卷積核可以提取更多的邊緣特征。在分類結果中,單一組合混合圖像、統計類圖像、流程圖和網頁或軟件截圖容易被錯分。雖然該模型是針對醫學圖像開發的,但是可以通過微調訓練遷移到其他科技圖像檢測任務中。在以后的研究中,我們將繼續針對混合圖像進行研究,對其進行分割,并為各子圖生成標題,為混合圖像的檢索利用提供支撐。

參考文獻

[1]Han X H,Y W Chen.Biomedical Imaging Modality Classification Using Combined Visual Features and Textual Terms[J].International Journal of Biomedical Imaging,2011,2011(2011):1-7.

[2]Kalpathy-Cramer J,W Hersh,S Bedrick,et al.Query Analysis to Improve Medical Image Retrieval[C]//Society for Imaging Informatics in Medicine,2008:23-29.

[3]Akgül C B,D L Rubin,S Napel,et al.Content-Based Image Retrieval in Radiology:Current Status and Future Directions[J].Journal of Digital Imaging,2011,24(2):208-222.

[4]丁恒,陸偉,林霞,等.醫學圖像模態特征表達及其比較研究[J].情報學報,2016,35(12):1296-1304.

[5]Taschwer M,O Marques.Automatic Separation of Compound Figures in Scientific Articles[J].Multimedia Tools & Applications,2018,77(1):1-30.

[6]X Wang,X J,H Shatkay,C Kambhamettu.CIS UDEL Working Notes on Image-CLEF 2015:Compound Figure Detection Task[C]//Image-CLEF(Ranking 2nd in the Challenge),2015:298-304.

[7]Pelka O,C M Friedrich.FHDO Biomedical Computer Science Group at Medical Classification Task of ImageCLEF 2015[C]//Working Notes of CLEF 2015-Conference and Labs of the Evaluation Forum,2015:1208-1214.

[8]Yu Y,H Lin,J Meng,et al.Assembling Deep Neural Networks for Medical Compound Figure Detection[J].Information,2017,8(2):48-56.

[9]Sheng L L,M R Zare.Biomedical Compound Figure Detection Using Deep Learning and Fusion Techniques[J].Iet Image Processing,2018,12(6):1031-1037.

[10]Apostolova E,D You,Z Xue,et al.Image Retrieval from Scientific Publications:Text and Image Content Processing to Separate Multipanel Figures[J].Journal of the American Society for Information Science & Technology,2014,64(5):893-908.

[11]Herrera A G I S D,R Schaer,S Bromuri,et al.Overview of the Medical Tasks in ImageCLEF 2016[C]//Clef Working Notes,2016:1096-1104.

[12]Lecun Y,B Boser,J S Denker,et al.Backpropagation Applied to Handwritten Zip Code Recognition[J].Neural Computation,1989,1(4):541-551.

[13]Deng J,W Dong,R Socher,et al.ImageNet:A Large-scale Hierarchical Image Database[C]//Computer Vision and Pattern Recognition,2009:1007-1014.

[14]Krizhevsky A,I Sutskever,G E Hinton.ImageNet Classification with Deep Convolutional Neural Networks[C]//International Conference on Neural Information Processing Systems,2012:1345-1352.

[15]Zeiler M D,R Fergus.Visualizing and Understanding Convolutional Networks[C]//European Conference on Computer Vison,2014:818-833.

[16]Simonyan K,A Zisserman.Very Deep Convolutional Networks for Large-Scale Image Recognition[C]//Asian Conference on Pattern Recognition,2014:818-833.

[17]Szegedy C,W Liu,Y Jia,et al.Going Deeper with Convolutions[C]//Conference on Computer Vision and Pattern Recognition,2014:1-9.

[18]He K,X Zhang,S Ren,et al.Deep Residual Learning for Image Recognition[J].Conference on Computer Vision and Pattern Recognition,2016:770-778.

[19]翁雨辰,田野,路敦民.深度區域網絡方法的細粒度圖像分類[J].中國圖象圖形學報,2017,22(11):1521-1531.

[20]Hinton G E,N Srivastava,A Krizhevsky,et al.Improving Neural Networks By Preventing Co-adaptation of Feature Detectors[J].Computer Science,2012,3(4):212-223.

[21]Olah C,Mordvintsev A,Schubert L.Feature Visualization[EB/OL].https://distill.pub/2017/feature-visualization/,2017-11-07.

(責任編輯:郭沫含)