基于ResNet和RF-Net的遙感影像匹配

廖明哲,吳 謹*,朱 磊

(1.武漢科技大學 信息科學與工程學院,湖北 武漢 430081;2.冶金自動化與檢測技術教育部工程中心,湖北 武漢 430000)

1 引 言

遙感影像包含來自衛星、地面和航空等不同來源的圖像數據,通過對這些圖像進行匹配,可以建立起不同圖像間的空間對應關系,為檢測地球表面環境變化,應用于地質勘測和軍事偵察等領域提供服務。

圖像匹配使來自相同或者不同傳感器、具有不同視角和不同時相的多幅同一場景圖像,在空間上實現幾何對齊[1]。圖像匹配的常用方法可以分為3類:基于灰度和模板的方法、基于域變換的方法和基于特征的方法。其中,基于特征的匹配方法魯棒性好,適用于較多的應用場景[2]。典型的基于特征的方法包括兩部分:帶有屬性的關鍵點檢測和特征描述子提取。

基于特征的深度學習圖像匹配是目前非常重要的匹配技術,在深度學習圖像匹配框架中,有些方法僅用于檢測關鍵點,有些方法僅用于提取特征描述子。關鍵點檢測部分構建響應圖,特征信息豐富的響應圖有利于檢測到更多的關鍵點;特征描述子提取部分端到端地訓練特征描述子[3],特征描述子是用于描述圖像中某個關鍵點的特征向量。關鍵點檢測和特征描述子提取基于不同目標進行優化,兩個部分的增益無法直接疊加,在同一個通道中同時訓練這兩個部分難以取得更好的效果[4]。因此,如何聯合訓練關鍵點檢測和特征描述子提取,使兩個部分彼此更好地協作,是深度學習圖像匹配需要解決的問題。

LIFT[5]是最早實現關鍵點檢測和特征描述子提取聯合訓練的網絡之一,該網絡以尺度不變特征變換(Scale Invariant Feature Transform,SIFT)[6]中特征點所在的圖像塊作為輸入,其關鍵點檢測的效果與SIFT算法類似,魯棒性較好,但無法準確提取邊緣光滑目標的特征點。與LIFT方法不同,SuperPoint[7]采用了自監督訓練的特征點檢測和特征描述子提取方式,通過VGG[8]提取特征,關鍵點檢測部分需要在合成圖像數據集上進行預訓練,且整個網絡也需要在合成變換后的圖像上進行訓練。LF-Net[4]使用Siamense結構[9],無需任何手工方法的幫助,其通過深層特征提取網絡產生特征圖,可從輸入圖像中提取出感受野(特征圖上像素點在輸入圖像上映射的區域)較大的深層特征,但損失了淺層特征。RF-Net[10]在LF-Net的基礎上提出了一個新的基于感受野的關鍵點提取方法,保留了淺層特征,得到信息更豐富的尺度空間和響應圖,在特征描述子提取模塊上采用了與Hard-Net[11]一致的網絡結構,并提出了一個通用的損失函數項,用以解決圖像的剛性變換后,像素點位置偏移所造成的負面影響。

網絡的深度對于學習表征能力更強的特征至關重要,深層特征包含有豐富的語義信息,但隨著網絡深度的增加,會造成梯度消失或者梯度爆炸,以及網絡退化的問題。ResNet[12]為當前應用最為廣泛的CNN特征提取網絡之一,為了解決網絡的退化問題,引入了基本的殘差學習;為了克服梯度消失和梯度爆炸的問題,使用了批歸一化[13],并將激活函數置換為線性整流函數[14]Rectified Linear Unit(ReLU)。具有強表征能力的深層特征可以更好地定位顯著性目標的關鍵點位置,由ResNet獲取的深層特征圖有助于關鍵點的檢測。

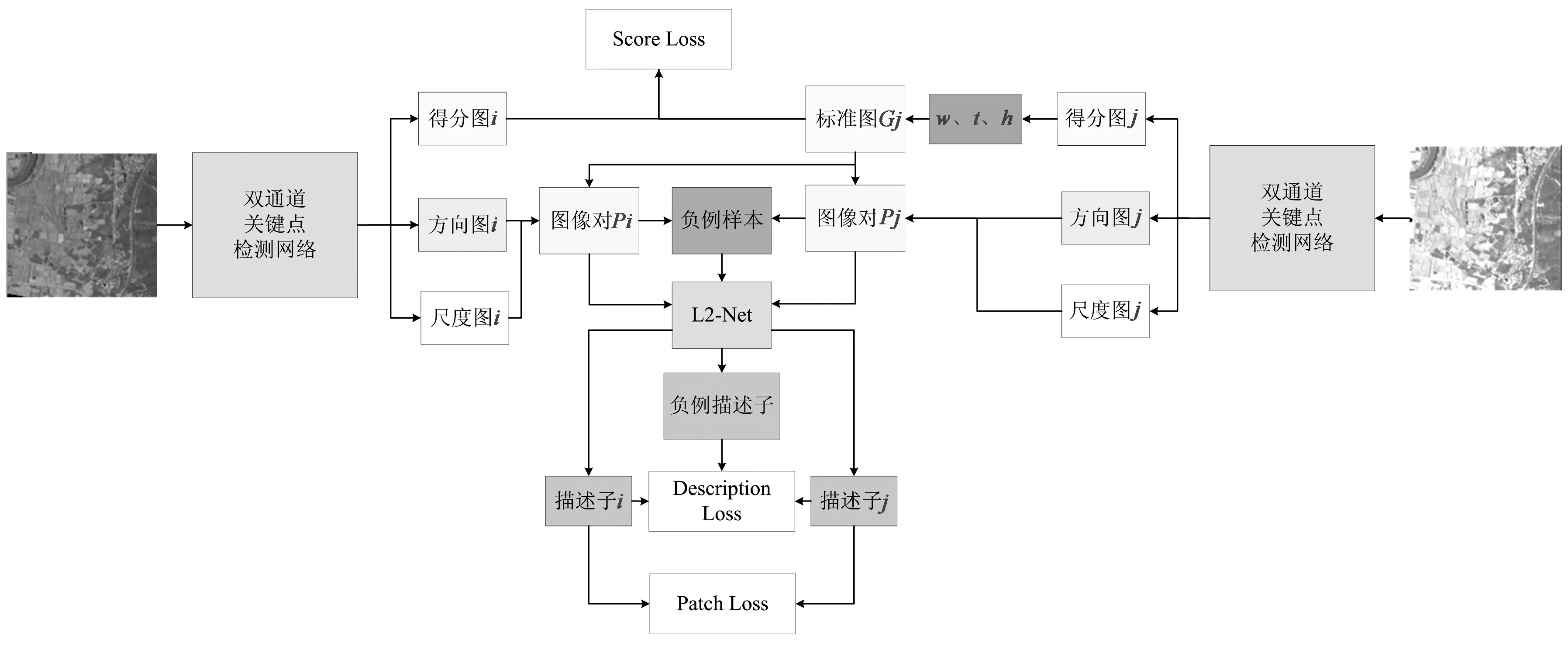

RF-Net采用公共數據集訓練,用于遙感影像匹配時只能檢測到較少的關鍵點,誤匹配率高;且關鍵點檢測模塊中網絡較淺,感受野受限,缺乏高層語義信息。本文基于ResNet和RF-Net提出了一個新的雙通道網絡,用于檢測圖像關鍵點和提取關鍵點的特征描述子。RF-Net的網絡流程如圖1(a)所示,基于ResNet和RF-Net的雙通道網絡流程如圖1(b)所示。通過對真實遙感影像進行光照變換、仿射變換,以及計算不同影像間的單應性矩陣,構建遙感影像匹配數據集,并采用該數據集對網絡進行訓練和測試。

圖1 網絡流程示意圖Fig.1 Diagram of network flow

2 ResNet

ResNet提出殘差網絡結構,采用批歸一化,并將激活函數設置為ReLU,在增加網絡深度的同時,避免了因梯度消失或爆炸帶來的性能下降。本文所提出的改進網絡通過ResNet獲取帶有豐富語義信息的深層特征,能更好地定位圖像中顯著性目標的關鍵點位置。

2.1 殘差學習

隨著網絡層數的增加,整體模型的表征能力更強,但訓練精度反而下降,出現網絡退化問題。殘差學習可用于解決深層網絡普遍存在的退化問題,殘差函數的表達式為:

F(x)=H(x)-x,

(1)

式中,x為網絡的輸入,H(x)為多個非線性網絡層擬合成的基礎映射。

基本的殘差單元可表示為:

yi=xi+F(xi,wi),

(2)

xi+1=g(yi),

(3)

式中,xi、xi+1和wi分別表示第i個殘差塊的輸入、輸出和權重,F表示殘差函數,ɡ表示ReLU激活函數。

由上式可得,網絡層數加深的過程可以表示為:

(4)

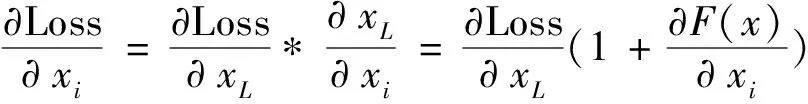

通過損失函數進行反向傳播,從而更新參數。如果損失函數用Loss表示,則有:

(5)

綜上,當F(x)=0時,疊加的非線性網絡層被構造為恒等映射,通過網絡學習到的特征與網絡輸入類似。在實際網絡訓練環境下,即F(x)≠0時,網絡層學習到新的特征,性能更優。

2.2 基于短接的恒等映射

由多個非線性網絡層組成的結構,在輸入和輸出間引入一條直接的關聯通道,使得網絡參數層集中學習殘差,如圖2所示。殘差塊可表示為:

圖2 殘差結構Fig.2 Structure of ResNet

Y=g[F(x,{wi})+x],

(6)

式中,x為網絡輸入,Y為網絡輸出。F(x,{wi})表示所學習的殘差映射,ɡ表示ReLU激活函數。

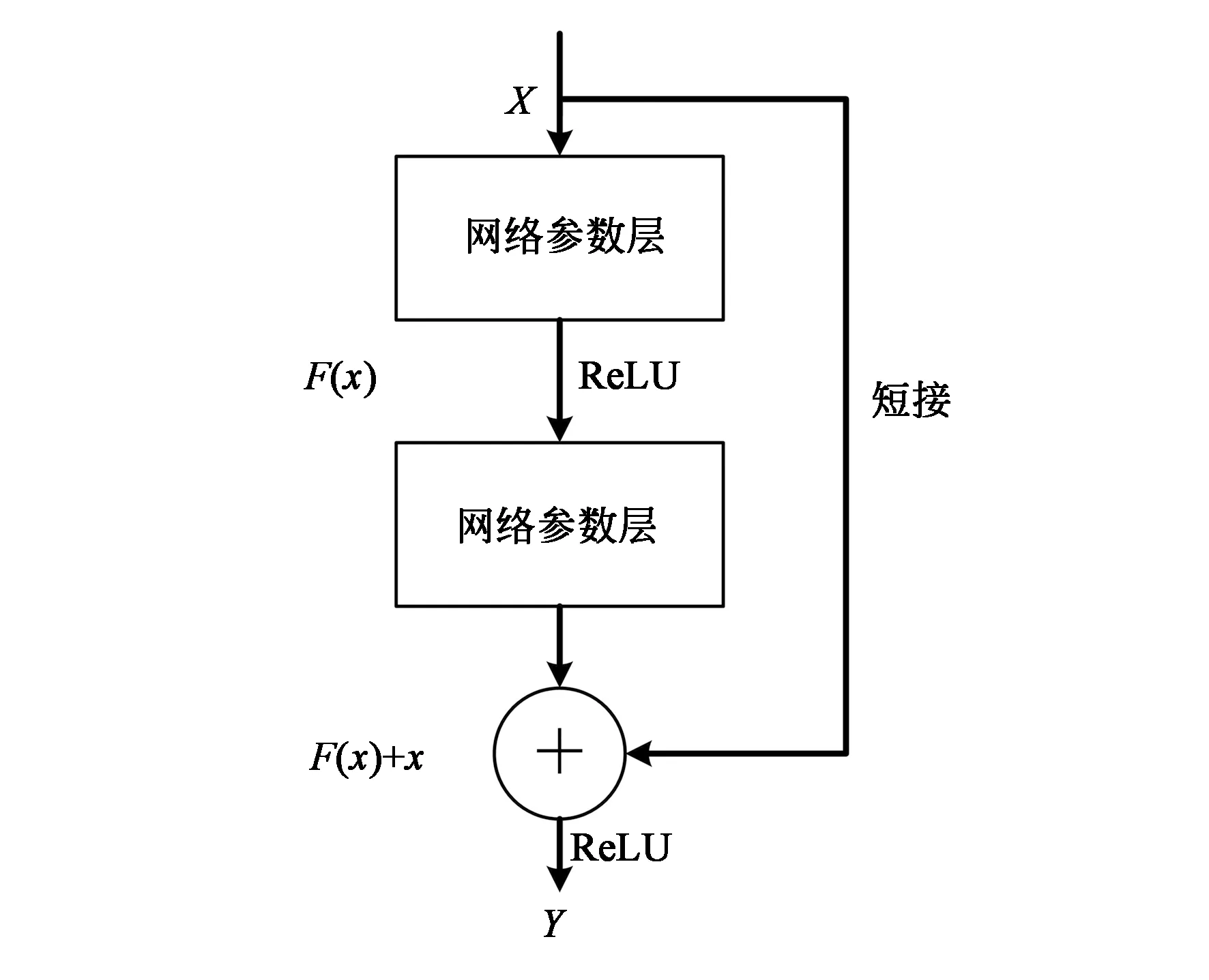

殘差塊的組成較為靈活。圖3(a)為基本殘差塊結構,由兩個網絡層組成;圖3(b)為瓶頸結構,由3個網絡層組成,分別對應1*1、3*3、1*1卷積,其無參數的恒等短接減少了計算參數,可更有效地訓練網絡。

圖3 殘差結構Fig.3 Structure of ResNet

以圖3(a)為例,該殘差塊由2個網絡層組成,即F=w2σ(w1x),σ表示ReLU激活函數,為了簡化結構省略了偏差項。F+x由短接的加法來表示,加法后再進行另一非線性操作。

F與x的維度必須保持一致,可改變x的維度以匹配F。

y=F(x,{wi})+wsx,

(7)

式中,ws表示第s個殘差塊的權重。

本文采用ResNet-50的網絡結構用以提取深層特征,通過圖3(b)中的瓶頸結構搭建整個網絡,其中輸出維度為256,512,1 024,2 048的瓶頸結構的個數分別為3,4,6,5。

3 基于ResNet和RF-Net的網絡

圖4 基于雙通道的網絡框架Fig.4 Network structure of dual-channel

3.1 雙通道網絡結構

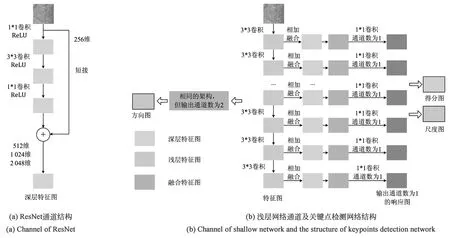

本文的關鍵點檢測部分,采用雙通道的方式構建網絡,兩個通道分別為RF-Det感受野遞增的淺層特征提取通道和ResNet的深層全局信息特征提取通道。前者提取的淺層特征具有豐富的細節信息,后者提取的深層特征包含更具代表性的全局信息。連接兩種不同的特征,提取出最具視覺區分度的特征圖,如圖5所示。第一個通道由3*3卷積、實例歸一化(Instance Normalization)正則函數和ReLU激活函數通過特征金字塔FPN(Feature Pyramid Networks)[16]的卷積方式構成,第二個通道選用ResNet-50。淺層特征和深層特征融合后,對側邊輸出使用1*1卷積和實例正則化函數(Instance Normalization)以生成所需的多尺度響應圖。本文提出的改進網絡得到的響應圖所需感受野較小,但包含豐富的深層語義信息和淺層細節信息,有助于檢測到更多顯著性目標的關鍵點。

圖5 雙通道網絡結構Fig.5 Structure of dual-channel network

3.2 關鍵點檢測

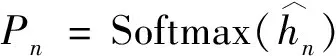

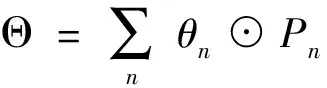

選擇高響應像素作為關鍵點,響應圖hn表示多個尺度上的像素響應,本文設計了一個類似于RF-Net和LF-Net的關鍵點檢測結構。

(8)

(9)

式中,⊙為哈達碼矩陣,Pn表示像素點為關鍵點的可能性[10]。

對于方向圖{θn},其值分別表示方向的sine和cosine,通過arctan函數計算角度。同樣,將θn融合成最后的方向圖Θ。

(10)

(11)

3.3 特征描述子提取網絡

本文采用L2-Net用于提取特征描述子。該網絡由6個3*3卷積層和1個8*8卷積層組成,在卷積層后都會加上ReLU激活函數,并進行批歸一化。描述子提取網絡最后一個卷積層的濾波器尺寸過大,對網絡會造成負擔,但可以獲取包含豐富信息的128維張量,并轉化為特征向量用以描述關鍵點。

3.4 損失函數

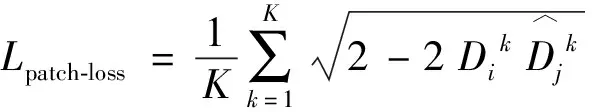

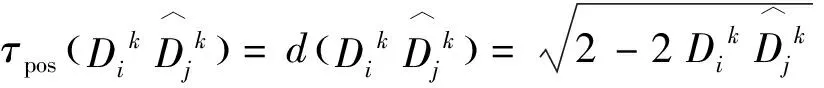

關鍵點檢測網絡對關鍵點的位置、方向和尺度進行預測,其損失函數由得分圖損失(Score Loss)和圖像對損失(Patch Loss)組成。

得分圖損失是指將圖像對Ii和Ij輸入網絡得到得分圖Si和Sj,通過Sj產生參考標準圖像(Ground Truth,GT)Gj,計算Si和Gj間的均方誤差(Mean Squared Error,MSE)。Gj是指從形變后的Sj中提取K個關鍵點,并使用高斯卷積(σ=0.5)得到干凈的GT。

Gj=g[t{w(Sj)}],

(12)

式中,w、t、g分別表示形變,選取關鍵點和高斯卷積的過程,如圖4所示。得分圖損失的計算公式如下:

Lscore-loss(Si,Gj)=|Si-Gj|2

.

(13)

(14)

綜上,關鍵點檢測網絡損失函數為:

Ldet=Lscore-loss+Lpatch-loss

.

(15)

描述子損失(Description Loss)從Hard-Net[11]中引入特征描述子損失函數Ldes,用于最大化距離最近正例和距離最近反例之間的距離,使特征描述子訓練更加穩定。

(16)

(17)

(18)

4 實驗結果

4.1 訓練數據以及評估標準

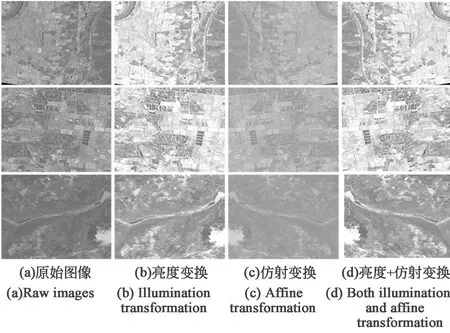

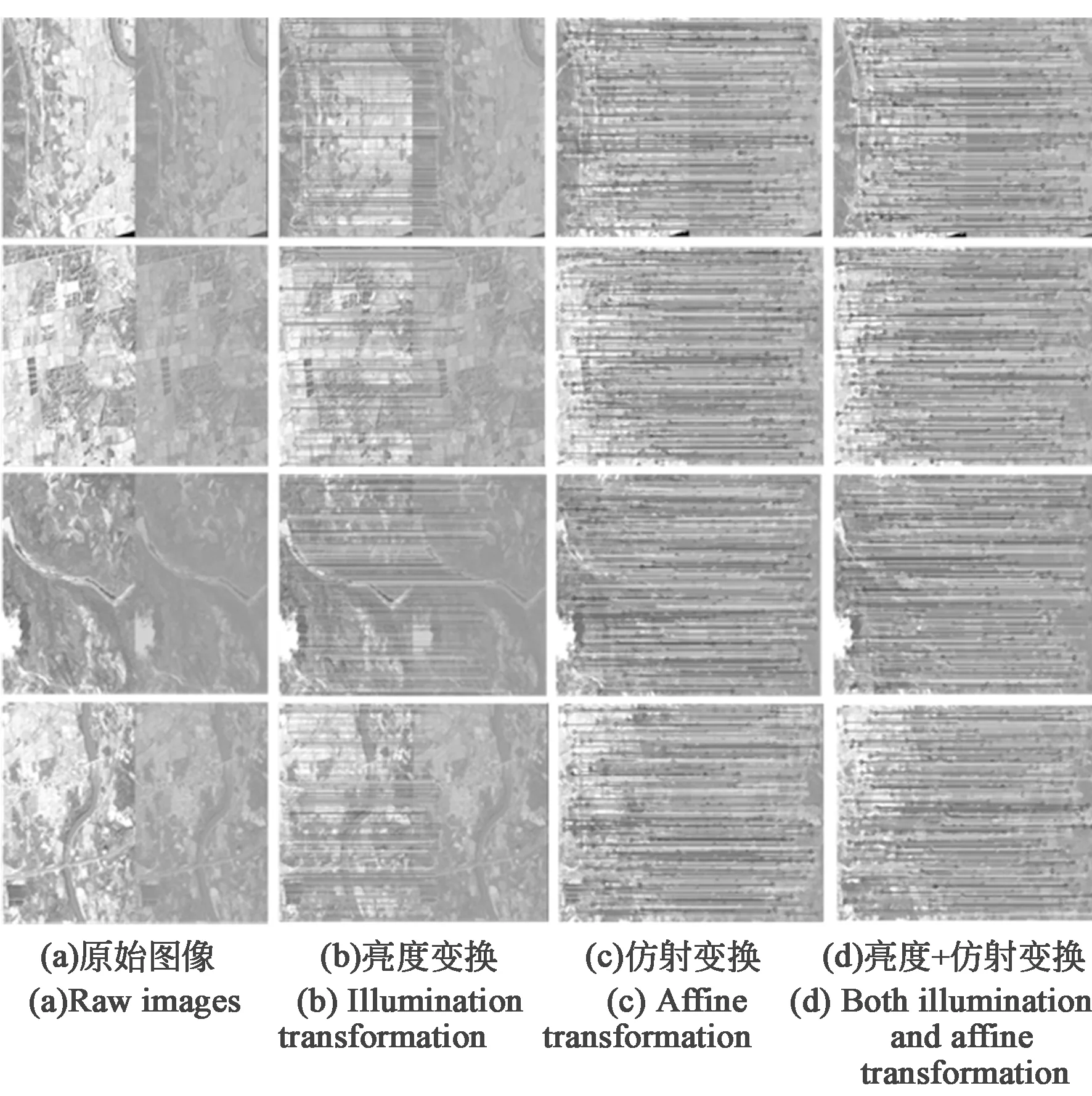

針對現有匹配網絡缺少遙感領域數據進行訓練,造成在遙感影像上測試效果較差的問題,本文構建了一個遙感影像數據集(Remote-B),對真實遙感影像進行裁剪、光照變換和仿射變換,生成了包括亮度變化和視點變化的另外9幅圖像,并計算原始圖像和每幅生成圖像之間的單應性(位置關系)矩陣,所有圖像和單應性矩陣構成了一個序列。數據集Remote-B由56個不同的序列、560幅影像組成,數據集部分圖像如圖6所示。此外,同時構建了僅含光照變換的42個序列、294幅影像的數據集(Remote-illu),以及僅含仿射變換的48個序列、336幅影像的數據集(Remote-view)用于測試。

圖6 遙感圖像數據集部分圖像Fig.6 Part of images in remote sensing images datasets

匹配的標準取決于匹配策略,本文分別采用3種匹配策略,計算匹配分數,用以定量評估[17]。

策略一:最近鄰NN(Nearest Neighbor)。在該標準下,每個描述子只能有一個匹配。兩個區域A和B,當且僅當其描述子DB和DA為最近鄰描述子,A與B匹配;

策略二:帶閾值的最近鄰NNT(Nearest Neighbor with a Threshold)。兩個區域A和B,當其描述子DB和DA為最近鄰描述子且兩者之間的距離小于閾值t時,A與B匹配;

這3種匹配策略用以衡量匹配的精度和關鍵點數量。在訓練過程中,所有學習過的描述子均采用L2正則化,其距離范圍是[0,2]。NNT和NNR的閾值t分別設置為1和0.7。

4.2 訓練過程

本文在構建的遙感影像數據集Remote-B上進行訓練和測試,將數據集按9∶1的比例劃分為訓練集和測試集,500幅遙感影像用于訓練,60幅遙感影像用于測試。

在訓練時,將數據集中遙感影像尺度縮放,修改至320×240,并進行灰度變換。對于描述子提取網絡部分,圍繞關鍵點裁剪32×32尺寸大小影像輸入網絡訓練。在訓練階段,提取K=512個關鍵點,但是在測試階段,可以任選所需的關鍵點數量,通過描述子網絡,得到512個128維特征向量。采用適應性矩估計Adam(Adaptive moment estimation)[18]進行優化,初始學習率設置為0.1,同時訓練兩次描述子網絡和一次關鍵點檢測網絡。

4.3 匹配結果

分別按照SIFT算法、RF-Net和本文改進網絡,對兩幅場景相同、仿射變換不同的遙感影像進行匹配,圖像間關鍵點的正確匹配如圖7所示。

圖7 SIFT、RF-Net及本文改進網絡的匹配結果。Fig.7 Matching result of SIFT,RF-Net,and the improved network proposed in this paper.

RF-Net和本文改進網絡的匹配效果明顯優于傳統的SIFT算法。一方面,從圖中可以直觀看到,RF-Net和本文改進網絡的關鍵點匹配對數明顯多于SIFT算法,深度學習卷積神經網絡具有強大的特征提取能力,有助于圖像中關鍵點的檢測;另一方面,在同一區域內,SIFT算法的關鍵點更為密集,關鍵點距離過近會導致產生的圖像對太相似而出現錯誤匹配,該結果可以驗證稀疏關鍵點的匹配效果更好。

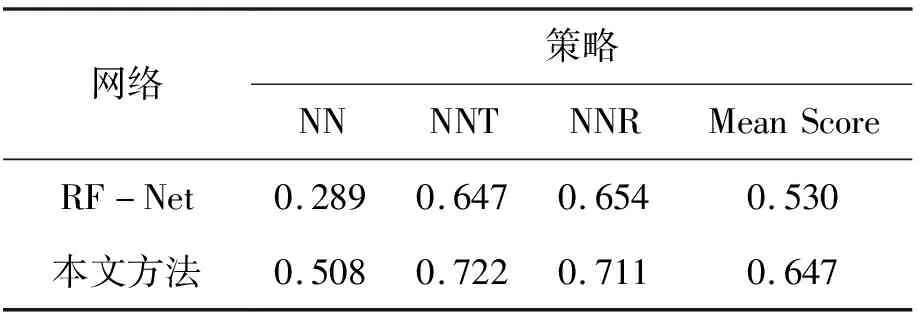

將RF-Net和本文提出的改進網絡,在數據集Remote-B、Remote-illu和Remote-view上分別采用NN、NNT和NNR策略進行匹配。其匹配得分和平均匹配得分(Mean Score)分別如表1、表2和表3所示。

表3 Remote-view測試結果定量分析Tab.3 Test results on Remote-view

由表1可見,在Remote-B遙感數據集中,本文網絡的平均得分比RF-Net高出0.104,匹配精度更高。由表2可見,在Remote-illu數據集中,本文網絡的匹配得分高出0.002,在光照變換條件下本文提出的網絡和RF-Net都取得了較高的匹配精度,但本文網絡的匹配精度略優于RF-Net。由表3可見,在Remote-view數據集中,本文網絡的匹配得分比RF-Net高出0.117,在仿射變換條件下匹配性能提升效果更為明顯。

綜上所述,本文所提出的改進網絡比RF-Net具有更好的關鍵點提取和匹配精度性能,尤其具有更好的抗仿射變換魯棒性能,可以更好地應用于遙感影像匹配。

5 結 論

遙感影像匹配可以將來自不同設備、不同時間和不同角度的影像數據聯系起來,提取更為豐富的信息。基于深度學習的匹配方法,不僅可以提高圖像匹配的準確率,也可以適應復雜應用場景的需求,具有非常重要的研究意義。本文提出了一種基于ResNet和RF-Net的雙通道檢測網絡,用以提取表征能力更強的深層特征,并融合感受野遞增的淺層特征,提高了檢測到的關鍵點數量和匹配的準確率。在與RF-Net的對比實驗中可以看出,本文提出的改進網絡在遙感影像數據集Remote-B、Remote-illu和Remote-view上的匹配得分,分別為0.416、0.966和0.647,對仿射變換具有更好的魯棒性,在關鍵點檢測和匹配精度方面性能更優,可以有效地應用于遙感圖像的關鍵點匹配。