基于改進的3DU-Net的肺結節檢測算法

摘 ?要:針對傳統方法對結節檢測不全,且誤檢率較高的問題,提出了一種改進的3D U-Net肺結節檢測算法。根據肺結節的形態大小特性,將殘差網絡引入3D U-Net網絡框架中,并在3D U-Net的編碼結構里引入了空洞卷積。利用改進的3D U-Net肺結節檢測算法在中南民族大學認知科學實驗室中完成一系列肺結節檢測實驗。實驗結果表明,所提出的算法檢測敏感度達到92.30%,并且降低了誤診率和漏檢率。

關鍵詞:結節檢測;3D U-Net;肺癌

中圖分類號:TP183;TP391.41 ? ? ?文獻標識碼:A 文章編號:2096-4706(2020)12-0066-04

Abstract:In order to solve the problem of incomplete detection and high false detection rate of traditional methods,an improved 3D U-Net lung nodule detection algorithm is proposed. According to the shape and size characteristics of pulmonary nodules,the residual network is introduced into the 3D U-Net network framework,and the hole convolution is introduced into the 3D U-Net coding structure. The improved 3D U-Net pulmonary nodule detection algorithm was used to complete a series of pulmonary nodule detection experiments in the Cognitive Science Laboratory of South-central University for Nationalities. The experimental results show that the accuracy of the proposed algorithm is 92.30%,and the rate of misdiagnosis and missed detection is reduced.

Keywords:nodule detection;3D U-Net;lung cancer

0 ?引 ?言

肺癌是危及人類生命健康的最嚴重疾病之一,其不僅發病率極高,而且死亡率也很高。因此,對肺癌的早期診斷的研究備受學者們的關注。肺癌的早期癥狀表現并不明顯,甚至無癥狀,而輕微癥狀通常僅表現為咳嗽,胸痛,聲音嘶啞等,容易使人與感冒混淆而被忽視。而當肺癌惡化時,患者通常表現為全身發熱、咳血、呼吸困難等,并伴隨著其他疾病的發生,難以治愈,嚴重者會致死。早期肺癌的治愈率為55%,晚期肺癌的治愈率為17%[1]。因此,及時診斷肺癌是治愈肺癌中極其重要的一環。而肺結節作為肺癌的早期表現,檢測肺結節對預測肺癌有重大的意義。

1 ?相關研究

現有的肺結節檢測包括早期的傳統方法和現代的深度學習的方法[2]。傳統的肺結節檢測方法有閾值分割法[3]、區域生長法[4]、形態學方法、聚類法[5]等,主要著力于CT圖像的基本特征來實現目標,但仍然需要具有豐富經驗醫師的人工干預,從而導致這些方法的泛化能力低;然而深度學習方法,特別是基于卷積神經網絡(Convolutional Neural Network,CNN)的肺結節檢測方法,能自動提取胸腔CT圖中大量的圖像精細特征,實現肺結節的有效檢測,滿足了醫學信息處理智能的需求,因此成為肺結節檢測研究領域的重要手段。

2 ?U-Net卷積神經網絡

近年來,深度卷積神經網絡在很多視覺識別任務中皆獲得了卓著的成績。在圖像分類任務方面,圖像的輸出是單個標簽,但在圖像分割領域,任務不僅僅要輸出圖像的類別,還需要輸出定位信息。普通的卷積神經網絡結構在圖像分割領域表現并不好,通常的思路是通過滑窗的方法,根據像素點周圍的像素來對該像素進行分類,但這種網絡要對每個窗體進行訓練,計算量太大,冗余性太高。

2015年,Ronneberger等人[6]以全卷積網絡(Fully Convolu-tional Network,FCN)為基礎架構,提出了U-Net模型。該模型結構包含一個用于捕捉語義的收縮途徑(contracting path)和一個用在準確定位的對稱延伸途徑(expansive path)。收縮路徑是典型的卷積網絡架構,先通過卷積和池化層進行下采樣,每一次下采樣特征圖大小減半,通道數量加倍,對稱延伸途徑是上采樣特征圖放大階段,通過反卷積實現,并且將反卷積的結果與收縮路徑中對應步驟的特征圖拼接起來,最后輸出與原圖尺寸相同的圖片。

普通卷積神經網絡中每一個卷積層的特征圖都由上一層繼承而來,而U-Net中的expansive path則將多級特征組合,使局部信息的準確性與語義的確定同時兼顧成為可能。這一網絡僅使用少量數據,便能夠訓練出一個端對端網絡,而且性能極佳,被廣泛應用于醫學圖像分割領域。

由于在醫學圖像處理領域,立體影像數據是很常見的,比如CT、核磁共振成像(Magnetic Resonance Imaging,MRI)等,而一層一層轉化成2D數據去標注是不現實的,而且用整個3D影像的全部數據去訓練既低效又容易過擬合。

2018年,?I?EK等人[7]首次提出3D U-Net網絡模型,該模型不僅解決了效率問題,而且解決了數據的標注問題,即對塊狀圖分割時不要求數據全部標注,而只需要標注切片中的部分,即可進行立體分割。

由于整個3D U-Net的模型是在之前U-Net(2D)的基礎上創建起來的,因此同樣包含了一個編碼部分和一個解碼部分。編碼部分用來分析三維圖像序列,并進行特征提取與分析,包含四個重復的卷積層,每個卷積層里有兩個卷積塊,一個Batch Norm層和ReLU激活函數,而與之相對應的解碼部分則與編碼階段類似,只是max-pooling換成了反卷積,即下采樣變成上采樣,增加特征圖的尺寸大小,中間的expansive path操作也與2D U-Net相同,最后生成分割好的圖像序列,即三維分割圖像。

3D U-Net同樣采用了數據增強(Data Augmentation)的手段,主要由rotation、scaling和將圖像設置為gray,與此同時在訓練數據上和真實標注的數據上運用平滑的密集變形場(smooth dense deformation field)[8],主要是通過從在一個正態分布的隨機向量樣本中選取標準偏差為4的網格,在每個方向上具有32個體素的間距,然后應用B樣條插值(B-Spline Interpolation)[9],B樣條插值法比較籠統的說就是在原本地形狀上找到一個類似地形狀來近似(approximation)。之后就對數據開始進行訓練,訓練采用的是加權交叉熵損失函數(weighted cross-entropy loss function)以至于減少背景的權重并增加標注到的圖像數據部分的權重以達到平衡的影響小管和背景體素上的損失。

3D U-Net的誕生在醫學影像分割,特別是對于立體圖像(volumetric images)的分割,都是有很大幫助的,因為它很大程度上解決了3D圖像一個個slice送入模型進行訓練的尷尬局面,也大幅度的提升訓練效率,并且保留了FCN和U-Net本來具備的優秀特征。

3 ?改進的3D U-Net卷積神經網絡

肺結節區域檢測是典型的3D小目標檢測。用2D的卷積網絡模型則需要將CT圖以Z軸切片為平面圖,再送入網絡模型中進行訓練(包括切片圖和標注圖),這樣不僅使得預處理過程變得煩瑣,還丟失了CT圖里的Z軸的空間信息,訓練出來的效果也是差強人意。

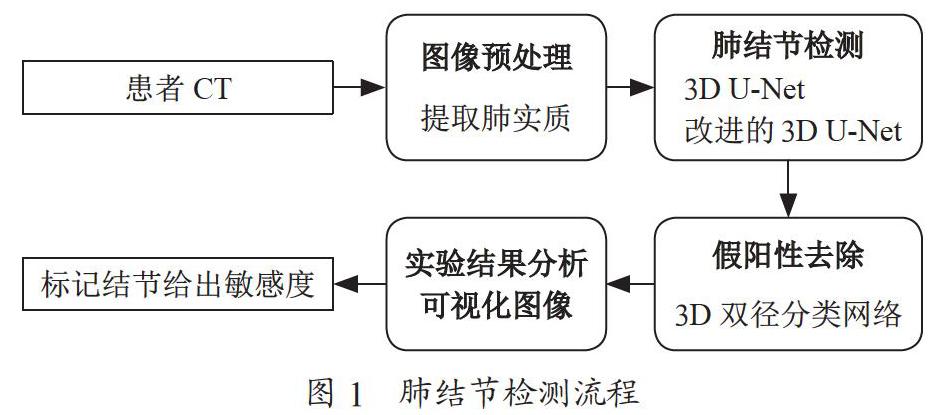

肺結節檢測流程圖如圖1所示,本文先是直接選用了3D U-Net模型進行肺結節檢測實驗,然后選用3D雙徑分類網絡進行假陽性去除,最后對實驗結果進行對比分析,對結果圖像進行可視化研究。采用的數據集是LUNA16,其中,70%用于訓練,15%用來驗證,15%用來測試,采用十折交叉驗證方法進行訓練。基于網絡輸入大小以及硬件條件的限制,這里先將預處理之后的圖片crop成96×96×96大小的cube,裁剪后的結果包含兩部分,70%的立方體是根據標簽來裁剪,但肺結節并不在立方體中心,剩余30%部分是在整個肺部隨機裁剪的。

實驗結果顯示,3D U-Net模型的敏感度達到了89.60%,FROC(Free-Response Receiver Operating Characteristic,FROC)曲線中AUC值為0.91,相較于LUNA16比賽中其他小組的算法,取得了不錯的成績,根據上述分析發現,3D U-Net模型是端對端的U型網絡結構。在收縮網絡部分,包含有卷積核大小為3×3的多個卷積層,且每個卷積層后均連接著修正單元(ReLU)與一個窗口大小是2×2,步長是2的池化層。在池化層的操作下,圖像皆會被下采樣,而每次下采樣都會損失圖像中的信息。在肺部CT圖像中,肺結節的大小通常在2 mm到30 mm之間,屬于典型的小目標。當池化層下采樣的次數越多,圖像信息的丟失就越大,對于小的肺結節目標的特征就幾乎得不到反映了,這樣就會影響模型訓練的結果,造成網絡對小體積結節的檢測遺漏。為此,本文主要針對這些問題改進原有的網絡模型結構。

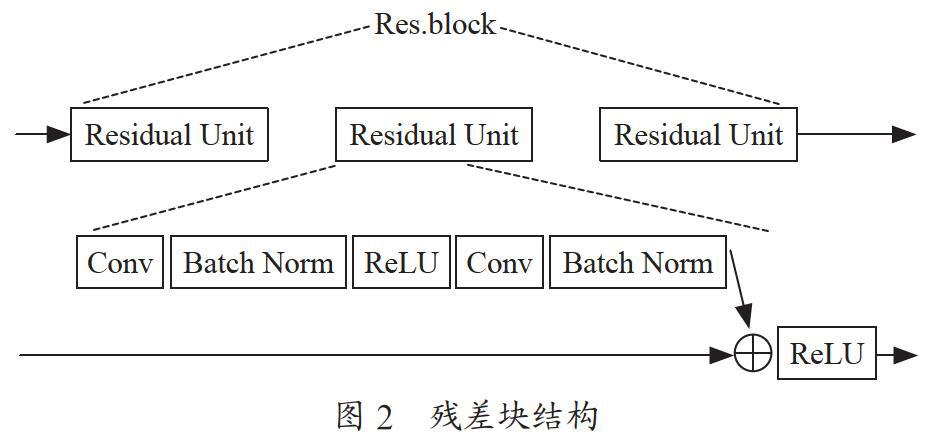

用ResNet網絡[10]替換3D U-Net里的主干網絡,有力聯系了兩個網絡的優點,首先是殘差模型會簡化網絡的訓練,其次是在殘差單元中的shortcut連接和網絡的低層級與高層級二者間會推動信息傳播而不會發生梯度丟失。設計的殘差結構如圖2所示。

每一個殘差塊(Res.block)里包含三個殘差單元(Residual Unit),并在每一個3×3卷積核后面添加了BatchNorm層,進行數據歸一化,提高了網絡穩定性并大幅加快了收斂速度。然后借鑒Deeplab模型[11]的思想,將U-Net里加入空洞卷積層。設計出最終的改進的3D U-Net檢測模型架構圖如圖3所示。

用串行方法構建空洞卷積(Atrous Convolution)結構塊,復制Res.block的最后一個block,如圖3的Res.block4,并把復制后的blocks用串行方法級聯。其中,每個block內存在三個卷積,除了最后一個block,其他的block步長皆是2。其中,定義Multi_Grid=(r1,r2,r3)為block4~block7的三個卷積核的基礎空洞率(unit rates)。卷積核最終的空洞率(atrous rate)等于unit rate與對應的rate的乘積。其中Multi_Grid=(1,2,4)block4中三個卷積層的rate為2,則最終的空洞率分別為(2,4,8),block5中的rate為4,最終的空洞率為(4,8,16),以此類推。此類網絡結構構建的目的,引進的空洞卷積能比較輕易捕捉更深更大區域的信息。而人體內部結構相對固定,引入全局信息能提高檢測的精度,并能有效地降低假陽性。

此外,損失函數用dice_coef_loss概念,其中,兩個區塊的類似程度以DSC代表,A與B代表兩個輪廓區塊所囊括的點的集合,概念見式(1)。

DSC=(A,B)=2|A∩B|/(|A|+|B|) ? ? ?(1)

dice_coef_loss以式(2)呈現,并運用Adam(Adaptive moment estimation,Adam)算法來訓練。

dice_coef_loss=1-DSC ? ? ? ? ? ? ? ? ? ? ? ?(2)

4 ?實驗結果與分析

4.1 ?評估標準

肺結節檢測出來的疑似結節有兩種情況,真性結節和非真性結節(包含假陽性結節和非結節),可以看成是一個二分類問題,真性結節為正樣本,非真性結節為負樣本。為了評估本文提出的改進的3D U-Net檢驗模型的可行性和穩定性,文章使用混淆矩陣來進行模型評估。二分類問題中樣本只能為正類和負類。則檢測出來的會有四種情況:(1)被預測為正的正樣本;(2)被預測為負的正樣本;(3)被預測為正的負樣本;(4)被預測為負的負樣本。這四類情況如表1所示。

肺結節檢驗系統之中,正類也就是標記的肺結節區塊,負類是不包含肺結節區塊在內的區塊。就相當于正樣本數量是定了的,而負樣本是未知的。肺結節檢測第一步主要是為了查全,因此選取的評估標準重點為醫學較為常用的評估標準敏感度(Sensitivity),即數據中肺結節被檢出的占比,即式(3)。

Sensitivity= ? ? ? ? ? ? ? ? ? ? ? ? ? (3)

此外,還有一個評價標準,就是在平均每張CT影像中檢測出的結節的數量(Candidates/Scan)。

4.2 ?實驗結果與分析

本文提出的改進的3D U-Net肺結節檢測網絡在LUNA16和天池醫療AI大賽的數據集進行實驗,皆取得了突出的成效。文章提出的改進的3D U-net網絡與參考文獻[12-15]中提到的相關算法的比較結果如表2所示。

表2中,ISICAD和M5L采用傳統方法,其中人工特征提取的方法候選結節數量很多,3D區域生長法取得了不錯的成績,Xie等和嚴忱君采用的是深度學習的方法,FRCNN和2D U-Net是目前比較流行的肺結節檢測模型。通過表格數據對比,采用3D U-Net模型能較好地分割出肺結節,本文的改進取得了不錯的效果,具有一定的理論和實際意義。

采用國際通用的模型評估標準FROC曲線來驗證該模型的性能,FROC是ROC(Receiver Operating Characteristic curv,ROC)的一個變種,ROC曲線是針對二分類問題的,FROC曲線則對應多目標檢測問題。縱坐標為敏感度Sensitivity,橫坐標為FPPS(False Positives Per Scan,FPPS),即平均每張CT中假陽性樣本的個數,這里設置為FPPS= {0.125,0.250,0.500,1.000,2.000,4.000,8.000},如圖4所示,是本文的算法與LUNA16肺結節挑戰賽中一些小組算法的對比結果。

由表內數據能夠獲悉,文章給出的方式達到了最高的敏感度,而且生成的候選結節的均數最少。由圖可以看出,當FPPS略低時,3D區域生長法、3D U-Net和改進的3D U-Net表現偏好,另外三組的敏感度偏低,當FPPS大于2時,3D U-Net、FRCNN和本文的敏感度都超過了80%,但是當FPPS小于0.500時,其敏感度要低于改進的3D U-Net,綜合來看,本文提出的改進的3D U-Net算法不管是哪個階段,表現力都優于其他幾組。證明了改進的3D U-Net網絡在候選結節檢驗上獲得了突出的成果。

圖5為檢測之后的可視化結果圖,從圖中可以看出肺結節的大小和給出的預測概率,從圖中也可以看出,對于不同形態和大小的結節,用本文提出的檢測算法都能有效的檢測出來。

5 ?結 ?論

本文選用了3D U-Net作為肺結節檢測實驗的神經網絡模型。然后根據肺結節的形態不規則,體積偏小的形態特點,以及實驗訓練過程中遇到的梯度爆炸模型不收斂問題,引入了殘差結構優化了主干網絡,融合空洞卷積加深了U-Net結構里的收斂途徑,獲得了更多的有效的特征信息。最后采用LUNA16數據集用來訓練模型,得到的結果與其他方法進行對比。結果表明,改進的3D U-Net模型在一定情況下具有比其他方法更高的敏感度,即漏檢率更低,能盡可能全的分割出肺結節。

參考文獻:

[1] BROWN M S,GOLDIN J G,SUH R D,et al. Lung Micronodules:Automated Method for Detection at Thin-Section CT——Initial Experience [J].Radiology,2003,226(1):256-62.

[2] 趙清一,孔平,閔建中,等.肺結節檢測與分類的深度學習方法綜述 [J].生物醫學工程學雜志,2019,36(6):1060-1068.

[3] LIAO X L,ZHAO J J,JIAO C,et al. A Segmentation Method for Lung Parenchyma Image Sequences Based on Superpixels and a Self-Generating Neural Forest [J].PLoS One,2016,11(8):e0160556.

[4] 蘇明超,郭書軍.基于區域生長算法的CT圖像肺組織分割 [C]//中國電子學會第十五屆信息論學術年會暨第一屆全國網絡編碼學術年會.中國電子學會第十五屆信息論學術年會暨第一屆全國網絡編碼學術年會論文集(上冊).青島:國防工業出版社,2008:180-182.

[5] CHEN N J,LIU G,Liao Y Y,et al. Research on computer-aided diagnosis of lung nodule [C]//2014 IEEE Workshop on Electronics,Computer and Applications.Ottawa:IEEE,2014:1019-1022.

[6] RONNEBERGER O. Invited Talk:U-Net Convolutional Networks for Biomedical Image Segmentation [C]//Algorithmen-Systeme-Anwendungen.Heidelberg:Springer Vieweg,2017:3.

[7] ?I?EK ?,ABDULKADIR A,LIENKAMP S S,et al. 3D U-Net:Learning Dense Volumetric Segmentation from Sparse Annotation [C]//Medical Image Computing and Computer-Assisted Intervention——MICCAI 2016.Cham:Springer,2016:424-432.

[8] PUJOL A,VILLANUEVA J J,WECHSLER H. Automatic View Based Caricaturing [C]//Proceedings 15th International Conference on Pattern Recognition.Barcelona:IEEE,2000(1):1072-1075.

[9] LEHMANN T M,GONNER C,SPITZER K. Addendum:B-spline interpolation in medical image processing [J].IEEE Transactions on Medical Imaging,2001,20(7):660-665.

[10] HE K M,ZHANG X Y,REN S Q,et al. Deep Residual Learning for Image Recognition [C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:IEEE,2016:770-778.

[11] CHEN L,PAPANDREOU G,KOKKINOS I,et al. DeepLab:Semantic Image Segmentation with Deep Convolutional Nets,Atrous Convolution,and Fully Connected CRFs [J].IEEE transactions on pattern analysis and machine intelligence,2018,40(4):834-848.

[12] MURPHY K,GINNEKEN B V,SCHILHAM A M R,et al. A large-scale evaluation of automatic pulmonary nodule detection in chest CT using local image features and k-nearest-neighbour classification [J].Medical Image Analysis,2009,13(5):757-770.

[13] TRAVERSO A,TORRES E L,BAGNASCO S,et al. B.318-Clinical validation of the M5L lung computer-assisted detection system [J].Physica Medica,2016,32:94.

[14] XIE Y T,ZHANG J P,XIA Y,et al. Fusing texture,shape and deep model-learned information at decision level for automated classification of lung nodules on chest CT [J].Information Fusion,2018(42):102-110.

[15] 嚴忱君.基于機器視覺的肺結節初篩算法研究與實現 [D].杭州:浙江大學,2018.

作者簡介:周晨芳(1995—),女,漢族,湖北孝感人,碩士研究生,研究方向:醫學圖像處理。