基于FC_DenseNet深度學習網絡自動分割肺癌放療中的危及器官

張富利,楊安寧,路娜,蔣華勇,陳點點,郁艷軍,王雅棣

1.解放軍總醫院第七醫學中心放療科,北京100700;2.北京航空航天大學自動化科學與電氣工程學院,北京100191

前言

在放射治療中,醫師基于CT、MRI、PET/CT 圖像提供的信息進行靶區和危及器官(Organs at Risk,OAR)的勾畫,該過程較為費時費力,且勾畫質量很大程度上取決于醫師的經驗[1-2]。由于在CT 圖像上比較容易區分有骨質支撐的器官,而對于腫瘤組織與正常組織相粘連的邊界則較難以區分,這增加了醫師手動勾畫輪廓的難度[3]。即使是同一醫師不同時間對于同一序列CT 圖像的勾畫結果也會存在一定的不一致性[4],這些因素都會影響放療精度和療效[5]。增加勾畫的精度和一致性,提高醫師工作效率是目前醫學圖像分割中亟待解決的問題[6]。

近年來,基于深度學習的圖像自動分割已成為放療領域的研究熱點之一。2015年Ronneberger等[7]針對醫學圖像分割提出了結構上完全對稱的U-Net網絡,整體結構包括了提取圖片特征的編碼階段,以及從壓縮后的特征圖中恢復原圖片尺寸的解碼階段,并且通過長連接將編碼階段和解碼階段相同尺寸的特征圖連接,補充解碼階段的圖像信息。U-Net編碼-解碼對稱的結構成為圖像分割的經典分割框架。同一年,He等[8]提出了ResNet殘差網絡,通過將一些層的學習目標轉化為學習殘差函數,從而使得映射凸顯輸入變化的微小量,緩解了深度增加帶來的梯度消失問題。2017年Huang 等[9]提 出 了DenseNet 網絡,使用特征圖復用的思想以應對監督學習中小樣本的訓練數據,DenseNet 網絡以過渡層連接多個Dense Block,將各個Dense Block 特征圖的通道進行串聯拼接,以增加特征圖的數量,提高特征圖的利用率。

本研究建立起一種基于DenseNet 與全卷積神經網絡(Fully Convolutional Networks, FCN)的深度學習模型FC_DenseNet,通過密集連接的Dense Block模塊學習CT 影像中OARs 平面分布特征,實現端到端的OARs精準勾畫任務。

1 資料與方法

1.1 數據集的構建

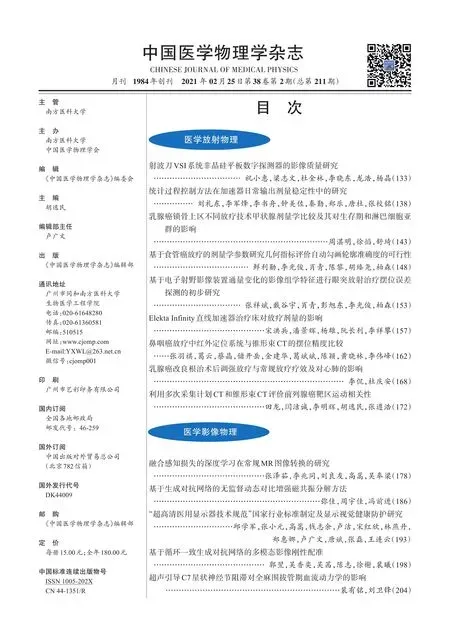

本研究數據集來自解放軍總醫院第七醫學中心放療科的36 例肺癌患者的CT 圖像,通過解析DICOM 文件,將原圖像CT 的灰度值映射到0~255 范圍內,調整窗寬400 和窗位40,改變圖像對比度和亮度[10]。將放療醫師手工勾畫的OARs 輪廓映射到分辨率為512×512 的原圖像上,并根據OARs 鍵值不同,填充不同灰度值,生成掩碼圖作為訓練的標簽,如圖1所示[11]。

圖1 原始圖像和掩碼圖(標簽)Fig.1 Original image and mask map(labeled)

訓練集包括27 例患者的3 803 張CT 圖像,從訓練集隨機抽取大約20%的病例做交叉驗證集,共包括6 例患者650 張圖像,測試集包括9 例患者的567張圖像。經過數據清洗和增強后送入構建好的FC_DenseNet進行訓練。

1.2 FC_DenseNet的網絡設計

本文使用DenseNet56 作為輕量化模型實現肺部4 個危及器官的自動分割,DenseNet56 的具體結構如圖2所示。分割過程主要分為兩部分,左半邊稱為分析路徑,由Dense Block 模塊和Transition down 模塊相互串聯組成,使用Short cut 躍層連接,用以提取圖像特征;右半邊稱為合成路徑,通過Transition up 轉置卷積模塊上采樣,逐層恢復特征圖的尺寸。且將分析路徑中相同尺寸的特征圖相互串聯作為下一層的Dense Block輸入,以提高重構后的圖像精度,加速網絡參數的收斂過程。

圖2 FC_DenseNet結構圖Fig.2 FC_DenseNet framework

Dense Block 每一層的輸入由其前面層的所有輸出經過密集連接后組成(圖3)。每一層的輸入和其他前面層的輸出有以下對應函數關系:

圖3 Dense Block結構圖Fig.3 Dense Block framework

其中,H(*)表示非線性轉化函數,它代表一個組合操作,包括一系列的批標準化(Batch_Normalization,BN)、ReLU(Rectified Linear Units)激活、池化、卷積等操作[12],用來調整特征圖的尺寸大小,減少通道維度。考慮到密集連接的操作會帶來通道數量激增、訓練難度增加的問題[13],在每個網絡中設置Bottleneck 結構,Bottleneck 使用1×1 的卷積核實現跨通道的特征融合,增強網絡的特征提取能力。

Transition Block 連接兩個相鄰的Dense Block,用來調整特征圖大小,通過壓縮因子θ(θ∈[0,1])壓縮特征圖,包含m個特征映射的Dense Block 通過Transition Block 后輸出θ*m個特征映射。上采樣Transition up 模塊與下采樣Transition down 模塊不同,Transition up 對特征圖進行反卷積操作后需要與躍層連接的特征圖進行連接,因此還需要調整躍層拼接的特征圖尺寸。最后將特征圖送入Softmax 函數,網絡Softmax輸出通道數為5的特征圖,像素點所對應的5 個通道數分別代表經過網絡輸出背景和左肺、右肺、心臟、脊髓4個OAR的后驗概率。

將4 個概率中最大的概率類別所對應的灰度值作為該像素點的灰度編碼,形成與訓練真值一致的單通道灰度掩碼圖。將圖像的通道數映射為[0, 1]之間的概率值,選取類別中概率最大的類別作為該像素的類別,填充對應的灰度值,實現逐像素語義勾畫[14]。

1.3 網絡的訓練以及圖像處理

本研究的深度學習框架為PyTorch,Python 版本3.5,處理器為intel corei7 8700,顯卡型號GTX1070ti,內存32 G,考慮到數據集樣本有限,借鑒遷移學習的思想對網絡參數初始化[15],采用He 等[8]提供的卷積初始參數,引入網絡對自然圖像分割的先驗知識,以應對小樣本對于模型訓練效果的限制問題。經過初始權重輸出模型如圖4所示。

圖4 模型初始化Fig.4 Model initialization

每次讀入小批量的樣本mini_batch 作為網絡的輸入,經過數據清洗和增強后送入構建好的FC_DenseNet進行訓練,使用交叉熵損失函數對網絡權重和偏置量進行更新。交叉熵損失函數(Softmax Cross-Entropy Loss),數學表達式如下:

其中,x表示系統的輸入量表示經過網絡回歸后的后驗概率輸出,k表示類別數量。網絡的訓練器選取Adam 優化器。 Adam 優化器使用動量法(Momentum)的梯度累計思想,計算梯度更新的加權平均對網絡進行平滑處理,之后使用RMSProp 阻力法計算梯度累積動量的微分加權平均數更新,使其權重和偏重更新幅度更小,網絡更平穩收斂到全局最優點。有效解決了稀疏梯度和噪聲的問題。

訓練集的平均分割時間為12.576 min/epoch,單幅512×512 CT 圖像的平均分割時間為0.168 s,對一位患者全部CT 圖像進行勾畫的時間約為13.4 s,本研究通過檢測迭代次數增加過程中的網絡準確率和損失函數值,加入了早停(Early Stop)模塊,選取DenseNet56 在第30 代(epoch)左右時的網絡結構,另外網絡訓練過程中設置初始學習率為1e-3,隨著訓練代數(epoch)的增加不斷遞減,一方面保證了網絡在訓練初期能快速收斂,另一方面避免學習率過大導致網絡從訓練集中提取的特征泛化性較差和繼續訓練時帶來的網絡過擬合問題。

圖5 形態學去噪效果前后對比Fig.5 Images before and after morphological denoising

逐像素語義分割的圖像邊緣容易產生毛刺、非連通區域、噪聲;分割的交接區域容易出現像素點交疊的情況。為了使分割圖像的輸出結果更加平滑精確,本文使用形態學去噪的二值形態學進行運算。二值形態學包括收縮圖像邊界的腐蝕操作和填充圖像內部空洞點的膨脹操作,先膨脹后侵蝕構成了閉運算方法以侵蝕孤立點,填補空洞。

本文使用OpenCV 實現形態學去噪,去噪前網絡預測圖如圖5a所示,去噪后的圖像如圖5b所示,可以看到圖像噪聲明顯減少,圖像更平滑。

1.4 分割精確性評價

本文采用Dice 系數、95%豪斯多夫距離(95%Hausdorff Distance, HD95)、平均表面距離(Average Surface Distance,ASD)3個指標評價自動分割結果。并將基于DenseNet56網絡的肺部OAR分割結果與基于ResNet50網絡和U-Net網絡的自動分割結果進行比較。

1.5 統計學分析

采用SPSS 24.0 統計學軟件行ANOVA 單因素方差分析,顯著性水平α=0.05,P<0.05 表示差異有統計學意義。

2 結果

基于DenseNet56網絡的肺部OAR分割結果與基于ResNet50網絡和U-Net網絡的自動分割結果的評價指標Dice、HD95、ASD分別如表1~表3所示。3種網絡的平均分割時間分別為(13.63±2.9)s、(12.86±2.7)s、(12.24±2.6)s,P=0.57。某例患者基于DenseNet網絡OAR自動分割和手動分割結果對比如圖6所示。

3 討論

根據結果可以看到3 種網絡左肺與右肺的分割效果均好于脊髓與心臟,觀察CT 圖像可以看出,左肺與右肺在原始圖像上有明顯的邊界,深度學習網絡比較容易提取邊緣特征。而脊髓與左右肺相比,雖然有骨質結構作為支持,也有明顯的紋理與邊緣區分,但在影像中占的區域面積較少,影像的背景作為負樣本數量遠遠大于脊髓正樣本,正負樣本不均衡導致了脊髓的勾畫精度相對較低。心臟在切片的位置處于中心,其周圍有喉管食管等其他器官,影像中心臟的特征表達能力不強,因此較左肺與右肺分割結果稍差。

表1 3種網絡的Dice指標比較(± s)Tab.1 Comparison of Dice parameter among 3 networks(Mean±SD)

表1 3種網絡的Dice指標比較(± s)Tab.1 Comparison of Dice parameter among 3 networks(Mean±SD)

網絡DenseNet56 ResNet50 U-Net P值脊髓0.89±0.01 0.87±0.03 0.86±0.05 0.255心臟0.84±0.10 0.79±0.15 0.82±0.12 0.752右肺0.93±0.06 0.92±0.09 0.92±0.07 0.904左肺0.97±0.01 0.97±0.01 0.96±0.02 0.141

表2 3種網絡的HD95指標比較(mm,± s)Tab.2 Comparison of HD95 among 3 networks(mm,Mean±SD)

表2 3種網絡的HD95指標比較(mm,± s)Tab.2 Comparison of HD95 among 3 networks(mm,Mean±SD)

網絡DenseNet56 ResNet50 U-Net P值脊髓1.85±0.36 2.03±0.61 2.42±0.66 0.109心臟15.95±16.0 20.31±12.1 18.65±15.2 0.930右肺9.48±5.50 12.8±12.1 13.2±8.99 0.642左肺6.97±3.41 7.16±2.39 9.56±4.62 0.255

表3 3種網絡的ASD指標比較(mm,± s)Tab.3 Comparison of average surface distance among 3networks(mm,Mean±SD)

表3 3種網絡的ASD指標比較(mm,± s)Tab.3 Comparison of average surface distance among 3networks(mm,Mean±SD)

網絡DenseNet56 ResNet50 U-Net P值脊髓0.69±0.13 0.85±0.33 0.86±0.26 0.304心臟6.98±5.55 8.16±6.10 7.52±4.65 0.900右肺1.81±1.61 2.59±3.38 2.55±2.82 0.789左肺1.11±0.51 1.19±0.49 1.72±0.60 0.053

圖6 基于DenseNet網絡自動分割OAR示意圖Fig.6 DenseNet-based autosegmentation of organs-at-risk

在9 例患者OAR 自動分割測試集中,FC_DenseNet 網絡的Dice 指標 與ResNet 和U-Net 相比平均值略微提高,方差較小,表明FC_DenseNet 自動分割效果較為穩定,模型的泛化性能較好。HD95是衡量分割結果最大畸變程度的指標,其大小受到離群點數量的影響,通過觀察分析,9 例測試集患者中FC_DenseNet分割出的圖像連續性更強,產生的離群點較少,HD95與ASD兩個距離指標均優于ResNet與U-Net。由于每例患者的CT 層數并不相同,其分割時間差異性較大,FC_DenseNet 構建的網絡提升了對每一層特征圖的利用率,與ResNet和U-Net網絡相比,DenseNet每例患者的分割時間平均增加1 s左右。根據2017年美國醫學物理家協會(American Association of Medical Physicists,AAPM)年會組織的胸部器官自動分割挑戰賽報告提供的評估基準[16],Dice 值最高的器官是肺部,平均值為0.95~0.98,本研究結果與之較為一致。周正東等[17]提出的帶孔卷積塊U-Net 神經網絡使用了54 個放療病例進行訓練,完成了對肺部OAR 的分割,心臟的平均Dice 系數為0.92,肺部的平均Dice 系數為0.97。由于選用的訓練數據集不同,無法比較該方法與本文方法的優劣。但本文采用的訓練病例數明顯較少,FC_DenseNet在小樣本的訓練中特征提取能力較強,分割結果與較大數據集訓練模型的結果相近。Zhang 等[18]開發了基于ResNet101 卷積神經網絡的自動分割(Automatic Segmentation based on Convolutional Neural Network,AS-CNN)系統,左肺分割平均Dice系數為0.94,心臟平均Dice 系數為0.89,右肺分割平均Dice 系數為0.94,脊髓分割平均Dice 系數為0.82,與該方法相比,本研究使用的模型獲得的脊髓Dice系數為0.89,分割性能上明顯優于AS-CNN,并且本研究使用的是FC_DenseNet網絡的輕量級模型,模型結構更精簡。

Zhu 等[19]提出了一種基于深度卷積的自動分割模型,對肺癌患者的CT 圖像進行分割,模型中使用了帶有3D卷積核的U形網絡,HD95為7.96~8.74 mm,ASD 為1.81~2.92 mm,分割性能明顯優于本研究中的DenseNet 網絡,原因可能是本研究中采用的DenseNet 為2D 模型,所提取的特征序列在空間上的連續性較差所致。

目前深度學習網絡在醫學圖像分割主要有3 個發展方向。第一個方向是不斷加深網絡層級與深度,提取更深層的語義特征以獲得更強的網絡表達能力,或是將網絡展寬增加通道數量,在同一層保證獲得更多的信息例如不同頻率的紋理特征、不同方向上的邊界特征等。第二個方向是通過學習一個病例多個CT 層面的序列關聯性質,以獲得更有效的空間特征提取能力,以3D U-Net為代表,以及其他的諸多衍生網絡。而以DenseNet為代表的第三個方向則是通過將逐層的特征圖共享,提高了特征圖的利用率,以增強圖像的特征表達能力,提高網絡的泛化性能[20]。

本研究結果表明,在OAR 分割任務上,與ResNet50和U-Net分割效果相比,即使訓練集圖像數據較少,FC_DenseNet 仍能有效地防止過擬合的發生,同時將不同層級的特征圖反復疊加利用,在訓練過程中能有效緩解訓練過程中梯度消失的問題,為醫學圖像分割提供了新的思路。