基于神經(jīng)網(wǎng)絡(luò)的裂紋擴(kuò)展過程預(yù)測(cè)

鄭國(guó)君 杜超群 申國(guó)哲 夏陽

摘要:? 提出基于神經(jīng)網(wǎng)絡(luò)的裂紋擴(kuò)展過程實(shí)時(shí)預(yù)測(cè)方法,其計(jì)算效率比近場(chǎng)動(dòng)力學(xué)(peridynamic, PD)模型提高。使用PD算法獲取裂紋擴(kuò)展過程中的損傷云圖,構(gòu)建裂紋擴(kuò)展數(shù)據(jù)集。基于數(shù)據(jù)集構(gòu)建生成對(duì)抗網(wǎng)絡(luò)(generative adversarial networks, GAN)模型,根據(jù)不同加載條件實(shí)時(shí)生成損傷云圖,從而快速預(yù)測(cè)裂紋的擴(kuò)展過程。將PD模型計(jì)算得到的損傷云圖中的RGB值與相應(yīng)位置處的損傷值結(jié)合,構(gòu)建多層前饋神經(jīng)網(wǎng)絡(luò)模型的數(shù)據(jù)庫,并使用多層前饋神經(jīng)網(wǎng)絡(luò)模型分析GAN模型產(chǎn)生的損傷云圖,得到相應(yīng)的損傷值。通過數(shù)值算例證明該方法的效率和準(zhǔn)確性。

關(guān)鍵詞:? 近場(chǎng)動(dòng)力學(xué); 計(jì)算時(shí)間; 生成對(duì)抗網(wǎng)絡(luò); 裂紋擴(kuò)展; 裂紋預(yù)測(cè); 損傷云圖; 前饋神經(jīng)網(wǎng)絡(luò); 損傷值預(yù)測(cè)

中圖分類號(hào):? TP391.99; TB115.1文獻(xiàn)標(biāo)志碼:? B

Prediction of crack propagation process

based on neural network

ZHENG Guojun, DU Chaoqun, SHEN Guozhe, XIA Yang

(State Key Laboratory of Structural Analysis for Industrial Equipment, School of Automotive Engineering,

Dalian University of Technology, Dalian 116024, Liaoning, China)

Abstract: A method of real-time prediction of the crack propagation process based on the neural network is proposed, and the calculation efficiency can be improved compared with peridynamic(PD) model. The damage contours of the crack propagation process are obtained using the PD model, and then the crack propagation dataset is built. Based on the dataset, the generative adversarial network(GAN) model is constructed. The damage contours are generated in real time according to differential loading conditions, thus the crack propagation process can be predicted quickly. The damage value database is built based on the RGB color values and the damage values at the corresponding position from the damage contours generated by the PD model. The damage contours generated by GAN model is analyzed using the multi-layer feedforward neural network model, and then the corresponding damage values are obtained. The efficiency and accuracy of the method are proved by numerical examples.

Key words: peridynamics; calculation time; generative adversarial network; crack propagation; crack prediction; damage contour; feedforward neural network; damage value prediction

收稿日期:? 2021-08-16修回日期:? 2021-10-21

基金項(xiàng)目:? 國(guó)家自然科學(xué)基金(12072065);中央高校基本科研業(yè)務(wù)費(fèi)專項(xiàng)資金(DUT20JC34)

作者簡(jiǎn)介: 鄭國(guó)君(1981—),男,湖北恩施人,副教授,研究方向?yàn)檐嚿斫Y(jié)構(gòu)輕量化,(E-mail)gj_zheng@dlut.edu.cn

通信作者: 夏陽(1987—),男,河南駐馬店人,副教授,研究方向?yàn)榻鼒?chǎng)動(dòng)力學(xué)等數(shù)值模擬方法,(E-mail)yangxia@dlut.edu.cn0引言經(jīng)典連續(xù)介質(zhì)力學(xué)是一種局部理論,其運(yùn)動(dòng)方程基于微分形式進(jìn)行求解,當(dāng)位移不連續(xù)時(shí)無法確定當(dāng)前的運(yùn)動(dòng)方程,因此到目前為止依然難以通過連續(xù)介質(zhì)力學(xué)對(duì)材料中裂紋的形成與擴(kuò)展進(jìn)行準(zhǔn)確預(yù)測(cè)。SILLING等[1-4]提出非局部近場(chǎng)動(dòng)力學(xué)(peridynamics,PD)理論,使用積分形式構(gòu)建運(yùn)動(dòng)方程,實(shí)現(xiàn)材料在多部位萌生并沿任意路徑進(jìn)行擴(kuò)展的計(jì)算。PD理論可以應(yīng)用于線彈性、非線彈性、塑性、黏塑性以及黏彈性等[5-8]材料的行為,同時(shí)也可以應(yīng)用于多晶材料[9]和復(fù)合材料[10]。PD理論的應(yīng)用范圍較廣,但是計(jì)算過程較為復(fù)雜、仿真時(shí)間較長(zhǎng),且模型越大其計(jì)算復(fù)雜度越高,以目前計(jì)算機(jī)的計(jì)算能力無法實(shí)現(xiàn)實(shí)時(shí)的裂紋可視化仿真模擬和預(yù)測(cè)。人工智能、機(jī)器學(xué)習(xí)和大數(shù)據(jù)技術(shù)的發(fā)展,可為實(shí)現(xiàn)裂紋的實(shí)時(shí)可視化模擬和預(yù)測(cè)提供切實(shí)可行的方案。自GOODFELLOW等[11]提出生成對(duì)抗網(wǎng)絡(luò)(generative adversarial networks, GAN)以來,由于GAN生成的圖片效果好,吸引大量學(xué)者進(jìn)行研究。借助GAN對(duì)輸入響應(yīng)迅速的優(yōu)點(diǎn),使用神經(jīng)網(wǎng)絡(luò)生成可視化的圖片結(jié)果,可以實(shí)現(xiàn)對(duì)裂紋擴(kuò)展過程的實(shí)時(shí)模擬。如RADFORD等[12]提出深度卷積GAN(deep convolutional GAN, DCGAN),使用反卷積層替代全連接層,可提升生成圖像的質(zhì)量;MIRZA等[13]提出條件GAN(condition GAN, CGAN),對(duì)GAN增加條件約束,使得生成結(jié)果更具有方向性;ARJOVSKY等[14]提出的WGAN(wasserstein GAN,WGAN)與GULRAJANI等[15]提出的WGAN-GP可改善GAN訓(xùn)練不穩(wěn)定容易出現(xiàn)模型崩潰的現(xiàn)象,使得GAN的訓(xùn)練過程更加穩(wěn)定;近年來ACGAN[16]、StackGAN[17]以及BigGAN[18]等結(jié)構(gòu)的提出更是逐漸提升GAN的生成質(zhì)量,同時(shí)也使得GAN獲得更廣泛的應(yīng)用。在PD領(lǐng)域,KIM等[19]基于PD理論,使用卷積神經(jīng)網(wǎng)絡(luò)對(duì)受到撞擊后磁盤的裂紋擴(kuò)展結(jié)果進(jìn)行預(yù)測(cè),但是依舊需要后處理軟件對(duì)生成結(jié)果進(jìn)行可視化處理后才能觀察裂紋的擴(kuò)展情況。此外,NGUYEN等[20]通過神經(jīng)網(wǎng)絡(luò)擬合物質(zhì)點(diǎn)的位移與施加載荷之間的線性關(guān)系,將機(jī)器學(xué)習(xí)與PD進(jìn)行耦合,從而降低計(jì)算的時(shí)間消耗;計(jì)算包含4×104個(gè)物質(zhì)點(diǎn)的模型時(shí),可在每個(gè)時(shí)間步內(nèi)降低約15%的時(shí)間消耗,但依舊難以實(shí)時(shí)得到可視化的裂紋擴(kuò)展結(jié)果。本文使用PD算法對(duì)預(yù)制裂紋板在指定條件下進(jìn)行仿真模擬,獲取大量的損傷云圖并構(gòu)建數(shù)據(jù)集,使用該損傷云圖數(shù)據(jù)集對(duì)基于圖像數(shù)據(jù)驅(qū)動(dòng)的GAN模型進(jìn)行訓(xùn)練。基于該GAN模型,將載荷和加載時(shí)間步作為輸入,在無須后處理軟件的情況下,生成相應(yīng)的預(yù)制裂紋板損傷云圖,實(shí)現(xiàn)對(duì)裂紋擴(kuò)展過程的實(shí)時(shí)可視化模擬和預(yù)測(cè)。同時(shí),基于BP神經(jīng)網(wǎng)絡(luò)[21]擬合損傷云圖的RGB顏色值與其相應(yīng)的損傷值之間的函數(shù)關(guān)系,實(shí)現(xiàn)RGB顏色值信息到損傷值信息的預(yù)測(cè)。

1理論基礎(chǔ)

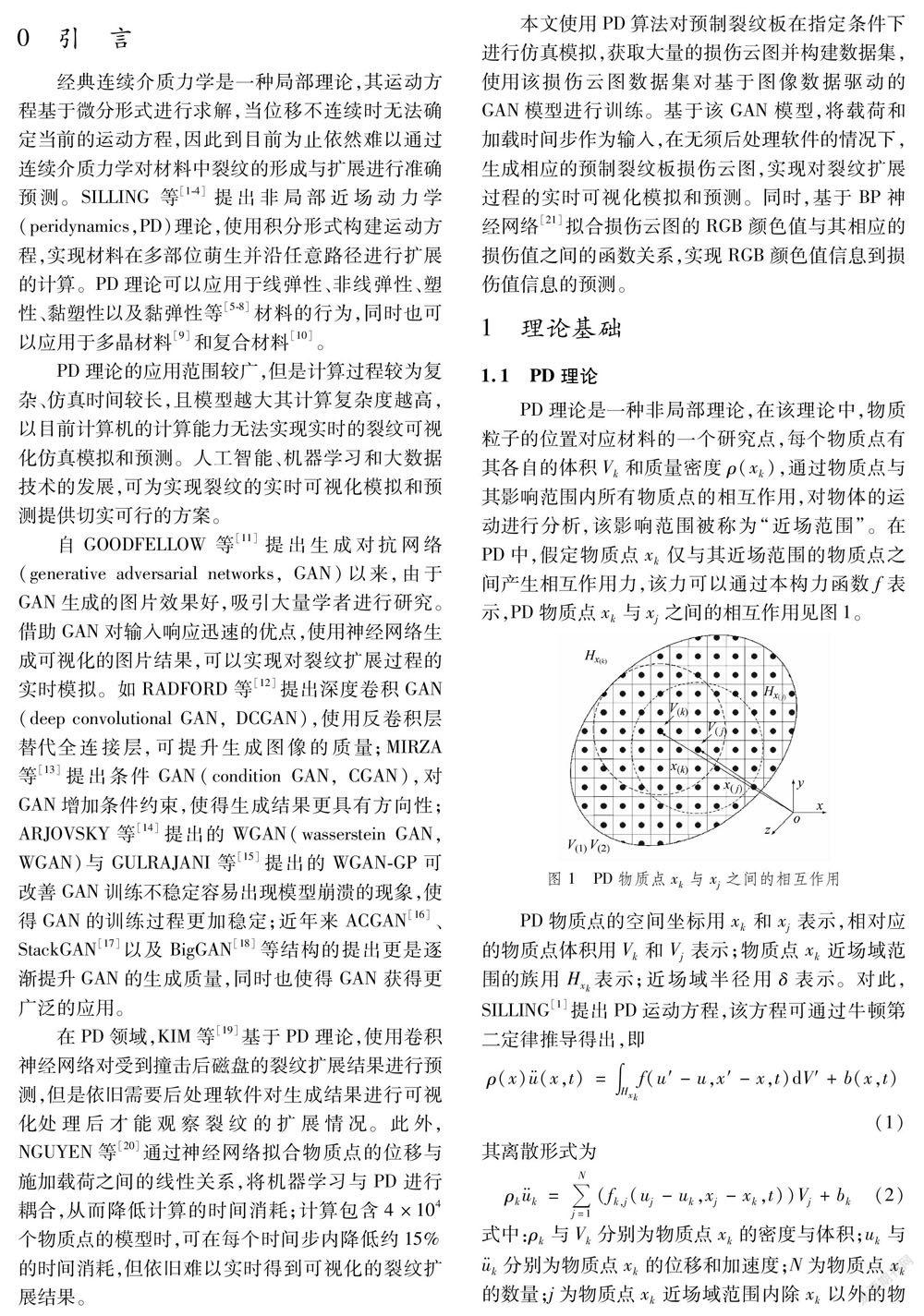

1.1PD理論P(yáng)D理論是一種非局部理論,在該理論中,物質(zhì)粒子的位置對(duì)應(yīng)材料的一個(gè)研究點(diǎn),每個(gè)物質(zhì)點(diǎn)有其各自的體積Vk和質(zhì)量密度ρ(xk),通過物質(zhì)點(diǎn)與其影響范圍內(nèi)所有物質(zhì)點(diǎn)的相互作用,對(duì)物體的運(yùn)動(dòng)進(jìn)行分析,該影響范圍被稱為“近場(chǎng)范圍”。在PD中,假定物質(zhì)點(diǎn)xk僅與其近場(chǎng)范圍的物質(zhì)點(diǎn)之間產(chǎn)生相互作用力,該力可以通過本構(gòu)力函數(shù)f表示,PD物質(zhì)點(diǎn)xk與xj之間的相互作用見圖1。

PD物質(zhì)點(diǎn)的空間坐標(biāo)用xk和xj表示,相對(duì)應(yīng)的物質(zhì)點(diǎn)體積用Vk和Vj表示;物質(zhì)點(diǎn)xk近場(chǎng)域范圍的族用Hxk表示;近場(chǎng)域半徑用δ表示。對(duì)此,SILLING[1]提出PD運(yùn)動(dòng)方程,該方程可通過牛頓第二定律推導(dǎo)得出,即ρ(x)u··(x,t)=∫Hxkf(u′-u,x′-x,t)dV′+b(x,t)(1)其離散形式為

ρku··k=Nj=1(fk,j(uj-uk,xj-xk,t))Vj+bk(2)

式中:ρk與Vk分別為物質(zhì)點(diǎn)xk的密度與體積;uk與u··k分別為物質(zhì)點(diǎn)xk的位移和加速度;N為物質(zhì)點(diǎn)xk的數(shù)量;j為物質(zhì)點(diǎn)xk近場(chǎng)域范圍內(nèi)除xk以外的物質(zhì)點(diǎn);Vj為物質(zhì)點(diǎn)j的體積;fk,j為物質(zhì)點(diǎn)xk與xj之間的相互作用力;bk為作用在物質(zhì)點(diǎn)xk上的外力或體力密度。

1.2生成對(duì)抗網(wǎng)絡(luò)GANGAN是一種新型的網(wǎng)絡(luò)框架,由2個(gè)結(jié)構(gòu)不同的多層感知機(jī)[22]組成,分別記為生成模型G和判別模型D。生成模型G記作函數(shù)G(z;θg),z為噪聲,θg為生成模型參數(shù)。G(z;θg)可將噪聲z映射到新的數(shù)據(jù)空間。判別模型則D記作D(x,θd),作為一個(gè)特殊的多層感知機(jī),對(duì)x來自真實(shí)數(shù)據(jù)分布還是來自生成模型G的輸出進(jìn)行判斷:x來自真實(shí)數(shù)據(jù)分布時(shí)D(x)=1,x來自生成模型G生成的數(shù)據(jù)分布時(shí)D(G(z))≈0。因此,GAN的優(yōu)化過程是在“二人零和博弈”[23]中獲得納什均衡的過程。對(duì)GAN模型進(jìn)行優(yōu)化的公式為

minG (maxD V(D,G))=Ex~pdata(x)(log D(x))+

Ez~pz(x)(log(1-D(G(z))))(3)

式中:pdata(x)為在真實(shí)數(shù)據(jù)上x的分布;pz(x)為先驗(yàn)的輸入噪聲變量;E為期望。

2構(gòu)建損傷云圖預(yù)測(cè)網(wǎng)絡(luò)數(shù)據(jù)集GAN模型需要圖像數(shù)據(jù)作為驅(qū)動(dòng),因此需要通過數(shù)值算例得到損傷云圖以構(gòu)建數(shù)據(jù)集。本文使用PD理論對(duì)預(yù)制裂紋板進(jìn)行仿真,構(gòu)建損傷云圖數(shù)據(jù)集。

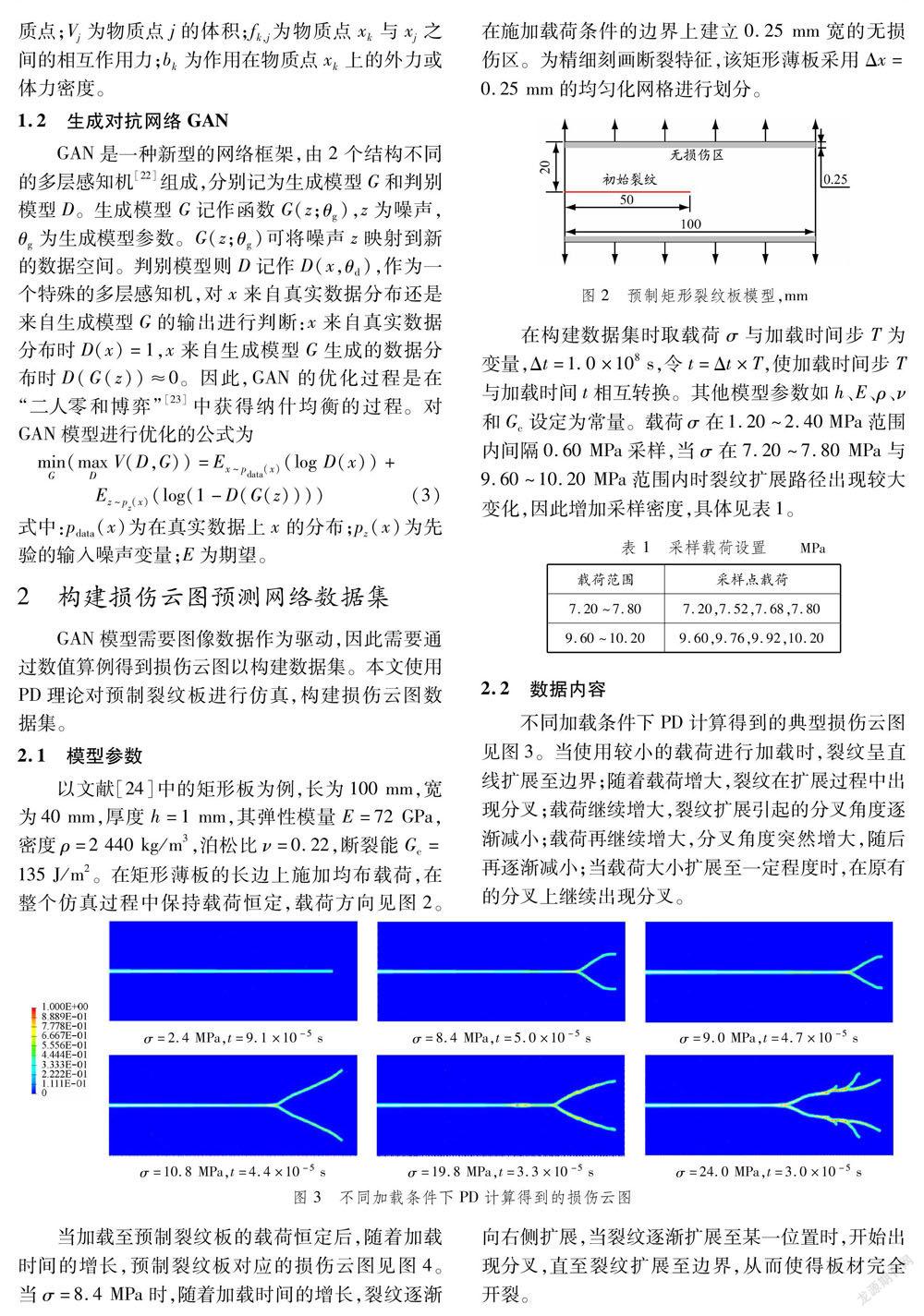

2.1模型參數(shù)以文獻(xiàn)[24]中的矩形板為例,長(zhǎng)為100 mm,寬為40 mm,厚度h=1 mm,其彈性模量E=72 GPa,密度ρ=2 440 kg/m3,泊松比ν=0.22,斷裂能Gc=135 J/m2。在矩形薄板的長(zhǎng)邊上施加均布載荷,在整個(gè)仿真過程中保持載荷恒定,載荷方向見圖2。在施加載荷條件的邊界上建立0.25 mm寬的無損傷區(qū)。為精細(xì)刻畫斷裂特征,該矩形薄板采用Δx=0.25 mm的均勻化網(wǎng)格進(jìn)行劃分。

在構(gòu)建數(shù)據(jù)集時(shí)取載荷σ與加載時(shí)間步T為變量,Δt=1.0×108 s,令t=Δt×T,使加載時(shí)間步T與加載時(shí)間t相互轉(zhuǎn)換。其他模型參數(shù)如h、E、ρ、ν和Gc設(shè)定為常量。載荷σ在1.20~2.40 MPa范圍內(nèi)間隔0.60 MPa采樣,當(dāng)σ在7.20~7.80 MPa與 9.60~10.20 MPa范圍內(nèi)時(shí)裂紋擴(kuò)展路徑出現(xiàn)較大變化,因此增加采樣密度,具體見表1。

2.2數(shù)據(jù)內(nèi)容不同加載條件下PD計(jì)算得到的典型損傷云圖見圖3。當(dāng)使用較小的載荷進(jìn)行加載時(shí),裂紋呈直線擴(kuò)展至邊界;隨著載荷增大,裂紋在擴(kuò)展過程中出現(xiàn)分叉;

當(dāng)加載至預(yù)制裂紋板的載荷恒定后,隨著加載時(shí)間的增長(zhǎng),預(yù)制裂紋板對(duì)應(yīng)的損傷云圖見圖4。當(dāng)σ=8.4 MPa時(shí),隨著加載時(shí)間的增長(zhǎng),裂紋逐漸向右側(cè)擴(kuò)展,當(dāng)裂紋逐漸擴(kuò)展至某一位置時(shí),開始出現(xiàn)分叉,直至裂紋擴(kuò)展至邊界,從而使得板材完全開裂。

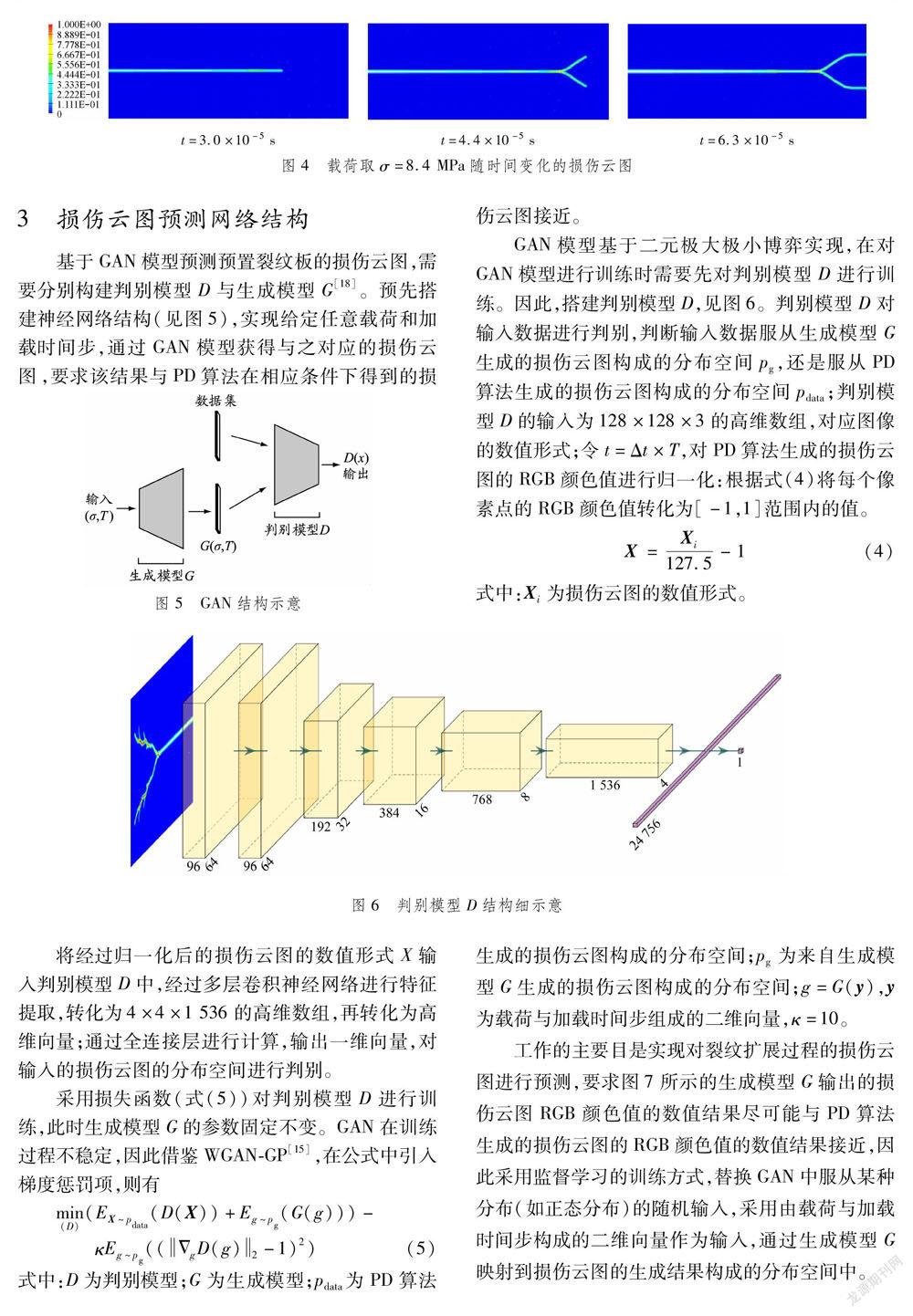

3損傷云圖預(yù)測(cè)網(wǎng)絡(luò)結(jié)構(gòu)基于GAN模型預(yù)測(cè)預(yù)置裂紋板的損傷云圖,需要分別構(gòu)建判別模型D與生成模型G[18]。預(yù)先搭建神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)(見圖5),實(shí)現(xiàn)給定任意載荷和加載時(shí)間步,通過GAN模型獲得與之對(duì)應(yīng)的損傷云圖,要求該結(jié)果與PD算法在相應(yīng)條件下得到的損傷云圖接近。

GAN模型基于二元極大極小博弈實(shí)現(xiàn),在對(duì)GAN模型進(jìn)行訓(xùn)練時(shí)需要先對(duì)判別模型D進(jìn)行訓(xùn)練。因此,搭建判別模型D,見圖6。判別模型D對(duì)輸入數(shù)據(jù)進(jìn)行判別,判斷輸入數(shù)據(jù)服從生成模型G生成的損傷云圖構(gòu)成的分布空間pg,還是服從PD算法生成的損傷云圖構(gòu)成的分布空間pdata;判別模型D的輸入為128×128×3的高維數(shù)組,對(duì)應(yīng)圖像的數(shù)值形式;令t=Δt×T,對(duì)PD算法生成的損傷云圖的RGB顏色值進(jìn)行歸一化:根據(jù)式(4)將每個(gè)像素點(diǎn)的RGB顏色值轉(zhuǎn)化為[-1,1]范圍內(nèi)的值。X=Xi127.5-1(4)式中:Xi為損傷云圖的數(shù)值形式。

將經(jīng)過歸一化后的損傷云圖的數(shù)值形式X輸入判別模型D中,經(jīng)過多層卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行特征提取,轉(zhuǎn)化為4×4×1 536的高維數(shù)組,再轉(zhuǎn)化為高維向量;通過全連接層進(jìn)行計(jì)算,輸出一維向量,對(duì)輸入的損傷云圖的分布空間進(jìn)行判別。采用損失函數(shù)(式(5))對(duì)判別模型D進(jìn)行訓(xùn)練,此時(shí)生成模型G的參數(shù)固定不變。GAN在訓(xùn)練過程不穩(wěn)定,因此借鑒WGAN-GP[15],在公式中引入梯度懲罰項(xiàng),則有

min(D)(EX~pdata(D(X))+Eg~pg(G(g)))-

κEg~pg((ΔgD(g)2-1)2)(5)

式中:D為判別模型;G為生成模型;pdata為PD算法生成的損傷云圖構(gòu)成的分布空間;pg為來自生成模型G生成的損傷云圖構(gòu)成的分布空間;g=G(y),y為載荷與加載時(shí)間步組成的二維向量,κ=10。工作的主要目是實(shí)現(xiàn)對(duì)裂紋擴(kuò)展過程的損傷云圖進(jìn)行預(yù)測(cè),要求圖7所示的生成模型G輸出的損傷云圖RGB顏色值的數(shù)值結(jié)果盡可能與PD算法生成的損傷云圖的RGB顏色值的數(shù)值結(jié)果接近,因此采用監(jiān)督學(xué)習(xí)的訓(xùn)練方式,替換GAN中服從某種分布(如正態(tài)分布)的隨機(jī)輸入,采用由載荷與加載時(shí)間步構(gòu)成的二維向量作為輸入,通過生成模型G映射到損傷云圖的生成結(jié)果構(gòu)成的分布空間中。

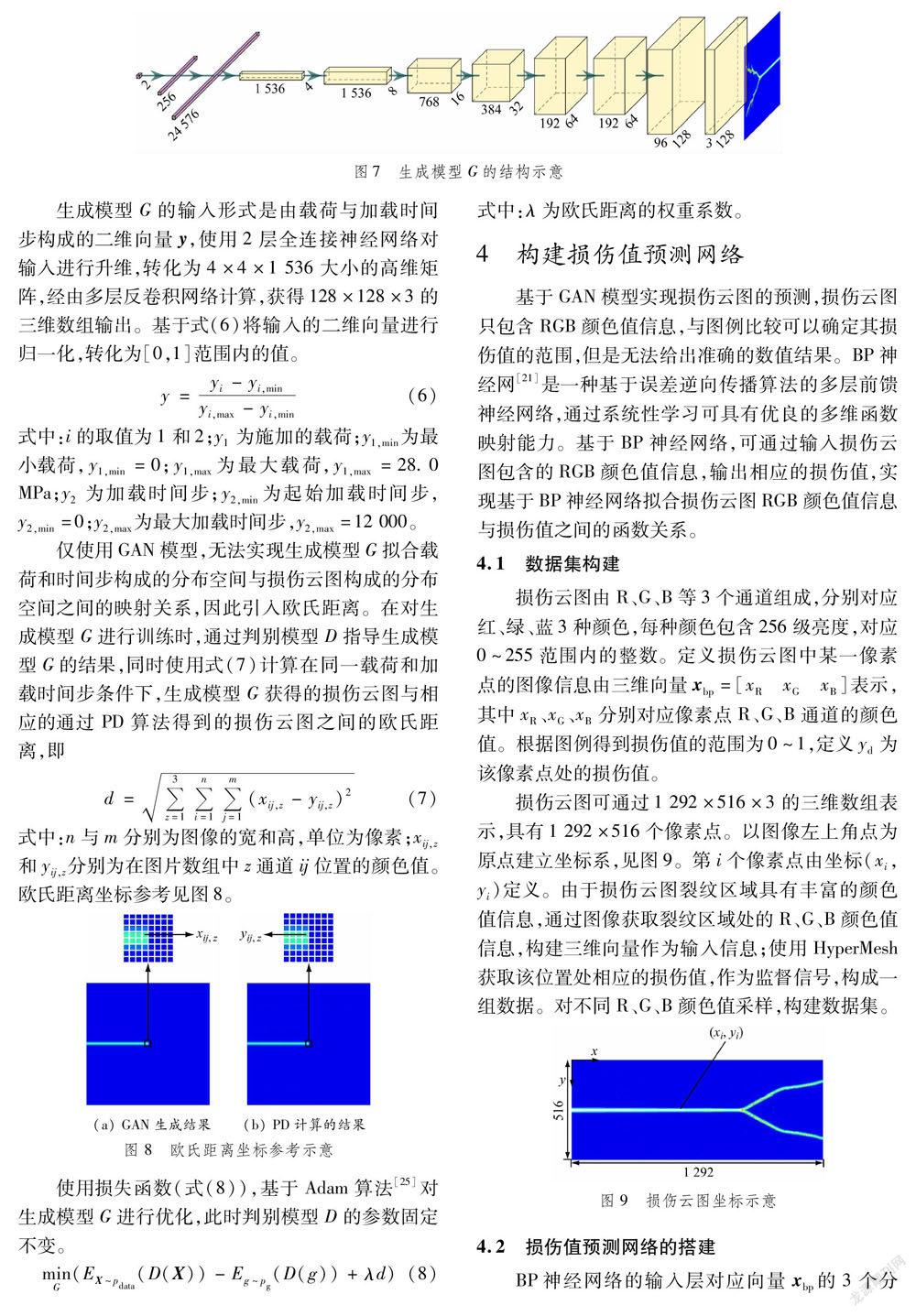

生成模型G的輸入形式是由載荷與加載時(shí)間步構(gòu)成的二維向量y,使用2層全連接神經(jīng)網(wǎng)絡(luò)對(duì)輸入進(jìn)行升維,轉(zhuǎn)化為4×4×1 536大小的高維矩陣,經(jīng)由多層反卷積網(wǎng)絡(luò)計(jì)算,獲得128×128×3的三維數(shù)組輸出。基于式(6)將輸入的二維向量進(jìn)行歸一化,轉(zhuǎn)化為[0,1]范圍內(nèi)的值。y=yi-yi,minyi,max-yi,min(6)式中:i的取值為1和2;y1為施加的載荷;y1,min為最小載荷,y1,min=0;y1,max為最大載荷,y1,max=28.0 MPa;y2為加載時(shí)間步;y2,min為起始加載時(shí)間步,y2,min=0;y2,max為最大加載時(shí)間步,y2,max=12 000。僅使用GAN模型,無法實(shí)現(xiàn)生成模型G擬合載荷和時(shí)間步構(gòu)成的分布空間與損傷云圖構(gòu)成的分布空間之間的映射關(guān)系,因此引入歐氏距離。在對(duì)生成模型G進(jìn)行訓(xùn)練時(shí),通過判別模型D指導(dǎo)生成模型G的結(jié)果,同時(shí)使用式(7)計(jì)算在同一載荷和加載時(shí)間步條件下,生成模型G獲得的損傷云圖與相應(yīng)的通過PD算法得到的損傷云圖之間的歐氏距離,即d=3z=1ni=1mj=1(xij,z-yij,z)2(7)式中:n與m分別為圖像的寬和高,單位為像素;xij,z和yij,z分別為在圖片數(shù)組中z通道ij位置的顏色值。歐氏距離坐標(biāo)參考見圖8。

使用損失函數(shù)(式(8)),基于Adam算法[25]對(duì)生成模型G進(jìn)行優(yōu)化,此時(shí)判別模型D的參數(shù)固定不變。

minG (EX~pdata(D(X))-Eg~pg(D(g))+λd)(8)

式中:λ為歐氏距離的權(quán)重系數(shù)。

4構(gòu)建損傷值預(yù)測(cè)網(wǎng)絡(luò)基于GAN模型實(shí)現(xiàn)損傷云圖的預(yù)測(cè),損傷云圖只包含RGB顏色值信息,與圖例比較可以確定其損傷值的范圍,但是無法給出準(zhǔn)確的數(shù)值結(jié)果。BP神經(jīng)網(wǎng)[21]是一種基于誤差逆向傳播算法的多層前饋神經(jīng)網(wǎng)絡(luò),通過系統(tǒng)性學(xué)習(xí)可具有優(yōu)良的多維函數(shù)映射能力。基于BP神經(jīng)網(wǎng)絡(luò),可通過輸入損傷云圖包含的RGB顏色值信息,輸出相應(yīng)的損傷值,實(shí)現(xiàn)基于BP神經(jīng)網(wǎng)絡(luò)擬合損傷云圖RGB顏色值信息與損傷值之間的函數(shù)關(guān)系。

4.1數(shù)據(jù)集構(gòu)建損傷云圖由R、G、B等3個(gè)通道組成,分別對(duì)應(yīng)紅、綠、藍(lán)3種顏色,每種顏色包含256級(jí)亮度,對(duì)應(yīng)0~255范圍內(nèi)的整數(shù)。定義損傷云圖中某一像素點(diǎn)的圖像信息由三維向量xbp=[xRxGxB]表示,其中xR、xG、xB分別對(duì)應(yīng)像素點(diǎn)R、G、B通道的顏色值。根據(jù)圖例得到損傷值的范圍為0~1,定義yd為該像素點(diǎn)處的損傷值。損傷云圖可通過1 292×516×3的三維數(shù)組表示,具有1 292×516個(gè)像素點(diǎn)。以圖像左上角點(diǎn)為原點(diǎn)建立坐標(biāo)系,見圖9。第i個(gè)像素點(diǎn)由坐標(biāo)(xi,yi)定義。由于損傷云圖裂紋區(qū)域具有豐富的顏色值信息,通過圖像獲取裂紋區(qū)域處的R、G、B顏色值信息,構(gòu)建三維向量作為輸入信息;使用HyperMesh獲取該位置處相應(yīng)的損傷值,作為監(jiān)督信號(hào),構(gòu)成一組數(shù)據(jù)。對(duì)不同R、G、B顏色值采樣,構(gòu)建數(shù)據(jù)集。

4.2損傷值預(yù)測(cè)網(wǎng)絡(luò)的搭建BP神經(jīng)網(wǎng)絡(luò)的輸入層對(duì)應(yīng)向量xbp的3個(gè)分量。搭建3層隱含層,每層包括10個(gè)神經(jīng)元[27]。鑒于損傷值由0~1的數(shù)值表示,因此輸出層的神經(jīng)元個(gè)數(shù)取1。作為輸入信息,xbp在輸入神經(jīng)網(wǎng)絡(luò)之前用式(9)進(jìn)行歸一化處理。xin=xbp/255(9)在BP神經(jīng)網(wǎng)絡(luò)中,從隱含層到輸出層之間每層神經(jīng)元的輸入為Ni,l=ni=1(wij,lxj,l-1)+bi,l(10)式中:Ni,l為第l層第i個(gè)神經(jīng)元的輸入;wij,l為第l-1層第j個(gè)神經(jīng)元與第l層第i個(gè)神經(jīng)元之間的加權(quán)系數(shù);bi,l為第l層第i個(gè)神經(jīng)元的偏置量。網(wǎng)絡(luò)神經(jīng)元的輸出為hi,l=f(Ni,l)(11)式中:f()為激活函數(shù);hi,l為第l層第i個(gè)神經(jīng)元的輸出,BP網(wǎng)絡(luò)共有5層,因此l取2~5。每個(gè)神經(jīng)元取線性整流函數(shù)[28]作為激活函數(shù),f(x)=max(0,x)(12)將式(13)作為損失函數(shù),通過誤差反向傳播算法對(duì)BP神經(jīng)網(wǎng)絡(luò)進(jìn)行權(quán)值修正計(jì)算。lo=(yd-hi,4)2(13)式中:y為監(jiān)督信號(hào);lo為損失函數(shù)值。

4.3損傷值預(yù)測(cè)結(jié)果分析取不在訓(xùn)練集內(nèi)的8個(gè)采樣點(diǎn)的RGB顏色值輸入到BP神經(jīng)網(wǎng)絡(luò)中,與該點(diǎn)處實(shí)際損傷值進(jìn)行比較,結(jié)果見表2。平均誤差為0.561%,可見經(jīng)過反復(fù)學(xué)習(xí)訓(xùn)練后的BP神經(jīng)網(wǎng)絡(luò)可以較好地?cái)M合RGB顏色值與損傷值之間的函數(shù)關(guān)系。

5結(jié)果分析在不同載荷條件下,加載至t=5.0×10-5 s時(shí),PD算法與GAN模型獲得200張損傷云圖的時(shí)間消耗結(jié)果對(duì)比見表4。其中,PD算法計(jì)算所需時(shí)間不包括使用后處理軟件轉(zhuǎn)化為損傷云圖所包含的時(shí)間。由此可知,GAN模型消耗的時(shí)間遠(yuǎn)低于PD算法所需要的時(shí)間。

為驗(yàn)證通過訓(xùn)練完成的GAN可以比較準(zhǔn)確地預(yù)測(cè)0~24 MPa范圍內(nèi)任意載荷與加載時(shí)間對(duì)應(yīng)的損傷云圖,利用主觀觀察和數(shù)值對(duì)比2種方式進(jìn)行驗(yàn)證。

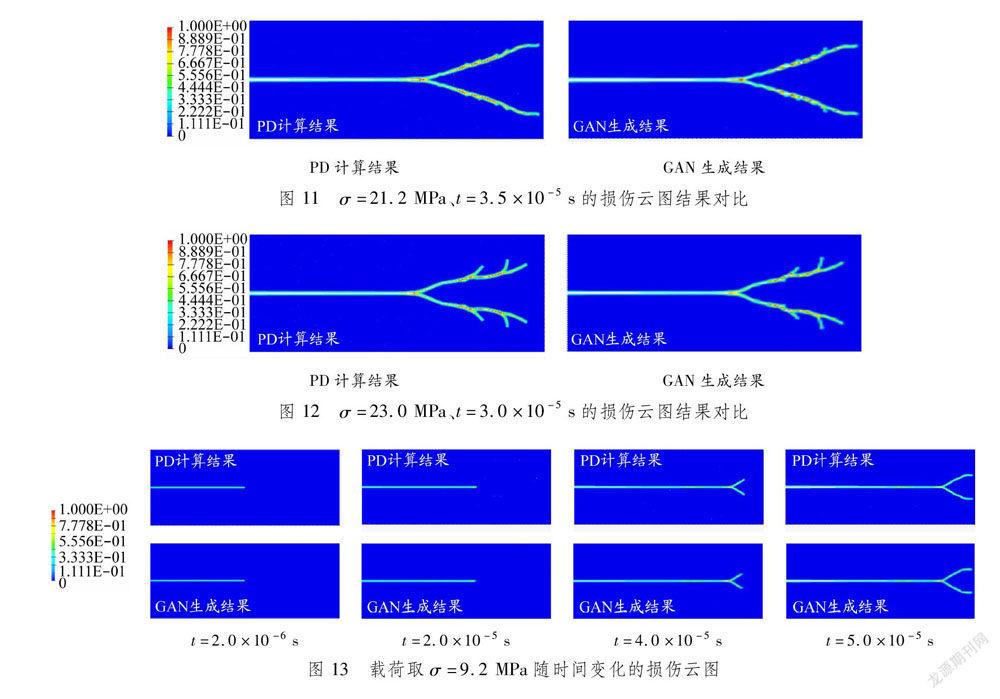

5.1損傷云圖結(jié)果對(duì)比通過與PD算法獲得的損傷云圖結(jié)果進(jìn)行主觀對(duì)比,可以驗(yàn)證GAN模型生成結(jié)果的準(zhǔn)確性。在載荷與加載時(shí)間分別為σ=14.8 MPa、t=3.8×10-5 s,σ=21.2 MPa、t=3.5×10-5 s與σ=23.0 MPa、t=3.0×10-5 s的條件下(該條件不在訓(xùn)練集內(nèi)),GAN生成結(jié)果與PD計(jì)算結(jié)果損傷云圖對(duì)比分別見圖10~12。GAN模型與PD算法得到損傷云圖裂紋出現(xiàn)分叉的位置和裂紋擴(kuò)展的路徑極為接近。因此可以認(rèn)為,GAN模型能夠根據(jù)載荷與加載時(shí)間預(yù)測(cè)相應(yīng)的損傷云圖。此外,σ=9.2 MPa時(shí),改變加載時(shí)間,GAN模型得到的損傷云圖與PD算法得到的結(jié)果對(duì)比見圖13。在GAN模型得到的加載時(shí)間分別為t=2.0×10-6 s、t=2.0×10-5 s、t=4.0×10-5 s以及t=5.0×10-5 s的損傷云圖中,裂紋長(zhǎng)度和裂紋擴(kuò)展的趨勢(shì)與PD得到的結(jié)果極為接近,這也證明GAN模型具有預(yù)測(cè)裂紋擴(kuò)展的形狀隨加載時(shí)間改變的效果。

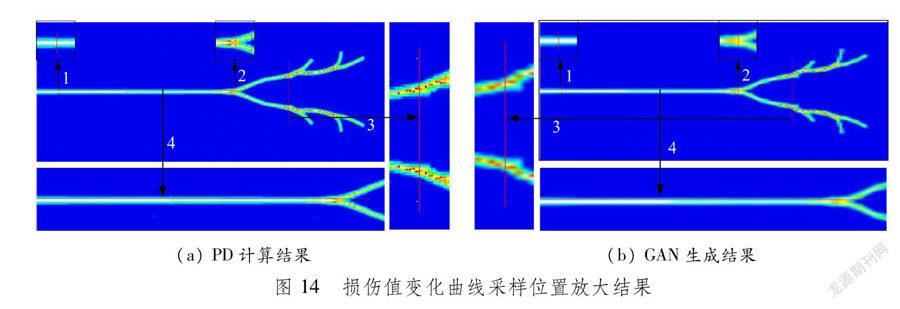

5.2基于BP神經(jīng)網(wǎng)絡(luò)的結(jié)果對(duì)比由于損傷云圖在輸入GAN模型時(shí)由1 292×516×3的高維數(shù)組轉(zhuǎn)化為128×128×3的低維數(shù)組,輸出結(jié)果再由128×128×3轉(zhuǎn)化為1 292×516×3,在轉(zhuǎn)化過程中損傷云圖損失大量的細(xì)節(jié)信息。當(dāng)放大損傷云圖(圖14)時(shí),相對(duì)于PD算法得到的損傷云圖,GAN模型得到的損傷云圖細(xì)節(jié)部分表現(xiàn)較為平滑,難以獲得與PD一樣的效果,但是依舊能確定損傷部分的大致輪廓,并通過圖例確定損傷值的大致范圍。

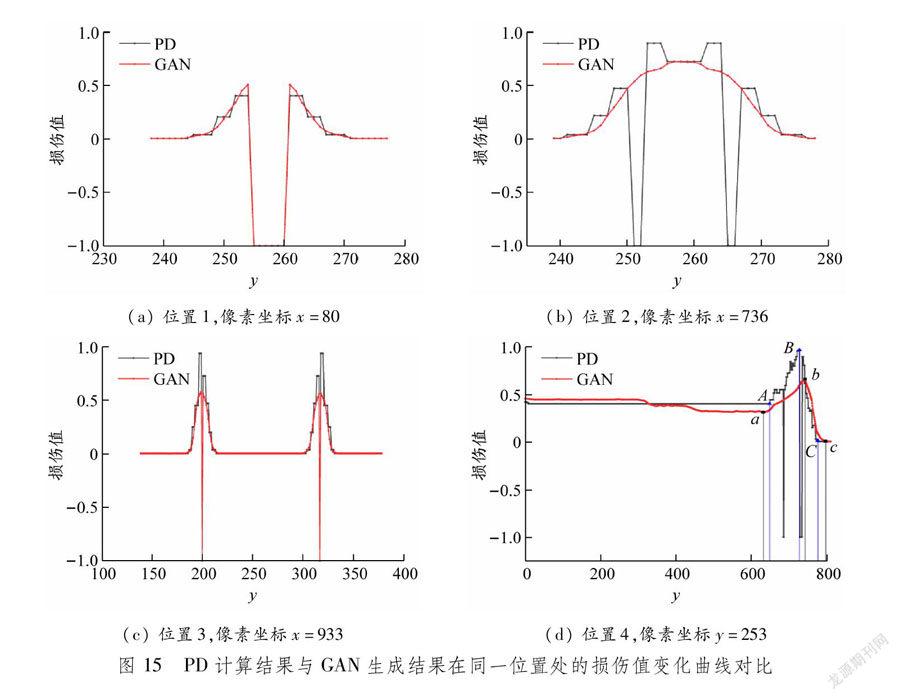

取σ=23.0 MPa、t=3.0×10-5 s條件下的損傷云圖,使用所繪線段對(duì)應(yīng)位置處的RGB顏色值,利用BP神經(jīng)網(wǎng)絡(luò)獲取損傷值進(jìn)行對(duì)比。白色區(qū)域代表無效區(qū)域,因此定義R、G、B各通道對(duì)應(yīng)的顏色值≥220時(shí)的損傷值取-1,仍按圖9建立坐標(biāo)系。PD計(jì)算結(jié)果與GAN生成結(jié)果在同一位置處的損傷值變化曲線對(duì)比見圖15。圖14位置1、2、3的損傷值變化曲線橫坐標(biāo)與線段從上至下的像素點(diǎn)坐標(biāo)對(duì)應(yīng)。圖15(a)為位置1對(duì)應(yīng)的損傷值變化曲線圖,圖中PD對(duì)應(yīng)的損傷值變化曲線呈階梯式變化,線段上半部分損傷值逐漸增加,達(dá)到無效區(qū)域轉(zhuǎn)變?yōu)?1,下半部分與上半部分關(guān)于線段的法線對(duì)稱;GAN模型對(duì)應(yīng)的損傷值變化曲線呈平滑的曲線狀變化,其無效區(qū)域出現(xiàn)的位置與PD的結(jié)果重合。在位置2與位置3處,GAN模型與PD對(duì)應(yīng)的損傷值變化曲線均關(guān)于線段的法線對(duì)稱,且整體變化趨勢(shì)相同,但當(dāng)無效區(qū)域過小時(shí),由于圖像尺寸轉(zhuǎn)化導(dǎo)致圖像信息損失,GAN模型無法準(zhǔn)確預(yù)測(cè)無效區(qū)域的位置,唯有增大GAN模型結(jié)構(gòu)與輸出尺寸才能獲得與PD更為接近的預(yù)測(cè)結(jié)果。綜上所述,可以認(rèn)為GAN模型具有預(yù)測(cè)損傷值整體變化趨勢(shì)的效用。

圖15(d)為位置4對(duì)應(yīng)的損傷值曲線,該線段具有810個(gè)像素點(diǎn),與PD模型相比,GAN模型的損傷值變化曲線上升拐點(diǎn)a與PD模型中的上升拐點(diǎn)A相差17個(gè)像素點(diǎn),其下降拐點(diǎn)b與PD模型的B點(diǎn)相比相差15個(gè)像素點(diǎn),GAN模型中出現(xiàn)無損傷位置的拐點(diǎn)c點(diǎn)與PD模型的C點(diǎn)相差22個(gè)像素點(diǎn),證明GAN預(yù)測(cè)得到的損傷云圖中裂紋出現(xiàn)分叉的坐標(biāo)位置與PD得到的結(jié)果接近,說明GAN模型對(duì)損傷值變化趨勢(shì)的預(yù)測(cè)準(zhǔn)確。

6結(jié)論基于GAN模型,通過PD算法獲得損傷云圖進(jìn)行數(shù)據(jù)驅(qū)動(dòng),可實(shí)現(xiàn)在不同載荷與加載時(shí)間條件下對(duì)預(yù)制裂紋板的損傷云圖進(jìn)行實(shí)時(shí)模擬與預(yù)測(cè)。對(duì)比2種算法的計(jì)算消耗時(shí)間,證明GAN模型計(jì)算消耗的時(shí)間顯著低于PD算法。分別對(duì)比2種算法在不同載荷與加載時(shí)間下的損傷云圖,證明GAN模型的有效性與實(shí)時(shí)性。與傳統(tǒng)PD算法相比,本文方法不僅可以顯著提高損傷云圖的生成速度,還可以脫離后處理軟件,通過GAN模型實(shí)現(xiàn)損傷云圖的實(shí)時(shí)可視化。同時(shí),基于BP神經(jīng)網(wǎng)絡(luò)擬合RGB顏色值信息與損傷值之間的函數(shù)關(guān)系,實(shí)現(xiàn)通過損傷云圖中的RGB顏色值到損傷值的預(yù)測(cè)。由于數(shù)據(jù)集的限制,僅能證明文中的方法能應(yīng)用在少種類變量中,更多驗(yàn)證尚需要擴(kuò)展數(shù)據(jù)集。神經(jīng)網(wǎng)絡(luò)對(duì)輸入具有快速響應(yīng)的能力,因此可將基于神經(jīng)網(wǎng)絡(luò)進(jìn)行裂紋預(yù)測(cè)的方法應(yīng)用于對(duì)目標(biāo)對(duì)象的硬件狀態(tài)實(shí)時(shí)檢測(cè)與預(yù)測(cè)中,有利于提高目標(biāo)對(duì)象的安全性。參考文獻(xiàn):

[1]SILLING S A. Reformulation of elasticity theory for discontinuities and long-range forces[J]. 2000, 48(1): 175-209. DOI: 10.1016/S0022-5096(99)00029-0.

[2]SILLING S A, ASKARI E. A meshfree method based on peridynamic model of solid mechanics[J]. Computers & Structures, 2005, 83(17-18): 1526-1535. DOI: 10.1016/j.compstruc.2004.11.026.

[3]SILLING S A, EPTON M, WECKNER O, et al. Peridynamic states and constitutive modeling[J]. Journal of Elasticity, 2007, 88(2): 151-184. DOI: 10.1007/s10659-007-9125-1.

[4]SILLING S A, LEHOUCQ R B. Peridynamic theory of solid mechanics[J]. Advances in Applied Mechanics, 2010, 44: 73-168. DOI: 10.1016/s0065-2156(10)44002-8.

[5]KILIC B. Peridynamic theory for progressive failure prediction in homogeneous and heterogeneous materials[D]. Tucson: University of Arizona, 2008: 50.

[6]MADENCI E, OTERKUS S. Ordinary state-based peridynamics for plastic deformation according to VON MISES yield criteria with isotropic hardening[J]. Journal of Mechanics and Physics of Solids, 2016, 86: 192-219. DOI: 10.1016/j.jmps.2015.09.016.

[7]SILLING S A, BOBARU F. Peridynamic modeling of membranes and fibers[J]. International Journal of Non-Linear Mechanics, 2005, 40(2-3): 395-409. DOI: 10.1016/j.ijnonlinmec.2004.08.004.

[8]ZHENG G, SHEN G, HU P, et al. Coupling approach of isogeometric analysis with non-ordinary state-based peridynamics[J]. European Journal of Mechanics: A/Solids, 2020, 82: 103981. DOI: 10.1016/j.euromechsol.2020.103981.

[9]DE MEO D, ZHU N, OTERKUS E. Peridynamic modeling of granular fracture in polycrystalline materials[J]. Journal of Engineering Materials and Technology, 2016, 138(4): 16. DOI: 10.1115/1.4033634.

[10]ASKARI E, XU J, SILLING S. Peridynamic analysis of damage and failure in composites[C]//Proceedings of 44th AIAA Aerospace Sciences Meeting and Exhibit, 2006. Reno: AIAA. DOI: 10.2514/6.2006-88.

[11]GOODFELLOW I J, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial nets[C]//Proceedings of 27th International Conference on Neural Information Processing Systems, 2014. Montreal: Association for Computing Machinery.

[12]RADFORD A, METZ L, CHINTALA S. Unsupervised representation learning with deep convolutional generative adversarial networks[EB/OL]. (2016-01-31)[2021-08-10]. https://arxiv.org/abs/1511.06434v1.

[13]MIRZA M, OSINDERO S. Conditional generative adversarial nets[EB/OL]. (2014-11-30)[2021-08-10]. https://arxiv.org/abs/1411.1784.

[14]ARJOVSKY M, CHINTALA S, BOTTOU L E. Wasserstein generative adversarial networks[C]//Proceedings of 34th International Conference on Machine Learning, 2017. Sydney: PMLR.

[15]GULRAJANI I, AHMED F, ARJOVSKY M, et al. Improved training of wasserstein GANs[EB/OL]. (2017-02-27)[2021-08-10]. https://papers.nips.cc/paper/2017/file/892c3b1c6dccd52936e27cbd0ff683d6-Paper.pdf.

[16]ODENA A, OLAH C, SHLENS J. Conditional image synthesis with auxiliary classifier GANs[C]//Proceedings of 34th International Conference on Machine Learning, 2017. Sydney: PMLR.

[17]ZHANG H, XU T, LI H, et al. StackGAN(2017): Text to photo-realistic image synthesis with stacked generative adversarial networks[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice: ICCV. DOI: 10.1109/iccv.2017.629.

[18]BROCK A, DONAHUE J, SIMONYAN K. Large scale GAN training for high fidelity natural image synthesis[EB/OL]. (2019-02-25)[2021-08-10]. https://arxiv.org/abs/1809.11096?context=cs.LG.

[19]KIM M, WINOVICH N, LIN G, et al. Peri-net: Analysis of crack patterns using deep neural networks[J]. Journal of Peridynamics and Nonlocal Modeling, 2019, 1(2): 131-142. DOI: 10.1007/s42102-019-00013-x.

[20]NGUYEN C T, OTERKUS S, OTERKUS E. A peridynamic-based machine learning model for one-dimensional and two-dimensional structures[EB/OL]. (2020-08-06)[2021-08-10]. https://link.springer.com/article/10.1007/s00161-020-00905-0. DOI: 0.1007/s00161-020-00905-0.

[21]HECHT-NIELSEN R. Theory of backpropagation neural network[C]//Proceedings of International 1989 Joint Conference on Neural Networks. Washington: IEEE. DOI: 10.1109/IJCNN.1989.118638.

[22]PAL S K, MITRA S. Multilayer perceptron, fuzzy sets, classification[J]. IEEE Transactions on Neural Networks, 1992: 3(5): 683-697. DOI: 10.1109/72.159058.

[23]MERTENS J-F, ZAMIR S. Value of two-person zero-sum repeated games with lack of information on both sides[J]. International Journal of Game Theory, 1971, 1(1):39-64. DOI: 10.1007/BF01753433.

[24]BOWDEN F P, BRUNTON J H, FIELD J E, et al. Controlled fracture of brittle solids and interruption of electrical current[J]. Nature, 1967, 216: 38-42. DOI: 10.1038/216038a0.

[25]KINGMA D, BA J. Adam: A method for stochastic optimization[EB/OL]. (2014-12-22)[2021-08-10]. https://arxiv.org/abs/1412.6980v5.

[26]HUANG G B, CHEN L, SIEW C. Universal approximation using incremental constructive feedforward networks with random hidden nodes[J]. IEEE Transactions on Neural Networks, 2006, 17(4): 879-892. DOI: 10.1109/TNN.2006.875977.

[27]NAIR V, HINTON G E. Rectified linear units improve restricted Boltzmann machines[C]//Proceedings of 27th International Conference on International Conference on Machine Learning, 2010. Haifa: PMLR.(編輯武曉英)