基于多傳感器融合的交通數據采集系統概述

張 藝,嚴翌,李 靜

(長安大學,陜西 西安 710061)

0 引 言

多傳感器信息融合環境感知技術在提高道路環境感知能力方面具有舉足輕重的作用,在目標探測方面,與傳統單一的感知相比,道路環境的信息獲取能力更高、更準確、更兼容[1]。本文要解決的問題是構建一個交通數據采集系統,使該系統可以實現在低能見度的情況下利用多個傳感器準確、實時、有效地檢測前方道路環境,對獲取到的數據進行融合處理,從而對移動目標(例如行人或汽車)進行精確識別。交通數據采集系統可以為車與車、車與人、車與路側設備之間的互通提供可靠的信息。

1 交通數據采集系統框架

1.1 設備選型

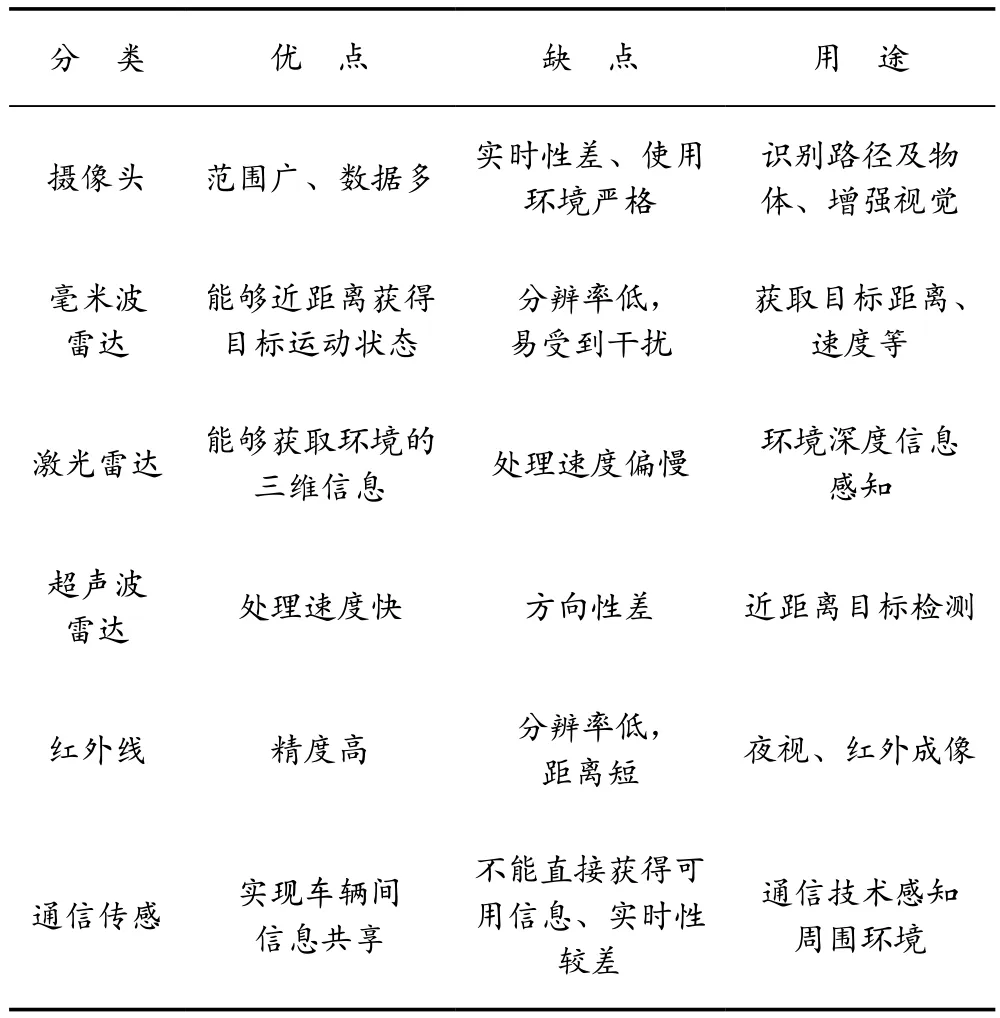

不同傳感器有著不同的特點與性能,使用多個傳感器采集多種信息源與數據,從而獲得完整、確切、高效的綜合信息[2-3]。激光雷達是通過發射的線束掃描周圍環境來獲得距離信息,從而對周圍環境進行感知,但激光雷達對光線變化的適應性較弱,無法獲得顏色信息,且價格昂貴,實用性較差。毫米波雷達探測范圍廣,抗天氣干擾能力強,但分辨率不高。相機成本低,檢測精度高,但魯棒性較低。表1列出了常用傳感器的優缺點與用途。

交通數據采集系統選取激光雷達、毫米波雷達、全景相機作為主要傳感器對環境進行感知,本系統中激光雷達選取鐳神CH16的16線激光雷達,毫米波雷達選擇Delphi SRR2,相機選擇DS-2CD3T46FWDV2-I8S槍型攝像機。

1.2 數據傳輸

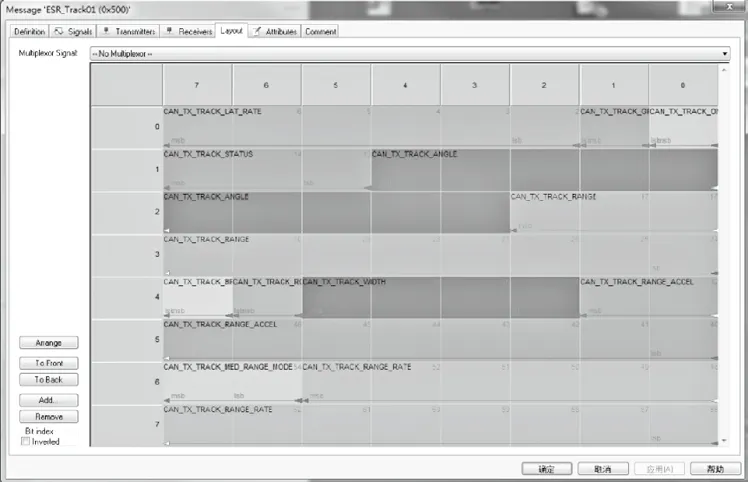

可以對激光雷達采集的數據進行可視化操作,形成激光點云圖。相機采集到的數據為二維圖像,通過數據線可以直接進行數據傳輸。毫米波雷達采集的數據為數據幀格式,如圖1所示。

表1 不同傳感器性能對比

圖1 數據幀格式

數據幀由8個字節組成,不同顏色代表不同的message。message的類別由幀ID決定,毫米波雷達可同時識別64個目標,ID范圍為500~53F,如圖2所示。

圖2 數據幀解析界面

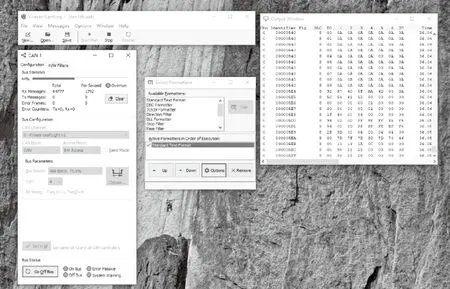

將數據幀進行可視化處理,再將可視化后的圖像與其他信息融合。Delphi ESR毫米波雷達通過Kvaser將數據幀進行可視化處理,設置界面如圖3所示。

圖3 數據幀可視化設置界面

數據幀可視化后的界面如圖4所示。每一個方框代表一個目標,有綠色交叉線的方框表示系統根據目標速度、加速度等信息將目標判定為虛假目標。

圖4 數據幀可視化界面

1.3 融合框架

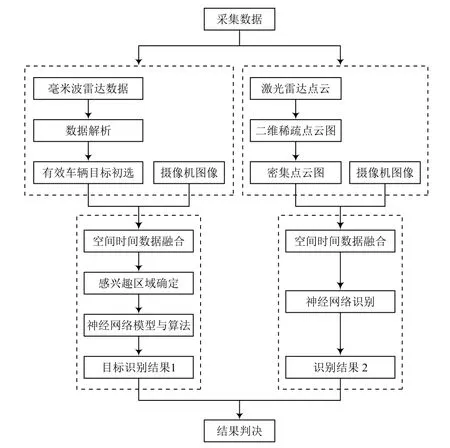

通過交通數據采集系統獲取周圍環境信息的關鍵是將激光雷達、毫米波雷達與相機采集的數據進行有效融合[4-5]。首先將毫米波雷達數據解析之后與相機圖像進行融合,確定感興趣的區域,使用神經網絡算法對車輛進行識別,得出結果1;然后將稀疏的激光點云數據進行補全,得到密集點云圖,將密集點云圖與相機圖像進行融合,通過神經網絡算法進行目標識別,得到結果2;最后采用D-S證據理論將結果1與結果2進行結果判決,得到最終的目標識別結果。融合框架如圖5所示。

圖5 融合框架

2 異質傳感器空間標定

2.1 相機標定

相機成像會使圖像有不同程度的畸變,相機標定的目的是建立一個相機成像幾何模型,從而矯正透鏡的畸變[6]。要解決這一問題,首先需要建立相機成像幾何模型,最關鍵的就是要得到相機的內參和外參。通過相機標定,可以得到5個內參、3個外參、2個畸變參數,并且這些參數具有高估計精度。通過這些參數,可以對相機圖像進行畸變矯正、圖像矯正等處理。本文采用張正友標定法(該方法由張正友教授在1998年提出),即一種基于單平面棋盤格的攝像機標定方法,只需要一張打印出來的黑白棋盤格圖片即可。該方法不僅能夠解決傳統標定法進行高精度標定時存在的問題,而且相對于自標定而言,提高了標定精度,可操作性強。

張正友標定法通過棋盤格上8個點的坐標計算出單應性矩陣,從而可以表示出世界平面到圖像平面之間的轉換關系。

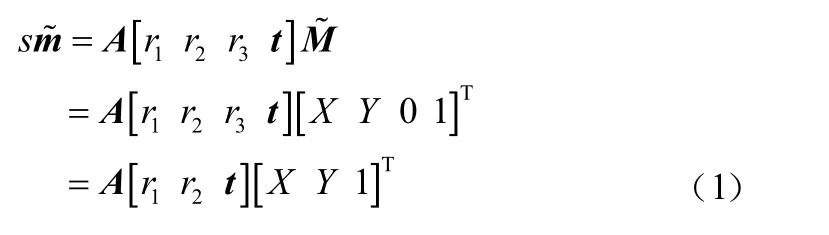

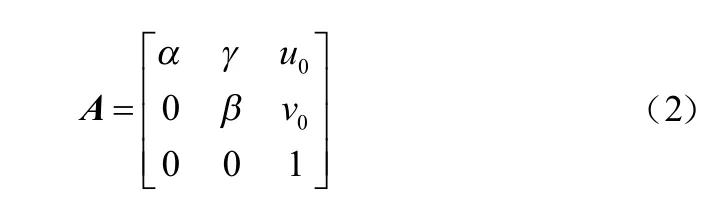

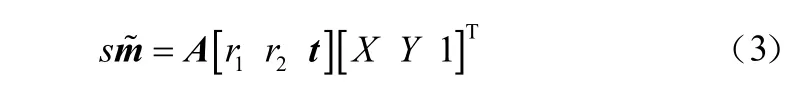

標定用的棋盤格平面到相機圖像平面的轉換關系為:

式中:s為任意比例因子;R為旋轉矩陣,且是一個單位正交矩陣;(R,t)為外參矩陣,ri為R的第i列,t為平移矩陣;A為攝像機內參數。

式中:α和β是圖像u和v軸中的比例因子;γ為畸變因子,是描述2個圖像軸偏斜的參數。

把A[r1,r2,t]稱為單應性矩陣H,即:

一個對應點能夠提供2個方程,在矩陣H中有8個未知參數,所以至少需要8個方程進行求解,就至少需要4個對應點,才能算出世界平面到圖像平面的單應性矩陣H。

將單應性矩陣寫作行向量的形式,行向量中每一個元素為一個列向量,即:

由3個單應性矩陣作為約束條件,計算5個內參參數,得到內參矩陣,最后基于內參矩陣估算外參矩陣。

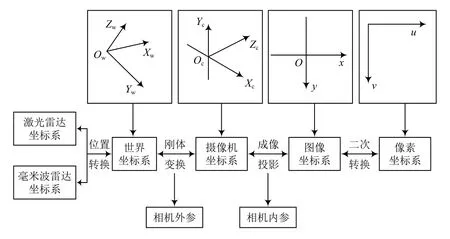

2.2 坐標系轉換

由于相機和雷達安裝位置以及采集獲取的維度信息不同,不能將三者數據直接進行融合處理,需要先進行預處理[7]。首要的工作就是將檢測目標在2個傳感器的空間位置上相互對應,為此需建立多個坐標系,分別為激光雷達坐標系、毫米波雷達坐標系、攝像頭坐標系、世界坐標系、圖像坐標系以及像素坐標系,通過坐標系之間的轉化使得三種傳感器在空間上彼此對齊。

本文中的坐標系轉換可以實現雷達坐標系、三維世界坐標系、攝像機坐標系、圖像坐標系和像素坐標系的統一,將雷達獲取的車輛信息在視頻圖像上生成感興趣區域。圖6所示為三維世界坐標系與二維像素坐標系之間的轉換關系。相機的成像可以將三維空間中多個相互平行的曲面投影到一個二維平面上,即三維空間到二維空間平面的轉換是多對一的映射關系。

圖6 坐標系轉換

3 多傳感器融合算法

3.1 融合算法

數據融合方法可以根據融合層次的不同分為三個層級,即像素級融合、特征級融合、決策級融合。像素級融合作為最底層的融合方法,主要從傳感器獲取的原始數據中直接提取特征,對同一事物的不同特征進行融合。該操作一般發生在特征提取之前,常用的方法有平均與加權平均方法、基于金字塔變換的圖像融合方法、基于Ridgelet變換的圖像融合方法等;特征級融合的方法主要有人工神經網絡、聚類方法、K階最近鄰法等;決策級融合是圖像數據融合的最高層次,它的結果可以作為決策的要素,一般發生在各種傳感器獨立說明之后,常用方法有Bayes推斷、D-S證據推理等[8]。

本文中,雷達與相機的融合采用人工神經網絡方法,最后的結果采用特征級融合D-S證據推理進行結果判決。融合層次確定了2個主要問題,一是多源原始圖像數據進行預處理的程度;二是在信息處理中的融合層次。

3.2 目標識別

采用YOLO算法對融合后的二維圖像進行目標識別。YOLO將對象檢測重新定義為一個回歸問題[9]。它將單個卷積神經網絡(CNN)應用于整個圖像,將圖像分成網格,并預測每個網格的類概率和邊界框。每個邊界框可以使用4個描述符進行描述,即邊界框的中心、高度、寬度、值映射到對象所屬的類[10]。最后對每個類的對象應用一個稱為“非最大抑制(Non Max Suppression)”的方法過濾出“置信度”小于閾值的邊界框,以此作為目標識別結果的預測依據。

4 實驗與結論分析

4.1 實驗結果

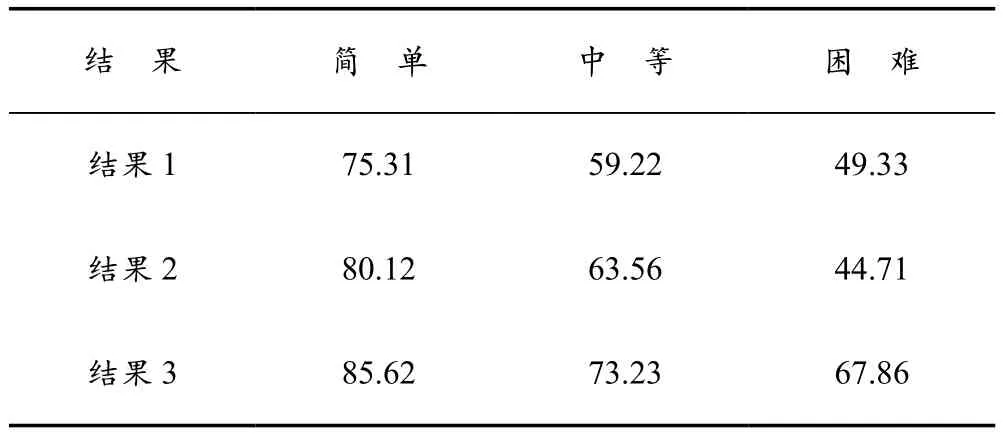

將交通數據采集裝置放置在學校某十字路口段,從早晨9點至10點對來往車輛數據進行采集與預處理后,通過系統的目標識別以及結果判決等過程,得到最終的車輛識別結果。根據圖像中的車輛有無遮擋物、車速、車型大小等指標將識別難度分類為簡單、中等、困難三個層級,并對三個層級的目標識別結果進行對比,其中結果1為激光雷達點云與相機圖像融合后的識別結果;結果2為毫米波雷達與相機圖像融合后的識別結果;結果3為結果1與結果2使用D-S證據推理進行判決后的結果。精度值對比見表2所列。

4.2 結論與分析

從表中可知,三種傳感器融合后的檢測結果皆高于傳感器兩兩融合后的檢測精度,在識別難度為困難的類別中精度值提高最多。

表2 檢測結果精度值對比 %

5 結 語

本文提出的基于多傳感器融合的交通數據采集系統能夠有效提高目標的識別精度。