基于Mask R-CNN的款式圖衣領(lǐng)識(shí)別

黃振華,李濤,蔣玉萍,杜磊*

(1. 浙江理工大學(xué) 絲綢文化傳承與產(chǎn)品設(shè)計(jì)數(shù)字化技術(shù)文化和旅游部重點(diǎn)實(shí)驗(yàn)室,浙江 杭州 310018;2. 浙江理工大學(xué) 浙江省服裝工程技術(shù)研究中心,浙江 杭州 310018;3. 浙江理工大學(xué) 服裝數(shù)字化技術(shù)浙江省工程實(shí)驗(yàn)室, 浙江 杭州 310018)

目前服裝樣板生成過(guò)程中,需要樣板師人工解讀款式圖信息,容易造成識(shí)別錯(cuò)誤或理解偏差,導(dǎo)致樣板生成錯(cuò)誤,降低生產(chǎn)效率[1]。衣領(lǐng)是服裝的重要組成部分,不僅展現(xiàn)服裝的美感,而且很大程度上決定了服裝風(fēng)格[2]。由于款式圖對(duì)衣領(lǐng)的細(xì)部工藝表達(dá)不完整,容易造成樣板師人工識(shí)別錯(cuò)誤[3],因此,實(shí)現(xiàn)款式圖衣領(lǐng)的自動(dòng)識(shí)別具有重要現(xiàn)實(shí)意義。

為降低人工識(shí)別誤差,國(guó)內(nèi)外學(xué)者通過(guò)引入計(jì)算機(jī)視覺(jué)技術(shù)代替人工識(shí)別,其主要基于圖像內(nèi)容與深度學(xué)習(xí)兩種方式[4]。基于圖像內(nèi)容是通過(guò)人工設(shè)計(jì)方法提取圖像特征,主要有幾何特征[5]、全局特征[6]、局部特征[7]及多特征融合[8]等提取方式。其中,AN L X等[9]運(yùn)用小波傅里葉描述子表征服裝外部廓形特征,并利用主成分分析降維,結(jié)合極端學(xué)習(xí)機(jī)對(duì)款式圖進(jìn)行分類。由于小波傅里葉描述子不適合形狀的實(shí)時(shí)分類,李東等[6]提出一種通過(guò)預(yù)處理獲取服裝輪廓信息的算法,并訓(xùn)練多分類支持向量機(jī)實(shí)現(xiàn)實(shí)時(shí)分類。

隨著深度學(xué)習(xí)在圖像分類上的不斷發(fā)展,學(xué)者們利用深度學(xué)習(xí)方法進(jìn)行服裝圖像識(shí)別。吳歡等[10]針對(duì)服裝相似廓形分類效果不理想的問(wèn)題,引入卷積神經(jīng)網(wǎng)絡(luò)CaffeNet模型進(jìn)行女褲廓形分類,分類準(zhǔn)確率達(dá)到95%。針對(duì)衣領(lǐng)部位分類效果不理想的問(wèn)題,尹光燦等[11]通過(guò)人工截取領(lǐng)型區(qū)域,運(yùn)用AlexNet卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)對(duì)服裝領(lǐng)型的識(shí)別與分類。由于衣領(lǐng)部件相對(duì)服裝整體目標(biāo)較小,其他服裝部件會(huì)形成噪聲,導(dǎo)致分類準(zhǔn)確率低,通過(guò)人工截取目標(biāo)區(qū)域雖然可以減少噪聲,但被分類圖像需進(jìn)行裁剪以保證部件位置統(tǒng)一,因此無(wú)法廣泛適用于服裝圖像的分類。

針對(duì)小目標(biāo)識(shí)別困難的問(wèn)題,以服裝款式圖中衣領(lǐng)作為研究對(duì)象,選用神經(jīng)網(wǎng)絡(luò)模型 (mask region convolutional neural networks,Mask R-CNN)進(jìn)行試驗(yàn)[12],該模型對(duì)數(shù)據(jù)要求低,不需要對(duì)數(shù)據(jù)進(jìn)行裁剪、灰度化等預(yù)處理,對(duì)小目標(biāo)物體識(shí)別性能高。文中根據(jù)款式圖特點(diǎn)調(diào)整模型參數(shù),結(jié)合遷移學(xué)習(xí)方法實(shí)現(xiàn)對(duì)款式圖領(lǐng)型的識(shí)別與定位。

1 實(shí)驗(yàn)方法

1.1 Mask R-CNN模型

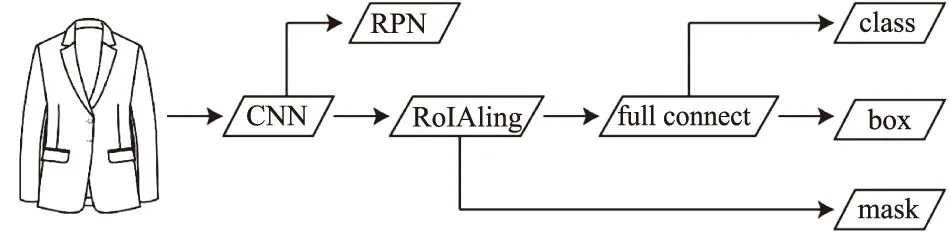

實(shí)驗(yàn)采用Mask R-CNN深度學(xué)習(xí)算法,該方法在Faster R-CNN基礎(chǔ)上進(jìn)行改進(jìn),解決了Faster R-CNN在識(shí)別小目標(biāo)物體上出現(xiàn)丟失的問(wèn)題,并提升了識(shí)別準(zhǔn)確度[13]。Mask R-CNN結(jié)構(gòu)如圖1所示,主要由3個(gè)模塊組成,分別是特征提取網(wǎng)絡(luò)(CNN)、區(qū)域建議網(wǎng)絡(luò)(region proposal network,RPN)及全連接層回歸網(wǎng)絡(luò)(full connect)。最終網(wǎng)絡(luò)輸出包含3個(gè)分支,分別是目標(biāo)的分類(class)、目標(biāo)包圍框的坐標(biāo)(box)及目標(biāo)物體的二值掩碼(mask)。

圖1 Mask R-CNN結(jié)構(gòu)Fig.1 Structure of Mask R-CNN

1.1.1特征提取網(wǎng)絡(luò) Mask R-CNN在特征提取網(wǎng)絡(luò)中采用殘差特征金字塔結(jié)構(gòu),該網(wǎng)絡(luò)將ResNet與特征金字塔網(wǎng)絡(luò)(feature pyramid networks,F(xiàn)PN)進(jìn)行結(jié)合,實(shí)現(xiàn)僅增加極小的計(jì)算量,同時(shí)處理好物體檢測(cè)的多尺度變化問(wèn)題,能夠使小目標(biāo)在下采樣過(guò)程中不丟失。ResNet還可以根據(jù)不同任務(wù)目標(biāo)選取不同的骨干網(wǎng)絡(luò),例如ResNet-50與ResNet-101。其中ResNet-50是由4個(gè)模塊組成,每個(gè)模塊中含有若干個(gè)殘差塊,第一個(gè)殘差塊將上一個(gè)模塊通道數(shù)量翻倍,而高與寬減半,共包含了49層卷積層與1層全連接層。ResNet-101是在ResNet-50的基礎(chǔ)上增加第4層殘差塊。在Mask R-CNN中,ResNet僅作為特征提取器對(duì)圖像進(jìn)行特征提取,因此將ResNet的全連接層去除。

1.1.2區(qū)域建議網(wǎng)絡(luò) Mask R-CNN利用ResNet-FPN結(jié)構(gòu)將不同階段的特征圖輸入RPN生成多個(gè)候選信息區(qū)域(region of interest, RoI),通過(guò)RPN對(duì)RoI進(jìn)行訓(xùn)練,得到標(biāo)定具有完整標(biāo)定正樣本與含有部分標(biāo)定區(qū)域負(fù)樣本,將剩余的RoI進(jìn)行RoIAlign操作,將圖像上生成的RoI與Resnet-FPN提取的特征層進(jìn)行對(duì)齊,最后計(jì)算RPN網(wǎng)絡(luò)的損失。RoIAlign通過(guò)雙線性插值得到固定的像素值,減少返回原圖時(shí)的誤差。其中RoIAlign的對(duì)齊公式為

(1)

式中:w,h分別表示RoI寬度和高度;K為這個(gè)RoI的特征層;K0是w=224,h=224時(shí)的特征層。

1.1.3全連接層回歸

將獲取的RoI運(yùn)用全卷積網(wǎng)絡(luò)(fully convolution network,F(xiàn)CN)進(jìn)行類別分類、標(biāo)定框回歸與Mask掩碼回歸。該模型將訓(xùn)練與預(yù)測(cè)分離,在訓(xùn)練中同時(shí)進(jìn)行分類與掩碼回歸,而在預(yù)測(cè)中先得到分類結(jié)果,再將結(jié)果導(dǎo)入掩碼回歸中得到對(duì)應(yīng)掩碼。FCN類別分類和回歸與RPN網(wǎng)絡(luò)中分類和回歸相同,損失函數(shù)也與Softmax層交叉熵?fù)p失函數(shù)相同。其中訓(xùn)練采用多任務(wù)損失函數(shù),通過(guò)學(xué)習(xí)不斷減小損失函數(shù)的值,直至獲得全局最優(yōu)解。損失函數(shù)的公式為

L=Lc+Lb+Lm。

(2)

式中:Lc為分類誤差,Lb為標(biāo)定框誤差,Lm為掩碼誤差。

1.2 結(jié)果評(píng)價(jià)指標(biāo)

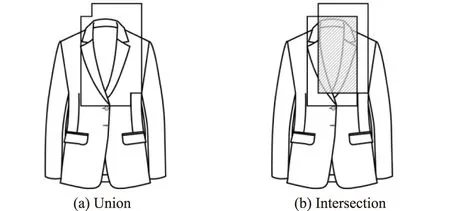

在目標(biāo)檢測(cè)中常用精確度與平均AP值(mean average precision,mAP)作為評(píng)價(jià)指標(biāo)。精確度是衡量分類準(zhǔn)確性的指標(biāo),以分類結(jié)果為正類的概率進(jìn)行表征。mAP是多個(gè)類別AP的平均值,AP是單個(gè)類別的平均精確度,通過(guò)計(jì)算精確度、召回率以及預(yù)測(cè)框和真實(shí)框的交并比(intersection over union,IoU)判斷預(yù)測(cè)框是否準(zhǔn)確預(yù)測(cè)到了位置信息,具體如圖2所示,其中并集U如圖2(a)所示,陰影部分為交集I如圖2(b)所示。SIoU值越高表示領(lǐng)型目標(biāo)定位越精確。IoU公式為

(3)

式中:I為預(yù)測(cè)邊框與真實(shí)邊框交集,U為預(yù)測(cè)邊框與真實(shí)邊框并集。

圖2 IoU示意Fig.2 Schematic diagram of IoU

2 識(shí)別實(shí)驗(yàn)

2.1 樣本庫(kù)構(gòu)建

根據(jù)領(lǐng)型結(jié)構(gòu)進(jìn)行分類,將領(lǐng)型分為無(wú)領(lǐng)、立領(lǐng)、翻領(lǐng)、駁領(lǐng)4種領(lǐng)型[11],其特點(diǎn)與款式圖見(jiàn)表1[14],每種領(lǐng)型下含有不同細(xì)分領(lǐng)型,但實(shí)驗(yàn)僅針對(duì)經(jīng)典領(lǐng)型進(jìn)行分類。在網(wǎng)絡(luò)上收集包含4種領(lǐng)型的款式圖,創(chuàng)建一個(gè)款式圖樣本庫(kù)。為減少樣本不均勻造成的誤差,每種領(lǐng)型各收集200張,共得到800張服裝款式圖,通過(guò)數(shù)據(jù)增強(qiáng)[13]的方式,將樣本庫(kù)擴(kuò)充為1 800張,其中訓(xùn)練集為1 600張,測(cè)試集為200張,4種領(lǐng)型樣本數(shù)量均勻分布。款式圖源于網(wǎng)絡(luò)設(shè)計(jì)素材,主要為白底背景,不含有噪音。由于Mask R-CNN對(duì)圖像質(zhì)量要求較低,樣本庫(kù)中圖像分辨率范圍為437×459像素到2 480×3 508像素。

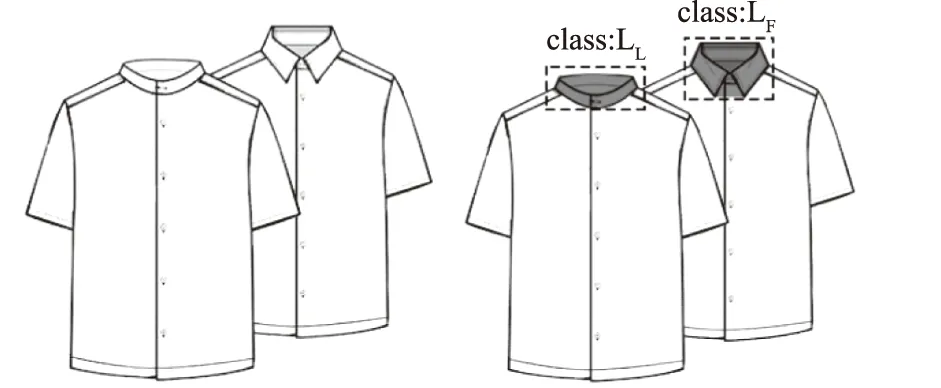

2.2 數(shù)據(jù)集制作

將樣本庫(kù)中樣本運(yùn)用深度學(xué)習(xí)圖像標(biāo)注工具VIA (VGG Image Annotation) 進(jìn)行人工Mask框選以及類別標(biāo)注,使用多邊形線段描出所有領(lǐng)型區(qū)域與領(lǐng)型輪廓,根據(jù)領(lǐng)型賦予標(biāo)簽“LL”“LF”“LW”和“LB”。當(dāng)一張圖像中含有2個(gè)款式時(shí),對(duì)2個(gè)款式的衣領(lǐng)處進(jìn)行對(duì)應(yīng)標(biāo)注,款式圖標(biāo)注格式如圖3所示,陰影區(qū)域?yàn)樵摽钍綀D領(lǐng)型的mask,并在屬性中選取對(duì)應(yīng)class標(biāo)簽。將標(biāo)記好的圖像保存為json格式,作為神經(jīng)網(wǎng)絡(luò)讀取數(shù)據(jù)。

表1 領(lǐng)型特點(diǎn)與款式圖

圖3 款式圖標(biāo)注格式Fig.3 Labeling format of garment flat

2.3 Mask R-CNN實(shí)驗(yàn)

實(shí)驗(yàn)采用Python語(yǔ)言、TensorFlow框架編程實(shí)現(xiàn),基于臺(tái)式電腦Windows 10操作系統(tǒng)[Intel (R) Core (TM) i7-8700 CPU,3.20 GHz,32 GB],GPU為MSI RTX 2060。實(shí)驗(yàn)針對(duì)款式圖特點(diǎn)與樣本庫(kù)數(shù)量進(jìn)行參數(shù)修改。

由于人工采集的數(shù)據(jù)集較少,為了防止算法在訓(xùn)練過(guò)程中發(fā)生過(guò)擬合現(xiàn)象,采用遷移學(xué)習(xí)方法,利用MS COCO公用數(shù)據(jù)集進(jìn)行網(wǎng)絡(luò)預(yù)訓(xùn)練。該數(shù)據(jù)集適用于圖像分類與語(yǔ)義分割,保存訓(xùn)練后網(wǎng)絡(luò)的權(quán)重。

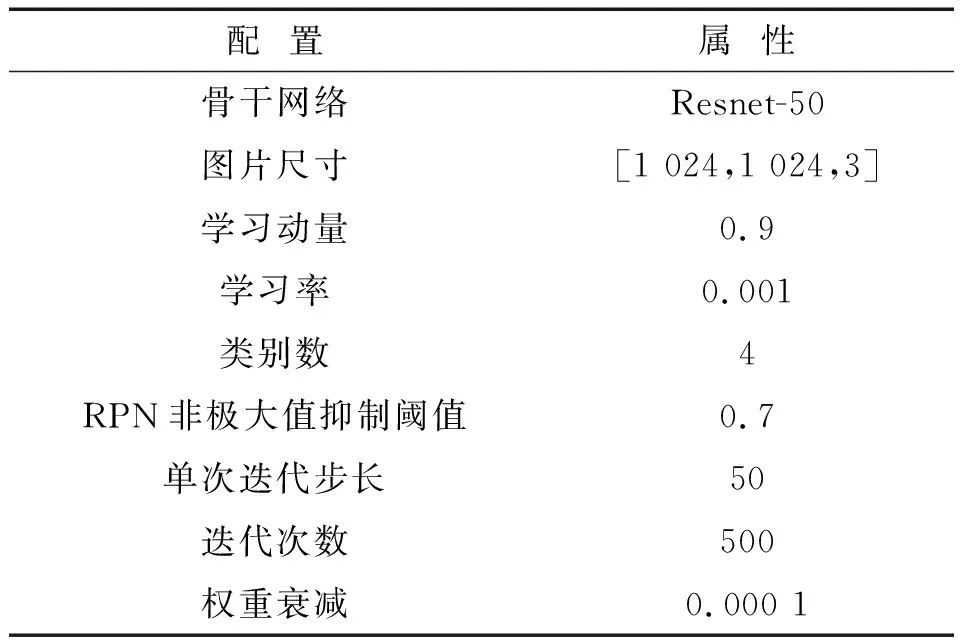

網(wǎng)絡(luò)主要結(jié)構(gòu)參數(shù)見(jiàn)表2。由于款式圖中領(lǐng)型特征信息較少,運(yùn)用多層數(shù)隱含層骨架網(wǎng)絡(luò)容易產(chǎn)生過(guò)擬合現(xiàn)象,因此將Mask R-CNN網(wǎng)絡(luò)默認(rèn)的卷積神經(jīng)網(wǎng)絡(luò)模型ResNet-101修改為ResNet-50,迭代次數(shù)(epoch)為500,每次迭代訓(xùn)練圖片張數(shù)(steps-per-epoch)為50,學(xué)習(xí)率為0.001,權(quán)重下降為0.000 1。Mask R-CNN分類過(guò)程如圖4所示。

表2 Mask R-CNN主要參數(shù)

圖4 Mask R-CNN分類過(guò)程Fig.4 Classification process of Mask R-CNN

3 結(jié)果與分析

3.1 Mask R-CNN識(shí)別結(jié)果

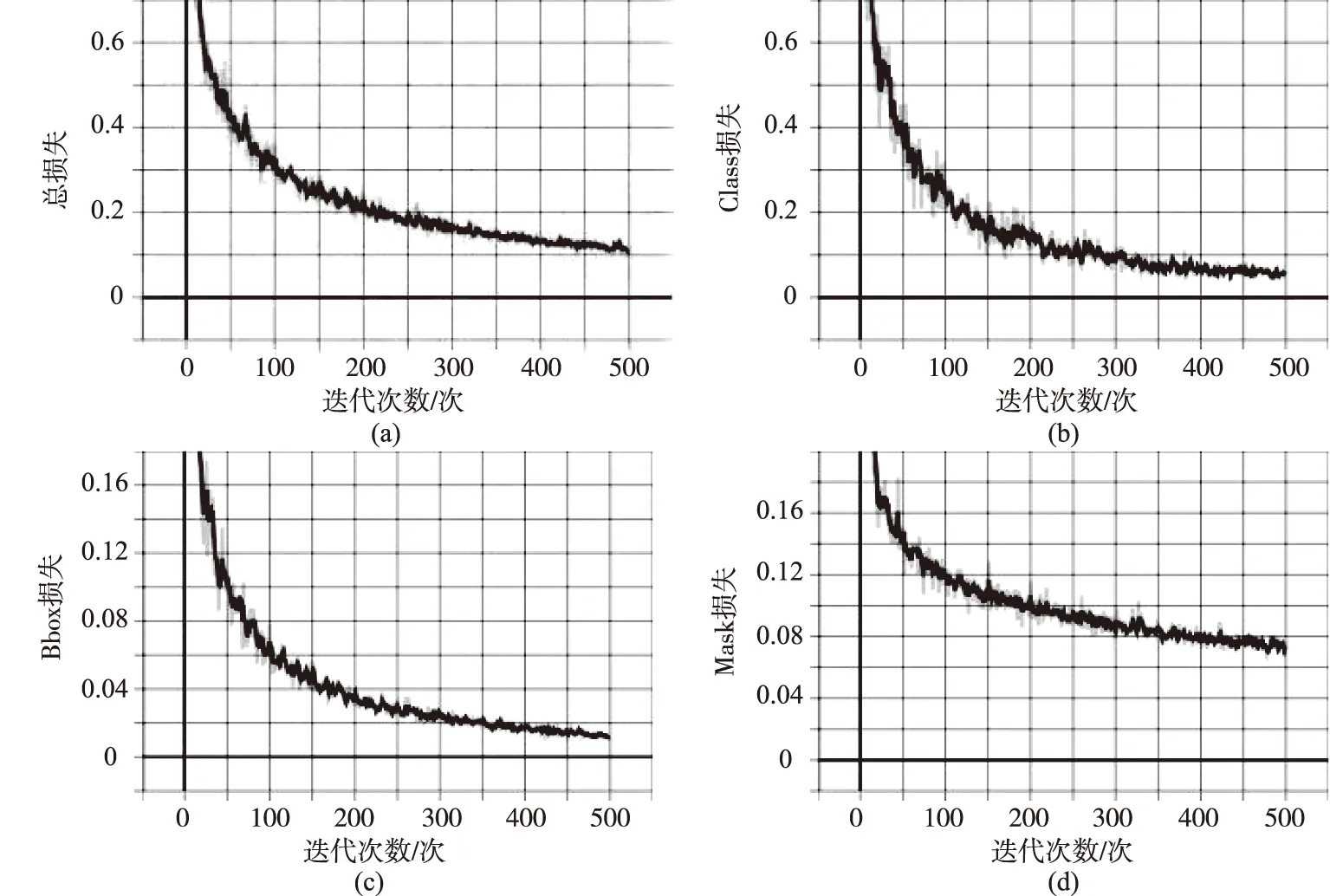

3.1.1訓(xùn)練結(jié)果分析 實(shí)驗(yàn)采用Mask R-CNN網(wǎng)絡(luò)是為了將服裝款式圖中衣領(lǐng)位置進(jìn)行定位,并根據(jù)標(biāo)定框中提取的領(lǐng)型特征信息進(jìn)行類型識(shí)別。網(wǎng)絡(luò)的各損失函數(shù)如圖5所示,從網(wǎng)絡(luò)損失圖可知,網(wǎng)絡(luò)訓(xùn)練結(jié)果良好,沒(méi)有出現(xiàn)過(guò)擬合現(xiàn)象。

由圖5可知,總損失、class損失、bbox損失和mask損失都在穩(wěn)定收斂。其中總體損失函數(shù)在迭代次數(shù)達(dá)到400后,總損失趨近0.1;class損失在迭代次數(shù)達(dá)到400時(shí),損失低于0.01;bbox損失在迭代次數(shù)達(dá)到400后已經(jīng)穩(wěn)定波動(dòng),mask在迭代次數(shù)達(dá)到450次后也趨于穩(wěn)定。

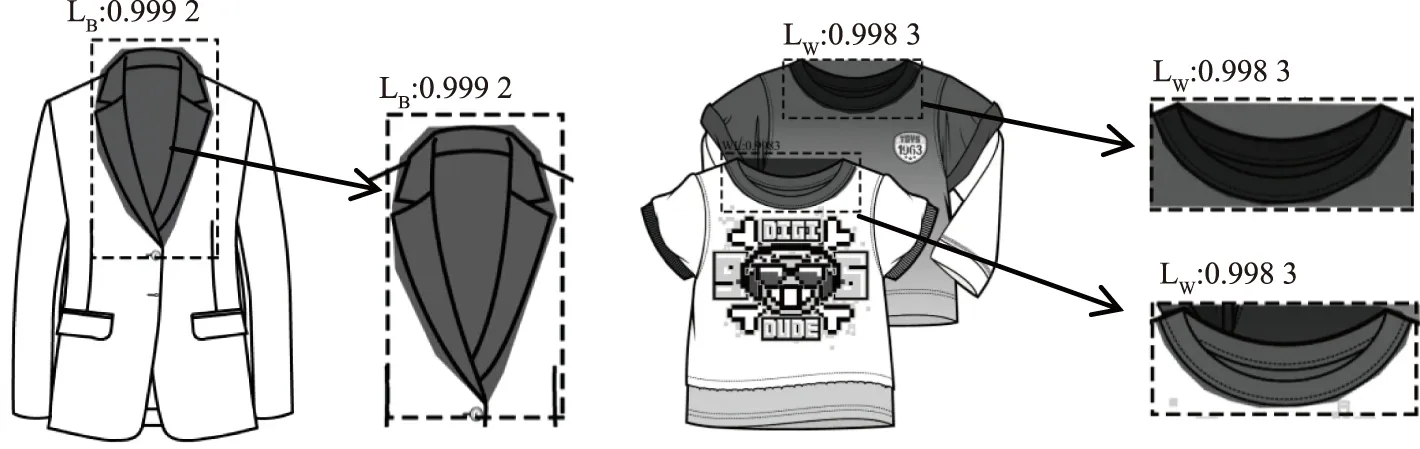

3.1.2識(shí)別結(jié)果 隨機(jī)抽取測(cè)試集中的款式圖進(jìn)行識(shí)別測(cè)試,針對(duì)領(lǐng)型識(shí)別精度而言,單個(gè)領(lǐng)子識(shí)別精確度為99.9%;包含2個(gè)領(lǐng)型的款式圖的識(shí)別精確度為99.8%,識(shí)別結(jié)果如圖6所示。其中掩碼mask能夠完整覆蓋領(lǐng)型區(qū)域,標(biāo)定框box準(zhǔn)確檢測(cè)出領(lǐng)型所在區(qū)域。

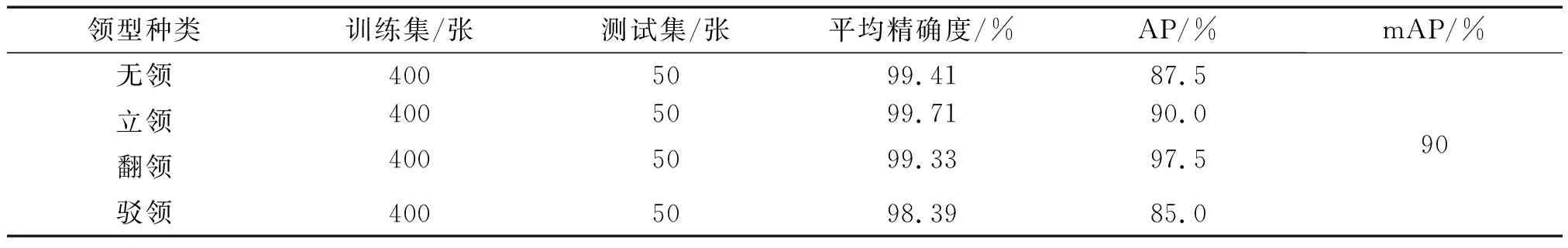

表3為Mask R-CNN的實(shí)驗(yàn)結(jié)果。由表3可知,所有領(lǐng)型的平均識(shí)別精確度達(dá)到98%以上,無(wú)領(lǐng)、立領(lǐng)與翻領(lǐng)的平均識(shí)別精確度達(dá)到99%以上,并且mAP值為90%,表明文中實(shí)驗(yàn)方法取得良好結(jié)果,對(duì)款式圖領(lǐng)型分類與定位具有較高的精確度。其中,無(wú)領(lǐng)與駁領(lǐng)的AP不足90%,這主要是由于4種領(lǐng)型中無(wú)領(lǐng)和駁領(lǐng)的細(xì)部領(lǐng)型形態(tài)和形狀差異較大,box定位與mask標(biāo)注不能完全與測(cè)試集標(biāo)注重合,導(dǎo)致在計(jì)算AP時(shí)IoU值下降。

圖5 損失函數(shù)曲線Fig.5 Loss function curve

圖6 識(shí)別結(jié)果Fig.6 Recognition result

表3 Mask R-CNN實(shí)驗(yàn)結(jié)果

3.2 實(shí)驗(yàn)對(duì)比分析

為驗(yàn)證改進(jìn)后的Mask R-CNN網(wǎng)絡(luò)對(duì)服裝款式圖領(lǐng)型分類的優(yōu)勢(shì),將基于Mask R-CNN識(shí)別分類方法與尹光燦等[11]在領(lǐng)型分類中提出的Canny邊緣檢測(cè)算法結(jié)合AlexNet卷積神經(jīng)網(wǎng)絡(luò)模型的方法進(jìn)行對(duì)比。采用數(shù)據(jù)增強(qiáng)后的數(shù)據(jù)庫(kù)進(jìn)行實(shí)驗(yàn),研究發(fā)現(xiàn),相對(duì)于AlexNet的衣領(lǐng)識(shí)別,Mask R-CNN方法在提高服裝領(lǐng)型分類準(zhǔn)確率方面具有優(yōu)勢(shì),且不需要人工截取衣領(lǐng)信息,可有效減少人為干預(yù)因素。由于mAP是目標(biāo)檢測(cè)評(píng)價(jià)指標(biāo),所以僅用精確度進(jìn)行對(duì)比,實(shí)驗(yàn)對(duì)比結(jié)果見(jiàn)表4。

表4 識(shí)別精度實(shí)驗(yàn)對(duì)比

由表4可知,AlexNet識(shí)別精確度為20.3%,識(shí)別結(jié)果較差,主要因?yàn)锳lexNet卷積神經(jīng)網(wǎng)絡(luò)對(duì)圖像質(zhì)量要求較高,增加隨機(jī)噪聲的數(shù)據(jù)增強(qiáng)方式對(duì)AlexNet卷積神經(jīng)網(wǎng)絡(luò)造成較大干擾。利用Canny邊緣檢測(cè)算法對(duì)圖片進(jìn)行處理,雖然可以降低網(wǎng)絡(luò)提取領(lǐng)型特征的難度,減少色彩對(duì)領(lǐng)型識(shí)別的影響,進(jìn)而提高領(lǐng)型分類的準(zhǔn)確率,但調(diào)整后的Mask R-CNN網(wǎng)絡(luò)識(shí)別效果更為理想。Mask R-CNN與AlexNet卷積神經(jīng)網(wǎng)絡(luò)方法相比,精確度提高了79.5%;與Canny邊緣檢測(cè)結(jié)合AlexNet卷積神經(jīng)網(wǎng)絡(luò)方法相比,精確度提高了70.3%,并且相較于文獻(xiàn)[11]的方法,Mask R-CNN不需要對(duì)樣本進(jìn)行裁剪、灰度化和邊緣檢測(cè)等預(yù)處理,適用于各類服裝圖像。

4 結(jié)語(yǔ)

文中以衣領(lǐng)款式圖作為研究對(duì)象,通過(guò)改進(jìn)Mask R-CNN目標(biāo)檢測(cè)方法,結(jié)合遷移學(xué)習(xí)對(duì)模型進(jìn)行預(yù)訓(xùn)練,修改Mask R-CNN中的骨干網(wǎng)絡(luò),實(shí)現(xiàn)了對(duì)服裝款式圖中的領(lǐng)型識(shí)別,平均精確度達(dá)到99.2%,mAP值達(dá)到90%。相較于卷積神經(jīng)網(wǎng)絡(luò)方法,該方法對(duì)圖像質(zhì)量要求低,并且不需要對(duì)圖像進(jìn)行裁剪預(yù)處理,可以識(shí)別服裝款式圖部件,準(zhǔn)確率提高79.5%,為二維數(shù)字化樣板生成提供參考與借鑒。