基于深度學習的糧庫測控技術研究進展

高 輝 甄 彤 李智慧

(糧食信息處理與控制重點實驗室;河南工業大學信息科學與工程學院,鄭州 450001)

目前,中國糧食的播種面積約為17.41億畝,糧食總產量達6.64億t,糧食的產量及消費量均占到全球糧食生產量與消費量的四分之一[1,2]。

糧庫測控技術通過計算機、傳感器、攝像頭等設備對糧庫人員、糧區環境及運輸中的糧情變化進行實時檢測[3]。對運糧車的可視化追溯[4],包括車輛檢測、車型識別以及檢測車輛的車牌、車身顏色等信息,確保出入庫車輛一致;對糧食裝卸倉房動態視頻跟蹤,確保在指定倉庫作業。庫區人員監控[5]包括對庫區內工作人員識別考勤;監控倉內作業人員的摔倒等異常行為。糧庫倉房的監控包括監測識別害蟲、發霉、發芽及溫濕度[6];監控倉房內的火焰、煙霧等情況;通過監控糧面高度、空間體積,結合糧食品種倉房信息進行數量檢測。

現有車輛檢測主要是光流法,計算復雜,易受光照影響[7];幀間差分法,對于靜止、塞車車輛的檢出有所困難[8];背景建模法,受光照、背景中非車輛對象移動等影響大[9]。車牌識別有模板匹配[10]、特征統計[11]和機器學習等,前兩種方法復雜度低,但魯棒性不強,相似字符易出錯。機器學習方法[12]理論精度與實際效果有差距。車型識別主要利用車輛的前臉特征[13],根據車牌、車標、車燈、空間曲線特征等進行分類,正確率有待提高。車輛跟蹤[14]特征點的選擇好壞直接影響跟蹤效果。現有人員識別基于子空間的整體特征提取方法有線性判別分析(LDA)、主成分分析(PCA)等[15]。基于局部特征識別方法有Gabor特征、LBP特征等,相比子空間方法只考慮模式全局特征,更多考慮空間特征分布。行為識別手工提取特征方法[16],包括輪廓剪影、運動軌跡(IDT)等,經典IDT算法分類效果好,但特征維度較高,運算資源消耗過大。現有儲糧害蟲檢測[17-19]主要有聲檢測法,聲音信號常常受到傳感器、環境噪聲影響;取樣檢測法側重人工檢測,工作量較大,考慮因素較多;近紅外檢測法不易檢測蟲害較輕的糧食,受糧堆濕度影響較大;電導率檢測法只能檢測活蟲,不適用于蟲卵、幼蟲的檢測。現有糧堆溫度預測模型[20,21]主要有基于三傳理論的計算模型、利用有限元法建立溫度場的預測模型,模型預測方法對大量非線性數據處理能力相對較弱。

深度學習網絡通過構建大量神經元節點和多層隱含層結構,將底層特征轉化為更加抽象的高層特征,實現復雜函數的逼近,建立起從輸入到輸出的關系。該方法具備特征自動提取,完美的函數擬合能力,強大的特征表達能力,多類別物體檢測,網絡靈活性、可移植性好等特點[22,23]。除此之外,我國糧庫測控系統主要面臨檢測項目單一、糧庫測控技術落后以及精度偏低等問題。故本文通過總結各種檢測、識別、跟蹤、預測算法的優缺點,著重突出新一代深度學習技術與糧庫系統的結合,將為智能化糧庫的實現做出貢獻。

1 基于深度學習的糧庫出入庫車輛檢測

1.1 車輛檢測

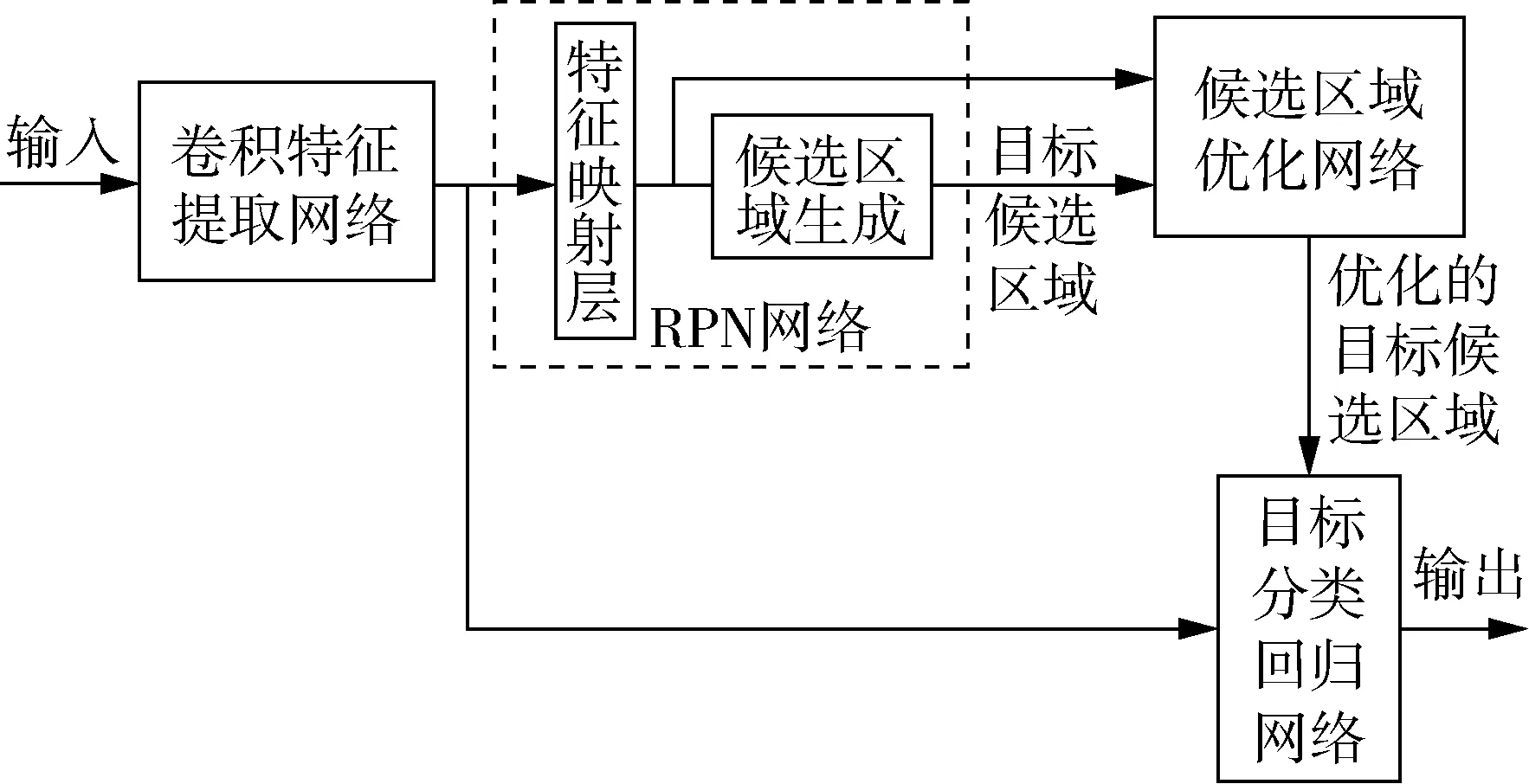

朱立志[24]利用RPN網絡將特征圖上的特征點映射到輸入圖像相應位置,繪制區域建議框,通過計算IoU確定訓練樣本,最終利用分類層確定前景、背景,根據回歸層預測坐標值。Faster R-CNN網絡結構如圖1所示。

圖1 Faster R-CNN網絡結構

結果顯示,在光線微暗等復雜背景下,對車輛檢測準確率達到90%。泛化能力測試,結果準確率達到80%。

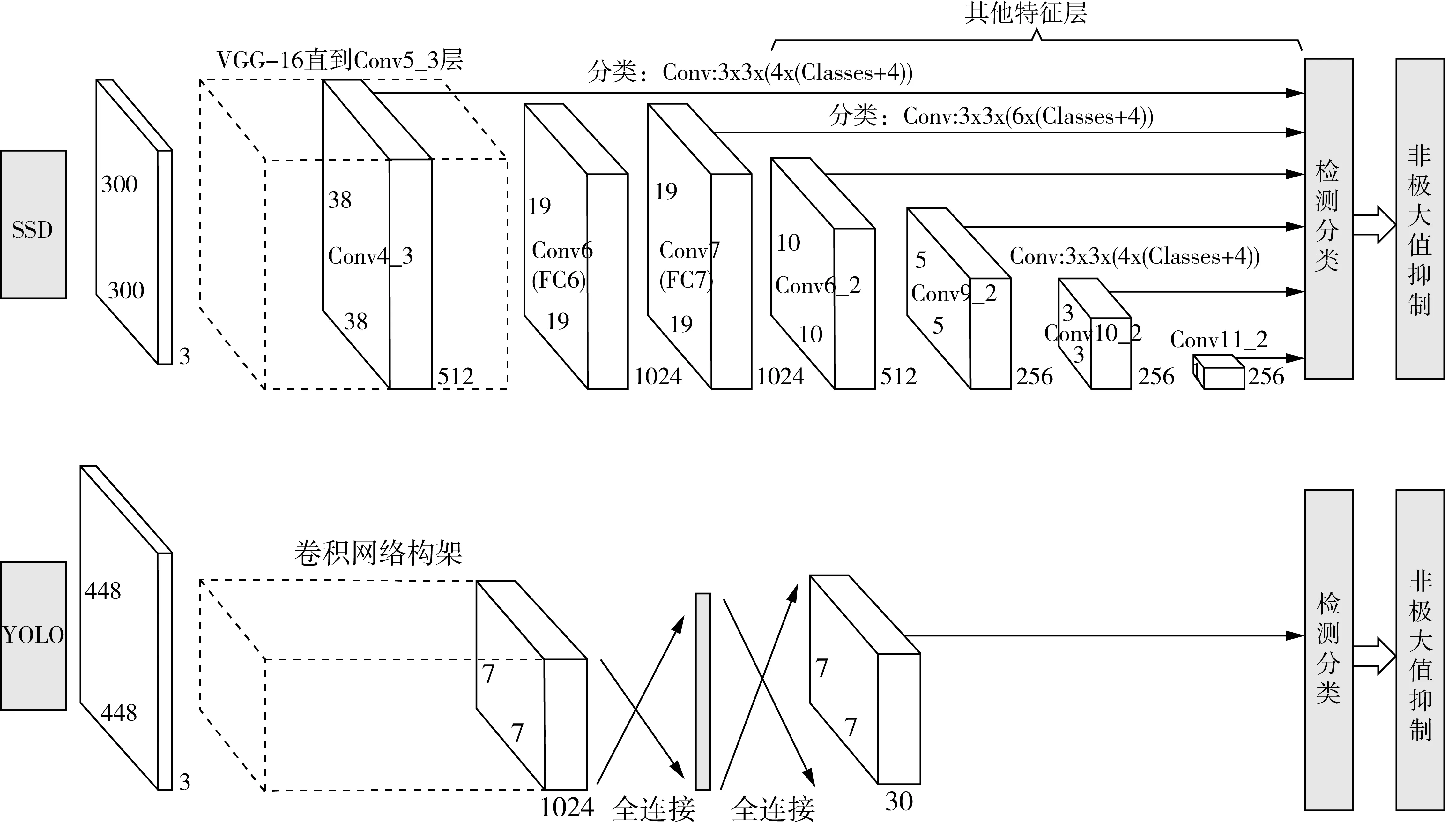

劉肯等[25]利用Skip connection思想改進YOLO算法,輸入直接進入后面的layer,避免梯度消失的同時,加強層之間的特征關系。對比發現,YOLO算法檢測準確率達83.4%,改進后的YOLO-D算法檢測準確率達到87.1%。YOLO及SSD網絡結構如圖2所示。

曹偉[26]認為YOLO算法實時性好,但檢測準確率較低。對Faster R-CNN的可靠性上給予肯定,但認為實際車輛方位多樣、道路復雜,需進一步研究。故提出一種利用不同卷積層上的特征進行多尺度預測的SSD算法,車輛檢測網絡結構前面使用VGG-16網絡作為基礎,后面網絡添加幾個由大到小的額外卷積層,實現多尺度特征圖檢測。在相同檢測樣本條件下,該算法檢測準確率達到90.1%,高于Faster R-CNN的88.4%。陳夢[27]在SSD算法基礎上通過金字塔式多尺度窮盡搜索法改進SSD檢測器,相同條件下,改進的SSD算法檢測率達到98.80%,高于原始SSD算法的97.13%。但對小目標來說,檢測準確率和檢測速度不是太過理想。

1.2 車牌識別

蒙特卡洛方法首先生成一個均值為0,標準差為0.01的正態分布隨機矩陣,判斷隨機矩陣是否符合一致分布,循環迭代,直到生成符合要求的卷積核。李達[28]利用蒙特卡洛方法對卷積核初始化方法進行優化,通過CNN網絡過濾疑似車牌區域,使用滑動窗口掃描車牌圖像,獲取特征圖,通過識別器識別字符,篩選最優解。

結果顯示,CNN網絡特征提取效率高,對光照不均勻、車牌傾斜等具有很好魯棒性。但其方法和步驟比較繁瑣,不能實現實時檢測。

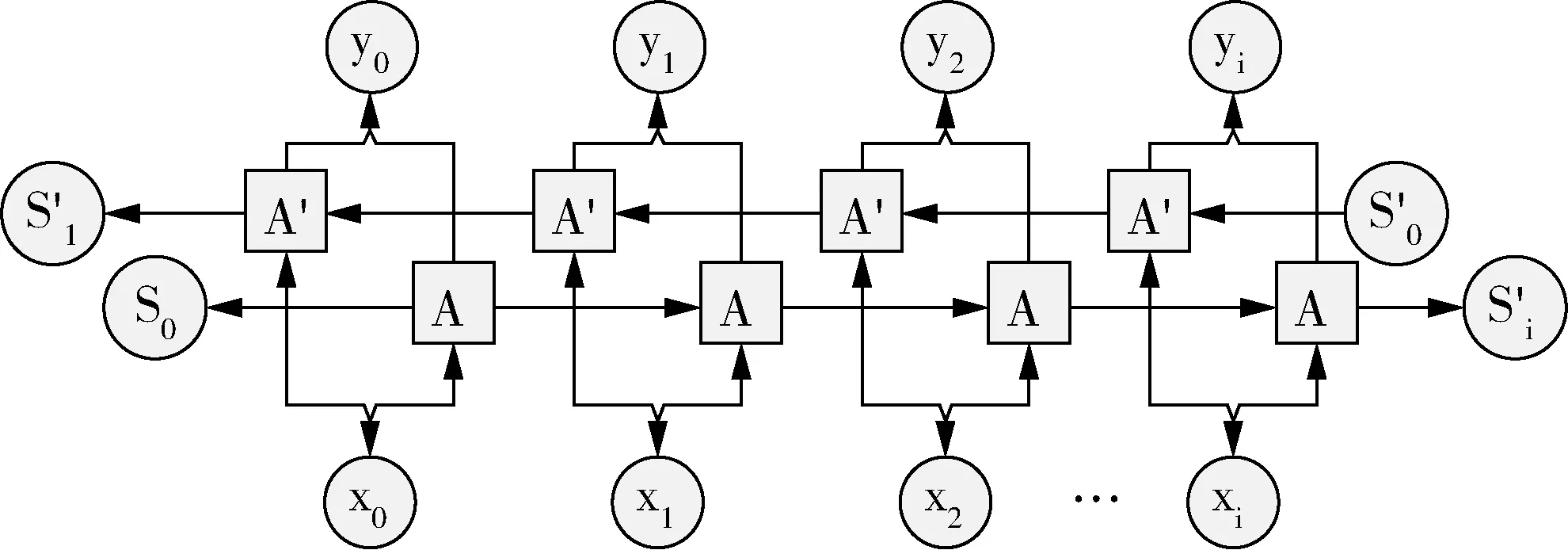

高路[29]直接從RPN產生的候選區域對應的特征圖中識別車牌字符,通過BRNN將車牌識別視為序列標記問題解決,選擇CTC作為損失函數,實現端到端檢測識別。BRNN網絡結構如圖3所示。

圖2 SSD及YOLO網絡結構

圖3 BRNN網絡結構

和基于Faster R-CNN檢測出車牌,再經裁剪送入BRNN進行識別的兩階段方法相比較,端到端的方法在3種數據集上7字符平均識別率為81.64%,識別速度320 ms,優于兩階段方法。但在復雜場景下,仍不滿足實時性要求。

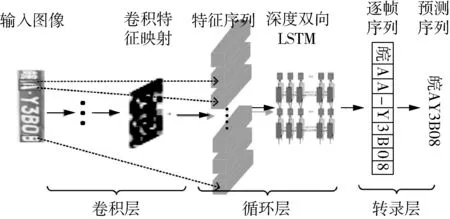

陳強等[30]利用CRNN直接整行循環卷積識別,循環層使用多個雙向傳播的LSTM組件預測標簽分布,再使用轉錄層將預測變為實際標簽序列。實現發現,字符識別準確率達98.06%。且能適應黑暗、強光、車身反光、雨雪天氣、車牌距離很遠或很近、車牌歪斜等情況。CRNN網絡結構如圖4所示。

圖4 CRNN網絡結構

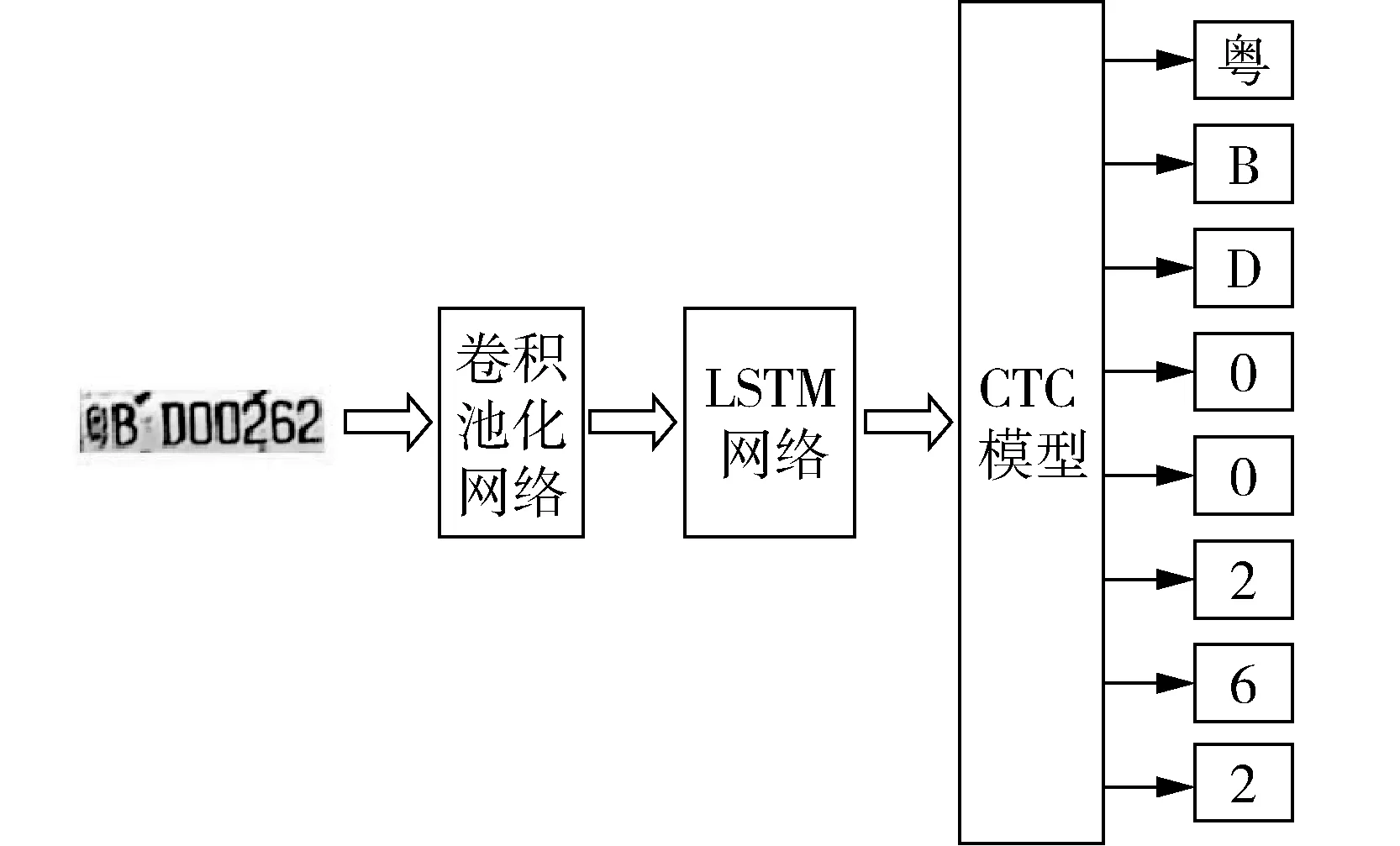

王瀟凡[31]采用將CNN、LSTM型循環神經網絡與CTC目標函數進行網絡模型融合,進行無分割字符序列識別,使用4層卷積、池化提取特征,雙層LSTM作為隱含層網絡,CTC將LSTM習得的特征向量解碼為字符。識別精度達到95.5%,單個樣本識別時間為0.07 s。基于循環神經網絡的OCR車牌識別網絡如圖5所示。

圖5 基于循環神經網絡的OCR車牌識別網絡

針對小數據集,識別精度較高,但該網絡識別字符序列的實時性有待提高。

1.3 車型識別

級聯MT-CNN網絡,通常應用于需要同時進行位置預測、分類等至少兩種學習任務[32]。利用MT-GooGleNet網絡模型進行車輛定位,再送入車型分類的神經網絡中,挖掘出車輛的制造商家、型號與生產年代。

在GooGleNet網絡基礎上增加3組對比實驗,分別進行網絡數據增強、網絡預訓練及同時進行數據增強與預訓練,最高識別正確率達85%,該方法能有效分離相似車型。但需不斷更新車型數據庫,另外在雨雪極端天氣下的車型識別需進一步研究。

劉輝[33]基于深度殘差單元的結構級聯,將大型數據集的分類準確度提升到新高度。實驗通過對比ResNet-50 和 ResNet-101,對于20次測試的分類top-5的準確率,Resnet-50平均準確率達93.7%,優于Resnet-101的90.5%。泛化能力測試上,以GoogleNet網絡為參照,ResNet-50的網絡分類抗干擾能力遠遠高于GoogleNet網絡,但精確識別還需要進一步研究。

吳雙敬[34]提出多階段卷積神經網絡(MS-CNN)解決車型精確識別問題,在ResNet-50基礎上進行優化,網絡S4層后進行空間金字塔池化(SPP),通過SPP多級池化,提取特征圖中多尺度信息;網絡S5層后增加1×1卷積,并利用全局平均池化代替全連接層,實現信息整合、降維,減少過擬合。在MTV-1638s數據集實驗顯示,MS-CNN車型識別精度為95.51%,略高于ResNet網絡。

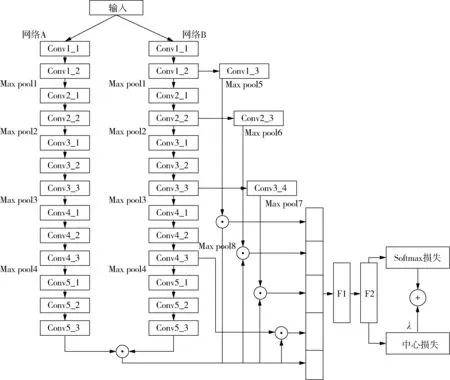

周野[35]提出MS-B-CNN算法進一步研究車型精確識別問題。B-CNN中網絡A主要完成細粒度圖像的區域檢測,網絡B完成提取網絡A檢測到的特征,對K個角度下提取的卷積特征進行線性融合,用融合特征訓練模型分類器實現分類。網絡模型如圖6所示。

圖6 MS-B-CNN網絡結構

實驗發現,基于MS-B-CNN的多尺度特征融合的平均正確率達到93.63%,應用在車輛正面和背面角度,識別準確率達95.73%和95.26%,更好的基礎網絡會進一步提升識別效果。

1.4 車輛跟蹤

車輛跟蹤的實現結合運動檢測、車輛識別及跟蹤三個模塊[26]。運動檢測模塊通過高斯混合背景建模,篩選出運動區域。多尺度特征圖預測的SSD車輛檢測算法提取圖像特征,區分是否存在車輛。車輛跟蹤利用Kalman濾波算法預測視頻車輛的下一幀位置坐標,利用Camshift算法迭代搜索當前幀的實際位置,循環往復,直至目標車輛丟失為止。結果顯示,該方法對車輛的跟蹤實時性好,準確性高,但對小目標車輛的檢測跟蹤效果還需進一步研究。

杜省[36]研究三種車輛跟蹤算法,基于k稀疏深度降噪自編碼器的目標跟蹤算法采用深度降噪自編碼器作為離線訓練模型,學習目標的通用特征,通過引入k稀疏限制構造分類神經網絡,學習輸入的不變性特征,輸出特征向量空間點的置信度,根據粒子置信度計算概率并更新權值以決策車輛位置;相比前者,基于多深度自編碼器融合的目標跟蹤在離線訓練模型時利用兩個深度自編碼器學習灰度特征和梯度特征,進行線性融合;基于多深度自編碼器自適應融合的目標跟蹤不僅利用兩個深度自編碼器學習灰度特征和梯度特征,而且構建兩個分類神經網絡,結合粒子濾波算法,根據不同特征圖的粒子分布情況,選取前10%置信度最大的粒子作為最優粒子,自適應確定特征融合權值,最終實現目標狀態估計。實驗顯示,三種方法的跟蹤準確性和跟蹤魯棒性取得較好效果。

2 基于深度學習的糧庫人臉識別及行為識別

2.1 人臉識別

BP網絡人臉識別使用滑動窗口獲取Harr的矩形特征,網絡訓練利用反向傳播算法將最后產生的誤差逆向回傳網絡模型,循環迭代使參數最優,然后進行人臉圖片的特征提取。將待測人臉的特征向量與人臉特征數據庫相對比,判定人員身份。該系統能穩定、實時的進行人臉提取。但該網絡需大量樣本訓練,且存儲空間較大。

萬士寧[15]通過保留原始VGG-16底層網絡模型,增加Block5的卷積核,去掉全連接層-1與全連接層-2,縮減參數數量和計算存儲時間。前12卷積層參數采用Karen Simonyan公布的VGG-16權值參數,其余層重新訓練。網絡人臉識別準確率達94.0%。但對于復雜圖片(未預處理)識別效果稍差,需要更多圖片訓練提高泛化能力。根據上述缺點,采用34層Residual卷積神經網絡,用滑動步長2的卷積操作代替Pooling,網絡初始化方法采用隨機初始化。網絡人臉識別準確率達96.0%。該方法網絡層次較深,適用Casia-WebFaceResidual Netork等大型數據集。

圖7 multi-CNN網絡

圖8 雙通道DCNN網絡結構

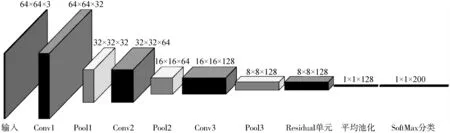

柯鵬飛等[37]提出一種基于改進CNN網絡和集成學習方法,由兩個CNN組成一個multi-CNN,采用投票法集成策略將多個學習器結果凸組合并為最終結果。CNN網絡前兩層卷積核采用5×5,最后一層采用3×3卷積核,每層后采用2×2池化,Residual單元分別利用1×1、3×3、1×1卷積核控制輸入向量與輸出向量,最終采用平均池化層代替全連接層。multi-CNN網絡模型如圖7所示。

實驗顯示,在Color FERET、AR和ORL數據集的識別率分別達 98.89%、99.67%和100%。

2.2 行為識別

雙流卷積神經網絡進行行為識別時,重點是通過獨立的時間和空間雙通道進行行為特征提取及融合,即空間通道是通過視頻中靜止的每一幀RGB圖像來提取靜態特征信息,時間通道是提取每一幀水平方向和豎直方向上的光流分量及光流幅值,來表征動態特征信息。再通過加權平均的方法將各自通道的單幀對象轉換為空間通道視頻特征與時間通道視頻特征,實現時空信息融合,給出綜合判定結果。通過實驗,在KTH行為數據集上獲得96.18%的識別準確率[38,39]。雙通道DCNN網絡結構如圖8所示。

實驗發現,雙流卷積神經網絡的行為識別取得較好識別效果。但離實際應用還有一定距離,網絡訓練需要更多的數據支持,往往還需要考慮動作的時序信息。

3 基于深度學習的儲糧安全測控技術

3.1 火焰識別

糧庫的重點工作基本都放在預防為主,即對溫度和濕度的監控以及使用煙火報警器的預警,伴隨深度學習在各領域蔓延,利用神經網絡進行煙火識別的研究逐步拓展。

R-FCN+ResNet火焰檢測模型,第一部分采用ResNet深度卷積網絡自動提取特征;第二部分R-FCN通過特征譜圖捕獲疑似火焰區域集合,給出分數圖;第三部分設為二次分類模型,根據給出的位置信息,截取原始圖片中的火焰圖像,送進ResNet中進行二次識別[40]。

結果顯示,該方法對Biilkkent大學的視頻數據集上的識別精度達到98.25%,并且誤報率低、穩定、可靠。

3.2 糧蟲識別

劉治財[17]分別對比Faster R-CNN、R-FCN和YOLO網絡,基于VGG-16、ResNet-101為基礎的Faster R-CNN算法在測試數據集上的平均準確率達74.24%、81.36%,因ResNet-101網絡存在大量重復計算,故在該網絡基礎上,采用R-FCN算法,平均準確率達83.44%。YOLO算法在Google-Net網絡上,平均準確率只達到68.77%。為了進一步提高精度,基于R-FCN算法,將基礎網絡改為網絡更深但是參數更少的DesNet-121網絡,平均準確率達到85.28%。

高雅[18]選取糧倉表面、糧蟲較多的位置及墻壁,搜集糧蟲圖片,形成數據集;在Keras框架下運用Sequential模型,調整不同的激活函數,對比七層CNN與九層CNN,并對九層CNN進行隨機失活方法(Dropout)的參數優化,對比不同卷積神經網絡模型下的訓練集及驗證集的識別準確率。

實現顯示,Relu函數的識別準確率較高,迭代次數少,曲線平滑。在此基礎上對比兩種不同卷積神經網絡,七層卷積神經網絡在迭代20次時,驗證數據集的識別準確率為80%,改進后的九層卷積神經網絡在迭代10次時,驗證數據集的識別準確率為98.6%。但該方法未能實現對多個生長期及多種類糧蟲的識別,實時識別有待進一步研發。

3.3 糧堆溫度預測

糧食儲藏過程中,影響最大的便是溫度。 BP網絡將影響因子作為輸入數據,將實際溫度作為輸出結果,在預測結果與實際結果的誤差大于期望值時,對誤差進行反向傳播,更新各層神經元的權值和閾值。因BP神經網絡的初始閾值和權值是自己學得,具有隨機性,因此提出GANPSO-BP算法,通過粒子群算法尋覓目標最優解,并對粒子的慣性權重和閾值進行優化,同時利用遺傳算法對尋優過程進行優化[41]。

測試數據來自華東某糧庫2016年前11個月的糧倉數據,以此預測12月份糧倉中糧堆底層的平均溫度。對比BP,PSO-BP和GANPSO-BP算法,GANPSO-BP算法的預測結果誤差數值相對較小,穩定性較高。

在考慮小數據量的情況下,提出基于循環神經網絡的糧倉溫度時間序列預測方法,而RNN網絡容易出現梯度消失與梯度爆炸,提出基于循環神經網絡-長短時記憶法(RNN-LSTM)糧倉溫度時間序列預測模型。

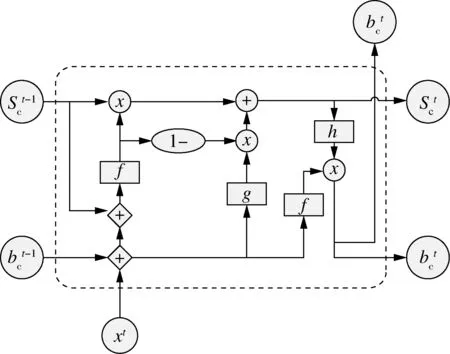

LSTM模型在原有RNN模型的基礎上,增加了選擇性學習的細胞狀態,主要通過遺忘門、輸入門和輸出門來控制細胞狀態。CLSTM是在LSTM基礎上的變形,把遺忘門與輸入門合并為新的門限單元。實驗對比,選用CLSTM作為預測模型細胞體,選用改進SRelu激活函數,選擇L2正則化,提升泛化能力。由于梯度下降算法造成冗余計算,故采用隨機梯度下降算法,有效避免使用所有樣本進行參數更新[42]。CLSTM單元模塊圖如圖9所示。

圖9 CLSTM單元模塊圖

測試數據來自山東某糧庫2015年全年和2016年前十個月的糧倉數據,以此預測2016年后兩個月情況。輸入數據包括糧倉外部溫濕度、糧倉內部溫濕度及糧堆溫度,主要預測糧堆底層溫度的平均溫度。通過在相同條件下對比RNN、LSTM、GRU及CLSTM方法,CLSTM均方誤差最低,而改進后的CLSTM方法預測結果更好。

3.4 糧食籽粒檢測與計數

糧食籽粒檢測與計數主要使用圖像處理,分水嶺算法、大津閾值法等,都有一些無法克服的缺點,為更加準確的識別粘連籽粒,基于深度學習的糧食籽粒檢測與計數的方法及裝置走進視野[43]。

網絡模型的構建,主要包括小目標特征提取、密集特征提取及目標檢測。特征提取主要通過密集連接各個卷積層,并在各層間增加篩選策略,根據刪除連接后精度的變化情況,篩選出最優連接。目標檢測通過生成目標候選框及標注概率值的方法,采用雙線性插值方法提高圖像特征。訓練模型,直至誤差很小。

對于實際糧食籽粒數9 033顆,檢測出9 068顆,正確檢測出9 024顆,9顆漏檢,誤檢44顆。

3.5 糧庫視頻監控圖像去霧

在糧庫中,糧食的出入運輸、裝卸、糧面翻動等作業,都會產生大量的粉塵,并結合霧霾等天氣因素,獲取的圖像的顏色、紋理等細節信息嚴重弱化[44,45]。

去霧圖像的獲取取決于大氣散射模型中全局大氣光及圖像透光率的準確估計,而圖像中的亮白色區域往往對大氣光估計造成影響。通過四叉樹分解法對大氣光進行估計,即把圖像以遞歸形式分割四象限,將最終區域的亮度平均值作為大氣光。圖像透光率依托多尺度卷積神經網絡進行特征學習及特征融合獲得粗濾圖,與灰度圖像融合后得到細化圖像,利用大氣散射模型生成清晰圖像。利用2 000幅清晰圖像,根據大氣散射模型以及透射率隨景物到成像設備的距離成反比,生成霧霾圖像數據集,進行訓練。霧塵圖像處理流程如圖10所示。

圖10 霧塵圖像處理流程

結果顯示,該方法在圖像邊緣的處理結果好,提取效果對視覺更舒服,顏色比較亮,對天空區域及亮白色區域的處理比較自然,較好的去除霧氣,不僅適用合成圖像,而且適用真實圖像。

4 結論

對比發現,Faster R-CNN兩階段檢測模型,精度高,但是運算速度慢、訓練起來相對困難,YoLo單階段檢測模型,運算速度快,效率高,但是精度較差;深度學習方法對基礎網絡的依賴性較強,通過選擇高性能的基礎網絡能從根本上提高識別效率;在此基礎上,通過改進網絡模型架構、選擇適當激活函數、平衡網絡參數、優化卷積核初始方法、保證大數據集樣本訓練、進行特征網絡融合等,可進一步提高識別效果;與此同時,深度學習方法的檢測識別、預測等效果參差不齊,對于高性能骨干網絡的構建、更加豐富的圖像信息的獲取、小目標物體的高精度檢測、多類別復雜環境檢測、檢測算法的輕量化需求等,將是深度學習獲得全面推廣必須克服的困難。

近年來,我國已建立健全中央、省、市、縣四級糧食儲備體系,第四代依托無線傳感網絡的糧庫測控系統逐漸開始部署,依托現有常規檢測方法的優勢,嘗試性利用深度學習的一些成熟方法進行補漏,從實踐挖掘出深度學習方法的不足之處,逐步完善,將進一步建立健全糧庫測控系統。