基于深度Q學習的電熱綜合能源系統能量管理

王新迎,趙琦,趙黎媛,楊挺

(1.中國電力科學研究院有限公司,北京市 100192;2.天津大學電氣自動化與信息工程學院,天津市 300072)

0 引 言

隨著社會的不斷發展進步,人類對于能源的需求不斷增大,而石油、煤炭等傳統化石能源日漸枯竭,發展環境友好的可再生能源、提高能源利用效率是當今世界共同關注的焦點。綜合能源系統(integrated energy system, IES)可實現能源的梯級利用以及多種能源的協調互補,是緩解環境壓力的重要選擇[1-2]。在能源需求中,電能與熱能是人類生活的基本能源需求,也是綜合能源系統的兩大主要能源形式[3]。電熱綜合能源系統并非2個獨立供能系統的直接疊加,而是通過對多種能量單元的協同管理,在更大范圍內實現系統資源的優化配置。

多種能量單元的共存和使用使得如何對電熱綜合能源系統進行能量管理以實現系統的運行優化得到廣泛關注。針對綜合能源系統的能量管理,文獻[4]研究了含光伏、風機、儲能及熱電聯供機組等單元的微網運行優化問題,將模型轉化為混合整數線性規劃問題求解;文獻[5]利用改進的遺傳算法,進行工業園區綜合能源系統的能量管理方法研究;文獻[6]研究了含可再生能源發電的電熱綜合能源系統的優化調度問題,利用改進的粒子群優化算法求解能量調度方案。上述研究在綜合能源系統的能量管理和優化調度方面取得了一定的成果,但這些工作均是在對可再生能源出力和負荷需求進行預測的基礎上進行的,求解效果依賴于預測的準確性。然而,受天氣變化的影響,可再生能源發電是高度間歇性和隨機性的。這些不確定性的資源與亦具有不確定性的用戶負荷相結合,導致系統中供需雙側隨機變化,為系統的能量優化管理帶來巨大挑戰。

為了應對綜合能源系統中的不確定性,文獻[7-8]采用隨機規劃方法對不確定性進行建模,分析不確定性因素的概率分布。然而,傳統隨機規劃方法中誤差場景的數目直接影響能量管理模型的求解效果。若場景數目過少,則難以真實反映可再生能源的不確定性;而場景數目過多,則求解難度及求解時間會大幅增加。此外,文獻[9-10]采用魯棒優化技術將不確定性因素采用不確定性集進行刻畫,求取在最壞情況下的最優運行方案。然而,魯棒優化算法采用不確定性集對不確定性因素進行刻畫,往往難以選取合適的不確定性集[11]。

為了克服上述方法的缺點,本文引入無模型的強化學習(reinforcement learning, RL)方法以應對電熱綜合能源系統能量管理問題中可再生能源(源)和異質負荷需求(荷)的不確定性問題。基于馬爾可夫決策過程(Markov decision process, MDP)理論的強化學習是一種重要的機器學習方法,具有強大的自主學習能力和適應能力[12]。強化學習中的智能體通過和環境進行交互,通過“試錯”的方式不斷自適應地學習探尋到最優策略[13]。強化學習不需要系統不確定因素的分布知識,是解決含不確定性因素的優化問題的很有潛力的方法,已被作為潛力解決方案引入智能電網、建筑等的運行優化和能量管理中[14-15]。

在采用強化學習進行綜合能源系統的能量管理方面,已有學者進行了初步探索。文獻[16]將綜合能源微網的調度問題建模為馬爾可夫決策過程,采用納什(Nash)博弈和Q-learning算法實現能量管理及多主體運行策略的制定。文獻[17]為應對系統中光伏出力和異類負荷的隨機不確定性,提出了一種基于Q-learning的冷熱電聯供微網能量調度方法。文獻[18]提出了一種基于強化學習的智慧能源樞紐運行優化方法,所提方法不需要系統動力學的任何知識,能夠同時降低電費和天然氣費用。然而,傳統的強化學習是表格型的方法,僅適用于離散狀態空間或小狀態空間問題。如果直接采用強化學習處理綜合能源系統的能量管理問題,需要將系統的狀態量進行離散,離散化得到的狀態數量隨著自由度的增加會呈指數倍增長,從而出現維數災難問題[19]。為應對該問題,本文將深度強化學習引入所研究的問題中,提出一種基于深度Q學習網絡(deep Q-learning network,DQN)的電熱綜合能源系統能量管理方法。深度Q學習網絡采用深度學習對Q-learning進行函數近似,避免對狀態空間的離散化操作。此外,不同于傳統方法,本文所提方法不需要可再生能源出力以及電熱負荷需求的預測信息,能夠自適應地對源和荷的隨機波動做出響應。

文章首先對強化學習方法進行詳細介紹,然后確定電熱綜合能源系統的能量優化管理問題的目標和約束,并將該問題表述為馬爾科夫決策過程,進而采用DQN求解電熱綜合能源系統的能量管理問題。

1 強化學習方法

1.1 馬爾科夫決策過程

強化學習的經典研究是基于馬爾科夫決策過程[19],即系統下一時刻狀態僅與當前時刻狀態和動作有關。其問題模型通常被表示為一個元組

智能體在當前狀態s采取動作a∈A(s),收到環境反饋的獎勵r(s,a),并且以T(s,a,s′)的概率轉移到下一狀態s′∈S,其中A(s)表示在狀態s可采取動作的集合。此過程可無限進行下去,也可以到終止狀態處結束。策略π為狀態到動作的映射:S×A→[0,1]。智能體的目標是通過調整策略來最大化累積獎勵。通常可以使用狀態-動作值函數Qπ(s,a)來衡量某個策略π的優劣程度。給定一個策略π,狀態-動作值函數定義如下:

(1)

式中:Eπ[·]是策略π下的期望;s0是初始狀態;a0是初始動作;t是時間槽的索引;rt是時間槽t時的獎勵;γ∈[0,1]為折扣因子,表示未來獎勵在累積獎勵中所占的影響比重,γ越大表示越重視對未來的獎勵。

1.2 Q學習算法

Q學習算法是解決馬爾科夫決策過程的經典方法,是一種不基于環境模型的強化學習算法。在Q學習算法中,內部維護一個狀態-動作值函數表Q(st,at),采用Q(st,at)值代表在狀態st執行動作后獲得的累積折扣獎勵。智能體通過與環境反復地交互,利用獲得的反饋信息不斷地訓練更新值函數,最終學習到完成目標的最優策略。Q函數的迭代更新公式表示如下:

Qt+1(st,at)=Qt(st,at)+αδt

(2)

式中:α為學習率;δt表示時間差分誤差,表示為:

δt=rt+1+γQt(st+1,a′)-Qt(st,at)

(3)

式中:a′是狀態st+1時能夠執行的動作。

1.3 DQN算法

經典強化學習是表格型的方法,在處理高維狀態空間或連續狀態空間的問題時,存在維數災難的問題。受深度學習[20]強大表征能力的啟發,研究人員將深度學習和強化學習相結合,得到了深度強化學習。深度強化學習采用深度學習對強化學習進行函數近似,利用深度神經網絡強大的函數逼近能力,使智能體不需要遍歷每個狀態或狀態-動作對就可以對值函數進行表征,因此避免了維數災難問題。深度強化學習使強化學習能夠擴展到一些以前難以處理的問題,比如高維狀態空間下的決策問題[21]。

DeepMind公司在Q學習算法和深度學習的基礎上,提出了深度Q學習網絡(DQN)[22]。DQN使用了經驗回放機制和目標網絡技術,其訓練過程如圖1所示。

圖1 DQN訓練過程示意圖Fig.1 The training process of DQN

經驗回放機制:強化學習中的樣本是有關聯的,訓練結果難以收斂。經驗回放機制通過存儲智能體的經驗et=(st,at,rt,st+1)形成記憶序列。訓練時,每次從經驗回放池中隨機提取小批量的經驗,然后根據隨機梯度下降法更新網絡參數。

目標網絡:為了使DQN算法的性能更穩定,建立2個結構一樣的神經網絡,即一直在更新神經網絡參數的Q網絡和用于更新Q值的目標Q網絡。DQN使用參數為θ的深度神經網絡(Q網絡)來逼近動作值函數,表示為Q(s,a;θ) ≈Qπ(s,a)。訓練過程中,通過最小化損失函數進行參數更新:

Lt(θt)=E(s,a,r,s′)[(y-Q(s,a;θt))2]

(4)

式中:Lt(·)為t時的損失函數;θt為t時Q網絡的參數;E(·)表示數學期望;y為Q網絡的優化目標值,表示為:

(5)

E(s,a,r,s′)[(y-Q(s,a;θt))θtQ(s,a;θt)]

(6)

2 電熱綜合能源系統的能量優化管理問題

2.1 電熱綜合能源系統

電熱綜合能源系統通常由能量轉化單元、能量存儲單元、能量傳輸網絡和用戶負荷組成,同時能夠與上級主電網和天然氣供應商進行能量交互。為進行具體分析,本文以如圖2所示的電熱綜合能源系統為例進行研究,系統中的能量轉化單元包括熱電聯供機組(combined heat and power, CHP)、燃氣鍋爐(gas boiler, GB)、電鍋爐(electric boiler, EB)、可再生能源發電(renewable generation, RG)單元光伏,能量存儲單元為蓄電池(battery, BA),用戶負荷包括電負荷和熱負荷。

圖2 電熱綜合能源系統示意圖Fig.2 Schematic diagram of the integrated electricity-heat energy system

電熱綜合能源系統各個元件特性詳述如下:

1)熱電聯供機組。

熱電聯供機組是實現綜合能源系統熱、電聯供的重要設備,其消耗天然氣提供電能和熱能。熱電聯供機組在時間槽t時輸出的電功率計算如下:

PCHP(t)=vCHP(t)HNGηCHP

(7)

式中:PCHP(t)為時間槽t時熱電聯供機組輸出的電功率;vCHP(t)為熱電聯供機組消耗的天然氣量;HNG為天然氣熱值;ηCHP為熱電聯供機組的電效率。

熱電聯供機組輸出熱功率與電功率的比值為熱電比b,可表示為:

(8)

式中:HCHP(t)時間槽t時熱電聯供機組輸出的熱功率。

2)燃氣鍋爐。

燃氣鍋爐消耗天然氣提供熱能,燃氣鍋爐在時間槽t時輸出的熱功率計算如下:

HGB(t)=vGB(t)HNGηGB

(9)

式中:HGB(t)為燃氣鍋爐輸出的熱功率;vGB(t)為燃氣鍋爐消耗的天然氣量;ηGB為燃氣鍋爐的效率。

3)電鍋爐。

電鍋爐消耗電能產生熱能,電鍋爐在時間槽t時輸出的熱功率計算如下:

HEB(t)=PEB(t)ηEB

(10)

式中:HEB(t)為電鍋爐輸出的熱功率;PEB(t)為電鍋爐的輸入電功率;ηEB為電鍋爐的效率。

4)蓄電池。

蓄電池在時間槽t的荷電狀態(state of charge, SOC)為:

SSOC(t)=SSOC(t-1)-ηBA·PBA(t)·Δt/QBA

(11)

式中:PBA(t)是蓄電池的運行功率,為正時表示其處于放電狀態,為負時表示其處于充電狀態;QBA是蓄電池的容量;Δt是相鄰兩個時間槽的時隙長度;ηBA是蓄電池的充/放電系數,表示為:

(12)

式中:ηch∈(0, 1]為蓄電池的充電效率;ηdis∈(0, 1]為蓄電池的放電效率。

2.2 系統能量優化管理問題的數學描述

2.2.1目標函數

綜合能源系統能量管理問題的目標是協調系統中各單元出力,獲得最小化系統運行成本。系統運行成本主要由與主網能量交互成本、消耗的天然氣成本、蓄電池的折舊成本構成。系統總成本表示為:

minC=min(CMG+CNG+CBA)

(13)

式中:C為系統總成本;CMG為與主網能量交互成本;CNG為消耗的天然氣成本;CBA為蓄電池的充放電折舊成本[23]。各項成本具體表示如下:

(14)

(15)

(16)

式中:PMG(t)為時間槽t時綜合能源系統與主網的電力交換功率,為正時表示向主網購電,為負時表示系統向主網售電;εMG(t)為時間槽t時的電價,PMG(t)為正時電價為購電電價,PMG(t)為負時電價為售電電價;εNG(t)為時間槽t時的天然氣單價;ρBA是蓄電池的折舊成本系數;T為對系統進行能量管理所考慮的總時間槽個數。

2.2.2約束條件

綜合能源系統能量管理問題的約束條件包括電功率平衡約束、熱功率平衡約束、外部能源供應約束和元件運行上下限約束。

1)電功率平衡約束。

式(17)為時間槽t時系統電功率平衡約束的數學表述。等式左側包含系統與主電網的電力交互功率、可再生能源發電單元的輸出功率、蓄電池的充/放電功率及熱電聯供單元的輸出電功率,等式右側包括電鍋爐的耗電功率及用戶的電負荷。

PMG(t)+PRG(t)+PBA(t)+PCHP(t)=

PEB(t)+Pload(t)

(17)

式中:PRG(t)為可再生能源發電單元RG的輸出功率;Pload(t)為時間槽t時的用戶電負荷。

2)熱功率平衡約束。

式(18)為時間槽t時系統熱功率平衡約束的數學表述。等式左側包含熱電聯供單元的輸出熱功率、燃氣鍋爐的輸出熱功率及電鍋爐的輸出熱功率,等式右側為用戶的熱負荷。

HCHP(t)+HGB(t)+HEB(t)=Hload(t)

(18)

式中:Hload(t)為時間槽t時的用戶熱負荷

3)外部能源供應約束。

綜合能源系統與主網間的功率交互有上下限約束:

(19)

對于天然氣供應,需滿足以下約束:

(20)

vNG(t)=vCHP(t)+vGB(t)

(21)

4)元件運行上下限約束。

綜合能源系統中各元件均需滿足相應的運行范圍約束,對于熱電聯供單元的輸出電功率、燃氣鍋爐及電鍋爐的輸出熱功率和蓄電池的充/放電功率,分別要滿足如下運行上下限約束:

(22)

(23)

(24)

(25)

對于蓄電池,為了避免深度充放電對蓄電池造成損害,蓄電池的荷電狀態被限定在一定范圍內:

(26)

3 基于深度強化學習的系統能量優化管理

3.1 能量管理問題的馬爾科夫決策過程描述

電熱綜合能源系統能量優化管理的目標是最優地管理系統中各元件在每個時間槽的出力,從而降低系統總運行成本。由于綜合能源系統中間歇性可再生能源出力和電負荷、熱負荷需求是隨機的,綜合能源系統的能量管理問題可以看作是不確定條件下的序貫決策問題。在本節中,將電熱綜合能源系統的能量管理問題表述為馬爾科夫決策過程,定義狀態、動作、狀態轉移函數和獎勵函數。

1)狀態空間描述。

在時間槽t,智能體接收到環境的觀測狀態,即綜合能源系統的狀態st。系統狀態包括用戶負荷(電負荷和熱負荷)、可再生能源發電功率、蓄電池的荷電狀態,以及所處的運行時間槽t。因此,狀態st表示如下:

st=[Pload(t),Hload(t),PRG(t),SSOC(t),t]

(27)

2)動作空間描述。

電熱綜合能源系統能量管理的目標是最優地確定熱電聯供單元的輸出電功率和輸出熱功率、蓄電池的充/放電功率、綜合能源系統和主網的交互功率、GB的輸出熱功率、EB的輸入電功率和輸出熱功率。由于PCHP確定后,HCHP可由式(8)計算得到;HGB確定后,HEB可根據式(18)確定;進而PEB、PMG也可分別通過式(10)、(17)計算確定。也就是說,在PCHP、PBA、HGB確定后,其他量可以迅速得到。將PCHP、PBA、HGB按各自范圍分別劃分為K1、K2、K3個離散的動作選擇,分別均勻離散化為動作空間ACHP、ABA和AGB:

(28)

(29)

(30)

故電熱綜合能源系統的動作可以表示為:

(31)

這里,a∈A,k1∈[1,K1],k2∈[1,K2],k3∈[1,K3]。

3)狀態轉移函數建立。

環境狀態st轉移到狀態st+1表示為:

st+1=f(st,at,ωt)

(32)

式中:ωt表示隨機量。式(32)表示狀態轉移不僅受動作at的控制,而且還受隨機性的影響。對于Pload、Hload和PRG,由于下一時刻的用能需求和可再生能源出力未知,狀態轉移受隨機性影響。由于很難為隨機性建立一個精確的模型,本文并未對其進行建模,而是利用神經網絡學習狀態轉移。

4)獎勵函數構建。

在IES狀態st時,智能體執行動作at后獲得獎勵rt。電熱綜合能源系統能量優化管理的目的是最小化系統運行成本,因此,在時間槽t,智能體獲得的獎勵可表示為:

rt(st,at)=-[CMG(st,at)+CNG(st,at)+

CBA(st,at)]×0.001

(33)

其中,乘以0.001是對成本值進行縮小。

電熱綜合能源系統能量管理動作a的優劣程度可以使用狀態-動作值函數Qπ(s,a)來評估,其目標是找到最優策略π*以最大化狀態-動作值函數。

(34)

3.2 基于DQN的系統能量管理方法

由于電熱綜合能源系統中未來的可再生能源出力和用戶負荷需求是未知的,因此很難解析地確定最優能量管理策略π*。強化學習不需要隨機過程的統計模型,是一種無模型的學習方法,因此非常適用于本文的含不確定性因素的電熱綜合能源系統能量優化管理問題。

然而,由于本文中的電熱綜合能源系統能量管理問題的狀態空間(如式(27)中所示的電負荷、熱負荷、可再生能源發電等)是連續的,需要極其大的表來近似Q函數,并且更新如此大的表也是非常有挑戰性的,故傳統的強化學習方法已無法適用。因此,本文采用DQN算法進行電熱綜合能源系統的能量優化管理。基于DQN的綜合能源系統能量管理方法流程如圖3所示。

圖3 基于DQN的綜合能源系統能量管理流程圖Fig.3 Flowchart of the DQN-based IES energy management method

4 算例分析

4.1 仿真算例設置

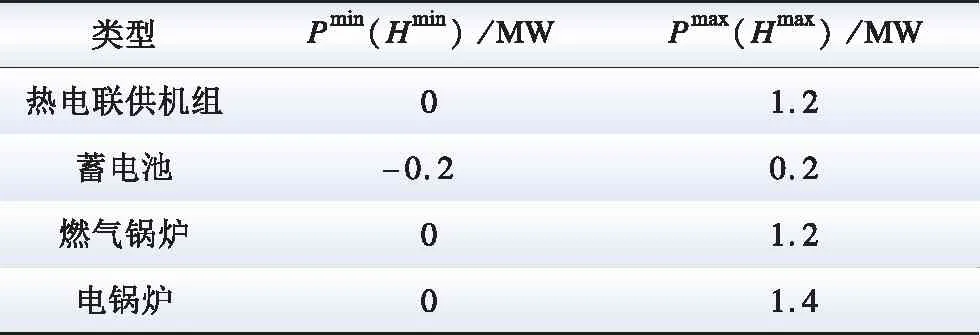

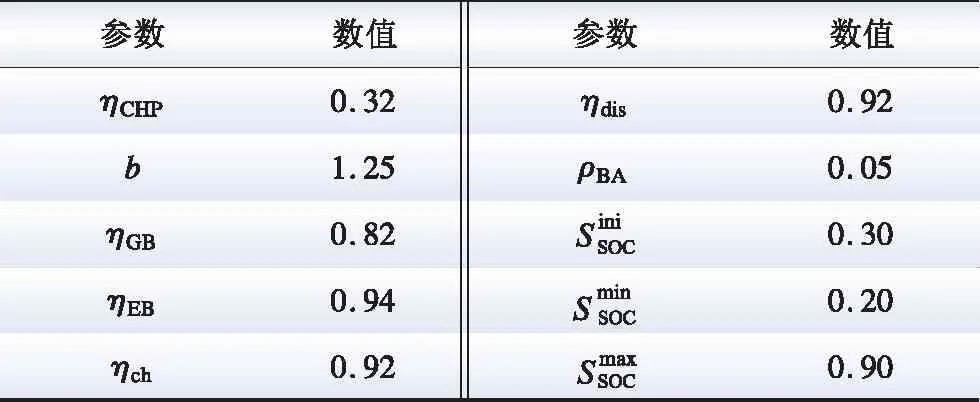

本節對所提方法進行仿真分析,以驗證所提出的基于DQN的綜合能源系統能量管理策略的有效性。以圖2所示的電熱綜合能源系統作為算例,其中,可再生能源發電裝置為太陽能光伏裝置。電負荷、熱負荷和光伏數據基于開源的CREST模型[24]產生。該模型已經過定性驗證,且在很多研究中廣泛應用[25-26]。該模型產生的數據包含隨機性,模擬了真實電熱綜合能源系統環境中源和荷的不確定性。由CREST模型生成了12月至次年3月的數據,每月前23天的數據用于訓練,每月的剩余天數用于性能評估。系統能量管理時段長度設置為1天,Δt為15 min。

電熱綜合能源系統中元件的運行參數如表1所示。與主網交換電功率的范圍為[-3 , 3] MW,與天然氣供應商交換功率的范圍為[0 , 4] MW,蓄電池的容量是1 000 kW·h,綜合能源系統其他參數見表2。電價采用分時電價,購電價格方面,谷電價為0.17元/(kW·h) (23:00—07:00),峰電價為0.83元/(kW·h) (12:00—19:00),其他時刻為平電價0.49元/ (kW·h);售電價格為購電價格的0.4倍。天然氣的單價為3.45元/m3,天然氣熱值為9.88 kW/m3。

表1 綜合能源系統中元件的運行參數Table 1 Operational parameters of the IES

表2 綜合能源系統的其他參數Table 2 Other parameters of the IES

所提深度強化學習方法是使用TensorFlow平臺實現的。DQN網絡的輸入為5維狀態向量st,輸出為狀態-動作對的Q值,本文將PCHP(t)、PBA(t)、HGB(t)分別以0.2 、0.1 、0.2 MW為間隔進行離散,即CHP的可選動作為{0, 0.2, 0.4, 0.6, 0.8, 1.0, 1.2}MW,蓄電池BA的可選動作為{-0.2, -0.1, 0, 0.1, 0.2}MW, 燃氣鍋爐GB的可選動作為{0, 0.2, 0.4, 0.6, 0.8, 1.0, 1.2}MW。超參數,如深度神經網絡隱含層的層數和每個隱含層的神經元數目,根據深度學習社區[27]推薦的常用做法選取,并根據訓練數據進行試錯調整。折扣因子為0.99,學習率為0.001,mini-batch大小為128,經驗池大小為10 000,隱含層層數為2層,每層分別有128、256個神經元,激活函數為線性修正函數 (rectified linear units, ReLU)。

4.2 能量管理結果分析

在將所建深度Q學習網絡應用于系統能量管理之前,首先訓練DQN的參數。智能體接收電負荷、熱負荷及光伏出力的觀測數據,然后根據3.2節中的訓練過程調整DQN網絡的參數,即權重θ。在利用訓練數據對DQN網絡進行離線訓練后,得到的網絡被保存以用于系統的能量優化管理。離線訓練完成的標志是隨著迭代次數的增加,獎勵值變化幅度較小,不再呈明顯增加趨勢,即網絡達到收斂。應用訓練好的DQN對系統進行能量管理,輸入數據是當前電負荷、熱負荷、光伏發電量、蓄電池SOC及時間槽,輸出是CHP的電功率、蓄電池的充/放電功率和燃氣鍋爐的熱功率。

為了說明所提方法的能量管理結果,選取測試集中的數據進行測試,首先以一個冬季典型日(1月25日)為例進行說明,結果如圖4和圖5所示。圖4為電能管理結果,包括和主網的電功率交換、光伏發電、熱電聯供機組輸出電功率、蓄電池運行功率和電鍋爐的輸入電功率,分別表示為GRID、PV、CHP-E、BA和EB-E;電鍋爐消耗電功率,因此其電能管理結果用負值表示。圖5為熱能管理結果,包括燃氣鍋爐、電鍋爐、熱電聯供機組輸出的熱功率,分別表示為GB、EB-H和CHP-H。

圖4 基于DQN的電能管理結果Fig.4 Electric power management results based on DQN method

由圖4可以看出,系統向主電網購電情況基本跟隨電價變化。在谷電價和平電價階段,向主網購電以滿足用戶電負荷需求。在峰電價階段,電負荷主要由熱電聯供單元滿足。在電負荷較小而熱負荷較大時,熱電聯供單元多生產的電能售回電網,如13:00—14:00時段等。蓄電池在谷電價時充電,并在峰電價時放電以減少系統運行成本,如12:15—12:30時段和13:45等。

圖5 基于DQN的熱能管理結果Fig.5 Heat power management results based on DQN method

由圖5可以看出,系統中的熱能供應來自于CHP、GB和EB。EB為谷電價時熱能的主要來源,谷電價階段且熱負荷高于1.4 MW時,EB所制熱不能滿足熱負荷需求,GB制熱進行補充,如05:45—06:45時段。在平電價階段,熱負荷主要由GB提供,當熱負荷高于1.2 MW時,GB的出力不能滿熱負荷需求,通過增加EB或EB與CHP的出力進行補充。在峰電價時,熱負荷主要由CHP和GB提供,當兩者出力之和不能滿足熱負荷需求時,通過增加EB的出力進行補充。這表明本文提出的基于DQN的能量管理方法能夠不斷優化各設備出力以降低系統運行成本。

4.3 對比結果分析

為了驗證所提方法的有效性,將本文提出的基于DQN的綜合能源系統能量管理方法與基于Q學習的能量管理方法以及依賴預測信息的調度方法進行比較。其中,Q學習方法的動作空間劃分與DQN方法的一致。對于依賴預測信息的調度方法(傳統方法),采用神經網絡對光伏出力和電、熱負荷進行預測,然后類似文獻[4],采用優化軟件進行求解。對采用3種方案在測試集數據運行得到的日運行成本進行比較,統計結果如表3所示。圖6給出了從測試集中隨機選取的10個測試日的日運行成本結果。

表3 不同能量管理方法的日運行成本統計結果Table 3 Statistics of the daily operation costs under different methods元

由表3可以看出,基于DQN的能量管理方法的平均日運行成本為17 621元;基于Q學習方法的平均日運行成本為18 516元,較DQN方法增加了5.08%;基于預測信息的調度方法的平均日運行成本為18 133元,較DQN方法增加了2.91%。從日運行成本的最大值、最小值、平均值以及隨機選取的測試日的日運行成本來看,DQN能量管理方法較其他2種能量管理方法獲得了更好的經濟性能,能有效地降低系統運行成本。

圖6 不同方法的系統運行成本對比Fig.6 Comparison of system operation costs under different methods

5 結 論

本文提出了一種用于綜合能源系統運行優化的能量管理方法。將電熱綜合能源系統的能量管理問題表述為一個馬爾科夫決策過程,其中考慮了可再生能源發電和負荷需求的不確定性。為求解該馬爾科夫決策過程,提出了一種基于DQN的電熱綜合能源系統能量管理方法。所提方法不依賴于綜合能源系統中不確定因素的預測信息及分布知識,可以根據系統的觀測狀態直接確定系統的能量管理策略,因此避免了由于預測或建模不準確而導致的后續能量管理策略的不可靠和大偏差。將所提方法在測試集上進行測試,結果表明所提方法能夠不斷優化各設備出力以降低系統運行成本。將該方法與基于傳統Q學習的能量管理方法進行對比,對運行得到的日運行成本的平均值、最大值和最小值進行比較,驗證了所提方法的有效性,表明了本文所提出的基于DQN的綜合能源系統能量管理方案能夠更好地實現系統的能量管理與運行優化。