基于Leap Motion的電影前期預演人機交互方法

趙建軍,黃竣鵬,陳俊良

基于Leap Motion的電影前期預演人機交互方法

趙建軍,黃竣鵬,陳俊良

(北京電影學院影視技術系,北京 100088)

隨著虛擬現實(VR)技術的發展,虛擬預演逐漸成為電影制作流程中不可或缺的一環,如何使用自然、多模態的交互方式,結合三維實時渲染引擎,提高電影制作人員在前期預演中的參與感,是該領域的重要研究內容。針對當前虛擬預演中使用的交互方式大多為光學運動捕捉系統等,存在價格昂貴、操作難度高、便攜性差等問題。提出一種基于Leap Motion的電影前期預演人機交互方式,在獲得精準數據的同時,大大降低了操作難度與設備成本,電影制作人員使用手勢交互控制虛擬角色的運動軌跡,完成不同運動狀態的切換,并結合運動捕獲數據庫,直接參與到前期預演中。通過方案驗證,該方法的用戶體驗更加自然、友好、直觀和高效。

Leap Motion;電影前期預演;人機交互;虛擬現實;虛擬角色

電影是科技與藝術相結合的產物,電影技術的重大變革,均伴隨著科學技術的重大突破。近年來,隨著虛擬現實(virtual reality,VR)技術與計算機圖形學的飛速發展,電影制作方式也發生著新的變化,其中前期預演是影視制作中新興的應用技術。在電影開拍之前,對一些鏡頭甚至整部影片進行可視化預覽且無需承擔實際拍攝成本,在虛擬環境下可幫助電影制作團隊進行技術論證、探討影片敘事、規劃拍攝流程等。

前期預演的加入,使得電影制作呈現出后期流程“前置”化的特征。這種可視化呈現方式,能夠方便電影創作團隊進行構思設計及電影拍攝的預覽。當前大部分的鏡頭預演是借助于傳統的三維軟件如Maya,3DMax和Motion Builder等實現,這些軟件借助于動捕系統等技術手段,進行大部的分預演鏡頭制作。此外,市面上也有多種專業軟件用于幫助電影創意設計探索和創作團隊頭腦風暴,如Amazon Storyteller,Sketchup,FrameForge 3D Studio,Cinebox和iClone等,雖然功能各有不同,但可在不同程度上完成對鏡頭畫面進行可視化預覽。

然而,現有的前期預演軟件及呈現方式,一般由動畫師參與設計三維動畫,通過生成動畫鏡頭,來指導電影現場拍攝。電影主創團隊大多不能實時、便捷地參與鏡頭設計,若要參與,需使用鼠標鍵盤進行虛擬角色的動畫設計、虛擬鏡頭的設置等,大大降低了創作團隊的創作設計體驗感及創作效率。針對上述問題,本文提出了一種基于Leap Motion的人機交互方式,創作團隊簡單使用手勢交互的方式,控制虛擬拍攝中的角色動畫軌跡,以及控制角色在運動狀態間進行切換,達到參與虛擬預演動畫設計的效果,使得電影創作人員能夠便捷地參與到電影的前期預演中。

1 相關工作

Leap Motion 是一種人機交互中的體感控制器,可利用手勢識別采集數據,即借助手掌和手指的動作感應技術進行信息輸入,完成人機互動。因其設備使用方式簡單、體積小、價格低廉、手勢精度高、可配合多種傳感設備進行輔助操作,為人機交互的應用提供了一種新的思路。Leap Motion由于直接捕獲真實的手勢運動數據,其數據更自然、逼真、仿真度高。同時,支持雙手交互控制,可在極端情況下進行動作采集、跟蹤,結果更精確、穩定、識別度好。

在人機交互領域,KHALAF 等[1]對多種手勢識別采集設備進行對比測試,在基于視覺的手勢識別設備中,測試了RealSense,Leap Motion和Kinect的用戶體驗、認知需求、舒適度和使用性能,測試結果表明Leap Motion的表現最佳。Leap Motion在多個行業內被廣泛應用:在航天領域中,胡弘等[2]提出了基于Leap Motion采集設備的關鍵點模型手姿態參數估計,驅動虛擬手運動;在醫療領域中,孫國道等[3]提出基于雙Leap Motion的三維可視化體感交互系統,以減少手指混疊現象、提高設備易用性;教學領域中,VASYLEVSKA 等[4]利用Leap Motion進行VR和AR的教學構建和發展,提升VR用戶使用體驗;在安全領域,基于Leap Motion傳感設備,利用手指的速度和傾斜角的特征進行生物身份識別認證,MARUYAMA 等[5]利用手指的關節間三維空間坐標計算出的手指內和手指間的特征值進行用戶驗證,結果顯示其僅使用關節間距離作為特征進行識別,識別率高達84.65%。除此,KAMAISHI和UDA[6]借助Leap采集的數據,基于動作識別的用戶界面設計,提升工作效率;HERNOUX等[7]利用Leap的高精度采集特性,實時將3D人體運動采集應用于機器人動態運動,使機器人能夠應對和執行多種復雜的任務;美國宇航局使用Leap Motion模擬控制太空機器人登陸火星,提升用戶使用操作體驗。

在影視娛樂行業,HANTRAKUL和KACZMAREK[8]將Leap傳感器與合成器、揚聲器相連接,使用手指和手部運動對合成器進行觸發,實現了設備控制聲音合成和交互式現場表演的應用;DESNOYERS- STEWART等[9]通過Leap Motion與HTC Vive,在虛擬環境中操作混合現實的樂器,使用戶在視覺、觸覺和本體感覺吻合中獲得良好的用戶體驗;XU[10]借助Leap Motion采集手的位置和手勢數據,對機器人角色進行動畫交互。

綜上,Leap Motion體感控制器體積小、價格低廉,采集數據精度高、穩定性強、識別度好、仿真度高,符合人體工程規律,可應用于多種領域。然而在當下影視領域的虛擬制作中,人機交互控制仍然采用傳統的鼠標鍵盤操作,電影從業者體驗感差,參與度低。基于此,本文提出了一種基于Leap Motion的虛擬預演人機交互系統設計方案,在渲染引擎中通過Leap Motion體感控制器對場景內的數字角色進行控制與操作,解決藝術家對角色快捷控制的需求,提升用戶體驗,同時實現虛擬預演的高效制作。

2 基于Leap Motion的虛擬角色交互控制

在電影前期預演中,非常重要的內容是通過設計演員的走位,進而設計鏡頭,演員的走位設計分為2類:設計演員的軌跡和安排演員在不同的運動類型之間進行切換。如圖1所示,為了使得電影創作人員能夠在電影前期預演中充分發揮作用,尤其是設計虛擬角色運動,本文設計了一種基于Leap Motion的人機交互方式。首先需分別設計虛擬角色的運動軌跡以及進行不同運動狀態的切換,然后結合運動數據庫,生成自然的虛擬角色運動,用于鏡頭設計與前期預演流程。

圖1 基于Leap Motion的人機交互方式

2.1 基于Leap Motion的軌跡規劃

在虛擬預演的制作過程中,如何讓制作人員快速生成角色運動軌跡是虛擬預演人機交互的重要研究部分。為此,本文提出基于手勢識別的軌跡規劃方法,快速生成角色運動軌跡。其使用Leap Motion獲得采樣點,分2步驅動角色運動:對采樣點進行再處理獲得控制路徑離散點;利用路徑離散點驅動角色運動。

2.1.1 采樣點再處理

Leap Motion采集到的手部位置抖動非常明顯,為獲得一條相對平滑且準確的控制路徑,在利用路徑離散點驅動角色運動中,本文提出數據重采樣、數值濾波、根據縮放進行插值等3步進行處理。

步驟1.在獲取離散點后,對數據進行重采樣,減少手部運動緩慢時路徑在一個區間內不斷抖動的現象。設置一個閾值(單位為像素),當采樣點之間歐氏距離小于該閾值時,可忽略。當實驗閾值設置為6時,可大幅減少抖動,同時對路徑的連續性影響較小。重采樣算法1為:

設重采樣離散點序列為,采集離散點序列為,閾值為。

算法1.

輸入:, array

輸出: array

該方法可用在獲取離散采樣點上。若采樣到手部位置為1,路徑離散點序列中最后的離散點為,(1,)≥,則將1保存在中,否則丟棄該點。

步驟2. 進行重采樣處理后,需要對數據進行濾波,進一步減少抖動。傳統的卡爾曼濾波、中值濾波等方式,可使沖擊信號出現延遲,缺少尖峰等現象。在路徑規劃中,如果路徑中存在折角,經濾波后會變為圓弧,當折角為銳角或直角時,該現象尤為明顯。為解決此問題,在濾波中首先判斷采樣點是否為路徑角點,如果是則保留。獲取當前采樣點前后各3個點,在此范圍內,將路徑近似為2段直線。濾波算法如下:

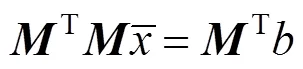

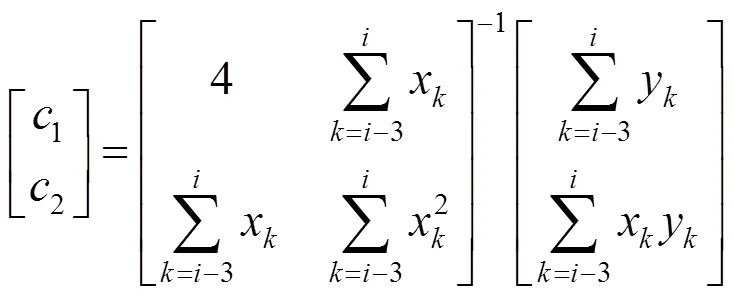

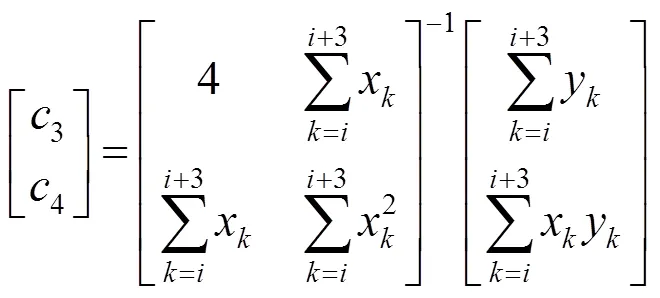

(1) 設重采樣離散點序列為,=(x,y)為其第個點,取當前采樣點前后各3個點,用最小二乘法分別擬合直線,即=1+2,其最小二乘法的矩陣形式為

可推出-3,-2,-1,,所擬合直線*1=1+2,即

同理,,+1,+2,+3所擬合直線*2=3+4,即

利用2,4計算出*1,*2方向向量之間的夾角,當夾角大于90°時,標記采樣點A為角點。

(2) 利用角點進行分段,2個角點之間的采樣點使用滑動平均濾波(算法2)。

算法2實現如下:設上一步處理好的重采樣離散點序列為,濾波處理后離散點序列為,角點序列為。

算法2.

輸入:, array

輸出: array

步驟3. 根據縮放進行插值。上述獲取的路徑采樣點是處于Leap Motion的分辨率范圍中,若將路徑映射在虛擬場景中,需進行縮放。為使縮放后路徑的采樣點依然保持較好的分布,需對路徑進行重采樣或插值,方法為:

(1) 縮放比例是通過場景中需要的路徑空間與離散點分布的空間相除得到的,其中像素與距離的換算比為1 px/0.05 m。

(2) 對離散點進行歸一化,并縮放到虛擬場景中。

(3) 根據縮放比例,對縮放后的路徑離散點進行插值或降采樣,確保場景中點的密集程度相對均勻。其中插值的方式為使用三次樣條對2個離散點之間的空隙進行插值,空隙中需要插值-1個點,若<1則丟棄相應比例的點。

2.1.2 路徑離散點驅動角色運動

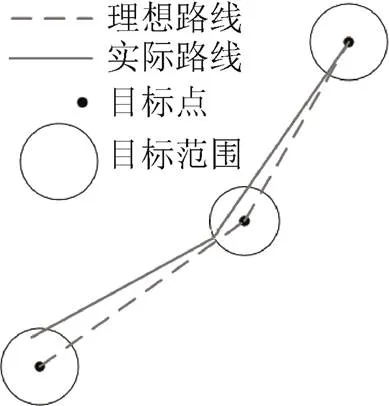

將處理后的離散點按獲取時間排列,并作為角色的運動路徑。到達一個點后,可將下一個點作為逼近的目標,按照角色的運動速度進行移動,逐漸逼近目標點。由于角色處于移動狀態,很難精確到達每一個目標點,故本文將目標點變為一個目標圓,其直徑大于角色每幀運動距離,以解決角色陷入不斷逼近某個目標點或移動超過了目標點而折返發生運動抖動的情況,如圖2所示。

2.2 基于Leap Motion的狀態切換控制

虛擬預演中對虛擬角色控制,通常是一個多狀態的過程,需要用戶進行不同狀態間切換。在一個簡單的控制元里,通過加入不同的附加條件,影響和控制角色的不同狀態。同時,狀態的設計還需要符合用戶的操作控制思維。基于此思路,如圖3所示,Leap Motion作為角色運動控制采集器之外,還作為不同狀態間切換控制器。

圖2 運動軌跡逼近方法

圖3 運動狀態轉移示意圖

如圖4所示,用戶使用Leap Motion時手勢基本高度保持一致,角色保持默認走路姿態。

圖4 步行狀態及手勢對應圖

如圖5所示,用戶進行握拳或手的三維空間坐標高度接近傳感器平面,角色運動狀態切換為停止狀態,虛擬角色不再運動。

圖5 停止狀態及手勢對應圖

如圖6所示,用戶抬手到達一定高度時,角色表現為跑步。

圖6 跑步狀態及手勢對應圖

如圖7所示,用戶手掌位置向前或向上運動超過一定速度時,角色進行跳躍。

通過不同的手勢對角色的4種狀態進行控制操作,如圖8所示。基于手勢的控制方式,不僅符合用戶對虛擬角色的控制習慣,同時提升了用戶體驗。

圖7 跳躍狀態及手勢對應圖

圖8 Leap Motion控制方式示意圖

2.3 基于運動數據庫的動畫生成

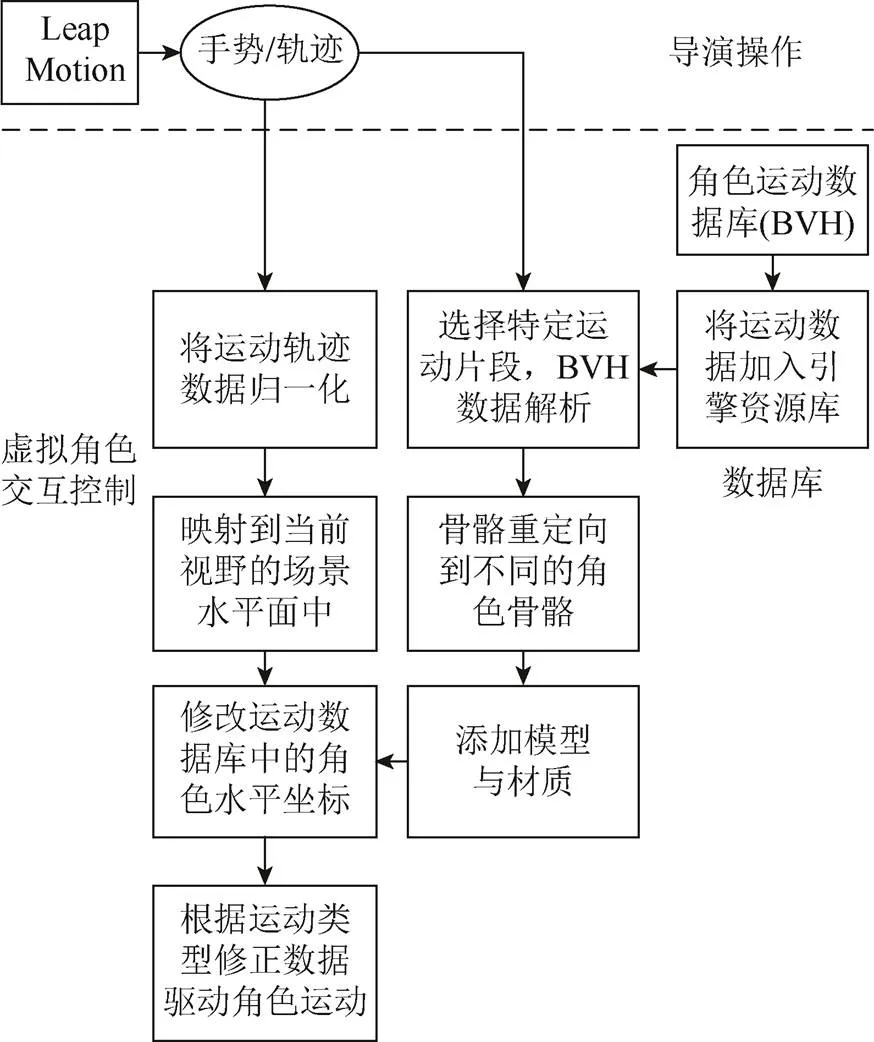

通過上述的路徑獲取與狀態切換控制方法,使用者能夠便捷地交互控制虛擬數字角色。在電影制作中,預演動畫生成除了要求交互性強之外,還需要角色的運動能夠自然逼真,具有一定的表現力。為此,在上述控制的基礎上,采用運動數據庫,驅動角色在發生位移等運動時,肢體運動表現的自然逼真。

另本文還采用了BVH格式的數據庫。其為骨骼構成和動作數據庫,廣泛支持各種動畫制作軟件,業界許多動捕數據庫,均以BVH文件為發行格式。角色動捕數據大大提升了角色運動的真實感,增強了虛擬預演的效果,給導演提供更大的創作空間。

前期預演中,虛擬角色的位置信息更為關鍵,而一些穿幫現象并不重要,故可采用同一組運動數據庫進行不同角色的交互控制。一般需要使用與所驅動的模型采用同樣骨骼結構的BVH文件。本文采用了卡耐基梅隆大學的運動捕獲數據庫轉換得到BVH文件進行測試驗證。值得注意的是,BVH文件中角色的關節坐標,,軸朝向均為初始姿態,即以右手坐標系為標準的世界坐標系下,,軸朝向。所有關節初始姿態的,,軸朝向均相同。

圖9首先將角色運動數據庫加載到引擎中。不同的手勢,對應于不同的運動,如張手為步行,握拳為跳躍。根據手勢類型,選擇調用的運動類型。確定運動類型后,進行BVH解析,得到動作信息。在基于引擎的實現中,需要調整所驅動角色的初始姿態,并獲得初始姿態,使得在后續操作中,每次驅動角色,均需每個關節恢復到初始姿態再驅動。

圖9 基于數據庫的虛擬角色交互控制

需注意的是,在現有的預演方案中,一部分使用運動捕獲系統直接控制虛擬的角色,另一部分使用基于物理的虛擬角色生成方法進行人體運動控制。而本文所采用的方法,成本低廉、便攜,在不同的場合均可便捷使用。

3 電影前期預演的實例應用

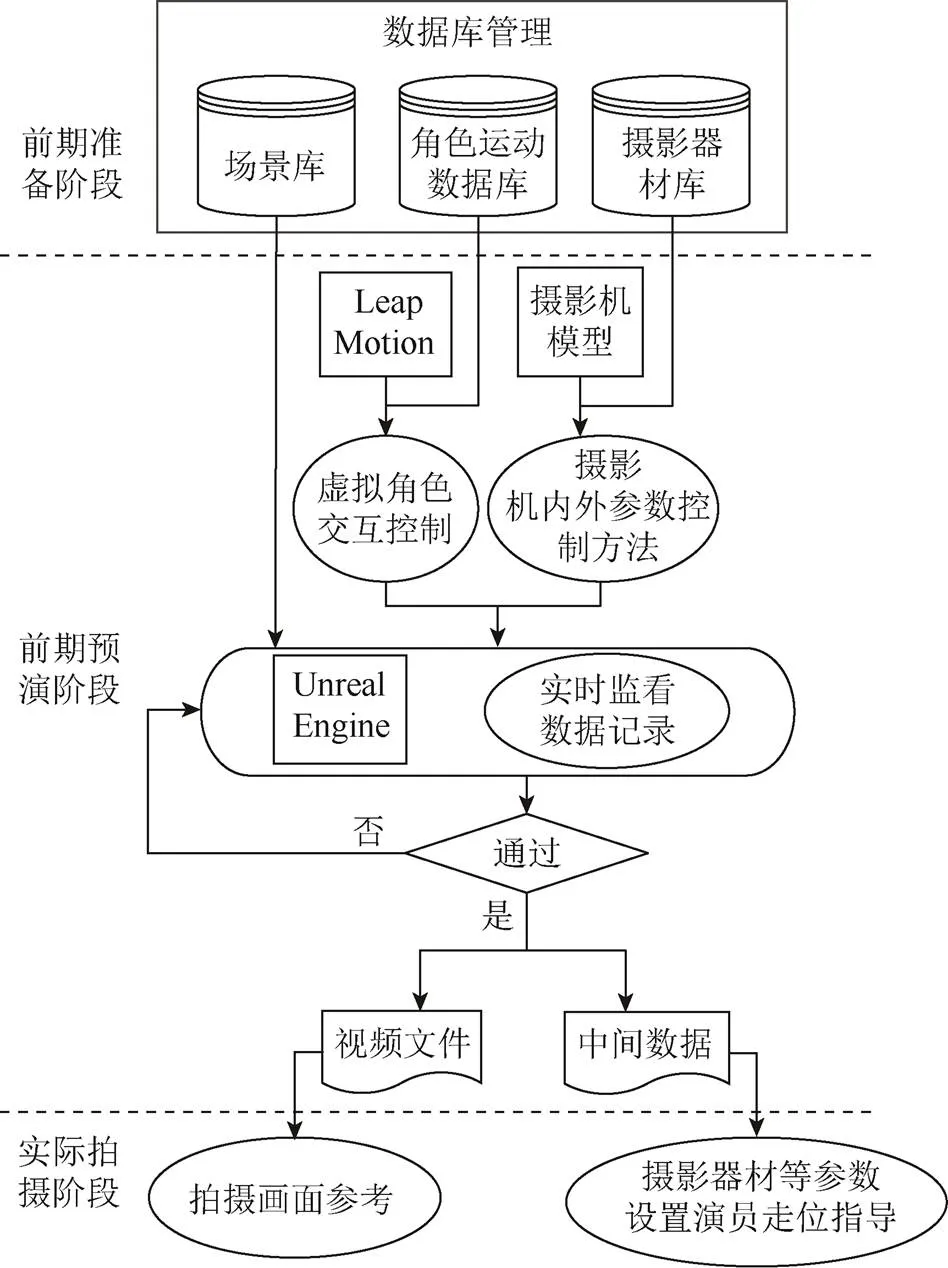

為了驗證方法的實用性,本文使用Unreal Engine,設計了電影前期預演的解決方案,如圖10所示。

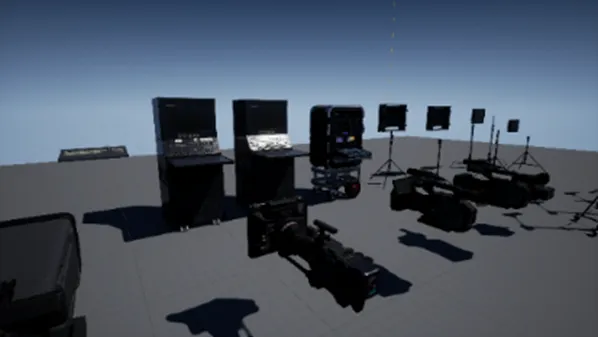

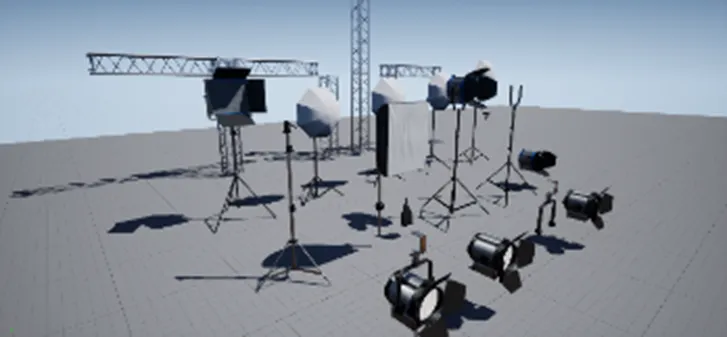

3.1 虛擬資產庫的準備

為了確保前期預演的內容能夠在拍攝中得以執行,需要根據真實的設備,建立虛擬模型,其物理屬性需與真實的設備完全一致,如圖11~12所示。本文使用了與當前電影主流真實攝影機、三腳架、燈具、視頻輔助設備等完全相同尺寸、相同數字屬性的虛擬資產模型,以便在前期預演中根據不同劇組、不同導演在不同場景、不同劇目中進行選擇。

圖10 前期預演交互設計方案框架圖

為了驗證對不同角色的交互控制,使用了多種虛擬角色模型,如圖13所示。

同樣,還使用圖像建模或手工建模等方式,設計虛擬場景,用于前期預演,如圖14所示。

為了方便不同的場景預演,在前期預演中預加載不同場景模型,方便在前期預演中實時切換所預演的場景,如圖15所示。

通過與真實對象相一致的數字資產庫的建設,以保證前期預演的內容在現場拍攝中復現出來。

3.2 基于半實物模型及回看監視器的虛擬攝影實現

在電影的拍攝中,導演、攝影師通過攝影機與畫面進行交流創作。為了使導演、攝影師能夠以自身熟悉的方式進行創意設計,本文采用3D打印的半實物仿真攝影機鏡頭模型加回看監視器模擬真實的拍攝工作環境,如圖16所示。攝影機鏡頭模型及數字參數與真實攝影機相似且一致。在其他虛擬資產保證一致性的前提下,前期預演設計的鏡頭能夠完美地在真實拍攝中呈現。

圖11 虛擬攝影機及鏡頭

圖12 虛擬燈具

圖13 虛擬角色

圖14 虛擬場景

圖15 虛擬場景選擇界面

圖16 攝影機模型及監看設備

與光學跟蹤點的半實物模型相比較,本文的半實物模型能夠直接控制攝影機的內外參數,同時進行實時記錄,有助于后續現場拍攝與后期制作。而與Mosys機械傳感器的半實物模型相比較,其造價低廉,在滿足前期預演需求的前提下,可讓攝影師通過個人友好的方式進行虛擬創作。

3.3 基于Leap Motion的虛擬角色交互控制

在現有的虛擬角色交互方式解決方案中,大多使用運動捕獲系統,該方式能夠由演員表演驅動虛擬角色得到想要的表演效果。然而需要在前期預演系統中搭建運動捕獲系統,除了經濟成本之外,對于前期預演的環境有比較嚴格的要求。

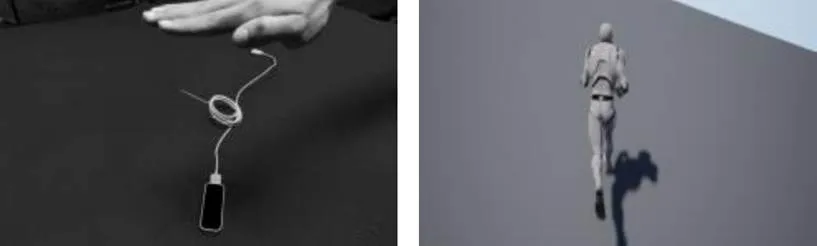

由于在前期預演中,需要驗證的是在特定的場景中,虛擬角色走位與攝影機走位的關系,其虛擬角色的運動細節是否充分、細致,對于預演效果影響有限。導演是否能夠方便、友好、快捷地控制虛擬角色的走位,是前期實時預演中需要解決的問題。本文使用Leap Motion,在Unreal Engine引擎中基于手勢識別的方式進行虛擬角色交互控制。并實時獲取手掌的運動軌跡,歸一化到場景窗口的地面后,虛擬角色根據指定的運動軌跡進行運動,并使用手勢上下滑動控制運動速度。通過這種便攜、低廉的體感控制器,導演能夠實時控制虛擬角色的走位,如圖17所示。

圖17 虛擬角色軌跡規劃控制

3.4 基于按鈕傳感器的攝影錄制及數據記錄

前期預演的主要產出是鏡頭的預演視頻。與動畫預演或游戲過場動畫的制作方式不同,前期預演需求是能夠充分、快捷地反映創作者的想法。即導演、攝影師的創作能夠實時進行可視化預覽,通過視頻監看,判斷預演效果是否達到預期。如果達到預期,則該視頻可作為真實拍攝與后期特效制作的參考視頻。

如圖18所示,通過在搖桿上添加2個按鈕,控制虛擬攝影的拍攝與回看,這樣既能夠實時將引擎中的渲染畫面傳送到攝影師操作端,以供攝影師參考,也能夠將預演拍攝的鏡頭錄制供導演等回看,從而保證導演、攝影師的創作能夠得到可視化呈現。

圖18 前期預演錄制按鈕

在Intel i7-8700k,16 G內存,NVIDIA RTX 2080實驗環境中,幀速率測試結果為120 fps,相較于傳統鍵盤鼠標操作,幀速率相同,但交互性更強。

為驗證該虛擬角色交互控制系統的人機交互友好性與操作易用性,本文對19名志愿者進行應用實驗,志愿者均為在讀影視制作類專業本科生及研究生。

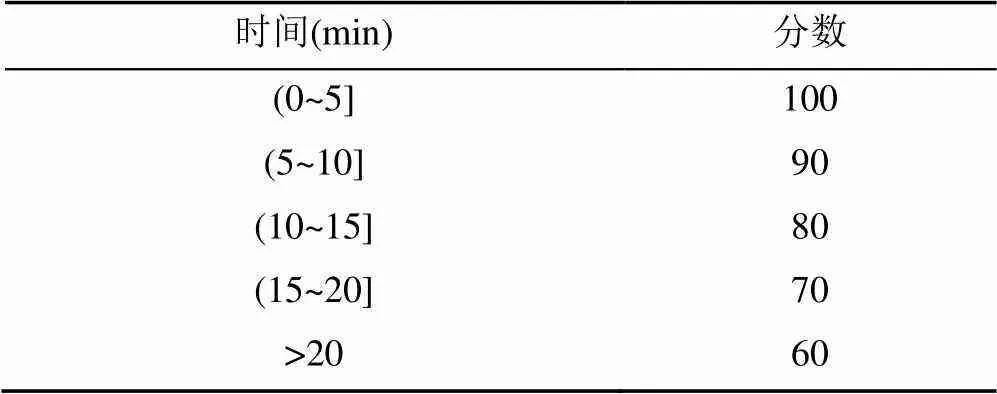

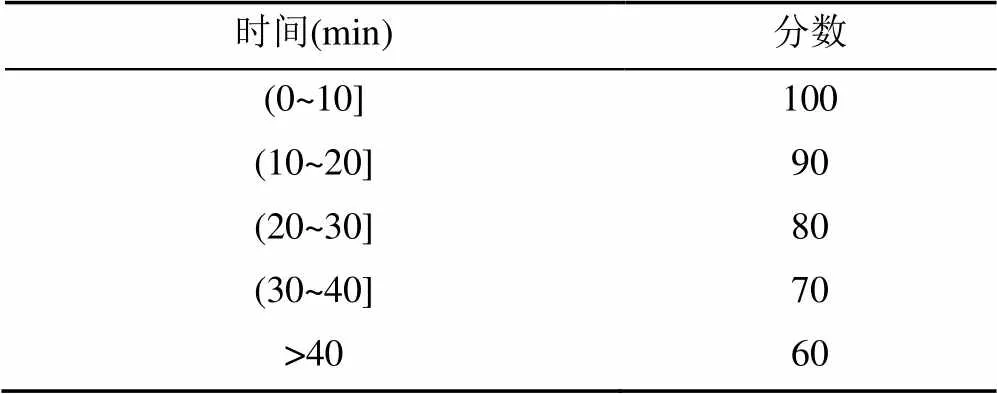

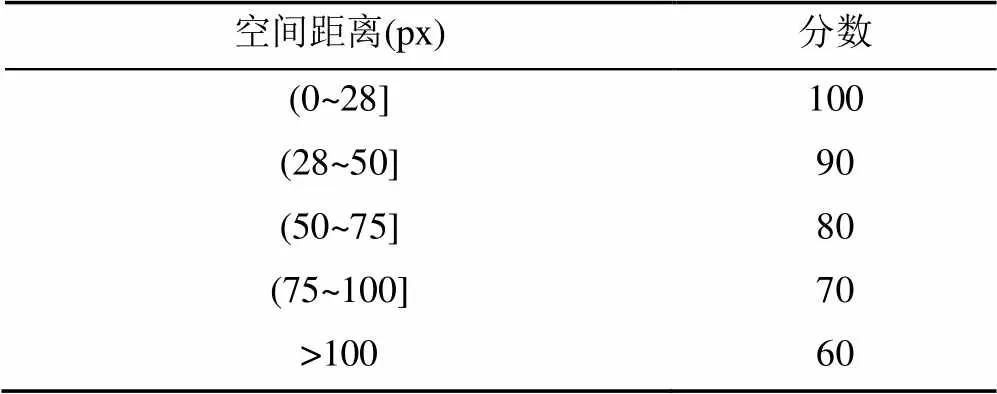

其中,交互性為用戶在使用不同交互方式達到同一鏡頭所需時間;易用性為零基礎用戶學習不同交互方式后進行制作所需的學習時間。魯棒性為在不同交互方式下,達到同一鏡頭實現結果與預計要求位置的精準度,衡量標準見表1~3。

表1 交互性指標衡量表

表2 易用性指標衡量表

表3 魯棒性指標衡量表

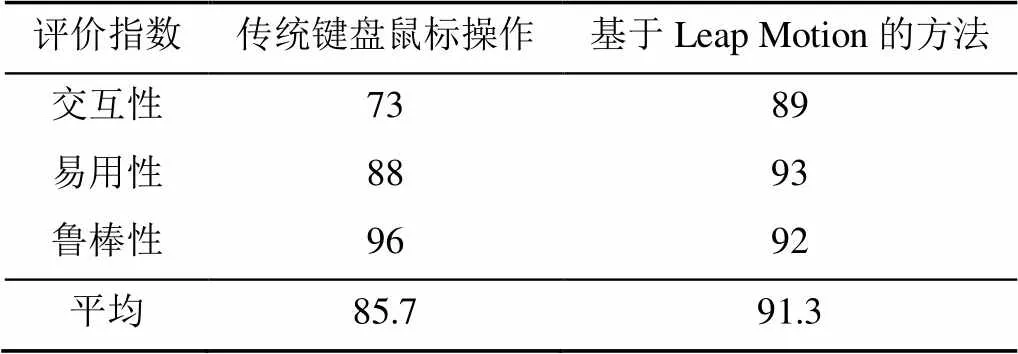

志愿者使用鍵盤鼠標操作與基于Leap Motion交互控制進行對比,結果見表4。

表4 不同交互方式用戶體驗評價

通過表4可見,基于Leap Motion的虛擬角色交互控制系統更加方便用戶使用,交互體驗感更強。

4 小結與討論

與傳統的動畫前期預演方式不同,本文實現了面向電影制作人員的前期預演中人機交互。本文的人機交互系統基于Unreal Engine實現,其主要功能基于藍圖編程實現。本系統的特點如下:

(1) 面向電影制作人員的人機交互方式。在游戲動畫及動畫預演領域,修改鏡頭畫面必須重新進行繁復的三維動畫流程。與游戲制作行業不同,電影從業者不習慣動畫編輯的方式,本系統通過簡便、友好的交互方式,電影從業人員能夠充分在前期預演系統中表達自己的訴求,進行藝術創作。

(2) 由于本系統使用了與真實世界完全一致的虛擬資產,其預演的鏡頭可參考性更強,預演中能夠實現的內容,在真實的拍攝中也能夠實現。

(3) Unreal Engine引擎不僅僅是一款開放的實時游戲引擎,也是各種大型3D項目的組裝器。開放的引擎具有兼容各種硬件接口的能力,本系統能夠滿足前期預演對交互控制的外設接口需求,如手柄、遙控器等。

(4) 基于高效、高質量的實時渲染,前期預演的畫面質量相較于傳統的如Maya,3Dmax等工具,畫面逼真,便于使用者接受。

(5) 本系統使用的外接設備為3D打印模型及Leap Motion,成本低廉,無需昂貴的運動捕獲設備等系統,也為后續電影制作人員遠程協作進行前期預演提供了可能。

隨著電影特效制作流程的后期前置化,數字資產庫在前期預演中起著非常重要的作用。虛擬資產庫不僅僅包括攝影機、鏡頭、滑軌等攝影器材的虛擬資產,還包括燈光、道具等,以及虛擬角色的動畫資源。為了能夠應對不同題材、不同場景的預演需求,數字資產的需求將會非常巨大。

數字資產是否與真實一致,即數字參數與真實的參數是否完全相同,將在很大成度上影響著前期預演效果,這也是前期預演鏡頭能否在現場拍攝以及后期制作中“再現”的主要制約因素。

本文設計了符合影視制作人員使用習慣的人機交互方式,能夠使電影制作人員參與到電影前期預演中。該交互方式也為未來交互式影像的數字娛樂方式帶來一定的參考價值。

[1] KHALAF A S, ALHARTHI S A, DOLGOV I, et al. A comparative study of hand gesture recognition devices in the context of game design[C]//2019 ACM International Conference on Interactive Surfaces and Spaces. New York: ACM Press, 2019: 397-402.

[2] 胡弘, 晁建剛, 楊進, 等. Leap Motion關鍵點模型手姿態估計方法[J]. 計算機輔助設計與圖形學學報, 2015, 27(7): 1211-1216.HU H, CHAO J G, YANG J, et al. Key point model for hand pose estimation based on leap motion[J]. Journal of Computer-Aided Design & Computer Graphics, 2015, 27(7): 1211-1216 (in Chinese).

[3] 孫國道, 黃普永, 劉義鵬, 等. 基于雙Leap Motion的三維可視化交互方法研究[J]. 計算機輔助設計與圖形學學報, 2018, 30(7): 1268-1275.SUN G D, HUANG P Y, LIU Y P, et al. Interactive 3D visualization with dual Leap Motions[J]. Journal of Computer-Aided Design & Computer Graphics, 2018, 30(7): 1268-1275 (in Chinese).

[4] VASYLEVSKA K, PODKOSOVA I, KAUFMANN H. Teaching virtual reality with HTC vive and leap motion[C]//SIGGRAPH Asia 2017 Symposium on Education on – SA’17. New York: ACM Press, 2017: 1-8.

[5] MARUYAMA K, SHIN J, KIM C M, et al. User authentication using leap motion[C]//2017 International Conference on Research in Adaptive and Convergent Systems. New York: ACM Press, 2017: 213-216.

[6] KAMAISHI S, UDA R. Biometric authentication by handwriting using leap motion[C]//The10th International Conference on Ubiquitous Information Management and Communication – IMCOM’16. New York: ACM Press, 2016: 1-5.

[7] HERNOUX F, BéARéE R, GIBARU O. Investigation of dynamic 3D hand motion reproduction by a robot using a Leap Motion[C]//2015 Virtual Reality International Conference on ZZZ – VRIC’15. New York: ACM Press, 2015: 1-10.

[8] HANTRAKUL L, KACZMAREK K. Implementations of the Leap Motion device in sound synthesis and interactive live performance[C]//2014 International Workshop on Movement and Computing – MOCO’14. New York: ACM Press, 2014: 142-145.

[9] DESNOYERS-STEWART J, SMITH M, GERHARD D. Mixed reality MIDI keyboard demonstration[C]//The 12th International Audio Mostly Conference on Augmented and Participatory Sound and Music Experiences. New York: ACM Press, 2017: 1-5.

[10] XU Y M. An animated lighting robot by gesture recognition[C]//SA’14: SIGGRAPH Asia 2014 Posters. New York: ACM Press, 2014: 1.

Human-computer interaction method in previz based on Leap Motion

ZHAO Jian-jun, HUANG Jun-peng, CHEN Jun-liang

(Department of Film and TV Technology, Beijing Film Academy, Beijing 100088, China)

With the development of virtual reality (VR) technology, previz has gradually become an indispensable part of the film production. To improve the experience of filmmakers in previz, the utilization of natural multi-modal interaction, combined with 3D real-time rendering engine, has become increasingly important. At present, most of the interactive methods employed in previz are optical motion capture methods, which are expensive, difficult to operate, and poor in portability. This paper presented a human-computer interaction method based on Leap Motion. In addition to obtaining accurate captured data, it greatly reduced cost and the difficulty of operation. Filmmakers can interactively control the trajectory and switch between different motion states of virtual characters through gestures. With the help of motion capture data, filmmakers can directly participate in previz. The verification through previz schemes shows that this method is more natural, friendly, direct and efficient.

Leap Motion; previz; human computer interaction; virtual reality; virtual character

TP 391

10.11996/JG.j.2095-302X.2021010071

A

2095-302X(2021)01-0071-08

2020-08-04;

4 August,2020;

2020-08-14

14 August,2020

北京市教委科研計劃一般項目(KM201810050001);北京市教委科技創新服務能力建設項目(PXM2019_014220_000096)

:Beijing Municipal Education Commission Science and Technology Planning Project (KM201810050001);Beijing Municipal Education Commission Scientific and Technological Innovation Service Capacity Building Project (PXM2019_014220_000096)

趙建軍(1983–),男,山西平遙人,講師,博士。主要研究方向為計算機圖形學、虛擬現實。E-mail:zhaojianjun@bfa.edu.cn

ZHAO Jian-jun (1983-), male, lecture, Ph.D. His main research interests cover computer graph and virtual reality. E-mail:zhaojianjun@bfa.edu.cn