基于YOLOv3算法的船舶雙目視覺檢測與定位方法

張嘯塵 趙建森 王勝正 張敏 程成

摘要:

為快速、準確地檢測船舶目標,提出一種基于YOLOv3算法的船舶雙目視覺檢測與定位方法。

在特征學習時針對樣本中不同船舶長寬比例,重新聚類樣本中心錨點框,增強對船舶檢測的準確性;利用SURF算法進行特征匹配,并引入雙目測距算法,實現目標的測距與定位。實驗結果表明,該方法在每秒傳輸圖片30幀的情況下,平均檢測精度達到94%,在1 n mile內的目標平均定位誤差為11 m左右,與現有檢測算法相比,具有更好的實時性、準確性。該方法對智能船舶視覺感知信息與雷達、AIS信息的融合,以及避碰輔助決策具有非常重要的作用。

關鍵詞:

智能船舶; 目標檢測; 雙目測距; 輔助決策

中圖分類號:? U675.79; TP242.6+2

文獻標志碼:? A

收稿日期: 2020-04-09

修回日期: 2020-08-10

基金項目:

國家自然科學基金(51709167,61701299);國家重點研發計劃(2019YFB1600605);上海市科技創新行動計劃社會發展領域項目(18DZ1206101);大學生創新創業項目(S20190105, S20190117)

作者簡介:

張嘯塵(1995—),男,江蘇蘇州人,碩士研究生,研究方向為船舶智能導航、計算機視覺,(E-mail)247101485@qq.com;

趙建森(1983—),男,黑龍江牡丹江人,副教授,博士,研究方向為智能通信、微波和天線,(E-mail)7230981@163.com;

王勝正(1976—),男,湖南雙峰人,教授,博士,研究方向為航海仿真、智能船舶導航、大數據、機器學習,(E-mail)szwang@shmtu.edu.cn

Binocular vision detection and positioning method for

ships based on YOLOv3 algorithm

ZHANG Xiaochen, ZHAO Jiansen, WANG Shengzheng,

ZHANG Min, CHENG Cheng

(Merchant Marine College, Shanghai Maritime University, Shanghai 201306, China)

Abstract:

In order to detect target ships quickly and accurately, a binocular vision detection and positioning method for ships based on YOLOv3 algorithm is proposed.? During feature learning, the center anchor frames of the samples are re-clustered for the different ship length-width ratios in the samples to enhance the accuracy of ship detection; the feature matching is carried out by the SURF algorithm, and the binocular ranging algorithm is introduced to achieve target ranging and positioning. The experimental results show that, under the condition of 30 frames per second, the average detection accuracy of this method is 94%, and the average positioning error of the targets within 1 n mile is about 11 m. Compared with the existing detection algorithms, it is of better real-time performance and accuracy. It plays a very important role in the information fusion from the visual perception, radars and AIS, as well as collision avoidance auxiliary decision for intelligent ships.

Key words:

intelligent ship; target detection; binocular ranging; auxiliary decision

0 引 言

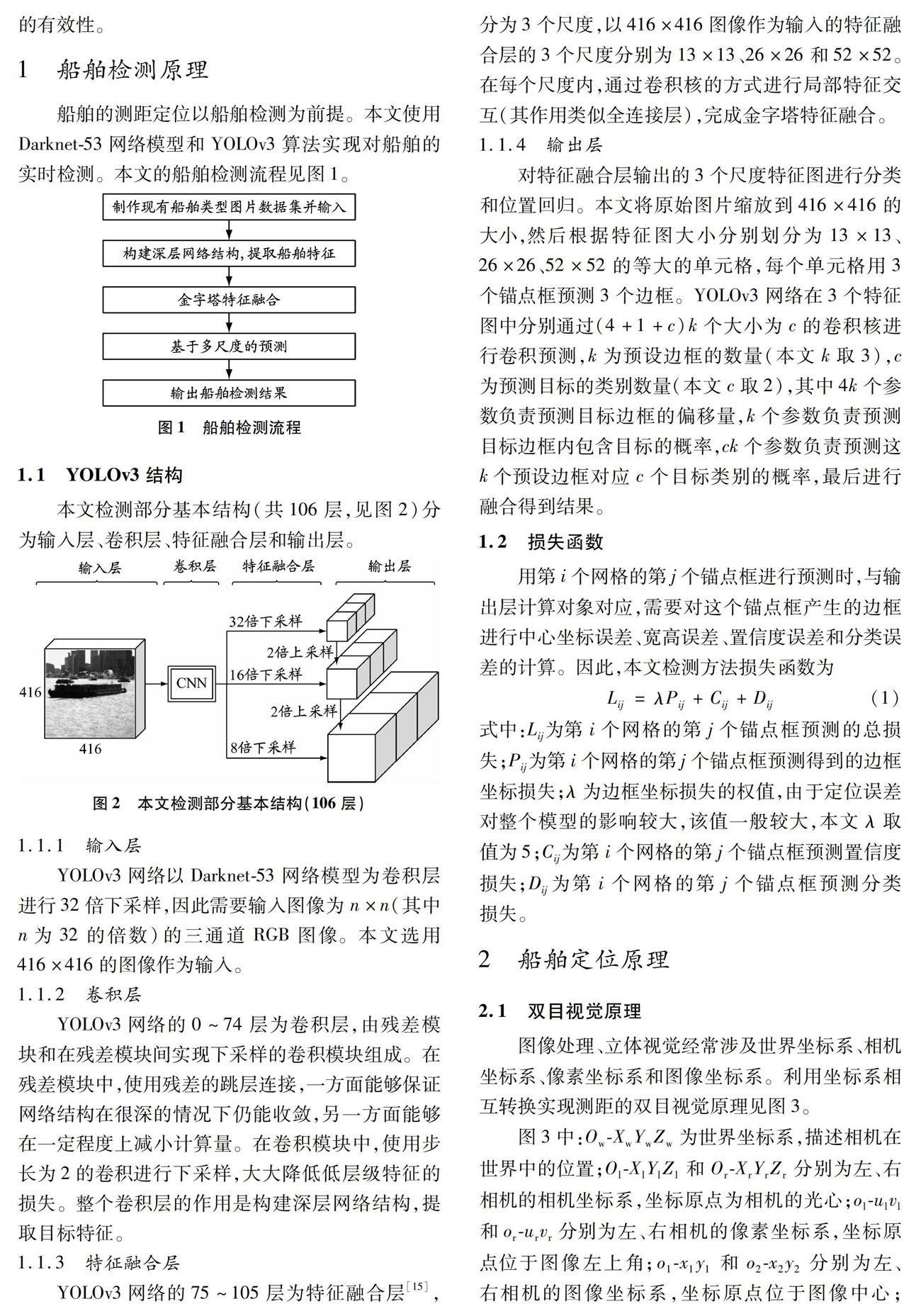

中國船級社2015年發布的《智能船舶規范》中提到,智能船舶需利用傳感器、通信、互聯網等技術手段自主感知和分析船舶周邊環境的信息和數據,以保證自身安全、自主航行。由此可見,信息感知技術在智能船舶領域是一項非常關鍵的技術。目前比較成熟的兩種感知手段是船舶自動識別系統(automatic identification system,AIS)和雷達。雖然這兩種感知手段使用范圍較廣,但是AIS信息存在主觀錯誤和延遲,雷達存在檢測盲區,因此多信息源信息融合成為港口監測和智能船舶自主航行迫切需求的新技術。大部分沿海、內陸水域以及智能化船舶上已經配備視頻監控裝置,但是船舶位置和航行態勢仍需依靠人工判斷。隨著計算機視覺智能感知技術的發展,船舶目標智能識別和跟蹤成為該領域新的研究熱點。

1.1.4 輸出層

對特征融合層輸出的3個尺度特征圖進行分類和位置回歸。本文將原始圖片縮放到416×416的大小,然后根據特征圖大小分別劃分為13×13、26×26、52×52的等大的單元格,每個單元格用3個錨點框預測3個邊框。YOLOv3網絡在3個特征圖中分別通過(4+1+c)k個大小為c的卷積核進行卷積預測,k為預設邊框的數量

(本文k取3),c為預測目標的類別數量(本文c取2),其中4k個參數負責預測目標邊框的偏移量,k個參數負責預測目標邊框內包含目標的概率,ck個參數負責預測這k個預設邊框對應c個目標類別的概率,最后進行融合得到結果。

1.2 損失函數

用第i個網格的第j個錨點框進行預測時,與輸出層計算對象對應,需要對這個錨點框產生的邊框進行中心坐標誤差、寬高誤差、置信度誤差和分類誤差的計算。因此,本文檢測方法損失函數為

Lij=λPij+Cij+Dij(1)

式中:Lij為第i個網格的第j個錨點框預測的總損失;Pij為第i個網格的第j個錨點框預測得到的邊框坐標損失;λ為邊框坐標損失的權值,由于定位誤差對整個模型的影響較大,該值一般較大,本文λ取值為5;Cij為第i個網格的第j個錨點框預測置信度損失;Dij為第i個網格的第j個錨點框預測分類損失。

2 船舶定位原理

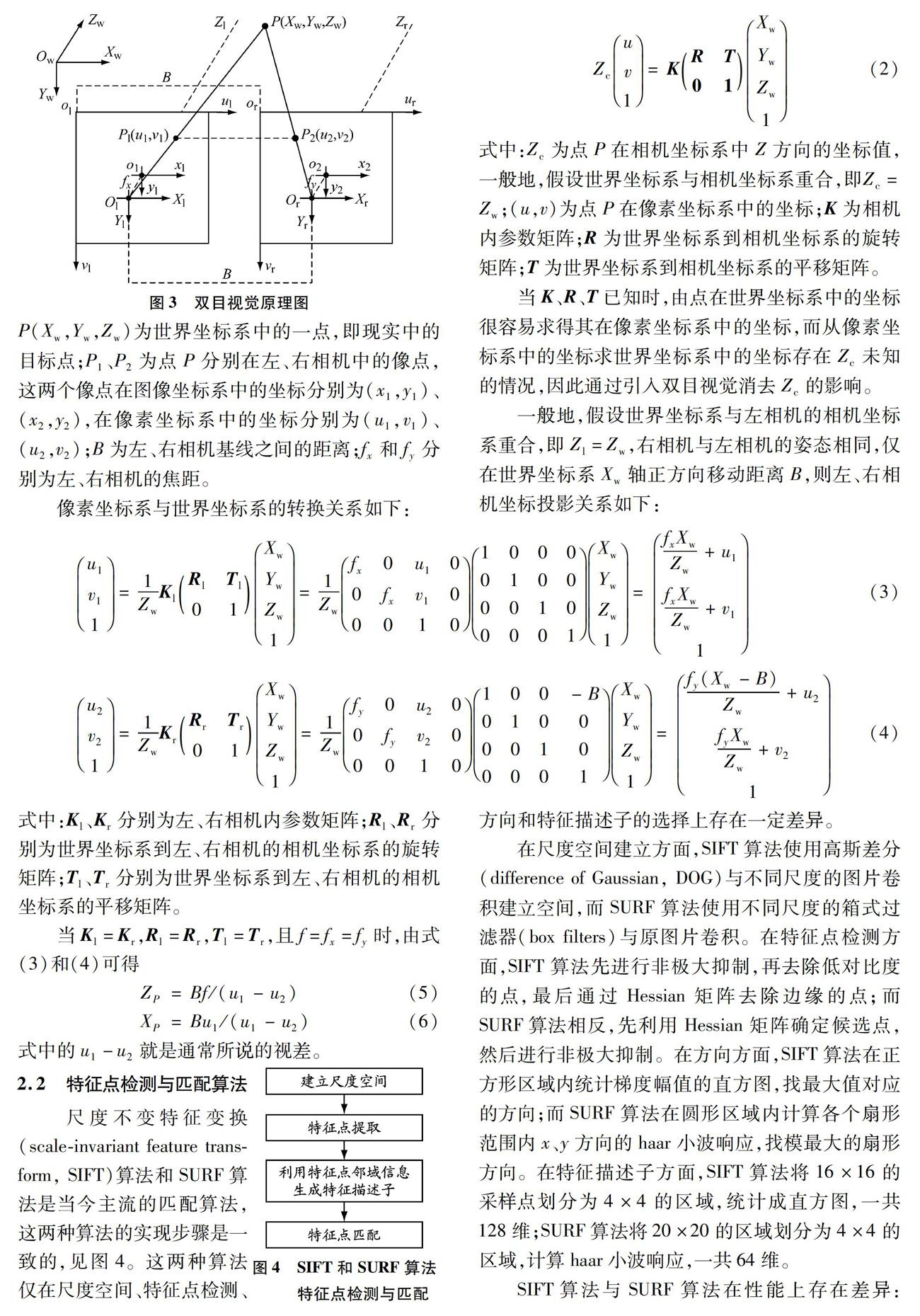

2.1 雙目視覺原理

圖像處理、立體視覺經常涉及世界坐標系、相機坐標系、像素坐標系和圖像坐標系。利用坐標系相互轉換實現測距的雙目視覺原理見圖3。

圖3中:Ow-XwYwZw為世界坐標系,描述相機在世界中的位置;Ol-XlYlZl和Or-XrYrZr分別為左、右相機的相機坐標系,坐標原點為相機的光心;ol-ulvl和or-urvr分別為左、右相機的像素坐標系,坐標原點位于圖像左上角;o1-x1y1和o2-x2y2分

別為左、右相機的圖像坐標系,坐標原點位于圖像中心;

P(Xw,Yw,Zw)為世界坐標系中的一

點,即現實中的目標點;P1、P2為點P分別在左、右相機中的像點,這兩個像點在圖像坐標系中的坐標分別為(x1,y1)、(x2,y2),在像素坐標系中的坐標分別為(u1,v1)、(u2,v2);B為左、右相機基線之間的距離;fx和fy分別為左、右相機的焦距。

像素坐標系與世界坐標系的轉換關系如下:

式中:Zc為點P在相機坐標系中Z方向的坐標值,一般地,假設世界坐標系與相機坐標系重合,即Zc=Zw;(u,v)為點P在像素坐標系中的坐標;K為相機內參數矩陣;R為世界坐標系到相機坐標系的旋轉矩陣;T為世界坐標系到相機坐標系的平移矩陣。

當K、R、T已知時,由點在世界坐標系中的坐標很容易求得其在像素坐標系中的坐標,而從像素坐標系中的坐標求世界坐標系中的坐標存在Zc未知的情況,因此通過引入雙目視覺消去Zc的影響。

一般地,假設世界坐標系與左相機的相機坐標系重合,即Zl=Zw,右相機與左相機的姿態相同,僅在世界坐標系Xw軸正方向移動距離B,則左、右相機坐標投影關系如下:

式中:Kl、Kr

分別為左、右相機內參數矩陣;

Rl、Rr

分別為世界坐標系到左、右相機的相機坐標系的旋轉矩陣;

Tl、Tr

分別為世界坐標系到左、右相機的相機坐標系的平移矩陣。

式中的u1-u2就是通常所說的視差。

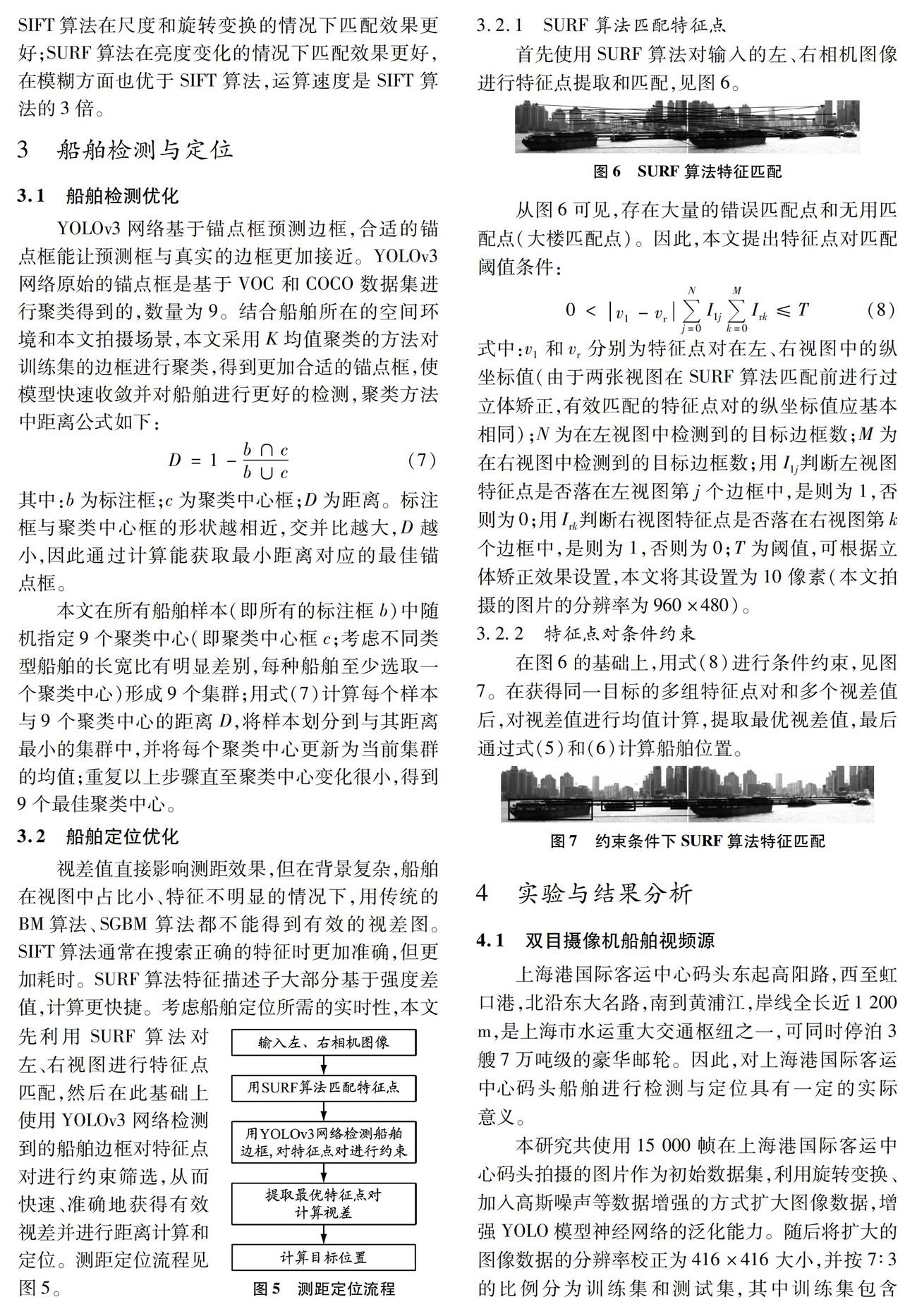

2.2 特征點檢測與匹配算法

尺度不變特征變換(scale-invariant feature transform, SIFT)算法和SURF算法是當今主流的匹配算法,這兩種算法的實現步驟是一致的,見圖4。這兩種算法僅在尺度空間、特征點檢測、方向和特征描述子的選擇上存在一定差異。

在尺度空間建立方面,SIFT算法使用高斯差分(difference of Gaussian, DOG)與不同尺度的圖片卷積建立空間,而SURF算法使用不同尺度的箱式過濾器(box filters)與原圖片卷積。在特征點檢測方面,SIFT算法先進行非極大抑制,再去除低對比度的點,最后通過Hessian矩陣去除邊緣的點;而SURF算法相反,先利用Hessian矩陣確定候選點,然后進行非極大抑制。在方向方面,SIFT算法在正方形區域內統計梯度幅值的直方圖,找最大值對應的方向;而SURF算法在圓形區域內計算各個扇形范圍內x、y方向的haar小波響應,找模最大的扇形方向。在特征描述子方面,SIFT算法將16×16的采樣點劃分為4×4的區域,統計成直方圖,一共128維;SURF算法將20×20的區域劃分為4×4的區域,計算haar小波響應,一共64維。

SIFT算法與SURF算法在性能上存在差異:SIFT算法在尺度和旋轉變換的情況下匹配效果更好;SURF算法在亮度變化的情況下匹配效果更好,在模糊方面也優于SIFT算法,運算速度是SIFT算法的3倍。

3 船舶檢測與定位

3.1 船舶檢測優化

YOLOv3網絡基于錨點框預測邊框,合適的錨點框能讓預測框與真實的邊框更加接近。YOLOv3網絡原始的錨點框是基于VOC和COCO數據集進行聚類得到的,數量為9。結合船舶所在的空間環境和本文拍攝場景,本文采用K均值聚類的方法對訓練集的邊框進行聚類,得到更加合適的錨點框,使模型快速收斂并對船舶進行更好的檢測,聚類方法中距離公式如下:

D=1-b∩cb∪c(7)

其中:b為標注框;c為聚類中心框;D為距離。標注框與聚類中心框的形狀越相近,交并比越大,D越小,因此通過計算能獲取最小距離對應的最佳錨點框。

本文在所有船舶樣本(即所有的標注框b)中隨機指定9個聚類中心(即聚類中心框c

;考慮不同類型船舶的長寬比有明顯差別,每種船舶至少選取一個聚類中心)形成9個集群

;用式(7)計算每個樣本與9個聚類中心的距離D,將樣本劃分到與其距離最小的集群中,并將每個聚類中心更新為當前集群的均值;重復以上步驟直至聚類中心變化很小,得到9個最佳聚類中心。

3.2 船舶定位優化

視差值直接影響測距效果,但在背景復雜,船舶在視圖中占比小、特征不明顯的情況下,用傳統的BM算法、SGBM算法都不能得到有效的視差圖。SIFT算法通常在搜索正確的特征時更加準確,但更加耗時。SURF算法特征描述子大部分基于強度差值,計算更快捷。考慮船舶定位所需的實時性,本

文先利用SURF算法對左、右視圖進行特征點匹配,然后在此基礎上使用YOLOv3網絡檢測到的船舶邊框對特征點對進行約束篩選,從而快速、準確地獲得有效視差并進行距離計算和定位。測距定位流程見圖5。

3.2.1 SURF算法匹配特征點

首先使用SURF算法對輸入的左、右相機圖像進行特征點提取和匹配,見圖6。

從圖6可見,存在大量的錯誤匹配點和無用匹配點(大樓匹配點)。因此,本文提出特征點對匹配閾值條件:

式中:v1和vr分別為特征點對在左、右視圖中的縱坐標值(由于兩張視圖在SURF算法匹配前進行過立體矯正,有效匹配的特征點對的縱坐標值應基本相同);N為在左視圖中檢測到的目標邊框數;M為在右視圖中檢測到的目標邊框數;用I1j判斷左視圖特征點是否落在左視圖第j個邊框中,是則為1,否則為0;用Irk判斷右視圖特征點是否落在右視圖第k個邊框中,是則為1,否則為0;T為閾值,可根據立體矯正效果設置,本文將其設置為10像素(本文拍攝的圖片的分辨率為960×480)。

3.2.2 特征點對條件約束

在圖6的基礎上,用式(8)進行條件約束,見圖7。在獲得同一目標的多組特征點對和多個視差值后,對視差值進行均值計算,提取最優視差值,最后通過式(5)和(6)計算船舶位置。

4 實驗與結果分析

4.1 雙目攝像機船舶視頻源

上海港國際客運中心碼頭東起高陽路,西至虹口港,北沿東大名路,南到黃浦江,岸線全長近1 200 m,是上海市水運重大交通樞紐之一,可同時停泊3艘7萬噸級的豪華郵輪。因此,對上海港國際客運中心碼頭船舶進行檢測與定位具有一定的實際意義。

本研究共使用15 000幀在上海港國際客運中心碼頭拍攝的圖片作為初始數據集,利用旋轉變換、加入高斯噪聲等數據增強的方式擴大圖像數據,增強YOLO模型神經網絡的泛化能力。隨后將擴大的圖像數據的分辨率校正為416×416大小,并按

7∶3的比例分為訓練集和測試集,其中訓練集包含21 000幀圖片,測試集包含9 000幀圖片。

本研究采用Windows 10操作系統,16 GB RAM,CPU I7-9750H主頻為2.6 GHz,GPU為RTX 2070,實驗平臺為Visual Studio 2017及Python 3.6.5。

4.2 實驗結果分析

為驗證檢測的有效性,對數據集進行訓練,訓練200次后,平均損失函數值下降到1以下并趨于穩定,表明該算法在訓練過程中具有很好的收斂性。

通過精確率-召回率曲線評估本文檢測方法的性能,對100幀圖片進行評估。假設測試圖中實際有船舶A艘,通過本文檢測方法檢測到的船舶有B艘,其中檢測到的的確是船舶的有C艘,則精確率P=C/B,召回率R=C/A。

根據圖8可知,在精確率為95%的條件下召回率能達到85%,而當召回率達到92%時精確率依然可以達到85%。

本文采用SURF算法得到特征點對,結合多目標檢測得到的船舶邊框處理特征點對,確定船舶最佳視差,通過計算得到船舶位置信息,效果見圖9。

為實現測距定位效果可視化,對測試圖中的船舶位置進行二維平面還原。多幀圖片的二維還原圖見圖10,其中:坐標為(0,0)的點與圖3中的Ol重合;Z軸與圖3中Zl軸重合;X軸與圖3中Xl軸重合。從圖10可知,本文算法預測位置與激光測距儀測量位置基本重合。

4.3 性能評估

4.3.1 多目標檢測性能評估

本文在YOLOv3網絡訓練過程中采用K均值聚類的方法對訓練集的邊框重新進行聚類,得到更加合適的錨點框。分別對原錨點框和新錨點框進行訓練得到兩個模型,再用這兩個模型對500幀圖片進行檢測并計算精度。結果表明,原錨點框訓練得到的模型的檢測精度為89%,新錨點框訓練得到的模型的檢測精度為94%。

4.3.2 測距性能評估

用(XV,ZV)和(XL,ZL)分別表示采用本文方法測得的船舶位置坐標和采用激光測距儀測得的船舶位置坐標,則單一船舶定位誤差可表示為

E=(XV-XL)2+(ZV-ZL)2(9)

本文對500幀圖片上的3 000艘船進行定位誤差計算,部分船坐標值及其定位誤差值見表1。最后求得最大誤差為16 m,平均誤差為11 m。

考慮距離遠近對定位誤差的影響,每100 m計算一次平均誤差值,目標距離與本文方法定位誤差關系曲線見圖11。由圖11可見,定位誤差隨距離增大而增大。

大量實驗表明,本文方法能實現對播放速度為30幀/s的視頻中目標的高精度自動檢測和10次/s的目標位置信息更新。在現今有人值守的船端,船員能夠通過視覺傳感器實時獲悉周邊有無他船、他船種類和他船位置信息。

5 結束語

本文提出的基于YOLOv3算法的船舶檢測與定位方法對播放速度為30幀/s的視頻中目標的平均檢測精度達94%,目標在1 n mile內的平均定位誤差為11 m左右。本文方法對智能船舶視覺感知信息與雷達、船舶自動識別系統(AIS)信息的融合,以及避碰輔助決策具有非常重要的作用。本研究僅利用激光測距儀對定位方法進行評估,且并未考慮船舶大小和船舶定位點(定位點為船首或桅桿)。后續將測算船舶大小,確定船舶定位點,并且融合雷達、AIS等海上交通數據,對定位方法進行進一步評估。

參考文獻:

[1]蔣晶晶, 安博文. 低空航拍視頻中基于Vibe算法的船舶檢測方法[J]. 微型機與應用, 2017, 36(10): 44-47. DOI: 10.19358/j.issn.1674-7720.2017.10.013.

[2]李雙雙. 內河視頻監控中運動船舶檢測算法研究[D]. 大連: 大連海事大學, 2018.

[3]GIRSHICKR, DONAHUE J, DARRELL T,et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2014: 580-587. DOI: 10.1109/CVPR.2014.81.

[4]GIRSHICKR. Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision. IEEE, 2015: 1440-1448. DOI: 10.1109/ICCV.2015.169.

[5]RENShaoqing, HE Kaiming, GIRSHICK R,et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6): 1137-1149. DOI: 10.1109/TPAMI.2016.2577031.

[6]LIUWei, ANGUELOV D, ERHAN D,et al. SSD: single shot multi-box detector[C]//European Conference on Computer Vision 2016, Lecture Notes in Computer Science. Springer, 2016, 9905: 21-37. DOI: 10.1007/978-3-319-46448-0_2 vol 9905.

[7]SHAOZhenfeng, WANG Linggang, WANG Zhongyuan,et al. Saliency-aware convolution neural network for ship detection in surveillance video[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2020, 30(3): 781-794. DOI: 10.1109/TCSVT.2019.2897980.

[8]SHAOZhenfeng, WU Wenjing, WANG Zhongyuan,et al. SeaShips: a large-scale precisely annotated dataset for ship detection[J]. IEEE Transactions on Multimedia, 2018, 20(10): 2593-2604. DOI: 10.1109/TMM.2018.2865686.

[9]HUANGZhijian, SUI Bowen, WEN Jiayi,et al. An intelligent ship image/video detection and classification method with improved regressive deep convolutional neural network[J]. Complexity, 2020(1): 1-11. DOI: 10.1155/2020/1520872.

[10]劉博, 王勝正, 趙建森, 等. 基于Darknet網絡和YOLOv3算法的船舶跟蹤識別[J]. 計算機應用, 2019, 39(6): 1663-1668. DOI: 10.11772/j.issn.1001-9081.2018102190.

[11]REDMONJ, DIVVALA S, GIRSHICK R,et al. You only look once: unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). IEEE, 2016: 779-788. DOI: 10.1109/CVPR.2016.91.

[12]張帆, 王欣, 孫增玉. 基于雙目視覺+激光測距融合的空間目標位姿測量方法研究[C]//第二屆中國空天安全會議. 中國指揮與控制學會空天安全平行系統專業委員會, 2017: 109-116.

[13]YANGM S, SINAGA K P. A feature-reduction multi-viewK-means clustering algorithm[J]. IEEE Access, 2019, 7: 114472-114486. DOI: 10.1109/ACCESS.2019.2934179.

[14]CHENWei, CAO Qian. Feature points extraction and matching based on improved SURF algorithm[C]//2018 IEEE International Conference on Mechatronics and Automation (ICMA). IEEE, 2018: 1194-1198. DOI: 10.1109/ICMA.2018.8484336.

[15]FANGQiang, ZHUO Li, HU Xiaochen,et al. Fine-grained vehicle recognition using hierarchical fine-tuning strategy for urban surveillance videos[C]//2016 International Conference on Progress in Informatics and Computing (PIC). IEEE, 2016: 233-236. DOI: 10.1109/PIC.2016.7949501.

(編輯 賈裙平)