利用深度特征融合進行高光譜遙感影像分類

韓彥嶺,劉業錕,楊樹瑚,崔鵬霞,洪中華

(上海海洋大學 信息學院,上海 201306)

0 引言

高光譜遙感(hyperspectral remote sensing)技術是基于窄而連續的光譜通道對地物持續遙感成像的技術,它將成像技術和光譜技術相結合,能夠獲取地物接近連續的窄波段圖像數據。高光譜影像(hyperspectral image,HSI)是在二維空間圖像的基礎上,增加了一維光譜數據,光譜通道數多達數十甚至數百個以上,具有“圖譜合一”的特性,其內部包含的豐富二維圖像信息和接近連續的光譜信息可以實現對地物的精細區分。近年來,HSI以其獨特的優勢在自然資源調查、生態環境調查以及農業和城市管理等領域發揮著重要的作用[1],其中利用HSI進行地物分類是其重要的研究內容。高光譜影像包含的豐富空間信息和接近連續的光譜信息為精細化地物分類提供了數據支撐。同時,其高維度、大數據量的特點也對傳統地物分類方法提出了挑戰。目前,傳統的高光譜影像分類主要利用圖像的光譜信息通過機器學習方法實現,如K近鄰算法(k-nearest neighbor,KNN)[2]、最大似然法[3]、支持向量機(support vector machine,SVM)[4]等,這些算法屬于淺層學習方法,難以提取隱含在高光譜數據中的深層特征,限制了高光譜分類精度的提高。在傳統的方法中,為了充分利用高光譜遙感的空間信息進一步提高分類精度,需要通過一定的算法提取表征空間特征,如Su等[5]提出了一種基于灰度共生矩陣(gray level co-occurrence matrix,GLCM)紋理分析的渤海海冰檢測方法;Imani等[6]通過GLCM、Gabor濾波(gabor filtering)和形態學輪廓(morphology profiles,MP)從相鄰像素中提取空間信息,研究空間特征與光譜特征的不同組合。2016年,王建華等[7]提出了一種加入空間紋理信息的遙感影像道路提取方法,對圖像進行空間自相關Moran指數計算,提取圖像空間紋理信息,并將其加入到原始光譜波段中,取得很好的效果。近幾年,人工智能爆發式發展,各種深度學習算法也逐漸開始發展成熟。大量研究表明,深度學習中的卷積神經網絡在計算機視覺圖像分類中相對于傳統算法具有明顯優勢。Krizhevsky等[8]提出的AlexNet深度卷積神經網絡,在ILSVRC 2012圖像分類大賽中獲得冠軍,與傳統分類算法相比錯誤率降低了10%左右;He等[9]提出了一種深度殘差網絡(deep residual network,Resnet),可以將網絡的層數增加到上百層,提取更多的特征信息;Chen 等[10]在遙感領域提出了一種基于深度學習的高光譜影像分類方法;Zhao等[11]利用深度學習多尺度二維卷積網絡(two dimensional convolution neural network,2D-CNN)對高光譜遙感影像進行深度表達并融合多波段光譜信息進行分類。這些方法大多沒有充分利用遙感影像的空間信息。隨著深度學習的深入發展,Li等[12]提出了三維卷積神經網絡(3D-CNN),通過“立方體”的感受野直接提取高光譜影像的空間和光譜特征信息,分類精度相對于傳統方法和2D-CNN具有一定程度的提升;Zeiler等[13]通過實驗分析卷積網絡中各層的特征圖,觀察每層卷積層提取圖像的特征信息,實驗表明,淺層卷積層主要提取了邊緣、顏色、輪廓等局部區域信息,高層卷積層主要提取抽象的特征信息,對物體的大小、位置和方向敏感性低;Chopra 等[14]提出了孿生網絡(siamese network),將2個CNN模型的特征融合起來,能夠提高分類精度;Guo等[15]提出了一種基于CNN的空間特征融合方法,將卷積網絡提取的空間特征與光譜特征融合起來進行分類;Song等[16]提出了深度融合網絡的策略,對于Indian Pines、Salinas Pines、Pavia等數據集進行實驗,獲得了較好的分類精度。通過以上分析,目前的高光譜遙感影像分類中,采用的融合策略大多為光譜信息和空間信息的融合,針對不同卷積層提取的特征在分類中所起的不同作用方面研究較少。

基于上述研究,本文提出了一種基于深度特征融合的高光譜遙感影像分類方法,構建3D-CNN深度網絡同時利用光譜信息和空間信息進行深度特征提取,分析不同網絡層提取的特征信息的差異,研究不同的特征融合策略,有針對性地深度挖掘高光譜遙感影像中的空譜特征,進一步提高地物分類精度。本文采用“珠海一號”高光譜衛星數據進行實驗,并與其他經典方法進行對比分析。

1 基于深度特征融合的高光譜遙感影像分類

在3D-CNN提出之前,2D-CNN已經在圖像分類、目標檢測等領域獲得廣泛的應用。但是高光譜影像光譜波段通常有幾十個以上,將2D-CNN應用于高光譜影像中,大部分是采用波段數據降維的圖像預處理方法[16-21],沒有很好地利用其空間信息,不利于進一步提高高光譜影像分類精度,因此本文基于3D-CNN進行深度空譜特征提取。

1.1 3D-CNN

1)卷積層。式(1)為三維卷積網絡的卷積操作計算公式。

(1)

2)激活函數。由于ReLU激活函數的計算復雜度非常低,而且收斂的速度很快[24],所以本文的實驗都是采用ReLU激活函數,如式(2)所示。

(2)

3)Softmax分類器。Softmax函數一般用于多分類問題,經過大量實驗表明,Softmax分類器具有良好的表現。Softmax的取值從0到1,表示屬于對應類別的概率,因此對于Softmax的值加起來總和等于1。Softmax函數表達式如式(3)所示。

(3)

式中:Si為第i個神經元中Softmax函數激活計算出來的值;yi為第i個神經元的輸出值;k表示需要分類類別的數量,如二分類器中k為2。

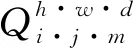

本文根據3D-CNN的特點,設計的三維卷積神經網絡結構包括6層卷積層和1層全連接層,訓練圖像的輸入大小為7×7×32,經過多層的卷積后得到1×1×26的特征信息。具體如圖1所示。

圖1 3D-CNNZ模型結構圖

1.2 特征融合策略

卷積神經網絡在特征學習過程中,在低層網絡主要提取顏色、邊緣等紋理特征信息,在中間層重點提取區域信息,高層網絡主要提取整體對象信息,此過程層層遞進,最后利用Softmax分類器進行像素分類時主要利用了高層特征信息。為了更充分利用各卷積層提取的不同特征信息,本文在獲取不同卷積層特征信息的基礎上,結合不同的特征融合策略,研究它們對地物圖像分類結果的影響,以期通過對不同層特征的深度融合改進分類精度。本文采用2種特征融合策略,一種是將卷積層的特征數據一維化后在全連接層中進行融合,另一種是在卷積層中對特征圖像進行融合。

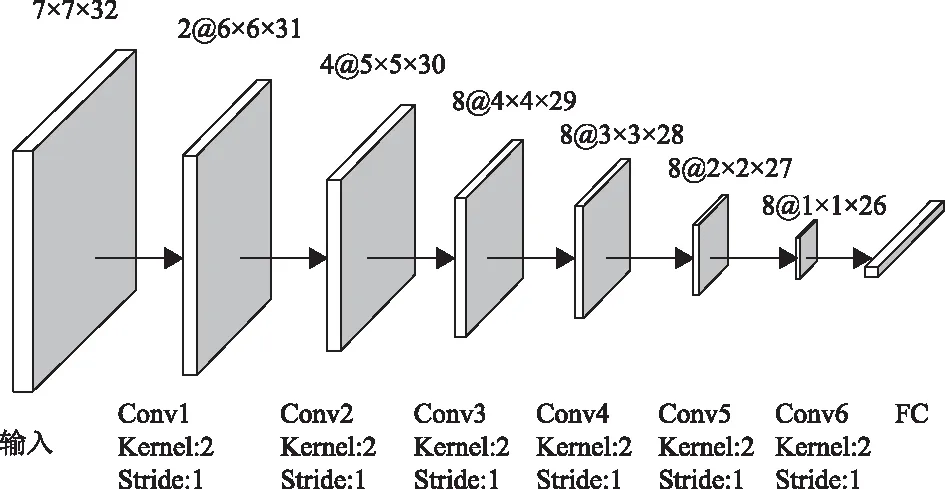

1)卷積層融合。不同卷積層提取的特征信息具有語義差異,通過對不同卷積層提取的特征進行融合可以深度提取地物特征并充分利用提取的特征進一步提高分類[25]。由于不同的卷積層輸出的特征圖維度不一樣,故不能直接將2層的特征信息融合到一起。本文提出的卷積層融合策略,如圖2所示,在①操作中,將Conv-n卷積層和Conv-(n+m)層特征信息融合,其中m>1。由于Conv-n卷積層和Conv-(n+m)卷積層特征圖維度不相同,需要通過合適的卷積核大小對特征圖降維,使得Conv-n卷積后特征圖的維度大小與Conv-(n+m)相同,此時可對2層特征進行融合。卷積層特征融合表達如式(4)所示。

Ff=g(yn)+yn+m

(4)

式中:yn表示第n層卷積層的輸出;yn+m為第n+m層的特征圖;Ff為融合后的特征信息;g(x)為卷積操作。

圖2 卷積層特征融合

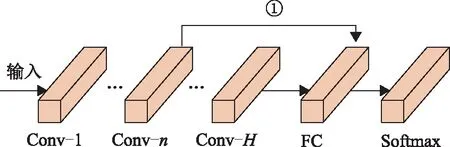

2)全連接層融合。3D-CNN網絡中最后一層卷積層輸出的數據經過全連接層后變成長度為N的一維向量。為了充分利用前面卷積層的特征信息,本文提出的全連接層融合策略是將各層的特征信息進行一維處理后,得到一維向量數據,將其數據與輸入全連接層的高層數據進行融合,可以得到多層次的特征信息。式(5)表示第n層卷積層特征信息。

(5)

式中:yn表示第n層卷積特征信息;k表示卷積核的個數;xi為第n層的第i張特征圖的映射;卷積的第i個卷積核參數表示為W;b為偏置值。特征融合的計算如式(6)所示。

Ffusion=f(yn)+fc(yh)

(6)

式中:Ffusion為特征融合的特征信息;f(yn)表示對第n層卷積層的特征信息進行一維化的處理;fc(yh)表示全連接層yh的特征信息。

圖3為全連接層融合,其中,紅色框部分為特征融合,Conv-n為第n層特征信息,Conv-H為最后一層特征信息。操作①是對第n層卷積層特征信息進行一維化處理后傳輸到全連接層進行融合。

圖3 全連接層特征融合

1.3 算法描述

由于卷積神經網絡的各層卷積層所提取的信息各不相同,淺層卷積層主要是反映物體的邊緣、輪廓、顏色等特征信息;高層卷積層主要反映了具有顯著姿態變化的整個對象。本文通過低中高層融合方法和中高層融合方法比較不同層特征信息對分類性能的影響,提出一種基于3D-CNN的多層特征深度融合算法。

1)低中高層融合方法。低中高層融合方法利用低中高層的特征信息,使用全連接層融合策略,對每一層獲得的特征圖進行一維化處理,處理后的特征信息在全連接層中進行融合,輸入Softmax分類器進行分類,獲得其特征信息對高光譜影像分類精度的影響。低中高層特征融合結構在圖3的3D-CNN模型基礎上進行改進,具體如圖4所示。

圖4 低中高層特征融合結構圖

2)中高層融合方法。為了分析低層特征對遙感影像分類的影響程度,中高層融合采取全連接層策略,只將中高層特征信息在全連接層進行融合,與低中高層融合方法進行比較,分析低層和中層特征信息對圖像分類結果的影響。中高層特征融合結構如圖5所示。

圖5 中高層特征融合結構圖

3)多輸入中高層融合方法。通過低中高層融合方法和中高層融合方法的分析,本文最終提出一種基于3D-CNN的多層特征深度融合算法。在一個感受野中,因為其值為隨機生成,故同一張圖像同一個感受野在不同層卷積中得到的特征信息也不相同。為了獲得更加豐富的特征信息,采用全連接層融合和卷積層融合策略,對實驗進行樣本增強和特征增強。在實驗前將已處理的訓練圖像集Lable分別輸入不同卷積層中,如圖6的多輸入中高層特征融合結構圖,在①操作中,將Lable輸入Conv1,進行Conv1~Conv6層直接卷積運算。在②操作中,把Lable通過調整卷積核大小為[3,3,3],以獲得與第2層卷積層Conv2相同維度的特征圖,并將其特征圖在Conv2融合。在③操作中,將Lable通過調整卷積核大小為[4,4,4],將特征信息在Conv3中融合。對于圖中②③,相當于只進行了5層和4層卷積,這樣的目的是獲得更多圖像數據的同時也獲得更多不同卷積層的特征圖。

圖6 多輸入中高層特征融合結構圖

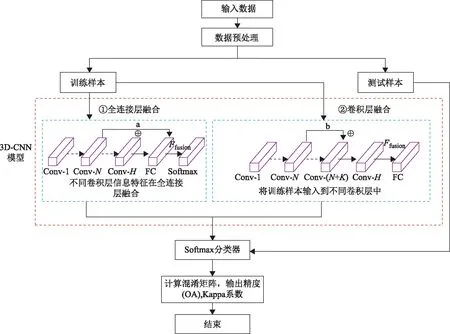

本文的算法流程如圖7所示。首先將高光譜數據進行預處理并制作樣本庫,對樣本庫中的數據分為訓練樣本和測試樣本,將訓練數據輸入3D-CNN模型中,實驗在3D-CNN模型中進行融合。本文提出2種融合策略,藍色虛線框①,為全連接層融合,融合的特征信息為不同卷積層的特征信息;藍色虛線框②為卷積層融合,在該過程中,將訓練樣本輸入多個卷積層中進行融合。

圖7 實驗方法流程圖

多輸入中,高層特征融合采用卷積層融合和全連接層融合相結合策略,具體實現如算法1所示。

算法1 多輸入中高層特征融合算法

輸入:

訓練圖像大小:M×M×B;

訓練樣本集:Label1;

測試樣本集:Label2;

設置每批輸入樣本數量:batch_size;

卷積核大小:kernel_size;

設定迭代次數:epoch;

卷積網絡層數:N;

開始:

(1)圖像預處理

步驟1:輸入高光譜影像數據;

步驟2:從步驟1輸入的數據提取帶標簽的樣本,每個樣本大小為M×M×B,形成樣本庫;

步驟3:將樣本庫隨機分為訓練樣本集Label1和測試樣本集Label2,訓練樣本和測試樣本比例為1∶1;

(2)3D-CNN特征融合

步驟4:在訓練樣本中,分批將所有樣本輸入3D-CNN網絡,設置batch_size(batch=25)參數,參數值表示每批樣本數;

步驟5:對網絡前N/2層進行卷積層融合,將訓練樣本集Label1輸入Conv1后,調整卷積核大小kernel_size,通過卷積操作對訓練樣本集Label1提取特征獲得特征圖feature2,…,featurek(k 步驟6:對網絡后N/2進行全連接層融合,對Conv(N-k)…Conv(N-1)、ConvN分別進行一維化處理,將得到的一維化特征信息輸入全連接層; 步驟7:在訓練的過程中,卷積層采用ReLU函數做非線性激活,將全連接層融合的特征輸入Softmax交叉熵損失函數,通過反向傳播機制計算每個參數的梯度,利用Adam優化算法更新網絡參數權重; 步驟8:設置epoch次訓練使得模型收斂并得到最佳訓練模型; (3)結果預測 步驟9:將測試樣本Label2輸入最佳的訓練模型,經過Softmax分類器對預測標簽進行預測,根據預測標簽和真實標簽計算混淆矩陣。 步驟10:通過計算混淆矩陣分析模型性能。 輸出:總體分類精度(Overall Accuracy,OA)、Kappa系數 結束。 珠海一號OHS高光譜衛星是我國唯一完成發射并組網的商用高光譜衛星,它對于水體、植被等具備識別與分析的能力,本實驗圍繞基于“珠海一號”衛星拍攝的高光譜影像進行地物分類展開分析,如圖8所示,實驗選取3套數據集。 珠海一號衛星高光譜影像總共包含32個波段,光譜分辨率為2.5 nm,空間分辨率為10 m,波段范圍在400~1 000 nm,實驗采用的各數據集拍攝時間以及經緯度如表1所示。 圖8 實驗數據遙感圖 表1 各數據集拍攝時間和經緯度 研究區域影像已做相對輻射定標、幾何校正處理。實驗選擇3種樣本,分別為水體、建筑、植被3個類別。類別描述如表2所示。 表2 地物類別 為了提高實驗效率,選取原始圖像大小為5 056×5 056×32的部分區域進行實驗分析,所選實驗區域大小為2 000×2 000×32。本文在選取樣本過程中,首先提取高光譜數據中典型的河流、植被、建筑等類別的像素點的光譜特征反射率曲線,并以此為參照,選擇感興趣的像素點并與參照像素點的光譜曲線進行對比,光譜曲線相近的歸為一類,作為該類別的訓練樣本,參照像素點的光譜曲線如圖9所示。 圖9 3種地物的光譜反射率 獲取3D-CNN輸入樣本則是根據上述已劃的分類別像素點獲取,其具體步驟為:對于每一類的像素點,以其中心取M×M的鄰域,將鄰域內所有像素點作為輸入數據,最終形成大小為M×M×B的數據塊[26-27]。如圖10所示,一個方格表示一個像素點,以像素點m為中心,其空間鄰域內m1~m8與m點屬于同類別的概率很大,在選取3×3圖像大小時,以m為中心點,包含鄰域[m1,m2,m3,m4,m5,m6,m7,m8],以此方法可獲5×5,7×7,…,n×n等圖像大小。本文使用7×7×32的三維圖像大小進行訓練。 圖10 提取訓練圖像大小方法 3個研究區域的數據集樣本總數和各類樣本總數如表3所示。 表3 各數據集樣本數(像素點) 在本文的實驗中,3D-CNN網絡模型、低中高層特征融合模型、中高層特征融合模型、多輸入中高層特征融合模型,均采用相同的模型參數設置。其主要模型參數如表4所示,卷積核大小為[2,2,2];為了獲得更有價值的參數,步長stride設置1;同時,因實驗設備運算能力限制,卷積核個數1~3層卷積層從2開始以2的倍數遞增,第4層卷積層開始均為8,實驗采用的填充方式為Valid,由于輸入的訓練圖像尺寸較小,實驗不包括池化層。 表4 3D-CNN模型參數 本文采用3D-Resnet(three dimensional deep residual network)、孿生網絡、SVM 3種算法作為對比算法,表5為對比算法和本文算法的調優參數設置,其對應參數為本文實驗數據中的最優參數。實驗以Windows7系統為操作平臺,ENVI 4.8和Matlab軟件為制作圖像標簽工具,采用TensorFlow-GPU框架。 表5 本文算法和對比算法的最佳調優參數 1)基于3D-CNN的實驗結果。為了進行對比分析,本文先不采用融合策略,通過基本的3D-CNN模型挖掘地物空譜信息對這3套數據集進行實驗分析,所使用的網絡模型結構如圖3所示。由于樣本隨機選擇,為了避免實驗最終結果具有偶然性,對每套數據集進行5次實驗,取其平均值作為總體分類結果,表6為基于3D-CNN基本模型的總體分類精度OA和Kappa系數。從表6可以看出,由于3D-CNN模型可以同時利用光譜信息和空間信息進行地物識別,在3組數據中都取得了較好的分類結果,總體分類精度分別為91.20%、92.43%、92.66%,Kappa系數分別為0.875 7、0.886 9、0.896 7。 表6 3D-CNN模型分類精度評價 2)不同特征融合策略的實驗結果對比。卷積神經網絡的各層卷積層所提取的特征信息不一樣,隨著網絡層數遞增,提取到更多的特征。為了進一步提高地物分類精度,充分挖掘不同層次特征對分類結果的影響,本節進行了不同的特征融合實驗并對實驗結果進行對比分析。 (1)低中高層特征融合。采用圖4的低中高層融合模型,利用低中高層的特征信息,因為每一層特征的維度不一樣,所以對每一層獲得的特征圖進行一維化處理,處理后的特征信息在全連接層中進行融合,分析其特征信息對高光譜影像分類精度的影響。 采用5次實驗的平均值作為最終分類結果,將融合后的實驗結果與采用基本3D-CNN網絡結構的結果進行對比,對比結果如表7所示。 表7 低中高融合分類精度評價 由表7可以看出,本文將低中高層特征信息融合到全連接層通過Softmax進行分類,在3套數據集上都獲得了較高的分類效果,分類精度分別為94.38%、94.42%、93.97%,其分類精度相對基本3D-CNN均有一定程度的提升,在3套數據集上分別提高了3.18%、1.99%和1.31%。 (2)中高層特征融合。采用圖5的中高層融合模型,只將中高層特征信息在全連接層進行融合,分析低中層特征信息中哪層特征對圖像分類結果影響比較大。使用3套數據集進行測試,其最終結果為5次結果的平均值,對比結果如表8所示。 表8 中高層融合分類精度評價 上述結果表明,低中高層特征融合總體上稍高于中高層融合的分類精度,但差別很小,精度差別分別為0.01%、0.13%、0.13%,二者的差別在于前者少了淺層的特征信息,說明在卷積神經網絡中,相對于中高層特征信息,淺層的卷積特征信息對于圖像的分類精度影響并不大。 (3)多輸入中高層特征融合策略。為了獲得更多圖像數據的同時也獲得更多的不同卷積層特征,采用圖6的多輸入中高層特征融合結構圖,分別對3套數據進行實驗,實驗結果為5次結果平均值,如表9所示。 表9 多輸入中高層特征融合分類精度評價 實驗結果表明,相對于無特征融合算法和中高層特征融合算法,多輸入中高層特征融合方法在3套數據集上均獲得了最好的分類效果,分類精度分別為96.46%、95.88%、94.80%,相比中高層融合方法分別提高了2.17%、1.59%、0.96%,相比基本3D-CNN方法分別提高了5.26%、3.45%、2.14%。 3)不同融合策略分類圖。通過對不同融合策略實驗對比分析,本文提出的多輸入中高層融合算法取得了比較好的效果,說明通過增加輸入圖像和融合不同層提取的特征信息可以獲得更好的分類精度。為了驗證本文算法的有效性,將上述不同融合方法結果進行可視化。為了更好地展示本文方法在紋理細節方面的識別效果,在3個實驗中針對不同的融合策略都選取了局部區域進行放大,如圖11中右下角的黑色矩形框為右上黑色矩形框標注的局部細節放大圖。從圖11可以看出,相比其他融合策略,本文提出的多輸入中高層特征融合方法在局部紋理細節的提取上更加精確,地物邊界更加完整清晰。 圖11 不同融合策略分類結果圖 4)與其他圖像分類方法的對比分析。為了進一步驗證本文方法的有效性,與傳統高光譜分類方法SVM及其他典型的深度學習方法,如孿生卷積神經網絡、3D-Resnet進行對比。采用相同的標簽樣本庫,同樣取5次實驗的平均值作為總體分類精度,對比實驗結果如圖12所示。 圖12 不同算法精度分析評估 由圖12可知,相對于傳統分類方法SVM以及其他的深度學習方法,本文提出的方法通過對多層特征進行深度融合,在3套高光譜數據中均獲得了最高的分類精度。SVM算法屬于淺層學習且只利用了地物光譜信息,對地物特征的表達能力有限,獲得較低的分類精度,在3套數據中精度分別為80.45%、83.12%、82.46%;孿生網絡使用二維卷積,沒有充分利用高光譜影像的空間信息,故其精度明顯低于3D-CNN的方法。本文方法由于充分利用了高光譜影像的空-譜聯合特征,通過特征融合集成了不同網絡層的特征優勢,相對于其他方法獲得了最高的分類效果,分類精度分別為96.46%、95.80%、94.80%。 在時間效率方面,本文方法和其他方法的對比結果如表10所示,結果均取5次實驗運行時間的平均值。由于SVM屬于淺層學習方法,相比深度學習方法在時間效率上表現最好;孿生網絡采用的是二維卷積網絡結構,時間成本也相對較低;3D-Resnet和本文方法均使用三維卷積網絡,訓練模型需要的時間相對較長。本文方法為充分挖掘不同卷積層的特征進行多輸入中高層特征融合,增加了網絡結構的復雜性,相比其他方法,其訓練時間稍長。 表10 不同方法的訓練時間 s 為充分挖掘不同卷積層提取的特征在高光譜遙感影像分類中的作用,本文提出了一種基于深度特征融合的高光譜遙感影像分類方法。實驗分析表明,在深度卷積神經網絡中,低層提取的特征信息對于高光譜影像分類結果影響不大,而中高層提取的特征包含地物的紋理、輪廓等抽象語義特征,對最終分類結果具有重要作用。本文結合不同層次所提取特征對分類影響的結果分析,采用多輸入中高層特征融合方法,通過在不同卷積層多次輸入訓練樣本以增加特征多樣性,再融合中高層的特征信息進一步增強對高光譜影像的特征表達,最后利用“珠海一號”獲取的3套高光譜數據進行地物分類實驗,并與3D-Resnet、SVM、孿生網絡等典型高光譜影像分類方法進行對比分析。結果表明,相比其他圖像分類方法,本文提出的方法都獲得了最好的分類性能,進一步驗證了本文算法的有效性。 文中的實驗數據雖然地物類別偏少,但所提方法對高光譜遙感影像分類具有一定的普適性,本文可為其他領域的高光譜遙感地物分類提供思路和參考。 致謝:本文所用高光譜實驗數據由珠海歐比特宇航科技股份有限公司提供,對此表示真摯的感謝。2 實驗與分析

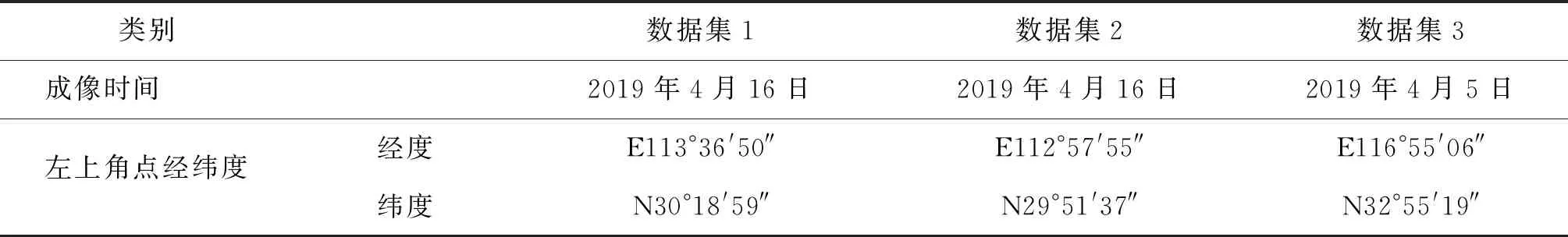

2.1 數據集描述

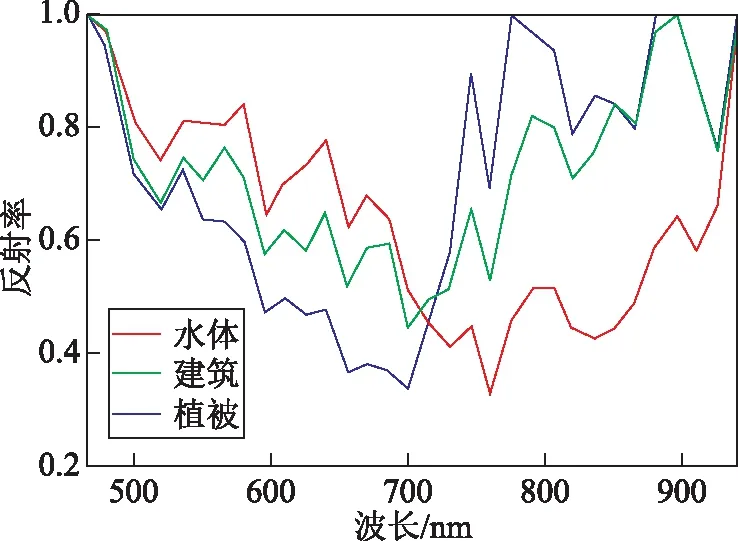

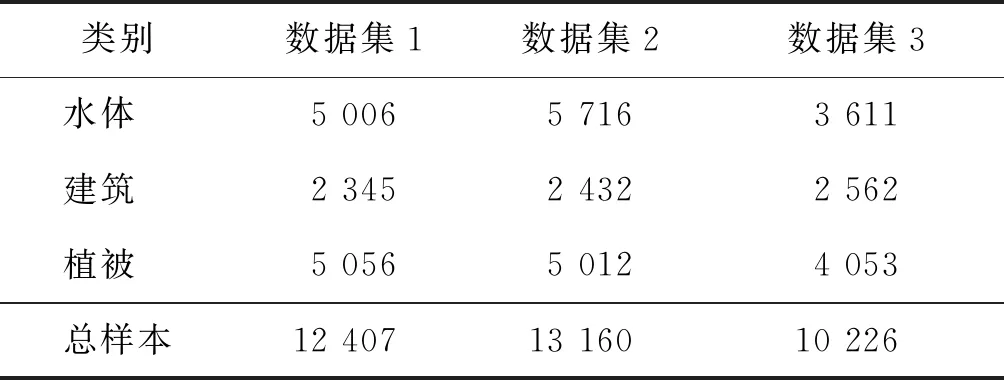

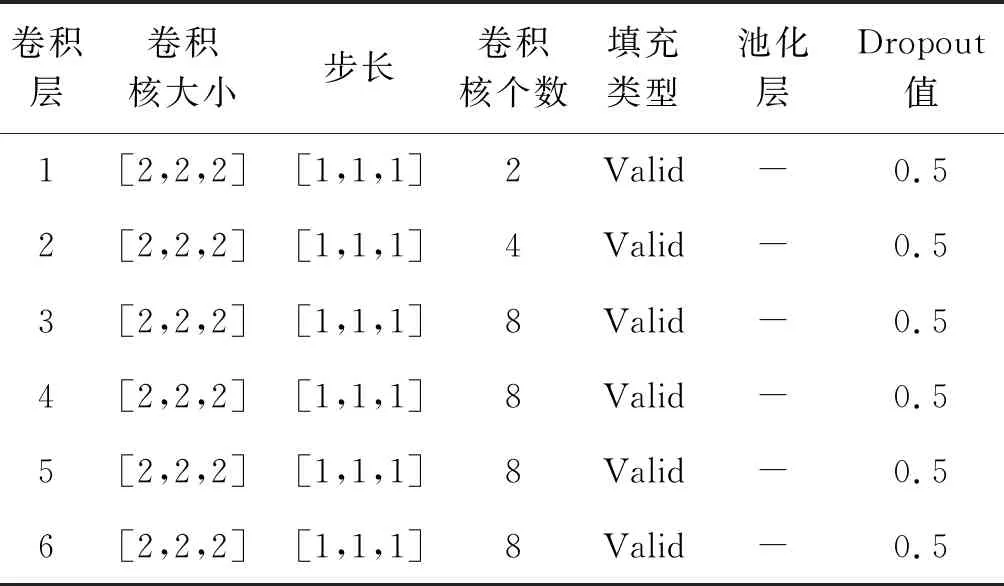

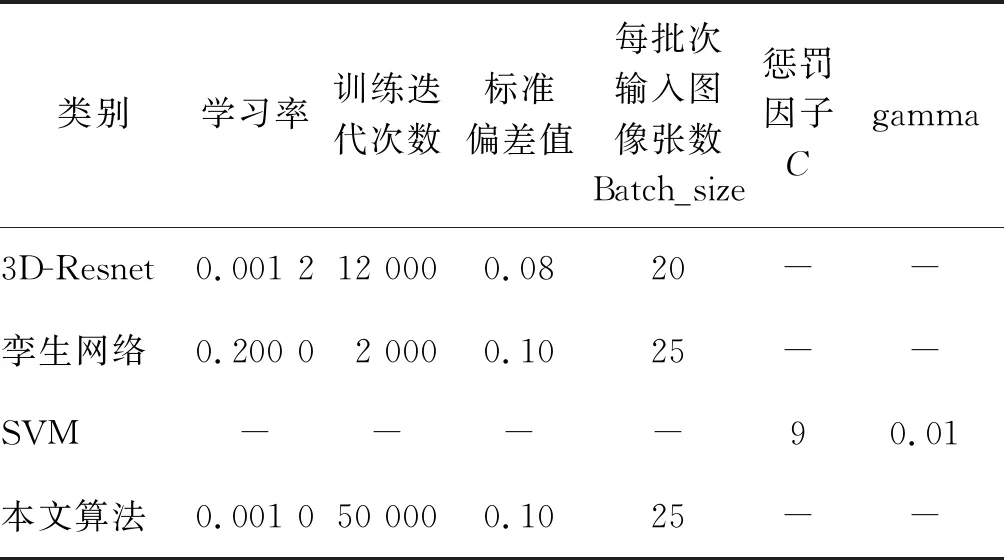

2.2 實驗設置

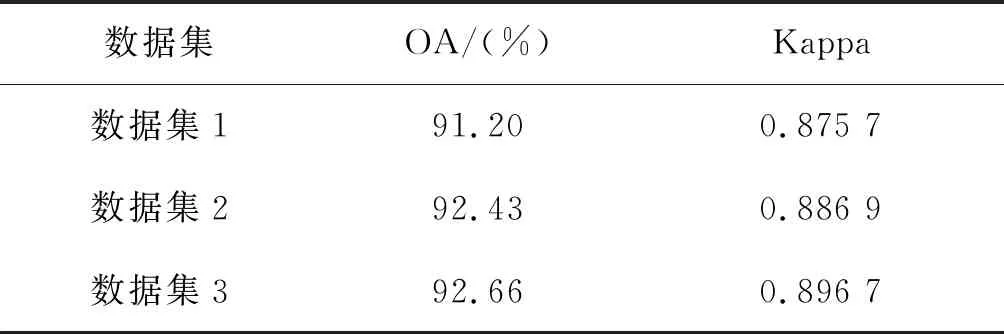

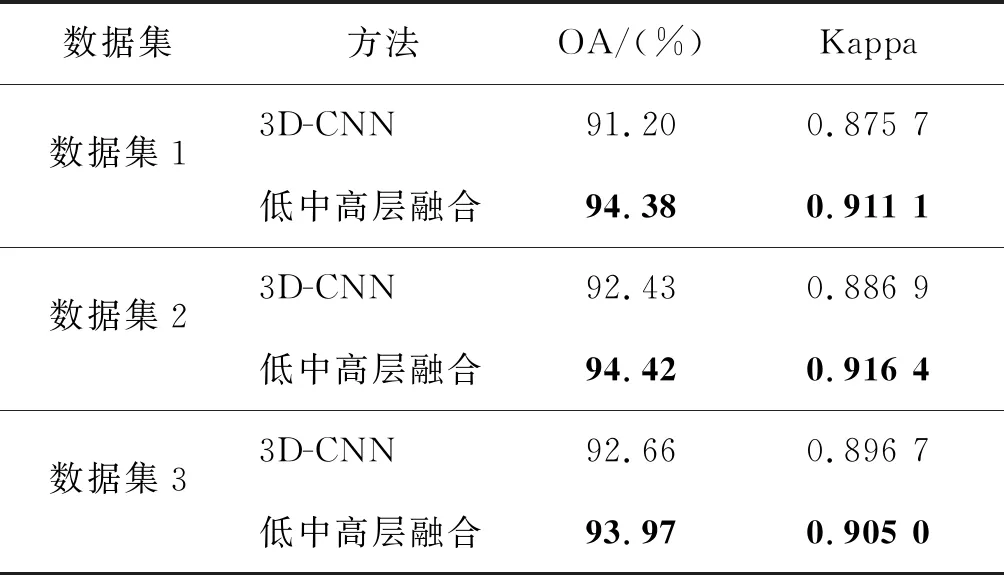

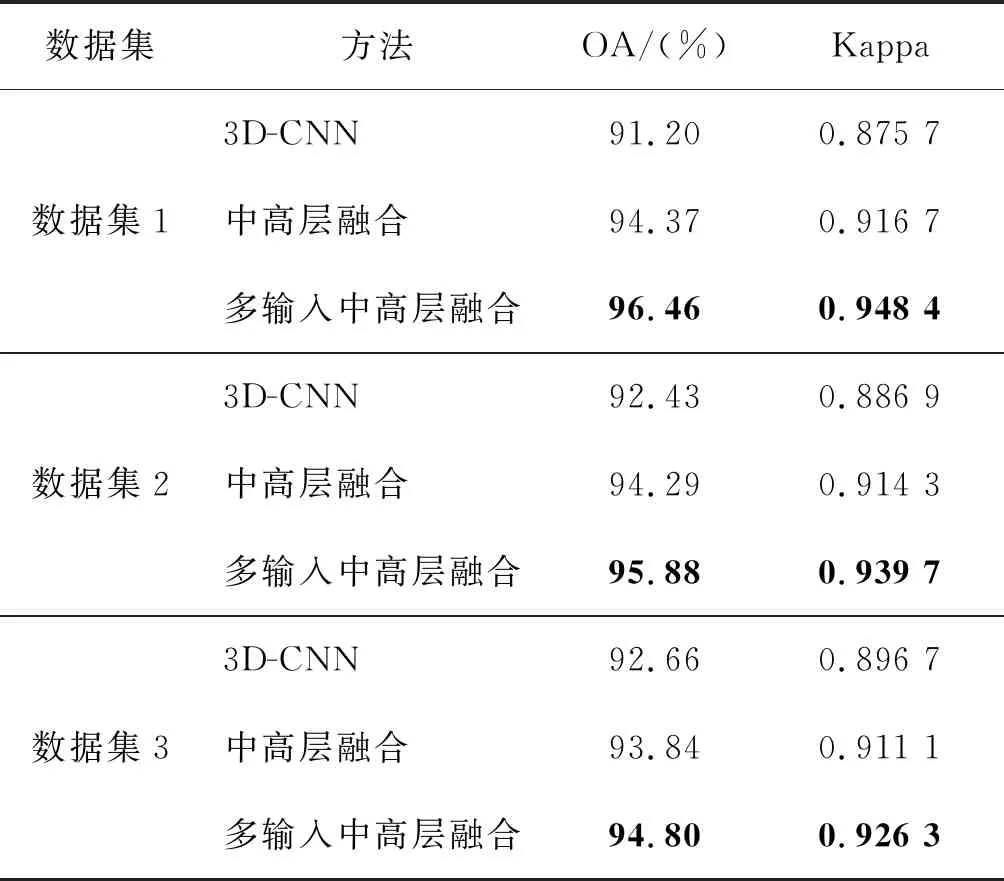

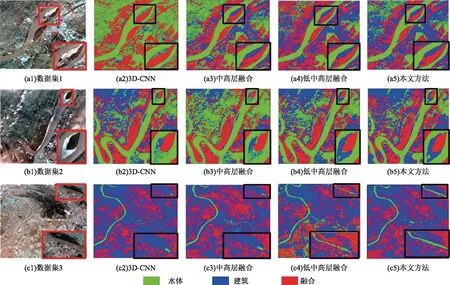

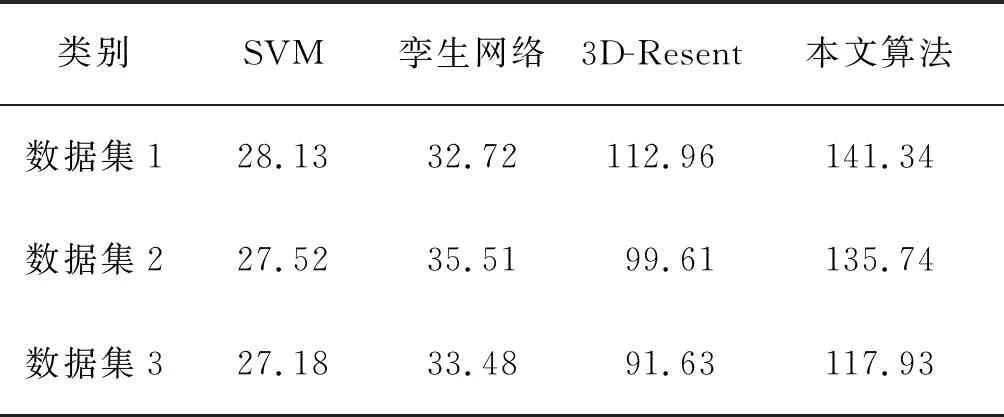

2.3 實驗結果和分析

3 結束語