基于上下文感知和尺度自適應的實時目標跟蹤

夏愛明,伍雪冬

〈圖像處理與仿真〉

基于上下文感知和尺度自適應的實時目標跟蹤

夏愛明,伍雪冬

(江蘇科技大學 電子信息學院,江蘇 鎮江 212003)

針對傳統核相關濾波視覺目標跟蹤算法在快速運動、背景雜波、運動模糊等情況下跟蹤精度低且不能處理尺度變化的問題,提出了一種基于上下文感知和尺度自適應的實時目標跟蹤算法。該算法在核相關濾波算法框架的基礎上,引入了上下文感知和尺度自適應方法,增加了背景信息且能夠處理目標的尺度變化。首先,利用融合了fHOG(fusion histogram of oriented gradient)、CN(color names)和灰度的特征對目標區域進行采樣,訓練一個二維位移濾波器,然后,在目標區域建立尺度金字塔,利用fHOG對目標區域進行多尺度采樣,訓練一個一維尺度濾波器,最后,在模型更新階段改進了更新策略。在標準數據集OTB-2015上對100組視頻序列進行的試驗結果表明,提出的算法比基準算法(kernel correlation filter, KCF)精度提高了13.9%,成功率提高了14.2%,且優于實驗中對比的其他跟蹤算法。在尺度變化、運動模糊、快速運動等條件下,提出的算法在準確跟蹤的同時,能夠保持較高的速度。

相關濾波;特征融合;上下文感知;尺度自適應

0 引言

目標跟蹤是計算機視覺領域極具挑戰性的課題,在服務型機器人、視頻監控、人機交互、智能交通等方面有著廣泛的應用前景。但在實際的場景中,存在著目標尺度變化、遮擋、姿態變化、光照變化等問題,這些問題影響了目標跟蹤的準確性和成功率,因此如何解決這些問題成為視覺目標跟蹤方向的研究熱點[1-2]。

針對在實際場景中存在的問題,研究人員提出了多種算法,但是目前還沒有通用的算法可以解決所有問題。總體而言,現有的目標跟蹤算法主要分為生成式算法和判別式算法[3-4]。

近年來,基于判別式的相關濾波跟蹤算法,因其結構簡單和速度快而得到了廣泛的關注[5-8]。Bolme等[9]首次將相關濾波引入目標跟蹤領域,并提出最小均方誤差和(minimum output sum of squared error, MOSSE)濾波器,采用簡單的灰度特征即達到了快速高效的跟蹤。Henriques等[10]提出了經典的核相關濾波算法(kernel correlation filter,KCF),采用方向梯度直方圖(histogram of oriented gradient,HOG)[11]特征并引入循環采樣、核方法和嶺回歸分類器,算法高速且精度高,成為了后續眾多算法的基礎,但是該算法沒有考慮尺度變化和背景信息,對尺度變化、背景雜波等不夠魯棒。Danelljan等[12]提出了自適應顏色屬性跟蹤算法(color names,CN),利用顏色名[13]作為特征進行目標跟蹤,取得了不錯的效果,但是特征單一,對光照變化不夠魯棒。Danelljan等[14]提出了尺度自適應跟蹤算法(discriminative scale space tracker, DSST),利用降維后的HOG特征和灰度特征進行位置跟蹤,利用HOG特征進行尺度跟蹤,實現了對目標尺度的魯棒跟蹤,但是其尺度金字塔尺度較粗,在尺度較細時,跟蹤不夠魯棒。Mueller等[15]提出了上下文感知相關濾波算法(context-aware correlation filter tracker, CACF),在目標周圍提取圖像塊作為訓練樣本,增加了訓練樣本的背景信息,且速度損失較小,但是其更新策略不夠魯棒。

本文針對核相關濾波算法沒有考慮尺度變化、背景信息較少的問題,提出了一種改進的基于核相關濾波的實時視覺目標跟蹤算法(improved kernel correlation filter,IKCF),該算法引入上下文感知相關濾波來增加背景信息,并改進其更新策略,顯著提高其精度和成功率,將HOG特征替換為融合fHOG、CN和灰度的特征,獲取更多的特征信息,增強特征的魯棒性,采用一維尺度金字塔尺度濾波器估計尺度,兩維位置濾波器估計位置,并改進尺度金字塔的尺度粗細,引入了尺度估計且保證算法的實時性。

1 基于核相關濾波的改進算法

核相關濾波算法通過對單個樣本進行循環移位形成豐富的樣本庫,利用樣本庫建立目標表觀模型,訓練一個正則化的最小二乘(嶺回歸)分類器,利用核函數在傅里葉域進行分類器訓練和響應檢測,得到濾波器模板和目標在新一幀的位置,實現了目標的在線訓練與跟蹤。雖然KCF算法取得了不錯的跟蹤效果,但是其跟蹤準確性和成功率還有進一步提升的空間。

本文針對KCF算法在目標尺度變化、快速運動、背景雜波、運動模糊等情形下出現跟蹤失敗或跟蹤精度不高的問題,對KCF算法在目標特征、背景信息、跟蹤策略和更新策略方面進行了改進。

1.1 特征融合

在目標跟蹤過程中強大的特征可以顯著提高跟蹤的準確度和檢測的性能。

KCF算法在CSK(circulant structure of tracking- by-detection with kernels)算法[16]的基礎上將灰度特征替換為HOG特征,性能得到了大幅地提升,CN在CSK的基礎上用顏色名特征對灰度特征進行了替換,并利用主成分分析技術(principal component analysis, PCA)將11維顏色特征降為2維,取得了很好的效果,可見HOG特征和CN特征對目標表觀建模有很強的表達能力。

fHOG[17]特征是將36維HOG特征縮減為32維特征而得,包括18維對比度敏感的方向通道、9個對比度不敏感的方向通道、4個紋理通道和一個全零通道,這種改進的HOG特征保持了傳統HOG特征判別能力,且縮減了通道維數,從而減少了計算量,加快了跟蹤速度,本文去除全零通道,將fHOG縮減為31維。顏色名特征(CN)是人類用來表示世界上顏色的語言標簽,包含11個基本的顏色術語:黑色、藍色、棕色、灰色、綠色、橙色、粉色、紫色、紅色、白色和黃色,這種描述比常用的顏色(如RGB、Hue等)具有更好的表達能力。本文沒有采用CN算法的降維方法,而僅保留了其中的10維通道。原始的灰度像素特征雖然沒有HOG和CN特征表達的信息多,但是其特征表達能力仍不能忽略。

由于核相關函數只需要計算點積和向量范數,因此可以對圖像特征應用多個通道。本文中將31維的fHOG、10維的CN和1維的灰度像素共42個通道連接到一個向量中,使得本文提出的算法可以使用更強大的特征,特征的可視化見圖1。

1.2 環境上下文感知相關濾波

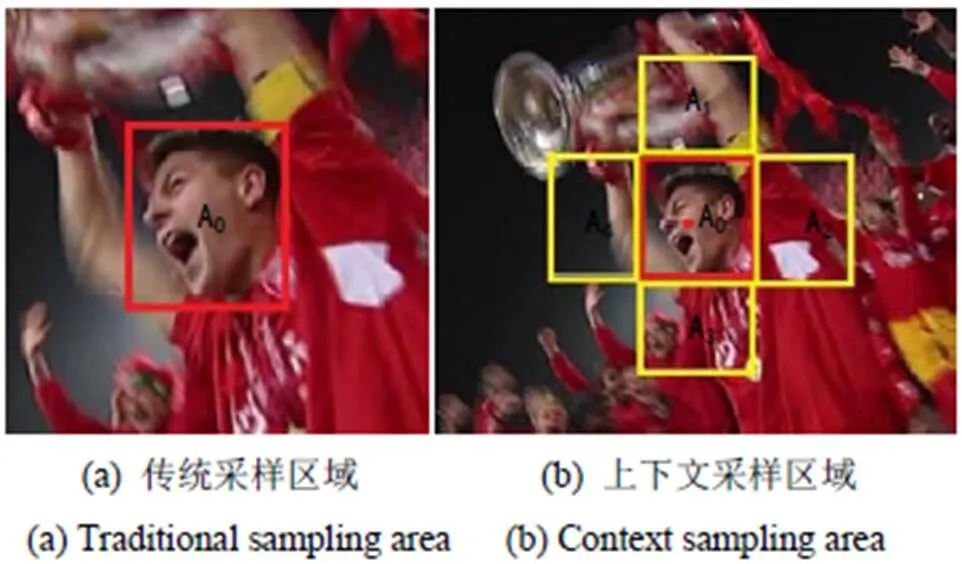

目標跟蹤通常在第一幀人工給定一個矩形框,根據給定的矩形框進行跟蹤。基于核相關濾波的算法一般都是在給定矩形框的基礎上放大1~2倍建立搜索區域,但是這樣做會丟失很多背景信息,而目標周圍的背景對于跟蹤的性能有很大影響,如相似物體的背景雜波等。文獻[15]提出了在訓練階段向濾波器添加上下文環境信息的環境上下文相關濾波跟蹤算法,增加更多的背景信息,采樣區域如圖2所示。

圖1 融合特征的可視化

圖2 采樣區域

在每一幀中,對目標樣本周圍的個上下文圖像塊a(=1,2,…,)進行采樣,它們對應的循環矩陣為(=1,2,…,),這些上下文圖像塊可以視為硬性負樣本。它們以各種干擾物和不同背景的形式包含目標周圍的背景。這樣可以學習一個包含上下文樣本的濾波器,使得濾波器對目標產生較高響應,對上下文背景樣本響應接近零。包含環境上下文圖像塊的最小化目標函數為:

上式在單通道特征原始域中的解為:

式中:表示圖像的第幀;為學習率。

1.3 跟蹤過程

1.3.1 位移相關濾波

基于HOG特征的相關濾波跟蹤器(比如KCF,DSST)通過提取灰度圖像的方向梯度圖對特征進行表達,對運動模糊和光照變化魯棒性高,但對顏色跟蹤效果不魯棒,CN特征側重于顏色信息,對顏色魯棒性高,對運動模糊和光照變化效果不佳,兩者具有互補作用,提出的算法將兩者結合并加上灰度特征,在KCF框架的基礎上引入環境上下文感知,用于2維位移相關濾波訓練和檢測。將表示特征的多個通道連接到一個向量中,連接后的特征向量為c=[1,2, …,42],則公式(2)為:

響應的檢測公式為:

1.3.2 尺度相關濾波

KCF跟蹤算法采用固定的目標搜索區域,沒有考慮目標尺度的變化,跟蹤過程中目標尺度變化時,容易導致跟蹤失敗。為了保證跟蹤的成功率,需要對目標的尺度變化進行估計。目前尺度估計算法的一種常見思路是將尺度估計并入位移跟蹤器,構成三維濾波器(如SAMF,scale adaptive with multiple features tracker[17]),而濾波器維數越高需要的計算成本越高,這將降低跟蹤器的速度。理想情況下,精確的尺度估計方法應該是魯棒的,同時計算效率高。文獻[14]提出了一種快速尺度估計方法,通過分別獨立學習一個二維位移濾波器和一個一維尺度估計濾波器,相比融合尺度和位移的三維濾波器擁有更低的計算成本。此方法可以獨立選擇特征,而尺度估計加入CN特征對于尺度濾波器跟蹤意義不大,還可能降低跟蹤的效果,因此,提出的算法在這種方法的基礎上采用31維的fHOG特征進行尺度跟蹤,以估計目標圖像塊的尺度。

1)一維尺度金字塔構建

設和分別表示當前幀中目標的寬和高,表示尺度濾波器中的尺度數,其值取為33。以位移濾波器預測的目標位置為中心,構建尺度金字塔圖像塊J,表達式如下:

式中:b表示各個特征層之間的尺度因子,在實驗中觀察發現,兩幀圖像間尺度變化不會特別大,故本文采用細尺度,取值為1.002,通過式(6)可以得到33個以目標尺度為中心的尺度金字塔,如圖3。

2)一維尺度估計

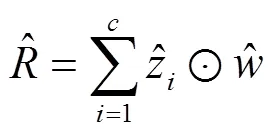

利用下式計算尺度相關濾波器響應值R,以最大響應尺度為當前目標尺度。

1.4 更新策略

在KCF中利用簡單線性插值作為模型更新策略被證明不是最優的[12],因為在更新模型時只考慮當前幀,而且之前幀在模型中的貢獻指數衰減過快。為了提高KCF的魯棒性,本算法采用了CN中提出的更新策略,同時考慮了當前幀和之前所有幀中的目標圖像塊,對分子分母分別更新,公式(4)和(8)的更新方式如下:

式中:1、2分別為位移濾波器和尺度濾波器的學習率。

2 算法流程

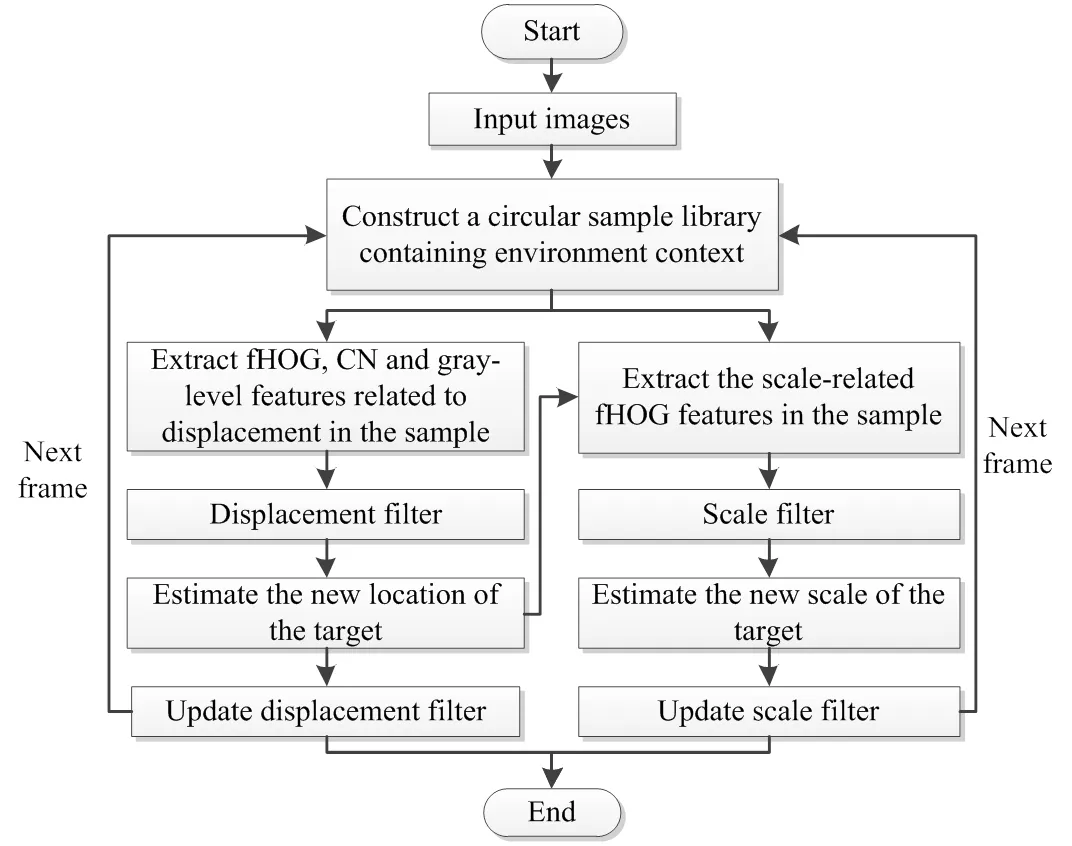

基于上述策略,文中算法的跟蹤步驟如下。

輸入:

當前幀圖像I;

先前目標位置p-1和尺度s-1;

位移模型A-1、B-1和尺度模型C-1、D-1。

輸出:

當前幀目標位置p和尺度s;

更新位移模型A、B和尺度模型C、D

位移估計:

1)在當前幀圖像I中位置p-1和尺度s-1處提取位移樣本trans;

尺度估計:

5)在當前幀圖像I中位置p和尺度s-1處提取尺度樣本scale;

模型更新

9)利用公式(9)、(10)更新位移模型A、B;

10)利用公式(11)、(12)更新尺度模型C、D

當輸入下一幀圖像I+1時,重復以上步驟,算法的整體跟蹤框架如圖4所示。

3 實驗驗證與分析

3.1 特征和參數設置

所有訓練集視頻的參數設為固定,以防止過擬合。正則化參數設置為=0.0001,1=0.01。

將位移濾波器期望的相關輸出的標準偏差設置為目標大小的1/10。濾波器大小設置為初始目標大小的3倍。

位移濾波器的二維高斯標簽的帶寬=0.4,尺度濾波器的一維高斯標簽帶寬1=0.25。位移和尺度濾波器的學習率分別設置為1=0.005,2=0.03。

位移濾波器中使用的fHOG特征單元尺寸采用4×4,尺度濾波器使用的fHOG特征單元尺寸采用1×1。尺度參數設置參照第1.3.2節。

圖4 本文算法流程圖

3.2 實驗設置

本文的所有代碼在MATLAB R2016a上編譯實現。在CPU為Intel G630,主頻2.70GHz,內存為4GB的臺式計算機上運行。

3.2.1 數據集

Wu等[18]建立了一套評估目標跟蹤算法的視頻測試數據集OTB-2015,其中包含100個視頻,涵蓋了光照變化、顏色變化、快速移動、遮擋、尺度變化等一系列視頻目標跟蹤的過程中常見的問題,具有較高的代表性,已成為目標跟蹤領域的通用測試集,提出的算法在此數據集中的全部100個視頻序列中運行。

3.2.2 評估方法

為了評估跟蹤算法的性能,實驗中采用OTB-2015測試數據集中兩種通用評估方法即精度圖(precision plots)和成功率圖(success plots)作為定量評價標準,評估方式采用一次跟蹤評估(one-pass evaluation,OPE),即所有的視頻序列只跟蹤一次。

在精度圖中,根據某范圍內的閾值來繪制平均距離精度(distance precision, DP),使用的指標是中心位置誤差(center location error, CLE),CLE定義為算法預測的目標框中心坐標與視頻序列中人工標注的框中心坐標之間的平均歐式距離。DP為CLE小于某一閾值的幀數占總幀數的比值,計算公式為DP=/,為算法預測的位置與目標的真實位置小于一定閾值時的幀數,為跟蹤視頻的總幀數,實驗采用標準閾值(20像素)。

成功率圖的評估標準是成功率(Success Rate, SR),即跟蹤目標框與人工標注目標框之間的重疊率超過一定閾值的幀數與跟蹤視頻的總幀數的比值,用重疊率R表示,計算公式為:

式中:T為算法預測目標框;G為人工標注目標框,area(T∩G)表示區域重疊面積,area(T∪G)表示區域合并面積。實驗中采用標準閾值0.5,大于該值認為跟蹤成功。

為了評估算法的實時性,采用平均跟蹤速度進行評估,平均跟蹤速度定義為視頻幀數除以算法跟蹤圖像總耗時,單位為fps(幀/每秒),文中以文獻[19-20]中定義的15fps作為實時性的判別標準。

3.3 與先進算法的對比與分析

實驗中選擇了OTB-2015中提供的可用于運行100組視頻的7種算法,分別為CT(compressive tracking)、IVT(incremental learning for visual tracking)、DFT(distribution fields for tracking)、ASLA(adaptive structural local sparse appearance model)、L1APG(L1 tracker using accelerated proximal gradient approach)、ORIA(online robust image alignment)、CSK(circulant structure of tracking-by-detection with kernels),新加入了近年來比較先進的算法3種,分別為KCF、CN和DSST。IKCF為本文提出的算法。為了保證測試的客觀性,所有的對比算法都采用其原始代碼和參數,并在相同的測試環境中進行。

3.3.1 不同算法的特點

表1列出了最新6種算法的特點,從表1中可看出,本文算法采用了更強的特征來表征目標,并且加入了尺度估計。

3.3.2 不同算法幀率

表2列出了全部11種算法在不同視頻上的跟蹤速度,表中第1行為視頻序列,最后1列為運行速度,單位fps,表中加粗字體表示其對應的算法達到了實時性的要求。從表2中可以看出,L1APG算法的跟蹤速度僅約0.6fps,遠不能達到實時要求,而本文提出的算法可以達到26fps,與DSST相近。

表1 6種最新算法的特點

表2 11種算法運行速度對比

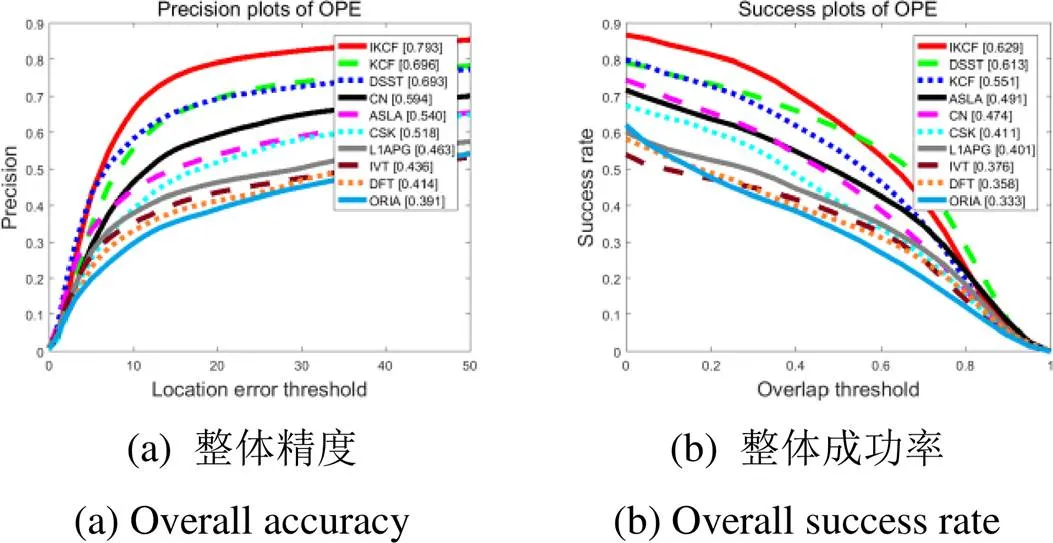

3.3.3 定量分析

將11種算法在標準OTB-2015視頻數據集上運行,得到排名前10的10種算法精度曲線圖和成功率曲線圖圖5。圖5為全部100組視頻的整體精度和成功率圖。從圖中可看出,文中提出的算法在整體跟蹤精度和成功率上均是最優的。在精度圖中,提出的算法精度為0.793,比排名第二的基準算法(KCF)提高了13.9%。在成功率圖中,本文算法成功率比基準算法(KCF)提高了14.2%,比排名第二的DSST提高了2.6%。

實驗中還繪制了不同環境下的精度圖和成功率圖,從中選出了快速運動、背景雜波、運動模糊、尺度變化4種環境下的精度圖和成功率圖,列在圖6中。從圖中可以看出,在這4種跟蹤環境下:①提出的算法在精度和成功率上均比基準算法(KCF)有較大提高;②提出的算法的精度均排在第一;③在跟蹤成功率方面,除了尺度變化環境下的成功率略低于DSST,其余跟蹤環境下的成功率均排在第一。

圖5 100個視頻序列的精度圖和成功率圖

3.3.4 定性分析

為了更直觀地體現各個算法的跟蹤效果,圖7列出了11種對比算法中排名前4位的算法在OTB-2015數據集中部分具有代表性的視頻序列的跟蹤效果截圖。圖中視頻序列從上到下依次為jogging-1,singer2和shaking。3組視頻均存在快速運動、遮擋、運動模糊、尺度變化等多種干擾條件,具有很好的代表性。

1)jogging-1視頻中第76幀左右遇到燈桿的遮擋,在第84幀看到只有本文算法跟蹤到目標,其他算法均跟蹤失敗。

2)singer2視頻中第11幀4種算法都能很好地跟蹤,由于目標的快速運動、姿態變化、背景雜波和尺度變化,在15幀左右CN算法跟蹤發生了偏離,本文算法和其它算法能夠一直跟蹤到第366幀,并且跟蹤效果最好。

3)shaking視頻序列中由于目標的光照變化、姿態變化、尺度變化和平面內翻轉,本文算法在第15幀左右發生了跟蹤偏離,但在21幀左右又能重新跟蹤到目標,并且跟蹤效果較好。

從3組視頻序列可以看出,本文算法在保持較高精度的同時,還可以很好地處理目標的尺度變化和目標周圍的環境,說明算法中加入的尺度自適應、上下文感知和更新策略發揮了良好的作用。

圖6 不同跟蹤環境曲線圖

4 結束語

針對KCF算法存在背景信息較少和不能很好處理目標尺度變化的問題,在其基礎上提出了一種改進算法,增加背景信息的同時,還可以處理目標的尺度變化。利用融合的多特征訓練一個二維位移濾波器估計目標位置,利用fHOG特征訓練一個一維尺度濾波器估計目標尺度,在模型更新階段改進了更新策略。在標準數據集上進行的實驗表明:提出的算法對基準KCF算法有較大改善,與其他當前一些主流跟蹤算法相比整體綜合性能較好,驗證了提出的算法的可行性和有效性。另外,位移濾波器中使用的3種特征只是簡單的矢量鏈接,沒有考慮到不同視頻場合下不同特征的主導作用,同時跟蹤的成功率還有待進一步提高。

[1] Yilmaz A. Object tracking: a survey[J]., 2006, 38(4): 1-45.

[2] Smeulders A W M, Chu D M, Cucchiara R, et al. Visual tracking: an experimental survey[J]., 2014, 36(7): 1442-1468.

[3] 魏全祿, 老松楊, 白亮.基于相關濾波器的視覺目標跟蹤綜述[J]. 計算機科學, 2016, 43(11):1-5,18.

WEI Quanlu, LAO Songyang, BAI Liang. Visual Object Tracking Based on Correlation Filters: A Survey[J]., 2016, 43(11): 1-5, 18.

[4] 孟琭, 楊旭. 目標跟蹤算法綜述[J]. 自動化學報, 2019, 45(7): 1244-1260.

MENG Lu, YANG Xu. A Survey of Object Tracking Algorithms[J]., 2019, 45(7): 1244-1260.

[5] 徐康, 龍敏.增強尺度估計的特征壓縮跟蹤算法[J]. 紅外技術, 2018, 40(12): 1176-1181.

XU Kang, LONG Min. Feature Compression Tracking Algorithm with Enhanced Scale Estimation[J]., 2018, 40(12): 1176-1181.

[6] 劉教民, 郭劍威, 師碩.自適應模板更新和目標重定位的相關濾波器跟蹤[J]. 光學精密工程, 2018, 26(8): 2100-2111.

LIU Jiaomin, GUO Jianwei, SHI Shuo. Correlation filter tracking based on adaptive learning rate and location refiner[J]., 2018, 26(8): 2100-2111.

[7] 葉瑞哲, 許卓斌.基于自適應搜索的空時上下文目標跟蹤算法[J]. 微電子學與計算機, 2018, 35(6):88-91.

YE Ruizhe, XU Zhuobin.Spatio-Temporal Context-based Object Tracking Algorithm in Video Surveillance[J]., 2018, 35(6): 88-91.

[8] 胡昭華, 鈕夢宇, 邵曉雯, 等.多層深度特征的目標跟蹤算法研究[J]. 現代電子技術, 2019, 42(1): 51-56.

HU Zhaohua, NIU Mengyu, SHAO Xiaowen, et al. Research on object tracking method based on multi-level deep feature[J]., 2019, 42(1): 51-56.

[9] Bolme D S, Beveridge J R, Draper B A, et al. Visual object tracking using adaptive correlation filters[C]//2010, 2010: 2544-2550.

[10] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]., 2015, 37(3): 583-596.

[11] Felzenszwalb P F, Girshick R B, McAllester D, et al. Object detection with discriminatively trained part-based models[J]., 2010, 32(9): 1627-1645.

[12] Danelljan M, Shahbaz Khan F, Felsberg M, et al. Adaptive color attributes for real-time visual tracking[C]//, 2014: 1090-1097.

[13] Van De Weijer J, Schmid C, Verbeek J, et al. Learning color names for real-world applications[J]., 2009, 18(7): 1512-1523.

[14] Danelljan M, H?ger G, Khan F, et al. Accurate scale estimation for robust visual tracking[C]//, 2014: 1-11.

[15] Mueller M, Smith N, Ghanem B. Context-aware correlation filter tracking[C]//, 2017: 1396-1404.

[16] Henriques J F, Caseiro R, Martins P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//2012: 702-715.

[17] LI Y, ZHU J. A scale adaptive kernel correlation filter tracker with feature integration[C]//, 2014: 254-265.

[18] WU Y, LIM J, YANG M H. Object Tracking Benchmark[J]., 2015, 37(9): 1834-1848.

[19] YUN S, CHOI J, YOO Y, et al. Action-decision networks for visual tracking with deep reinforcement learning[C]//. 2017: 2711-2720.

[20] LI Y, FU C, HUANG Z, et al. Keyfilter-aware real-time uav object tracking[C]//2020(), 2020: 193-199.

Real-time Object Tracking Based on Context Awareness and Scale Adaptation

XIA Aiming,WU Xuedong

(School of Electronics and Information, Jiangsu University of Science and Technology, Zhenjiang 212000, China)

Becausethe traditional kernel correlation filter algorithm for visual object tracking has low tracking accuracy under fast motion, background clutter, and motion blurring conditions and cannot deal with scale changes, a real-time object tracking algorithm based on context awareness and scale adaptation is proposed. Based on the kernel correlation filter algorithmframework, context-aware and scale-adaptive methods are introduced to add background information and handle changes in the scale of the target. First, the target region is sampled using the features of the fusion histogram of oriented gradient (fHOG), color names (CN),and gray, and a two-dimensional translation filter is trained. Then, a scale pyramid is established in the target areaand multi-scale sampling is performed using fHOG on the target area. Following this, a one-dimensional scale filter is trained. Finally, the update strategy is improved in the model updating stage. The experimental results of 100 sets of video sequences in the standard OTB-2015 dataset show that the proposed algorithm showed an improvement in the accuracy by 13.9% as compared with the benchmark algorithm (kernel correlation filter, KCF), and the success rate improved by 14.2%, which is superior to that of other comparison-tracking algorithms considered in the experiment. Under the conditions of scale change, motion blur, and fast motion, the proposed algorithm can maintain a high speed with accurate tracking.

correlation filters, feature fusion, context-aware, scale-adaptive

TP391.41

A

1001-8891(2021)05-0429-08

2019-06-08;

2021-03-19.

夏愛明(1985-),男,碩士研究生,主要研究方向為視覺目標跟蹤。E-mail: 362931408@qq.com。

伍雪冬(1975-),男,博士,教授,主要研究方向為計算機視覺,能源預測與環境經濟調度等。E-mail: woolcn@163.com。

國家自然科學基金(61671222)。