基于GLNet和HRNet的高分辨率遙感影像語義分割

趙紫旋,吳 謹(jǐn),朱 磊

基于GLNet和HRNet的高分辨率遙感影像語義分割

趙紫旋1,2,吳 謹(jǐn)1,2,朱 磊1,3

(1. 武漢科技大學(xué) 信息科學(xué)與工程學(xué)院,湖北 武漢 430081;2. 冶金自動化與檢測技術(shù)教育部工程中心,湖北 武漢 430000;3. 中冶南方連鑄技術(shù)工程有限責(zé)任公司,湖北 武漢 430223)

在GLNet(Global-Local Network)中,全局分支采用ResNet(Residual Network)作為主干網(wǎng)絡(luò),其側(cè)邊輸出的特征圖分辨率較低,而且表征能力不足,局部分支融合全局分支中未充分學(xué)習(xí)的特征圖,造成分割準(zhǔn)確率欠佳。針對上述問題,提出了一種基于GLNet和HRNet(High-Resolution Network)的改進(jìn)網(wǎng)絡(luò)用于高分辨率遙感影像語義分割。首先,利用HRNet取代全局分支中原有的ResNet主干,獲取表征能力更強(qiáng),分辨率更高的特征圖。然后,采用多級損失函數(shù)對網(wǎng)絡(luò)進(jìn)行優(yōu)化,使輸出結(jié)果與人工標(biāo)記更為相似。最后,獨(dú)立訓(xùn)練局部分支,以消除全局分支中特征圖所帶來的混淆。在高分辨率遙感影像數(shù)據(jù)集上,對所提出的改進(jìn)網(wǎng)絡(luò)進(jìn)行訓(xùn)練和測試,實(shí)驗(yàn)結(jié)果表明,改進(jìn)網(wǎng)絡(luò)在全局分支和局部分支上的平均絕對誤差(Mean Absolute Error,MAE)分別為0.0630和0.0479,在分割準(zhǔn)確率和平均絕對誤差方面均優(yōu)于GLNet。

高分辨率遙感影像;語義分割;全局分支;局部分支;獨(dú)立訓(xùn)練

0 引言

圖像的語義分割將屬于相同目標(biāo)類別的圖像子區(qū)域聚合起來,是高分辨率遙感影像信息提取和場景理解的基礎(chǔ),也是實(shí)現(xiàn)從數(shù)據(jù)到信息對象化提取的關(guān)鍵步驟,具有重要的意義。

在對高分辨率遙感影像進(jìn)行語義分割時,傳統(tǒng)方法的抗噪性能較差,難以獲得較好的分割準(zhǔn)確率和分割速度。隨著大規(guī)模數(shù)據(jù)集和硬件計算能力的發(fā)展,深度學(xué)習(xí)的方法在圖像處理任務(wù)中取得了較好的成績,基于深度學(xué)習(xí)的圖像語義分割方法也可以更好地應(yīng)用于實(shí)際任務(wù)。

目前,基于深度學(xué)習(xí)的圖像語義分割可以分為兩類:基于區(qū)域分類的圖像語義分割和基于像素分類的圖像語義分割。其中,基于像素分類的圖像語義分割方法增加了模型的整體契合度,而且可以有效提升分割準(zhǔn)確率和分割速度。在實(shí)際應(yīng)用中,多采用全監(jiān)督學(xué)習(xí)的像素分類方式進(jìn)行訓(xùn)練[1]。

全卷積網(wǎng)絡(luò)[2](Fully Convolutional Network, FCN)是最早實(shí)現(xiàn)基于像素分類的圖像語義分割網(wǎng)絡(luò)之一,在牛津大學(xué)計算機(jī)視覺組(Visual Geometry Group, VGG)所提出的VGG-16[3]網(wǎng)絡(luò)的基礎(chǔ)上進(jìn)行改進(jìn),將全連接層替換為卷積層以實(shí)現(xiàn)逐像素的密集預(yù)測,該方法可以分割出圖像的大致輪廓,但是結(jié)果較為粗糙。在FCN[2]的基礎(chǔ)上,U-Net[4]采用編碼器-解碼器的對稱網(wǎng)絡(luò)結(jié)構(gòu),并通過跳層連接(skip-connection)的方式將低級特征融合至高級特征,DeconvNet[5]和SegNet[6]也采用了類似的結(jié)構(gòu)。Deeplab[7]采用空洞卷積的方式來擴(kuò)大卷積的感受野,大感受野下所獲取的特征能夠有效地編碼圖像中的上下文信息。然而,這些網(wǎng)絡(luò)應(yīng)用于高分辨率遙感影像時,隨著計算量增加,需要占用更多的GPU內(nèi)存,造成運(yùn)行速度減慢等問題。

隨著語義分割在許多實(shí)時應(yīng)用中變得越來越重要,高效和快速的分割網(wǎng)絡(luò)得到了更多的關(guān)注。ENet[8]在進(jìn)行語義分割時,采用分解濾波器策略,通過低階近似(low-rank approximation)的方法簡化卷積操作,以減少運(yùn)算。圖像級聯(lián)網(wǎng)絡(luò)(Image Cascade Network, ICNet)[9]將不同尺寸的低分辨率圖像輸入主干網(wǎng)絡(luò)得到粗糙分割圖,然后通過級聯(lián)特征融合單元來融合高分辨率特征圖,提高了分割速度。盡管實(shí)時性能得到提升,但這些網(wǎng)絡(luò)對于高分辨率遙感影像的分割準(zhǔn)確率不佳。

GLNet[10]由全局分支(global branch)和局部分支(local branch)構(gòu)成,分別以降采樣的全局圖像和全分辨率的裁剪圖像作為輸入,有效保留了細(xì)節(jié)信息和全局上下文信息,并能減少GPU內(nèi)存的使用量,該網(wǎng)絡(luò)以ResNet[11]和特征金字塔網(wǎng)絡(luò)(Feature Pyramid Network,F(xiàn)PN)[12]作為兩個分支的主干。GLNet在保證高分辨率圖像分割準(zhǔn)確率的前提下,提高了內(nèi)存的使用效率,但是其全局分支主干網(wǎng)絡(luò)側(cè)邊輸出的特征圖分辨率較低,而且表征能力不足,局部分支的學(xué)習(xí)也存在被混淆的問題。

HRNet[13]能夠全程保持高分辨率的特征圖,得到更為精準(zhǔn)的空間信息,其多尺度融合策略也可以得到更為豐富的高分辨率表征,使預(yù)測的熱點(diǎn)圖(heatmap)更為準(zhǔn)確。采用HRNet替代GLNet中的全局分支ResNet,可以得到分辨率更高,而且特征信息更為豐富的側(cè)邊輸出特征圖,可以提高分割的準(zhǔn)確率。

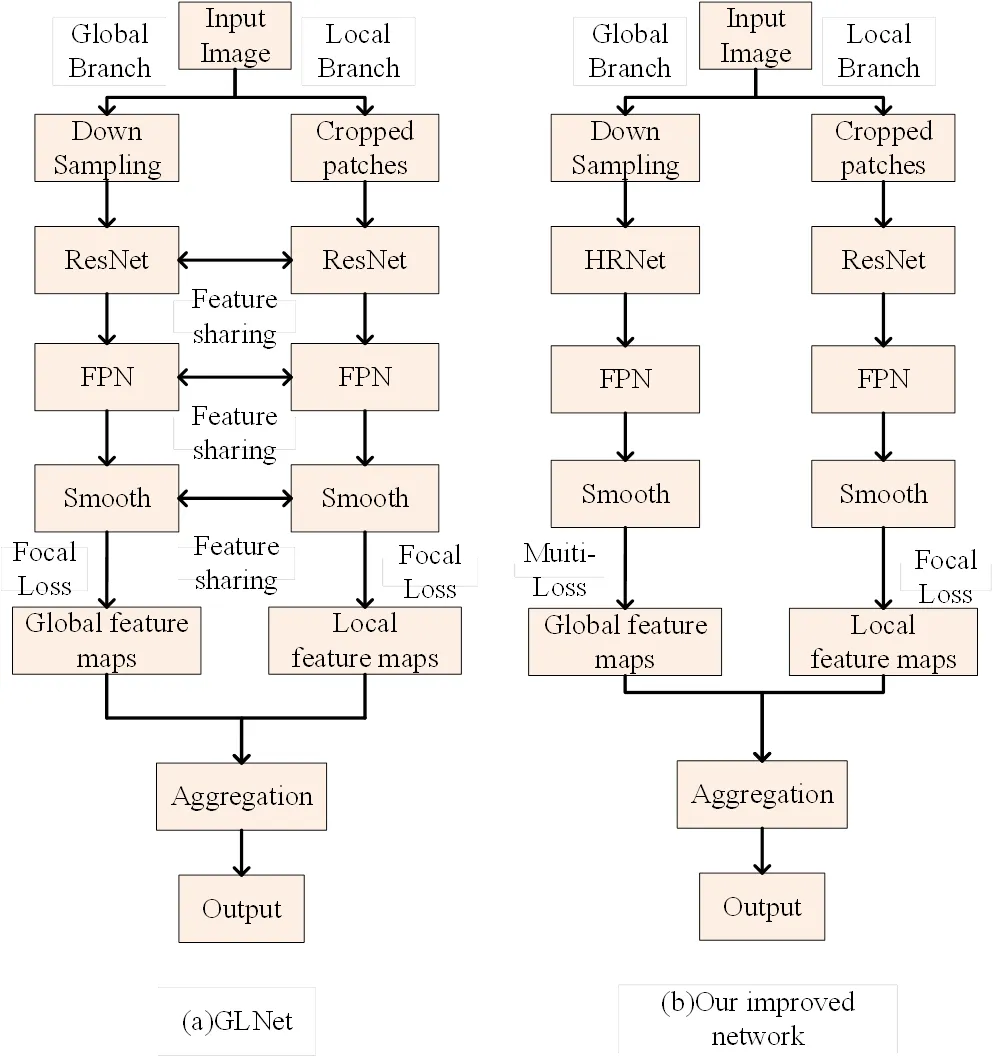

本文基于HRNet和GLNet提出了一種改進(jìn)網(wǎng)絡(luò)用于高分辨率遙感影像的語義分割。在全局分支中,將GLNet中的ResNet調(diào)整為HRNet,以HRNet和FPN作為主干網(wǎng)絡(luò),在保持高分辨率特征圖的同時,融合豐富的多尺度信息,得到更具代表性的表征。將輔助損失函數(shù)修改為多級損失結(jié)構(gòu)優(yōu)化網(wǎng)絡(luò)[14],使分割結(jié)果更為準(zhǔn)確。在局部分支中,采用ResNet和FPN作為主干網(wǎng)絡(luò),獨(dú)立訓(xùn)練該部分網(wǎng)絡(luò),不采用原有的特征共享策略,以消除全局分支中,未充分學(xué)習(xí)的特征圖所帶來的混淆。GLNet和改進(jìn)網(wǎng)絡(luò)的流程,分別如圖1(a)和圖1(b)所示,在高分辨率遙感影像數(shù)據(jù)集上對兩者進(jìn)行比較,實(shí)驗(yàn)結(jié)果表明,該網(wǎng)絡(luò)在分割準(zhǔn)確率上優(yōu)于GLNet,得到了更好的結(jié)果。

圖1 GLNet和本文改進(jìn)網(wǎng)絡(luò)的流程對比

1 HRNet

HRNet并行連接由高到低的子網(wǎng)絡(luò),在不采用中間熱點(diǎn)圖監(jiān)督的條件下,重復(fù)融合子網(wǎng)絡(luò)產(chǎn)生的表征,得到可靠的高分辨率表征。與通過由低到高的上采樣進(jìn)程,聚合低層和高層表征的大多數(shù)網(wǎng)絡(luò)相比,HRNet具有較好的計算復(fù)雜度和參數(shù)效率。

1.1 并行多分辨率子網(wǎng)

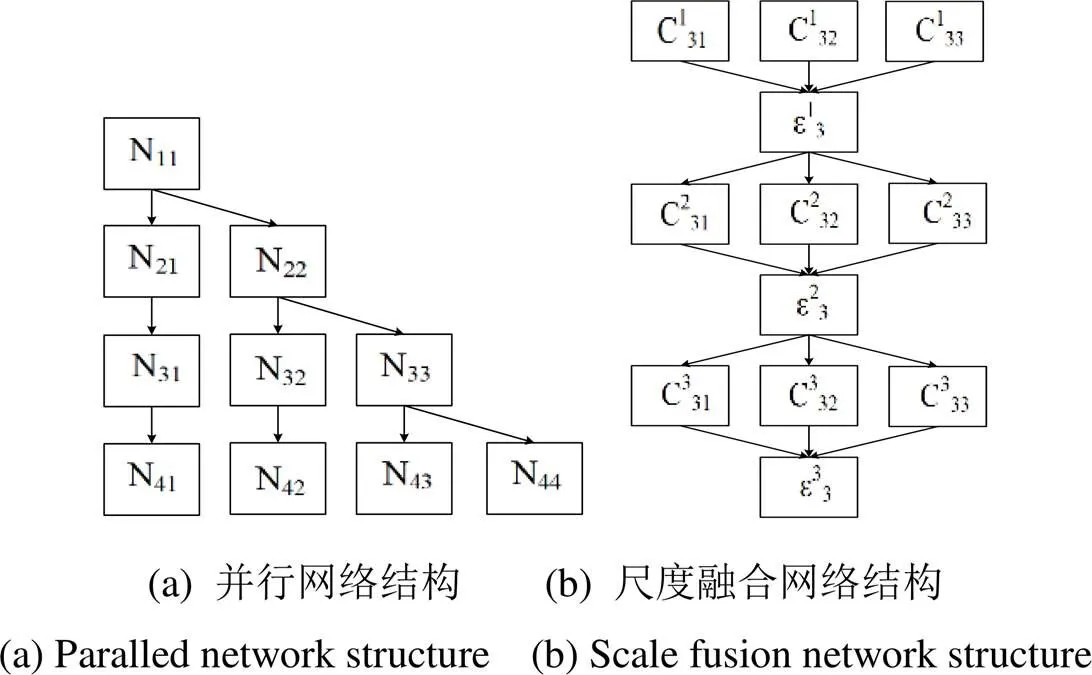

并行多分辨率子網(wǎng)通過并行連接由高分辨率到低分辨率的子網(wǎng)構(gòu)建而成,每個子網(wǎng)包含多個卷積序列,臨近的子網(wǎng)間存在降采樣層,以將特征圖分辨率減半。以高分辨率子網(wǎng)作為第一個階段,逐步增加由高到低分辨率的子網(wǎng),組成新的階段,然后并行連接多個分辨率子網(wǎng)。并行子網(wǎng)后一階段的分辨率由前一階段的分辨率和下一階段的分辨率組成。通過4個并行子網(wǎng)組成的網(wǎng)絡(luò)結(jié)構(gòu),如圖2(a)所示。圖中:N表示在第階段的子網(wǎng),其分辨率為初始階段圖像的1/(2-1)。

圖2 HRNet的基本網(wǎng)絡(luò)結(jié)構(gòu)

1.2 重復(fù)的尺度融合

HRNet引入跨并行子網(wǎng)的交換單元,使每個子網(wǎng)多次接收來自其它子網(wǎng)的信息。信息交換單元的示例如圖2(b)所示,將第3階段分隔為多個交換塊,而每個交換塊由3個并行卷積單元和1個交換單元組成。圖中:C表示第階段的第個交換塊,其交換單元的分辨率為初始階段的1/(2-1),而表示相應(yīng)的交換單元。HRNet中交換單元聚合不同分辨率特征信息的具體實(shí)現(xiàn),如圖3所示。

圖3 HRNet的交換單元

(X,)表示將輸入X的分辨率由變換到的過程,通過降采樣或上采樣的方式實(shí)現(xiàn)。HRNet的交換單元采用步長為2的3×3卷積進(jìn)行降采樣,而上采樣則利用雙線性插值的方式實(shí)現(xiàn)。值得注意的是,如果=,則(x,)表示恒等映射,即(x,)=x。

2 基于HRNet和GLNet的網(wǎng)絡(luò)

基于HRNet和GLNet的網(wǎng)絡(luò)由全局和局部兩個分支構(gòu)成。全局分支以降采樣后的整體圖像作為輸入,保留了圖像的全局上下文信息,但缺少了部分的細(xì)節(jié)信息;局部分支以全分辨率的裁剪圖像作為輸入,高分辨率圖像保留了細(xì)節(jié)信息,但缺少了空間信息和鄰近區(qū)域依賴信息。本文改進(jìn)的網(wǎng)絡(luò)在全局分支采用了HRNet的結(jié)構(gòu)提高了特征圖的分辨率,在局部分支采用獨(dú)立訓(xùn)練的方式保證網(wǎng)絡(luò)學(xué)習(xí)效率,并有效整合兩個分支,實(shí)現(xiàn)更好的分割性能。

2.1 全局分支和局部分支

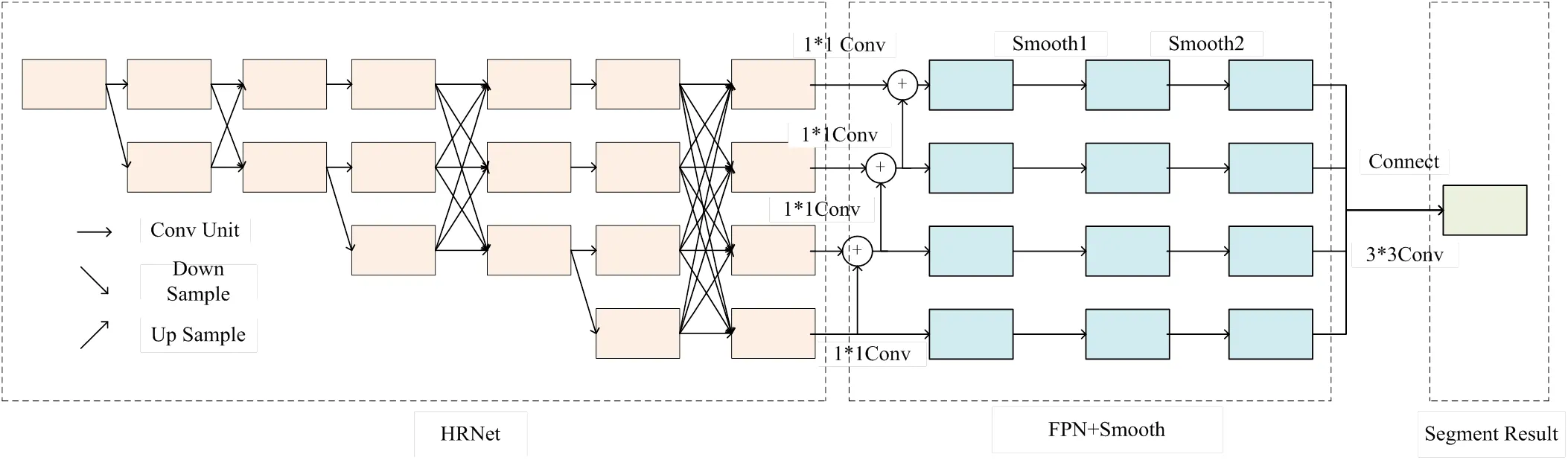

在全局分支中,采用HRNet作為主干網(wǎng)絡(luò)。其并行連接由高分辨率到低分辨率的子網(wǎng),重復(fù)融合多分辨率特征,生成了可靠的高分辨率表征。與原有ResNet網(wǎng)絡(luò)相比,提高了特征圖的分辨率,在豐富了全局上下文信息的同時,保留了更多的細(xì)節(jié)信息,提高了分割效率,其網(wǎng)絡(luò)結(jié)構(gòu)如圖4所示。

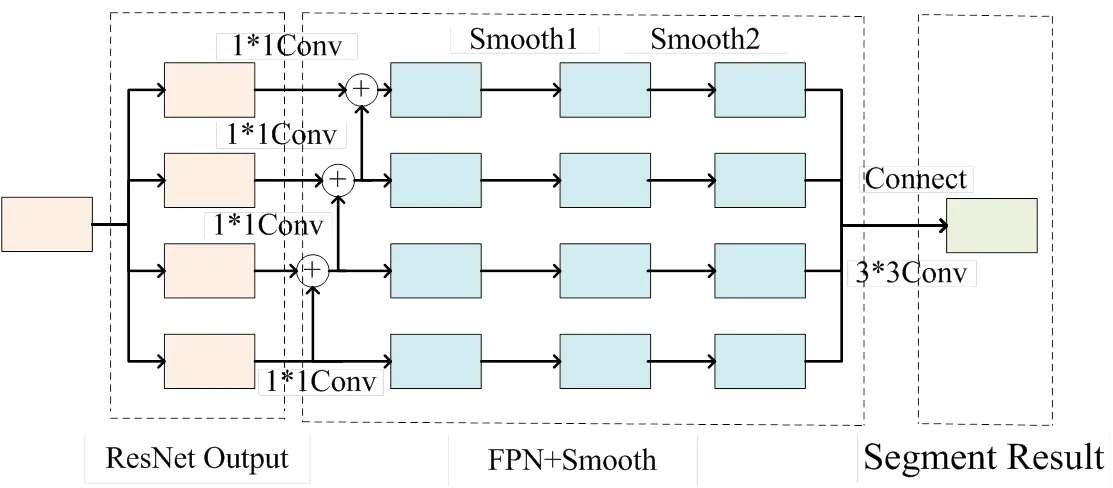

在局部分支中,仍采用ResNet作為主干網(wǎng)絡(luò)。與原有網(wǎng)絡(luò)不同,本文所提出的改進(jìn)網(wǎng)絡(luò)并未與全局分支深度共享特征圖。全局分支在對局部分支缺少的上下文信息進(jìn)行補(bǔ)充的同時,也對其特征圖的學(xué)習(xí)造成混淆。因此,采用獨(dú)立訓(xùn)練的方式,以提高局部分支的分割效果,局部分支的網(wǎng)絡(luò)結(jié)構(gòu)如圖5所示。

圖4 GLNet的全局分支結(jié)構(gòu)

圖5 GLNet的局部分支網(wǎng)絡(luò)結(jié)構(gòu)

2.2 分支聚合

如圖6所示,令兩個分支間的聚合層為AGG,該層由3×3卷積構(gòu)成,實(shí)現(xiàn)了兩個分支特征圖之間的聚合(ensemble)。從局部分支和全局分支中提取的特征圖可以分為層,分別用X,i和X,i表示,其中∈,=4,將最后一層特征圖沿著維度相連,通過聚合層AGG得到最后的分割圖,令其為AGG。除了針對于AGG的主損失函數(shù),本文還采用了2個輔助損失函數(shù),分別使全局分支的分割圖為S,L、局部分支的分割輸出為S,L,與相對應(yīng)的人工標(biāo)記結(jié)果(Ground Truth,GT)更為接近,該操作也使得訓(xùn)練過程更為穩(wěn)定。

圖6 聚合過程

3 實(shí)驗(yàn)結(jié)果

3.1 實(shí)現(xiàn)細(xì)節(jié)

在全局分支,采用HRNet和FPN作為主干網(wǎng)絡(luò),其中,HRNet包含4個并行子網(wǎng),每個子網(wǎng)分辨率遞減一半,而通道數(shù)增加至上一階段的2倍。HRNet的第一階段由4個與ResNet-50結(jié)構(gòu)一致的殘差單元構(gòu)成;第二,三,四階段分別包含有1,4,3個交換塊,每個交換塊在相同分辨率之間包含有2個3×3卷積,而在不同分辨率之間包含1個交換單元。在進(jìn)入第一階段前,HRNet需要經(jīng)過2次降采樣,本文實(shí)驗(yàn),在輸入降采樣后的遙感圖像前提下,僅通過1次降采樣即可實(shí)現(xiàn)最優(yōu)效果。

在局部分支,仍采用ResNet和FPN作為主干網(wǎng)絡(luò),提取ResNet在從第2個至第5個殘差塊的側(cè)邊輸出進(jìn)行學(xué)習(xí)。

全局分支輸入的降采樣圖像與局部分支輸入的裁剪圖像均采用500×500的像素大小。局部分支中相鄰的裁剪子圖有50個像素的重疊,以避免卷積層的邊界消失,并采用=6的主損失函數(shù)和兩個輔助損失函數(shù)來優(yōu)化目標(biāo)[15],全局分支采用多級損失[14]的計算方式,每條分支的損失權(quán)重平均分配為1,局部分支采用二元交叉熵?fù)p失函數(shù)。

實(shí)驗(yàn)是在PyTorch深度學(xué)習(xí)框架下進(jìn)行,采用Adam優(yōu)化器[16](1=0.9,2=0.999),全局分支的學(xué)習(xí)率設(shè)置為1×10-4,局部分支的學(xué)習(xí)率設(shè)置為2×10-5,所有分支訓(xùn)練時批量處理的數(shù)量均為6。

3.2 實(shí)驗(yàn)數(shù)據(jù)及評估標(biāo)準(zhǔn)

在遙感數(shù)據(jù)集上進(jìn)行訓(xùn)練和測試,數(shù)據(jù)集中包含有759幅高分辨率的遙感影像(分辨率為2248×2248),以及對應(yīng)的人工標(biāo)記結(jié)果。將數(shù)據(jù)集按8:2的比例劃分成訓(xùn)練集和驗(yàn)證集,607幅遙感影像用于訓(xùn)練,152幅遙感影像用于測試。

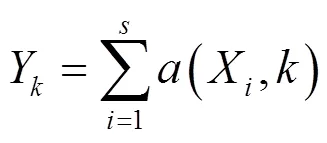

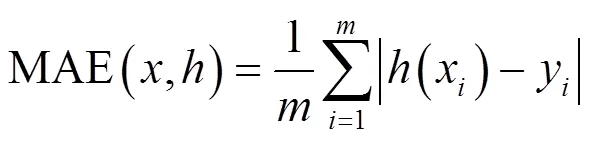

在實(shí)驗(yàn)過程中,采用平均絕對誤差作為評估標(biāo)準(zhǔn)。MAE是單個觀測值與標(biāo)準(zhǔn)值的偏差的絕對值平均,所有個體差異在平均值上的權(quán)重都相等,可以更好地反映預(yù)測值誤差的實(shí)際情況,其表達(dá)式如下所示:

式中:表示輸入數(shù)據(jù)集;表示中數(shù)據(jù)的總量;表示預(yù)測過程;(x)和y分別表示第個數(shù)據(jù)的預(yù)測值和標(biāo)準(zhǔn)值。

在Linux實(shí)驗(yàn)環(huán)境下,通過Nvidia-smi命令調(diào)取并記錄GPU的內(nèi)存占用情況。

3.3 實(shí)驗(yàn)結(jié)果

分別采用GLNet和改進(jìn)網(wǎng)絡(luò)對兩幅相同的高分辨率遙感影像進(jìn)行分割,結(jié)果對比如圖7所示。

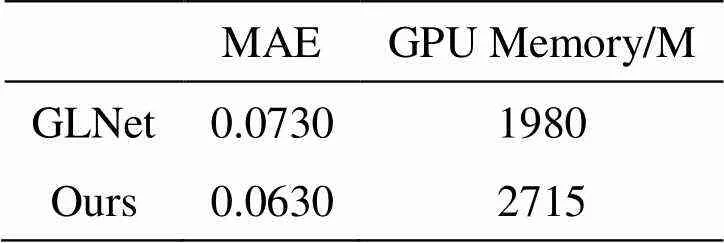

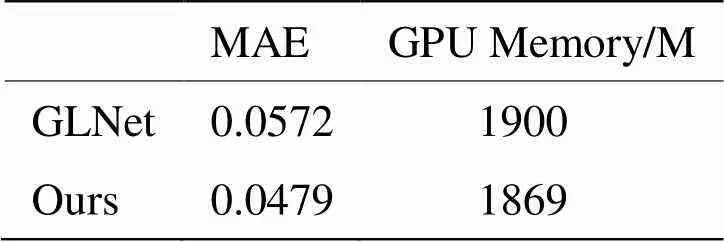

在全局分支上,將本文所提出的改進(jìn)網(wǎng)絡(luò)與GLNet進(jìn)行對比。平均絕對誤差和內(nèi)存占用量的對比數(shù)據(jù)如表1所示。

表1 Global分支實(shí)驗(yàn)對比

在局部分支上,將本文所提出的改進(jìn)網(wǎng)絡(luò)與GLNet中特征圖共享的網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行對比。平均絕對誤差和內(nèi)存占用量的對比數(shù)據(jù)如表2所示。

表2 Local分支實(shí)驗(yàn)對比

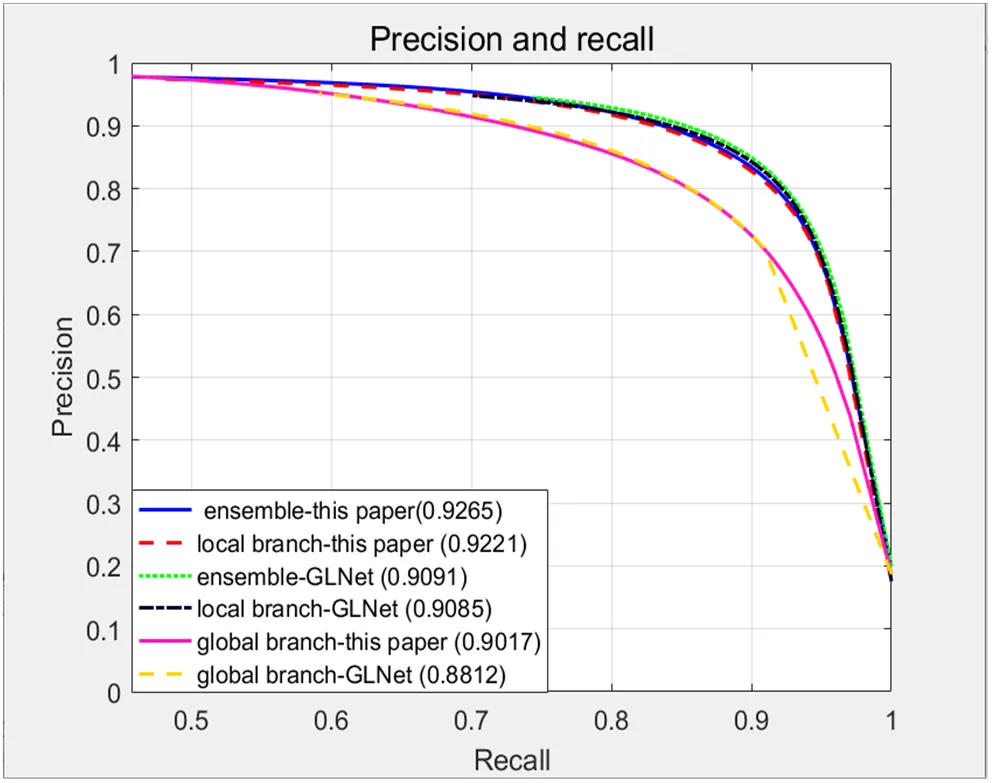

精度召回率(Precision Recall,PR)曲線是衡量學(xué)習(xí)器優(yōu)劣的標(biāo)準(zhǔn)之一,其曲線下的面積(Area Under Curve,AUC)用以定量的評估分割效果。本文所提出的改進(jìn)網(wǎng)絡(luò)和GLNet的PR曲線如圖8所示。

圖8 高分辨率遙感圖像PR曲線圖

在全局分支,本文基于HRNet主干結(jié)構(gòu)的MAE=0.0630,平均絕對誤差相比于GLNet降低了0.01,由圖7所見,改進(jìn)網(wǎng)絡(luò)全局分支的分割結(jié)果圖也明顯優(yōu)于GLNet,證明本文所提出的結(jié)構(gòu)在全局分支可以更好地進(jìn)行高分辨率遙感影像語義分割;在局部分支,未融入全局分支特征圖的方法,MAE=0.0479,平均絕對誤差更低,可以推斷全局分支對局部分支的學(xué)習(xí)造成了混淆,從分割圖也可看出,不采用特征圖共享的結(jié)構(gòu)分割效果更好。由圖8中的PR曲線定量分析可知,改進(jìn)網(wǎng)絡(luò)在融合、局部和全局模塊的AUC均高于GLNet的對應(yīng)模塊,分別為0.9265、0.9221和0.9017,具有更好的分割效果。綜上所述,本文基于HRNet和GLNet的方法,在分割準(zhǔn)確度和平均絕對誤差方面性能更優(yōu)。值得注意的是,該方法在內(nèi)存使用效率方面,稍弱于GLNet,全局分支的GPU內(nèi)存使用僅比GLNet多了735M,優(yōu)于多數(shù)主流分割網(wǎng)絡(luò)(U-Net:5507M,F(xiàn)CN-8s:5227M,PSPNet[17]:6289M,SegNet[6]:10339M)。

4 結(jié)論

高分辨率遙感影像分割是當(dāng)前非常重要的計算機(jī)視覺技術(shù)之一。GLNet在保證分割效率的同時,優(yōu)化GPU內(nèi)存的使用效率。本文在GLNet的基礎(chǔ)上,對分割準(zhǔn)確率進(jìn)一步提升。在全局分支,采用HRNet作為主干網(wǎng)絡(luò),并采用多級損失函數(shù)優(yōu)化網(wǎng)絡(luò);在局部分支,獨(dú)立訓(xùn)練該部分網(wǎng)絡(luò),證明了全局分支中的特征圖對局部分支特征圖的學(xué)習(xí)造成了混淆。實(shí)驗(yàn)結(jié)果表明,本文所提出改進(jìn)網(wǎng)絡(luò)的平均絕對誤差更低,且分割準(zhǔn)確率更優(yōu),該方法可有效用于高分辨率遙感影像的語義分割。

[1] 田萱, 王亮, 丁琪. 基于深度學(xué)習(xí)的圖像語義分割方法綜述[J]. 軟件學(xué)報, 2019, 30(2): 250-278.

TIAN X, WANG L, DING Q. Review of Image Semantic Segmentation Based on Deep Learning[J]., 2019, 30(2): 440-468.

[2] LONG J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]//, 2015: 3431-3440.

[3] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]//, 2015: 1-13.

[4] Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation[C]//, 2015: 234-241.

[5] Noh H, Hong S, Han B. Learning deconvolution network for semantic segmentation[C]//, 2015: 1520-1528.

[6] Badrinarayanan V, Kendall A, Cipolla R. Segnet: A deep convolutional encoder-decoder architecture for image segmentation[J]., 2017, 39(12): 2481-2495.

[7] CHEN L C, Papandreou G, Kokkinos I, et al. DeepLab: Semantic Image Segmentation with Deep Convolutional Nets, Atrous Convolution, and Fully Connected CRFs[J]., 2018, 40(4):834.

[8] Paszke A, Chaurasia A, Kim S, et al. Enet: A deep neural network architecture for real-time semantic segmentation[J/OL]., 2016,https://arxiv.org/abs/1606.02147.

[9] ZHAO H, QI X, SHEN X, et al. Icnet for real-time semantic segmentation on high-resolution images[C]//, 2018: 405-420.

[10] CHEN W, JIANG Z, WANG Z, et al. Collaborative global-local networks for memory-efficient segmentation of ultra-high resolution images[C]//,2019: 8924-8933.

[11] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//,2016: 770-778.

[12] LIN T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//,2017: 2117-2125.

[13] SUN K, XIAO B, LIU D, et al. Deep high-resolution representation learning for human pose estimation[C]//, 2019: 5693-5703.

[14] HOU Q, CHENG M M, HU X, et al. Deeply supervised salient object detection with short connections[C]//,2017: 3203-3212.

[15] LIN T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//, 2017: 2980-2988.

[16] Kingma D P, Ba J. Adam: A method for stochastic optimization[J/OL]. arXiv preprint arXiv:1412.6980, 2014.

[17] ZHAO H, SHI J, QI X, et al. Pyramid scene parsing network[C]//,2017: 2881-2890.

High-resolution Remote Sensing Image Semantic Segmentation Based on GLNet and HRNet

ZHAO Zixuan1,2,WU Jin1,2,ZHU Lei1,3

(1.,430081,;2.,430000,;3.,430223,)

The backbone of a convolutional neural network global branch, a residual network (ResNet), obtains low-resolution feature maps at side outputs that lack feature representation. The local branch aggregates the feature maps in the global branch, which are not fully learned, resulting in a negative impact on image segmentation. To solve these problems in GLNet (Global-Local Network), a new semantic segmentation network based on GLNet and High-Resolution Network (HRNet) is proposed. First, we replaced the original backbone of the global branch with HRNet to obtain high-level feature maps with stronger representation. Second, the loss calculation method was modified using a multi-loss function, causing the outputs of the global branch to become more similar to the ground truth. Finally, the local branch was trained independently to eliminate the confusion produced by the global branch. The improved network was trained and tested on the remote sensing image dataset. The results show that the mean absolute errors of the global and local branches are 0.0630 and 0.0479, respectively, and the improved network outperforms GLNet in terms of segmentation accuracy and mean absolute errors.

high-resolution remote sensing image, semantic segmentation, global branch, local branch, trained independently

TP751.1

A

1001-8891(2021)05-0437-06

2020-04-08;

2020-06-23.

趙紫旋(1997-),女,湖北武漢人,碩士研究生,研究方向?yàn)閳D像處理、深度學(xué)習(xí)。E-mail:zhaozixuan19970708@163.com。

吳謹(jǐn)(1967-),女,安徽蕪湖人,博士,教授,研究方向?yàn)閳D像處理與模式識別、信號處理與多媒體通信等。E-mail:wujin@wust.edu.cn。

國家自然科學(xué)基金青年基金項(xiàng)目資助(61502358,61702384)。