卷積神經網絡研究綜述

李炳臻 劉克 顧佼佼 姜文志

摘? 要: 回顧了卷積神經網絡的發展歷程, 介紹了卷積神經網絡的基本運算單元。在查閱大量資料基礎上,重點介紹了有代表性的AlexNet、VGGNet、GoogLeNet、ResNet等,對他們所用到的技術進行剖析,歸納、總結、分析其優缺點,并指出卷積神經網絡未來的研究方向。

關鍵詞: 卷積神經網絡; AlexNet; VGGNet; GoogLeNet; ResNet

中圖分類號:TP399? ? ? ? ? 文獻標識碼:A? ? ?文章編號:1006-8228(2021)04-08-05

Absrtact: This paper reviews the development of convolutional neural networks, and introduces the basic operation unit of convolutional neural networks. On the basis of consulting a large amount of information, this paper focuses on the representative convolutional neural networks such as AlexNet, VGGNet, GoogLeNet and ResNet etc., analyzes the technologies they used, summarizes and analyzes their advantages and disadvantages, and points out the future research direction of convolutional neural networks.

Key words: convolutional neural networks; AlexNet; VGGNet; GoogLeNet; ResNet

0 引言

卷積神經網絡(Convolutional Neural Networks,CNN)是一類包含卷積計算并且含有深層次結構的深度前饋神經網絡,是深度學習的代表算法之一[1-2],21世紀后,隨著深度學習理論的提出和數值計算設備的改進,卷積神經網絡得到了快速發展。較之于傳統方法,卷積神經網絡的優點在于可自動提取目標特征,發現樣本集中特征規律,解決了手動提取特征效率低下、分類準確率低的不足,因此卷積神經網絡被廣泛應用于圖像分類、目標識別、自然語言處理等領域[3],取得了矚目的成就。

1 卷積神經網絡的發展歷程

卷積神經網絡最早可以追溯到1943年,心理學家Warren和數理邏輯學家Walter在文獻[4]第一次提出神經元的概念,通過一個簡單的數學模型將神經反應簡化為信號輸入、求和、線性激活及輸出,具有開創性意義;1958年神經學家Frank通過機器模擬了人類的感知能力[5],這就是最初的“感知機”,同時他在當時的計算機IBM704上完成了感知機的仿真,能夠對三角形和四邊形進行分類,這是神經元概念提出后第一次成功的實驗,驗證了神經元概念的可行性。以上是神經元發展的第一階段。第一代神經網絡由于結構單一,僅能解決線性問題。此外,認知的限制也使得神經網絡的研究止步于此。

第二代卷積神經網絡出現于1985年,Geoffrey Hinton在神經網絡中使用多個隱含層進行權重變換,同時提出了誤差反向傳播算法(Backpropagationalgorithm,BP算法)[6],求解各隱含層的網絡參數,優點是理論基礎牢固、通用性好,不足之處在于網絡收斂速度慢、容易出現局部極小的問題;1988年,Wei Zhang提出平移不變人工神經網絡[7](SIANN),將其應用在醫學圖像檢測領域;1989年,LeCun構建了應用于計算機視覺問題的卷積神經網絡,也就是LeNet的早期版本,包含兩個卷積層、兩個全連接層共計6萬多個參數,結構上與現代的卷積神經網絡模型結構相似,而且開創性的提出了“卷積”這一概念,卷積神經網絡因此得名。1998年LeCun構建了更加完備的卷積神經網絡LeNet-5[8]并將其應用于手寫字體識別,在原有LeNet的基礎上加入了池化層,模型在Mnist上的識別準確率達到了98%以上,但由于當時不具備大規模計算能力的硬件條件,因此卷積神經網絡的發展并沒有引起足夠的重視。

第三代卷積神經網絡興起于2006年,統稱為深度學習,分為兩個階段,2006至2012年為快速發展期,2012至今為爆發期,訓練數據量越大,卷積神經網絡準確率越高,同時隨著具備大規模計算能力GPU的應用,模型的訓練時間大大縮短,深度卷積神經網絡的發展是必然的趨勢。2006年Hintont提出了包含多個隱含層的深度置信網絡[9](Deep BeliefNetwork,DBN),取得了十分好的訓練效果,DBN的成功實驗拉開了卷積神經網絡百花齊放的序幕:自2012年AlexNet[10]取得ImageNet視覺挑戰賽的冠軍,幾乎每年都有新的卷積神經網絡產生,諸如ZFNet[11]、VGGNet[12]、GoogLeNet[13]、ResNet[14]以及DPRSNet[15]等等,都取得了很好的效果。

2 卷積神經網絡的基本運算單元

卷積神經網絡中隱含層低層中的卷積層與池化層交替連接,構成了卷積神經網絡的核心模塊,高層由全連接層構成。

2.1 卷積層

卷積層用于提取輸入的特征信息,由若干卷積單元組成,每個卷積單元的參數都是通過反向傳播算法優化得到的,通過感受野(filter)對輸入圖片進行有規律的移動,并與所對應的區域做卷積運算提取特征;低層卷積只能提取到低級特征,如邊緣、線條等,高層卷積可以提取更深層的特征。

卷積層參數包括filter大小、步長(stride)和邊界填充(pad),三者共同決定了卷積層輸出特征圖的尺寸大小;感受野大小小于輸入圖片尺寸,感受野越大,可提取的特征越復雜;stride定義了filter掃過相鄰區域時的位置距離;pad是在特征圖周圍進行填充避免輸出特征丟失過多邊緣信息的方法,pad值代表填充層數。

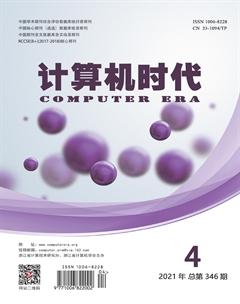

卷積層的運算過程如圖1,輸入為一個5×5×3的圖像,pad=1,邊界填充后,尺寸為7×7×3,使用3×3×3感受野進行卷積運算,整個運算過程可以看成卷積核輸入層上滑動計算,每次滑動的距離為2,從原圖左上角開始從左至右滑動進行卷積運算,這一行處理結束后,移動到下一行,繼續向右滑動,直至覆蓋所有區域,共得到9個運算結果,輸出3×3的矩陣,稱為特征圖。表達式如下:

在公式⑴中,[fx]代表輸出特征,[θij]代表第i行j列的卷積核元素大小,[χij]代表第i行j列元素大小,b為偏差。卷積層具有局部感受野、權值共享的特點,可以減少網絡中的參數。

2.2 激活函數層

卷積運算提取到的圖像特征是線性的,但真正的樣本往往是非線性的,為此引入非線性函數來解決。激活函數,使得每個像素點可以用0到1的任何數值來代表,模擬更為細微的變化。激活函數一般具有非線性、連續可微、單調性等特性。

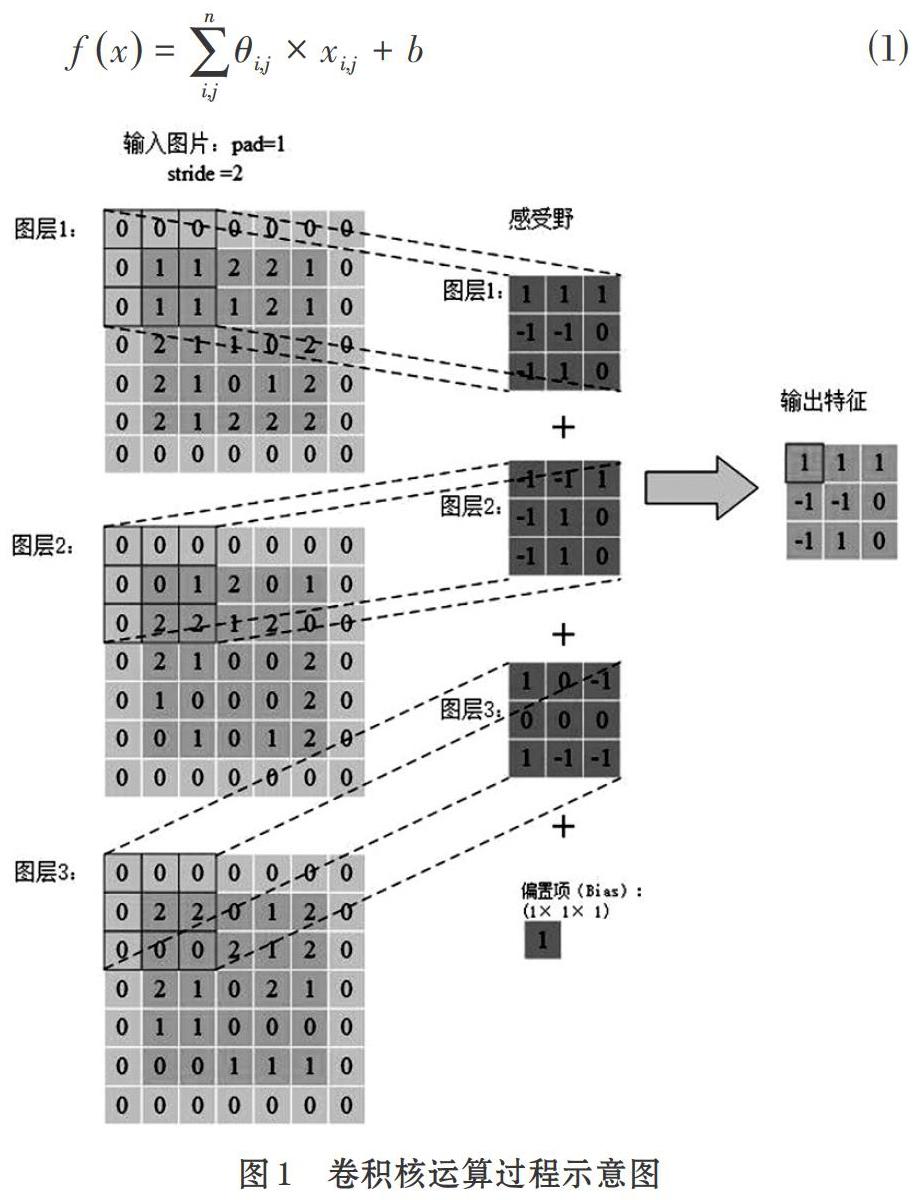

比較常用的激活函數有Sigmod函數、tanh函數,以及ReLU函數(Rectified Linear Unit,即線性整流函數)。Sigmod函數的定義式是[fx=11+e-x],tanh函數的定義式為[fx=ex-e-xex+e-x],ReLU函數的定義式為[fx=max (0,x)],曲線如圖2。

sigmod函數單調易求導,但輸出不以0為中心,且飽和時梯度非常小,網絡權值得不到有效的更新;tanh函數本質上為2×sigmod(2[x)-1],仍存在飽和時梯度過小的問題;ReLU函數具有單側抑制、稀疏激活性的特點,即在x>0時,梯度恒為1,無梯度耗散問題;x<0時,輸出為0,訓練結束后神經元為0越多,網絡越稀疏,提取出的特征越具有代表性,能夠緩解過擬合的問題。

缺點在于強制的稀疏處理會導致模型無法學習到有效的特征。最常用是ReLU函數,但要注意學習率的設置,防止過多神經元壞死。

2.3 池化層

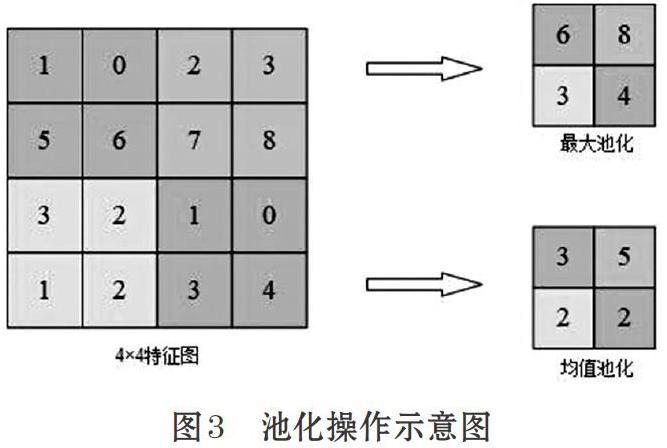

池化層的作用為壓縮特征圖,提取主要特征,簡化網絡計算的復雜度。池化方式一般有兩種,均值池化與最大池化。示意如圖3。

圖3中,采用一個2×2的filter,stride為2,padding為0。最大池化即在2×2的區域中尋找最大值;均值池化則是求每一個2×2的區域中的平均值,得到主要特征。一般最常用的filter取值為2,stride為2,池化操作將特征圖縮小,有可能影響網絡的準確度,但可以通過增加網絡深度來彌補。

2.4 全連接層

全連接層位于卷積神經網絡的最后,給出最后的分類結果,在全連接層中,特征圖會失去空間結構,展開為特征向量,并把由前面層級所提取到的特征進行非線性組合得到輸出可用公式⑵表示。

公式⑵中,x為全連接層的輸入,W為權重系數,b為偏置。全連接層連接所有特征輸出至輸出層,對于圖像分類問題,輸出層使用邏輯函數或歸一化指數函數(softmax function)輸出分類標簽[16]。在識別(object detection)問題中,輸出層輸出為物體的中心坐標、大小和分類[16]。在語義分割中,則直接輸出每個像素的分類結果[16]。

3 幾種性能優異的卷積神經網絡

3.1 AlexNet

AlexNet贏得了2012 ILSVRC(ImageNet 大規模視覺識別挑戰賽)的冠軍。2012年是CNN首次實現Top 5誤差率15.4%的一年(Top 5誤差率是指給定一張圖像,其標簽不在模型認為最有可能的5個結果中的概率),第二名使用傳統識別方法得到的誤差率為26.2%。卷積神經網絡在這次比賽的表現震驚了整個計算機視覺界,奠定了卷積神經網絡在計算機視覺領域的絕對地位。

AlexNet包含6億3千萬個連接,6000萬個參數和65萬個神經元,網絡結構如圖4。

AlexNet的成功,除了深層次的網絡結構,還有以下幾點:首先,采用ReLU作為激活函數,避免了梯度耗散問題,提高了網絡訓練的速度;其次,通過平移、翻轉等擴充訓練集,避免產生過擬合;最后提出并采用了LRN(Local Response Normalization,局部響應歸一化處理),利用臨近的數據做歸一化處理技術,提高深度學習訓練時的準確度;除此之外,AlexNet使用GPU處理訓練時所產生大量的矩陣運算,提升了網絡的訓練效率。

3.2 VGGNet

VGGNet是牛津大學與GoogleDeepMind公司的研究員一起合作開發的卷積神經網絡,2014年取得了ILSVRC比賽分類項目的亞軍和識別項目的冠軍。VGGNet探索了網絡深度與其性能的關系,通過構筑16-19層深的卷積神經網絡,Top 5誤差率為7.5%,在整個卷積神經網絡中,全部采用3×3的卷積核與2×2的池化核,網絡結構如圖5。

VGGNet包含很多級別的網絡,深度從11層到19層不等,最常用的是VGG-16和VGG-19。VGGNet把網絡分成了5段,每段都把多個3×3的網絡串聯在一起,每段卷積后接一個最大池化層,最后是3個全連接層和一個softmax層。

VGGNet有兩個創新點。①通過網絡分段增加網絡深度、采用多層小卷積代替一層大卷積,2個3×3的卷積核相當于5×5的感受野,三個相當于7×7的感受野。優勢在于:首先包含三個ReLU層增加了非線性操作,對特征的學習能力更強;其次減少了參數,使用3×3的3個卷積層需要3×(3×3×n)=27×n個參數,使用7×7的一個卷積層需要7×7×n=49×n個參數。②在訓練過程中采用了多尺度和交替訓練的方式,同時對一些層進行預訓練,使得VGGNet能夠在較少的周期內收斂,減輕了神經網絡訓練時間過長的問題。不足之處在于使用三個全連接層,參數過多導致內存占用過大,耗費過多的計算資源。

VGGNet是最重要的神經網絡之一,它強調了卷積網絡的深度的增加對于性能的提升有著重要的意義。

3.3 GoogLeNet

GoogLeNet是由谷歌研究院提出的卷積神經網絡,獲得2014年的ILSVRC比賽分類任務的冠軍,Top 5誤差率僅為為6.656%。GoogLeNet的網絡共有22層,但參數僅有700萬個,比之前的網絡模型都少很多。一般來說,提升網絡性能最直接的辦法就是增加網絡深度,隨之增加的還有網絡中的參數,但過量的參數容易產生過擬合,也會增大計算量。GoogLeNet采用稀疏連接解決這種問題,為此提出了inception的結構,如圖6所示。

在inception結構中,同時采用1×1、3×3、5×5卷積核是為了將卷積后特征圖保持一致,便于融合,stride=1,padding分別為0、1、2,卷積后就可得到相同維度的特征,最后進行拼接,將不同尺度的特征進行融合,使得網絡可更好的提取特征。

在整個網絡中,越靠后提取到的特征也越抽象,每個特征所對應的感受野也隨之增大,因此隨著層數的增加,3×3、5×5卷積核的比例也要隨之增加,這樣也會帶來巨大的參數計算,為此GoogLeNet也有過諸多改進版本,GoogLeNet Inception V2、V3以及V4,通過增加Batch Normalization、在卷積之前采用1×1卷積降低緯度、將n×n的卷積核替換為1×n和n×1等方法降低網絡參數,提升網絡性能。

3.4 ResNet

ResNet于2015年被提出,獲得了ILSVRC比賽的冠軍,ResNet的網絡結構有152層,但Top 5錯誤率僅為3.57%,之前的網絡都很少有超過25層的,這是因為隨著神經網絡深度的增加,模型準確率會先上升然后達到飽和,持續增加深度時,準確率會下降;因為隨著層數的增多,會出現梯度爆炸或衰減現象,梯度會隨著連乘變得不穩定,數值會特別大或者特別小;因此網絡性能會變得越來越差。ResNet通過在網絡結構中引入殘差網絡來解決此類問題,殘差網絡結構示意圖如圖7所示。

很明顯,殘差網絡是跳躍結構,殘差項原本是帶權值的,但ResNet用恒等映射代替了它。在圖7中,輸入為x,期望輸出為H(x),通過捷徑連接的方式將x傳到輸出作為初始結果,輸出為H(x)=F(x)+x,當F(x)=0時,H(x)=x。于是,ResNet相當于將學習目標改變為目標值H(X)和x的差值,也就是所謂的殘差F(x)=H(x)-x,因此,后面的訓練目標就是要將殘差結果逼近于0。

ResNet通過提出殘差學習,將殘差網絡作為卷積神經網絡的基本結構,通過恒等映射,來解決因網絡模型層數過多導致的梯度爆炸或衰減問題,可以最大程度地加深網,并得到非常好的分類效果。

4 結束語

本文對卷積神經網絡的發展進行了梳理和分析,歸納、總結了卷積神經網絡中基本的運算單元,重點剖析了幾個性能優異應用廣泛的卷積神經網絡,卷積神經網絡目前已得到了廣泛的應用,但仍然存在大量值得研究的熱點方向:

⑴ 如何設計結構可以使得模型具備更高程度的智能化,從而解決更加復雜的問題;

⑵ 隨著卷積神經網絡層數的不斷加深,卷積神經網絡的訓練,勢必會消耗大量能耗、占用大量內存,應用在生產中如何降低能耗,降低生產成本;

⑶ 手機的大力普及對于卷積神經網絡的實時性需求增加,如何設計輕量級、小巧的卷積神經網絡,同時保證實時性與模型性能也是值得研究的問題。

參考文獻(References):

[1] Goodfellow, I., Bengio, Y., Courville, A..Deep learning(Vol. 1).Cambridge:MIT press,2016:326-366

[2] Gu, J., Wang, Z., Kuen, J., Ma, L., Shahroudy, A., Shuai,B., Liu, T., Wang, X., Wang, L., Wang, G. and Cai, J., 2015. Recent advances in convolutional neural networks. arXiv preprint arXiv:1512.07108

[3] Sun B, Ju Q Q, Sang Q B. Image dehazing algorithm based on FC-DenseNet and WGAN[J]. Journal of Frontiers of Computer Science and Technology,2020.14(8):1380-1388

[4] McCulloch W S, Pitts W. A logical calculus of the ideas immanent in nervous activity[J]. The bulletin of mathematical biophysics,1943.5(4):115-133

[5] Rosenblatt, F. The perceptron: A probabilistic model for information storage andorganizationin the brain[J]. Psychological Review,65(6):386-408

[6] Rumelhart D E, Hinton G E, Williams R J. Learning Representations by Back Propagating Errors[J].Nature,1986.323(6088):533-536

[7] Zhang, W., 1988. Shift-invariant pattern recognition neural network and its optical architecture. In Proceedings of annual conference of the Japan Society of Applied Physics.

[8] LeCun, Y., Bottou, L., Bengio, Y. and Haffner, P., 1998.Gradient-based learning applied to document recognition. Proceedings of the IEEE,86(11):2278-2324

[9] Hinton G E, Osindero S, Teh Y W. A fast learning algorithm for deep belief net[J].NeuralComputxtion,2006.18(7):1527-1554

[10] Krizhevsky A,Sutskever I,Hinton G E.Imagenet classification with deep convolutional neural networks[C]//Advances in Neural Information Processing Systems,2012:1097-1105

[11] Zeiler M D, Fergus R. Visualizing and understanding convolutional networks[C]//European conference on computer vision. Springer, Cham,2014:818-833

[12] Simonyan K, Zisserman A. Very Deep Convolutional?Networks for Large Scale Image Recognition[J]. Computer ence, 2014.

[13] Szegedy C,Liu W,Jia Y,et al.Going deeper with convolutions[C]//Proceedings of International Conference on Computer Vision and Pattern Recognition,2015.

[14] Huang G, Liu Z, Van Der Maaten L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition,2017:4700-4708

[15] Yamada Y, Iwamura M, Kise K. Deep pyramidal residual networks with separated stochastic depth[J]. arXiv preprint arXiv:1612.01230, 2016.

[16] 芮挺,費建超,周遊,方虎生,朱經緯.基于深度卷積神經網絡的行人檢測[J].計算機工程與應用,2016.52(13):162-166