結合模糊特征檢測的魯棒核相關濾波跟蹤法

林椹尠,鄭興寧,吳成茂

(1. 西安郵電大學 理學院,陜西 西安 710121; 2. 西安郵電大學 通信與信息工程學院,陜西 西安 710121; 3. 西安郵電大學 電子工程學院,陜西 西安 710121)

目標跟蹤指通過目標檢測或人工標記來確定目標在第一幀中的尺寸、位置,然后利用跟蹤算法繼續獲取下一幀中目標的尺寸、位置,進而預測目標的運動軌跡[1]。它是計算機視覺領域中重要的研究方向,在視頻監控和軍事領域等方面應用廣泛[2]。

生成式跟蹤法[3]主要根據目標的外觀特征建立復雜跟蹤模型,但它忽略了背景信息,當跟蹤目標和背景信息較相似時,容易導致跟蹤失敗,并且該方法計算復雜度較高,實時性相對較差。而判別式跟蹤法[4-5]結合了目標和背景信息來訓練分類器,在跟蹤過程中通過分類器預測目標運動軌跡,其表現更為魯棒。

核相關濾波法(kernelized correlation filter,KCF)[6]屬于判別式跟蹤法,其高效的計算能力受到國內外研究者的青睞[7]。KCF算法將目標樣本進行循環移位采集到大量訓練樣本,通過循環矩陣的性質將時域中的矩陣求逆轉化為頻域中的點積運算,降低了計算復雜度[8],并通過引入核函數將非線性問題轉化為線性問題,使得該算法滿足大多數實際應用場景的需求。但是KCF算法難以解決運動目標發生形變、尺度變化、遮擋和運動模糊等情況下的跟蹤問題。近幾年,CN(color name)[9]、DSST(accurate scale estimation for robust visual tracking)[10]、SAMF(scale adaptive with multiple features)[11]、SRDCF (spatially regularized correlation filters)[12-13]和CFLB (correlation filters with limited boundaries)[14]等算法相繼提出,分別從顏色特征、多尺度變化、特征融合和降低邊界效應等方面不斷將跟蹤法進行優化,來提高算法的跟蹤精度。

然而,對模糊圖像中的目標進行有效跟蹤仍是跟蹤領域內的一個難題。為此,本文在KCF算法的基礎上引入了尺度不變特征變換描述子(scale invariant feature transform, SIFT)[15],通過結合局部二值模式 (local binary pattern, LBP)[16]算法使得SIFT描述子可從模糊圖像中提取到更多的目標特征點,并采用圓形鄰域對特征點進行描述以降低特征向量的維度,綜合構建出高效模糊特征檢測器,并通過OTB-2013[17]和OTB-2015[18]數據集對所提算法進行分析與驗證。

1 KCF跟蹤法

1.1 訓練分類器

KCF算法通過循環移位目標樣本采集到大量訓練樣本,(xi,yi) 為第 i 個訓練樣本與其對應的標簽。該算法的核心是嶺回歸,目的是找到一個回歸函數 f(x)=wTx,通過最小化樣本與標簽之間的誤差平方和,求得權重向量 w。計算方法如下:

式中:w為分類器權重向量;λ 是防止過擬合的正則化參數。利用最小二乘法進行求解:

式中:X 表示樣本循環矩陣;y 是列向量,每個元素代表一個樣本標簽;I 是單位矩陣。

針對非線性問題,將樣本 xi映射到非線性的特征空間 φ (xi),將權重向量 w 表示為樣本的線性組合,即為第 i 個樣本的權重系數。

利用核函數 φT(x)φ(x′)=k(x,x′) 進行樣本間的點積計算,計算結果保存在核循環矩陣 K=C(k(x,x′)) 中,其元素 Kij=k(xi,xj)。求得系數向量 α=(K+λI)-1y,利用循環矩陣性質得出系數向量的傅里葉變換形式:

式中:σ表示高斯核的帶寬;⊙表示向量間的點乘運算;F-1表示傅里葉逆變換。

1.2 預測目標位置

計算當前圖像中所有待檢測樣本 z 的回歸響應值,計算公式為

式中:kxz表示訓練樣本 x 與檢測樣本 z生成的互相關核向量。最大響應值的位置就是當前圖像中目標 的可能位置。

1.3 參數更新

為了防止模型發生劇烈變化,需不斷地更新當前圖像中的目標模板以及分類器權重向量,更新的目標模板和權重向量:

式中:β 是更新參數的學習率;下標 pre和 update 分別表示上一幀和當前圖像更新后的參數向量。將訓練和檢測交替進行,實現目標的持續跟蹤。

傳統的KCF算法同時結合了目標和背景信息,并且引入了循環矩陣和核函數,算法運行速度快,可以滿足實時跟蹤的需求。但是該算法在面對模糊圖像時,容易出現跟蹤失敗的現象。本文在KCF算法基礎上結合了模糊特征檢測器,通過在模糊圖像上提取特征點來計算跟蹤目標的位置,進一步提高KCF算法的跟蹤精確度和成功率。

2 結合模糊特征檢測的KCF跟蹤法

跟蹤過程中,若出現模糊圖像,會造成跟蹤模板被污染,導致KCF算法跟蹤失敗。本文在傳統KCF算法的基礎上,提出一種結合模糊特征檢測的魯棒KCF跟蹤法。該算法通過在模糊圖像上提取大量特征點并進行特征向量匹配來確定當前圖像中跟蹤目標的位置,進而提高KCF算法在模糊圖像中的精確度和準確率。

2.1 目標特征點檢測

SIFT描述子是一種多尺度的局部特征描述算法,對光照變化、視覺變換等具有一定的穩定性。算法主要分為4個部分[19]:1)在原始圖像的基礎上,通過高斯濾波形成高斯尺度空間,將相鄰高斯圖像相減形成高斯差分金字塔,檢測圖像的局部極值點;2)確定極值點的精確位置并輸出穩定的特征點;3)計算特征點鄰域像素點的梯度幅值和梯度方向,根據鄰域像素點的梯度方向分布,得出梯度直方圖,為特征點指定主方向;4)通常在特征點周圍構建 16×16 像素大小的矩形鄰域,并將其劃分為 4×4 個子區域,在每個子區域中計算8個方向的梯度累加值,形成 4×4×8=128 維的特征描述符向量[20]。

但是,現有的SIFT描述子存在兩方面的問題:1)SIFT描述子丟棄了一些邊緣上的點和低對比度的點,導致該描述子在邊緣光滑或模糊圖像中提取的特征點數量較少,或提取的特征點不準確;2)SIFT描述子生成了128維的特征描述符向量,高緯度的特征向量造成該描述子運行時間過長。針對現有SIFT描述子的不足之處,本文通過構建高效模糊特征檢測器來提高特征點的數量和精確度。

1)在模糊圖像中提取穩定特征點

LBP算法用于提取圖像的局部紋理特征,當圖像變得模糊時,LBP圖像可以保留原始圖像的結構信息和空間信息,具有旋轉不變性和灰度不變性[21]。并且該算法參數設置較少,計算公式為

式中:B(x0,y0) 表示特征點的LBP值; vc表示特征點的灰度值;vp表示鄰域像素點的灰度值;s 為符號函數,且將LBP算法與SIFT 描述子結合,新形成的描述子在LBP圖像的差分金字塔中尋找極值點。

2)降低特征描述符向量的維度

跟蹤過程中目標可能會發生旋轉,為使描述子依舊具有旋轉不變性,本文將特征點的矩形鄰域改為圓形鄰域[22],并將特征點鄰域像素的梯度幅值根據像素點與特征點的距離進行高斯加權,提高算法的精確度。通過擴大特征點鄰域范圍,使新形成的圓形描述符在降維的同時滿足跟蹤過程中所需的目標匹配精度。圓形描述符的具體模型為

式中:(x0,y0) 為特征點位置; ( x,y) 為圓形鄰域中像素點的位置;r 為同心圓區域的半徑。

以特征點為圓心,形成 n 個同心圓子區域,在每個子區域中計算 t 個方向的梯度累加值。然后將每個子區域中計算出的 t 維向量進行循環左移,使得梯度方圖中的最大值始終為向量的第1個元素,確保描述符向量具有選擇不變性。最后將生成的 n×t=w 維描述符向量進行歸一化,減少光照變化的影響。

構建的高效模糊特征檢測器,可以在模糊圖像中提取到大量穩定特征點,并且不需要計算特征點的主方向,同時降低了特征描述符向量的維度 ,可減少后續特征點匹配的時間。

2.2 目標特征點匹配

從上一幀圖像中選出跟蹤目標,生成 k 個模板特征向量 mi=(m1,m2,···,mc,···,mw),其中 i∈[1,k],c∈[1,w] 且 w 為每個特征向量的維度。并從當前模糊圖像中提取 p 個待匹配特征向量,其中 j∈[1,p],c∈[1,w]。利用公式分別計算每個模板特征向量與 p 個待匹配特征向量之間的絕對距離。若一組特征向量最近鄰絕對距離與次近鄰絕對距離的比值小于所給閾值,則接著計算兩個特征向量之間的余弦相似度,若所得相似度值大于經驗閾值,將這兩個特征向量視為匹配對;否則,進行下一組特征向量的計算。最后得出當前圖像中所有匹配點的重心位置,將此位置視為跟蹤目標 的中心位置。

2.3 預測目標最終位置

根據所給的視頻序列,設置清晰度閾值,若當前圖像清晰度高于閾值,則使用傳統的KCF算法預測目標位置;若當前圖像清晰度低于閾值,則啟動模糊特征檢測器,通過計算當前圖像上所有匹配點的重心位置來得到目標的中心位置,最后標定跟蹤目標,進行后續的檢測。模糊圖像中的目標匹配結果如圖1所示。

圖 1 模糊圖像匹配結果Fig. 1 Matching result of fuzzy image

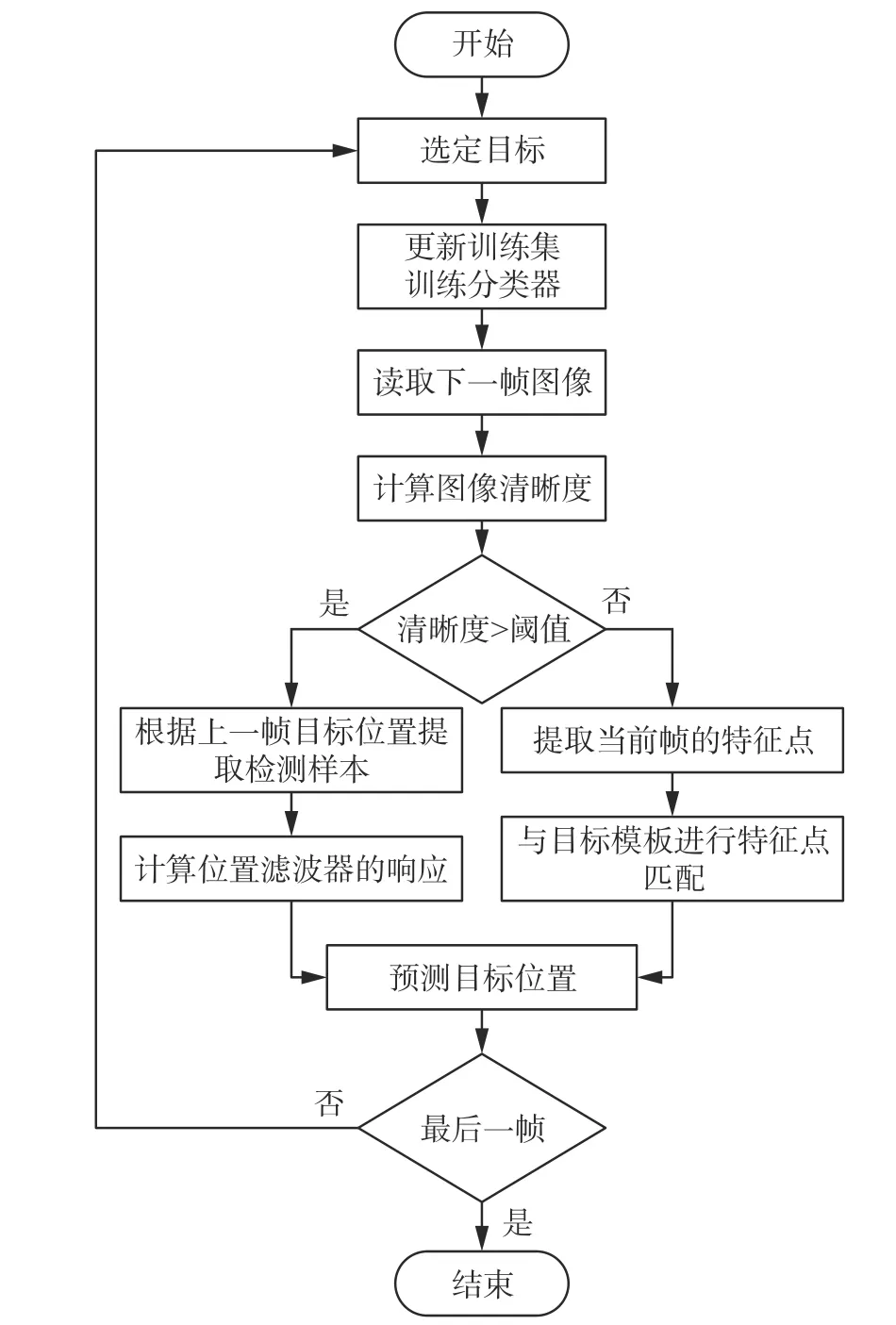

改進算法的整體流程圖如圖2所示。

圖 2 改進算法流程圖Fig. 2 Flowchart of the improved algorithm

3 實驗結果與分析

3.1 實驗設置

采用OTB-2013[17]和OTB-2015[18]數據集測試本文算法的性能,它們分別含有50和100個標注完整的視頻序列。實驗中設置目標搜索區域面積為跟蹤框的2.5倍,正則化參數0.000 1,空間帶寬0.1,更新參數的學習率 β 為0.02,高斯核函數的方差為0.5。低對比度閾值設置為170,主曲率閾值設置為18。經實驗分析,圓形鄰域最大半徑設為9,將特征點圓形鄰域分為6個同心圓子區域,梯度方向t=8,絕對距離閾值設為0.6,余弦相似度閾值設為0.95,并且在實驗過程中所有參數值固定不變。

實驗環境為Intel(R) Core(TM) i5-5200U CPU@2.20 GHz處理器,4 GB運行內存,MATLABR2014a平 臺。

3.2 定性分析

為了更直觀的對比各算法在模糊圖像上的跟蹤效果,從OTB-2013和OTB-2015數據集中選取了4組代表性的視頻序列,分別為Coke、Jogging、Couple和Jump序列,并將所選序列隨機地進行模糊化處理。視頻序列跟蹤結果如圖3所示,視頻圖中的數字表示幀數,綠色框、藍色框、紫紅色框、黑色框和紅色框分別代表KCF[6]、DSST[10]、SRDCF[12]、人工標注和本文算法的跟蹤框。

實驗1:OTB-2015數據集中的Coke序列受到不均勻的光照以及綠色樹葉的遮擋。跟蹤結果如圖3(a)所示:第17幀,視頻圖像清晰,跟蹤目標受到輕微光照的影響,4種算法均能正確跟蹤到目標物體。從第68幀到141幀,視頻圖像變得模糊,導致跟蹤目標外觀不清晰,KCF算法出現跟蹤失敗的現象,DSST算法雖然能跟蹤到目標,但是跟蹤框包含了大量的背景信息,只有本文算法和SRDCF算法可以正確定位到跟蹤目標的位置。第281幀,視頻圖像由模糊變得清晰,本文算法和SRDCF算法依舊可以順利跟蹤到目標,并且不受光照變化的影響,而其余兩種算法均跟蹤失敗。

實驗2:OTB-2015數據集中的Jogging序列,跟蹤目標與背景較相似,并且在跟蹤過程中目標受到較長時間的遮擋。跟蹤結果如圖3(b)所示:第66幀,視頻圖像清晰,4種算法均能正確跟蹤到目標物體。從第86幀到116幀,跟蹤目標受到了連續幾幀的模糊和遮擋,本文算法依舊可以正確預測到跟蹤目標的位置,而其余3種算法均跟蹤失敗。

實驗3:OTB-2013數據集中的Couple序列受到了光照變化的影響,并且運動速度較快。圖3(c)中,第21幀和第89幀的可視化跟蹤結果顯示:本文算法可以對模糊圖像中的目標進行有效跟蹤,而SRDCF算法出現跟蹤丟失的現象,DSST算法剛開始可以跟蹤到目標,之后跟蹤模板被污染,同樣出現了跟蹤失敗的現象。直到第125幀,視頻圖像再次變得清晰,但是此時跟蹤目標受到了強烈光照的影響,本文算法可以跟蹤到目標,而其余3種算法均出現跟蹤丟失的現象。

圖 3 視頻序列跟蹤結果Fig. 3 Tracking results of video sequence

實驗4:選取OTB-2013數據集中的Jump序列。跟蹤結果如圖3(d)所示:視頻圖像第20幀和第62幀,跟蹤目標外觀模糊、發生旋轉并且所在背景雜亂,本文算法可通過啟動模糊特征檢測器,在模糊圖像中提取到大量穩定的特征點,從而正確跟蹤到目標,而其他3種算法均出現跟蹤丟失的現象。

3.3 定量分析

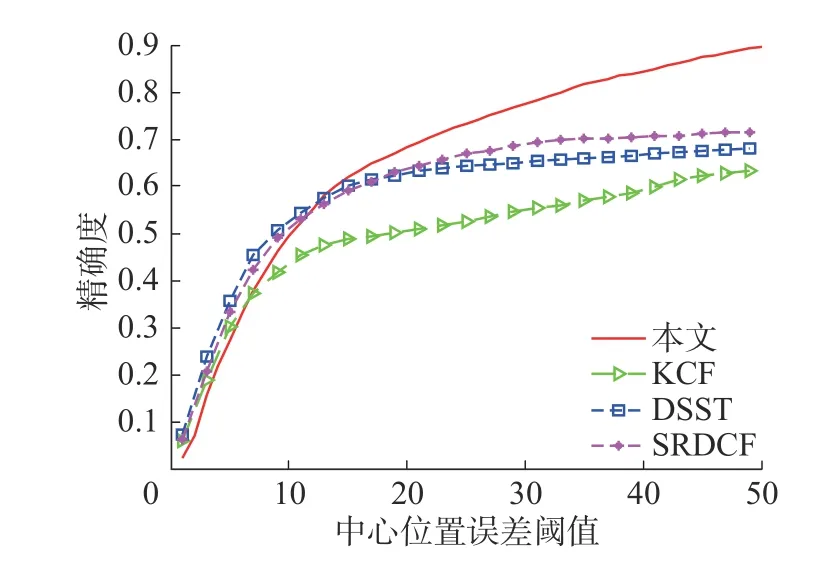

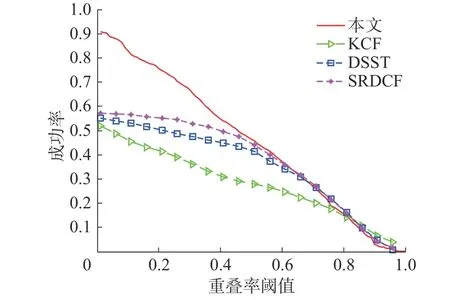

為進一步驗證本文所提算法在各視頻序列中的跟蹤性能,將跟蹤精確度和成功率作為算法的評價指標。其中,跟蹤精確度定義為預測的目標位置與人工標注的目標位置之間的歐式距離小于所給閾值的幀數占總幀數的比值[23];跟蹤成功率定義為預測的目標框的面積與人工標注的目標框的面積的重疊率大于給定閾值的幀數占總幀數的比值。采用經典實驗數據值,將精確度閾值設為20像素,成功率閾值設為0.5。

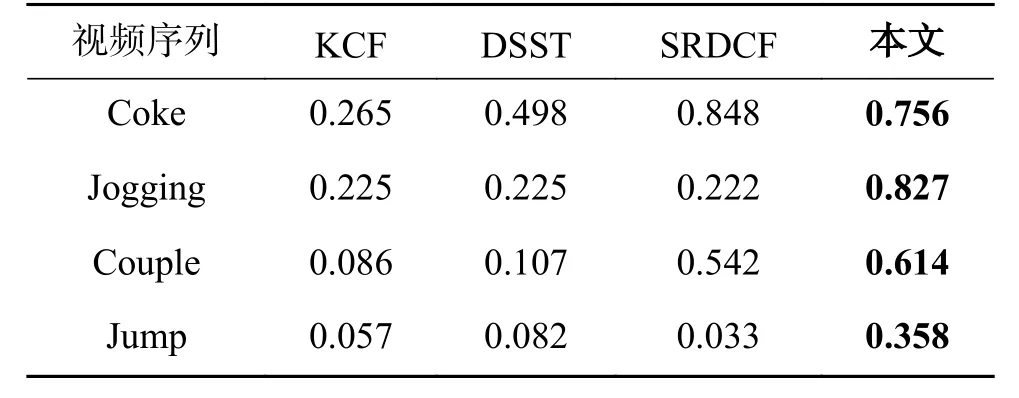

1)跟蹤序列精確度和成功率分析

4種算法對Coke、Jogging、Couple和Jump序列的跟蹤精確度和成功率值如表1~2所示:與其他3種實驗算法相比,本文算法的精確度和成功率均為最高或次高值。說明雖然圖像模糊導致跟蹤目標的邊緣信息丟失,但是本文算法可通過模糊特征檢測器,從模糊圖像中提取出大量特征點,從而跟蹤到目標,并且跟蹤框包含著大量的目標信息,使得跟蹤精度和準確率較高。而KCF算法、DSST算法和SRDCF算法由于不具備抗模糊性,在模糊圖像中導致跟蹤模板被污染,出現跟蹤失敗的現象。

表 1 跟蹤序列精確度對比Table 1 Comparison of accuracy

表 2 跟蹤序列成功率對比Table 2 Comparison of success rate

2)模糊序列精確度和成功率分析

為驗證本文算法在其他視頻序列上的適用性,從OTB-2015數據集中選取大量不同屬性的視頻,并將其進行不同程度的模糊化處理。跟蹤精確度和成功率曲線如圖4~5所示:本文算法的精確度和成功率均居第一。本文算法的精確度為68.2%,在經典KCF算法的基礎上提高了18.1%,比次優的SRDCF算法提高了5.7%;本文算法的成功率為49.5%,在經典KCF算法的基礎上提高了19.2%,比次優的SRDCF算法提高了2.3%。實驗數據說明,本文算法通過啟動模糊特征檢測器,可以在模糊圖像上提取到大量目標特征點,并通過絕對距離和余弦相似度進行目標特征向量匹配,進而成功定位到目標的位置,由此提高了KCF算法在模糊圖像上的精確度和成功率。

圖 4 平均精確度曲線Fig. 4 Curve of average accuracy

圖 5 平均成功率曲線Fig. 5 Curve of average success rate

另外,模糊化處理OTB-2013數據集里的視頻序列,并將其用于本文算法的測試中。測試結果表明,與現有的KCF算法相比,本文算法可以對模糊圖像中的目標進行有效跟蹤,且其精確度較高,從而進一步說明本文算法具有普適性。

4 結束語

對模糊圖像中的目標進行有效跟蹤是跟蹤領域內的一個難點,本文在KCF算法的基礎上,提出了一種結合模糊特征檢測的魯棒KCF跟蹤法。該算法通過啟動模糊特征檢測器,可以在模糊圖像上提取大量的目標特征點,并將降維后的目標特征向量進行匹配,提高了KCF算法的性能。視頻序列可視化跟蹤結果顯示,本文算法在模糊圖像上可以順利跟蹤到目標,且其精確度和成功率均高于對比算法,由此可說明本文算法具有抗模糊性和光照不變性,適用于大部分模糊圖像的跟蹤場景。但是,與經典的KCF算法相比,本文算法由于引入了LBP算法,在提高精度的同時也增加了計算量,導致跟蹤速度較低。下一步研究的目標是在不影響算法精度的情況下進一步提高算法的運行速度。