夜間復雜場景下紅外圖像行人檢測算法研究

趙 雙,陳樹越,王巧月

夜間復雜場景下紅外圖像行人檢測算法研究

趙 雙,陳樹越,王巧月

(常州大學 信息科學與工程學院,江蘇 常州 213164)

針對夜間紅外圖像中行人與背景灰度差異小且存在遮擋等問題,提出了一種夜間復雜場景下的紅外行人檢測算法。首先利用行人語義融合方法生成對目標全覆蓋的顯著圖,與原圖融合得到感興趣區域,然后構造基于改進的方向梯度直方圖特征的兩分支分類器,同時提出一種遮擋判別算法,根據分類器模糊分數判斷是否遮擋,設計一種頭部模板實現最終的行人檢測。在LSI遠紅外行人數據集和自主采集的冬、夏季節夜間行人數據上進行實驗,結果表明:在不同環境下,所提出的方法均可快速魯棒地檢測出行人,可較顯著地降低漏檢率,檢測率可達到94.20%。

紅外圖像;行人檢測;顯著性;復雜情況;方向梯度直方圖特征

0 引言

行人檢測是計算機視覺領域極具挑戰性的問題,廣泛應用在公共安全、智能監控、自動駕駛等領域中[1-2]。與傳統的基于可見光的行人檢測任務相比,遠紅外圖像不受光照的影響,可以檢測物體的熱分布,從而在夜間對物體進行空間顯示。熱成像受溫度值影響大,環境溫度升高會帶來灰度值反轉問題,當行人與環境相接時,輪廓邊緣無法保持完整,導致感興趣區域提取失敗進而無法檢出行人、路燈、車輛向陽面等灰度值高的目標易產生誤檢[3]。與此同時,還要應對行人個體和姿態、視角及尺度的差異問題,復雜的背景使行人極易出現遮擋情況導致誤判,現階段的研究多關注完整體態的行人檢測,而忽略了遮擋的情況。

傳統的行人檢測常采用分割及連通域分析,模板匹配等方法,Dalal[4]在2005年提出梯度方向直方圖特征(histogram of gradient,HOG),率先使用梯度描述行人,利用滑動窗口遍歷圖像,得到了很高的檢測率,但計算資源消耗大。隨后描述紋理的局部二值模式(local binary patterns, LBP)特征、描述線狀、形狀、邊緣的Haar-like特征,Shapelet特征和Edgelet特征等接連被提出并應用到行人檢測中。很多學者對HOG特征做出了改進,比如將金字塔思想應用于尺度縮放的PHOG特征[5],結合邊緣信息的HEOG特征[6],或者以HOG特征為基礎進行特征融合,如HOG-LBP[7],HOGI特征[8]等。

常見的感興趣區域(region of interest, ROI)提取方法是通過閾值分割,這種方法受圖像對比度影響大,效果較差,基于視覺顯著性進行ROI提取可以最大程度模擬司機的人眼注視,將有限的計算資源分配給容易引起觀察者注意的區域,達到輔助駕駛的目的。顯著性檢測分為兩類:自下而上基于數據驅動的顯著性區域凸顯,和自上而下任務驅動的目標凸顯。

Koch[9]引入了顯著圖(saliency map)的概念來表示復雜場景的突出位置,他使用“贏者全取”(winner-take-all)的神經網絡來選擇圖像中最顯著的位置,在此基礎上,許多由視覺注意機制啟發的顯著性模型被提出,如應用廣泛的FT模型[10],SR模型[11]等。

與相關研究相比,本文更關注在黑暗復雜環境下探測行人,考慮了遮擋、尺度不一等情況,利用行人先驗語義進行ROI提取,構造改進的HOG二分支分類器進行行人檢測,同時利用遮擋判別算法,設計頭部檢測算子對被遮擋行人進行二次識別,實驗證明本文方法檢測效果良好,克服了行人的多變性,背景的復雜性。

1 紅外行人候選區域提取

1.1 系統檢測框架

文中提出的檢測方法由3個模塊組成,包括ROI提取、基于HOG特征的二分支分類和遮擋特征重識別,整體流程圖如圖1所示。

1.2 光譜殘差(SR, spectrum residual)模型

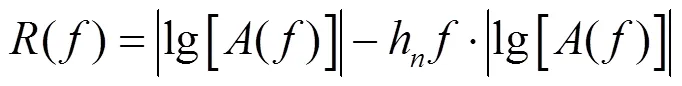

ROI是圖像中最吸引視覺的顯著關鍵信息,提取ROI代替原始圖像,可以減少大量無用的背景和噪聲點的影響。本文在光譜殘差模型的基礎上融入紅外行人的高層語義特征,得到更準確的感興趣區域。Hou等人[11]認為不同的圖像數據在對數尺度上有相似的分布趨勢,因此在不同的log譜中只需要關注差異性部分就可以得到顯著性區域。首先對輸入圖像()進行二維離散傅里葉變換,將其從空間域轉化到頻率域,光譜殘差()定義為:

式中:A(f)為實部;hn(f)為局部平均濾波器。

利用式(2)對譜殘差()和相位()進行二維離散傅里葉逆變換得到全局特征顯著圖(),所得的顯著性圖與人眼感知具有一致性。

1.3 行人高層語義特征融合

在利用SR分析得到顯著性圖的基礎上,本文提出了針對性的紅外行人的高層語義特征作為先驗知識融合,相當于在進行顯著性檢測時增加了對圖像的認知功能,提高分析準確度。行人的高層語義特征是指在待檢測的圖片中,一個區域或者一個像素點被行人目標包含的可能性的大小,求解這個可能性作為依托來求圖像的目標性,可以獲得圖像中所有行人目標的大概分布情況,對圖像的顯著性檢測有語義上的指導。

首先對輸入的圖像進行塊分割,本文選擇Alexe[12]的方法對原始圖像進行分割,然后對每個分割得到的窗口進行評分,量化每個窗口包含行人目標的可能性。在紅外圖像中,行人的亮度普遍高于周邊環境,頭部區域亮度最高,低頻信號強,邊緣紋理比內部紋理明顯,所以本文以亮度對比度和邊緣信息作為先驗語義,融入顯著性檢測中。

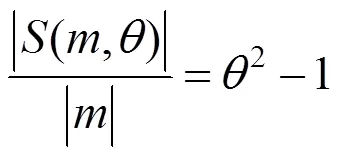

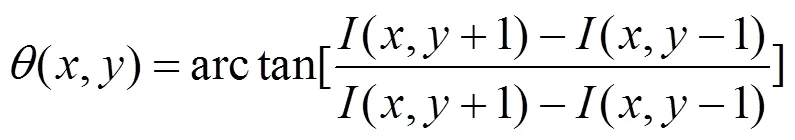

1)行人亮度對比度(brightness contrast, BC)。亮度特征是紅外圖像最重要的特征之一,如果一個包圍框完整包含行人部分,則得到較高的分數,如果窗口只包含部分目標時分數降低。如圖2(a)所示,實線框代表目標窗口,在計算的亮度對比度時,先將沿4個方向延伸一定尺度得到一個矩形外環,如圖2中虛線框所示,用外環框減去目標框,得到所對應的背景區域,此時有:

計算窗口和背景的亮度直方圖的卡方距離來定義窗口的亮度對比度:

式中:BC(,)表示亮度對比度特征值;2(·)表示卡方距離;(·)表示窗口的亮度直方圖。

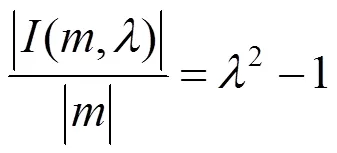

2)邊緣線密度(edge density, ED)。相比可見光圖像,紅外圖像(如圖2(b)所示)考慮的是物體的溫度信息,對雜亂的背景抑制效果良好,當溫度差距較大時,行人邊緣線明顯,當溫差小時,效果不顯著。行人邊緣線密度指的是窗口邊界附近的邊緣密度,通常情況下目標邊界邊緣的數量隨著目標邊界周長增大而增大,如圖2(c)所示。首先將得到的目標窗口沿4個方向向內收縮個尺度,得到:

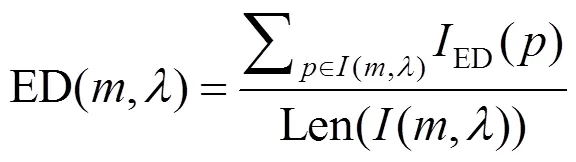

式中:(,)是的矩形內環。則ED計算公式如下:

實驗發現Canny算子的邊緣線檢測效果最佳,IED()?{0,1}是利用Canny算子進行邊線檢測后得到的二值化圖像,Len(·)表示矩形內環的周長。

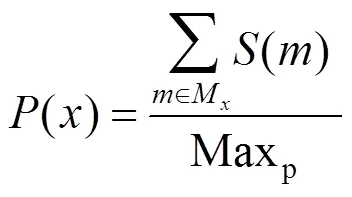

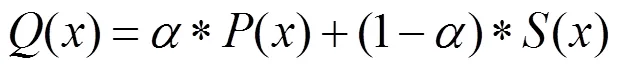

對圖像的每一個窗口都從這兩個角度進行打分,按式(7)計算圖像中每個像素點的目標性:

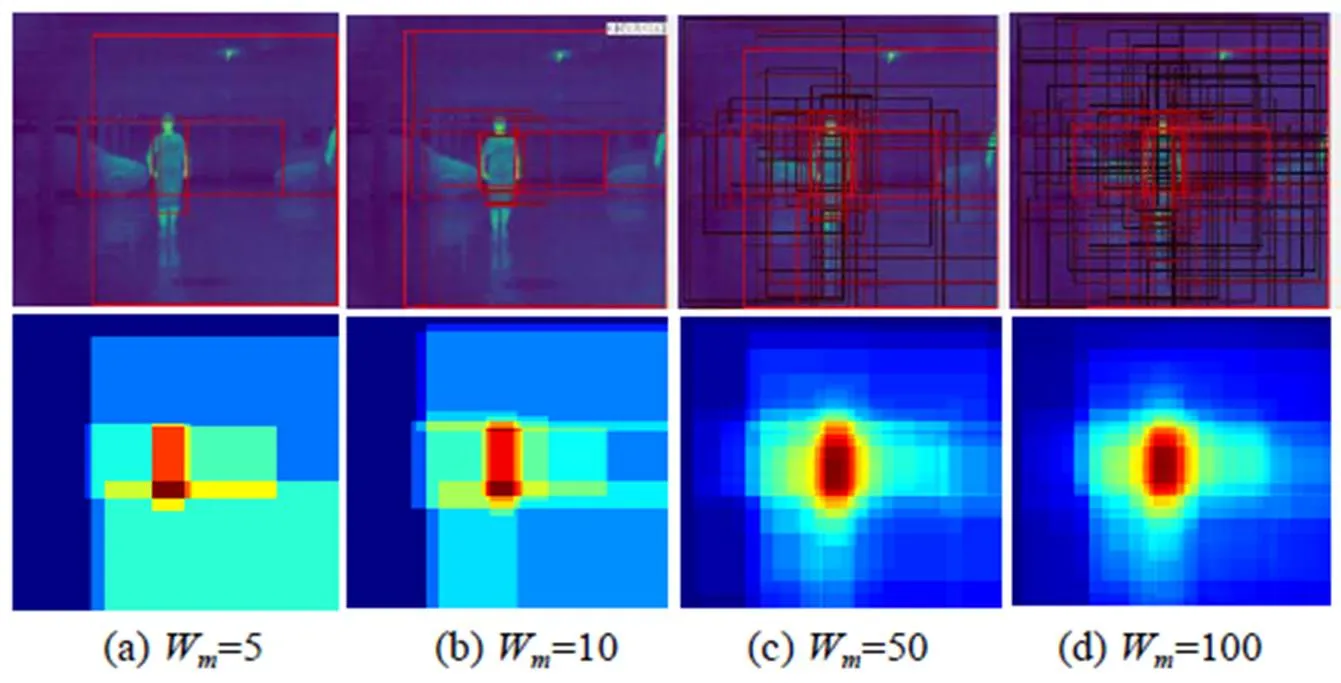

在實驗過程中,窗口劃分總個數W的選值決定了“行人”區域的標定時間和準確性,如果W值太小,得到的目標性區域結果存在較大偏差,如果W值太大,則顯著性檢測的計算時間過長。

2 快速行人特征提取與分類

2.1 基于改進的HOG特征的二分支構造

HOG特征可以很好地表征圖像梯度的方向分布,具體計算步驟如下:

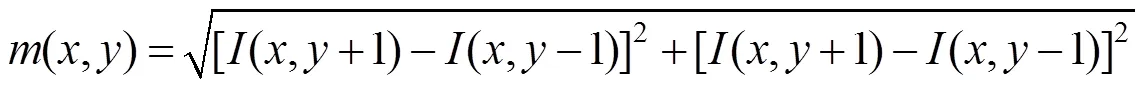

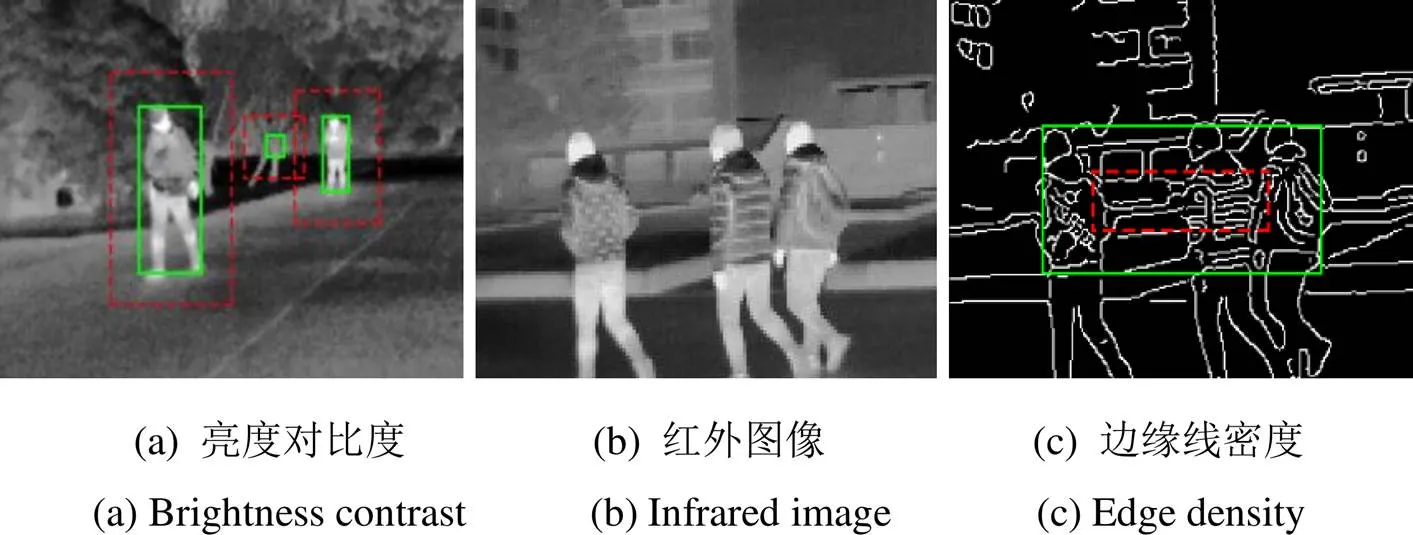

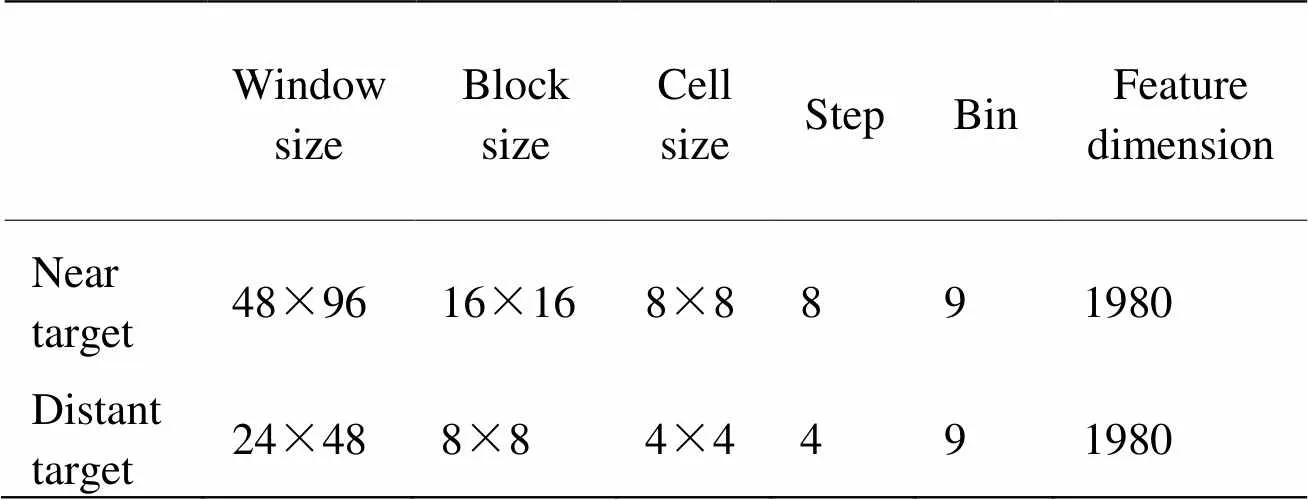

1)輸入大小為64×128的檢測窗口,每64個像素作為一個細胞單元,每4個細胞單元作為一個區塊,步長設置為8個像素,水平方向得到7個掃描窗口,垂直方向得到15個掃描窗口,如圖3(a)所示。定義每個細胞的組距為2p/9,統計落在9個不同方向區間內的梯度大小,如圖3(b)所示。利用式(8)、(9)計算每個像素的梯度幅值(,)和方向(,):

式中:(,)是圖像在點(,)處的像素值,Dalal[4]驗證了利用最簡單的一階梯度算子[1, 0, -1]進行水平和垂直方向的梯度計算效果最佳。

圖2 目標性計算示意圖

圖3 HOG特征計算過程

2)利用SVM分類器構建超平面進行分類,對于給定的{x,y},=1,…,,y?{1,-1},分類器通過尋找最優的超平面T+=0實現行人的分類識別。

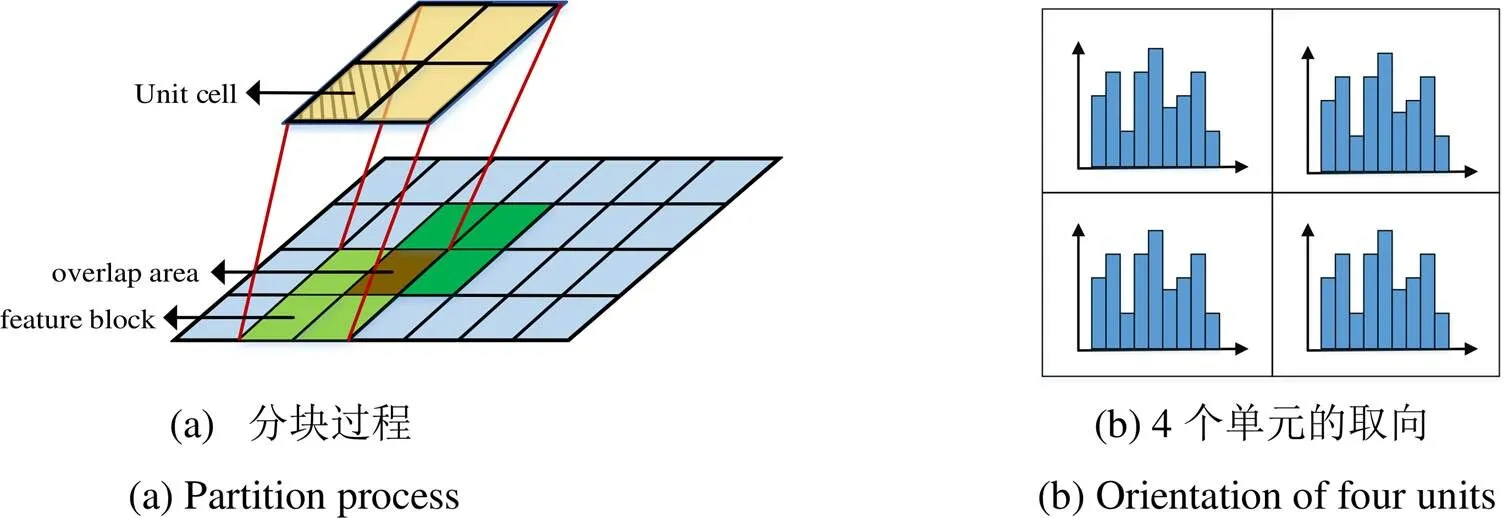

傳統的HOG特征提取所需的計算量非常大,分辨率為64×128的檢測窗口需要計算105個塊的梯度直方圖特征,得到3780維特征向量,同時多尺度縮放會導致相鄰檢測窗口間存在大量的重復計算區域,針對此種情況,本文提出了一種改進的HOG特征并構造了基于ROI高度的二分支分類結構(TBHOG, two-branches HOG),具體步驟如下:

①將得到的感興趣區域擴充至掃描步長的整數倍,用鄰域像素的灰度平均值作為擴充像素的灰度值;

②根據ROI的高度進行分類,定義為最小外接矩形垂直方向上的像素數,統計所有得到的ROI區域,平均高度為69.1pixel,所以本文選擇69像素作為分水嶺,高度小于69像素作為近景目標,高度大于69像素作為遠景目標,分別訓練SVM分類器,具體參數如表1所示。

③將得到的感興趣區域分別縮放至不同的窗口大小,輸入離線訓練的SVM分類器進行判別。

表1 兩分支的SVM分類器訓練參數

2.2 遮擋處理

上述行人檢測方法的出發點是將行人作為一個完整的整體設計,在LSI遠紅外(FIR)數據集的實驗發現,對比傳統的HOG方法,該方法的準確率有所提升,但是對本文自行拍攝的數據集來說,效果不夠理想,因為拍攝的視頻包含更多的遮擋情況,例如行人被樹木等背景遮擋或行人互相遮擋。

研究發現,如果行人發生遮擋,塊的HOG特征通過SVM分類器得到負的內積,每個窗口的線性SVM得分是HOG特征與向量的內積,向量是學習到的所有支持向量的加權和[13]。本文選擇利用整體分類器對得到的特征向量進行評價,如果整體分類器得到的置信度屬于一個模糊范圍,則判斷是否發生遮擋情況[14],如果確定發生遮擋,則利用設計的頭部模板進行行人頭部的檢測,對是否包含行人進行確認。具體步驟如下:

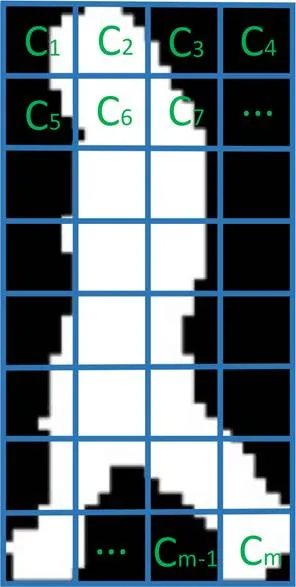

1)將待測窗口按圖4分塊,C是每個塊得到的特征值,維數為36,HOG特征計算過程中得到55個塊,定義窗口特征描述子=(1,2,…,55)T,通過訓練好的Linear SVM分類器,根據式(10)計算返回值():

()=+T·(10)

圖4 檢測窗口分塊

理論上()值越高,說明窗口中有行人的可能性越高,反之亦然,如果分類器的響應接近于0,就認為分類是模糊的。本文定義模糊區間為(-1.5, 0.5),認為可能存在遮擋。

2)對于每個C,?{1,2,…,55},定義一個局部分類器()=+T·C,其中是支持向量展開后所對應的向量,均為36維,為每個塊的檢測誤差。

3)通過對局部響應()進行閾值化得到離散的標簽t,t=1表示是C行人的一部分,t=-1表示C是被遮擋或是背景的一部分,得到一個二值映射(1,2,…,55)。

5)無論行人是否遮擋或出現不同的朝向、姿勢,行人的頭部輪廓變化基本可以保持不變,頭肩部呈現出類似于“W”的形狀[15],如圖5所示,我們設計了16×16的頭部模板進行分類識別,使用離線SVM分類器訓練。

圖5 頭部檢測模型

3 系統設計與結果評估

3.1 數據集選擇

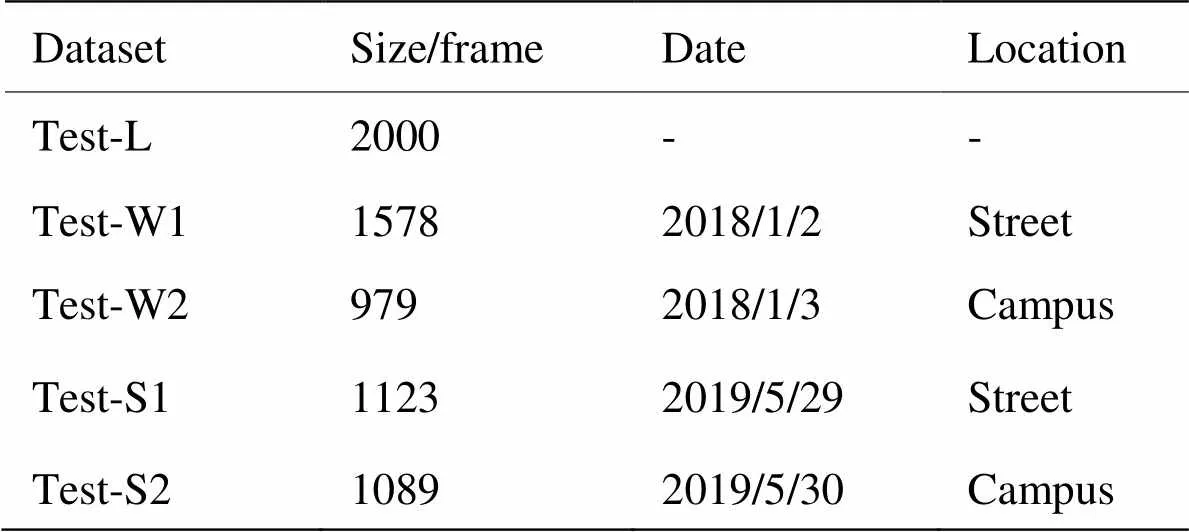

實驗運行環境為Intel(R) Core(TM) i3-4170 CPU,平臺為MATLAB R2018b和Python OpenCV庫,實驗使用3個數據集:LSI遠紅外行人數據集(https://e-archivo.uc3m.es/handle/10016/17370)和利用FLIR E40熱像儀采集的冬季(Test-W)、夏季(Test-S)道路/行人(Test-L)視頻,基本信息如表2所示。

表2 測試數據的基本信息

LSI數據集來自在室外城市場景中駕駛的車輛,包含用于訓練的53598張紅外圖像和用于測試的27994張圖像。自主數據采集速率為31幀/s,分辨率為320×240像素。數據采集的時間均為晚上22:00左右,涵蓋了溫度變化、遮擋、尺度變化等一系列夜間行人檢測常見的問題,示例如圖6。每隔3幀標注一次,保證了實驗的真實有效性。

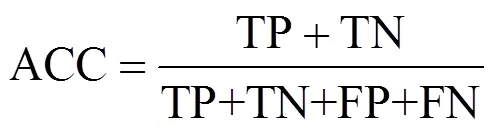

3.2 評價標準

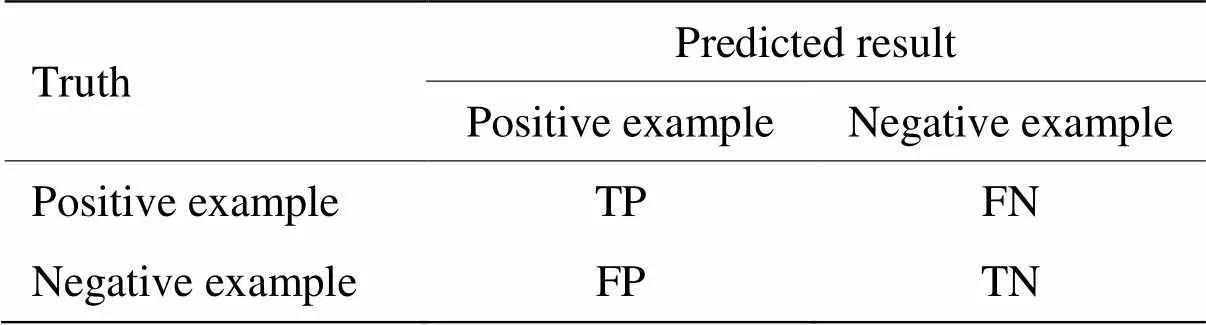

紅外圖像中行人的檢測本質上是一個二分類問題,檢測率(accuracy,ACC)是最常見的指標,即:

其中參數混淆矩陣如表3所示。

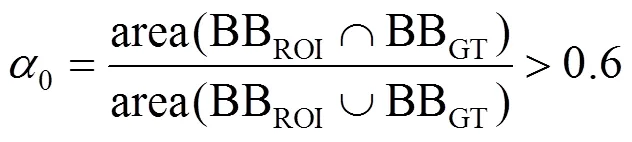

定義正確的檢測需符合條件:

即預測的邊界框BBROI和真實邊界框BBGT之間的重疊率a0必須超過60%,否則就認為是錯誤的檢測結果(虛警)。

表3 參數混淆矩陣

其中,TP(true positive)表示指檢測器正確預測的行人窗口,FP(false positive)指將非行人預測為行人窗口的數目,TN(true negative)指檢測器正確分類的非行人窗口,FN(false negative)指行人窗口發生漏檢的數目。

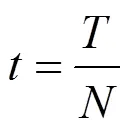

考慮行人檢測問題的實時性,本文將每張圖片的平均檢測時間也作為評價標準,即:

式中:是檢測耗費時間;是圖片張數。

3.3 參數選擇

隨機選取500幅LSI遠紅外數據集的測試圖片,手動標記行人區域,統計不同目標性檢測窗口數W下的行人區域數,目標性檢測示意圖如圖7所示。

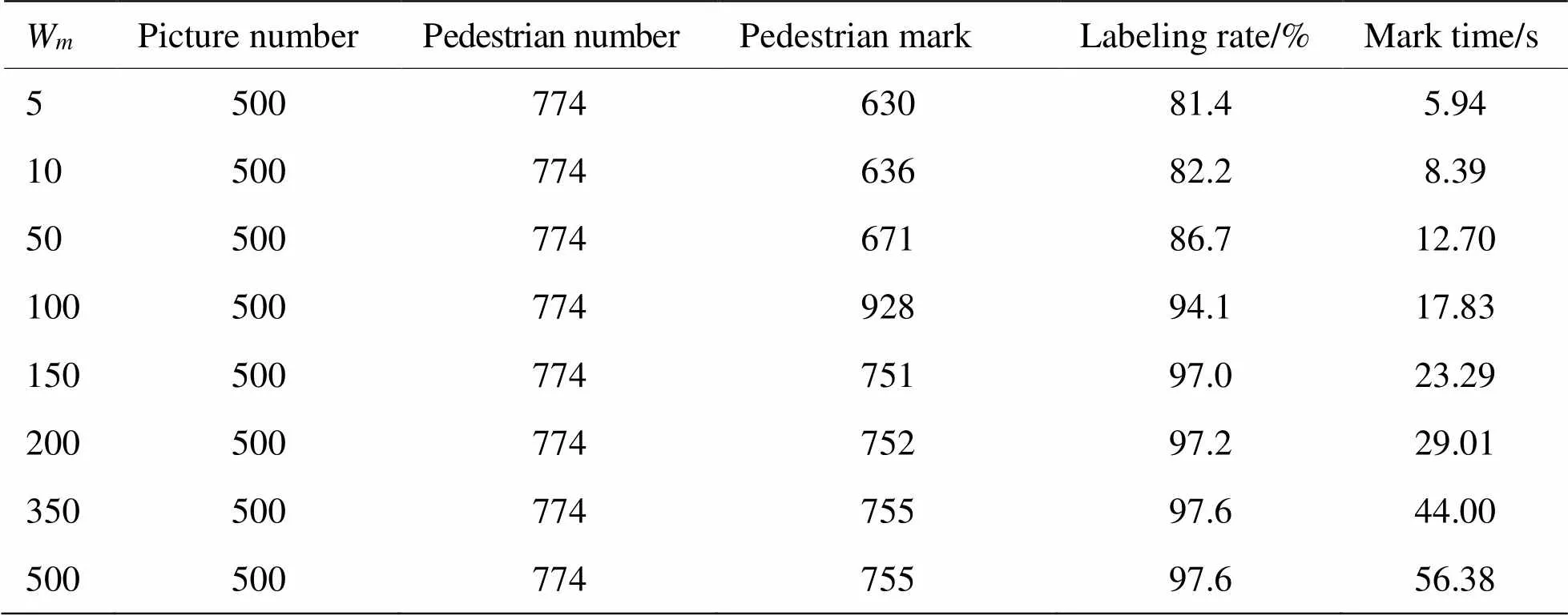

隨著W的增大,檢測結果如表4所示。

圖7 目標性檢測

表4 Wm標記結果

從表4可以看出,隨著W的增大,顯著性檢測框與真實標注框的重合度也在上升,W=150時標記率可以達到97%,隨后增速放緩但檢測時間持續增加,所以本文選擇目標性窗口數為150。

3.3.1 與基本算法的檢測效果對比

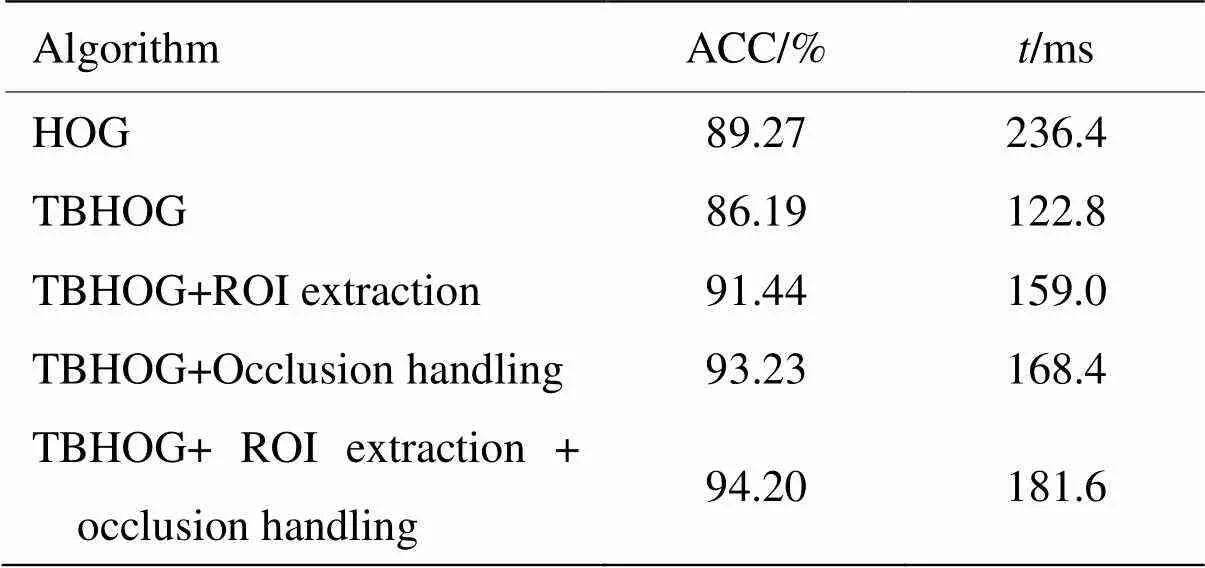

為了驗證本文算法的有效性,本文在LSI遠紅外數據集上進行了如下對比實驗,以經典的HOG特征作為基準,分別測試了二分支分類結構(TBHOG)、是否提取感興趣區域、是否采用遮擋處理算法,檢測結果如表5所示。

檢測結果表明與HOG特征相比,本文方法準確率提高了5.5%,檢測時間縮短了23.3%,可見本文方法對夜間行人識別有更好的實用性。準確率的提高主要來自于ROI提取和遮擋檢測算法,而二分支分類結構顯著降低了檢測時間。

3.3.2 與其他算法的檢測效果對比

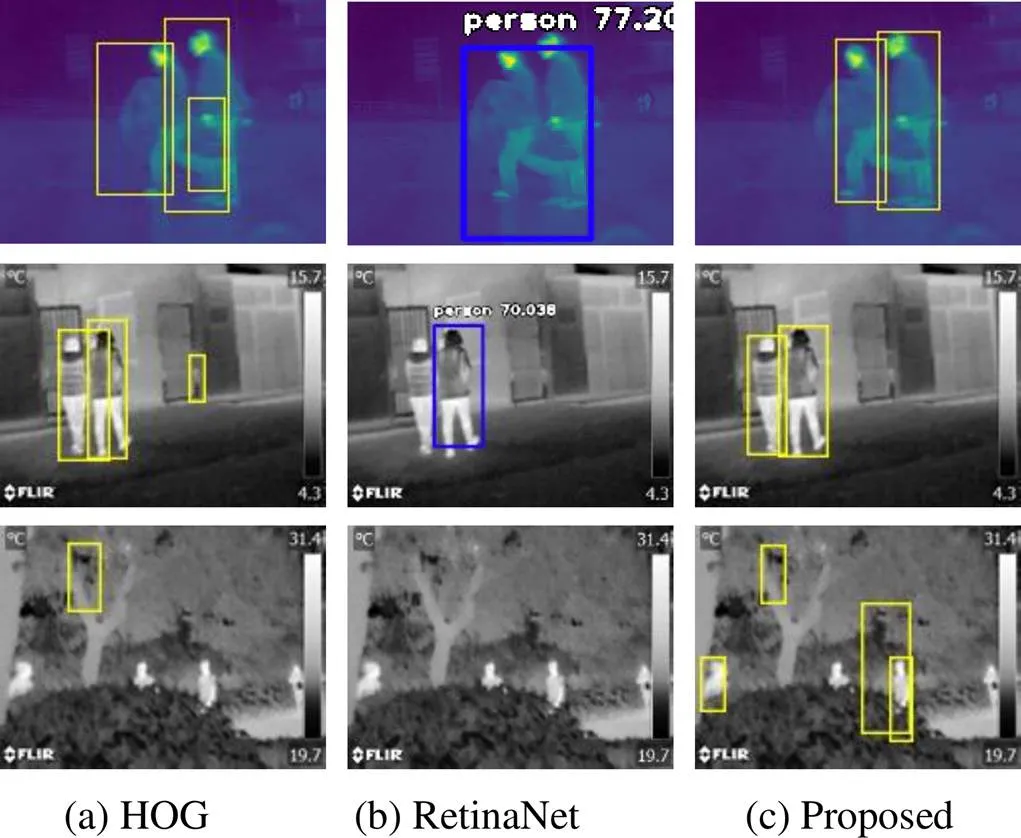

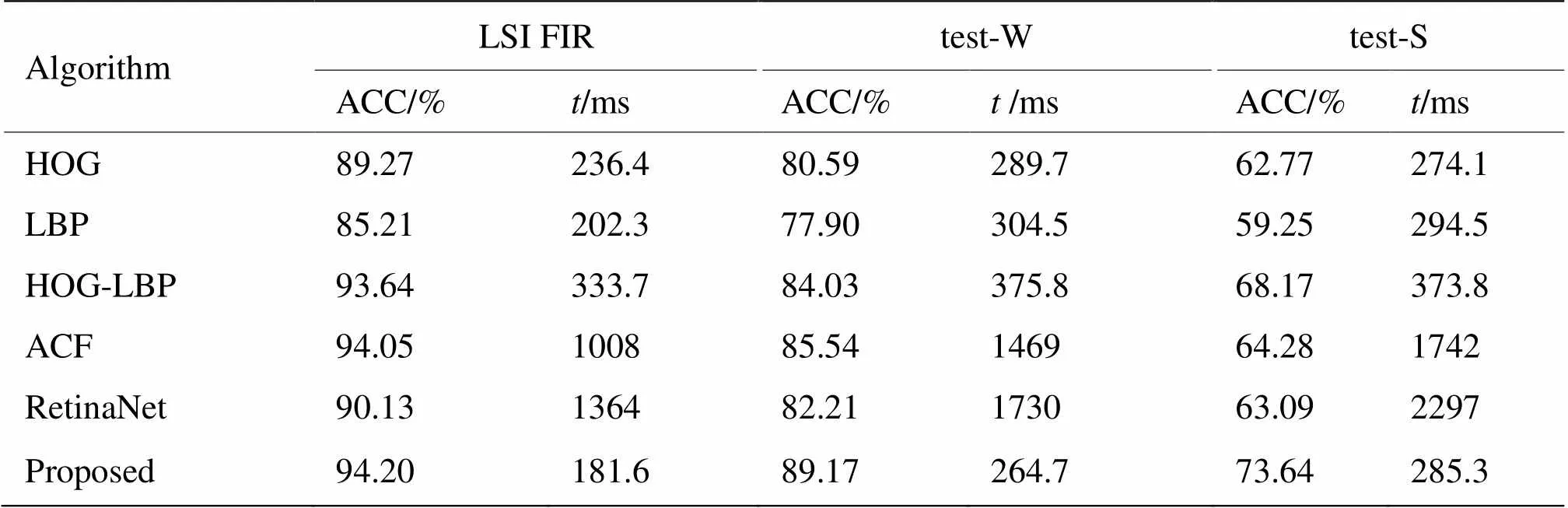

在所有數據集上將本文的檢測方法與當前主流的紅外行人檢測方法對比:HOG+SVM方法,LBP+SVM方法及融合方法,聚合通道(aggregate channel features,ACF)方法[16],基于深度學習的RetinaNet算法[17],該算法由Python的image AI庫集成,是一個開源的目標檢測項目。對比示意如圖8所示,檢測結果如表6所示。

表5 與基本算法檢測結果對比

傳統的特征提取采用滑動窗口法并利用尺度縮放策略進行檢測,計算量大且準確率取決于特征設計的合理性[18],由表6可以得到以下結論:

1)采用本文提出的算法,平均檢測率比使用單一HOG特征提高了11.1%,比使用融合特征如HOG-LBP和ACF均有所提高,說明了方法的有效性與針對性。

2)本文所提算法平均檢測速度相對于基于HOG的行人檢測算法提升了27.6%,說明了采用ROI提取及兩分支分類器結構的方法,相較于傳統尺度縮放策略能夠極大地加快檢測速度,雖然仍不能滿足實時性的要求,但相比檢測率較高的ACF和深度方法,檢測時間大幅縮短。

圖8 不同算法檢測效果對比

3)本文方法在LSI遠紅外數據集上檢測率比次好的算法提高了0.15個百分點,在Test-W數據集上比次好的算法提高了3.6個百分點,在Test-S數據集上提高了5.4個百分點,可能是因為實際道路背景復雜,對行人檢測不是很友好,行人的位置和姿態與開源數據庫差異大,本文提出的遮擋檢測算法在復雜情況下有效地降低了漏檢。

表6 與其他算法檢測效果對比

4 結論

針對夜間行人檢測背景復雜,遮擋嚴重的情況,本文在SR模型的基礎上改進了ROI提取方法,對得到的ROI構建基于改進的HOG特征的二分支分類器結構,并提出一種遮擋處理算法,性能評價表明,與標準方法相比,本方法在檢測精度和速度上均得到很大提升,為夜間復雜情況下的行人檢測提供了一種新的可能性。但算法仍無法滿足實時檢測的要求,且在行人較多的時候效果有限,下一步計劃采用特征性更強的描述子,并結合深度學習理論,嘗試解決行人的尺度不一、粘連等問題,進一步提高復雜情況下行人的檢測率。

[1] XU Z, ZHUANG J, LIU Q, et al. Nighttime FIR pedestrian detection benchmark dataset for ADAS[C]//, 2018: 323-333.

[2] TAO Y, FU D, SHU P. Pedestrian tracking for infrared image sequence based on trajectory manifold of spatio-temporal slice[J]., 2017, 76: 11021-11035.

[3] 劉洋. 基于LS-DYNA的汽車正面碰撞計算機模擬仿真[D]. 西安: 西華大學, 2011.

LIU Yang. Simulation on the Front Impact of Vehicle Based on LS-DYNA[D]. Xi’an: Xihua University, 2011.

[4] Dalal N, Triggs B. Histograms of Oriented Gradients for Human Detection[C]// 2005(CVPR'05), 2005, 1(1): 886-893.

[5] Bosch A, Zisserman A, Munoz X. Representing shape with a spatial pyramid kernel[C]//, 2007: 401-408(doi: https://doi.org/10.1145/1282280.1282340).

[6] Sangeetha D, Deepa P. A low-cost and high-performance architecture for robust human detection using histogram of edge oriented gradients[J]., 2017, 53: 106-119.

[7] ZHENG C H, PEI W J, YAN Q, et al. Pedestrian detection based on gradient and texture feature integration[J]., 2017, 228: 71-78.

[8] 朱聰聰, 項志宇. 基于梯度方向和強度直方圖的紅外行人檢測[J]. 計算機工程, 2014, 40(12): 195-198, 204.

ZHU Congcong, XIANG Zhiyu. Infrared pedestrian detection based on histograms of oriented gradients and intensity[J]., 2014, 40(12): 195-198, 204.

[9] Itti L, Koch E. A model of saliency-based visual attention for rapid scene analysis[J].., 1998, 20(11): 1254-1259

[10] Radhakrishna A, Sheila H, Francisco E, et al. Frequency-tuned salient region detection[C]//2009, 2009: (doi: 10.1109/CVPR.2009.5206596).

[11] HOU X D, ZHANG L Q. Saliency detection: aspectral residual approach[C]//2007, 2007:(doi:10.1109/CVPR.2007.383267).

[12] Alexe B, Deselaers T, Ferrari V. Measuring the objectness of image windows[J]., 2012, 34(11):2189-2202.

[13] WANG X, HAN T X, YAN S. An HOG-LBP human detector with partial occlusion handling[C]//12, 2010:(doi: 10.1109/ICCV.2009.5459207).

[14] Javier M N, Vazquez D, Lopez A M, et al. Occlusion handling via random subspace classifiers for human detection[J].Cybernetics, 2013,44(3): V342-354.

[15] Broggi A, Bertozzi M, Fascioli A, et al. Shape-based pedestrian detection[C]//, 2000: (doi: 10.1109/IVS.2000.898344).

[16] Brehar R,Vancea C, Nedevschi S. Pedestrian detection in infrared images using aggregated channel features[C]//, 2014: (doi: 10.1109/ICCP.2014.p6936964).

[17] LIN T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[J]., 2017, 99:2999-3007.

[18] 車凱, 向鄭濤, 陳宇峰, 等. 基于改進Fast R-CNN的紅外圖像行人檢測研究[J]. 紅外技術, 2018, 40(6): 578-584.

CHE Kai, XIANG Zhengtao, CHEN Yufeng, et al. Research on infrared image pedestrian detection based on improved fast R-CNN[J]., 2018, 40(6): 578-584.

Infrared Pedestrian Detection in Complex Night Scenes

ZHAO Shuang,CHENShuyue,WANGQiaoyue

(,,213164,)

An infrared pedestrian detection algorithm is proposed to solve the problem of small differencesbetween pedestrians and backgroundsin gray scale images and the occurrence of occlusion in infrared images at night.First, a significant graph with the full coverage of the target is generated by the pedestrian semantic fusion method, and the region of interest is obtained by combining it with the original graph. Then,a two-branch classifier based on the improved histogram of the gradient feature is constructed. The fuzzy score of the classifier is used to determine the occurrence of occlusion and call the head template for the final detection. Experiments based on the LSI far infrared pedestrian dataset and independent datasets of pedestrians captured at night in winter and summer prove that the proposed method is robust and quick in detecting pedestrians under different environments. It can significantly reduce the rate of missed detection and realize adetection rate of94.20%.

infrared image, pedestrian detection, saliency, complex censes, HOG feature

TP391

A

1001-8891(2021)06-0575-08

2019-07-02;

2019-11-25.

趙雙(1995-),女,碩士,主要研究方向:模式識別(行人檢測)。E-mail:zhsss1030@163.com。

陳樹越(1963-),男,教授,主要研究方向:計算機視覺、圖像處理。E-mail:csyue2000@163.com。

江蘇省研究生科研創新基金項目(KYCX19_1770)。