融入多特征的漢韓雙語自動句對齊方法

劉晨陽 唐慧豐

摘?要:為解決漢韓雙語平行語料庫資源匱乏以及傳統(tǒng)句對齊算法面向跨語系語言準(zhǔn)確率較低的問題,提出了融合特征的漢韓雙語句對齊方法。首先將Bi-LSTM融入孿生神經(jīng)網(wǎng)絡(luò)構(gòu)建句對齊模型,用以分別提取漢語和韓語句子的特征并進行對齊。之后基于語料的特點提取句對齊特征融入輸入層。通過與傳統(tǒng)Bi-LSTM和不同特征組合的孿生Bi-LSTM的對比實驗證明,融入特征的孿生Bi-LSTM方法在句對齊任務(wù)中具有更優(yōu)越的性能。

關(guān)鍵詞: 漢語-韓語;自動句對齊;孿生Bi-LSTM;多特征;平行語料庫

文章編號: 2095-2163(2021)01-0028-04 中圖分類號:TP391 文獻標(biāo)志碼:A

【Abstract】In order to solve the problem of the lack of resources in the Chinese-Korean bilingual parallel corpus and the low accuracy of traditional sentence alignment algorithms for cross-lingual languages, a method of Chinese-Korean bilingual sentence alignment with multiple-features is proposed. Firstly, Bi-LSTM is integrated into Siamese Neural Network to construct sentence alignment model, which is used to extract the features of Chinese and Korean sentences and align them. After that, sentence alignment features are extracted based on the features of corpus and integrated into the input layer. Compared with the traditional Bi-LSTM and the Siamese Bi-LSTM with different feature combinations, it is proved that the Siamese Bi-LSTM method with features has better performance in sentence alignment task.

【Key words】the Chinese-Korean; automatic sentence alignment; Siamese Bi-LSTM; multi-features; parallel corpus

0 引?言

雙語句對齊是指將語料中的雙語互譯句對進行匹配,該技術(shù)可以將篇章、段落級別對齊的語料進一步細(xì)化為句對齊語料,從而構(gòu)建高質(zhì)量的雙語平行語料庫。目前,漢韓雙語平行語料庫資源較為匱乏,構(gòu)建方式也多以人工為主,因此通過自動句對齊技術(shù)高效地構(gòu)建漢韓雙語平行語料庫,對以機器翻譯為代表的漢韓自然語言處理任務(wù)有著重大意義。

1 相關(guān)研究

研究可知,雙語句對齊的方法主要有基于長度的方法、基于詞匯的方法和基于長度與詞匯相結(jié)合的方法。對此擬展開研究論述如下。

1.1 基于長度的句對齊方法

該方法最初由Gale&Church提出,其依據(jù)是源語言與譯文文本長度具有關(guān)聯(lián)性,據(jù)此區(qū)分對齊與非對齊句對[1]。傳統(tǒng)的對齊算法多以字節(jié)、字符或詞數(shù)作為長度計量單位,此后的研究者利用其他元素計算句子長度,如張霞等人[2]將句子所含的動詞、名詞、形容詞等詞語作為句長計量單位,在英漢句對齊上取得了良好的效果。

基于長度的方法忽略了詞匯形態(tài)、詞義等信息,因此在印歐語系語言上對齊效果較好,卻不適合分屬漢藏語系和阿爾泰語系的漢語和韓語。

1.2 基于詞匯的句對齊方法

該方法利用雙語詞典和詞匯信息進行句對齊,其依據(jù)是句中的詞匯信息在一定程度上可以明確該句子的主題。Kay等人[3]基于對英德語料庫的研究提出將包含互譯詞匯最多的句對作為對齊句對。Ma[4]開發(fā)了基于詞典的句子對齊工具Champollin。

基于詞匯的方法雖然提升了句對齊的精準(zhǔn)度,但對雙語資源的要求較高,在面對跨語系、低資源的語言對齊時難度大大提升。

1.3 基于長度和詞匯相結(jié)合的句對齊方法

該方法結(jié)合兩者的優(yōu)點,在降低計算復(fù)雜度的同時提高了魯棒性。Wu[5]在基于長度的基礎(chǔ)上,利用香港議會漢英語料創(chuàng)建特殊詞表,將長度與詞匯相結(jié)合有效實現(xiàn)句對齊。

近年來,隨著機器學(xué)習(xí)與深度神經(jīng)網(wǎng)絡(luò)的發(fā)展,基于特征的分類思想被引入句對齊任務(wù)。讓子強[6]以句長比例、詞共現(xiàn)等為特征,使用最大熵與支持向量機模型實現(xiàn)漢語、老撾語句對齊;賈善崇等人[7]利用Bi-LSTM模型,使用漢語老撾語詞向量和長度特征實現(xiàn)漢老雙語句對齊;梁繼文等人[8]將對齊模式、關(guān)鍵詞互譯等特征融入神經(jīng)網(wǎng)絡(luò),完成了先秦典籍漢英句子的自動對齊。

2 韓-漢雙語句對齊模型

2.1 詞向量層

詞向量(Word Embedding)能夠?qū)⒃~轉(zhuǎn)化成一種分布式表示,即將每個詞映射到低維度的連續(xù)向量空間中,詞的分布式表示易于神經(jīng)網(wǎng)絡(luò)處理,同時可以展現(xiàn)詞間的深層語義關(guān)系。

對分詞后的漢語和韓語句子使用Word2Vec算法的CBOW(Continuous Bag-of-Words)模型計算詞向量,得到漢語句子的詞向量Vcn和韓語句子的詞向量Vkr?作為神經(jīng)網(wǎng)絡(luò)的輸入。

2.2 孿生神經(jīng)網(wǎng)絡(luò)

孿生神經(jīng)網(wǎng)絡(luò)(Siamese Neural Network, SNN)是基于2個人工神經(jīng)網(wǎng)絡(luò)建立的耦合架構(gòu)。狹義的孿生神經(jīng)網(wǎng)絡(luò)要求2個神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)相同且共享權(quán)重;廣義的孿生神經(jīng)網(wǎng)絡(luò),又稱“偽孿生神經(jīng)網(wǎng)絡(luò)(Pseudo-Siamese Network)”則可以由2種任意的神經(jīng)網(wǎng)絡(luò)組合而成,比如卷積神經(jīng)網(wǎng)絡(luò)(CNN)、循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)。孿生神經(jīng)網(wǎng)絡(luò)以2個樣本為輸入,輸出其嵌入高維空間的表征,因此在比較樣本相似度上取得了較好效果。

2.3 Bi-LSTM

長短期記憶網(wǎng)絡(luò)(Long Short-Term Memory Network, LSTM)[9]最早由Hochreiter和Schmidhuber提出,是循環(huán)神經(jīng)網(wǎng)絡(luò)(RNN)的一個變體,通過輸入、輸出和遺忘三種門控制上下文信息的選擇,有效解決了傳統(tǒng)RNN的梯度爆炸或消失問題。LSTM網(wǎng)絡(luò)的循環(huán)單元結(jié)構(gòu)如圖1所示。

輸入門it控制當(dāng)前時刻的候選狀態(tài)c~t有多少信息需要保存,其計算方式如下:

遺忘門ft控制上一個時刻的內(nèi)部狀態(tài)ct-1需要遺忘多少信息,其計算方式如下:

控制門ot控制當(dāng)前時刻的內(nèi)部狀態(tài)ct有多少狀態(tài)輸出給外部狀態(tài)ht,其計算方式如下:

LSTM網(wǎng)絡(luò)循環(huán)單元的計算過程為:首先使用上一時刻的外部狀態(tài)

ht-1和當(dāng)前時刻的輸入xt計算出3個門,之后利用遺忘門ft 和輸入門it更新記憶單元ct,最終結(jié)合輸出門ot將內(nèi)部狀態(tài)的信息傳遞給外部狀態(tài)ht。

雙向長短期記憶網(wǎng)絡(luò)(Bi-directional Long Short-Term Memory Network, Bi-LSTM)將前向LSTM與后向LSTM結(jié)合在一起,能夠從前后兩個方向?qū)π蛄羞M行訓(xùn)練,從而更好地獲取上下文信息,在長序列處理任務(wù)中效果更好。

2.4 孿生Bi-LSTM

基于長度、詞匯等傳統(tǒng)的句對齊方法在計算句子相似度時難以挖掘句子的深層特征,而傳統(tǒng)的神經(jīng)網(wǎng)絡(luò)方法將句對齊視為分類問題[10],忽略了雙語語句的內(nèi)在特征。因此結(jié)合孿生神經(jīng)網(wǎng)絡(luò)處理雙輸入樣本的特點和Bi-LSTM善于提取長序列特征的優(yōu)勢,將其作為孿生神經(jīng)網(wǎng)絡(luò)的網(wǎng)絡(luò)結(jié)構(gòu),得到孿生Bi-LSTM進行雙語句對齊任務(wù)。最終的句對齊模型如圖2所示。

模型訓(xùn)練的過程如下,將分詞過后的漢語句子Sentence_cn和韓語句子Sentence_ko,各自向量化后輸入至一組Bi-LSTM中;由該組Bi-LSTM得到各自輸入序列的特征向量h_cn和h_ko,經(jīng)融合后通過線性層映射至對齊結(jié)果。

2.5 漢-韓雙語文本分析及特征選取

2.5.1 句子長度特征FL

定義句子長度特征FL作為雙語句長關(guān)系的特征。以去除標(biāo)點后的字節(jié)數(shù)作為句長單位進行長度關(guān)系統(tǒng)計,得到句對長度分布如圖3所示。相比于未對齊句對,已對齊句對的句長具有相關(guān)性。

因此定義長度特征為:

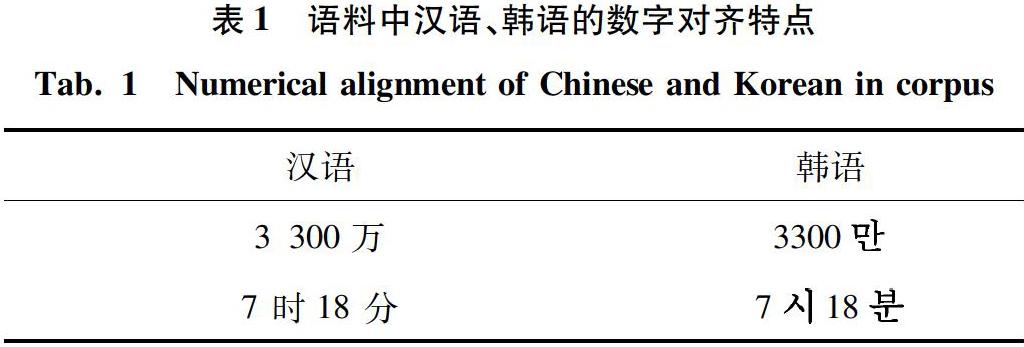

2.5.2 字對齊特征FN

定義數(shù)字對齊特征FN作為雙語句對中數(shù)字對齊的特征。數(shù)字對齊特點見表1。通過觀察發(fā)現(xiàn),語料中雙語句對中阿拉伯?dāng)?shù)字的表達方式相同,因此將存在數(shù)字對齊的句對特征設(shè)為1,不存在則設(shè)為0。

在模型的輸入層,將預(yù)訓(xùn)練的詞向量與特征向量首尾向量,形成聯(lián)合向量輸入至神經(jīng)網(wǎng)絡(luò)。

3 實驗分析

3.1 語料介紹及數(shù)據(jù)預(yù)處理

本實驗所用的數(shù)據(jù)集來自人工進行句對齊的漢-韓雙語新聞。原始數(shù)據(jù)集見表2。

實驗選取8000對句對作為總數(shù)據(jù)集,從中選取5000對對齊句對作為正例數(shù)據(jù),3000對完全打亂順序作為負(fù)例數(shù)據(jù)。實驗中訓(xùn)練集占80%,測試集占20%。在數(shù)據(jù)預(yù)處理時,將特殊符號及標(biāo)點符號進行清洗。

對漢語句子使用jieba進行分詞處理,對韓語句子使用Konlpy韓語自然語言處理庫進行分詞處理。

訓(xùn)練語料的格式為一行文本,即“漢語 韓語對齊標(biāo)志”,其中對齊標(biāo)志“1”表示對齊,“0”表示未對齊,語料的具體格式見表3。

3.2 實驗設(shè)置

實驗中各參數(shù)設(shè)置如下:batch_size=64,word_dim=128,epoch=10,優(yōu)化器選取Adam,學(xué)習(xí)率為自適應(yīng)的學(xué)習(xí)率函數(shù),其他參數(shù)為默認(rèn)參數(shù)。

模型使用準(zhǔn)確率(Precision)、召回率(Recall)以及F值(F-Score)作為評價指標(biāo)。計算公式如下:

準(zhǔn)確率=(所有預(yù)測正確的樣本/總的樣本)*100%,(5)

召回率=(將正類預(yù)測為正類/所有的正類)*100%,(6)

F值=準(zhǔn)確率*召回率*2/(準(zhǔn)確率+召回率).(7)

3.3 實驗結(jié)果與分析

實驗選取了2種模型和不同的特征組合分別進行對比,首先選取Bi-LSTM和孿生Bi-LSTM兩種模型進行對比實驗,結(jié)果見表4。

從表4中可以看出,孿生Bi-LSTM模型在準(zhǔn)確率、召回率、F值三項指標(biāo)上相比傳統(tǒng)的Bi-LSTM都有較大的提升,這是由于該模型分別提取了漢韓句子的特征而不是將其合成一個整體作為輸入。由此可以推斷孿生Bi-LSTM模型符合句對齊任務(wù)的內(nèi)在邏輯,可以取得較好的句對齊效果。

再將原始未加入特征的詞向量作為基準(zhǔn),選取孿生Bi-LSTM進行多類型特征融入的對比實驗,結(jié)果見表5。

可以看出,加入長度特征后的實驗結(jié)果有了較大提升,模型在分類準(zhǔn)確率上提升了07%,召回率上提升了85%,從而在F值上提升了42%;數(shù)字對齊特征的加入,使模型在分類準(zhǔn)確率上降低了10%,但在召回率上提升了30%,從而使F值提升了08%;在同時加入長度特征和數(shù)字特征后,模型在分類準(zhǔn)確率上提升了02%,召回率上提升了75%,從而在F值上提升了37%。

從實驗結(jié)果上看,在句對齊任務(wù)中,長度特征對模型效果有較好的正向作用,而數(shù)字對齊特征對模型效果作用較小,因此融入句子長度特征的孿生Bi-LSTM模型能夠有效提升漢韓雙語句對齊的效果。

4 結(jié)束語

本文面向漢韓雙語句對齊任務(wù),將Bi-LSTM融入孿生神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)中,同時針對漢韓雙語對齊句子的相關(guān)特征,提取句子長度特征、數(shù)字對齊特征融入輸入層,實現(xiàn)了漢韓雙語的自動句對齊。實驗結(jié)果表明,孿生Bi-LSTM在句對齊任務(wù)上的表現(xiàn)優(yōu)于傳統(tǒng)Bi-LSTM,且相關(guān)特征對于提升模型效果有正向作用。

本文仍存在一定不足。一方面,語料中對齊、非對齊雙語句對的比例關(guān)系對結(jié)果的影響有待進一步探究,可增加原始語料的類別和“完全對齊”類別的句對;另一方面,選取的雙語句對齊特征數(shù)量有待進一步擴充,可引入更多特征進行對比實驗,找出最佳特征組合。

參考文獻

[1]GALE W A, CHURCH K W ?A program for aligning sentences in bilingual corpora[J]?Computational Linguistics, 1993,19(1):75-102

[2]張霞, 昝紅英, 張恩展 漢英句子對齊長度計算方法的研究[J]?計算機工程與設(shè)計, 2009, 30(18):4356-4358

[3]KAY M, RSCHEISEN M Text-translation alignment[J]?Computational Lingus, 1993, 19(1):121-142

[4]MA Xiaoyi?Champollion: A robust parallel text sentence aligner[C]// Fifth International Conference on Language Resources & Evaluation?Genoa,Italy:dblp,2006:489-492

[5]WU Dekai?Aligning a parallel English-Chinese corpus statistically with lexical criteria[C]//Proceedings of the 32nd Annual Meeting on Association for Computational Linguistics?Stroudsburg, PA, USA:ACL, 1994:80-87

[6]讓子強 漢老雙語句子對齊方法研究[D]?昆明:昆明理工大學(xué),2017

[7]賈善崇,周蘭江,張建安,等融入多特征的漢-老雙語對齊方法[J]中國水運(下半月),2020,20(3):78-80

[8]梁繼文,江川,王東波基于多特征融合的先秦典籍漢英句子對齊研究[J]數(shù)據(jù)分析與知識發(fā)現(xiàn),2020(9):123-132

[9]HOCHREITER S, SCHMIDHUBER J ?Long short-term memory[J]?Neural Computation, 1997, 9(8):1735-1780

[10]和志強, 楊建, 羅長玲 基于BiLSTM神經(jīng)網(wǎng)絡(luò)的特征融合短文本分類算法[J]?智能計算機與應(yīng)用, 2019, 9(2):21-27