基于多任務模型的深度預測算法研究

姚 翰,殷雪峰,李 童,張肇軒,楊 鑫,尹寶才

基于多任務模型的深度預測算法研究

姚 翰,殷雪峰,李 童,張肇軒,楊 鑫,尹寶才

(大連理工大學計算機科學與技術(shù)學院,遼寧 大連 116024)

圖像的深度值預測是計算機視覺和機器人領域中的一個熱門的研究課題。深度圖的構(gòu)建是三維重建的重要前提,傳統(tǒng)方法主要依靠確定固定點深度進行人工標注或是根據(jù)相機的位置變化來進行雙目定位預測深度,但這類方法一方面費時費力,另一方面也受到相機位置、定位方式、分布概率性等因素的限制,準確率很難得到保證,從而導致預測的深度圖難以完成后續(xù)三維重建等工作。通過引入基于多任務模塊的深度學習方法,可以有效解決這一問題。針對場景圖像提出一種基于多任務模型的單目圖像深度預測網(wǎng)絡,能同時訓練學習深度預測、語義分割、表面向量估計3個任務,包括共有特征提取模塊和多任務特征融合模塊,能在提取共有特征的同時保證各個特征的獨立性,提升各個任務的結(jié)構(gòu)性的同時保證深度預測的準確性。

計算機視覺;單目深度預測;多任務模型;語義分割;表面向量估計

“近大遠小”是人們在自然界中對距離遠近把控的奧秘,大自然中的生物經(jīng)過不斷進化已形成了優(yōu)秀的視覺系統(tǒng),能輕松地識別視野中各物體與自身之間的距離,以完成各種交互任務。在計算機視覺領域,2D圖像的場景深度估計已然成為一個重點的研究方向,深度作為2.5D的因素,是連接2D圖像和3D立體模型的重要橋梁,可以說,深度是二維向三維過渡的關鍵,更是對場景結(jié)構(gòu)理解復現(xiàn)的重點,可以用于人體姿態(tài)預測、自動駕駛汽車、場景理解、3D重建和語義分割等多個方面。然而,目前的深度預測算法提取出的語義信息很難準確地反應深度信息在結(jié)構(gòu)上的信息,物體與物體、物體與背景之間的結(jié)構(gòu)性很難體現(xiàn),且易受光照、陰影影響,而與之對應的語義分割任務則會提取物體間的不同,更能反映物體間的結(jié)構(gòu)性信息。所以本文基于深度預測、語義分割、表面向量預測3個任務的共通性,設計了新的神經(jīng)網(wǎng)絡模型,提取更可靠的特征,使深度預測的結(jié)果更有結(jié)構(gòu)性。實驗表明,通過與深度預測有關的任務一同預測,可以利用兩者間相關的信息相互促進以提高效果,從而達到較好的效果。

1 國內(nèi)外研究現(xiàn)狀

1.1 單目圖像深度預測

在機器學習出現(xiàn)之前,一種是傳統(tǒng)方法,即使用人工的手工標注方法,通過對類似圖片的手工標注深度定位,再對場景提出合理的幾何假設,在概率模型的基礎上分析各部分的深度值;另一種方法則是SAXENA等[1-2]使用馬爾可夫條件隨機場(Markov random filed,MRF),將深度圖正則化,再將平面上像素通過平面系數(shù)和條件隨機場來預測對應的深度值,由于在公式中添加了約束相鄰像素的部分,使得該方法可以分析圖像中的局部特征和全局特征來推測其深度信息。

隨著深度學習方法在計算機圖形學領域的廣泛使用,LAINA等[3]基于全卷積網(wǎng)絡(fully convolutional networks,F(xiàn)CN)來進行單目深度估計,并通過加深網(wǎng)絡結(jié)構(gòu)來促進效果的提升,且FCN不限制分辨率大小,所以不需要進行圖像后處理。一方面使用不限制分辨率大小且同時優(yōu)化效率的新的Encoder-Decoder方法;另一方面使用逆Huber Loss函數(shù)進行優(yōu)化處理,可以使深度分布更合理。CAO等[4]將深度預測問題作為精細的語義分割處理。首先離散化圖像中的深度值,之后訓練一個殘差網(wǎng)絡來估計各個像素對應的分類。通過其相應的概率分布來使用條件隨機場(conditional random field,CRF)進行處理優(yōu)化。GARG等[5]首次實現(xiàn)無監(jiān)督的單目深度預測,使用立體圖像但不需要深度值數(shù)據(jù)。利用左目圖像、右目圖像和深度圖像的關系,先輸入左目RGB圖像來預測一個模糊的深度圖像,再通過深度圖像和原圖像恢復出右目圖像,計算右目圖像與真值之間的損失來優(yōu)化網(wǎng)絡。ZORAN等[6]則對圖像中的相對深度關系更感興趣,利用雙目系統(tǒng)中的點匹配關系來估計深度值,以達到無監(jiān)督或弱監(jiān)督的目的。該算法首先利用雙目圖像中點與點的對應關系,將2個預測的深度圖像進行插值優(yōu)化,以獲得更準確的深度。CASSER等[7]提出一種更有效的方法,即通過對移動目標進行建模,產(chǎn)生更高質(zhì)量的深度估計效果,另利用一種無縫的在線優(yōu)化方法,使訓練效果更好,提升預測的魯棒性,并且可在不同數(shù)據(jù)集中進行轉(zhuǎn)移。

雖然卷積神經(jīng)網(wǎng)絡(convolutional neural networks,CNN)在深度預測任務中能達到良好的效果,但還是存在一些問題,首先深度預測使用的網(wǎng)絡結(jié)構(gòu)多是用來解決語義分割問題,雖然能達到較好的準確率,但很難表達深度圖像所具有的結(jié)構(gòu)性。另外,深度圖像數(shù)據(jù)集存在的數(shù)量較少且有噪點問題也影響預測的魯棒性。

1.2 深度預測與多任務

深度預測的研究離不開語義分割的方式方法,相似的特征提取方式使得深度預測可以與語義分割等其他任務一同訓練,因此既能提取出各個任務的相同特征,又能利用各任務的相互關系來進行彼此促進,旨在執(zhí)行任務交互的特征融合或參數(shù)共享。融合或共享方式可以利用任務之間的相關信息。最近,針對此類任務的幾種聯(lián)合任務學習方法已顯示出一個有前途的方向,即通過利用與任務相關的信息相互促進來提高預測。EIGEN和FERGUS[8]提出了深度預測可以和語義分割與表面向量預測等任務一同使用一個網(wǎng)絡來進行訓練。MOUSAVIAN等[9]提出的模型將深度值預測和語義分割2個任務一同訓練,先將2個任務在第一階段一起訓練,在第二階段再使用損失函數(shù)分別收斂訓練以調(diào)整整個網(wǎng)絡形成優(yōu)化,之后將CNN與CRF結(jié)合進來,利用語義標簽和深度值的信息來優(yōu)化結(jié)果。WANG等[10]同樣結(jié)合CRF與CNN構(gòu)建模型,提出一種框架可以將深度與多種其他視覺信息結(jié)合起來,通過推導設計好的能量函數(shù),使得整個框架可以通過反向傳播進行訓練。GODARD等[11]將單一視角的深度預測、相機位姿預測、光流信息、靜態(tài)場景和移動區(qū)域的語義分割4個基本的視覺問題通過幾何關系進行約束,耦合在一起進行訓練。ZHANG等[12]將RGB圖像處理成了不同尺度的特征圖,在通過解碼器處理得到不同的深度信息和語義信息,經(jīng)過交替的特征融合來提升精度。ZHANG等[13]提出了一種“角度模式-主動傳播”(pattern-affinitive propagation,PAP)的框架,以實現(xiàn)同時預測深度、表面法線和語義分割任務,通過2種類型的傳播,能更好地使網(wǎng)絡適應不同任務之間的區(qū)別,每個任務的學習可以通過補充任務級別的能力來進行規(guī)范和增強。

目前多任務模型存在的問題主要是特征融合的方式僅是使用參數(shù)共享,并未將共有特征對任務的幫助和各任務之間的特點表現(xiàn)出來。

2 方法綜述

通過與深度預測有關的任務共同預測,可以利用兩者間相關的信息相互促進以提高效果,其根本原因是對相同的語義信息,網(wǎng)絡會給與相同的參數(shù),而共享這些參數(shù)則會使某些共有的信息更突出化,避免某一任務由于數(shù)據(jù)原因,忽略了一部分特征的提取。其中,語義分割和表面向量預測是與深度預測非常相關的2個任務,語義分割能有效地提取特征以區(qū)別不同物體,通過物體間梯度變換的特性,可以與深度預測中的物體關聯(lián),另一方面,語義分割能對不同物體進行分類,使得深度值的預測更能依賴于物體獨有的梯度變化,也更能分辨與背景相似的物體間的聯(lián)系。而表面向量對深度預測的影響更為直接,兩者之間存在著幾何關系可以互相轉(zhuǎn)換,其數(shù)學關系為

為了完成這一目的,本文將通過2個模塊進行網(wǎng)絡訓練,一個是共有特征提取模塊,負責提取各任務的特征,并可以恢復粗糙的深度圖、語義分割圖、表面向量圖;另一個模塊是多任務特征融合模塊,改模塊負責將第一個模塊提取到的特征進行多任務的融合,網(wǎng)絡模型將會區(qū)分各任務共有語義特征和各任務獨有的語義特征,使得最后恢復的圖像更具有結(jié)構(gòu)性。

圖1為整個算法的流程和2個模塊的信息,整體網(wǎng)絡的輸入為單張的RGB圖像,輸出為該圖像所對應的深度圖像、語義分割圖像、表面向量圖像。網(wǎng)絡中將共有特征提取模塊和多任務特征融合模塊整合成統(tǒng)一的結(jié)構(gòu),并在統(tǒng)一的訓練中完成端到端的生成。

圖1 基于多任務的深度預測算法流程圖

3 共有特征提取模塊

3.1 網(wǎng)絡結(jié)構(gòu)

共有特征提取模塊由單編碼器多解碼器構(gòu)成,目的是為了實現(xiàn)深度預測、語義分割、表面向量預測3個任務的共同特征提取以及第一階段的任務分化。該模塊首先通過編碼器將輸入的圖片進行編碼成一維特征,再通過3個解碼器分別解碼成3個任務所需的尺寸和通道,然后通過特征連接的方式結(jié)合各尺度的特征,最后可以將本模塊輸出的圖像與數(shù)據(jù)集中的真值圖像比較減少損失,更新網(wǎng)絡參數(shù),以保證編碼器提取的是3個任務共有的特征。

如圖2所示,本模塊使用的網(wǎng)絡結(jié)構(gòu)是以VGG-16模型搭建的FCN為主,其能很好地在像素級別對圖像進行分類,并完成語義分割的任務;在深度圖預測的問題上,表現(xiàn)也十分出色。

圖2 共有特征提取模塊結(jié)構(gòu)

本模塊包含4部分:編碼器、多維解碼器、多尺度特征融合模塊和細化模塊。其中,編碼器由4個卷積層組成,負責提取1/4,1/8,1/16和1/32多種尺度的特征。解碼器采用4個上采樣模塊,逐步擴大編碼器的最終特征,同時減少通道數(shù)量。多尺度特征融合模塊使用向上采樣和通道連接來集成自編碼器的4種不同比例特征。與編碼器相對應,將編碼器的4層輸出(每個具有16個通道)分別以×2,×4,×8和×16的形式上采樣,以便具有與最終輸出相同的大小。這種上采樣以通道連接方式完成,然后通過卷積層進一步變換以獲得具有64個通道的輸出。多尺度特征融合模塊的主要目的是將多個尺度的不同信息合并為一個,從而使編碼器的下層輸出保留了具有更精細空間分辨率的信息,有助于恢復由于多次下采樣而丟失的細節(jié)信息。最后,細化模型用于調(diào)整圖像的輸出大小以及通道數(shù),分別對應3個任務采用3個卷積層,使得輸出的通道數(shù)恢復為深度圖像的1通道,語義分割圖像的1通道和表面向量的3通道,便于進行損失的計算和反向傳播。

網(wǎng)絡輸入為320×240×3大小的RGB圖像,然后將其通過編碼器的4個卷積層得到4層特征,然后將此特征通過解碼器,解碼器由4個上采樣層組成,將不同尺度的特征進行解碼,完畢后,由多尺度融合模塊將不同尺度的上采樣輸出融合在一起,最后通過細化模塊中不同的反卷積層恢復出深度圖像、語義分割圖、表面向量圖的形狀,具體網(wǎng)絡參數(shù)及各層的輸出見表1。

表1 共有特征提取模塊網(wǎng)絡參數(shù)

3.2 訓練過程

本模塊屬于單輸入多輸出型網(wǎng)絡,在訓練的過程中,需要網(wǎng)絡根據(jù)數(shù)據(jù)集中RGB圖像與深度圖像、語義分割圖、表面向量圖與網(wǎng)絡預測的對應圖像之間建立損失函數(shù),進行網(wǎng)絡參數(shù)的更新、迭代直至損失函數(shù)收斂時,能夠得到訓練好的網(wǎng)絡。

由于需要同時處理3個任務,且保證各任務之間的相關性,所以本文的損失函數(shù)分為3個部分。特征提取損失函數(shù)為

各部分損失函數(shù)的作用和目的如下:

(1) 深度圖損失函數(shù),即

該函數(shù)為1損失函數(shù)與梯度損失函數(shù)之和,其中對于每個像素點,對應的預測深度與真實深度分別為d和D,1損失函數(shù)可以約束d與D間的不同,為該損失函數(shù)的主要部分,提供了準確率的保證。

(2) 語義分割損失函數(shù),其為交叉熵函數(shù),是語義分割問題中常用的損失函數(shù),常用于描述2個概率之間的距離,在本文中約束圖像中物體的預測語義類別的概率,其表達式為

在該模塊訓練過程中,本文通過直接在網(wǎng)絡的輸出端得到3個任務的圖像并與其對應的真值之間設計損失函數(shù),經(jīng)過梯度下降的方式進行反向傳播,從而對網(wǎng)絡的參數(shù)進行更新,當損失函數(shù)收斂時,可完成訓練。在本文算法的訓練過程中,設定迭代次數(shù)為100,每次處理圖像數(shù)量為4,初始學習率為10–4,每經(jīng)過20次迭代更新學習率為原來的十分之一,最后在經(jīng)過100次迭代后得到的收斂損失函數(shù)值為0.124 5。

4 多任務特征融合模塊

本模塊負責處理共有特征提取模塊的數(shù)據(jù),通過本模塊將共有特征更精細地進行特征融合和分化,旨在提取出各任務的具體的共同特征和分化特征,提高各任務的精度,增強各任務的結(jié)構(gòu)一致性。由于共有特征提取模塊僅僅是通過參數(shù)共享實現(xiàn)的共有特征的提取,其并不能準確的代表本文中3個任務的共通性,所以設計該模塊以保證多任務特征提取的普遍性。

4.1 網(wǎng)絡結(jié)構(gòu)

多任務特征融合模塊由2個部分組成,第一部分是多輸入特征融合模塊,負責將上一模塊輸出的多任務特征進行融合,所使用的網(wǎng)絡為密集連接的U-net;第二部分為特征解碼部分,與上一部分的解碼器部分類似,為多輸出解碼器,故不詳細介紹,本模塊的整體網(wǎng)絡結(jié)構(gòu)如圖3所示。

圖3 多任務特征融合模塊結(jié)構(gòu)

本文在原U-net網(wǎng)絡的基礎上添加了密集連接的方法,能有效地增強多輸入模式的特征提取能力,為了實現(xiàn)這種密集的連接模式,首先創(chuàng)建一個由多個流組成的編碼路徑,每個流都處理上一模塊不同的任務的圖像形式。對不同的圖像形式采用單獨的流的主要目的是分散原本會在早期融合的信息,從而限制了網(wǎng)絡捕獲模式之間復雜關系的學習能力。從網(wǎng)絡結(jié)構(gòu)中可以看出,3個任務先分別通過U-net的編碼器進行編碼,但不同點在于,在不同的卷積層傳遞時會產(chǎn)生交互,比如,任務1的圖像在經(jīng)過一次卷積池化操作之后,得到的池化特征會在任務2的二次池化特征進行結(jié)合,通過卷積層后又與任務3的池化特征結(jié)合。這樣可以使特征在任務之間流動,保證特征的共用性。在解碼器部分,將得到的共用特征先通過一個上采樣操作得到一個共有上采樣特征,再將此上采樣特征結(jié)合之前的池化特征一起進行解碼,分別將其與3種任務不同尺度的池化特征送入解碼器,并與之前的各任務提取的特征進行連接并通過上采樣層,恢復各任務原來的形狀,再將恢復的深度圖像、語義分割圖、和表面向量圖與數(shù)據(jù)集中的真值進行損失比較,以更新網(wǎng)絡中參數(shù)。本模塊網(wǎng)絡結(jié)構(gòu)參數(shù)見表2。

表2 U-net編碼器解碼器網(wǎng)絡參數(shù)

通過此種通道連接和下采樣連接結(jié)合的方式可以進一步將不同任務的特征融合,促進各任務之間的轉(zhuǎn)化,該方式與共有特征提取模塊中的共有特征不同,在保留原有特征的情況下更能體現(xiàn)不同任務之間的聯(lián)系,突出多任務特征之間的融合。

4.2 訓練過程

本模塊屬于多輸入多輸出型網(wǎng)絡,在訓練中,需要將輸出與數(shù)據(jù)庫中對應的深度圖像、語義分割圖、表面向量圖真值之間的關系建立損失函數(shù),并通過減小損失函數(shù)來更新網(wǎng)絡參數(shù),經(jīng)過迭代更新到損失函數(shù)收斂,得到訓練好的網(wǎng)絡。

在訓練網(wǎng)絡時,可以將本模塊與共有特征提取模塊統(tǒng)一訓練,以便形成一個端到端的神經(jīng)網(wǎng)絡,即輸入為單張RGB圖像,輸出為與其對應的深度圖像、語義分割圖、表面向量圖。由于3個任務與第3節(jié)相同,故采用相同的損失函數(shù)進行約束,故不詳細說明。

關于該模塊訓練的過程,本文通過直接在網(wǎng)絡的輸出端得到3個任務的圖像并與其對應的真值之間設計損失函數(shù),經(jīng)過梯度下降的方式進行反向傳播,從而對網(wǎng)絡的參數(shù)進行更新,當損失函數(shù)收斂時,可完成訓練。在本文算法的訓練過程中,設定迭代次數(shù)為100,每次處理圖像數(shù)量為4,初始學習率為10–4,每經(jīng)過20次迭代更新學習率為原來的十分之一,最后在經(jīng)過100次迭代后得到的收斂損失函數(shù)值為0.115 9。

5 實驗結(jié)果及評價

本文實驗使用的數(shù)據(jù)集,是基于NYU Depth V2數(shù)據(jù)集[14]建立的。并使用1 449組包含RGB圖像、語義分割圖像、深度圖像來完成訓練和測試,表面向量圖像由文獻[8]提出的方法將深度圖像轉(zhuǎn)換而成,并統(tǒng)一將圖像的大小轉(zhuǎn)換為320×240,與網(wǎng)絡的輸入一致。其中,795組用于訓練,654組用于測試。每組訓練圖像通過10像素的上下左右平移再獲得4組訓練集增強訓練的魯棒性,即訓練集包括3 975組RGB圖像、語義分割圖像、深度圖像和表面向量圖像,測試集為654組。

本文實驗的環(huán)境為Ubuntu操作系統(tǒng),編程語言為Python,網(wǎng)絡框架為Pytorch 1.0.0,顯卡為GTX 2080Ti,顯存為11 G。其他實驗具體參數(shù)見第3.2節(jié)和第4.2節(jié)的訓練方法。

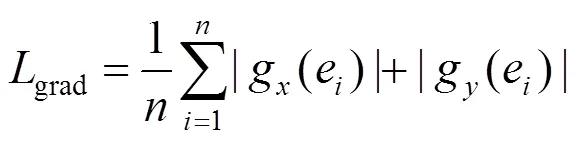

實驗數(shù)據(jù)與其他實驗的對比,首先在深度預測方面,本文從準確率和誤差率2個方面進行結(jié)果評價,本文實驗各個階段的結(jié)果見表3,其中第一項單任務表示的是按基于CNN的深度預測模型進行的預測;第二項則是按第3節(jié)中使用多任務模型中共有特征提取模塊進行深度圖像預測的結(jié)果;第三項則是按第4節(jié)中加入多任務特征融合模塊后的深度預測評價。表格中RMS(root mean squared error)表示均方根誤差,REL(average relative error)表平均相對誤差。

對于誤差評價而言,誤差率越小表面預測效果越好;反之,準確率越高說明預測結(jié)果更好,從結(jié)果中可以看出,多任務特征提取能有效地提取出共有特征,并提升深度預測的效果,而加入多任務特征融合模塊后,則更能體現(xiàn)出提取特征的共有性和獨有性,使得預測的結(jié)果更為準確,并且其他2個任務也能達到類似的提升效果。

表3 不同條件下的深度預測評價

語義分割和表面向量的預測結(jié)果見表4,其中,語義分割預測的評價標準為交并比函數(shù)(intersection over union,IoU),其是目標區(qū)域和預測區(qū)域交集和并集的比值,在本文中會將每一類別的IoU疊加,再進行平均,即均交并比函數(shù)(mean intersection over union, mean IoU),即

其中,Classes為圖像中含有的類別個數(shù)。

另外,表面向量的評價標準為均方根誤差(root mean square error,RMSE),即

從表3和表4可以看出,使用多任務模型能有效提升語義分割的準確率,降低表面向量預測的誤差,進一步證明了共有特征提取模塊和多任務特征融合模塊不僅能有效提升深度預測的能力,還可以對語義分割和表面向量預測起到積極促進作用。

表4 不同條件下的語義分割和表面向量評價

表5為相同條件下本文算法與全卷積殘差網(wǎng)絡(fully convolutional residual networks,F(xiàn)CRN)[3]和DenseDepth[15]方法在深度預測方面的對比,從表中可以看出,所列舉的方法無論在準確率上還是誤差率上都能達到一個很好的水平。

表5 相同條件下的不同方法深度預測評價

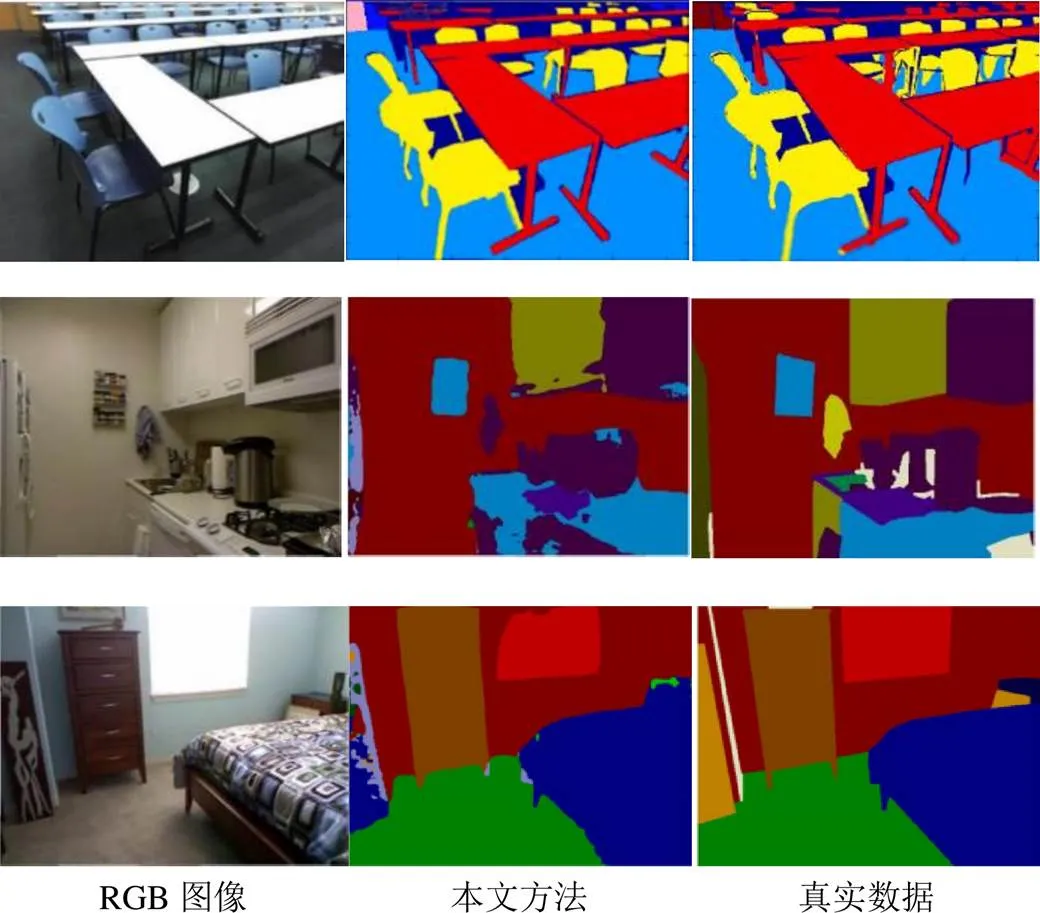

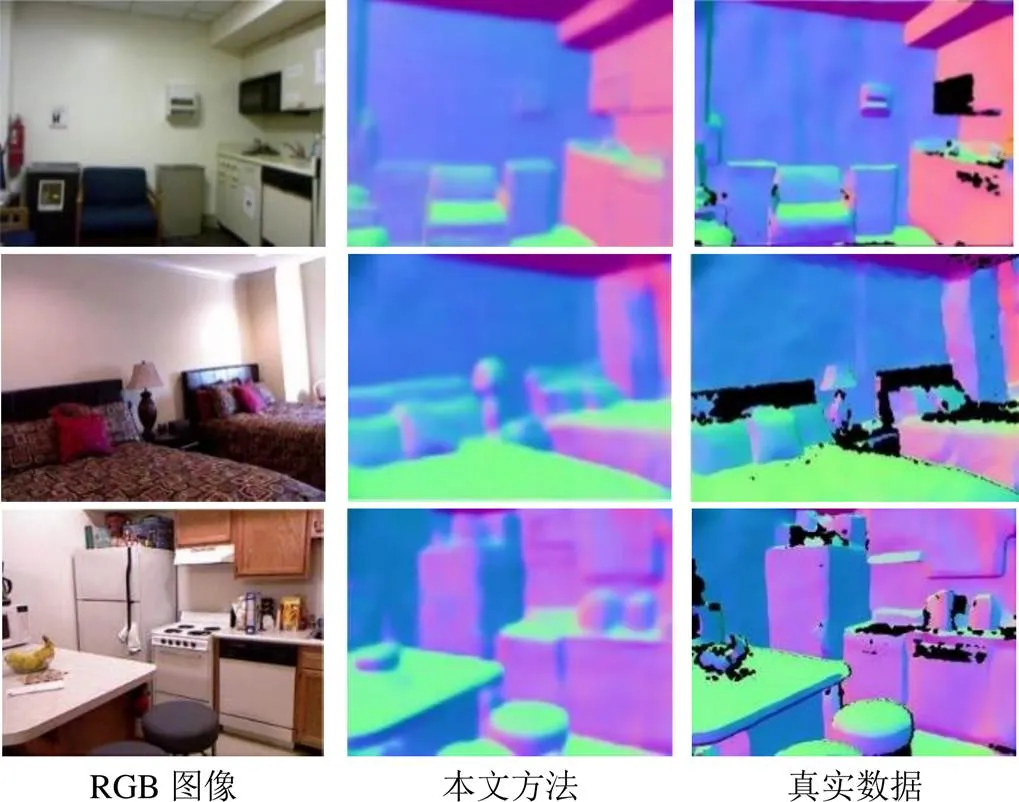

圖4~6分別為深度預測、語義分割、表面向量預測3個任務在本文實驗中的部分可視化結(jié)果,其中圖4包含了FRCN[3]方法,從可視化結(jié)果可以看出,本文算法基本達到各任務所需要求。

圖4 深度預測可視化結(jié)果

圖5 語義分割可視化結(jié)果

圖6 表面向量預測可視化結(jié)果

6 總 結(jié)

本文提出了一種基于多任務模型的單目深度預測網(wǎng)絡,通過與語義分割、表面向量預測2個任務一并訓練,利用深度預測、語義分割、表面向量預測3個任務之間的相互聯(lián)系來提升網(wǎng)絡的訓練效果。本文算法通過共有特征提取模塊共有特征來提升深度預測結(jié)構(gòu)性,再通過多任務特征融合模塊來進一步區(qū)分各任務間的特征獨特性和聯(lián)系性,使得各個任務的預測效果能夠進一步提升。實驗證明,本文算法在各個模塊的效果上均有提升,多任務特征提取和跨任務特征融合對網(wǎng)絡預測深度值提供了幫助,通過對比實驗也說明了本文算法的優(yōu)越性。

[1] SAXENA A, CHUNG S H, NG A Y. Learning depth from single monocular images[C]//The 18th International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2005: 1161-1168.

[2] SAXENA A, SUN M, NG A Y. Make3d: learning 3D scene structure from a single still image[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2008, 31(5): 824-840.

[3] LAINA I, RUPPRECHT C, BELAGIANNIS V, et al. Deeper depth prediction with fully convolutional residual networks[C]//2016 4th International Conference on 3D Vision (3DV). Washington,DC: IEEE Computer Society Press, 2016: 239-248.

[4] CAO Y, WU Z F, SHEN C H. Estimating depth from monocular images as classification using deep fully convolutional residual networks[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2018, 28(11): 3174-3182.

[5] GARG R, BG V K, CARNEIRO G, et al. Unsupervised CNN for single view depth estimation: geometry to the rescue[C]//The 14th European Conference on Computer Vision. Heidelberg: Springer, 2016: 740-756.

[6] ZORAN D, ISOLA P, KRISHNAN D, et al. Learning ordinal relationships for mid-level vision[C]//2015 IEEE International Conference on Computer Vision. Washington,DC: IEEE Computer Society, 2015: 388-396.

[7] CASSER V, PIRK S, MAHJOURIAN R, et al. Depth prediction without the sensors: leveraging structure for unsupervised learning from monocular videos[C]//The 33rd AAAI Conference on Artificial Intelligence. Palo Alto: AAAI Press, 2019: 8001-8008.

[8] EIGEN D, FERGUS R. Predicting depth, surface normals and semantic labels with a common multi-scale convolutional architecture[C]//2015 IEEE International Conference on Computer Vision. Washington,DC: IEEE Computer Society, 2015: 2650-2658.

[9] MOUSAVIAN A, PIRSIAVASH H, KO?ECKá J. Joint semantic segmentation and depth estimation with deep convolutional networks[C]//2016 4th International Conference on 3D Vision (3DV). Washington,DC: IEEE Computer Society, 2016: 611-619.

[10] WANG P, SHEN X H, RUSSELL B, et al. Surge: surface regularized geometry estimation from a single image[C]//The 30th International Conference on Neural Information Processing Systems. Cambridge: MIT Press, 2016: 172-180.

[11] GODARD C, MAC AODHA O, BROSTOW G. Digging into self-supervised monocular depth estimation[C]//2019 IEEE International Conference on Computer Vision. Washington,DC: IEEE Computer Society, 2019: 3828-3838.

[12] ZHANG Z Y, CUI Z, XU C Y, et al. Joint task-recursive learning for semantic segmentation and depth estimation[C]//The 15th European Conference on Computer Vision. Heidelberg: Springer, 2018: 235-251.

[13] ZHANG Z Y, CUI Z, XU C Y, et al. Pattern-affinitive propagation across depth, surface normal and semantic segmentation[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2019: 4106-4115.

[14] SILBERMAN N, HOIEM D, KOHLI P, et al. Indoor segmentation and support inference from rgbd images[C]//The 12th European Conference on Computer Vision. Heidelberg: Springer, 2012: 746-760.

[15] ALHASHIM I, WONKA P. High quality monocular depth estimation via transfer learning[EB/OL]. [2020-01-05]. https://arxiv.org/abs/1812.11941.

Research on depth prediction algorithm based on multi-task model

YAO Han, YIN Xue-feng, LI Tong, ZHANG Zhao-xuan, YANG Xin, YIN Bao-cai

(School of Computer Science and Technology, Dalian University of Technology, Dalian Liaoning 116024, China)

Image depth prediction is a hot research topic in the field of computer vision and robotics. The construction of depth image is an important prerequisite for 3D reconstruction. Traditional methods mainly conduct manual annotation based on the depth of a fixed point, or predict the depth based on binocular positioning according to the position of the camera. However, such methods are time-consuming and labor-intensive and restricted by factors such as camera position, positioning method, and distribution probability. As a result, the difficulty in guaranteeing high accuracy poses a challenge to subsequent tasks following the predicted depth map, such as 3D reconstruction. This problem can be effectively solved by introducing a deep learning method based on multi-task modules. For scene images, a multi-task model-based monocular-image depth-prediction network was proposed, which can simultaneously train and learn three tasks of depth prediction, semantic segmentation, and surface vector estimation. The network includes a common feature extraction module and a multi-task feature fusion module, which can ensure the independence of each feature while extracting common features, and guarantee the accuracy of depth prediction while improving the structure of each task.

computer vision; monocular depth prediction; multi-task model; semantic segmentation; surface normal estimation

TP 391

10.11996/JG.j.2095-302X.2021030446

A

2095-302X(2021)03-0446-08

2020-08-28;

2020-12-15

28 August,2020;

15 December,2020

國家自然科學基金項目(91748104,61972067,61632006,U1811463,U1908214,61751203);國家重點研發(fā)計劃項目(2018AAA0102003)

National Natural Science Foundation of China (91748104, 61172007, 61632006, U1811463, U1908214, 61751203); National Key Research and Development Program (2018AAA0102003)

姚 翰(1994-),男,遼寧沈陽人,碩士研究生。主要研究方向為數(shù)字圖像處理與三維重建。E-mail:yaohan@mail.dlut.edu.cn

YAO Han (1994-), male, master student. His main research interests cover digital image processing and 3D reconstruction. E-mail: yaohan@mail.dlut.edu.cn

楊 鑫(1984-),男,吉林四平人,教授,博士。主要研究方向為計算機圖形學與視覺。E-mail:xinyang@mail.dlut.edu.cn

YANG Xin (1984-), male, professor, Ph.D. His main research interests cover computer graphics and vision. E-mail: xinyang@mail.dlut.edu.cn