基于大數(shù)據(jù)的實(shí)驗(yàn)室局域網(wǎng)絡(luò)含噪字符識(shí)別方法研究

楊 磊

(安徽財(cái)經(jīng)大學(xué) 教務(wù)處,安徽 蚌埠 233000)

0 引言

實(shí)驗(yàn)室局域網(wǎng)含噪字符易受到環(huán)境等因素的干擾,導(dǎo)致含噪字符的識(shí)別能力較差,需要研究含噪字符圖像特征識(shí)別模型,結(jié)合模糊相關(guān)性特征檢測方法,進(jìn)行含噪字符圖像識(shí)別[1].對含噪字符圖像特征識(shí)別是建立在特征提取和模糊度分析基礎(chǔ)上,建立含噪字符圖像特征識(shí)別的統(tǒng)計(jì)分析模型,采用模糊信息融合方法,進(jìn)行含噪字符圖像局部模糊特征提取和識(shí)別[2],相關(guān)的含噪字符圖像特征識(shí)別方法研究受到人們的極大關(guān)注.

在傳統(tǒng)方法中,對含噪字符圖像局部模糊特征識(shí)別方法主要有子空間特征識(shí)別方法,模糊特征檢測方法和區(qū)域分塊信息增強(qiáng)方法等[3].文獻(xiàn)[4]提出空間欠采樣技術(shù)的含噪字符圖像特征識(shí)別方法.通過構(gòu)建實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像的空間采樣模型,結(jié)合局域網(wǎng)含噪字符特征分析方法進(jìn)行信息特征分析等.該方法有效提高特征識(shí)別能力,但該方法在進(jìn)行含噪字符圖像局部模糊特征識(shí)別時(shí)精度不高.

針對上述問題,本文提出基于模糊邊緣特征檢測和模板匹配的含噪字符圖像局部模糊特征精準(zhǔn)識(shí)別方法.

實(shí)驗(yàn)結(jié)果表明:采用本文方法可以提高含噪字符識(shí)別能力,且優(yōu)越性能顯著.

1 含噪字符圖像視覺空間采樣及特征提取

1.1 基于大數(shù)據(jù)的含噪字符圖像視覺空間采樣

為了實(shí)現(xiàn)含噪字符圖像特征識(shí)別,首先需要對含噪字符圖像視覺空間進(jìn)行采樣,本文借助大數(shù)據(jù)對其進(jìn)行采樣處理.

假設(shè)含噪字符圖像視覺空間數(shù)據(jù)為?1(i),?2(i),...,?n(i),通過公式(1)獲取含噪字符圖像視覺空間數(shù)據(jù),即:

式(1)中,?代表含噪字符圖像視覺空間基本數(shù)據(jù)量,a,b表示含噪字符圖像視覺空間數(shù)據(jù)的基本特征,A,B表示不同含噪字符圖像視覺空間數(shù)據(jù)的基本特征集合.

在上述獲取的含噪字符圖像視覺空間數(shù)據(jù)后,由于該樣本數(shù)據(jù)量較大,存在一定重復(fù)及噪聲較大的數(shù)據(jù)樣本,需要對該數(shù)據(jù)進(jìn)行有效的清洗,即:

式(2)中,?(k)代表精確的局域網(wǎng)含噪字符圖像視覺空間數(shù)據(jù),g(k)代表局域網(wǎng)含噪字符圖像視覺空間數(shù)據(jù)總集,v(k)代表干擾、重復(fù)的含噪字符圖像視覺空間數(shù)據(jù)集.

在此基礎(chǔ)上,通過構(gòu)建含噪字符圖像的三維可視化特征重建模型[5].結(jié)合含噪字符圖像的局部模糊特征采樣結(jié)果,進(jìn)行含噪字符圖像的模糊特征分析.

假設(shè)含噪字符圖像的邊緣輪廓長度為L=xmax-xmin,含噪字符圖像的分布空間區(qū)域的寬度為W=ymax-ymin,結(jié)合模糊邊緣區(qū)域重構(gòu)方法,進(jìn)行含噪字符圖像的特征重構(gòu)和識(shí)別,建立含噪字符圖像的模糊特征塊分配模型[6],得到含噪字符圖像的局部模糊空間分布像素序列為:

其中,m為含噪字符圖像的輪廓曲線分布維數(shù),p代表含噪字符圖像上的一點(diǎn).結(jié)合模糊信息融合方法,進(jìn)行含噪字符圖像的特征識(shí)別[7].基于邊緣輪廓特征檢測方法,構(gòu)建含噪字符圖像的分布式模板匹配函數(shù)為ηm(x,y)∈{-1,0,1},對含噪字符圖像進(jìn)行空間區(qū)域定位,得到圖像分量為:

其中,ψ為含噪字符圖像的局部模糊特征抽樣閾值,且0≤ψ≤1.采用向量量化檢測的方法,獲取含噪字符的量化編碼,得到特征編碼的均值為0,方差為,由此建立含噪字符的特征匹配模型,結(jié)合空間采樣技術(shù)進(jìn)行含噪字符圖像重建和識(shí)別[8].

1.2 圖像局部模糊特征提取與融合

通過模板自動(dòng)匹配和小波多尺度分解方法,檢測含噪字符圖像的局部模糊特征,建立含噪字符圖像的視空間區(qū)域融合模型[9],得到含噪字符區(qū)域分布的灰度直方圖為:

其中,c為含噪字符圖像像素分布列數(shù),r代表含噪字符圖像像素分布行數(shù),I代表局域網(wǎng)含噪字符圖像的真實(shí)灰度值.

提取局域網(wǎng)含噪字符圖像的譜特征量,根據(jù)譜特征量分布進(jìn)行局域網(wǎng)含噪字符局部模糊特征的多維重建,含噪字符軌跡模糊度函數(shù)為:

式(8)中,Δu為含噪字符圖像的全局閾值分割關(guān)聯(lián)像素點(diǎn),σ為含噪字符圖像灰度差異度特征量.

在上述含噪字符圖像灰度差異度特征量提取后,為了保證后續(xù)識(shí)別含噪字符的準(zhǔn)確度,對其特征進(jìn)行融合.將獲取的特征量通過大數(shù)據(jù)技術(shù)進(jìn)行融合.假設(shè)在特征量數(shù)據(jù)中存在多個(gè)數(shù)據(jù),其大小值基本相同,為保證特征量的均勻分布,數(shù)據(jù)融合后的結(jié)果為:

式(9)中,G(a)代表融合結(jié)果,R代表圖像局部模糊特征量,?代表數(shù)據(jù)融合介質(zhì),?代表2個(gè)特征量相鄰的概率.

在實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像區(qū)域內(nèi),提取實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像的局部關(guān)聯(lián)幀,根據(jù)上述分析,提取含噪字符圖像的局部模糊特征并對其進(jìn)行融合.

2 含噪字符圖像特征識(shí)別

2.1 含噪字符圖像局部模糊區(qū)域像素特征點(diǎn)重構(gòu)

構(gòu)建含噪字符模糊區(qū)域視覺圖像的稀疏性特征分割模型,重構(gòu)含噪字符圖像的邊緣輪廓特征分布集,采用模糊邊緣特征識(shí)別含噪字符圖像特征,得到含噪字符圖像相似度特征量,含噪字符圖像的邊緣與區(qū)域信息的變分水平集[10]為:

其中,

假設(shè)第k個(gè)含噪字符模糊區(qū)域的模糊分布特征向量為:

其中,Ic(y)為含噪字符局部模糊跟蹤像素集,Ac表示含噪字符圖像的尺度信息.根據(jù)灰度特征點(diǎn)重組,對含噪字符的圖像信息進(jìn)行融合,得到信息融合矩陣描述為:

其中,Lxy(x,σ)和Lyy(x,σ)為不同含噪字符特征匹配點(diǎn)的移動(dòng)尺度.

采用超像素特征融合方法,得到含噪字符像素特征點(diǎn)重構(gòu)輸出為:

其中,p(ωi)為含噪字符圖像的超像素大數(shù)據(jù)集分布維數(shù).

2.2 含噪字符圖像特征識(shí)別

基于GEPSO模型特征匹配方法[11],建立網(wǎng)含噪字符的模板自動(dòng)匹配模型,采用小波多尺度分解方法,進(jìn)行含噪字符圖像局部區(qū)域重構(gòu)和再檢測,分割圖像活動(dòng)輪廓并進(jìn)行優(yōu)化.將含噪字符圖像分割成M×N個(gè)2×2的子塊Gm,n,得到含噪字符圖像的匹配集為:

充分利用含噪字符圖像字符串的分布進(jìn)行特征匹配,融合圖像邊緣區(qū)域信息.采用大數(shù)據(jù)融合分析方法,進(jìn)行含噪字符識(shí)別.建立含噪字符圖像局部模糊特征檢測模型,得到特征分布函數(shù)描述為:

其中,Gnew和Gold分別是含噪字符圖像的分布向量集,進(jìn)行含噪字符圖像的視覺跟蹤和分塊匹配[12],實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像的特征識(shí)別輸出為:

其中,ejθF(k1,k2)和ejθG(k1,k2)為含噪字符跟蹤目標(biāo)域的分量,模板匹配大小為N1×N2,局域網(wǎng)含噪字符圖像的標(biāo)準(zhǔn)測試集為:

其中,‖sj‖表示sj中含噪字符圖像相似度.結(jié)合模板匹配方法,檢測和匹配含噪字符特征,建立含噪字符圖像局部模糊特征的分塊辨識(shí)模型.

3 實(shí)驗(yàn)分析

為了驗(yàn)證本文方法在實(shí)現(xiàn)實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像特征識(shí)別中的應(yīng)用性能,進(jìn)行仿真實(shí)驗(yàn)分析.

3.1 實(shí)驗(yàn)環(huán)境和參數(shù)

結(jié)合Visual C++和Matlab進(jìn)行仿真實(shí)驗(yàn),含噪字符圖像采樣數(shù)據(jù)庫來自于網(wǎng)絡(luò)數(shù)據(jù)庫DadaSet,隨機(jī)選取了5 000份實(shí)驗(yàn)數(shù)據(jù)進(jìn)行特征識(shí)別,其中,訓(xùn)練集樣本為2 000,測試集樣本為1 000份,含噪字符的分布像素強(qiáng)度為120 dB,特征采樣的時(shí)間間隔為0.46 s,樣本的幀長度為500,根據(jù)上述參數(shù)設(shè)定,進(jìn)行含噪字符的識(shí)別.

3.2 實(shí)驗(yàn)指標(biāo)

通過對比本文方法,文獻(xiàn)[3]方法和文獻(xiàn)[4]方法的含噪字符識(shí)別精度、特征匹配的準(zhǔn)確性以及識(shí)別用時(shí),驗(yàn)證本文方法的有效性.

3.3 實(shí)驗(yàn)結(jié)果分析

3.3.1 不同方法識(shí)別精度分析為了驗(yàn)證本文方法的可靠性,在相同實(shí)驗(yàn)環(huán)境下對比3種方法對實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像識(shí)別精度,對比結(jié)果如表1所示.

表1 不同方法含噪字符圖像識(shí)別精度對比Tab.1 Comparison of recognition accuracy of noisy character image by different methods

分析表1中數(shù)據(jù),可以看出,在不同的迭代次數(shù)情況下,不同方法的含噪字符圖像識(shí)別精度有所差異.當(dāng)?shù)螖?shù)為100時(shí),本文方法的識(shí)別精度為93.4%,文獻(xiàn)[3]方法的識(shí)別精度為84.3%,文獻(xiàn)[4]方識(shí)別精度為85.6%;當(dāng)?shù)螖?shù)為300時(shí),本文方法的識(shí)別精度為98.5%,文獻(xiàn)[3]方法的識(shí)別精度為93.6%,文獻(xiàn)[4]方法識(shí)別精度為96.5%;可以看出本文方法的最高識(shí)別精度可達(dá)98.6%,文獻(xiàn)[3]方法的識(shí)別精度最高為94.3%,文獻(xiàn)[4]方法識(shí)別精度最高為96.5%,本文方法的識(shí)別精度高于其他2種方法.這是由于本文方法采用大數(shù)據(jù)融合分析方法,建立含噪字符圖像局部模糊特征檢測模型等,對含噪字符進(jìn)行識(shí)別,進(jìn)而提高了本文方法的識(shí)別精度,證明本文方法具有一定的可靠性.

3.3.2 不同方法含噪字符圖像識(shí)別效果分析為了驗(yàn)證本文方法在含噪字符圖像識(shí)別效果的優(yōu)勢,采用3種方法對含噪字符圖像進(jìn)行識(shí)別用時(shí)的對比,實(shí)驗(yàn)結(jié)果如圖1所示.

圖1 不同方法特征匹配準(zhǔn)確度對比Fig.1 Comparison of feature matching accuracy by different methods

分析圖1可以看出,采用3種方法進(jìn)行含噪字符圖像特征匹配的準(zhǔn)確度有所差異.隨著匹配次數(shù)的增加,3種方法的匹配準(zhǔn)確度也隨之提高.當(dāng)匹配次數(shù)為4時(shí),本文方法的準(zhǔn)確度約為87%,文獻(xiàn)[3]方法的準(zhǔn)確度約為72%,文獻(xiàn)[4]方法的準(zhǔn)確度約為65%;當(dāng)匹配次數(shù)為10時(shí),本文方法的準(zhǔn)確度約為98%,文獻(xiàn)[3]方法的準(zhǔn)確度約為90%,文獻(xiàn)[4]方法的準(zhǔn)確度約為85%.可以看出本文方法在進(jìn)行含噪字符圖像特征匹配的準(zhǔn)確度最高,這是由于本文方法對含噪字符圖像字符串的分布進(jìn)行特征匹配,融合圖像邊緣區(qū)域信息等,實(shí)現(xiàn)了含噪字符圖像的特征匹配,從而提高了本文方法的特征匹配能力.

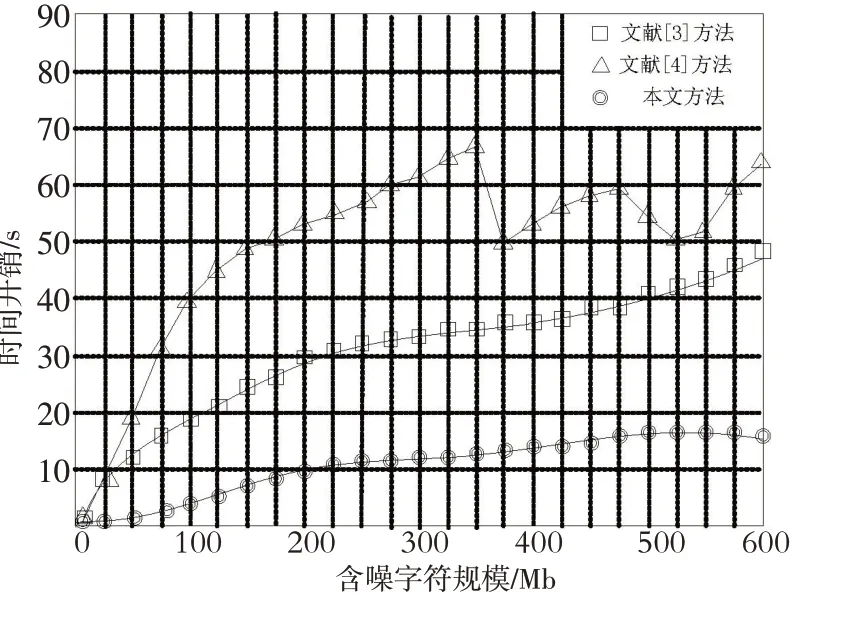

3.3.3 不同方法識(shí)別用時(shí)分析為了驗(yàn)證本文所提方法的可行性,實(shí)驗(yàn)對比3種方法在含噪字符圖像識(shí)別的用時(shí),實(shí)驗(yàn)結(jié)果如圖2所示.

圖2 不同方法含噪字符識(shí)別用時(shí)對比Fig.2 Time comparison of noisy character reagnition by different methods

分析圖2可以看出,在相同的含噪字符規(guī)模下,3種方法的識(shí)別用時(shí)不相同.其中,本文方法的識(shí)別用時(shí)較低,其次為文獻(xiàn)[3]方法和文獻(xiàn)[4]方法.本文方法的識(shí)別用時(shí)最大約為18 s,文獻(xiàn)[3]方法的識(shí)別用時(shí)最大約為50 s;文獻(xiàn)[4]方法的識(shí)別用時(shí)最大約為69 s.這是由于所提方法對含噪字符圖像局部模糊區(qū)域像素特征點(diǎn)進(jìn)行重構(gòu),構(gòu)建含噪字符圖像特征識(shí)別模型,通過識(shí)別模型直接對其進(jìn)行識(shí)別,進(jìn)而縮短了識(shí)別的用時(shí),驗(yàn)證了本文方法的工作效率較高,具有一定的可行性.

4 結(jié)束語

本文提出的基于大數(shù)據(jù)的實(shí)驗(yàn)室局域網(wǎng)含噪字符識(shí)別方法研究,通過分析實(shí)驗(yàn)室局域網(wǎng)含噪字符圖像的特征,將此特征進(jìn)行重建、提取等,實(shí)現(xiàn)了基于大數(shù)據(jù)的含噪字符的識(shí)別.實(shí)驗(yàn)結(jié)果表明,采用本文多提方法對含噪字符進(jìn)行識(shí)別的精度較高,特征匹配的準(zhǔn)確度最高可達(dá)98%,在識(shí)別過程中識(shí)別用時(shí)均小于20 s,在現(xiàn)實(shí)的應(yīng)用中具有一定意義.