基于Faster R-CNN和U-net改進的 混合模型絕緣子故障檢測

胡 祥,李英娜

(1.昆明理工大學 信息工程與自動化學院,云南 昆明 650500;2.云南電網有限責任公司研究生工作站,云南 昆明 650217)

0 引 言

絕緣子廣泛用于高壓輸電線路中,并在電絕緣和導體結合方面發揮重要作用。絕緣子故障(如玻璃絕緣子自爆)會對電力系統構成嚴重威脅,因為它可能會導致級聯故障。在極高電壓條件下定期手動啟動絕緣子存在很大的安全風險。然而,傳輸線上部署有數千個絕緣子,這些絕緣子通常距離較遠且海拔較高。常見的絕緣子安裝方法是捕獲航拍圖像,由直升機或無人飛行器(Unmanned Aerial Vehicle,UAV)安裝絕緣子。隨著技術的進步,巨大的航拍圖越來越容易獲得,因此迫切需要一種精確、實時的絕緣子定位方法。一般來說,絕緣子定位存在以下影響因素:一是復雜的背景,航空影像的背景通常包括森林,河流,農田等各種場景;二是動態視圖更改,有時相機可能無法對焦;三是低信噪比(Signal-Noise Ratio,SNR),與整個圖像相比,相當多的像素包含損壞的絕緣體信息,在某些極端情況下,很難通過人眼識別來定位折斷位置。

傳統的絕緣子識別方法有利用目標顏色特征進行閾值分割的識別法[1]和基于輪廓特征的定位方法[2]等。但上述方法要求人工提取目標特征,且根據目標場景差異設計有區分度的特征,防止由于主觀因素的干擾出現漏檢和誤檢等情形,識別準確率相對不高。

與傳統方法相比,深度學習在計算機視覺方面大放異彩,在過去十年中取得了矚目的成績。Hinton等人提出的關于AlexNet[3]的建議再一次把深度學習的浪潮推到了頂端。隨著新網絡架構(如VGG[4])的發明,InceptionNet[5]和ResNet[6]深度學習在各個級別的圖像分類比賽中的效果遠超過傳統方法。Ren等人提出的Faster R-CNN[7]方法能夠完成端到端的高效訓練且實時獲取目標檢測數據。文獻[8]利用Faster R-CNN框架對絕緣子進行識別,在定位方面取得了較傳統方法稍好的識別效果,但在小物體檢測和速度方面效果一般。此外,全卷積網絡(Fully Convolutional Network,FCN)由文獻[9]產生的像素到像素分割精度十分優秀,改善且革新了以前語義分割中的最佳結果。最近,在絕緣子檢測和狀態分類方面,國內外已經進行了很多工作。卷積神經網絡(Convolutional Neural Network,CNN)能夠從圖像中自動提取表達能力更強的特征[10],減少識別時間,提高分類和識別的準確率,文獻[11]在絕緣子定位中引入了CNN。文獻[12]在R-FCN模型的基礎上引入ASDN層,將絕緣子識別的平均準確率由77.27%提升至84.29%;張文秀等人運用U-net[13]在細胞分割中得到了良好的效果,帶來了小目標檢測的新思路。但在U-net識別過程中,由于圖像背景復雜,噪聲點多,許多干擾因素在圖片中的面積占比大于等于絕緣子和其故障位置的面積占比,容易受到干擾,造成錯誤識別,影響結果,導致識別準確率不夠理想。要檢測出比絕緣子圖像還要小很多的缺陷故障位置更是不現實的。

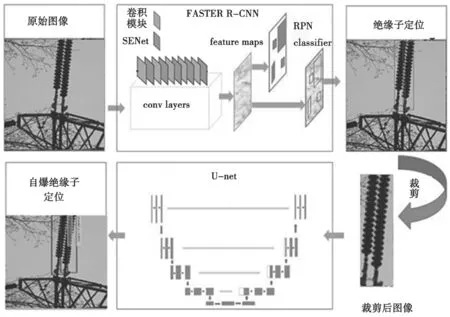

針對以上問題,本文采用注意力機制與Faster R-CNN相結合識別出絕緣子,之后通過U-net定位絕緣子故障的模型。首先,在Faster R-CNN網絡的特征提取階段引入Hu等[14]提出的基于注意力機制的SENet結構,使網絡能夠自動學習到每個特征通道的重要程度,關注與目標相關的特征通道而抑制與目標不相關的特征通道,提升網絡性能;其次,在RPN生成anchor階段,根據絕緣子的特點,改進基礎anchor的比例和尺度;再次,結合注意力機制計算候選框之間相互依賴關系的權重,融合周圍候選框的特征向量來更新每一個目標建議框的特征向量,使目標建議框的特征向量包含更準確的位置信息,促進識別準確率的提升,進一步提高絕緣子識別精度,裁剪出來的圖像提高了絕緣子和其爆裂位置在圖像中的占比,降低了U-net的運用難度;最后,將裁剪后的圖像作為U-net的輸入,并將像素二進制分類結果作為輸出,對于損壞的部分,將像素標記為false,對于正常的部分將像素標 記為true。

1 相關技術介紹

1.1 SENet結構

SENet網絡的設計基礎為注意力機制,兼具簡單和效果理想等優勢。其關鍵功能在于拓寬特征提取層的感受野,進而增進卷積神經網絡性能。它使用全局信息來有選擇地強調信息功能,同時壓制不太有用的功能,將權重引入圖層的每個要素圖。

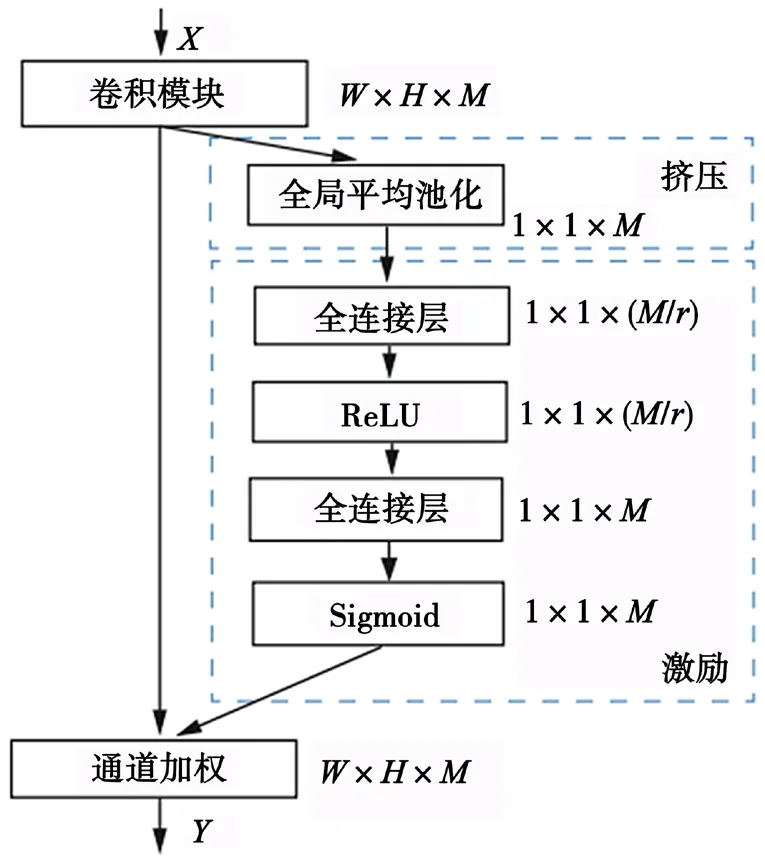

以下是SENet結構5個連續操作的綜合功能:全局平均池化(Global Average Pooling,GAP)的作用是將輸入的特征圖按全局平均進行歸并,將M個W×H大小的特征圖抽取為M個1×1實數序列,目的是使其他特征圖的上下文信息都能被每個特征圖利用,因此,可以為規模較小的低層次網絡提供全局信息;之后在兩個全連接層中得出一個有效的數字,降低維度,得到矢量1×1×(M/r),使用ReLU后提高維度,通過使用Sigmoid活化函數獲得一個向量1×1×M,以獲得相當于每個通道的權重,各通道分別與對應的權重系數相乘,進而獲得更新后的通道。由于具有FC和池化操作等額外的層,因此參數和計算負載的數量略有增加。這種“Squeeze-and-Excitation”(SE)網絡的獨特結構如圖1所示,X、Y分別指輸入特征圖及更新后輸出的特征圖。在SENet結構中,注意力機制的兩大核心操作是擠壓和激勵,同時引入了以輸入為條件的固有動態特性,以增強功能的可分辨性,可以與任何標準體系結構如Faster R-CNN、DenseNet及多輸入網絡等一起使用。

圖1 基于注意力機制的SENet結構

1.2 Faster R-CNN模型

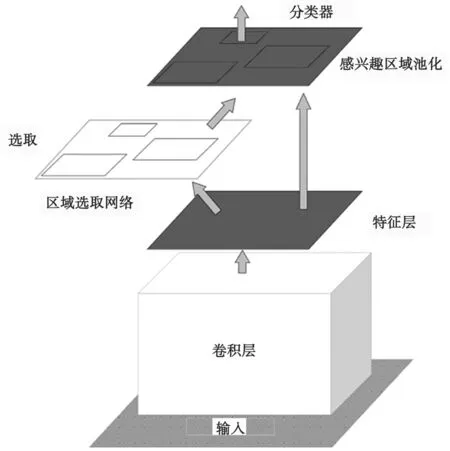

Faster R-CNN由兩部分構成:RPN屬于完全卷積網絡,其用途以生成建議區域為主,Faster R-CNN則對建議區域起到檢測和分類的作用。Faster R-CNN模型架構如圖2所示。

圖2 Faster R-CNN結構圖

如圖2所示,通過在ImageNet上預先訓練的常用CNN模型(如Resnet和VGG)提取航拍圖像的有效和豐富特征,預訓練的卷積層由RPN和Faster R-CNN共享。RPN處于模型核心位置,其目標是識別所有可能的候選框,使用連接到最后一個共享卷積層的內核3*3卷積來生成256通道的特征圖,在特征圖中實現滑動窗口方法,且256維特征向量都被每個特征圖獲得。在每個滑動窗口中,來自該區域的建議被同時規劃。該建議被參數化,與一個稱為“錨定點”的參考框相關,分別使用3類規格和刻度不等的參數值以提高精度。由Fast R-CNN網絡檢測RPN生成的建議區域,將特征圖重構為一個大尺寸的資源向量,要素層完全連接到另一個相同長度的要素層,且提供邊界框平移和縮放參數,候選框填制不同類別概率值。

1.3 U-net模型

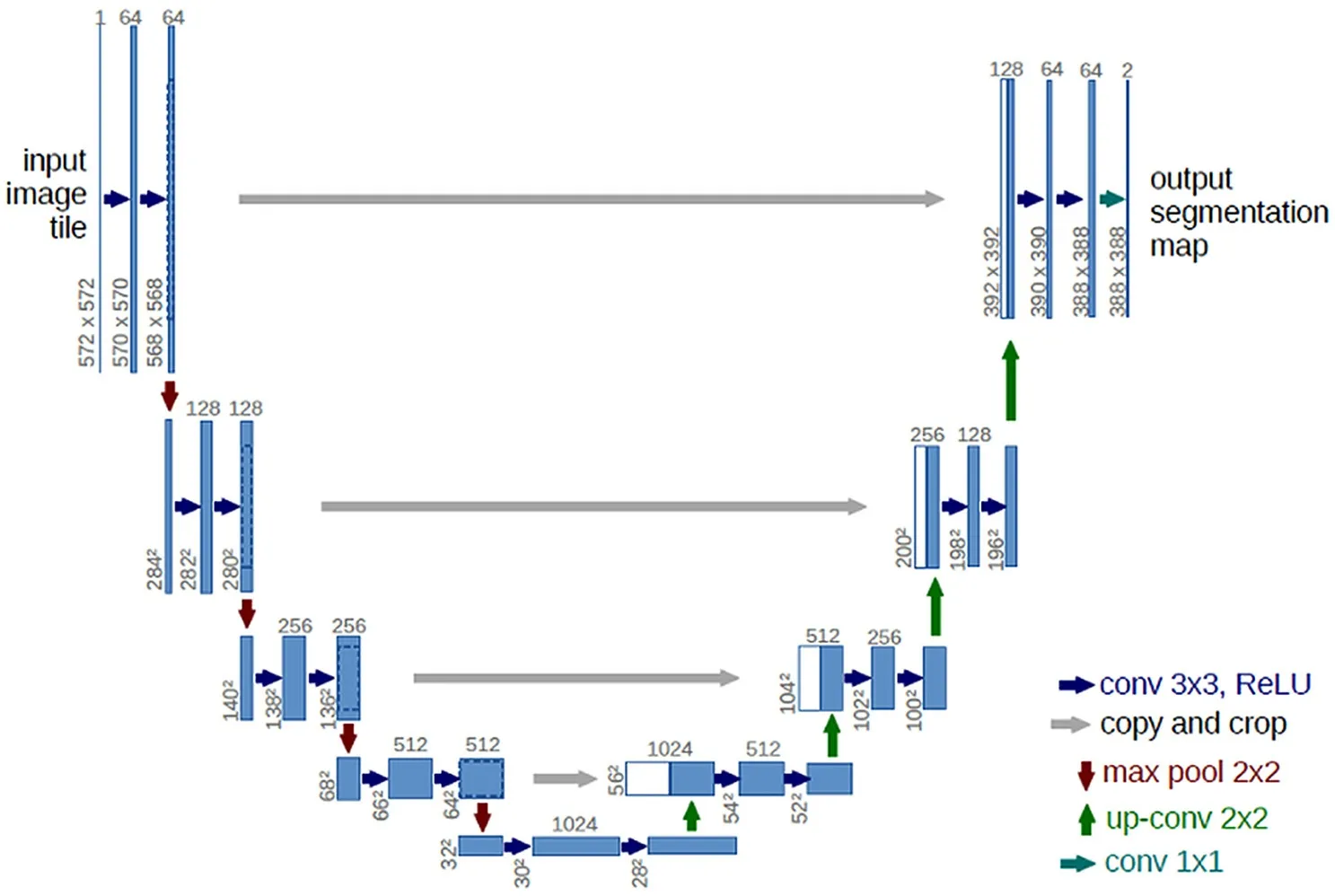

U-net是一種FCN架構。FCN包含上采樣和跳過層兩個核心操作。FCN采用上采樣以確保輸出與輸入圖像具有相同的大小。但是,通過直接上采樣獲得的特征圖通常會導致非常粗糙的分割結果。故跳過層的功能設計在于克服前述弊端。跳過層方法對不同池化層的輸出進行上采樣,并通過特征融合(如復制和裁剪)細化結果。

U-net結構如圖3所示,其形狀與U形相近。需要注意的是,U-net的輸入可以是任意大小的圖像,例如圖中的572×572。U-net由壓縮和恢復層組成,壓縮層是經典的VGGNet-16。重復運用兩個3×3卷積內核和2×2最大池化層的結構,并利用池化層的向下采樣效果逐層提取更多高級特征。恢復層的結構與VGGNet-16完全不同,由2×2反卷積核與兩個3×3卷積核重復疊加獲得,并由1×1卷積核實現特征圖的維映射,依照softmax函數作輸出層分類。需要注意是,池化層的輸入必須是寬度和高度十分均勻的要素圖,因此需要仔細設置超參數。

圖3 U-net網絡結構圖

2 改進的基于Faster R-CNN和U-net的絕緣子故障識別框架

本文提出的方法總體流程如圖4所示。

圖4 提出方法總體流程圖

2.1 引入SENet結構的特征提取網絡

原始絕緣子圖像依次進行尺寸放縮,VGG16特征提取,并獲得網絡提取特征。為了使特征提取網絡能夠使用全局信息,不局限于局部感受野,本文在特征提取網絡VGG16的5個卷積模塊之后引入SENet結構。權重和加權更新通道的生成,契合特征通道維度壓縮特征,由此保證特征圖的繪制更具表達能力。實驗結果顯示,采用該結構后,網絡識別能力有所提高。

2.2 改進區域建議網絡

將得到的特征圖輸入RPN,在特征圖上滑動窗口遍歷每個點,每個點上生成不同長寬比例(一般設置為1∶2、1∶1、2∶1,用于識別公共數據集中的大多數目標)和尺度的錨框。在以往的Faster R-CNN算法中錨框的比例設置并不適用于識別絕緣子,絕緣子偏窄長,并且跟拍攝角度關系很大,需要對生成基礎錨框的長寬比進行改進。從RPN生成基礎錨框的原理出發,對絕緣子圖像數據中絕緣子長寬比進行統計,其中絕緣子的長寬比范圍按數量依次排序為(4∶1、5∶1、6∶1),在此基礎之上,調整生成基礎錨框的比例,同時,為更好地識別出尺寸較小的或者拍攝距離較遠的絕緣子,調整尺度為(642、1 282、2 562),特征圖上每個點生成12種錨框,總共生成W×H×12個錨框。

2.3 基于注意力機制的建議框融合

將RPN獲得的目標建議框與對應的特征圖一一映射,而后依照ROI池化操作步驟,將各目標建議框在特征圖上的映射區域的大小設置為7×7,輸入對象為全連接層1。

考慮到RPN獲得的目標建議框定位不夠精準,對后續分類和定位的準確度造成了不可小視的影響,此外,相比較而言,周圍建議框含有更多豐富有用的位置信息,因此對目標建議框的設定較具矯正意義。然而,周圍建議框對于校正的絕緣子目標建議框的重要性不盡一致,而本文研究的基礎在于注意力機制,因此周圍建議框的選定要求與目標建議框的IOU值應高于等于閾值T,訓練學習各周圍建議框的重要程度(權重系數aij),且引入加權求和的方式完成融合,使絕緣子目標建議框的特征向量FV=[fv1,fv2,…,fvi]獲得更新,進而提供更為精準的向量位置信息,體現精確分類與位置回歸的意義,同時對模型識別精度提升具備不容忽視的重要價值。

3 輸出識別結果

涉及到全連接層2輸出的特征向量,引入Softmax分類器對各目標建議框加以運算,分類設定為絕緣子的置信度分數,且分別做邊界框回歸,據此獲得與真實框相對應的偏移量預測值,完成目標建議框的修正,使其定位信息更趨精確,識別獲得高置信度分數的目標建議框。圖像編輯后用作U-net輸入,在像素二進制基礎上輸出分類結果,其中正常及損壞部分的像素分別標記為true和false。

4 實驗結果與分析

4.1 實驗環境配置

本文實驗使用的操作系統為Windows 10,處理器為Intel(R) Core(TM) i5-10400F CPU 2.90 GHz, 32 GB RAM,GPU選用NVIDIA GeForce GTX 1080Ti 顯存為8 GB,深度學習框架為Pytorch 1.4。評價指標為AP。

4.2 數據集及實驗參數

數據集整理自某電網公司電力科學研究院無人機航拍的絕緣子圖像數據。采集所得復合絕緣子圖像共計840張,圖像尺寸參數為576×432像素,以圖像編輯軟件沿順逆時針方向旋轉180°、60°以及放縮等方式將圖像集增加至2 000張。實驗過程中,對絕緣子數據按照Labelme數據集格式進行標注,并隨機劃分訓練集為1 600張,測試集為 400張。

4.3 絕緣子串定位

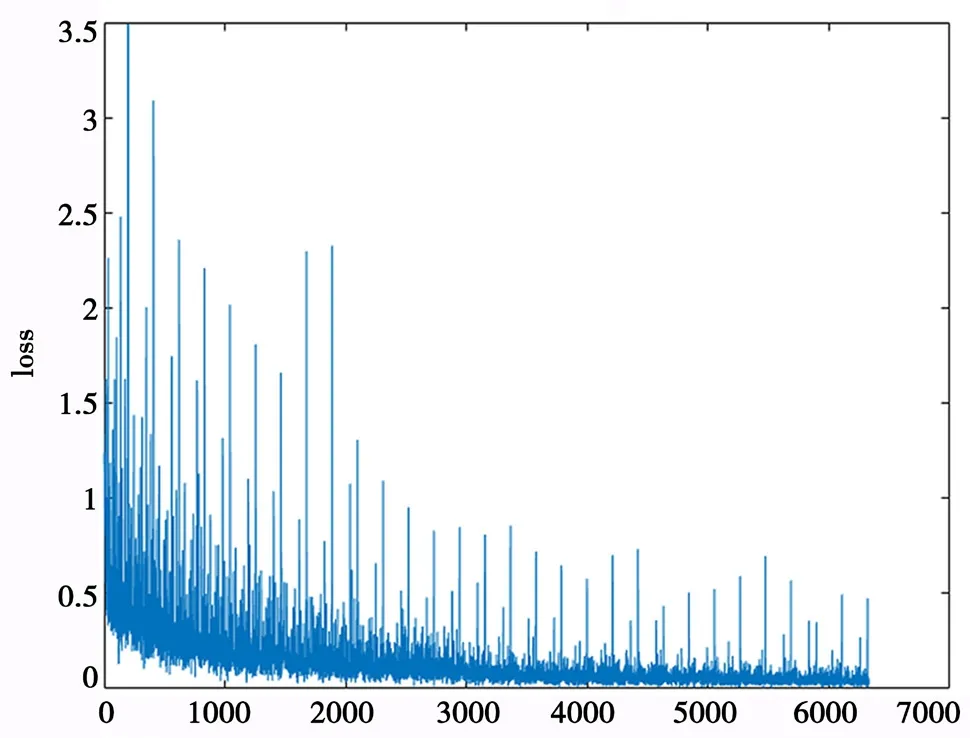

Faster R-CNN在玻璃絕緣子串定位中發揮有重要作用。引入動量法完成Faster R-CNN的訓練。訓練損失如圖5所示。該定位方法的平均精度為0.921,對于在復雜場景下檢測玻璃絕緣子串非常 有效。

圖5 Faster R-CNN損失函數訓練圖

4.4 自爆式絕緣子串故障定位

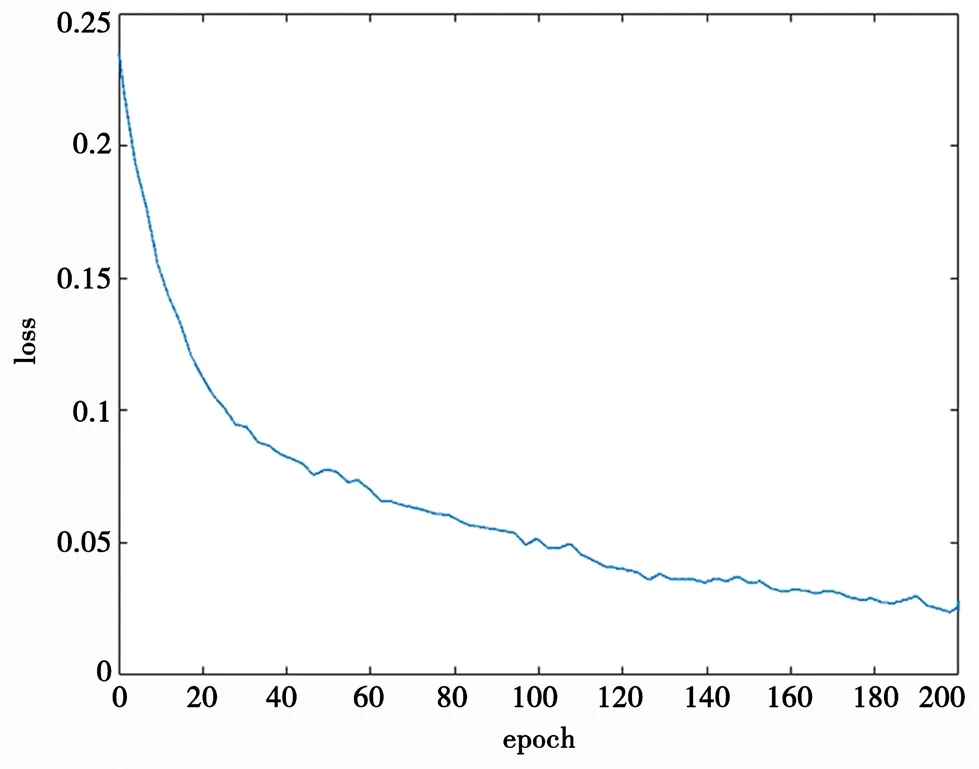

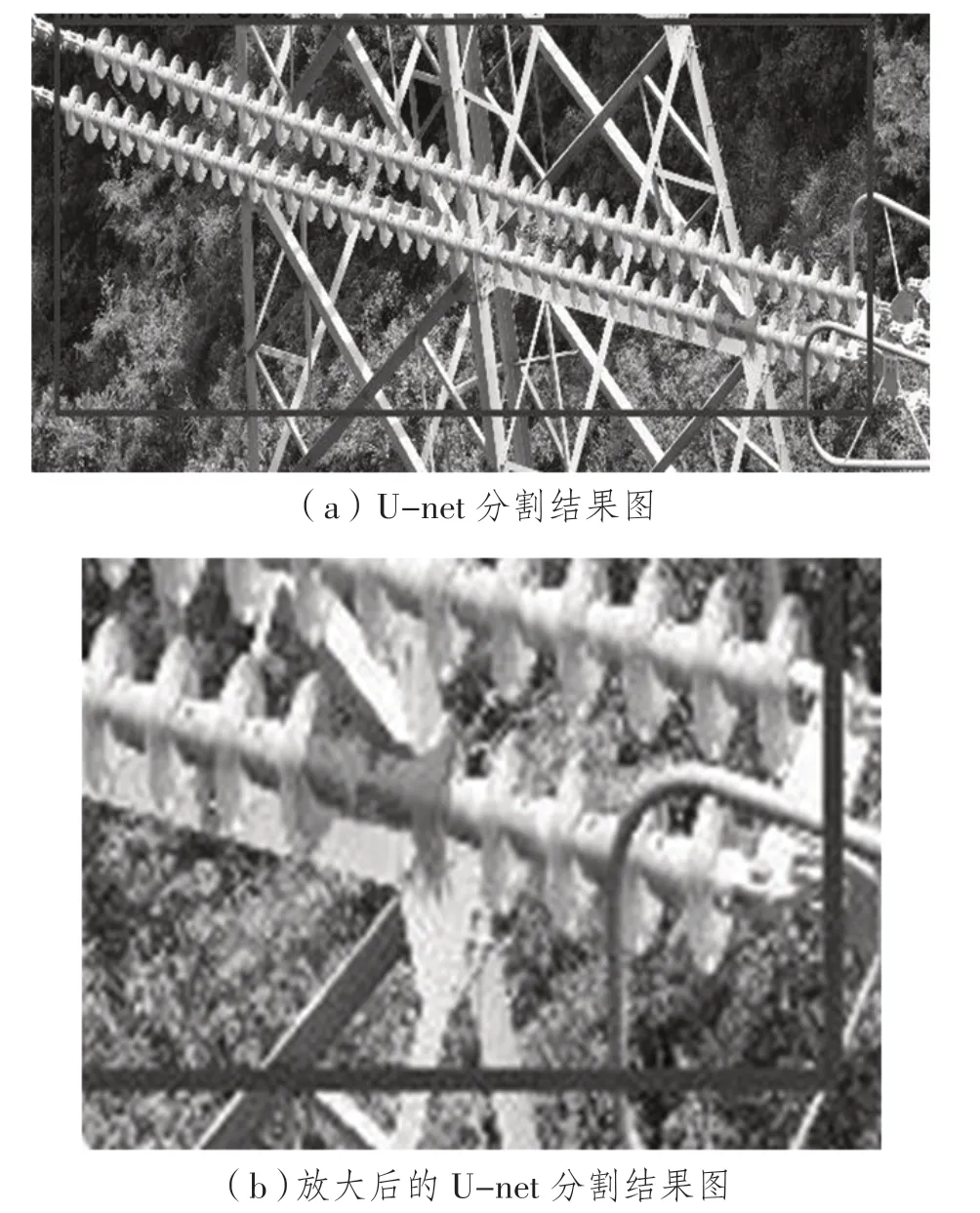

以邊界框裁剪圖像作為U-net的輸入,實驗選定的架構如圖4所示。需要注意的是,要在卷積層之后添加批歸一化層,以避免消失梯度問題并加速深度網絡訓練。實驗選取的優化算法Adam將相關參數E、β1、β2依次設定為0.000 000 01、0.9、0.999,批處理大小設置為1,初始學習率設置為0.001,按照線性方式減小,也就是隨著訓練周期的增大而依次降低。數據增強方法使用旋轉和翻轉等辦法。訓練周期80輪后的損失收斂如圖6所示。依照背景差異獲得4類結果,如圖7所示。故障位置被標出,如圖8所示。平均精度值為0.919,而圖像獲取所耗費的U-net時間成本則基本能夠忽略。

圖6 U-net損失函數訓練圖

圖7 不同背景下的Faster R-CNN定位結果

圖8 U-net輸出結果

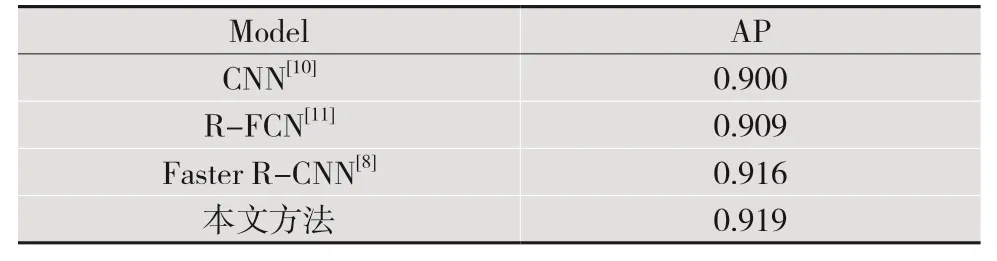

不同方法的識別結果對比如表1所示,可以看出,以AP作為評價指標,和文獻[8]、文獻[10]及文獻[11]的方法相比,本文方法比文獻[10]的CNN高出0.019,比文獻[11]的R-FCN高出了0.01,比文獻[8]的Faster R-CNN高出0.003。對于絕緣子故障位置識別的平均準確率,本文研究方法更具優勢。

表1 不同方法識別結果

5 結 語

本文介紹了SENet+Faster R-CNN+U-net的模型,使用某電力科學研究提供的航拍圖片制作成數據集,并對模型進行訓練、測試以及對比試驗。SENet+Faster R-CNN負責玻璃絕緣子串的位置定位,大大提高了效率,增加了絕緣子在圖片中的面積占比,打消了U-net過于精確而受到噪點干擾的后顧之憂。U-net可以對不同尺寸的裁剪圖像中的像素進行精確分類,提升了準確度。由此將兩類架構的優勢自然糅合起來。實驗結果表明,隨著訓練樣本數量的增加,該方法的效果會變得更好。