融合毫米波雷達(dá)與深度視覺(jué)的多目標(biāo)檢測(cè)與跟蹤*

甘耀東,鄭 玲,張志達(dá),李以農(nóng)

(重慶大學(xué),機(jī)械傳動(dòng)國(guó)家重點(diǎn)實(shí)驗(yàn)室,重慶 400044)

前言

隨著汽車(chē)保有量的增加和交通環(huán)境的日益復(fù)雜,汽車(chē)帶來(lái)的交通安全事故日益增多,亟待通過(guò)駕駛輔助系統(tǒng)和高級(jí)自動(dòng)駕駛技術(shù)等手段,降低交通事故的發(fā)生率,提高汽車(chē)行駛的安全性和效率。環(huán)境感知技術(shù)是自動(dòng)駕駛汽車(chē)的關(guān)鍵技術(shù),它通過(guò)車(chē)載傳感器獲取車(chē)輛周邊的環(huán)境信息,為自動(dòng)駕駛汽車(chē)的決策和控制提供依據(jù)[1-2]。

視覺(jué)傳感器采集數(shù)據(jù)信息量豐富、易于目標(biāo)識(shí)別分類且成本較低,廣泛應(yīng)用于前方車(chē)輛檢測(cè)[3]。傳統(tǒng)的車(chē)輛檢測(cè)大多利用車(chē)輛特征進(jìn)行識(shí)別,如文獻(xiàn)[4]中利用車(chē)輛底部陰影特征生成車(chē)輛假設(shè),并使用Adaboost驗(yàn)證車(chē)輛假設(shè);文獻(xiàn)[5]中利用HOG方向梯度直方圖特征,結(jié)合LSVM訓(xùn)練車(chē)輛識(shí)別分類器,對(duì)多視角的車(chē)輛有較高的識(shí)別率。傳統(tǒng)的視覺(jué)檢測(cè)本質(zhì)上利用人工選擇的特征進(jìn)行識(shí)別分類,該方法適合于某一類特定場(chǎng)景下的目標(biāo)識(shí)別,其數(shù)據(jù)規(guī)模不大,泛化能力較差,較難在復(fù)雜應(yīng)用場(chǎng)景中達(dá)到快速準(zhǔn)確檢測(cè)的效果。近年來(lái),深度學(xué)習(xí)技術(shù)因其可以自動(dòng)學(xué)習(xí)目標(biāo)的有效特征,無(wú)須人工提取特征即能保證良好的檢測(cè)效果,受到研究人員的廣泛關(guān)注[6]。基于深度學(xué)習(xí)的目標(biāo)檢測(cè)算法主要分為兩類:(1)以R?CNN系列[7-9]為代表的基于分類的目標(biāo)檢測(cè)框架;(2)以SSD[10-11]和YOLO系列[12-14]為代表的基于回歸的目標(biāo)檢測(cè)框架。其中,基于分類的檢測(cè)算法須生成待檢測(cè)目標(biāo)的候選區(qū)域,并對(duì)這些候選區(qū)域進(jìn)行分類與位置校準(zhǔn)。該類方法檢測(cè)精度較高,但實(shí)時(shí)性較差。基于回歸的檢測(cè)算法則直接在特征圖中進(jìn)行目標(biāo)的識(shí)別與定位。該類方法在保證較高檢測(cè)精度的同時(shí)具有較快的檢測(cè)速度。基于視覺(jué)的目標(biāo)檢測(cè)算法易受光照和雨雪等天氣的影響,檢測(cè)精度大幅降低,且無(wú)法獲取目標(biāo)的運(yùn)動(dòng)信息。

毫米波雷達(dá)具有抗環(huán)境干擾能力強(qiáng)、探測(cè)距離遠(yuǎn)、能獲取目標(biāo)運(yùn)動(dòng)信息和成本低等優(yōu)點(diǎn),是目前汽車(chē)高級(jí)輔助駕駛系統(tǒng)的主流傳感器,得到國(guó)內(nèi)外學(xué)者廣泛關(guān)注[15]。文獻(xiàn)[16]中針對(duì)雷達(dá)彎道目標(biāo)跟蹤準(zhǔn)確性較低的問(wèn)題,采用曼哈頓距離聚類和最鄰近數(shù)據(jù)關(guān)聯(lián)算法,減少了數(shù)據(jù)關(guān)聯(lián)計(jì)算并提高跟蹤準(zhǔn)確性。文獻(xiàn)[17]中通過(guò)兩級(jí)級(jí)聯(lián)邏輯進(jìn)行航跡的起始,解決了雷達(dá)存在的雜波和不確定量測(cè)情況下的目標(biāo)濾波問(wèn)題。雖然基于毫米波雷達(dá)的檢測(cè)跟蹤算法在智能駕駛領(lǐng)域取得了一定的成果,但毫米波雷達(dá)無(wú)法獲取目標(biāo)的幾何信息與類別信息,另外,雷達(dá)檢測(cè)中還存在虛假目標(biāo)。

針對(duì)單一傳感器自身功能的局限性,基于多傳感器信息融合的車(chē)輛檢測(cè)方法能充分融合不同傳感器的優(yōu)勢(shì)。文獻(xiàn)[18]和文獻(xiàn)[19]中采用毫米波雷達(dá)與視覺(jué)信息融合的方法檢測(cè)前方車(chē)輛,其中,文獻(xiàn)[18]中提出一種基于層次聚類的雷達(dá)雜波剔除方法,并采用KCF[20]-EKF[21]組合濾波算法對(duì)前方車(chē)輛進(jìn)行檢測(cè)跟蹤,有效降低了車(chē)輛檢測(cè)的漏檢率。文獻(xiàn)[19]中基于視覺(jué)圖像提取Haar?like特征,利用Adaboost算法檢測(cè)車(chē)輛并生成感興趣區(qū)域(region of interest,ROI),通過(guò)與雷達(dá)投影到視覺(jué)圖像產(chǎn)生的ROI計(jì)算重合率,完成雷達(dá)與視覺(jué)信息的融合,降低檢測(cè)時(shí)間。但是,上述視覺(jué)算法中采用傳統(tǒng)的機(jī)器視覺(jué)檢測(cè)方法,檢測(cè)精度受人工提取特征的影響,進(jìn)而影響后續(xù)融合算法的檢測(cè)效果。另外,上述雷達(dá)跟蹤算法中未考慮噪聲的先驗(yàn)統(tǒng)計(jì)特性和外部環(huán)境的動(dòng)態(tài)變化,易造成濾波精度下降進(jìn)而導(dǎo)致跟蹤算法失效。

為解決上述問(wèn)題,做出以下改進(jìn):針對(duì)雷達(dá)跟蹤穩(wěn)定性問(wèn)題,利用毫米波雷達(dá)的觀測(cè)數(shù)據(jù),實(shí)時(shí)估計(jì)和修正濾波器噪聲統(tǒng)計(jì)特性,提出一種自適應(yīng)EKF(adaptive extended Kalman filtering,AEKF)算法,用于提高目標(biāo)跟蹤的精度;針對(duì)傳統(tǒng)視覺(jué)檢測(cè)精度較低的問(wèn)題,采用SSD+MobileNetV2相結(jié)合的深度學(xué)習(xí)網(wǎng)絡(luò)進(jìn)行前方車(chē)輛目標(biāo)檢測(cè)。最后,結(jié)合毫米波雷達(dá)與深度視覺(jué)檢測(cè)信息,提出了決策級(jí)融合算法,用于提升前方車(chē)輛檢測(cè)的準(zhǔn)確性和實(shí)時(shí)性。

1 基于AEKF的毫米波雷達(dá)跟蹤

1.1 基于閾值篩選和前后幀關(guān)聯(lián)的雷達(dá)目標(biāo)提取

選用Delphi公司的ESR毫米波雷達(dá)進(jìn)行車(chē)輛目標(biāo)檢測(cè)與跟蹤,該雷達(dá)的工作頻率為20 Hz。其中,每幀返回64個(gè)通道的數(shù)據(jù),每個(gè)通道的數(shù)據(jù)信息包括前方目標(biāo)的相對(duì)距離、相對(duì)速度、相對(duì)加速度、相對(duì)角度和反射率等。考慮到后續(xù)決策與路徑規(guī)劃中需要識(shí)別的道路車(chē)輛目標(biāo)主要為同車(chē)道前方車(chē)輛和左右兩側(cè)鄰近車(chē)道的同向車(chē)輛,以及高速道路上車(chē)輛運(yùn)動(dòng)速度信息等,分別設(shè)置橫向距離閾值與速度閾值:

式中:y為本車(chē)與前方車(chē)輛的橫向距離;Y0為車(chē)道橫向有效車(chē)輛范圍閾值;v1為前方車(chē)輛與本車(chē)輛相對(duì)速度。根據(jù)我國(guó)道路技術(shù)規(guī)范,行車(chē)道的標(biāo)準(zhǔn)寬度為3.75 m。經(jīng)過(guò)大量實(shí)驗(yàn)數(shù)據(jù)驗(yàn)證,可以選取Y0=4.8 m。

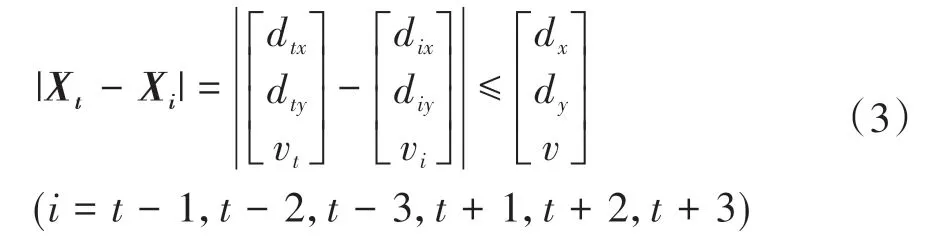

為濾除毫米波雷達(dá)中的非連續(xù)數(shù)據(jù),使用前后幀關(guān)聯(lián)方法,其判斷準(zhǔn)則為

式中:Xt=[d tx,d ty,vt]T表示t時(shí)刻每個(gè)通道測(cè)量前方目標(biāo)的橫向距離、縱向距離和相對(duì)速度;Xi=[dix,d iy,vi]T表示i時(shí)刻每個(gè)通道測(cè)量前方目標(biāo)的橫向距離、縱向距離和相對(duì)速度。

選取道路實(shí)測(cè)數(shù)據(jù)、毫米波雷達(dá)原始數(shù)據(jù)和濾波后數(shù)據(jù)對(duì)比如圖1所示。其中,藍(lán)色像素點(diǎn)表示雜波干擾信息,紅色像素點(diǎn)表示經(jīng)過(guò)閾值篩選與前后幀關(guān)聯(lián)方法提取得到的目標(biāo)點(diǎn)。可以看出該方法能夠有效濾除前方雜波干擾信息。

圖1 雷達(dá)數(shù)據(jù)濾波效果對(duì)比圖

1.2 基于AEKF的毫米波雷達(dá)跟蹤

基于EKF算法的毫米波雷達(dá)跟蹤通過(guò)求解Jacobian矩陣對(duì)系統(tǒng)1階線性化,可用于非線性估計(jì)。然而,EKF在未知噪聲的先驗(yàn)統(tǒng)計(jì)特性和外部環(huán)境的動(dòng)態(tài)變化的情況下,易出現(xiàn)濾波精度下降甚至發(fā)散的問(wèn)題,這些不確定性因素最終會(huì)導(dǎo)致EKF算法失效。針對(duì)此問(wèn)題,本文中提出一種AEKF算法,在濾波的同時(shí)利用毫米波雷達(dá)觀測(cè)數(shù)據(jù)帶來(lái)的信息,不斷在線估計(jì)和修正濾波器噪聲統(tǒng)計(jì)特性,以提高濾波精度,得到估計(jì)狀態(tài)的最優(yōu)值。

同時(shí),在目標(biāo)追蹤運(yùn)動(dòng)模型中,恒定速度與恒定加速度模型假定目標(biāo)為直線運(yùn)動(dòng),并不適合復(fù)雜環(huán)境下的車(chē)輛追蹤。考慮車(chē)輛在轉(zhuǎn)彎等復(fù)雜路況環(huán)境下的運(yùn)動(dòng)特征,采用恒定轉(zhuǎn)彎率和速度(constant turn rate and velocity,CTRV)模型進(jìn)行追蹤。

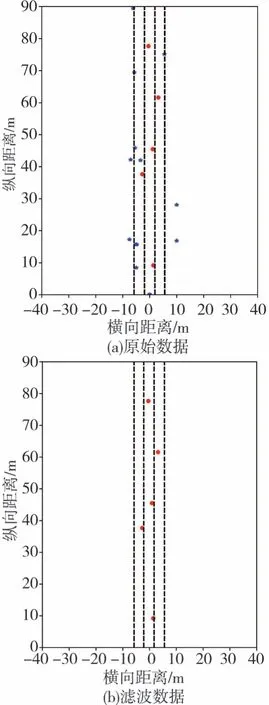

所提出的AEKF算法主要包括狀態(tài)預(yù)測(cè)、狀態(tài)更新和協(xié)方差矯正,具體實(shí)現(xiàn)過(guò)程如下。

步驟1:狀態(tài)預(yù)測(cè)

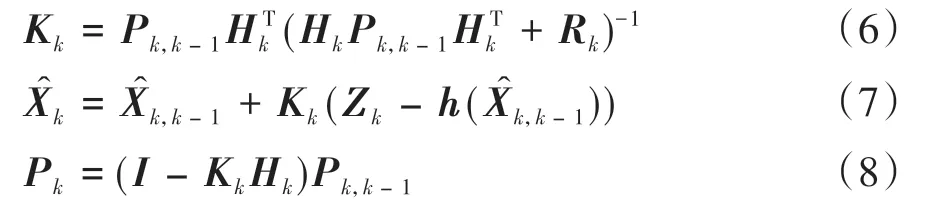

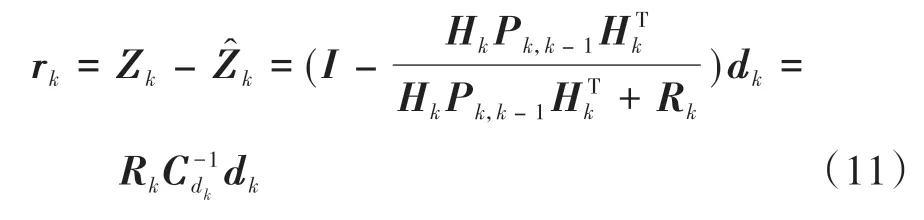

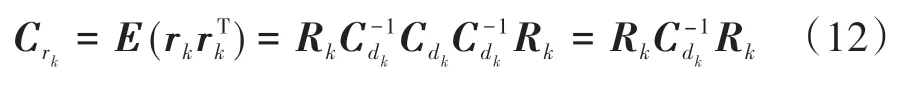

步驟2:狀態(tài)更新

步驟3:協(xié)方差矯正

k時(shí)刻新息d k定義為濾波器實(shí)際觀測(cè)值Z k和預(yù)測(cè)觀測(cè)值之差。假設(shè)d k具有各態(tài)歷經(jīng)性,則根據(jù)開(kāi)窗估計(jì)法可得到新息的實(shí)時(shí)估計(jì)方差為

式中W為滑動(dòng)數(shù)據(jù)窗口長(zhǎng)度。k時(shí)刻殘差r k定義為濾波器實(shí)際觀測(cè)值Z k和估計(jì)觀測(cè)值之差,即

殘差方差為

卡爾曼增益為

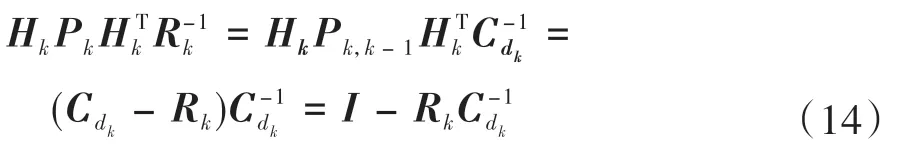

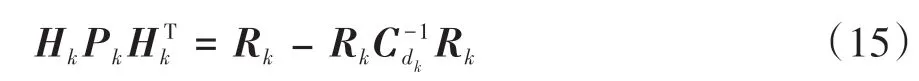

式(13)兩邊同時(shí)左乘H k,并代入式(10)可得

式(14)兩邊同時(shí)右乘R k可得

將其代入式(12)得R k的估計(jì)值為

同理,利用新息可以求得狀態(tài)噪聲方差Q的在線估計(jì)值:

為保持方差Q的半正定性,只提取Q k-1主對(duì)角線上的元素值。結(jié)合CTRV模型,設(shè)置跟蹤目標(biāo)的狀態(tài)量為

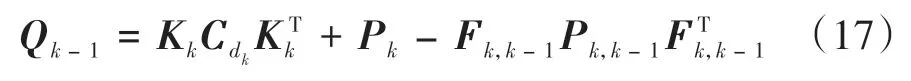

式中:θ為偏航角,是跟蹤目標(biāo)車(chē)輛在當(dāng)前車(chē)輛坐標(biāo)系下與x軸的夾角;w為偏航角速度。考慮到實(shí)際運(yùn)動(dòng)中目標(biāo)車(chē)輛存在直線加速度和偏航角加速度噪聲,最終CTRV的狀態(tài)轉(zhuǎn)移函數(shù)為

式中:μa為隨機(jī)縱向加速度;μω為隨機(jī)偏航角加速度。

由于狀態(tài)轉(zhuǎn)移函數(shù)與觀測(cè)函數(shù)都為非線性函數(shù),故使用1階泰勒展開(kāi)近似線性化得到狀態(tài)轉(zhuǎn)移函數(shù)與觀測(cè)函數(shù)的雅克比矩陣F和H。將毫米波雷達(dá)檢測(cè)結(jié)果進(jìn)行AEKF跟蹤,并將跟蹤結(jié)果通過(guò)投影方程投影到視覺(jué)圖像中。

1.3 毫米波雷達(dá)在視覺(jué)圖像上投影

通過(guò)閾值篩選與前后幀數(shù)據(jù)關(guān)聯(lián)提取出前方目標(biāo)車(chē)輛信息后,須將毫米波雷達(dá)識(shí)別結(jié)果通過(guò)空間與時(shí)間坐標(biāo)系進(jìn)行轉(zhuǎn)換進(jìn)而映射到視覺(jué)圖像中,以便之后與機(jī)器視覺(jué)檢測(cè)信息進(jìn)行融合[22]。具體步驟如下。

(1)空間坐標(biāo)系轉(zhuǎn)換

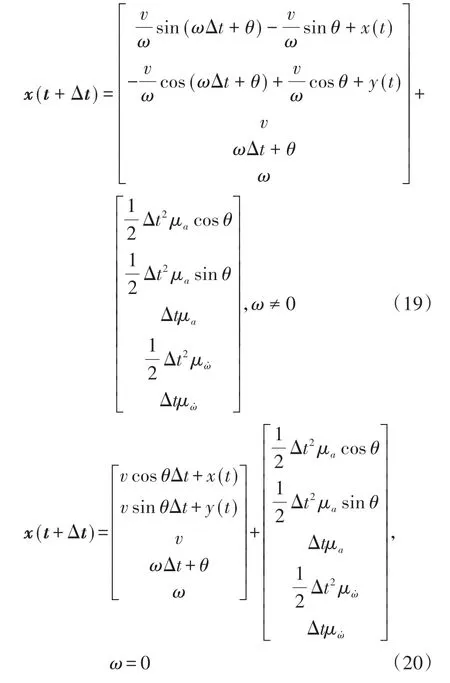

根據(jù)相機(jī)坐標(biāo)系與世界坐標(biāo)系、毫米波雷達(dá)坐標(biāo)系與世界坐標(biāo)系、相機(jī)坐標(biāo)系與圖像物理坐標(biāo)系、圖像像素坐標(biāo)系與圖像物理坐標(biāo)系之間相互的轉(zhuǎn)換關(guān)系可得到世界坐標(biāo)系到圖像像素坐標(biāo)系之間的轉(zhuǎn)換關(guān)系為

式中:R為旋轉(zhuǎn)矩陣,由相機(jī)的俯仰角和偏航角決定;T為平移向量,是相機(jī)坐標(biāo)系原點(diǎn)在世界坐標(biāo)系[X YZ]方向上的坐標(biāo);f為相機(jī)焦距;d x、d y為像素坐標(biāo)系下每個(gè)單位像素對(duì)應(yīng)物理坐標(biāo)系下距離的大小;[XW YW ZW]為雷達(dá)監(jiān)測(cè)點(diǎn)在世界坐標(biāo)系中的坐標(biāo);[u,v]為雷達(dá)檢測(cè)點(diǎn)在圖像坐標(biāo)系中的坐標(biāo);Zc為雷達(dá)監(jiān)測(cè)點(diǎn)在相機(jī)坐標(biāo)系中的Z軸坐標(biāo)。

(2)時(shí)間坐標(biāo)系對(duì)準(zhǔn)

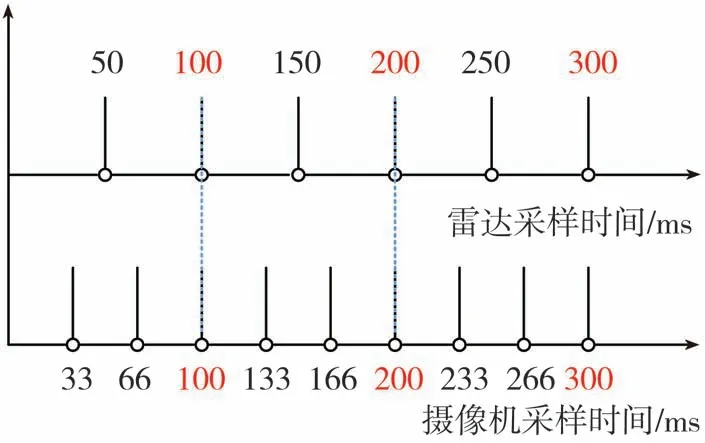

毫米波雷達(dá)與攝像機(jī)數(shù)據(jù)完成空間坐標(biāo)系的轉(zhuǎn)換之后,還須進(jìn)行時(shí)間信息上的匹配。本實(shí)驗(yàn)中采用的毫米波雷達(dá)采樣頻率為20幀/s,攝像機(jī)的采樣頻率為30幀/s,毫米波雷達(dá)每間隔2幀選取1次數(shù)據(jù)、攝像機(jī)每間隔3幀選取1次數(shù)據(jù),完成雷達(dá)與相機(jī)時(shí)間上的對(duì)準(zhǔn)。雷達(dá)與視覺(jué)坐標(biāo)系對(duì)準(zhǔn)規(guī)則如圖2所示。

圖2 雷達(dá)與視覺(jué)時(shí)間同步示意圖

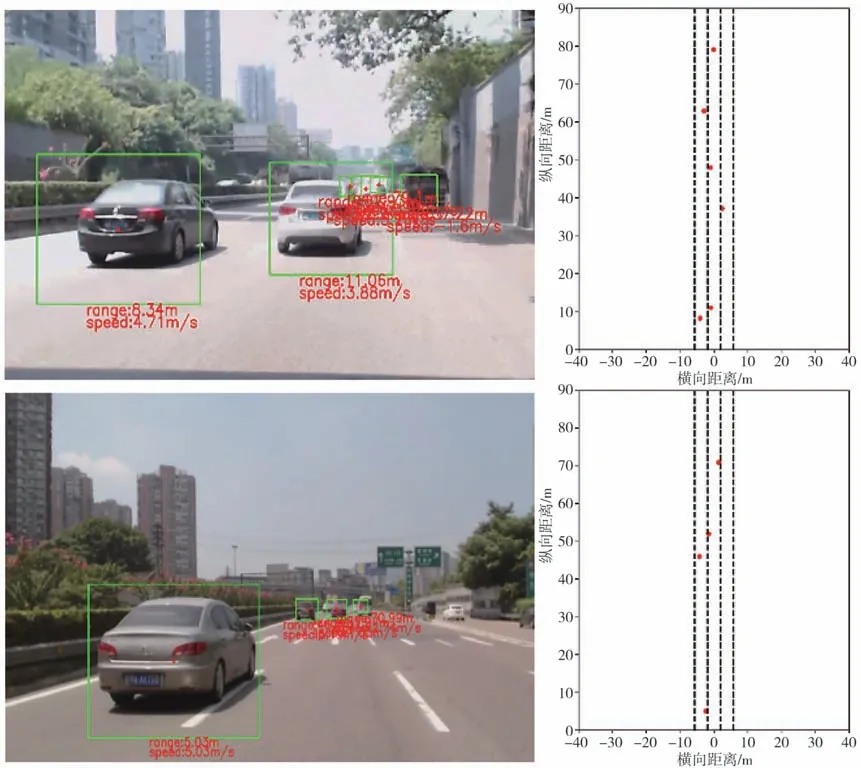

通過(guò)空間坐標(biāo)系與時(shí)間坐標(biāo)系的轉(zhuǎn)換得到毫米波雷達(dá)跟蹤檢測(cè)結(jié)果在視覺(jué)圖像上的投影,如圖3所示。其中,紅色部分為雷達(dá)檢測(cè)跟蹤結(jié)果,range為前車(chē)與實(shí)驗(yàn)車(chē)相對(duì)距離,speed為前車(chē)與實(shí)驗(yàn)車(chē)的相對(duì)速度。

圖3 雷達(dá)目標(biāo)投影ROI區(qū)域

2 基于深度視覺(jué)的車(chē)輛檢測(cè)

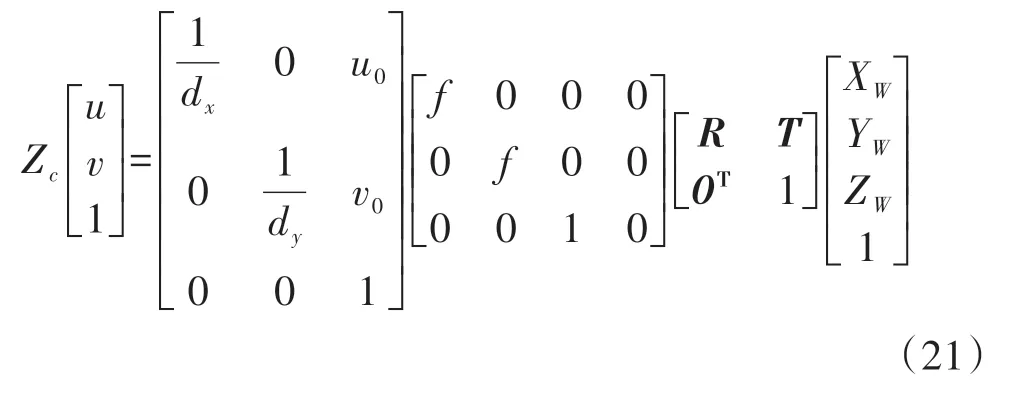

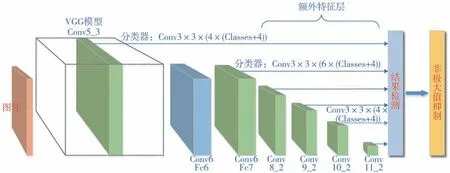

采用檢測(cè)精度與檢測(cè)速度都有較好表現(xiàn)的SSD(single shot multibox detector)神經(jīng)網(wǎng)絡(luò)算法作為視覺(jué)檢測(cè)算法。SSD算法直接在卷積網(wǎng)絡(luò)層進(jìn)行檢測(cè),其檢測(cè)速度比基于分類檢測(cè)的two?stage方法大大提高;同時(shí)SSD算法通過(guò)提取不同尺度的特征圖,更好地適應(yīng)不同尺寸物體的檢測(cè)。SSD算法網(wǎng)絡(luò)結(jié)構(gòu)如圖4所示。

圖4 SSD檢測(cè)算法網(wǎng)絡(luò)結(jié)構(gòu)圖

為解決SSD算法中參數(shù)過(guò)多、訓(xùn)練難度較大的問(wèn)題,采用輕量級(jí)神經(jīng)網(wǎng)絡(luò)模型MobileNetV2替換原始SSD算法中的VGG模型[23]。MobileNetV2網(wǎng)絡(luò)結(jié)構(gòu)通過(guò)深度可分離卷積與逆殘差的方法,大大減少網(wǎng)絡(luò)參數(shù)的同時(shí)保證較好的檢測(cè)精度。

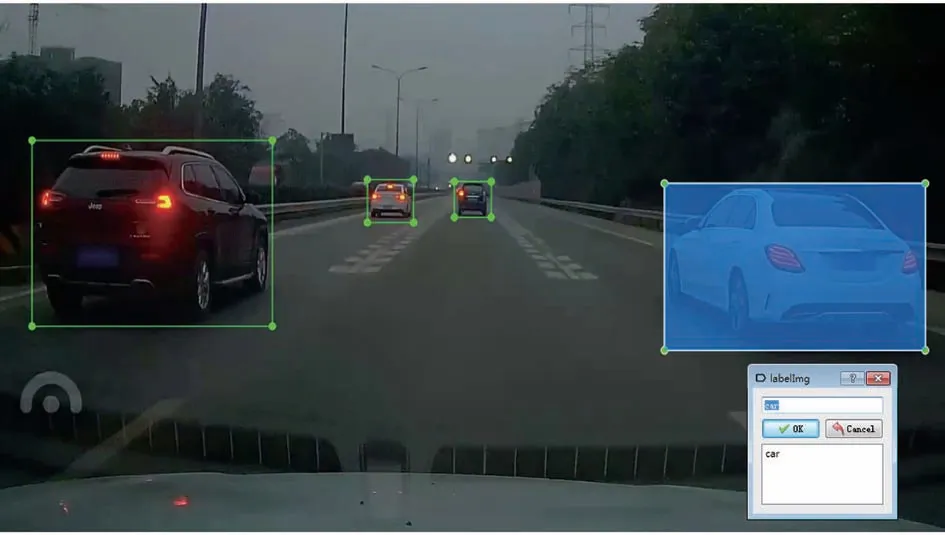

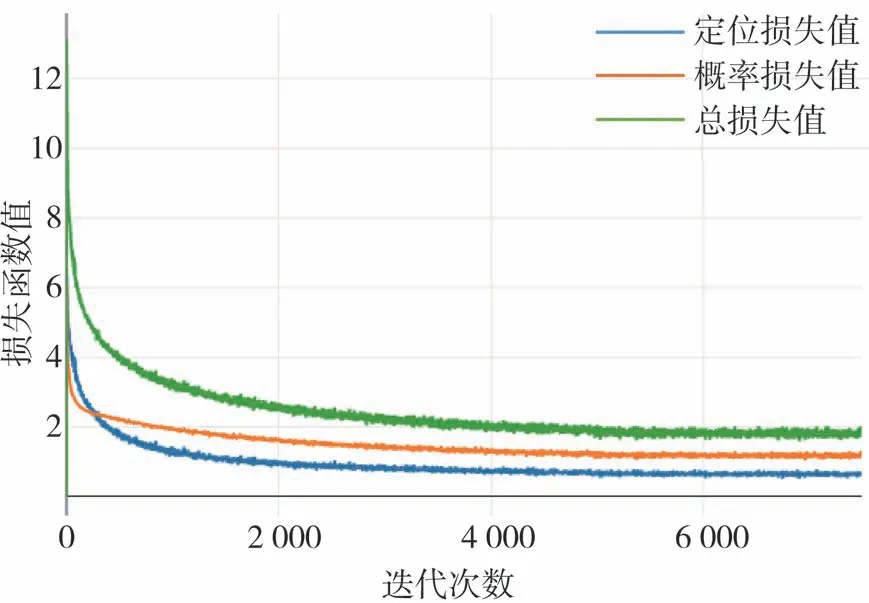

截取滴滴車(chē)載視頻幀,并手動(dòng)標(biāo)注車(chē)輛數(shù)據(jù)集訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò)[24]。其中手動(dòng)標(biāo)注車(chē)輛數(shù)據(jù)集過(guò)程如圖5所示。選取6 000張標(biāo)注數(shù)據(jù)集進(jìn)行神經(jīng)網(wǎng)絡(luò)訓(xùn)練,另選取2 000張數(shù)據(jù)集進(jìn)行檢測(cè)。設(shè)置訓(xùn)練的最大迭代次數(shù)為120k次,訓(xùn)練過(guò)程中實(shí)時(shí)記錄損失函數(shù)值的變化,直到損失函數(shù)值穩(wěn)定不變時(shí)結(jié)束訓(xùn)練。損失函數(shù)值變化如圖6所示。

圖5 手動(dòng)標(biāo)注數(shù)據(jù)集示例圖

圖6 滴滴數(shù)據(jù)集訓(xùn)練損失函數(shù)值變化圖

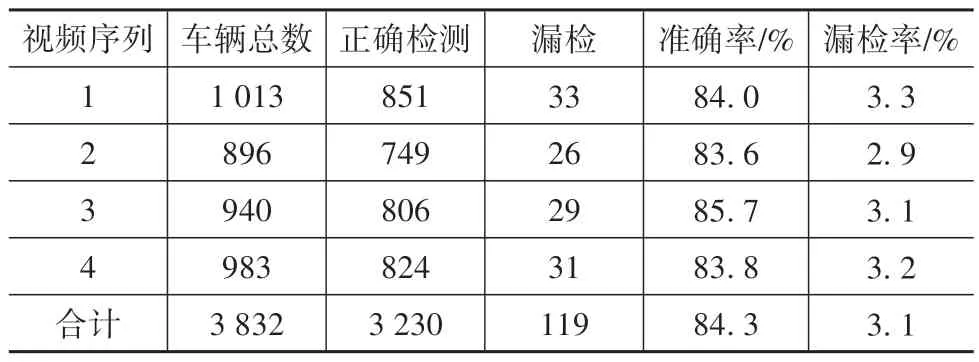

訓(xùn)練結(jié)束后對(duì)2 000張待檢測(cè)圖片進(jìn)行平均準(zhǔn)確率(average precision,AP)的計(jì)算,所得AP值為0.792。為進(jìn)一步測(cè)試神經(jīng)網(wǎng)絡(luò)檢測(cè)算法的準(zhǔn)確率,在天氣晴朗、光線良好的條件下采集4段城市道路視頻,并以每隔10幀的方式隨機(jī)抽取視頻圖像數(shù)據(jù)輸入至神經(jīng)網(wǎng)絡(luò)進(jìn)行檢測(cè)。其中,視頻幀大小為1920像素×1080像素。表1為神經(jīng)網(wǎng)絡(luò)算法基于采集視頻的檢測(cè)結(jié)果,圖7為神經(jīng)網(wǎng)絡(luò)算法檢測(cè)結(jié)果圖。其中,車(chē)輛總數(shù)為抽取到所有幀視頻圖像中車(chē)輛數(shù)目的總和,正確檢測(cè)數(shù)目為算法檢測(cè)出車(chē)輛的總和,漏檢數(shù)目為算法未檢測(cè)到車(chē)輛的總和。可以看出,基于所提出的SSD+MobileNetV2神經(jīng)網(wǎng)絡(luò)檢測(cè)方法進(jìn)行車(chē)輛識(shí)別的平均準(zhǔn)確率為84.3%,平均漏檢率為3.1%,實(shí)時(shí)檢測(cè)幀率為24幀/s。結(jié)果表明,基于手動(dòng)標(biāo)注滴滴數(shù)據(jù)集訓(xùn)練的SSD+MobileNet V2神經(jīng)網(wǎng)絡(luò)算法能快速準(zhǔn)確地識(shí)別前方車(chē)輛。

圖7 神經(jīng)網(wǎng)絡(luò)算法檢測(cè)結(jié)果

表1 神經(jīng)網(wǎng)絡(luò)算法檢測(cè)結(jié)果統(tǒng)計(jì)

3 毫米波雷達(dá)與深度視覺(jué)信息融合框架

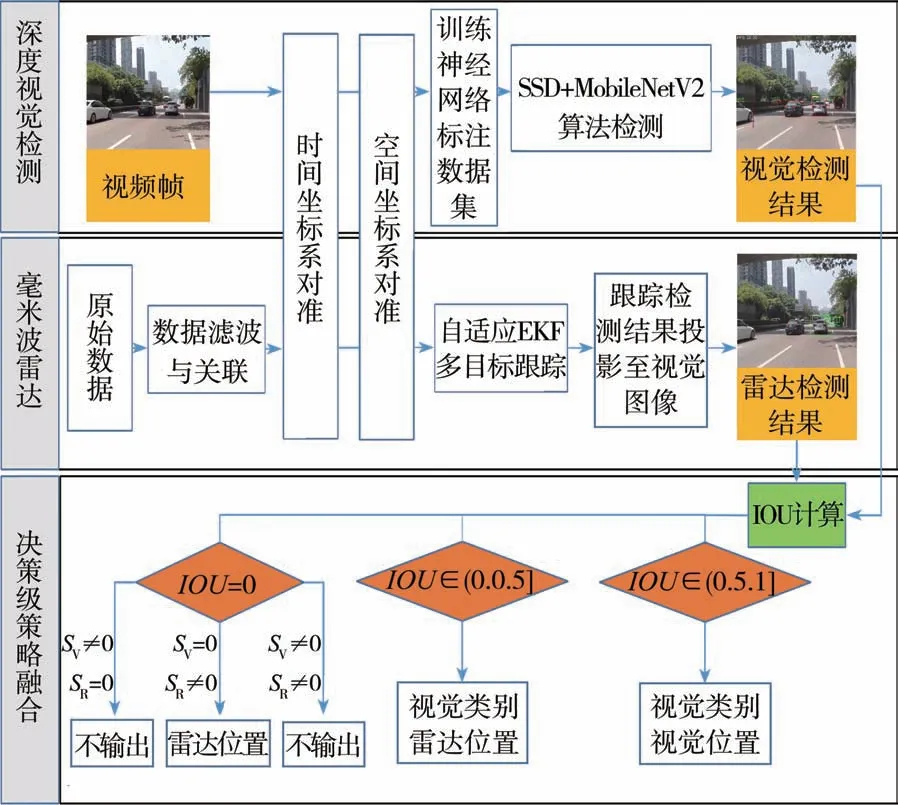

在完成雷達(dá)AEKF跟蹤和深度學(xué)習(xí)算法的訓(xùn)練后,須對(duì)毫米波雷達(dá)與深度視覺(jué)檢測(cè)跟蹤結(jié)果進(jìn)行融合。提出決策級(jí)融合策略,具體流程如圖8所示。首先,將毫米波雷達(dá)原始數(shù)據(jù)進(jìn)行閾值篩選與前后幀關(guān)聯(lián),得到目標(biāo)特征信息之后進(jìn)行時(shí)間坐標(biāo)系與空間坐標(biāo)系的轉(zhuǎn)換和對(duì)準(zhǔn),基于AEKF算法將跟蹤檢測(cè)結(jié)果投影至視覺(jué)圖像;其次,標(biāo)注車(chē)載數(shù)據(jù)集進(jìn)行SSD+MobileNetV2神經(jīng)網(wǎng)絡(luò)訓(xùn)練,完成深度視覺(jué)目標(biāo)檢測(cè);最后,將雷達(dá)與深度視覺(jué)檢測(cè)跟蹤結(jié)果進(jìn)行融合。

圖8 融合框架邏輯圖

對(duì)兩種傳感器得到的檢測(cè)框計(jì)算交并比(IOU)以便進(jìn)行決策級(jí)判斷。IOU計(jì)算公式為

式中:SV為深度視覺(jué)檢測(cè)矩形框面積;SR為毫米波雷達(dá)檢測(cè)跟蹤矩形框面積。當(dāng)IOU∈[0.5,1],輸出視覺(jué)檢測(cè)類別與位置信息;當(dāng)IOU∈(0,0.5),輸出視覺(jué)檢測(cè)類別與毫米波雷達(dá)檢測(cè)的目標(biāo)位置和狀態(tài)信息;當(dāng)IOU=0時(shí),針對(duì)SV≠0,SR=0和SV≠0,SR≠0的情況均不輸出檢測(cè)結(jié)果,當(dāng)SV=0,SR≠0時(shí)僅輸出雷達(dá)檢測(cè)目標(biāo)位置與狀態(tài)信息,直至IOU≠0。

基于上述毫米波雷達(dá)與視覺(jué)信息融合規(guī)則,對(duì)于不同情況下的車(chē)輛狀態(tài)均能對(duì)其位置信息進(jìn)行融合且獲得較為準(zhǔn)確的前方車(chē)輛位置狀態(tài)輸出。

4 實(shí)驗(yàn)結(jié)果分析

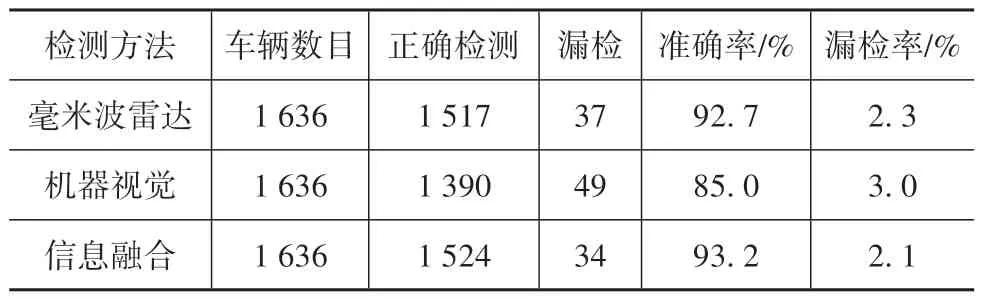

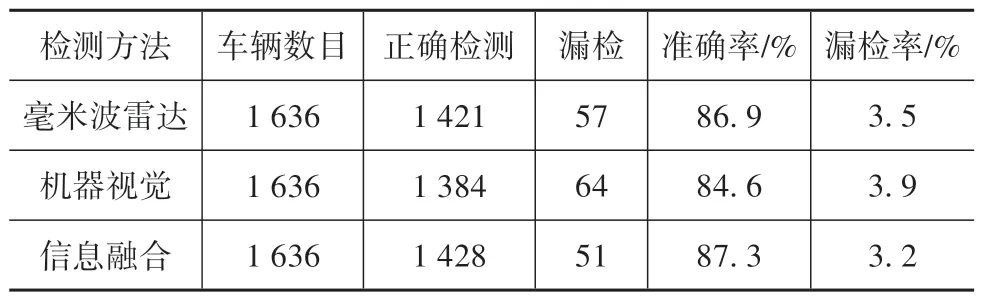

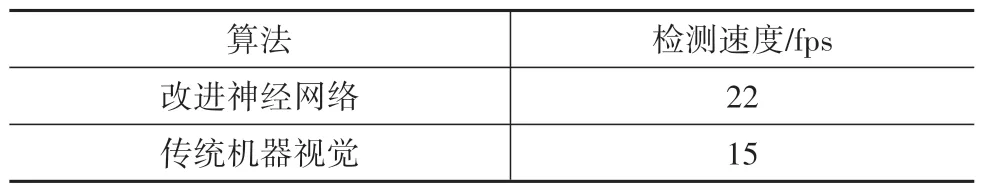

主要對(duì)日間結(jié)構(gòu)化高速和快速道路環(huán)境下的車(chē)輛檢測(cè)進(jìn)行研究。用于驗(yàn)證本文融合算法有效性的實(shí)驗(yàn)數(shù)據(jù)包含復(fù)雜道路背景、路面陰影、密集車(chē)輛和不同車(chē)距車(chē)輛等多種道路環(huán)境。實(shí)驗(yàn)采用的毫米波雷達(dá)型號(hào)為德國(guó)的Delphi ESR,工作頻率20 Hz。視覺(jué)傳感器型號(hào)為羅技C920 Pro攝像頭,采集分辨率為1920×1080,采集頻率為30幀/s。計(jì)算機(jī)平臺(tái)的配置為Intel Core i7?8700k處理器,NVIDIA RTX 2080 8G顯存,滿足神經(jīng)網(wǎng)絡(luò)訓(xùn)練與檢測(cè)的要求。算法采用Python語(yǔ)言實(shí)現(xiàn),其中神經(jīng)網(wǎng)絡(luò)算法采用pytorch神經(jīng)網(wǎng)絡(luò)框架進(jìn)行搭建。實(shí)驗(yàn)融合檢測(cè)結(jié)果如圖9所示。其中,綠色框?yàn)楹撩撞ɡ走_(dá)跟蹤檢測(cè)框,紅色框?yàn)樯窠?jīng)網(wǎng)絡(luò)算法檢測(cè)框。本文算法檢測(cè)統(tǒng)計(jì)如表2所示,文獻(xiàn)[18]方法檢測(cè)結(jié)果如表3所示,不同檢測(cè)算法檢測(cè)速度對(duì)比結(jié)果如表4所示。

圖9 算法檢測(cè)結(jié)果

表2 本文方法檢測(cè)結(jié)果統(tǒng)計(jì)

表3 文獻(xiàn)[18]方法檢測(cè)結(jié)果統(tǒng)計(jì)

表4 不同檢測(cè)算法檢測(cè)速度對(duì)比

為驗(yàn)證所提出的基于AEKF算法跟蹤與深度視覺(jué)信息融合算法的穩(wěn)定性與準(zhǔn)確性,與文獻(xiàn)[18]中的算法進(jìn)行對(duì)比分析。對(duì)比表2與表3可見(jiàn),基于相同視頻序列的檢測(cè)結(jié)果,本文提出的毫米波雷達(dá)AEKF檢測(cè)跟蹤算法與深度視覺(jué)算法對(duì)前方車(chē)輛檢測(cè)精度與漏檢情況皆優(yōu)于文獻(xiàn)[18]中的傳統(tǒng)檢測(cè)方法,進(jìn)而提升了兩種傳感器信息融合檢測(cè)的精度。文獻(xiàn)[18]中采用EKF算法對(duì)毫米波雷達(dá)目標(biāo)進(jìn)行跟蹤,并未考慮噪聲先驗(yàn)統(tǒng)計(jì)特性和外部環(huán)境動(dòng)態(tài)變化對(duì)濾波精度的影響。此外,其采用傳統(tǒng)的基于HOG特征的SVM分類器對(duì)車(chē)輛進(jìn)行檢測(cè),泛化能力較差,較難在復(fù)雜應(yīng)用場(chǎng)景中達(dá)到快速準(zhǔn)確檢測(cè)的效果。本文改進(jìn)方法采用AEKF算法對(duì)毫米波雷達(dá)進(jìn)行跟蹤,檢測(cè)準(zhǔn)確率達(dá)93.2%,有效降低了雷達(dá)漏檢、誤檢對(duì)目標(biāo)檢測(cè)的影響。采用SSD+MobileNetV2神經(jīng)網(wǎng)絡(luò)算法提升了檢測(cè)準(zhǔn)確率,針對(duì)實(shí)車(chē)道路場(chǎng)景測(cè)試能達(dá)到22幀/s的檢測(cè)速度,實(shí)現(xiàn)了快速準(zhǔn)確檢測(cè)目標(biāo)。基于決策級(jí)融合策略,降低了光照、陰影等環(huán)境對(duì)算法的影響,進(jìn)一步提升了檢測(cè)精度,減少了漏檢與誤檢情況的發(fā)生,提高對(duì)目標(biāo)車(chē)輛位置、運(yùn)動(dòng)狀態(tài)和幾何參數(shù)估計(jì)的準(zhǔn)確性。

5 結(jié)論

(1)針對(duì)融合毫米波雷達(dá)與機(jī)器視覺(jué)的信息檢測(cè)跟蹤算法準(zhǔn)確率低和實(shí)時(shí)性較差的問(wèn)題,提出一種基于自適應(yīng)EKF濾波跟蹤算法。在未知噪聲先驗(yàn)統(tǒng)計(jì)特性和外部環(huán)境動(dòng)態(tài)變化的情況下,利用毫米波雷達(dá)觀測(cè)數(shù)據(jù)不斷在線估計(jì)和修正濾波器噪聲統(tǒng)計(jì)特性,以提高濾波精度與穩(wěn)定性。

(2)針對(duì)傳統(tǒng)機(jī)器視覺(jué)檢測(cè)算法精度較低、檢測(cè)速度較慢的問(wèn)題,采用SSD+MobileNetV2的神經(jīng)網(wǎng)絡(luò)算法進(jìn)行前方車(chē)輛檢測(cè),進(jìn)一步提升融合檢測(cè)算法的精度與速度。

(3)提出毫米波雷達(dá)與深度視覺(jué)信息融合框架,為驗(yàn)證融合框架檢測(cè)跟蹤的有效性,進(jìn)行了不同交通環(huán)境場(chǎng)景下的實(shí)車(chē)實(shí)驗(yàn)。在存在光照變化、路面陰影和道路車(chē)輛密集的情況下,所提出的算法依然能快速準(zhǔn)確地對(duì)前方車(chē)輛進(jìn)行檢測(cè)跟蹤。結(jié)果表明所提出的檢測(cè)跟蹤算法有效降低了雷達(dá)檢測(cè)跟蹤的漏檢率,提高了車(chē)輛檢測(cè)精度與速度。

(4)所提出的融合毫米波雷達(dá)與深度視覺(jué)信息檢測(cè)跟蹤算法可實(shí)時(shí)檢測(cè)跟蹤前方車(chē)輛,具有比傳統(tǒng)方法更好的可靠性與穩(wěn)定性,對(duì)提高智能汽車(chē)環(huán)境感知性能具有重要的意義。