UTMCQA:融合多任務的復雜問答模型

周高峰,高盛祥,余正濤,宋 燃,寇夢珂

1(昆明理工大學 信息工程與自動化學院,昆明 650500) 2(昆明理工大學 云南省人工智能重點實驗室,昆明 650500)

1 引 言

當前大部分問答系統可以較好地回答簡單(單跳)事實型問題[1],例如:“誰是電影《泰坦尼克號》的導演?”,此類問題僅包含單一事實,可以通過查詢知識庫中的單個關系(或路徑)或檢索某個文本段落來解決.但是,真實應用中的問題往往涉及多個實體和關系,同時它們之間具有復雜的約束限制和推理模式,這類問題常稱為復雜問題[2,3],如:“What is the currency used in the region that has time zone Central Western Time Zone?”,該問題中涉及“currency”、“region”、“Central Western Time Zone”等實體以及“Entity-is”、“Entity-use”、“Entity-have”等實體間關系和“time zone”等約束情況,此類復雜問題需要綜合利用多個支撐線索才能回答,因此處理復雜問題中的多個語義單元及它們之間的復雜關系至關重要.

知識庫是處理復雜問題的一個重要信息源,目前利用知識庫處理復雜問題的主流方法可以分為基于模板、語義解析和問題分解3類.其中,基于模板的方法[4,5]通常將自然語言問題映射到基于知識庫的預先定義好的模板庫,再使用對應的模板進行查詢.語義解析技術[6-9]旨在為自然語言問題構造語義分析樹或等價查詢結構,把問題轉換為對應知識庫的查詢語句進而通過檢索獲取答案.問題分解技術[2,9,10]將復雜的問題分解成多個相關但更簡單的子問題,并以子問題的答案作為證據支撐得出最終答案.但此種方法的缺點在于系統的性能往往受到知識庫不完整性的影響.相反,文本庫往往包含了知識庫中不存在的實體信息,其豐富的信息可以彌補知識庫不完整的缺陷.最近的方法[11-13]通過融合結構化知識庫和非結構化文本兩個信息源,構建問題的相關子圖并利用圖表示學習的方法進行問答,在問答領域顯示出巨大潛力.

雖然目前對復雜問題(多跳問題)的研究日益火熱,但仍有很多挑戰,主要包括:1)大多數問答系統沒有關注到復雜問題中豐富的語義信息,大部分模型以流水線形式進行,實體鏈接、關系檢測等各模塊獨立學習,各個模塊不能通過相互作用彌補不足;2)雖然融合知識庫和文本庫的方法[12,13]在處理復雜問題上的效果顯著,但是大多數系統的語義空間不統一.自然語言問題嵌入之后,轉而用其他方法例如IDF相似度尋找實體信息,這樣可能會造成語義歧義和語義融合困難.

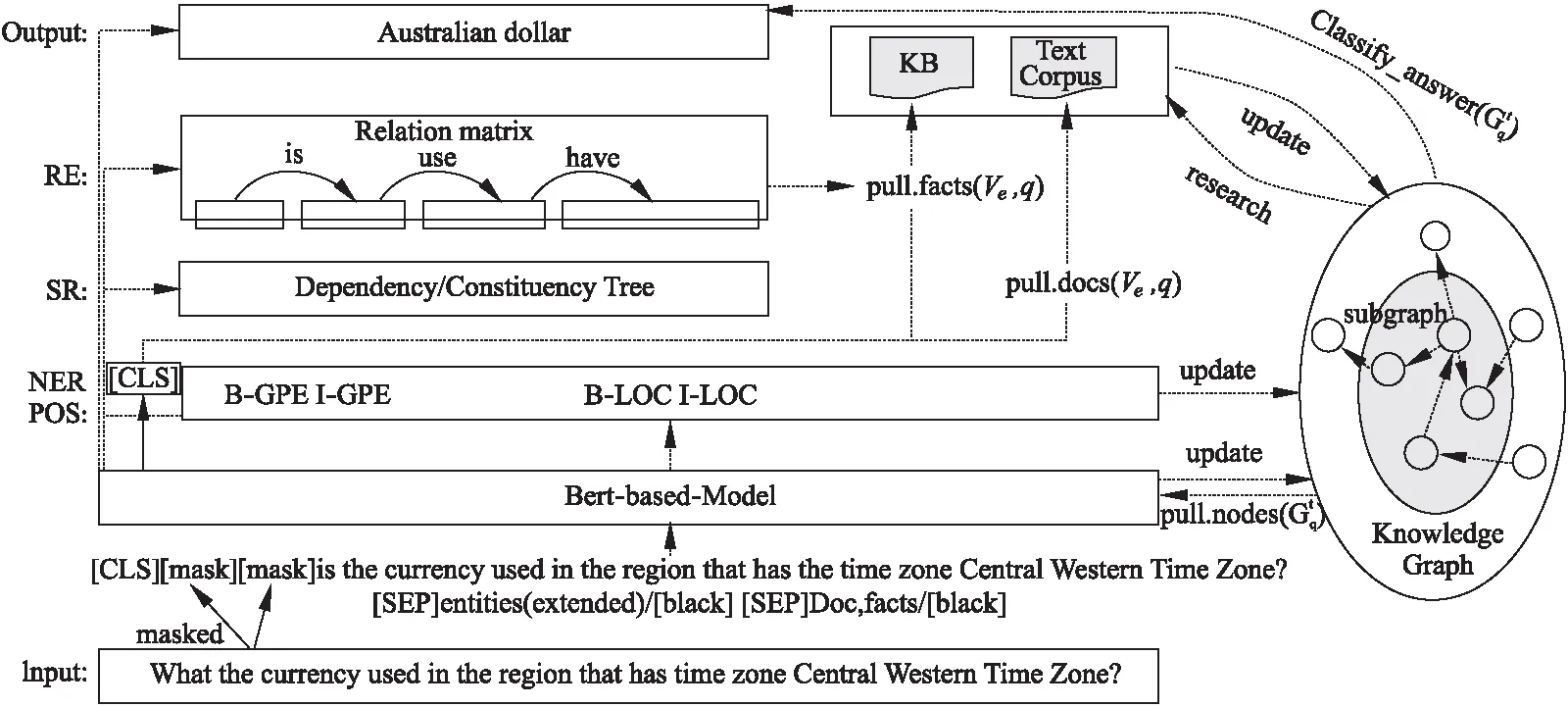

為了解決上述問題,我們提出了一種稱為UTMCQA(Uniform Multi-task Trainable framework for Complex Question Answering)的新框架.我們不假定信息在知識庫或文檔中,而是復合的,并且假設一個子圖對應于一個問題.圖1給出了UTMCQA框架概述.針對挑戰1,我們使用預訓練模型Albert[14]統一訓練命名實體識別,句法分析,關系分類等主要任務,使各個模塊中的信息相互作用,從而學習到復雜問句中的豐富語義信息;針對挑戰2,我們在GraphNet[12]的基礎上,采用BERT模型分析問題,結合語義相似從知識庫和文本庫獲取問題相關的實體或句子,并根據其關聯關系構建并迭代更新問題的圖模型;最后根據構建的子圖在一定范圍內選擇問題的最終答案.

本文在公開的大規模復雜問題數據集ComplexWebQuestion[15]上測試UTMCQA框架.實驗表明,相較于其他模型,本文提出的問答框架UTMCQA在多個場景設置下均取得了最好的效果,并且驗證了命名實體識別,句法分析,關系抽取等自然語言任務對框架的提升作用.本文的主要貢獻包括:1)使用預訓練語言模型(ALBERT)在同一語義空間統一訓練命名實體識別,句法分析,關系抽取等任務;2)結合語義相似獲取知識庫和文本中的相關實體信息;3)在統一的語義空間進行子圖更新和擴展;4)在大規模公開復雜問題數據集ComplexWebQuestion上的不同場景下的實驗效果均有較好提升.

2 相關工作

問答系統的關注熱點由簡單單跳問題轉移到了復雜的多跳問題.基于模板的方法[4,5,16]查詢速度快,有良好的可解釋性,但是復雜問題往往有多種表達形式,需要建立龐大的模板庫,這個過程人工開銷很大.語義解析技術為復雜問題構造語義分析樹或等價查詢結構.Hu[7]通過狀態轉移的方法把一個復雜問題轉化為一個查詢圖,通過匹配潛在的知識圖譜獲得問題的答案.Luo[8]使用神經網絡對復雜查詢圖的完整語義進行顯式編碼來處理復雜問題任務.Sun[17]用骨架語法來表達復雜問題的宏觀結構,從而生成更精確的依賴關系來提高下游的語義解析任務.但語義解析的方法通常依賴于句法類似的依賴關系.分割階段和語義分析階段都存在錯誤積累.問題分解技術是應對復雜問題更為直觀的策略.Talmor[2]和Min[18]等人將原始問題構建為多個跨距并利用端到端的深度神經網絡模型訓練.這些工作通常通過人類注釋的監督學習或者啟發式算法生成子問題,但收集分解標記并不容易,Perez[10]探索了無監督的方法來生成子問題.關注到子問題回答順序的隨意性會導致搜索空間大,漏掉答案的風險高,Zhang[19]通過優化這些順序進一步改善了問答的性能.Zhang[9]在嵌入空間拆分問題,然后通過語義解析分裂問題轉化為結構化SPARQL查詢.而目前大部分系統并沒有關注問題中豐富的語義信息,我們利用預訓練模型Albert統一訓練命名實體識別,句法分析,關系檢測等多個任務,在一定程度上解決了單個任務出錯引起的錯誤傳遞問題,并將學習到的復雜問題中的豐富語義信息應用到下游子圖構建任務.

聯合知識庫和文本庫是提升復雜問答推理的有效形式Das[11]將Universal Schema[20]擴展到QA的應用當中,將兩個不同來源的信息分別編碼放入Memory Networks[21]中,以處理文本與知識庫組合中的大量事實.GRAFT-Net[12]將知識庫實體和文本放入同一個子圖,利用圖表示學習網絡,訓練單個基于Graph-CNN的模型以從子圖中提取答案.PullNet[13]類似于GRAFT-Net,使用一個迭代過程來構造一個包含問題相關信息的特定于問題的子圖,之后使用另一個圖CNN從子圖中提取答案.然而對于知識庫或文本庫中相關的句子或事實,現有算法大都是通過基于詞頻的方式發現,并不能應對復雜問答存在的復雜語義和復雜關系.我們利用語義相似作為啟發信息,在統一的語義空間中進行分析和計算,并通過隊列算法動態地結合上游任務的語義信息進行子圖擴展,最后在圖的廣度范圍進行答案選擇,解決了不同訓練過程帶來的語義融合困難的問題.

3 模 型

3.1 任務定義

我們的目標是學習一個模型,對于給定的一個復雜問題q=(w1,…,w|q|),其中wi(1≤i≤|q|)表示復雜問題中的單詞;從知識庫K=(V,E,R)和文本庫D={d1,…,d|D|}獲取答案{a}q.其中V,E,R分別表示實體、關聯、關系集合,di=(w1,…,w|di|)表示包含v∈V的句子;關聯e∈E,表示為(vs,r,vo)三元組,其中vs,vo∈V,r∈R.

本文中為了獲取答案:1)基于BERT模型學習問題q及其相關句子的語義特征,主要任務包括命名實體識別、句法分析、關系抽取等.給定問題q=(w1,…,w|q|),以及查找到的與問題q相關的候選實體集合Vq=(v1,…,v|v|)和候選句子集合Dq=(d1,…,d|q|),構造輸入模型的數據格式為:[CLS]w1…w|q|[SEP]v1[#]…[#]v|v|[SEP]d1[&]…[&]d|q|,其中Vq包含的實體之間使用token“[#]”作為分割符,Dq包含的句子之間使用token“[&]”作為分隔符.同時在訓練時,用與答案等長的“[mask]”串對問題q=(w1,…,w|q|)中的疑問詞進行替代填充;2)根據問題q的語義特征從知識庫K=(V,E,R)和文本庫D={d1,…,d|D|}中獲取相關實體或句子,并根據其關聯關系構建并更新問題q的圖模型Gq=([Kq,Dq,vq],Eq);3)根據Gq選擇最終答案.整個過程均由可以訓練的模型組成,具體如圖1 UTMCQA模型所示.為此,我們將分3部分介紹UTMCQA模型:語義分析部分、圖模型構建部分、答案選擇部分.

注:NER、POS、SR、RE分別表示命名實體識別、詞性標注、句法分析、關系抽取,多個任務共享底層Bert;最右邊表示迭代地從問題、知識庫和文本庫中獲取實體、事實和句子以更新問題子圖,并從子圖中選擇問題的最終答案.

3.2 語義分析

將復雜問題中多重或隱含的信息識別出來并不容易,為此我們采用預訓練模型BERT作為基礎編碼器,并在其上構建可訓練的多任務模型(多個任務共享底層BERT,并各自有自己的上層網絡和損失函數)以更好地學習復雜問題所包含的豐富語法及語義信息,為構建和擴展面向復雜問題的圖模型提供啟發信息.具體請參考模型結構圖2 “What is the currency used in the region that has time zone Central Western Time Zone?”的語義分析構圖.下面,我們按照問題q的語義特征提取流程分別介紹相關處理.

注:ner表示實體,pos表示實體詞性;實體間關系、實體間句法依賴、實體間成分依賴分別用實線箭頭、虛線箭頭、方形標示出.

3.2.1 命名實體識別+詞性標注

在復雜問答中,命名實體識別(Named Entity Recognition,NER)和詞性標注(Part of Speech,POS)均扮演著重要角色,很多問答出現錯誤都與該任務密切相關,一旦NER或POS發生錯誤,后續的處理也會隨之產生級聯誤差;然而,目前的復雜問答算法并沒有專門將以上兩個任務作為必備的訓練任務,而是利用外部系統(如Stanford NER,NLTK)進行識別,通常情況下此類通用的外部系統得到的識別結果中存在不少錯誤,其會大大降低復雜問答系統的性能.鑒于此,我們在框架中融合了命名實體識別和詞性標注任務:

Oner/pos=CRF(BiLSTM(tanh(H[1],…,H[|q|]))

(1)

其中,H[1],…,H[|q|]表示問題q中所有單詞的BERT輸出,tanh,BiLSTM,CRF分別表示tanh函數,雙向LSTM(Bidirectional LSTM),條件隨機場.我們將這兩個任務和后續的問答任務一起訓練,此任務需要預先人工標注出句子中的命名實體和詞性以提供監督信息,損失函數采用交叉熵損失函數.

3.2.2 句法分析

在復雜問答中,句法分析對于判斷問題的復雜邏輯關系,有著重要的啟發作用,其中依賴樹(Dependency tree)和成分樹(Constituency tree)尤為重要,因此讓模型學習到句子中詞與詞之間的句法依賴關系以及不同詞扮演的不同成分對正確回答問題有很大幫助.在這里,我們按照 HPSG[22]的做法將兩者以Joint Span的形式定義span scores和dependence scores作為學習目標,句子中的詞經過BERT模型的輸出作為句法分析網絡的輸入,并用現有句法解析工具的結果作為監督信號(現有的句法解析工具可以標示出詞之間的關系以及每個詞的成分),具體計算過程如下:

relss=tanh(concat([H[i]-H[j],H[i]+H[j]]))

(2)

s(i,j)ss=sigmoid(linearss(relss))

(3)

s(i,j,l)ss=[s(i,j)ss]l

(4)

(5)

relds=concat([tanh(H[i]),tanh(H[j]),tanh(H[i]WH[j])])

(6)

s(i,j)ds=sigmoid(lineards(relds))

(7)

s(i,j,l)ds=[s(i,j)ds]l

(8)

其中ss為span-score的簡寫,ds為dependence-score的簡寫,s(i,j)span-score,s(i,j,l)span-score,s(T)span-score分別表示BERT輸出H[i],H[j]之間,標注為l及其整個樹T的跨度分數;同樣的,s(i,j)dependence-score,s(i,j,l)dependence-score分別表示H[i],H[j]之間及標注為l的依賴性得分,linearss和lineards表示線性函數.對于句法關系訓練的loss函數有如下定義:

(9)

loss(θ)ds=-(logPθ(H[parent]|H[child])+logPθ(l|H[parent],H[child]))

(10)

loss(θ)syntactic=loss(θ)ss+loss(θ)ds

(11)

3.2.3 關系抽取

在復雜問答中,一個問題往往包含實體之間多重或者隱含的關系,而這些關系可以深刻揭示問題的答案線索或答案本身.為此,我們以關系抽取作為復雜問答的重要線索,讓網絡能夠學習到實體間豐富的關系,此任務也需要人工預先標注出句子中實體詞之間的關系作為監督信息,類似的,此任務也以BERT模型的輸出作為關系抽取網絡的輸入,具體的計算過程如下:

relre=concat([Maxpool(H[1],…,H[|ve1|]),

Maxpool(H[1],…,H[|ve2|]))

(12)

H[ve1,ve2]=linearre1(tanh(relre)

(13)

(14)

(15)

3.2.4 語義相似

對于知識庫K或文本庫D中與問題q相關的句子或事實fact,現有算法大都通過實體鏈接系統發現,并按照IDF相似度將之排序并獲取TOP N的數據[13].但這種基于詞頻的算法缺乏對句子的深度理解,不足以處理復雜問答中所存在的不同語義和復雜關系的問題.為此,我們增加定義了可訓練的語義相似作為IDF的啟發信息,通過網絡來自適應地計算問題和事實之間的相似度:

simq=linearsim(tanh(H[q]))

(16)

simfact=linearsim(tanh(H[fact]))

(17)

(18)

其中,H[q],H[fact]分別是問題q和相關句子或事實fact的通過BERT編碼之后的句首輸出,cos是余弦相似度函數,損失函數采用均方誤差函數.

3.2.5 問答鏈接

復雜問答最終是對各種實體選擇問題的答案進行排序,本文引入問答鏈接來表征問題q與備選實體v之間的距離或相似度,并以語義相似作為啟發信息,具體定義如下:

linkqm=relu(linearlink(H[qm]))

(19)

linkv=relu(linearlink(H[v]))

(20)

(21)

3.3 圖模型構建

以問題q為中心,將知識庫K和文本庫D中與問題q相關的事實或句子,按照相互關聯關系,構建成問題q的圖模型Gq=([Kq,Dq,vq],Eq),其中圖模型的節點Kq,Dq,vq分別表示知識庫K,文本庫D及問題q中的事實、句子和實體,邊Eq則是它們之間的語義相似,問答鏈接或關系等產生的高相關度的關聯.

一般地,圖模型主要按照如下流程建立[12,23]:

2)按照圖相鄰關系,更新節點表示:

(22)

其中,Nr(v)表示實體v的入度節點,φ表示轉換函數,一般為神經網絡模型,每一次根據當前節點上一次的表示以及鄰居節點的表示來更新當前節點的表示,本文在此基礎上進行改進.

3.3.1 節點初始化

在復雜問答場景中主要涉及到3類節點(實體,句子,事實),本文均使用BERT模型的輸出作為節點的初始化表示:

其中,H[q]表示問題q,H[v]表示相關實體,H[fact]表示相關句子或事實;H[q]是問題經過BERT編碼后的句首輸出,H[v]是實體的BERT輸出經過Maxpool池化后得到的表示,H[fact]則是句子或事實的BERT的句首輸出,OX表示問題q經過語義分析后得到的啟發信息,例如關系抽取,句法分析等內容,具體的,這里將語義分析得到的輸出序列做Maxpool作為Ox.

3.3.2 節點更新

節點更新分為兩種類型:一種是實體更新,一種為句子更新,我們參考Graftnet[12]更新方式.但是,不同于Gq的鄰接矩陣,本文將各種語義分析的啟發信息合并到節點更新的過程中.

3.3.3 節點擴展

節點擴展即根據圖模型中的現有節點通過知識庫K和文本庫D中相關的事實或句子擴充圖模型的過程.假設Hexp是待擴展實體[exp]的Bert輸出,H[q]和H[fact]分別代表問題q和相關的句子或事實fact的BERT句首輸出:

1)獲取知識庫K中事實和文本庫D中句子fact:

(23)

Okb-ranking=affine(BiLSTM(Okb-scores))

(24)

而排名結果Okb-ranking則是將Okb-scores通過BiLSTM(Bidirectional-LSTM)和affine仿射函數映射到排名列表中得到.同時,我們定義了可微分的Triple Loss函數來學習排名:

(25)

(26)

2)選擇擴展節點:

算法.節點擴展(包含節點擴展中1)和2))

a) 經過如上步驟1)之后,首先對獲得的事實和句子進行NER,POS,RE,SR分析;

b) 建立隊列并更新:

對象隊列Oqueue:按照問題q中包含命名實體(包括普通實體)、名詞、動詞、疑問詞、形容詞(一般級,比較級,最高級)的基本順序分別建立隊列;將a)步驟中通過NER,POS分析出的命名實體、名詞、動詞、疑問詞、形容詞分別插入到它們相應的隊列中;

關系隊列Rqueue:遍歷問題q和a)步驟后獲得的句子經過RE分析后所得到的關系集合,按照每個關系中涉及的兩個實體索引以上對象隊列,并根據關系的方向性加入到每個實體對應的鏈表中:如,“Central Western Time Zone”與“Region”存在“Entity-Have”關系,則對象隊列中“Region”增加指向“Central Western Time Zone”的鏈表項;

句法隊列Squeue:將問題q和a)步驟后獲得的句子進行SR分析得到的依賴和成分關系添加到對象隊列中:其中依賴關系按照有向關系處理,參考關系隊列方式;而成分關系是無向關系,則對相應對象都添加鏈表項;

如隊列初次建立,則以上所有隊列和鏈表項都包含一個visited_time數據,初始值為0;

選擇擴展節點:

引入:問題q的覆蓋度是對象隊列,關系隊列,句法隊列中涉及問題q的隊列和鏈表項目中visited_time非零的項目個數的加權累加,wo、wr、ws是加權系數,counter計算隊列非零項目的個數:

Cover(Gq)=wocounter(Oqueue)+wrcounter(Rqueue)+wscounter(Squeue)

而Cover(Gq,v)表示增加訪問實體v后,問題q的最大可能的覆蓋度.

定義(覆蓋增益):

Gaincover(Gq,v)=Cover(Gq,v)-Cover(Gq)

表示由于增加了增加訪問實體v后,比原來覆蓋度增加的數量.

ⅰ.將待擴展實體按照覆蓋增益排序,選出Top N個實體,按照順序并根據隨機概率α=0.15選擇實體,選擇后實體所對應的Oqueue、Rqueue、Squeue相應的項目或鏈表visited_time 加1;

ⅱ.如果覆蓋增益小于一定閾值ξ或者Oqueue隊列長度大于一定閾值ζ時,則進行答案選擇;

ⅲ.否則,進行步驟1).

3.4 答案選擇

答案選擇是在一定范圍內,即圖模型Gq廣度范圍內,選擇實體集合中最優的實體,作為問題q的最終答案.對圖模型Gq中涉及的實體集合進行排序與上節中語義分析中的問答鏈接相同,此處不再贅述.

4 實驗及結果分析

4.1 實驗數據

為了防止訓練集到測試集的數據泄漏問題,我們在改進的數據集ComplexWebQuestion version 1.1[15]上驗證我們的想法,其中包含34689個示例,數據集按比例(8∶1∶1)劃分為27734個訓練樣本/ 3480個驗證樣本/ 3475個測試樣本,每個樣本中包含了問題、答案,Web片段和SPARQL查詢.該數據集包含4種類型的復雜問題:組合型(46.7%)、合并型(42.4%)、最高級類型(5.3%)和比較級類型(5.6%).每一個問題要么是兩個簡單問題的組合,要么是一個簡單問題的延伸.

4.2 評測標準

我們使用Precision@1(P@1)作為評估指標來測試我們的框架處理復雜問題的性能.即返回的最高得分的答案是否與正確答案之一匹配.

4.3 實驗設置

本文在涉及到多跳的數據集上進行實驗,并使用知識庫Freebase(version 2015-08-02)和文本庫(來自數據集Web Snippet)結合的基礎信息一起完成推理.為了加快訓練速度,對Freebase進行預處理,過濾掉所有不包含ComplexWebQuestion中實體或關系的三元組.我們的模型使用Adam算法[24]進行參數更新,學習率設置為0.0001,dropout設置為0.2,batchsize設置為{10,30,50},本文選擇Albert-base[14],輸出維度768.BilSTM設置為1層,linearss是1536×1的全連接網絡,lineards是2304×1的全連接網絡.關系抽取中Maxpool選擇128個768×3的kernel,linearre1和linearre2分別是128×64和64×1的全連接網絡,linearsim和linearlink均為768×384的全連接網絡.

4.4 實驗場景及基準模型設置

為了提高算法的泛化能力,貼近現實場景,我們參考PullNet[13]將實驗分為3種測試場景:知識庫K測試場景,文本庫D測試場景,知識庫K和文本庫D混合測試場景.考慮到知識庫的規模和實驗速度,本文在知識庫和文本庫混合場景下,只使用了50%的KB.

我們選擇KV-Mem(記憶網絡,Key-Value Memory Networks[25]),GRAFT-Net[12],PullNet[13]等作為基線測試模型,所有模型都支持如上3種測試場景:KV-Mem將句子或事實編碼后,形成Key-Value結構;Graft-Net 和PullNet以IDF 相似度獲取文本庫中的句子,使用PageRank-nibble算法[26]獲取知識庫中的事實;而我們的UTMCQA模型則是結合語義相似來動態獲取相關實體和句子信息.

4.5 實驗結果分析

本文的實驗主要基于ComplexWebQuestion數據集進行模型的測試,并選擇了KV-Mem,GraftNet,PullNet這3個基準模型進行對比.其中KV-Mem,GraftNet這兩種模型能夠放入內存的事實和文本的數量上都是有限的,通過表1注意到KV-Mem較其他模型表現較差,我們認為KV-Mem可以很方便的對先驗知識進行編碼,對鍵值的關注是在記憶上規范化的,這些記憶是KB事實(或文本句子),因此模型無法在同一時間為多個事實分配高的概率,從而在復雜問題上表現較差.而UTMCQA和PullNet類似,均能擴展子圖模型,從而包含更多的信息進行答案選擇.表1實驗結果表明:在不同知識庫和文檔成分的數據上的實驗,本文提出的方法相比于其他模型取得了更好的結果.

通過對比兩種信息來源的區別得出,知識庫是高度規則化結構化的知識,模型比較容易學習,而文本庫雖然蘊含豐富信息但是由于自然語言表達的復雜多樣性,其中的知識模型不易學習到,因此,單純使用知識庫(表1第1列)是要比單純使用文本庫(表1第2列)效果要好;但是也能看到,在50%的知識庫上添加文本庫,模型的效果得到了提升,這說明文本庫也可以作為知識庫的補充,以進一步提升模型性能,符合我們的預期;另外,只使用50%的知識庫(表1第3列)時,模型的效果并沒有降低50%,這可能是因為知識庫涵蓋的知識范圍太大,而其中大部分知識可能與問題無關,因此下一步可以考慮針對具體任務和問題對知識庫中的知識進行過濾.

其次,通過對比其他模型,UTMCQA加入命名實體識別、句法分析、關系抽取任務后,模型在兩個信息源上的效果均得到提升,這說明本文選取的輔助任務確實可以普適性地提升模型對文本的深層次理解,有助于模型在后續階段正確地回答問題.

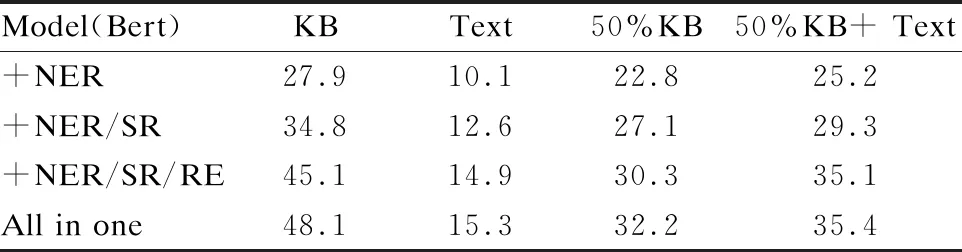

為了更好地判斷各個模塊對模型的影響,我們在BERT輸出的基礎上把UTMCQA框架中涉及語義分析的任務做了統一的消融實驗,分別設置如下實驗:僅進行命名實體識別任務(表2第1行),進行命名實體識別和句法分析任務(表2第2行),進行命名實體識別、句法分析和關系抽取任務(表2第3行),任務全部涉及(表2第4行).數據表明,命名實體識別,句法分析,關系抽取等對模型提升都是有貢獻的,各模塊完全整合的模型比缺失模塊的模型性能更好.通過進一步的分析,我們得出以下結論:1)知識庫越完備,模型的效果提升越高,說明引入外部的結構化知識庫有助于回答復雜問題;2)加入句法分析和關系抽取后的模型性能有提升,這也表明了復雜問句中的深層語義信息對于推理出復雜問題的答案有很大幫助.

表2 基于BERT模型上的多任務消融實驗結果

4.6 錯誤分析

我們隨機挑選了100個UTMCQA框架在ComplexWebQuestion數據及上測評時P@1=0的問題.發現并總結出如下幾類難以處理的問題類型:窮舉類問題(54%):如“what countries fall in Eastern Europe and the country calling code is smallest?”其需要先列舉出東歐地區的城市再進行相關計算,而本系統傾向于少量手工,缺少一些預定義規則來學習此類問題.否定類問題(12%):如“What music genre was don′t by the singer who wrote the song Whatever Gets You Through the Night sing?”此類問題的答案往往傾向于肯定回答而非否定.其他(32%):無約束類型,如“Which country with a population of 10,005,000 speaks Portuguese ? ”;少部分問題沒有檢測到實體,以及一部分聚合問題;編碼錯誤等.

5 總 結

本文通過預訓練模型BERT統一訓練了命名實體識別,句法分析,關系抽取等任務,并將語義相似作為啟發信息尋找知識庫和文本庫的相關實體,通過隊列算法動態擴展子圖,最后在子圖的廣度范圍內,選擇實體集合中最優的實體,作為最終答案.實驗結果表明,與現有的解決方案相比,本文的UTMCQA框架具有更強的表達能力,在精度上優于最新的競爭對手.未來我們將針對錯誤分析中的錯誤類型,設計更多的啟發式算法,改進模型的性能.