基于YOLO算法的無人機航拍圖像車輛目標檢測系統(tǒng)研究*

向昌成 黃成兵 羅 平 王 朋

(阿壩師范學院計算機科學與技術(shù)學院 汶川 623002)

1 引言

隨著無人機技術(shù)在生活中應(yīng)用的不斷深入,航拍在軍事偵察、交通管制、國土資源、環(huán)境監(jiān)測等軍事與民用領(lǐng)域有著十分廣闊的應(yīng)用前景[1]。其中地面車輛目標檢測技術(shù)作為智慧城市重要組成,為智能交通系統(tǒng)感知外界環(huán)境提供基礎(chǔ)。城市車輛數(shù)量的增加催生我國智慧交通發(fā)展與構(gòu)建。對于智慧城市交通的構(gòu)建,通過航拍手段完成對車輛目標的跟蹤與定位作為主要技術(shù)研究點,該點技術(shù)可以更加準確地傳遞城市交通信息與交通情況。

針對無人機航拍圖像地面車輛目標實時檢測問題,傳統(tǒng)的SIFT算法復(fù)雜度高,處理時間長,難以滿足實時性的要求。基于文獻[2]可知,通過SIFT算法可以將矩形區(qū)域內(nèi)的特征點進行成像,通過降維處理實現(xiàn)對相似度與距離、余弦相似度等數(shù)據(jù)的匹配,然后基于RANSAC算法完成對錯誤匹配點的剔除,改進的SIFT算法在尺度縮放、旋轉(zhuǎn)、光照等情況下均有良好的匹配效果,該改進算法針對大視角變換誤匹配率還比較高[2]。文獻[3]著重針對地面車輛目標的自動監(jiān)測效果進行研究,通過固定的無人機平臺與無人機實際姿勢情況進行控制,明確像素面積范圍以及特征目標內(nèi)的數(shù)學形態(tài),進而對現(xiàn)場所出現(xiàn)的疑似目標進行剔除與更加準確的甄選,提高系統(tǒng)對于整體疑似目標的判斷與追蹤效果,算法可靠穩(wěn)定具有很好的魯棒性,但系統(tǒng)的準確率不高[3]。文獻[4]將視覺注意力機制中的顯著性模型同DPM相結(jié)合,對目標區(qū)域內(nèi)的檢測干擾情況進行排除,進而有效地縮小特征取值范圍,解決圖像中不同尺寸車輛目標檢測的問題,但目標的檢測率不高[4]。文獻[5]中針對航拍圖像與實際車輛目標進行追蹤處理,通過手工標注的方法確定整個道路區(qū)域內(nèi)的標準情況,然后針對區(qū)域內(nèi)的閾值分割方法進行控制,然后針對弱小的車輛目標進行檢測,有效地解決遙感圖像道路內(nèi)的分割困難情況,在弱小車輛難以出現(xiàn)檢測問題的時候應(yīng)當對目標進行提取與控制[5]。在對目標特征提取與檢測的過程中要注意對特征訓練的分離,而在這個過程中,由于人工提取的特征不足,就會導(dǎo)致信息之間的分類無法恢復(fù),從而無法達到深度學習以及主流檢測的效果,也就不能滿足檢測與識別需求,因此,現(xiàn)階段深度學習就成為了主流方式內(nèi)容[6]。通過交通視頻可以準確地識別實際車況與道路情況,從而在應(yīng)對眾多因素影響的條件下保證其識別精度與檢測效果[7]。深度學習的物體檢測方法大致可以分為兩類:第一類是基于區(qū)域建議的目標檢測算法,也就是Faster RCNN[8];第二類是基于回歸的目標檢測算法,主要代表算法是Faster RCNN[9]。深度學習的卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,CNN)以其局部感知權(quán)值共享的特點,成為目標檢測領(lǐng)域的核心算法之一,使得深度學習算法在很多應(yīng)用場景替代了傳統(tǒng)的目標檢測算法。基于區(qū)域建議的目標檢測算法RCNN中將CNN的思路引入到檢測內(nèi)容中,針對高魯棒性模型的訓練完成對目標區(qū)域內(nèi)的檢測效果,保證檢測區(qū)域的主流性,而通過RCNN的實行可以在樣本信息中提取出神經(jīng)網(wǎng)絡(luò)樣本,在無法更新的條件下實現(xiàn)對獨立網(wǎng)絡(luò)以及判斷結(jié)果的輸出控制,進而保證YOLO的核心檢測思想與檢測速度,降低無減率,而在YOLO的特點中,小目標效果本身存在一定的缺點,為了有效地改進這些缺點情況,基于文獻[10]的內(nèi)容可知,通過RPN結(jié)構(gòu)可以完成SSD結(jié)合網(wǎng)絡(luò)模型的建立與訓練[10],而針對目標精度情況來看,測試速度與實際測試精度之間有所差異,因此就如同文獻[11]中的內(nèi)容,基于YOLOv2的網(wǎng)絡(luò)構(gòu)架中,檢測精度與速度是基于檢測方法與訓練條件而生成的,而在訓練過程中由于通過算法YOLO9000完成檢測[11],因此可以更好地實現(xiàn)實時檢測效果。根據(jù)物體檢測過程中RCNN系列的高精度模式來看,檢測速度與精度相較于Faster-RCNN更低,但是YOLO在使用過程中由于其速度的優(yōu)勢,在嵌入式系統(tǒng)的實現(xiàn)中使用更方便。

針對無人機航拍圖像中的車輛目標檢測問題進行研究,有研究人員應(yīng)用SSD方法是車輛目標檢測[12],網(wǎng)絡(luò)劃分思想是基于卷積網(wǎng)絡(luò)中的多個尺度內(nèi)容進行預(yù)測控制的,在不同尺寸目標中,一定程度上為了實現(xiàn)對目標精度的提高,就需要進行分類預(yù)測,但算法在TensorFlow運行環(huán)境搭建,不能實現(xiàn)實時運行處理。文獻[13]針對YOLO算法進行對多尺度特征層的檢測與處理,在原基礎(chǔ)上進行檢測與設(shè)計,通過對網(wǎng)絡(luò)模型的訓練與不同方法速度的控制,檢測得出高準確率與高召回率的車輛目標效果。對于一些遮擋嚴重的車輛,檢測效果尚未達到最佳[13]。文獻[2]將深度學習算法YOLOv2引入混合交通的車流量檢測中,并在嵌入式平臺RK3399上實現(xiàn)了該算法。由于YOLOv2是NVIDIA Titanic-X GPU中實時檢測的主要算法流程,但是根據(jù)RK3399中的長時間檢測算法,可以進一步調(diào)整其檢測速度與算法的效果[14]。因此,本文在保證一定檢測效果的同時降低了計算時間,滿足實時處理的要求,以YOLOv3目標檢測網(wǎng)絡(luò)為基礎(chǔ)實現(xiàn)地面車輛目標檢測技術(shù),在GPU服務(wù)器上對地面車輛目標進行離線訓練,通過自學習和迭代優(yōu)化網(wǎng)絡(luò)神經(jīng)元權(quán)重,并進行合理的參數(shù)調(diào)節(jié)以自動學習車輛特征,得到針對特定應(yīng)用場景的網(wǎng)絡(luò)模型;然后在嵌入式GPU平臺上部屬訓練好的網(wǎng)絡(luò)模型,進而完成對無人機地面車輛目標的自動檢測與識別,提高無人機航拍精度,并在基于GPU的嵌入式GPU系統(tǒng)上對1080P的高清航拍視頻達到實時處理的應(yīng)用。

2 YOLO v3目標檢測網(wǎng)絡(luò)模型

針對無人機航拍圖像與車輛的實際目標目的來看,優(yōu)先采取YOLOv3檢測算法作為地面車輛目標算法,在大尺度變化條件下應(yīng)當針對地面車輛的實際高度與尺度變化情況進行控制,對檢測算法的尺度不變性要求較高,同時,地面車輛目標在無人機航拍大視場圖像中屬于小目標,特征提取的質(zhì)量則直接影響分類器是否能找到目標。YOLOv3在解決這些問題上具有優(yōu)勢,YOLOv3在多個尺度的特征圖上檢測目標,能減弱目標尺度變化對檢測性能帶來的影響。傳統(tǒng)的YOLOv3的網(wǎng)絡(luò)架構(gòu)如圖1所示。

YOLO本身屬于回歸問題,而以小網(wǎng)格的形式實現(xiàn)對圖片的劃分,進而預(yù)測不同目標邊框,有效的S*S*(B*5+C)個張量。基于YOLO在圖1中所呈現(xiàn)出的流程架構(gòu)圖,每個小網(wǎng)格中所預(yù)測的概率大概在20類左右,而基于一張圖像可以完成對圖像的980個概率預(yù)測,49個網(wǎng)格中的大部分區(qū)域內(nèi)是沒有物體的,因此圖像本身在大部分區(qū)域內(nèi)的預(yù)測概率就為0,在長期變量的條件下,對這些問題的解決,可以保證在不同位置中物體存在概率的確定,其概率為Pr(Object)。從某區(qū)域內(nèi)的實際情況來看,在不同概率的預(yù)測中,某一位置的非條件性預(yù)測概率為Pr(Object)與條件概率的乘積。pr(〖class〗_i)=pr(〖class〗_i|object)*pr(object)針對不同位置情況來看,Pr(Object)的更新應(yīng)當基于物體本身存在的Pr(Dog|Object)進行更新。而在最后一層預(yù)測網(wǎng)絡(luò)概率與邊框情況來看,基于邏輯激活函數(shù)條件,對于其他層來說,主要使用ReLU函數(shù)。YOLO的網(wǎng)絡(luò)損失函數(shù)是基于平方誤差進行表示的,通過對尺度因子λ的引入,提高對類概率與邊框誤差的加權(quán),進而更好地反映出大邊框補償條件下的影響效果。

圖1 YOLOv3的網(wǎng)絡(luò)模型

2.1 k-means的錨節(jié)點聚類算法

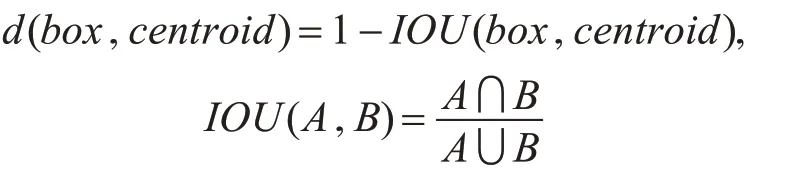

YOLO算法和Faster RCNN算法在訓練過程中,使用了錨節(jié)點機制進行目標的初步預(yù)測。Faster RCNN算法需要手動設(shè)置錨節(jié)點框的尺寸大小和個數(shù)作為網(wǎng)絡(luò)的訓練參數(shù),而YOLO通過對訓練數(shù)據(jù)集使用k-means聚類算法,得出錨節(jié)點框的尺寸大小和個數(shù),送入網(wǎng)絡(luò)進行訓練,使得網(wǎng)絡(luò)更容易學習到目標特征,網(wǎng)絡(luò)訓練時間得到大幅縮減。標準的k-means算法將距離作為聚類的準則,這使得大目標比小目標產(chǎn)生更多的錯誤,而本文采用k-means+YOLO聚類方法,對數(shù)據(jù)集中的目標大小進行聚類,來得到錨節(jié)點的預(yù)設(shè)置參數(shù)。使用如下的函數(shù)作為聚類的準則:

2.2 邊界框的預(yù)測

邊界框的預(yù)測跟YOLOv2中一樣,仍使用維度聚類方法,先在樣本上使用k-means聚類得到錨節(jié)點。使用邏輯回歸而不是Softmax對每個框進行分類,這是考慮到自然場景圖像中物體之間重疊很常見,使用Softmax在每一個框上只能給出最大的類別,導(dǎo)致重疊的漏檢,使用多個單獨的邏輯回歸(主要用到了sigmoid函數(shù))預(yù)測替代了之前的Softmax分類。最終有三個分支輸出做預(yù)測,輸出的特征圖大小分別為13*13,26*26,52*52,每個特征圖使用三個錨節(jié)點,13*13的特征圖使用(116×90)、(156×198)、(373×326)這三個錨節(jié)點;26*26的特征圖使用(30×61)、(62×45)、(59×119)這三個錨節(jié)點;52*52的特征圖使用(10×13)、(16×30)、(33×23)這三個錨節(jié)點。

2.3 檢測模塊

YOLOv3在三個不同的尺度上進行目標的預(yù)測,最后預(yù)測出三維的張量代表邊界框。在COCO數(shù)據(jù)集上,我們在每個尺度上預(yù)測的三個候選框的張量是N×N×[3*(4+1+80)]。共可以檢測80類目標。

3 實驗設(shè)計與實現(xiàn)

3.1 實驗數(shù)據(jù)集的獲取

使用無人機平臺對某城鎮(zhèn)附近場景進行視頻拍攝制作數(shù)據(jù)集。通過無人機可以實現(xiàn)對每隔1s提取一幀的視頻拍攝,而在3000張圖片中,拍攝的彩色圖片尺寸為1920×1080。在對圖片記性標記的時候選擇Labelimage軟件進行標記,每隔圖片所選用的文件格式為.xml。圖片數(shù)據(jù)集在增強之后,通過對圖片的數(shù)據(jù)量變換與訓練增強,保證圖片集本身的效果,提高網(wǎng)絡(luò)模型的泛化能力,并且通過增加噪聲數(shù)據(jù),提升網(wǎng)絡(luò)模型的魯棒性。本文主要使用的數(shù)據(jù)增強方法有旋轉(zhuǎn)、縮放、裁剪得到近30000張圖片,大小為1000×600。將27000張圖片作為訓練樣本,將其制作成voc數(shù)據(jù)集的格式。將剩余的3000張圖片作為測試集。

3.2 網(wǎng)絡(luò)模型訓練

在YOLO算法的骨架網(wǎng)絡(luò)Darknet-53使用正態(tài)分布初始化模型參數(shù)。在ubuntu操作系統(tǒng)下,基于darknet框架采用darknet53骨干模型和Xavier初始化方法,在imagenet1000分類數(shù)據(jù)集上進行預(yù)訓練,得到預(yù)訓練權(quán)重darknet53.con.74。然后,從訓練集圖片順序打亂,將訓練集的圖像輸入到網(wǎng)絡(luò)當中進行運算得到模型的預(yù)測結(jié)果,根據(jù)預(yù)測結(jié)果和真實標注值計算預(yù)測誤差,使用鏈式法則和反向傳播方法進行對誤差的求取,然后通過對參數(shù)梯度與下模型參數(shù)的控制,完成整體的訓練迭代過程。對以上步驟進行迭代,直到誤差收斂時完成訓練,保存模型參數(shù)文件(.weights文件)。

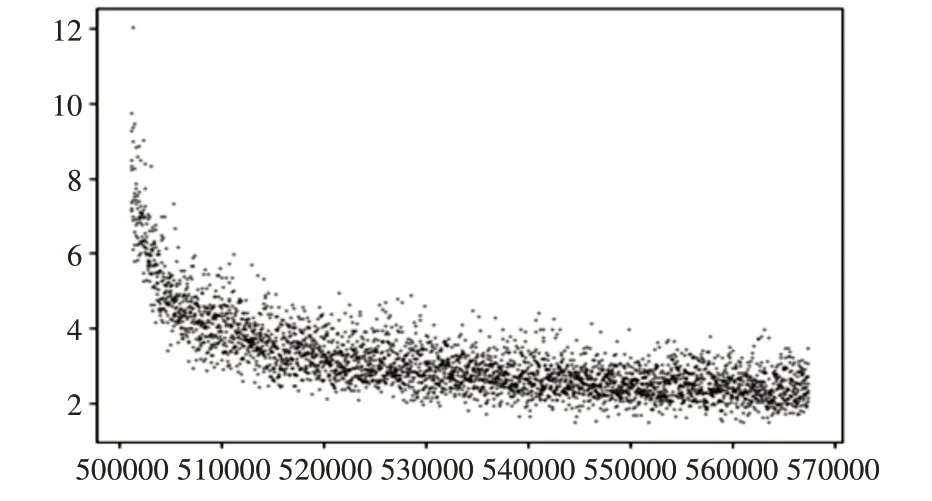

3.3 網(wǎng)絡(luò)參數(shù)的評估

每次訓練結(jié)束后,用測試集測試網(wǎng)絡(luò)的性能,將采用PASCALVOC07的評估方法評價檢測結(jié)果。保存結(jié)果在log.txt中,包含訓練epoch次數(shù),訓練誤差,學習率等。分析檢測評估結(jié)果,從網(wǎng)絡(luò)架構(gòu)、網(wǎng)絡(luò)參數(shù)、訓練流程等方面對網(wǎng)絡(luò)進行優(yōu)化式改進。最終挖掘網(wǎng)絡(luò)對地面汽車目標檢測方面的性能。經(jīng)過70000次訓練之后,損失在3.5左右不再變化,停止訓練。

圖2 網(wǎng)絡(luò)訓練損失函數(shù)趨勢圖

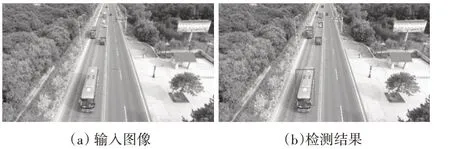

3.4 網(wǎng)絡(luò)檢測結(jié)果

將測試集圖像數(shù)據(jù)輸入到訓練好的網(wǎng)絡(luò)模型中,進行網(wǎng)絡(luò)性能測試。通過對主要準確度的評價,進行對準確度AP評價,明確其召回率與準確度對立關(guān)系,指標升降存在差異,而后對準確率與召回率曲線下的面積進行控制,為其算法指標準確度AP進行控制,在多個類別中完成mAP的平均值。AP@0.5為在IOU=0.5閾值時的指標。網(wǎng)絡(luò)測試結(jié)果為在IOU=0.5時的召回率83.25%和準確度67.14%,處理時間35.8ms。

圖3 基于YOLOv3網(wǎng)絡(luò)模型的檢測結(jié)果

4 硬件配置

4.1 網(wǎng)絡(luò)訓練服務(wù)器

深度學習開發(fā)平臺主要有GPU服務(wù)器組成,硬件配置為CPU:Intel Xeon Gold 5118(12核,2.3GHz),內(nèi)存:64G DDR 4,硬盤:512GB固態(tài)硬盤+4TB SATA,GPU:NVDIA TITAN V*2,顯示器:24英寸液晶顯示器*2。操作系統(tǒng):Windows7 SP1 64位、Ubuntu 16.04 lts,安裝cuda 10.1,cudnn 7.5.0并行計算庫,安裝Darknet環(huán)境。

4.2 網(wǎng)絡(luò)檢測嵌入式系統(tǒng)

本文檢測時采用NVIDIA TX2嵌入式平臺,它也可以作為一個可開發(fā)的工具箱,在硬件配置上,支持2.5Gbps/Lane的CSI攝像頭傳輸,支持與其他設(shè)備的802.11ac的無線連接和藍牙連接,配有8GB的內(nèi)存和32GB的外部存儲器。在性能上,NVIDIA TX2平臺包含了一個四核2.0GHz的64位ARMv8 A57處理器,一個雙核2.0GHz的ARMv8丹佛處理器,256核的Pascal GPU,6核心的處理器和GPU共享8G的內(nèi)存,可以面對不同的應(yīng)用場景需求。在以NVIDIA TX2平臺為核心的目標系統(tǒng)中搭建Darknet,植入最終訓練好的網(wǎng)絡(luò)參數(shù)文件,輸入無人機航拍的視頻圖像,運行YOLOv3算法,實現(xiàn)25幀/s的地面車輛目標識別與檢測。

5 結(jié)語

本文設(shè)計了一種基于YOLOv3深度學習網(wǎng)絡(luò)模型的無人機航拍圖像地面車輛的目標檢測嵌入式GPU系統(tǒng)。采用YOLOv3網(wǎng)絡(luò)模型目標檢測算法,在GPU服務(wù)器上實現(xiàn)了從輸入圖片到輸出結(jié)果的端到端的網(wǎng)絡(luò)模型訓練和優(yōu)化。首先在預(yù)設(shè)置參數(shù)階段采用了kmeans_YOLO聚類算法對數(shù)據(jù)集進行聚類,實現(xiàn)對錨節(jié)點參數(shù)的設(shè)置,然后采用了網(wǎng)絡(luò)特征提取框架,針對網(wǎng)絡(luò)訓練與預(yù)測速度進行加快,減少參數(shù)量,有效地實現(xiàn)對圖片的提取,得到最終訓練好的網(wǎng)絡(luò)模型,提高了地面車輛目標的檢出率,在IOU=0.5時的召回率為83.25%,準確度為67.14%。在NVIDIA TX2平臺上實現(xiàn)了25幀/s的檢測速率,基本滿足地面車輛目標檢測的需求。為以后深度學習的目標檢測在智能交通、智能安防和無人機上的應(yīng)用提供了基礎(chǔ)。