針對圖像盲去模糊的可微分神經網絡架構搜索方法

繆 斯,祝永新

(中國科學院上海高等研究院,上海 201210)

0 概述

圖像盲去模糊是在運動軌跡未知的情況下將模糊圖像轉變為清晰圖像的過程,在生活和安防等領域有廣泛的應用,例如修復拍攝時因手抖而模糊的照片,以及去除監控中物體的運動模糊,提升監控清晰度。圖像模糊分為兩種:均勻模糊和非均勻模糊。若圖像的各個像素運動軌跡相同(例如相機抖動),則稱為均勻模糊,反之若像素的運動軌跡不同(例如物體移動),則稱為非均勻模糊。

傳統的圖像去模糊方法,例如基于零范數先驗[1-2]、暗通道先驗[3-4]和LMS 自適應[5]的算法,通過交替估計清晰圖像和模糊軌跡去模糊。其中,模糊軌跡通常使用一個二維的卷積核表示。這種方法去除大面積的均勻模糊有很好的效果。然而,真實世界中的模糊大部分是非均勻的,使用二維的卷積核表示非均勻的模糊軌跡會有較大的誤差,因此傳統算法在去除非均勻模糊時表現欠佳。

近年來,神經網絡的方法在圖像復原領域的應用取得了較大進展。文獻[6]提出使用深度學習的方法提取特征圖,再利用模糊圖像和清晰圖像的特征圖估算模糊核。此后一些研究者開始探索不需要模糊核估計的端到端卷積神經網絡。文獻[7]提出了一個簡單的全卷積網絡用于去除文本圖像的模糊。文獻[8]提出了一個多層的神經網絡并將其運用于自然圖像處理。文獻[9]提出了基于LSTM[10]的多層神經網絡。文獻[11]提出了DeblurGAN,一種基于對抗生成網絡(GAN)[12]的去模糊神經網絡。盡管這些研究取得了不錯的實驗結果,但神經網絡的訓練仍然是一個難題,研究人員必須通過海量實驗選取最優的網絡結構。為解決該問題,一些研究者開始探索通過神經網絡架構搜索技術自動搜索出一個優質的去模糊神經網絡。

Google公司最早提出基于強化學習的NASNet[13]用于神經網絡架構搜索。NASNet 使用LSTM 作為控制器用于生成目標的網絡結構,并用目標網絡在驗證集上的誤差作為損失函數訓練控制器。然而,NASNet 每生成一個目標網絡都必須通過完整訓練并測試該目標網絡來評價該網絡的質量,這嚴重降低了NASNet 的搜索速度。NASNet 需要500 塊GPU訓練28 天才能在CIFAR10 數據集上取得不錯的實驗結果。為了加快訓練速度,文獻[14]提出可微分神經網絡架構搜索(DARTS)。DARTS 將網絡結構變為可微分的參數,使得網絡的訓練和架構的調優能夠同時進行,能夠一邊訓練一邊評價直至收斂,因此DARTS 可以在4 小時內在CIFAR10 上搜索出性能超過ResNet[15]的網絡。

目前,DARTS 多用于圖像分類問題,如行為識別[16],圖像識別[17-19]等,尚未應用于圖像去模糊領域。這是因為分類問題輸出的維度較少(僅為類別數),使用少于20 個卷積層的神經網絡(如VGG16[20])就可以取得不錯的效果,使用過深的神經網絡反而容易過擬合。而圖像去模糊問題對圖像細節要求高,淺層神經網絡無法清晰地恢復模糊圖像的細節,因此圖像去模糊一般使用超深的神經網絡,例如SRN-DeblurNet[9]和DeblurGAN[11]都擁有超過60 個卷積層。因此,將可微分神經網絡架構搜索技術應用于圖像去模糊領域的難度顯著大于應用于分類問題。此外,由于最初的DARTS 只考慮了分類問題,其搜索空間是專門為分類問題而設計的,輸出是維度等于類別數的向量而不是圖像,因此,DARTS 的搜索空間不能直接用于圖像去模糊。

本文將DARTS 應用于圖像去模糊領域,提出U型殘差搜索空間,并將搜索空間分割為9 個不同分辨率的單元,通過多尺度結構有效地提取圖像在不同分辨率上的特征,并通過殘差結構加快訓練和搜索的速度。最終將本文方法與UNet[21]、DeblurGAN等模型進行對比實驗驗證。

1 可微分神經網絡架構搜索

超邊結構是可微分神經網絡(DARTS)算法的核心,其基本結構如圖1 所示。

圖1 超邊結構的抽象圖Fig.1 Illustration of the superedge structure

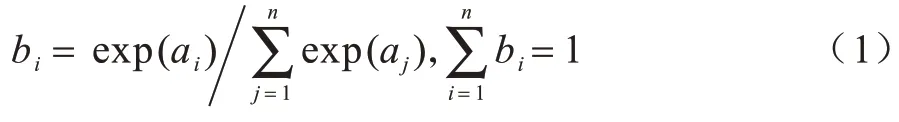

超邊結構包括n種可能的操作和n個結構參數。假設x為張量,θ為神經網絡的參數,簡稱“網絡參數”(如卷積核張量或全連接層矩陣),f1(x,θ),f2(x,θ),…,fn(x,θ)為n種可微分的運算(如普通卷積,空洞卷積和恒同映射),DARTS 的目標是在這n個運算中選取最優的操作。DARTS 引入n個結構參數a1,a2,…,an并用Softmax 函數歸一化,如式(1)所示:

定義輸出y為f1(x,θ),f2(x,θ),…,fn(x,θ)的凸組合如式(2)所示:

DARTS 的搜索策略如圖2 所示。

圖2 DARTS 的搜索流程Fig.2 Overview of the searching process of DARTS

由圖2 可以看出,DARTS 算法的優點是可以一邊訓練網絡參數,一邊優化網絡結構,而無需等到訓練完成后再調優網絡結構,這顯著減少了優化時間。

2 基于DARTS 的圖像盲去模糊方法

2.1 U 型殘差搜索空間

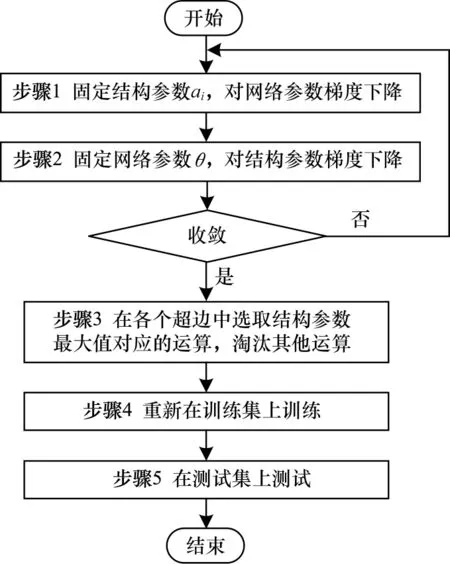

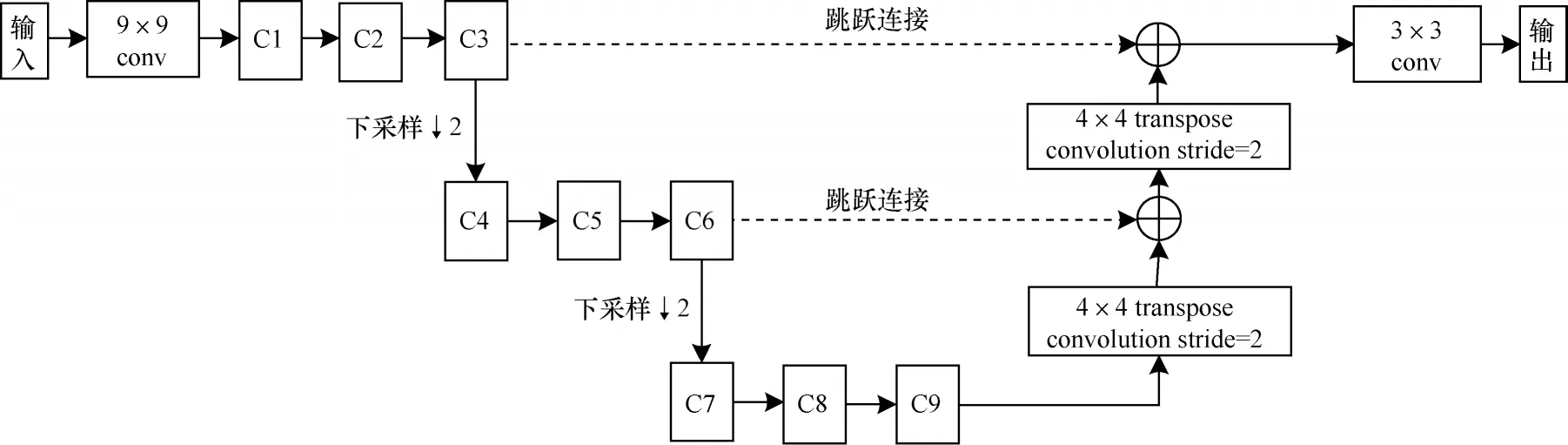

結合式(1)與式(2)定義超邊,再將這些超邊組成一個神經網絡,這個由超邊組成的神經網絡稱為“搜索空間”。如圖3 所示。

圖3 提出的U 型殘差搜索空間Fig.3 The proposed U-Shape search space

每條超邊包括多種運算,因此,DARTS 算法比較消耗內存。和圖像分類不同的是,為了達到較好的實驗效果,圖像去模糊的神經網絡一般比較大,因此無法做到神經網絡的每兩個數據節點都有超邊連接,搜索一個圖像去模糊的神經網絡難度也遠大于搜索一個分類網絡。

基于分治的思路,本文將搜索空間分為9 個單元3 個分辨率尺度,每個分辨率尺度由3 個單元組成,不同分辨率尺度之間使用圖3 所示U 型殘差結構串聯。單元內部使用自定義的搜索空間。這樣設計充分考慮了各分辨率尺度的信息。最高分辨率尺度中的3 個單元C1、C2、C3 有64 個特征圖,中等分辨率尺度的3 個單元C4、C5、C6 有128 個特征圖,最低分辨率尺度中的三個單元有C7、C8、C9 有256 個特征圖。較高分辨率的圖像長寬均為較低分辨率圖像的2 倍。在相同分辨率的張量之間使用跳躍連接。每個單元后都使用ReLU激活函數。盡管9 個單元的搜索空間是相似的,但訓練完成后每條超邊的結構參數可能互不相同,因此,訓練結束后,即使在同一分辨率上,不同的單元可能搜索到不同的網絡結構。

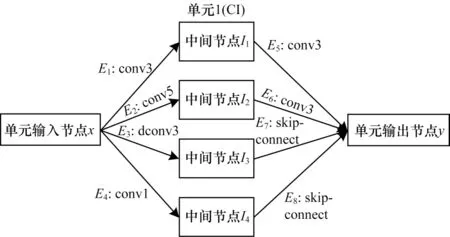

每個單元包括6 個數據節點和8 條超邊。每條超邊有5 種可能的操作:1)恒同連接;2)普通卷積,卷積核尺寸3×3;3)普通卷積,卷積核尺寸5×5;4)空洞卷積,卷積核尺寸3×3,膨脹系數為1;5)普通卷積,卷積核尺寸1×1。由于內存限制,本文所選用的大多數為小卷積核。每個單元的設計如圖4 所示。

圖4 搜索單元的定義Fig.4 Definition of our proposed search cell

x是單元的輸入,E1~E8為該單元的8 條超邊,輸出y如式(3)所示。

2.2 損失函數和訓練過程

本文使用均方損失函數,即比較復原后圖像和基準圖像的均方誤差。設模糊圖像為B,結構參數為a,網絡參數為θ,復原后圖像為I,基準圖像為Igt,神經網絡為f,則損失函數Loss 如式(4)所示:

基于本文提出的U 型殘差搜索空間可以在顯存僅8GB 的NVIDIA GPU 上訓練,所選用的優化器為Adam[22]。結構參數和網絡參數采用不同的學習率。結構參數的初始學習率為0.002 5,網絡參數的初始學習率為0.000 1。訓練總共進行50 輪,每輪訓練完畢后網絡參數和結構參數的學習率均變為上一輪學習率的0.96,訓練神經網絡的框架是PyTorch 1.0。

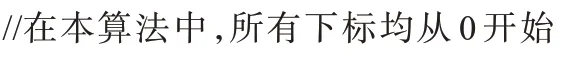

由于圖像去模糊的公開訓練集較少(例如GOPRO 數據集只包括2 103 張訓練圖像),圖2 所示的訓練流程在GOPRO 數據集上收斂到的結果較差,因此本文使用自己生成的模糊圖像作為訓練集和驗證 集。從MSCOCO[23]數 據集中選取 了56 000 張 圖像,40 000 張作為訓練集,16 000 張作為驗證集。對每一張圖像I,采用基于隨機游走的算法(算法1)隨機生成正方形模糊核k,k的邊長從[7,75]中的奇數隨機采樣。算法1 的思路是,定義一個游標(x,y),從模糊核中的任意一點出發,隨機選取運動角度α并更新游標位置(算法1 第4 步)。在游標所在的位置處,使用雙線性插值更新模糊核(算法1 第5 步)。最后更新運動角度α(算法1 第6 步)。生成模糊核后,使用式(5)生成模糊圖像B:

其中:?為卷積運算。

算法1基于隨機游走的模糊核生成算法

輸入模糊核邊長N(N是奇數),步長S

輸出模糊核k(N×N二維矩陣)

使得模糊核k 中的元素和為1

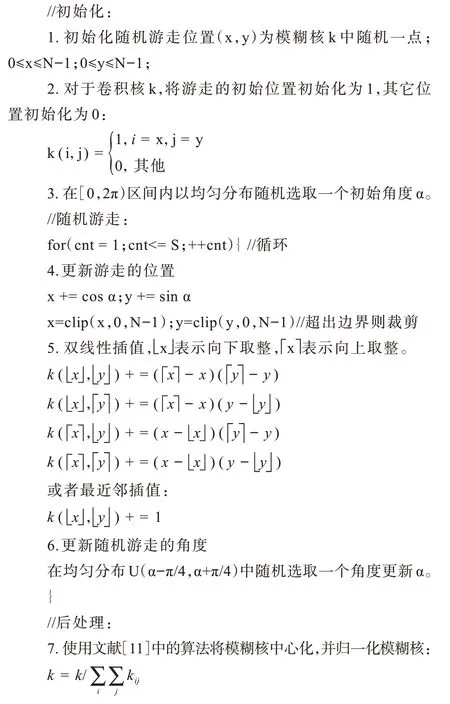

由算法1 生成的模糊核和得到的模糊圖像如圖5所示。

圖5 由算法1 生成的模糊核和模糊圖像Fig.5 The blur kernel and the blurred image generated by algorithm1

在算法1 中,步長S是一個[300,500]之間的隨機整數。算法1 采取雙線性插值時在一臺I7 CPU的PC 機上生成一張256×256 的圖像平均耗時約0.50 s。通過實驗發現,使用最近鄰插值取代算法1 步驟5 中的雙線性插值可以將生成時間從0.50 s降到約0.40 s,且兩種插值之間的訓練效果差別可以忽略不計。最近鄰插值法在GOPRO 數據集上PSNR 為28.56/0.871,和雙線性插值的28.55/0.873較為接近。

3 實驗結果與分析

3.1 實驗數據集

為了客觀評價本文的方法,使用兩個公開的數據集Kohler[24]和GOPRO[8]作為測試集。Kohler 是一個仿真數據集,數據集包括由4 個原始圖像和12 個卷積核生成的48 張分辨率為800 像素×800 像素的模糊圖像,模糊類型均為均勻模糊。GOPRO 數據集包括真實拍攝的1 111 個分辨率為1 280 像素×720 像素的模糊圖像,模糊類型為非均勻模糊。

本文采用兩種客觀的圖像評價指標:峰值信噪比PSNR 和結構相似度SSIM[25]。為充分體現搜索得到的網絡的性能,本文選取了近年來在頂級會議/期刊上發表的論文中具有較高PSNR 與SSIM 的模型作為比較對象。此外,文獻[26]指出,雖然這兩個評價指標在絕大多數情況下非常重要,但有時具有較好視覺效果的圖像未必在PSNR 和SSIM 指標上表現出色。因此,本文也和一些經典算法比較了去模糊的視覺效果。

3.2 實驗結果

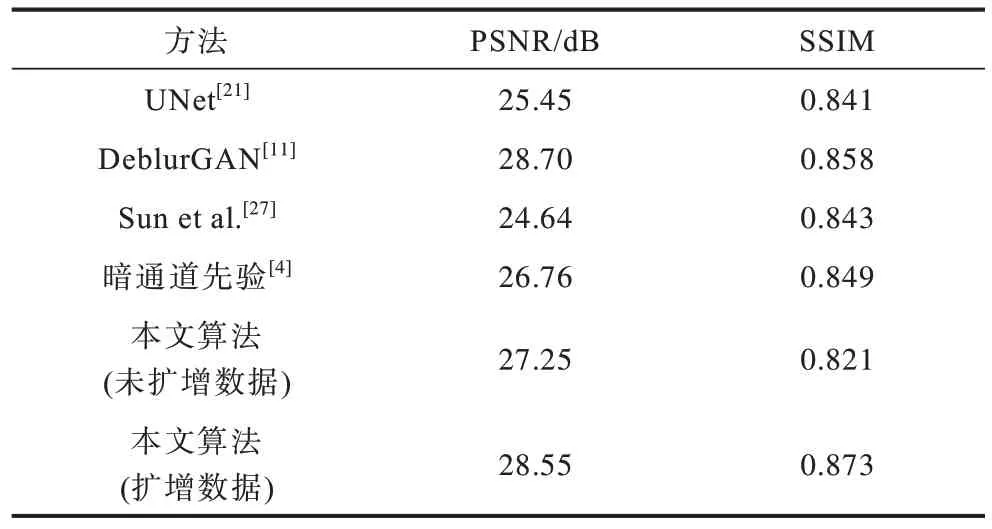

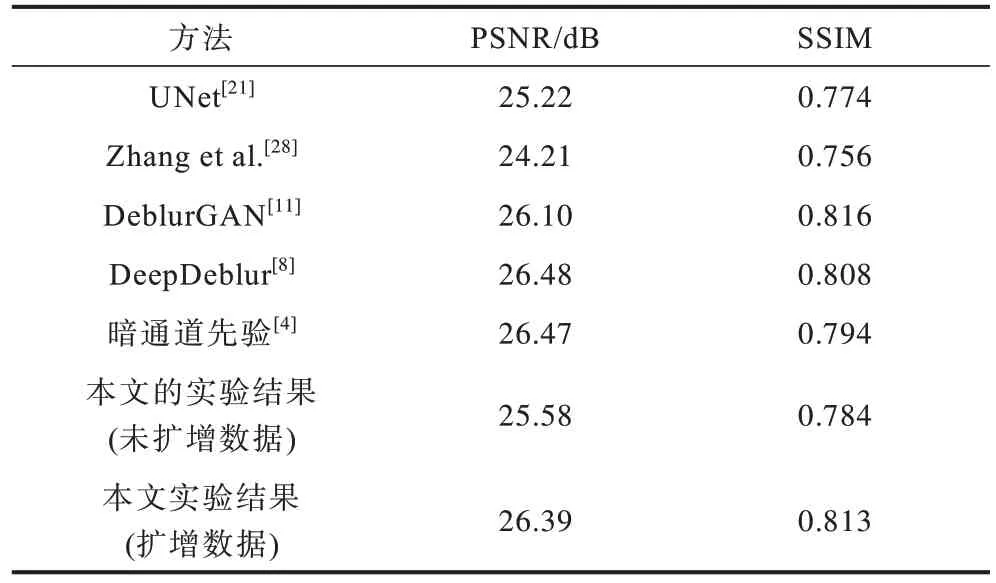

在GOPRO 數據集上的實驗結果如表1 所示。在Kohler 數據集上的實驗結果如表2 所示。

表1 GOPRO 數據集上的實驗結果Table 1 Experimental results on the GORPO dataset

表2 Kohler 數據集上的實驗結果Table 2 Experimental results on the Kohler dataset

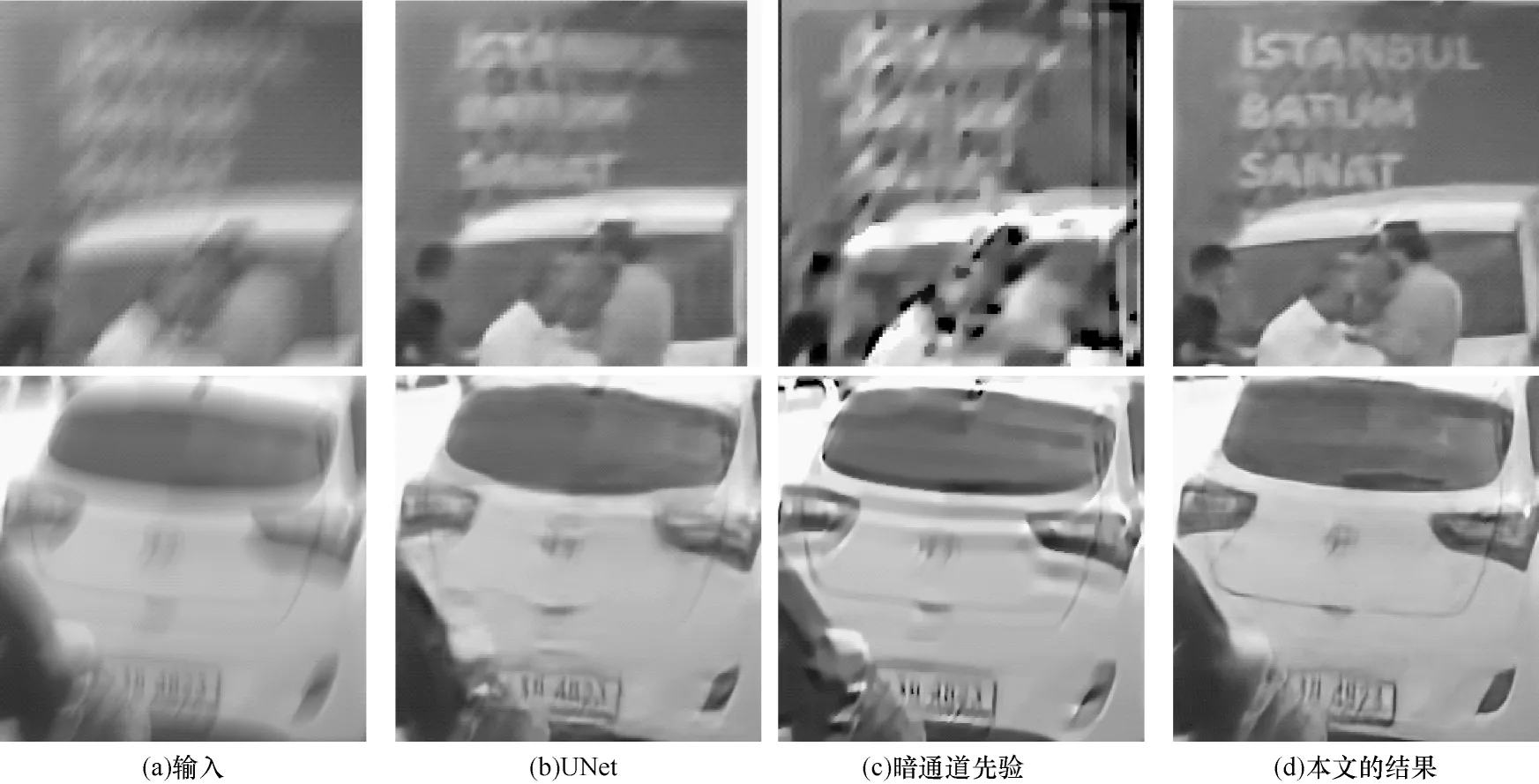

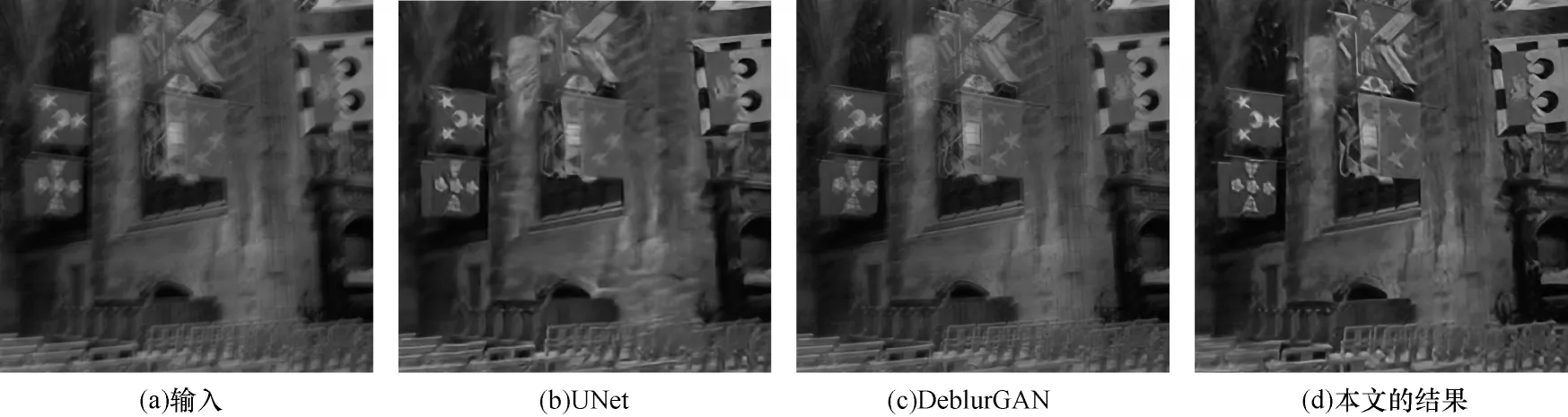

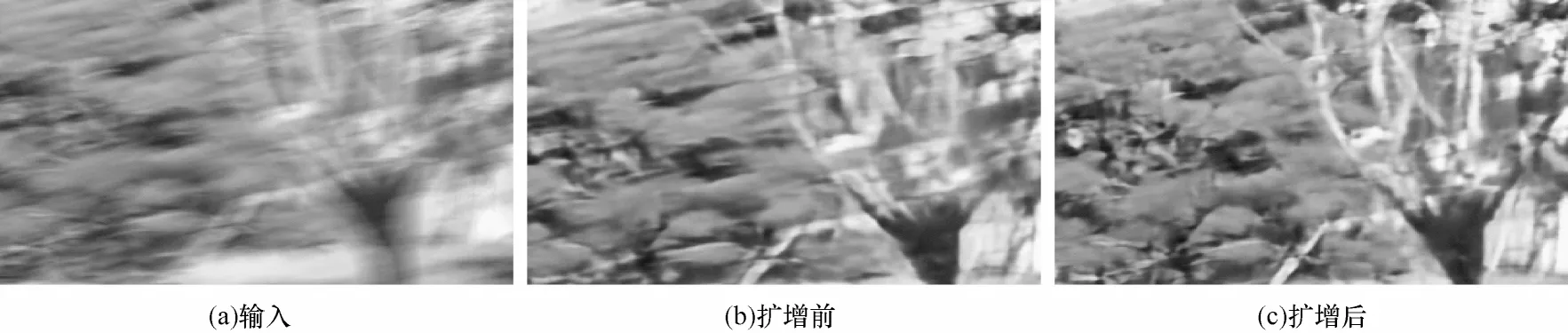

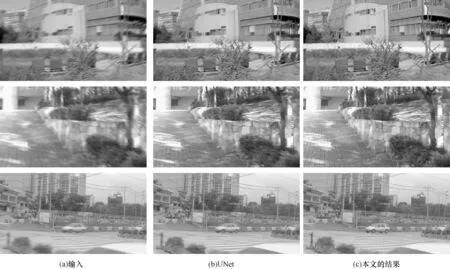

在GOPRO 數據集上,本文方法和UNet、暗通道先驗的去模糊效果比較如圖6 所示。在Kohler數據集上,本文方法和UNet、DeblurGAN的去模糊效果比較如圖7 所示。為了增加實驗效果的說服力,本文方法和當前最好的模型DeblurGAN 的比較結果如圖8所示。使用算法1 對數據集擴增前的視覺效果對比如圖9 所示。本文方法相對于UNet,在性能與搜索過程的自動化程度方面有巨大提升,同時運行速度與LINet 只相差0.02 s。本文方法與UNet方法的視覺效果對比如圖10 所示。

圖6 GOPRO 數據集上的視覺效果比較Fig.6 Visual quality comparisons on the GOPRO dataset

圖7 Kohler 數據集上的視覺效果比較Fig.7 Visual quality comparisons on the Kohler dataset

圖8 本文方法與DeblurGAN 的視覺效果對比Fig.8 Visual comparisons between the proposed method and DeblurGAN

圖9 使用算法1 進行數據集擴增前后視覺效果對比Fig.9 Effectiveness of data augmentation using algorithm 1

圖10 本文方法與UNet 的視覺效果對比Fig.10 Visual comparisons between the proposed method and UNet

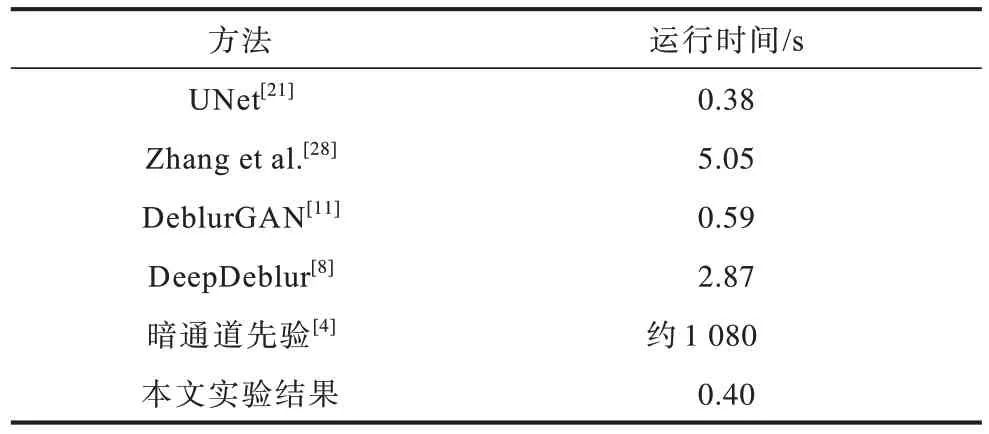

本文搜索得出的網絡和開源模型的運行時間比較結果如表3 所示。

表3 模型在分辨率為800 像素×800 像素的圖像上的運行時間Table 3 Running time on an image of resolution 800×800 pixel

3.3 實驗結果分析

從表1 和表2 可以看出,基于可微分神經網絡搜索技術(DARTS)搜索得到的神經網絡,在去模糊領域兩個知名公開數據集GOPRO 和Kohler 上的表現優于基于暗通道先驗的經典方法,峰值信噪比相對于基線模型UNet 分別提升3.10 dB 和1.17 dB,與當前最先進的DeblurGAN 性能基本相當。

從圖6 和圖7 看出,本文提出的方法有較好的視覺效果。如圖6 的第1 行所示,原始圖像文字部分的模糊非常嚴重,使用UNet[21]和暗通道先驗[4]算法,均無法看清圖像中的文字,使用本文的算法,圖像中的“ISTANBUL”和“SANAT”字樣依稀可見。圖6的第2行展示了一個模糊的車輛,使用文獻[21]和[4]算法均產生了明顯的振鈴偽影,而使用本文的算法可以較清晰地恢復出車輛的輪廓和車牌信息。從圖7 可以看出,使用本文的算法可以更清晰地恢復教堂的細節。從圖8第2 行可以看出,本文的算法可以從非常模糊的圖像中部分恢復出人臉,而DeblurGAN 完全無法恢復鏡頭前的人臉。

由表3 可知,本文搜索得到的網絡測試一張分辨率為800 像素×800 像素的圖像僅需要0.40 s,顯著小于DeblurGAN[28]。這表明本文的結構不僅有不錯的去模糊效果,而且具有較快的運行速度。

雖然DeepDeblur[8]和暗通道先驗方法[4]在Kohler數據集上的PSNR 超過了本文的算法,但它們的運算時間分別是本文算法的7.175 倍和2 700 倍,由于DeepDeblur 使用了金字塔結構,其測試時間較長。文獻[4]不僅使用了金字塔結構,而且還采用了迭代優化,因此很難在GPU 上并行優化,只能在CPU 上串行解決,這使得文獻[4]的方法幾乎不可能做到實時。此外,文獻[4]的迭代算法是基于均勻模糊的數學模型,而在實際應用中模糊一般是非均勻的,因此文獻[4]的實用性并不強。

采用本文方法,搜索得到神經網絡后,重新訓練這個神經網絡大概需要一天時間。根據開發經驗,傳統設計神經網絡很難一次成功,調試出一個既好又快的神經網絡大約需要10-15 次嘗試,這需要花費研究人員大量的時間和計算資源。顯然,本文方法對開發效率有顯著的提升。此外,前人已經探索得到了大量的結構(如基于多尺度特征的DeepDeblur[8],基于對抗生成網絡的DeblurGAN[11]),然而,通過引入當前最先進的可微分神經網絡架構搜索技術(DARTS[14]),并結合本文設計的搜索空間,能夠在不經過人為干預的情況下在兩天內搜索得到性能和速度不遜于DeepDeblur 和DeblurGAN 的神經網絡,這充分體現了可微分神經網絡架構搜索技術的強大潛力:只要搜索空間的定義合理,可微分神經網絡搜索技術就可以遷移到圖像分類、分割以外的領域。

3.4 搜索結果

以圖3 中搜索單元C1 為例,本文方法搜索得到的C1 的結構如圖11 所示。

圖11 搜索得出的單元C1 的結構Fig.11 The structure of C1 searched by the proposed method

圖11 中,超 邊E1、E5、E6為3×3 卷積,超邊E2為5×5 卷積,超邊E3為3×3 空洞卷積,超邊E4為1×1 卷積,超邊E7、E8均為恒同連接(skip-connect)。

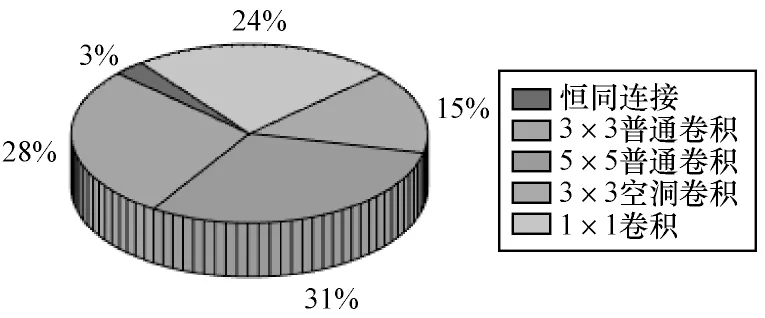

在單元C1~C9 中,5 種運算的分布如圖12 所示。

圖12 5 種候選操作的比重分布圖Fig.12 Distribution of the five candidate operations

本文提出的搜索空間總共包括9 個單元,每個單元8 條超邊共計72 條超邊。其中,有2 條恒同連接,11 個3×3 空洞卷積,22 個5×5 卷積,20 個3×3 卷積和17 個1×1 卷積。從圖12 可以看出,5×5 普通卷積占了很大的比重,這是符合預期的。文獻[29]表明,增大感受野對圖像去模糊等復原問題有重要作用,而5×5 卷積的感受野較大。恒同連接只有兩個且全部出現在單元C1 中,這也同樣符合預期,因為恒同連接不能提取特征。

4 結束語

本文將可微分神經網絡架構搜索技術(DARTS)引入圖像去模糊領域,提出了U 型殘差搜索空間,基于分治的思路,將搜索空間劃分為9 個搜索單元,顯著降低了搜索的計算難度。在不需要人工調參的情況下搜索得出的網絡,在GOPRO 和Kohler 數據集上,峰值信噪比相對于基準網絡UNet分別提升3.10 dB和1.17 dB,與當前最先進的DeblurGAN 性能基本相當。本文提出的搜索方法簡化了繁重的調參工作,使得研究人員可以更加集中精力于算法和整體架構的設計。目前,搜索得到的神經網絡較深,只能在性能強大的服務器上實驗,難以在移動設備上測試。下一步將結合神經網絡架構搜索與神經網絡量化、剪枝等技術,同時引入低延遲模塊,以搜索出一個可在移動端使用的輕量去模糊神經網絡。