基于主輔網(wǎng)絡(luò)特征融合的語音情感識(shí)別

胡德生,張雪英,張 靜,李寶蕓

(太原理工大學(xué) 信息與計(jì)算機(jī)學(xué)院,太原 030024)

語言是人類交流最方便、最快捷的方式,語言中包含的情感信息在交流時(shí)發(fā)揮著重要作用。讓機(jī)器像人一樣具備說話、思維和情感能力,是人工智能領(lǐng)域一直追求的目標(biāo)。語音情感識(shí)別的研究,將推動(dòng)這一目標(biāo)的逐步實(shí)現(xiàn)。

典型的語音情感識(shí)別模型由語音情感數(shù)據(jù)庫、特征提取和識(shí)別3部分組成[1],提取有效情感特征是語音情感識(shí)別的關(guān)鍵。傳統(tǒng)的語音情感識(shí)別首先分幀提取Mel頻率倒譜系數(shù)(Mel frequency cepstral coefficients,MFCC)等聲學(xué)特征,然后提取所有幀的最大值、最小值、均值、方差等統(tǒng)計(jì)特征作為語音信號(hào)的全局特征[2-4]。由于全局特征是在句子級(jí)別上提取統(tǒng)計(jì)特征,所以其只能粗略反映語音情感隨時(shí)間變化的特性。針對(duì)這個(gè)問題,段特征的概念被提出,首先將語音信號(hào)分段,每段包含若干幀語音,對(duì)這若干幀語音各自提取聲學(xué)特征后,再計(jì)算這段語音的多個(gè)統(tǒng)計(jì)特征作為段特征。文獻(xiàn)[2]將段特征直接輸入基于注意力機(jī)制的長短時(shí)記憶單元(long short-term memory,LSTM)網(wǎng)絡(luò)提取深度特征并分類,與全局特征相比取得了較好的效果。

語譜圖是一維語音信號(hào)在二維時(shí)頻域的展開,能夠充分反映語音信號(hào)在時(shí)頻域大部分信息。卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural networks,CNN)由于其自動(dòng)學(xué)習(xí)特征的能力和適用于二維圖像數(shù)據(jù)的特點(diǎn),目前被廣泛用在語譜圖中提取特征,進(jìn)一步提高語音情感識(shí)別性能[5-8]。如文獻(xiàn)[8]先將語譜圖輸入全卷積網(wǎng)絡(luò)(fully convolutional networks,F(xiàn)CN),并在最后一層卷積層使用注意力機(jī)制,最后進(jìn)行情感識(shí)別,在IEMOCAP數(shù)據(jù)集上其WA(weighted accuracy)和UA(unweighted accuracy)分別達(dá)到70.4%,63.9%.

近年來,國內(nèi)外學(xué)者提出多種混合網(wǎng)絡(luò)模型用于將不同類型的特征進(jìn)行特征融合,提升了語音情感識(shí)別的性能[9-11]。文獻(xiàn)[9]提出HSF-CRNN模型,采用CRNN網(wǎng)絡(luò)對(duì)語譜圖提取深度特征,將全局特征輸入全連接層,最后將兩者拼接進(jìn)行情感識(shí)別;文獻(xiàn)[10]提出Attention-BLSTM-FCN模型,在Mel語譜圖上分別應(yīng)用Attention-BLSTM網(wǎng)絡(luò)和Attention-FCN網(wǎng)絡(luò),然后將兩個(gè)網(wǎng)絡(luò)提取的深度情感特征以直接拼接的方式進(jìn)行特征融合,最后輸入全連接層進(jìn)行分類識(shí)別。雖然這些方法取得了一定的效果,但將不同類型的特征簡(jiǎn)單拼接起來作為識(shí)別網(wǎng)絡(luò)的輸入,沒有考慮不同特征的量綱和維度的差異,以及各類型特征實(shí)際物理意義的不同,會(huì)對(duì)識(shí)別結(jié)果帶來不利影響。

針對(duì)上述問題,本文提出了通過主輔網(wǎng)絡(luò)方式將不同類別特征進(jìn)行融合的方法。首先將段特征輸入BLSTM-Attention網(wǎng)絡(luò)作為主網(wǎng)絡(luò),提取深度段特征;然后,把Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò)作為輔助網(wǎng)絡(luò),提取深度Mel語譜圖特征;最后,用深度Mel語譜圖特征輔助深度段特征,將兩者以主輔網(wǎng)絡(luò)方式進(jìn)行特征融合。在IEMOCAP數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,使用主輔網(wǎng)絡(luò)深度特征融合的WA和UA分別達(dá)到74.45%、72.50%,比將特征直接拼接的WA和UA分別提高了1.24%、1.15%.

1 不同類別的特征提取

1.1 段特征提取

1) 語音信號(hào)采樣率為16 kHz,分幀處理時(shí)取窗長256,窗移128;

2) 使用截?cái)嗷蜓a(bǔ)零的方式使所有語音長度為1 000幀;

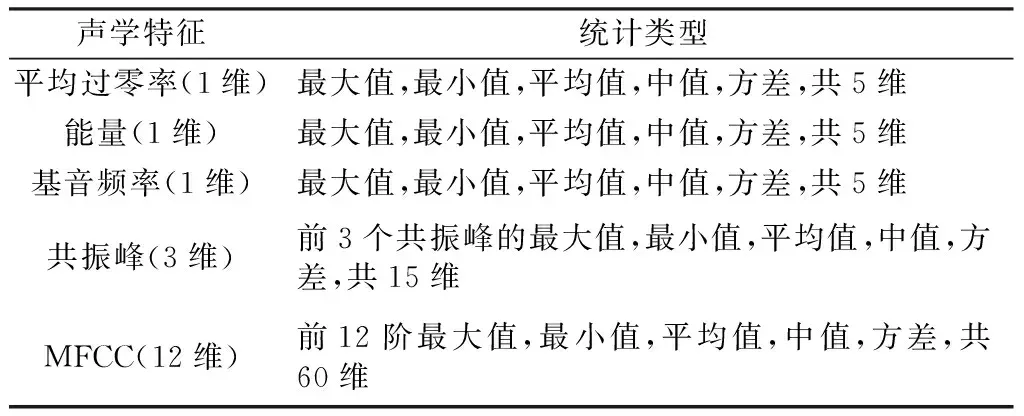

3) 計(jì)算每一幀信號(hào)的平均過零率、能量、基音頻率、共振峰、MFCC,共18維聲學(xué)特征[12];

4) 每5幀組成一段[13],共200段。計(jì)算一段內(nèi)聲學(xué)特征的最大值、最小值、平均值、中值和方差等統(tǒng)計(jì)特征,得到一段信號(hào)的18×5=90維特征;

5) 標(biāo)準(zhǔn)化處理,得到每一句情感語音信號(hào)的90×200的段特征,段內(nèi)的聲學(xué)特征如表1所示。

表1 段內(nèi)的聲學(xué)特征及其統(tǒng)計(jì)類型Table 1 Acoustic feature and statistical feature within a segment

1.2 Mel語譜圖生成

首先對(duì)語音信號(hào)進(jìn)行STFT變換,使用漢明窗,窗長256,窗移128.

大量實(shí)驗(yàn)表明人耳聽到的聲音高低和實(shí)際頻率(Hz)不呈線性關(guān)系,Mel頻率更加符合人耳的聽覺特性,Mel頻率fMel和Hz頻率f的關(guān)系如式(1)所示。

(1)

然后通過40階Mel濾波器組得到Hm(k),再將Hm(k)×|X(k)|2求和得到Mel語譜圖。

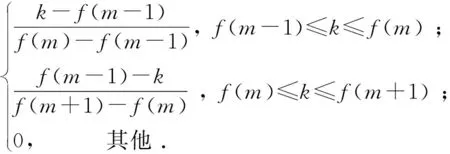

Mel濾波器組的輸出計(jì)算如式(2)所示,每個(gè)濾波器具有三角濾波特性,

(2)

式中:f(m)為中心頻率,m表示Mel濾波器的階數(shù);k表示FFT中點(diǎn)的編號(hào)。

Mel語譜圖計(jì)算如式(3)所示,

(3)

其中,|X(k)|2表示頻譜能量。

最后使用截?cái)嘌a(bǔ)零的方式使所有Mel語譜圖大小對(duì)齊,得到大小為40×432的Mel語譜圖。

1.3 基于BLSTM-Attention的深度段特征提取

LSTM適合對(duì)序列問題進(jìn)行建模,因此被廣泛應(yīng)用在語音識(shí)別和語音情感識(shí)別中。BLSTM由正向LSTM和反向LSTM組成。BLSTM不僅可以考慮輸入數(shù)據(jù)以前的信息,還可以考慮輸入數(shù)據(jù)未來的信息,可以更好地對(duì)序列問題進(jìn)行建模。采用BLSTM對(duì)段特征進(jìn)行建模可以提取考慮上下文情感信息的深度情感特征。本文使用兩層BLSTM,隱藏神經(jīng)元個(gè)數(shù)為300,為了減輕過擬合使用dropout,棄權(quán)率為0.5.

通過對(duì)BLSTM輸出應(yīng)用注意力機(jī)制可以關(guān)注輸入的情感語音信號(hào)中更顯著的情感片段,增強(qiáng)BLSTM網(wǎng)絡(luò)提取顯著深度段特征的能力。更具體地說,以LSTM為核心的識(shí)別器在時(shí)間上展開的長度是T,則LSTM在每一時(shí)刻都對(duì)應(yīng)一個(gè)輸出。相比于平均池化輸出和最后時(shí)刻輸出,注意力機(jī)制可以兼顧LSTM層每一時(shí)刻的輸出,其對(duì)LSTM網(wǎng)絡(luò)每一時(shí)刻的輸出分配不同的權(quán)重來考慮上下文情感信息的深層特征。注意力機(jī)制的具體計(jì)算如式(4)所示:

(4)

式中:st∈RD是輸入序列的某一元素;T表示LSTM的某一時(shí)刻;αt為加權(quán)系數(shù)。加權(quán)系數(shù)可以通過式(5)、(6)算出,并通過網(wǎng)絡(luò)訓(xùn)練進(jìn)行更新。

αt=softmax(βt) .

(5)

(6)

1.4 基于CNN-GAP的深度Mel語譜圖特征提取

由于CNN適合于二維圖像數(shù)據(jù),而Mel語譜圖是一維語音信號(hào)在二維時(shí)頻域的展開,因此CNN可以用來在Mel語譜圖上提取深度特征。CNN由卷積層和池化層組成,卷積層用來提取特征,池化層用來降低網(wǎng)絡(luò)規(guī)模和過擬合,通常采用最大值池化或均值池化。

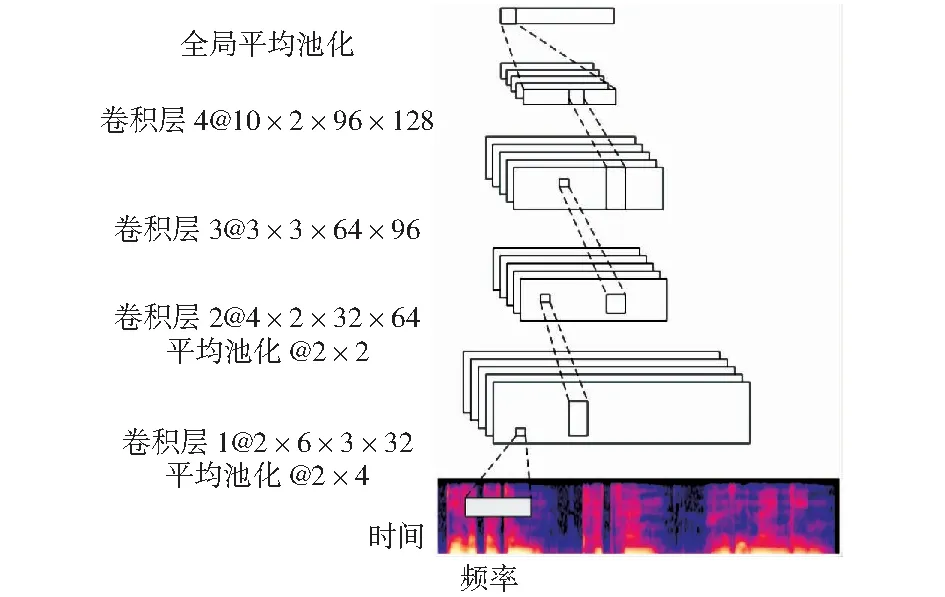

Mel語譜圖是一維語音信號(hào)在二維時(shí)頻域的展開,能夠充分反映語音信號(hào)在時(shí)頻域大部分信息。針對(duì)Mel語譜圖的這一特點(diǎn),可以分別在時(shí)間軸和頻率軸設(shè)計(jì)較大的卷積核,提取Mel語譜圖的頻率和時(shí)間特性,進(jìn)而提取顯著的情感特征。設(shè)計(jì)的卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。

卷積核大小表示為長×寬×輸入通道×輸出通道,池化層大小表示為長×寬圖1 設(shè)計(jì)的卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)Fig.1 Design of the convolutional neural network structure

第一層卷積層在時(shí)間軸上設(shè)計(jì)較大的卷積核,提取Mel語譜圖的時(shí)間特性;第二層卷積層在頻率軸上設(shè)計(jì)較大的卷積核,提取Mel語譜圖的頻率特性;第三層卷積層使用3×3卷積核;第四層卷積層在頻率軸上使用全卷積,最后再使用全局平均池化(global average pooling,GAP).用GAP代替全連接層可以減輕過擬合,使網(wǎng)絡(luò)易于訓(xùn)練。每一層卷積層都使用了批歸一化(batch normalization,BN)以及Relu激活函數(shù)。具體網(wǎng)絡(luò)參數(shù)經(jīng)過調(diào)參得到。

2 主輔網(wǎng)絡(luò)特征融合模型

2.1 主輔網(wǎng)絡(luò)特征融合的網(wǎng)絡(luò)結(jié)構(gòu)

將段特征輸入BLSTM-Attention網(wǎng)絡(luò)提取了深度段特征,將Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò)提取深度Mel語譜圖特征,通常將兩者以直接拼接的方式進(jìn)行特征融合,但是沒有考慮不同特征的量綱和維度的差異,會(huì)對(duì)識(shí)別結(jié)果帶來不利影響。因此,本文提出基于主輔網(wǎng)絡(luò)特征融合的語音情感識(shí)別。

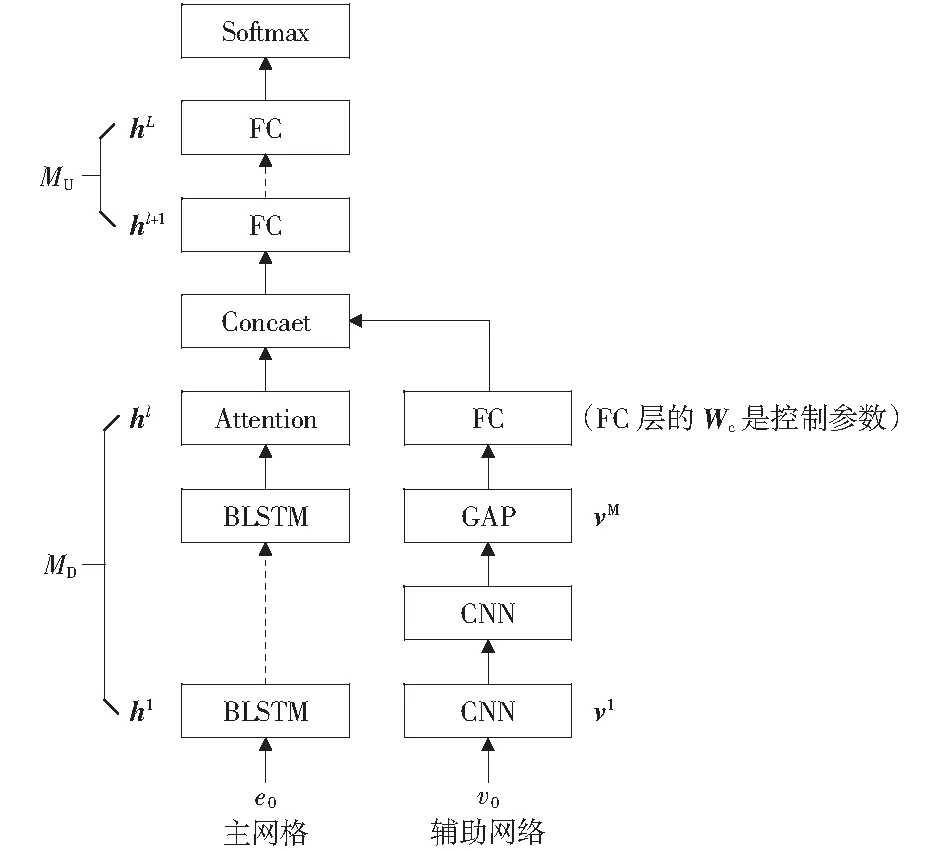

主輔網(wǎng)絡(luò)特征融合的網(wǎng)絡(luò)結(jié)構(gòu)如圖2所示。傳統(tǒng)聲學(xué)特征以時(shí)域特征為主,具有明確的物理意義,因此將其作為主網(wǎng)絡(luò)輸入特征。主網(wǎng)絡(luò)是基于BLSTM-Attention的深度段特征提取模塊,輔助網(wǎng)絡(luò)是基于CNN-GAP的深度Mel語譜圖特征提取模塊,兩者以主輔網(wǎng)絡(luò)方式組成特征融合網(wǎng)絡(luò)。主網(wǎng)絡(luò)分為上、下兩部分,MU代表上半部分,由全連接層構(gòu)成;MD代表下半部分,由BLSTM-Attention網(wǎng)絡(luò)構(gòu)成。e0表示語音段特征,經(jīng)標(biāo)準(zhǔn)化后作為主網(wǎng)絡(luò)的輸入;hl代表主網(wǎng)絡(luò)MD部分的輸出,是深度段特征,維度是600.輔助網(wǎng)絡(luò)由CNN-GAP網(wǎng)絡(luò)構(gòu)成,v0表示Mel語譜圖,作為輔助網(wǎng)絡(luò)輸入,vM表示輔助網(wǎng)絡(luò)GPA的輸出,輔助網(wǎng)絡(luò)FC層的Wc是控制參數(shù)(為了簡(jiǎn)化描述,省略了輔助網(wǎng)絡(luò)FC層偏置項(xiàng)),也是權(quán)重,維度是128×200.一方面在主網(wǎng)絡(luò)參數(shù)更新時(shí)可以控制輔助網(wǎng)絡(luò)參數(shù)不更新;另一方面是對(duì)vM進(jìn)行特征變換。Concate表示hl與WcvM直接拼接,并輸入主網(wǎng)絡(luò)的MU上半部分,其中hl表示BLSTM-Attention網(wǎng)絡(luò)提取的深度段特征,vM表示CNN-GAP網(wǎng)絡(luò)提取的深度Mel語譜圖特征,Wc表示控制主輔網(wǎng)絡(luò)訓(xùn)練的參數(shù)。然后將Concate拼接結(jié)果通過FC層做進(jìn)一步特征融合,最后使用Softmax進(jìn)行分類。

圖2 主輔網(wǎng)絡(luò)特征融合的結(jié)構(gòu)模型Fig.2 A structural model of feature fusion of main-auxiliary networks

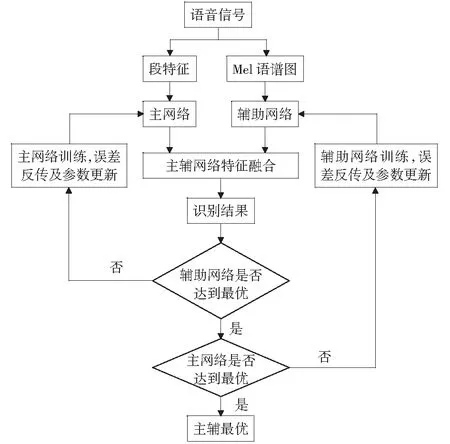

2.2 主輔網(wǎng)絡(luò)特征融合參數(shù)傳遞及更新

本文提出的基于主輔網(wǎng)絡(luò)特征融合的語音情感識(shí)別模型,最重要的是網(wǎng)絡(luò)訓(xùn)練過程,也就是誤差反傳參數(shù)更新的過程,主輔網(wǎng)絡(luò)特征融合參數(shù)傳遞示意圖如圖3所示。

圖3 主輔網(wǎng)絡(luò)特征融合參數(shù)傳遞及更新Fig.3 Transfer and update of main-auxiliary network feature fusion parameters

由于輔助網(wǎng)絡(luò)的加入,網(wǎng)絡(luò)的訓(xùn)練被分為三步:

1) 參數(shù)初始化。將語音段特征e0輸入主網(wǎng)絡(luò),將Mel語譜圖v0輸入輔助網(wǎng)絡(luò);然后將控制參數(shù)Wc初始化為0,主網(wǎng)絡(luò)和輔助網(wǎng)絡(luò)的權(quán)重和偏置通過截?cái)嗾植茧S機(jī)初始化。

2) 主網(wǎng)絡(luò)訓(xùn)練。首先通過控制Wc和網(wǎng)絡(luò)設(shè)置使輔助網(wǎng)絡(luò)不起作用,然后使用梯度下降算法和反向傳播算法訓(xùn)練主網(wǎng)絡(luò)使主網(wǎng)絡(luò)MD和MU參數(shù)更新。

3) 輔助網(wǎng)絡(luò)訓(xùn)練。首先將主網(wǎng)絡(luò)MD和MU的權(quán)重和偏置設(shè)置為不更新,將輔助網(wǎng)絡(luò)的權(quán)重、偏置和Wc設(shè)置為更新;使用梯度下降算法和反向傳播算法訓(xùn)練輔助網(wǎng)絡(luò)使輔助網(wǎng)絡(luò)參數(shù)和Wc更新。

下面介紹輔助網(wǎng)絡(luò)的一些參數(shù)更新。主輔網(wǎng)絡(luò)最后一層輸出拼接向量為hl,具體的拼接公式如式(7)所示:

hl=hl+WcvM.

(7)

(8)

(9)

3 實(shí)驗(yàn)及結(jié)果

3.1 實(shí)驗(yàn)數(shù)據(jù)庫及網(wǎng)絡(luò)參數(shù)設(shè)置

本文使用美國南加州大學(xué)發(fā)布的英文情感數(shù)據(jù)集IEMOCAP(the interactive emotional dyadic motion capture database).該數(shù)據(jù)集由5個(gè)會(huì)話組成,每個(gè)會(huì)話由一對(duì)說話者(女性和男性)在預(yù)先設(shè)定的場(chǎng)景和即興場(chǎng)景中對(duì)話。本文使用即興場(chǎng)景對(duì)話中的語句,選取4種情感,分別是高興、悲傷、憤怒、中性,共2 046條語句。

本文使用tensorflow深度學(xué)習(xí)框架,以本文提出的網(wǎng)絡(luò)模型為例,通過多次實(shí)驗(yàn)確定網(wǎng)絡(luò)參數(shù)如下:主網(wǎng)絡(luò)學(xué)習(xí)率為0.000 5,輔助網(wǎng)絡(luò)學(xué)習(xí)率為0.001;主網(wǎng)絡(luò)minibatch大小為96,輔助網(wǎng)絡(luò)minibatch大小為48;主輔網(wǎng)絡(luò)均使用Adam優(yōu)化器。

3.2 實(shí)驗(yàn)結(jié)果及分析

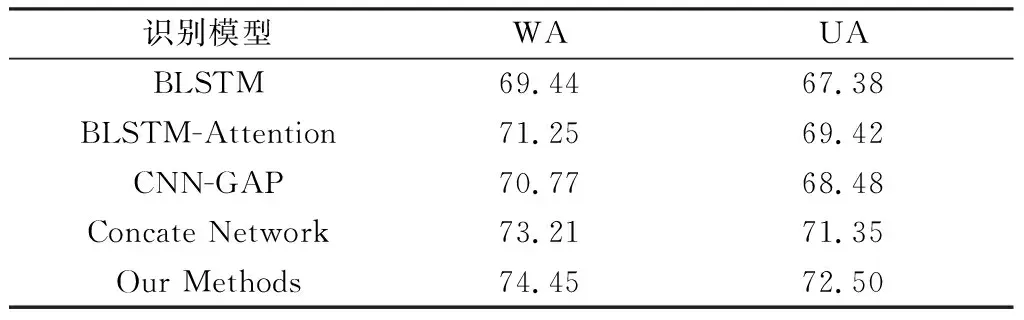

本文采用情感識(shí)別領(lǐng)域常見的兩種評(píng)價(jià)指標(biāo):加權(quán)準(zhǔn)確率WA和非加權(quán)準(zhǔn)確率UA.WA衡量了語音情感識(shí)別系統(tǒng)的總體性能,其計(jì)算方式為正確分類的樣本數(shù)量除以樣本總數(shù);UA衡量所有類別的識(shí)別性能,其計(jì)算方式為各類的分類準(zhǔn)確率再除以類別數(shù)。本文采用分層五折交叉方式驗(yàn)證模型預(yù)測(cè)效果,使用樣本的80%進(jìn)行訓(xùn)練,20%進(jìn)行測(cè)試,最后對(duì)5次預(yù)測(cè)結(jié)果取平均。為了評(píng)價(jià)本文所提算法的有效性,對(duì)5種識(shí)別模型在IEMOCAP數(shù)據(jù)集上進(jìn)行了對(duì)比實(shí)驗(yàn),結(jié)果如表2所示。

下面對(duì)5種識(shí)別模型的輸入特征進(jìn)行說明。

BLSTM:將段特征輸入BLSTM網(wǎng)絡(luò)進(jìn)行特征提取,然后輸入Softmax分類器進(jìn)行語音情感識(shí)別。

BLSTM-Attention:將段特征輸入BLSTM-Attention網(wǎng)絡(luò)進(jìn)行特征提取,然后輸入Softmax分類器進(jìn)行語音情感識(shí)別。

CNN-GAP:將Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò)進(jìn)行特征提取,然后輸入Softmax分類器進(jìn)行語音情感識(shí)別。

Concate Network:將段特征輸入基于BLSTM-Attention網(wǎng)絡(luò),將Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò),再將兩者以直接拼接的方式進(jìn)行特征融合,最后輸入Softmax分類器進(jìn)行語音情感識(shí)別。

Our Methods:本文提出的主輔網(wǎng)絡(luò)特征融合識(shí)別模型,先將段特征輸入基于BLSTM-Attention網(wǎng)絡(luò),將Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò),再將兩者以主輔網(wǎng)絡(luò)特征融合的方式進(jìn)行特征融合,最后輸入Softmax分類器進(jìn)行語音情感識(shí)別。

由表2可知,Our Methods的WA和UA比BLSTM-Attention分別提高3.20%,3.08%;比CNN-GAP分別提高3.68%,4.02%;比Concate Network分別提高1.24%,1.15%.表明使用兩種特征融合比單獨(dú)使用一種特征更有效,且主輔網(wǎng)絡(luò)特征融合方式的識(shí)別結(jié)果比直接拼接方式特征融合的識(shí)別結(jié)果更有效。

表2 5種識(shí)別模型在IEMOCAP數(shù)據(jù)集上的識(shí)別結(jié)果Table 2 Recognition results of the five recognition models on IEMOCAP dataset %

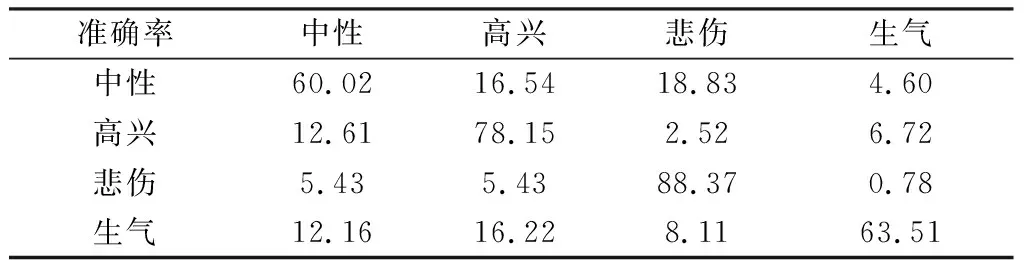

Our Methods的混淆矩陣如表3所示,中性、高興、悲傷、生氣情感的識(shí)別準(zhǔn)確率分別為60.02%,78.15%,88.37%,63.51%,4種情感識(shí)別準(zhǔn)確率均高于60%,進(jìn)一步證明了Our Methods的有效性。

表3 Our Methods的混淆矩陣Table 3 Confusion matrix of Our Methods %

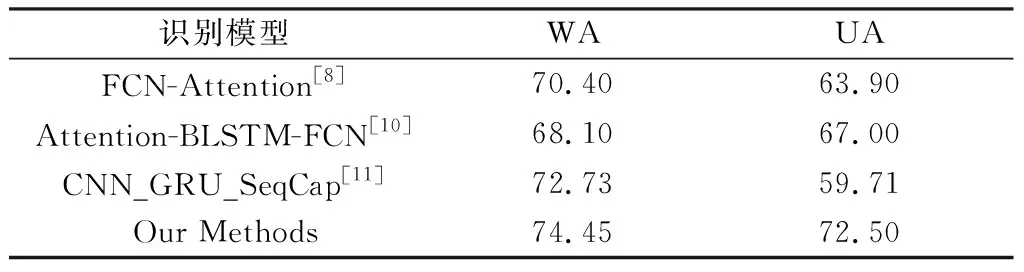

表4中列出了Our Methods和其他模型在 IEMOCAP數(shù)據(jù)集上研究的識(shí)別結(jié)果,識(shí)別模型均采用即興場(chǎng)景對(duì)話中的語句,選取了4種情感。從表4可以看出,Our Methods和其他模型相比取得了不錯(cuò)的效果,比Attention-BLSTM-FCN模型[15]的WA和UA分別提高了6.35%和5.50%.

表4 Our methods和其他模型在IEMOCAP數(shù)據(jù)集上的識(shí)別結(jié)果Table 4 Recognition results of Our Methods and other models on IEMOCAP datasets %

4 結(jié)束語

情感的表達(dá)本身是一個(gè)很復(fù)雜的過程,涉及到心理以及生理方面的諸多因素,因此從語音信號(hào)中識(shí)別出情感信息是一個(gè)挑戰(zhàn)性的課題。本文將段特征輸入BLSTM-Attention網(wǎng)絡(luò)作為主網(wǎng)絡(luò),把Mel語譜圖輸入CNN-GAP網(wǎng)絡(luò)作為輔助網(wǎng)絡(luò),然后將兩個(gè)網(wǎng)絡(luò)提取的深度特征以主輔網(wǎng)絡(luò)方式進(jìn)行特征融合,解決不同類型特征直接融合帶來的識(shí)別結(jié)果不理想的問題,并用實(shí)驗(yàn)驗(yàn)證了所提出模型的有效性。在今后的研究過程中,擬改進(jìn)CNN-GAP網(wǎng)絡(luò)的最后一層的池化方式并將腦電信號(hào)作為輔助信號(hào)引入主輔網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行語音情感識(shí)別。