一種基于DexiNed改進的紅外圖像邊緣檢測算法

何 謙,劉伯運

(海軍工程大學動力工程學院,湖北 武漢 430033)

0 引言

紅外成像技術根據輻射原理得到紅外圖像,像素亮度表征了物體表面的溫度。由于具有隱蔽性好、可全天候工作、可穿透煙霧等優良特性,紅外成像技術在軍用和民用領域都得到了廣泛應用。受制于紅外圖像的成像機理、成像系統特性和各種外界噪聲的影響,紅外圖像通常具有分辨率低、對比度差和邊緣模糊等特點。

邊緣特征在紅外圖像處理中極為重要,是目標檢測、跟蹤和識別的基礎。為滿足人們對紅外圖像進一步分析和識別的需求,紅外圖像邊緣檢測技術體現出了較大難度和重要意義。相比于可見光圖像邊緣檢測,紅外圖像邊緣檢測發展較晚,相關研究也較少,且大多都是根據可見光圖像邊緣檢測方法改進而來,而紅外圖像與可見光圖像的邊緣檢測任務存在很大不同,相比于可見光圖像,紅外圖像的特點主要有:無立體感、空間分辨率低、對比度低和邊緣模糊、非均勻性、信噪比低,等等。

近十年來,一些研究者針對紅外圖像邊緣檢測問題提出了解決方法,如基于邊緣檢測算子改進的方法[1-4]、基于蟻群算法的方法[5-6]、基于數學形態學的方法[7-8],這些方法的本質都是只考慮紅外圖像局部的急劇變化,尤其是亮度、梯度的變化,以此來檢測邊緣,但這些低層次特征難以反映較為復雜的場景。因此,雖然這些算法取得了較大的發展,卻始終存在一定限制,而打破這一限制的重要方向就是加入高層次的語義信息。

近年來,隨著深度學習技術的快速發展,大量研究[9-14]表明,卷積神經網絡(Convolutional Neural Network,CNN)具有強大的分層特征學習能力,并在自然圖像邊緣檢測中超過了人類視覺水平[11-14]。因此,有研究者開始嘗試將深度CNN應用到紅外圖像邊緣檢測中。文獻[15]將改進的HED(Holistically-Nested EdgeDetection)[10]網絡與匹配濾波對紅外圖像處理的結果進行融合以提取邊緣,但該方法處理較為復雜,沒有發揮出深度CNN 端到端的優勢,且受限于HED網絡的性能,檢測效果不太理想。

將深度學習技術應用于紅外圖像邊緣檢測也面臨著較大的問題。在自然圖像邊緣檢測任務中,我們可以利用多個公開數據集訓練和評估模型[16-21],但目前暫時沒有可以用于紅外圖像邊緣檢測的公開數據集。

總的來說,相比于自然圖像,紅外圖像的諸多缺點大大增加了邊緣檢測任務的難度,無數據集可用的現狀使得任務更加艱巨。為此,本文提出了一種基于深度學習的紅外圖像邊緣檢測算法,在DexiNed[14]的基礎上,縮減了網絡規模,并在損失函數中引入了圖像級的差異,精心設計了函數參數,進而優化了網絡性能。此外,還通過調整可見光圖像邊緣檢測數據集來近似模擬紅外圖像邊緣檢測數據集,對改進后的模型進行訓練,進一步提高了網絡對紅外圖像中邊緣信息的提取能力。

1 邊緣檢測方法

本文主要涉及紅外圖像邊緣檢測方法和基于深度學習的圖像邊緣檢測方法,下面分別對其進行簡要介紹。

1.1 紅外圖像邊緣檢測方法

作為圖像邊緣檢測領域的一個分支,有關紅外圖像的邊緣檢測方法研究較少,絕大多數都是基于傳統的可見光圖像邊緣檢測技術改進而來,根據圖像的低層次特征提取邊緣信息。這些方法主要可分為3類:一是基于邊緣檢測算子改進的方法[1-4],大多是結合各種去噪技術對圖像進行預處理,然后采用邊緣檢測算子提取邊緣,最后結合邊緣連接等圖像后處理技術優化結果,此類方法結構簡單、處理速度快,但處理結果往往不符合人眼視覺,較為生硬;二是基于蟻群算法的方法[5-6],通過蟻群搜索最優路徑的方式尋找邊緣區域,具有較強的魯棒性、優良的分布式計算和一定的抗干擾能力,然而,受制于蟻群算法本身計算量大、收斂速度慢、易過早陷入局部最優和參數設置帶有明顯經驗性的特點,此類算法在處理效率和自適應性上還有待于后續研究的不斷改進;三是基于數學形態學的方法[7-8],需要針對具體問題,精心設計結構元素和運算方法,以在抑噪和檢測精度之間達到良好的平衡。

1.2 基于深度學習的圖像邊緣檢測

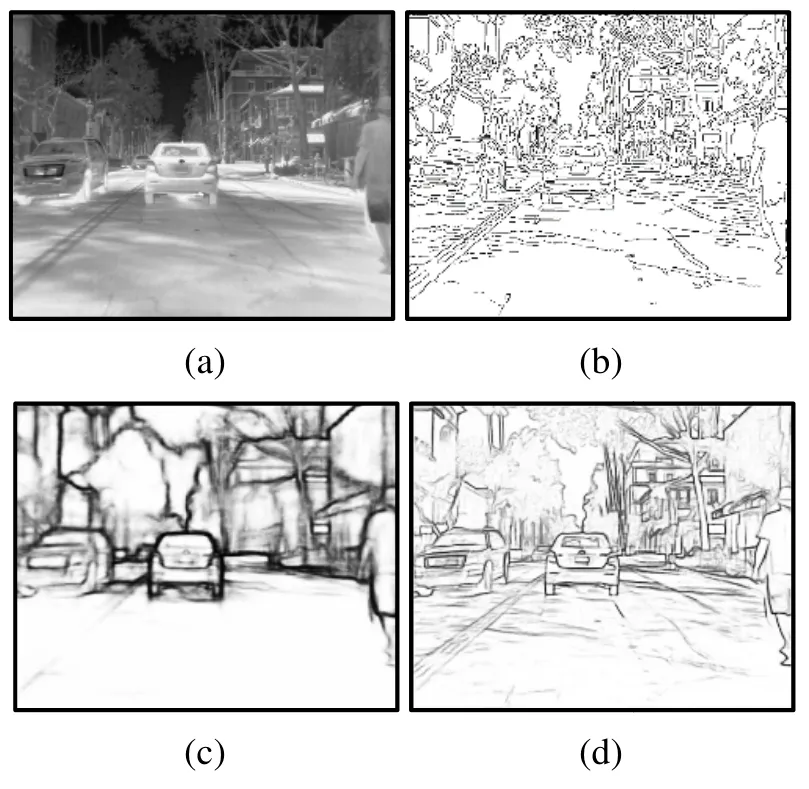

近年來,CNN得到了快速發展和廣泛應用,得益于其強大的特征提取能力,CNN 在圖像邊緣檢測領域表現出了優異的性能。圖1對比展示了傳統的和基于深度學習的圖像邊緣檢測算法用于紅外圖像的邊緣提取結果。

圖1 幾種圖像邊緣檢測方法提取紅外圖像邊緣的效果對比:(a)紅外圖像(來源于FLIR 紅外數據集);(b)Canny算子的邊緣檢測結果;(c)BDCN[12]的邊緣檢測結果;(d)本文方法的邊緣檢測結果Fig.1 Comparison of severalimage edge detection methodsto extract infrared image edge:(a)isanexampleinfrared image from FLIR Thermal Dataset (www.flir.com);(b)is theresultof the Cannyedge detector;(c)isthe result of BDCN[12];(d)is theresult of our method

DeepEdge[9]提取邊緣候選點周圍的多個圖像塊,并將這些圖像塊輸入多尺度CNN 以確定其是否為邊緣像素。HED[10],即 Holistically-Nested Edge Detection,Holistically 表示該算法試圖訓練一個端到端的網絡,Nested 則強調在生成的輸出過程中通過不斷地集成和學習得到更精確的邊緣預測圖的過程。RCF[11](Richer Convolutional Features)提出了一種基于豐富卷積特征的精確邊緣檢測算法。BDCN[12](Bi-Directional Cascade Network)提出了一種雙向級聯網絡結構,在該結構中,單個層由其特定尺度上的標記邊進行監督,而不是直接對不同的層應用相同的監督。LPCB[13](Learning to Predict Crisp Boundaries)提出了一種新的邊緣檢測方法,該方法能有效地對不平衡數據進行分類,并使網絡能夠產生清晰的邊界。DexiNed[14]可以生成適于人眼視覺的細化邊緣圖像,并且無需事先訓練或微調,就可以在任意邊緣檢測任務中使用。以上網絡幾乎都采用VGG[22](Visual Geometry Group)作為其主干。

2 本文方法

本文采用了基于深度學習的紅外圖像邊緣檢測方法,選用了目前自然圖像邊緣檢測領域性能最好的網絡模型,并在此基礎上進行了相應優化,精心構造了損失函數,并制作了近似的紅外圖像邊緣檢測數據集以微調網絡,進一步提升了神經網絡提取紅外圖像邊緣信息的性能。

2.1 網絡結構

選用DexiNed[14]作為紅外圖像邊緣檢測網絡結構的基礎并加以改進。作為目前最先進的邊緣檢測網絡模型之一,文獻[14]聲稱其不需要事先訓練和微調就能直接用于任意邊緣檢測任務。

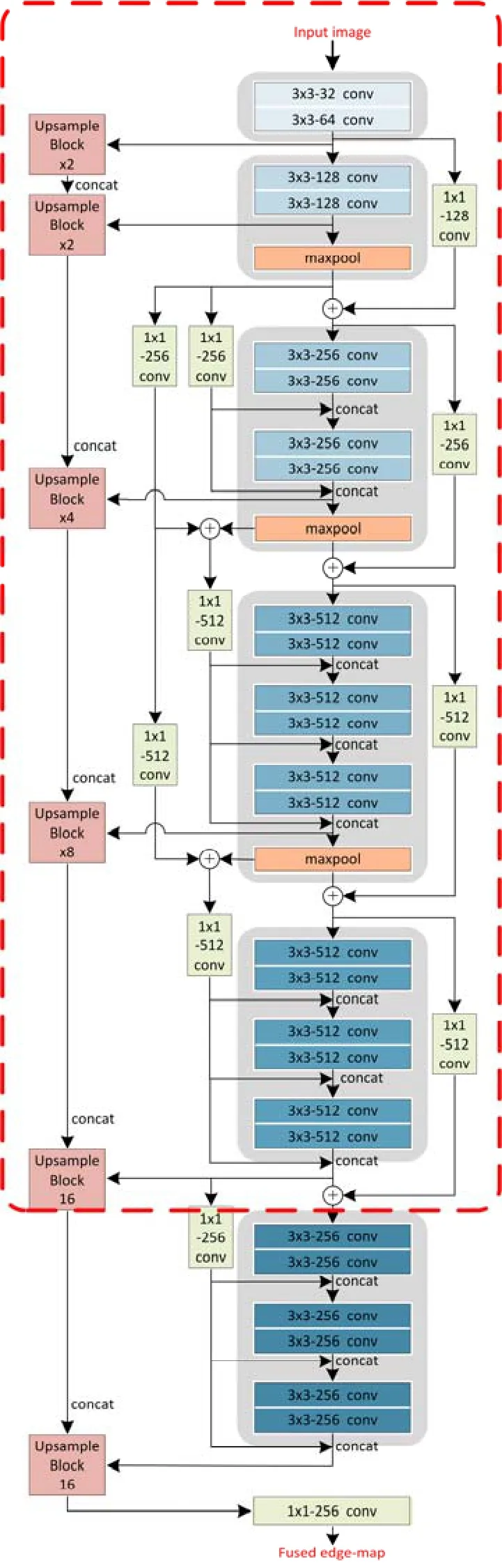

DexiNed 的結構如圖2所示,它由6 個主塊組成,每個主塊輸出特征映射,使用一個上采樣塊生成中間邊緣映射。所有由上采樣塊產生的邊緣映射被連接起來,以饋送網絡末端的學習濾波器堆棧,并產生融合的邊緣映射。DexiNed 具有優異性能的原因主要在于其具有密集的網絡層和層與層之間有效的聯接。此外,上采樣塊也起著重要的作用,它由條件疊加子塊組成。每個子塊有兩層,即卷積層和反卷積層。本文也嘗試使用其他更為簡單的上采樣方法,例如雙線性采樣和depth-to-space(由Tensorflow 提供),發現其效果遠不如該上采樣塊。

然而,DexiNed 在擁有良好的性能的同時也犧牲了模型的容量,它包含了35.2M 可訓練參數,相較于BDCN 為16.3M,RCF 為14.8M,其規模顯得較為龐大。DexiNed 網絡具有6 個主塊,其預測結果為6 個主塊輸出結果的融合或平均。在訓練和測試時,總是發現其第五和第六個主塊的輸出結果非常相似。據此猜想,第六個主塊輸出的有無對最終融合結果的影響并不是決定性的(驗證見3.2 節)。因此,為精簡網絡結構、減小網絡容量,只保留了5 個主塊,將參數減少至30.4M,相比于原網絡容量縮減了13.6%,改進后的網絡結構如圖2的虛線框中所示。

圖2 DexiNed 網絡結構和精簡后的網絡(位于虛線框中)Fig.2 Network architecture of DexiNed[14] and simplified one(in dotted box)

2.2 損失函數

在其他條件不變的情況下,網絡的精簡或多或少都會造成其性能的下降。而在訓練過程中,損失函數是最為重要的環節之一,因此,本文對DexiNed[14]原有的損失函數進行了改進。

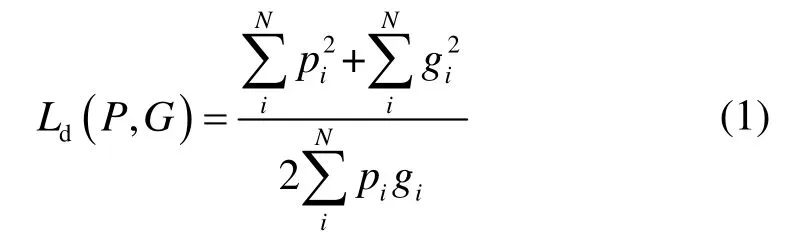

DexiNed[14]使用的損失函數為加權交叉熵損失(weighted cross-entropy loss),它是每個對應像素對之間的預測和真值的差異的加權總和,主要顯示了像素級的差異。為了獲得更好的性能,在損失函數中引入了圖像級的差異,與LPCB[13]相同,使用Dice 系數來度量預測P和真值G之間的差異。

Dice 系數是一種集合相似度的度量函數,通常用于計算兩個樣本的相似度。采用Dice 系數計算的損失為:

式中:pi和gi分別表示預測P和真值G中的第i個像素值。

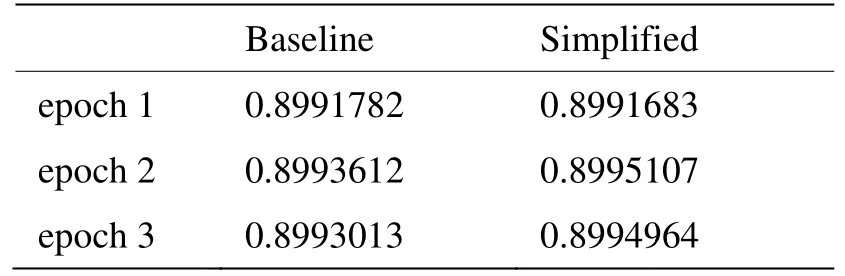

最終的損失函數為交叉熵損失(cross-entropy loss)和Dice 損失的結合:

另外,有一個細節需要說明:在計算交叉熵損失時,將網絡第五個主塊輸出結果的交叉熵損失乘以2,以近似表示疊加原網絡第六個主塊的交叉熵損失,這樣做有效地改善了精簡后網絡的訓練效果(分別訓練1 個epoch 后,相比于去掉第六個主塊而不改變損失函數的網絡,僅將損失函數中的第五個主塊的損失乘以2,就能將loss 降低21.4%、accuracy 提升2.5%)。

2.3 模擬紅外圖像邊緣檢測數據集

在前文中,已對紅外圖像邊緣檢測的難點進行了分析,紅外圖像與自然圖像存在的顯著區別,意味著紅外圖像邊緣檢測任務的難度要遠大于自然圖像。考慮到目前沒有公開的紅外圖像邊緣檢測數據集,本文認為有必要建立紅外圖像邊緣檢測數據集,進一步地訓練網絡,提升其對于紅外圖像的邊緣提取能力。

利用現有的自然圖像邊緣檢測數據集,可以在自然圖像的基礎上模擬相應的紅外圖像,以此來建立近似的紅外圖像邊緣檢測數據集。要想通過自然圖像較為準確的模擬紅外圖像,則必須在原始景物紅外輻射分布的基礎上,從時間、空間、光譜和輻射量等方面進行[23],這并非本文研究的重點,且實現起來比較復雜。

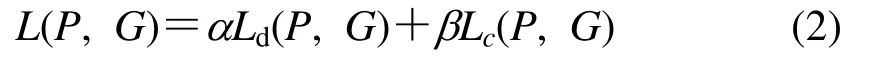

針對紅外圖像的特點,提出了一種較為簡單的方法來近似模擬紅外成像的視覺效果:首先將自然圖像灰度化,然后降低對比度,接著添加高斯噪聲,最后得到近似模擬的紅外圖像,如圖3所示。結合這種方法,基于BIPED[14]數據集建立了近似的紅外圖像邊緣檢測數據集。BIPED[14]數據集包含了250 幅分辨率為1280×720 的戶外圖像,通過裁剪、旋轉、翻轉等操作,得到增強后的數據集,再通過圖3方法進行處理,最終得到的模擬紅外圖像邊緣檢測數據集中包含72000 個模擬紅外圖像與邊緣真值圖像對,稱該數據集為IR-BIPED。

圖3 可見光圖像轉變為模擬紅外圖像的過程Fig.3 The process of transforming an optical image into a simulated infrared image

3 實驗

3.1 與DexiNed 的性能對比

首先,需要知道本文所做的一系列工作,相比于其基礎——DexiNed,是否在提取紅外圖像邊緣的效果上獲得了提升。

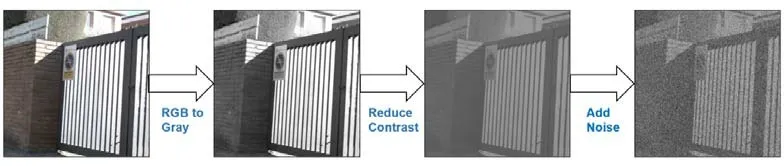

前文中提到,文獻[14]聲稱DexiNed 不需要事先訓練和微調就能直接用于任意邊緣檢測任務。因此,先將[14]中訓練好的DexiNed(在BIPED 數據集上訓練了24 個輪次)直接用于紅外圖像邊緣檢測,得到結果1。在本文方法中,將改進后的模型加載訓練好的DexiNed 部分權重后,在IR-BIPED 數據集上繼續訓練3 個輪次,測試得到結果2。公平起見,同樣將訓練好的DexiNed 繼續在IR-BIPED 數據集上微調3個輪次,測試得到結果3。測試結果1~3 對比如圖4所示,其中的紅外圖像來源于FLIR 紅外數據集。

由圖4可見,3個結果比較相似,但結果2提取得到的紅外圖像邊緣最為清晰、細節最為豐富。根據結果2,我們能夠清楚地分辨各景物,總體來說其視覺效果最好。這里需要強調,本文方法中使用的網絡容量較DexiNed 縮減了13.6%,這意味著本文方法較DexiNed 使用更少的資源,卻取得了更好的紅外圖像邊緣檢測效果。

圖4 測試結果對比Fig.4 Comparison of test results

此外,將結果3與結果1對比,可見經過3個輪次的微調后,DexiNed 提取的紅外圖像邊緣明顯更細,這也反映出IR-BIPED數據集對提升紅外圖像邊緣檢測效果起到了一定的作用,下節將進一步研究該數據集的影響。

3.2 消融實驗

下面通過實驗來驗證本文方法各組成部分的有效性。

在3.1節中,已經驗證本文方法相對于DexiNed[14]的改進既減小了網絡容量,又改善了紅外圖像的邊緣檢測效果。在本節中,將分別研究網絡容量的縮減、損失函數的設計和模擬紅外數據集各帶來了怎樣的影響。

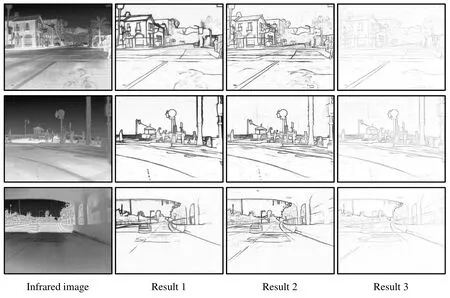

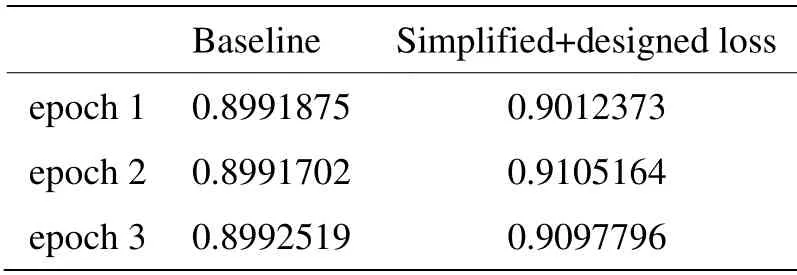

網絡容量的縮減。通過去除DexiNed[14]網絡的最后一個主塊來精簡網絡,將網絡容量縮減了13.6%。顯然,在此過程中損失了部分邊緣信息。為了量化容量縮減給邊緣檢測性能帶來的影響,將基礎網絡(baseline)和精簡后的網絡(simplified)在相同條件下各自從頭開始訓練3個輪次,發現兩者的邊緣檢測準確度變化如表1所示。由此可見,經過3個輪次的訓練后,精簡后的網絡與原網絡準確度差別不大,甚至有輕微程度的提升。

表1 網絡準確度對比1Table 1 Comparison of network accuracy-1

精心設計的損失函數。網絡結構的精簡勢必會造成部分信息的損失,自然地,我們想到通過改進損失函數來提升性能。在精簡后的網絡模型中應用3.2節所述的損失函數后,同樣將原網絡和精簡后的網絡在相同條件下各自訓練3個輪次,發現兩者的準確度變化如表2所示。由此可見,精心設計的損失函數有效地改善了網絡的性能,相比于原網絡,精簡后網絡的準確度提高了約2.6%,利用更少資源達到了更好的效果。

表2 網絡準確度對比2Table 2 Comparison of network accuracy-2

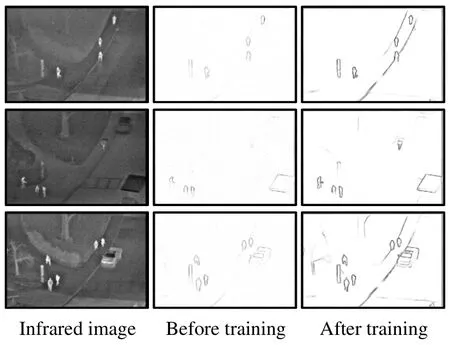

模擬紅外圖像邊緣檢測數據集。為了檢驗模擬紅外圖像邊緣檢測數據集——IR-BIPED是否對提升網絡提取紅外圖像邊緣的性能有所助益,測試了在IR-BIPED數據集上訓練前后的改進網絡,圖5展示了測試結果。其中的紅外圖像來源于OSU紅外數據集[24]。該數據集中的紅外圖像背景對比度低、邊緣模糊,選用這些圖像進行測試,能夠讓結果對比更鮮明。由圖5可見,訓練后網絡的邊緣提取結果明顯更加清晰,顯然,IR-BIPED數據集提升了模型的抗噪性能和對紅外圖像的適應性。

圖5 在IR-BIPED數據集上訓練前后的網絡測試結果對比Fig.5 Network test beforeand after training on IR-BIPEDdataset

3.3 對比評價

我們選擇了文獻[3]、[5]、[11]、[12]中的方法與本文方法進行對比,并進行了定性和定量評價。

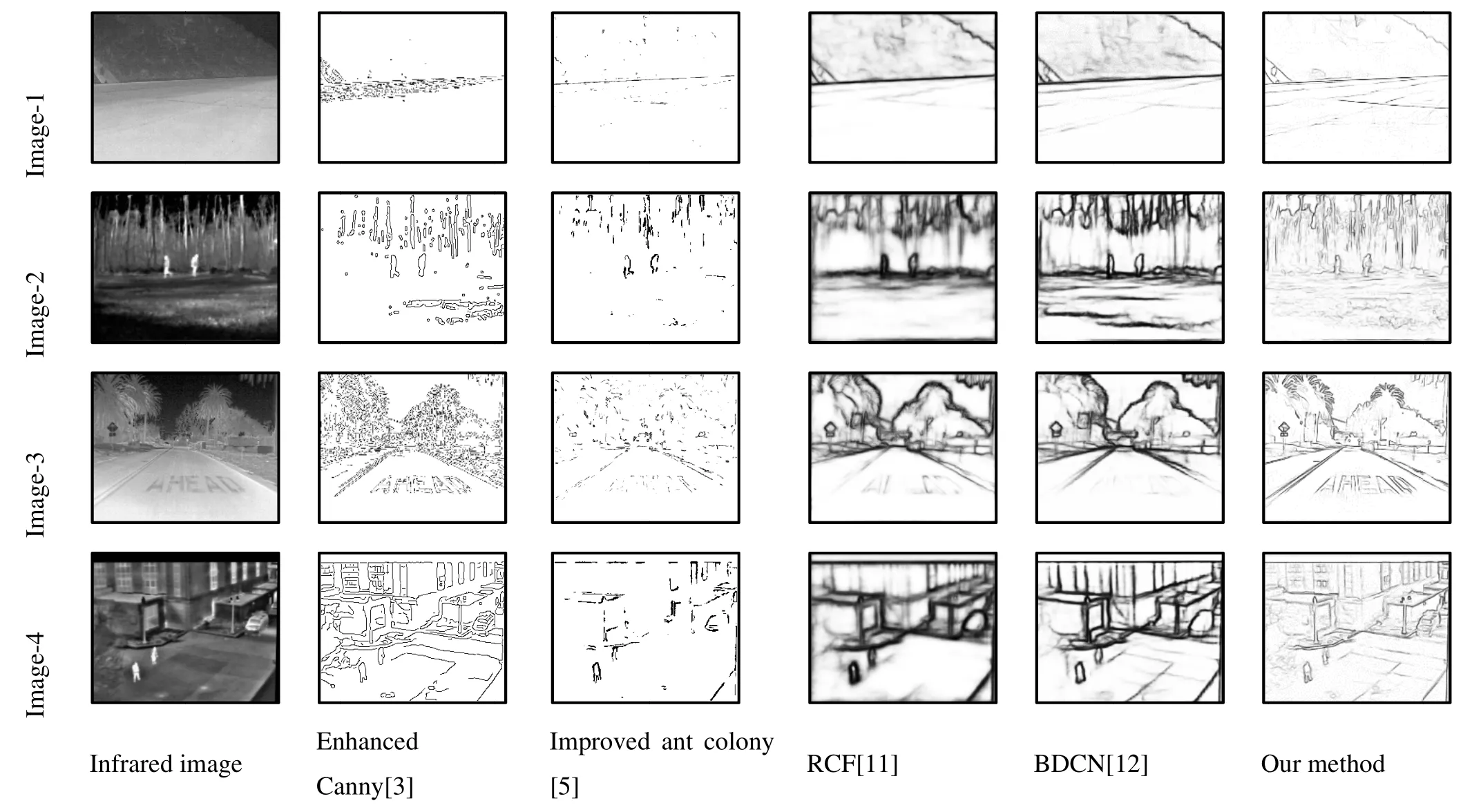

3.3.1 定性結果

前述幾種算法的紅外圖像邊緣檢測結果如圖6所示,測試紅外圖像來源于Terravic Motion 紅外數據集,FLIR 紅外數據集和OSU紅外數據集[24]。由圖可見,文獻[3]檢測出的邊緣較細、定位較準確,但受噪聲影響較大,整體觀感較生硬;文獻[5]受噪聲影響較小,但檢測出的邊緣不連續、定位精度低;文獻[11]和文獻[12]提取的邊緣連續、細節較為豐富,但邊緣較粗、觀感較差,文獻[12]的效果優于文獻[11];本文方法定位精度高,檢出的邊緣較細,且具有較好的連續性,細節豐富、清晰,人眼觀感良好。總體來說,本文方法的邊緣檢測效果最好。

圖6 不同邊緣檢測方法的結果對比Fig.6 Resultsof different methods

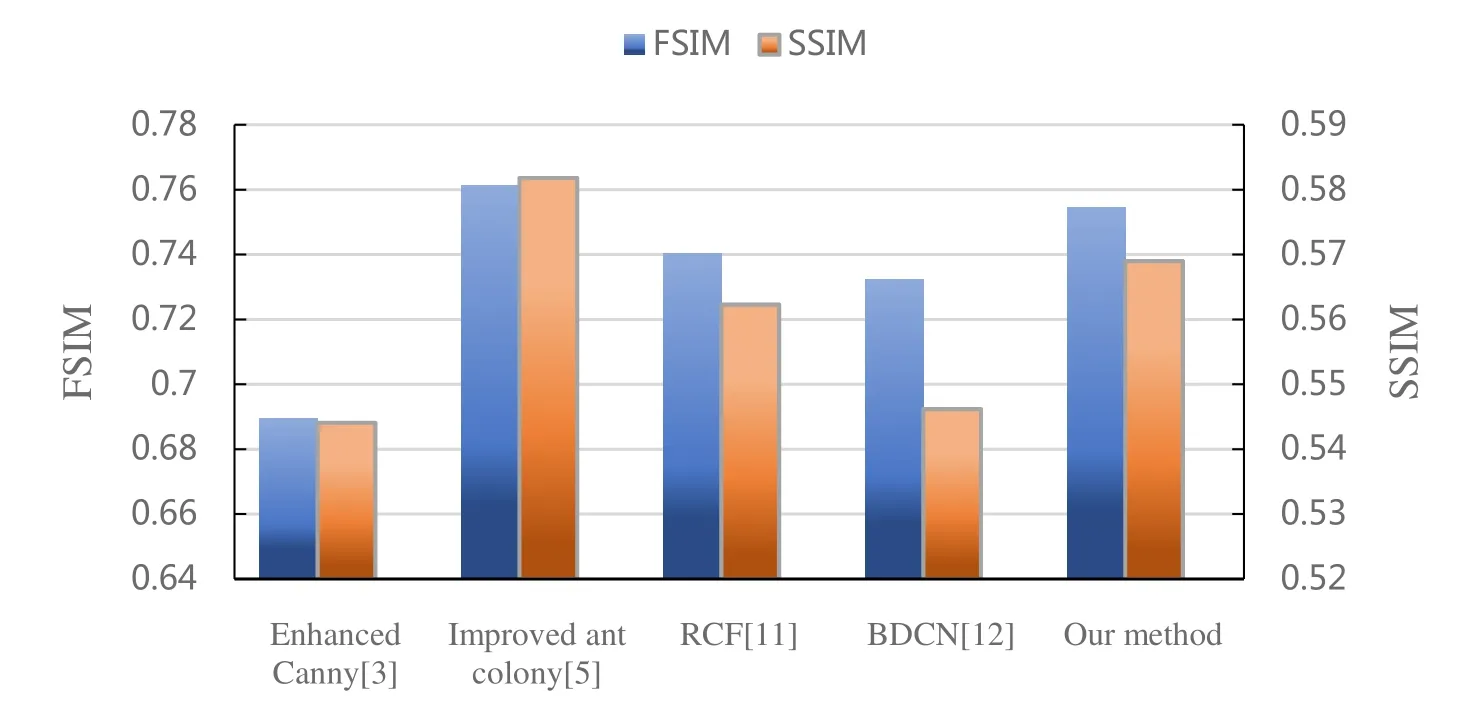

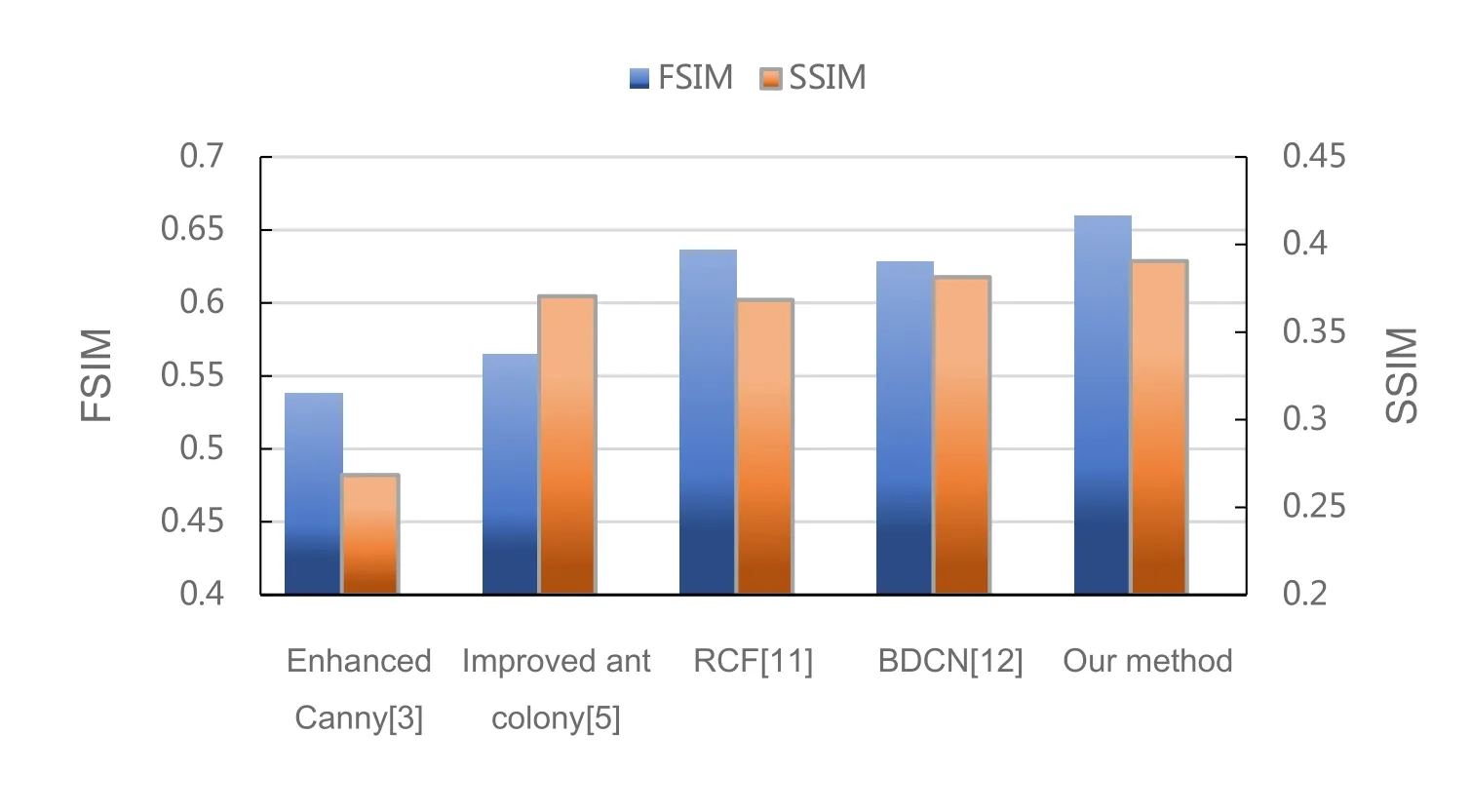

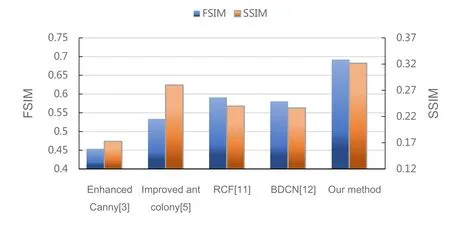

3.3.2 定量結果

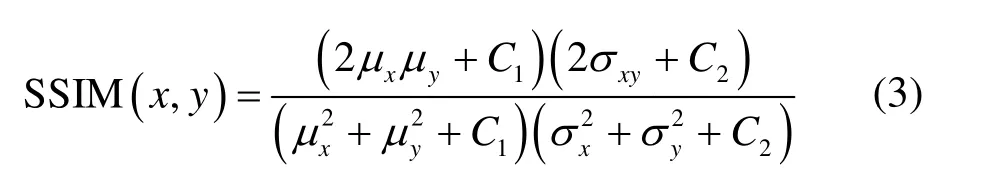

由于缺少用于評價紅外圖像邊緣檢測效果的標準數據集,這里采用了SSIM[25]和FSIM[26]兩個指標來定量評價紅外圖像的邊緣檢測效果。

SSIM是一種符合人眼視覺系統特性的圖像質量客觀評判標準,其具體形式為:

式中:x表示原圖;y表示邊緣圖像;μx和μy分別表示對應圖像的均值;σx和σy分別表示對應圖像的方差;σxy表示x和y的協方差。SSIM衡量了兩幅圖像的相似度,其取值范圍為[0,1],其值越大表示邊緣檢測效果越好。

FSIM 映射特征并測量兩個圖像之間的相似性。因為人類視覺系統(human visual system,HVS)是基于一些低層次特征來感知圖像的,而相位一致性特征(phase congruency,PC)可以很好地刻畫局部結構。同時由于PC 對于圖像的變化具有相對不變性,這有利于提取圖像中穩定的特征,但是有時圖像的變化確實會影響觀感,所以需要使用梯度幅值(gradient magnitude,GM)來彌補。FSIM 中使用了PC 和GM兩個特征互為補充。FSIM 的計算較為繁瑣,這里不再列出。FSIM 值越大表示邊緣檢測效果越好。

圖7~10展示了圖像1~4邊緣檢測效果的定量結果。由圖可見,僅在圖7中,本文方法的SSIM 和FSIM 值略低于文獻[5]的方法,其余表現均明顯優于其他方法。此外,綜合來看,文獻[11]和文獻[12]的表現優于文獻[3]和文獻[5],這也在一定程度上表明了基于深度學習的方法相對于傳統方法的優越性。

圖7 不同方法在圖像1 上測試后的定量結果對比Fig.7 Comparison of quantitative results of different methods on image1

圖8 不同方法在圖像2 上測試后的定量結果對比Fig.8 Comparison of quantitative results of different methods on image2

圖9 不同方法在圖像3 上測試后的定量結果對比Fig.9 Comparison of quantitative results of different methods on image3

圖10 不同方法在圖像4 上測試后的定量結果對比Fig.10 Comparison of quantitative results of different methods on image4

4 總結

本文研究了現有的各類紅外圖像邊緣檢測方法,并分析了紅外圖像邊緣檢測的難點和挑戰,提出了一種基于深度學習的紅外圖像邊緣檢測方法,在DexiNed 的基礎上,對網絡結構和損失函數進行改進,縮減了網絡規模、優化了網絡性能;此外,還通過調整自然圖像邊緣檢測數據集來近似模擬紅外圖像邊緣檢測數據集進行訓練,進一步提高了網絡對紅外圖像中邊緣信息的提取能力。通過實驗,我們驗證了本文對于DexiNed 所做的一系列改進的有效性,并證明了本文方法相比于其他方法的優越性。

為將本文方法應用到實際生產和生活中,后續將研究算法的嵌入式實現,提升計算效率,以實現實時的紅外圖像邊緣檢測。