基于Squeeze-Excitation的音頻場(chǎng)景分類(lèi)研究

喬高杰,廖聞劍

(1.武漢郵電科學(xué)研究院,湖北武漢 430074;2.南京烽火天地通信科技有限公司,江蘇 南京 210019)

音頻場(chǎng)景分類(lèi)(Acoustic Scene Classification,ASC)是計(jì)算機(jī)聽(tīng)覺(jué)場(chǎng)景分析(Computational Auditory Scene Analysis,CASA)[1]的子任務(wù)之一。聲音場(chǎng)景特征是從來(lái)自不同聲源的聲音疊加所形成的一個(gè)復(fù)雜聲信號(hào)中提取出來(lái)的一種高階知識(shí)[2]。音頻場(chǎng)景分類(lèi)的目標(biāo)是識(shí)別音頻的環(huán)境,即將音頻與語(yǔ)義標(biāo)簽關(guān)聯(lián)起來(lái)[3]。

MIT 實(shí)驗(yàn)室早在1997 年提交了第一份有關(guān)于音頻場(chǎng)景分類(lèi)的技術(shù)報(bào)告[4],從那時(shí)開(kāi)始人們逐步開(kāi)展了對(duì)音頻場(chǎng)景分類(lèi)的探索工作。早期的音頻場(chǎng)景分類(lèi)長(zhǎng)期受限于硬件計(jì)算能力和模式識(shí)別領(lǐng)域發(fā)展的瓶頸。當(dāng)時(shí),人們的主要研究思路和關(guān)注點(diǎn)都集中于音頻信號(hào)的時(shí)間特征,因此他們通常都使用高斯混合模型(Gaussian Mixture Model,GMM)或者隱馬爾科夫模型(Hidden Markov Model,HMM)[5-6]。隨著持續(xù)不斷提升的硬件計(jì)算能力以及深入研究的深度學(xué)習(xí)理論知識(shí),很多研究者在音頻場(chǎng)景分類(lèi)任務(wù)中利用深度學(xué)習(xí)來(lái)進(jìn)行研究。

奧地利約翰開(kāi)普勒林茲大學(xué)計(jì)算感知系的研究人員開(kāi)始嘗試將深度學(xué)習(xí)方法應(yīng)用到音頻場(chǎng)景分類(lèi)中[7],并且效果提升顯著。在音頻場(chǎng)景分類(lèi)和聲音事件檢測(cè)(Detection and Classification of Acoustic Scene and Event,DCASE)挑戰(zhàn)賽中,大多數(shù)參賽者均采用CNN[8-10]和RNN[11](Recurrent Neural Network)來(lái)進(jìn)行實(shí)驗(yàn)。例如,在DCASE2016 音頻場(chǎng)景分類(lèi)任務(wù)中,研究者采用8 層VGG 樣式的卷積層網(wǎng)絡(luò)結(jié)構(gòu)獲得的平均準(zhǔn)確率為83.3%[12]。在DCASE2019 音頻場(chǎng)景分類(lèi)任務(wù)中,研究人員采用8 層CNN 結(jié)合GNN(Generative Neural Network)等數(shù)據(jù)增強(qiáng)方法,獲得了平均準(zhǔn)確率為85.2%,并取得音頻場(chǎng)景分類(lèi)任務(wù)冠軍[13]。

在2017 年的ILSVRC 圖像分類(lèi)任務(wù)中,參賽者提出了一種新穎的SE 模塊,該模塊能夠提取特征圖的通道間信息。在當(dāng)時(shí)最優(yōu)的CNN 模型中加入SE模塊后,圖片分類(lèi)的top-5 error 下降到2.251%,因此參賽者獲得了分類(lèi)任務(wù)的第一名[14]。

目前,以對(duì)數(shù)梅爾譜為音頻場(chǎng)景分類(lèi)特征的任務(wù)與圖像分類(lèi)任務(wù)有相似之處,因此文中將SE 模塊引入音頻場(chǎng)景分類(lèi)任務(wù)中。SE 模塊能夠得到不同特征通道的重要程度,并將這些信息加入原始特征中。

1 音頻場(chǎng)景分類(lèi)總體設(shè)計(jì)

1.1 聲學(xué)特征

音頻的特征多種多樣,主要包括時(shí)間特征和頻率特征,此外,相干聲與環(huán)境聲的提取[15]也獲得了研究人員的關(guān)注。文中選取的聲學(xué)特征為目前深度學(xué)習(xí)中普遍使用的對(duì)數(shù)梅爾譜圖。因?yàn)閷?duì)數(shù)梅爾譜圖中包含了時(shí)間信息和頻率信息,因此能夠包含更多的音頻特征。接下來(lái)對(duì)用到的主要內(nèi)容進(jìn)行簡(jiǎn)單介紹。

首先,將音頻信號(hào)經(jīng)過(guò)分幀、加窗和離散傅里葉變換,通過(guò)分幀和加窗可將時(shí)間跨度較長(zhǎng)的信號(hào)裁剪為時(shí)間跨度小的幀,同時(shí)利用離散傅里葉變換將每一幀信號(hào)從時(shí)域轉(zhuǎn)到頻域,得到信號(hào)的頻譜,之后將每一幀的頻譜拼接成語(yǔ)譜圖;其次,將上述語(yǔ)譜圖的幅度譜通過(guò)設(shè)計(jì)好的梅爾濾波器組即可得到梅爾譜;最后,對(duì)梅爾譜取對(duì)數(shù)即可得到信號(hào)的對(duì)數(shù)梅爾譜圖。

在相同距離的條件下,相較于高頻信號(hào),低頻信號(hào)的衰減更小,并且人耳還存在掩蔽效應(yīng),基于以上特性,聲學(xué)專(zhuān)家設(shè)計(jì)出了將聲音頻帶從低到高按照臨界帶寬由密到疏地帶通濾波器組,即梅爾濾波器組。

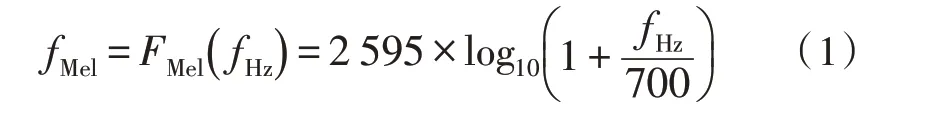

梅爾濾波器的設(shè)計(jì)首先將自然頻率(fl,fh)通過(guò)式(1)轉(zhuǎn)換到梅爾頻率范圍。

其次,在梅爾尺度下使用一系列等距的三角形帶通濾波器組成梅爾濾波器組。假設(shè)M為濾波器的個(gè)數(shù),第m個(gè)三角濾波器的頻率響應(yīng)如式(2)所示,其中,1 ≤m≤M。

其中,f(m)為濾波器的中心頻率,為式(1)的逆函數(shù)。

1.2 Squeeze-Excitation

卷積神經(jīng)網(wǎng)絡(luò)能夠利用感受野感知空間并通過(guò)提升通道的數(shù)量對(duì)更深層次的特征信息進(jìn)行提取,但通道與通道之間的信息卻沒(méi)有被關(guān)注到。為了考慮通道與通道之間的信息,在CNN 網(wǎng)絡(luò)中加入Squeeze-Excitation 模塊,并將通道信息加入到原始的特征中,進(jìn)而神經(jīng)網(wǎng)絡(luò)可利用全局信息降低特征表達(dá)能力較弱的通道,而加強(qiáng)特征表達(dá)能力強(qiáng)的通道,并且可以自主學(xué)習(xí)到各通道對(duì)任務(wù)的重要性,從而提高網(wǎng)絡(luò)對(duì)信息的表達(dá)能力。

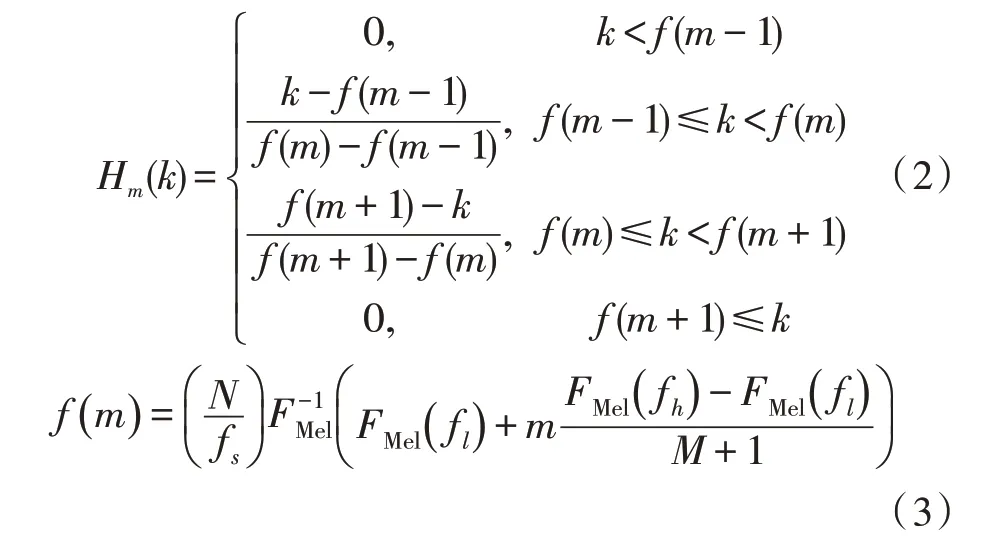

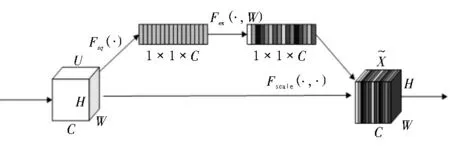

Squeeze-Excitation的原理圖如圖1 所示,假設(shè)前面網(wǎng)絡(luò)的輸出的特征圖為U,U的尺寸為(H,W,C),H、W、C分別為高、寬和通道數(shù)。首先將第c個(gè)特征圖uc進(jìn)行Squeeze 操作(記為Fsq),輸出為zc,計(jì)算過(guò)程如式(4)所示。將所有特征圖經(jīng)過(guò)Squeeze 操作輸出記為z,z的形狀為1×1×C。

圖1 Squeeze-Excitation的原理圖

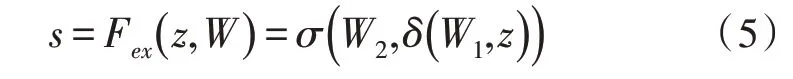

其次,將z進(jìn)行Excitation 操作(記為Fex),結(jié)果為s,計(jì)算過(guò)程見(jiàn)式(5)。

式中,W1和W2均表示全連接層的維度數(shù),σ和δ分別表示sigmoid 和relu 激活函數(shù)。

最后,將經(jīng)過(guò)式(6)Scale 操作(記為Fscale)的s加權(quán)給U,輸出為。

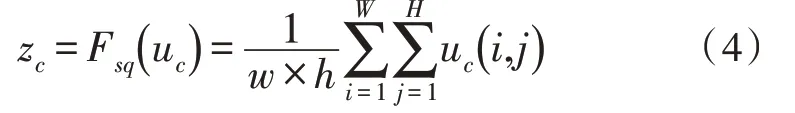

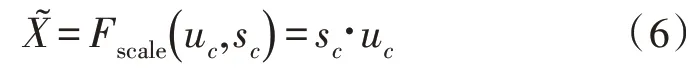

SE 模塊的網(wǎng)絡(luò)結(jié)構(gòu)如圖2 所示。首先,通過(guò)一個(gè)全局平均池化層壓縮特征圖的空間信息同時(shí)提取特征圖的通道信息;其次,通過(guò)兩個(gè)全連接層學(xué)習(xí)并融合通道維度的特征信息,與此同時(shí),通過(guò)兩個(gè)激活層Activation 1 與Activation 2 進(jìn)行非線性地學(xué)習(xí)通道之間的信息并調(diào)整輸出權(quán)重的數(shù)目。值得注意的是,Activation 1 和Activation 2 使用的激活函數(shù)分別是relu 和sigmoid。最后,將網(wǎng)絡(luò)提取出來(lái)的通道信息以權(quán)重的方式添加到原來(lái)的特征中。

圖2 Squeeze-Excitation的網(wǎng)絡(luò)結(jié)構(gòu)

1.3 網(wǎng)絡(luò)結(jié)構(gòu)

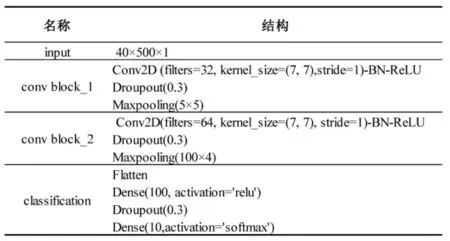

文獻(xiàn)[9]通過(guò)實(shí)驗(yàn)證明了4 個(gè)卷積層的網(wǎng)絡(luò)性能較6 個(gè)卷積層的網(wǎng)絡(luò)性能好,同時(shí)淺層網(wǎng)絡(luò)的計(jì)算效率高,占用資源少。文中采用兩層CNN 作為分類(lèi)器,基線系統(tǒng)的結(jié)構(gòu)如圖3 所示,兩個(gè)卷積層均采用7×7的卷積核尺寸與全零填充,每個(gè)卷積層之后均采用了批標(biāo)準(zhǔn)化(Batch Normalization,BN)和Droupout 來(lái)防止過(guò)擬合。同時(shí),除最后的分類(lèi)使用softmax 作為激活函數(shù)外,網(wǎng)絡(luò)均采用relu 作為激活函數(shù)。relu 函數(shù)相較于sigmoid 與tanh 等激活函數(shù)有著復(fù)雜度低、計(jì)算速度快和占用資源少等優(yōu)點(diǎn)。

圖3 基線系統(tǒng)的網(wǎng)絡(luò)架構(gòu)

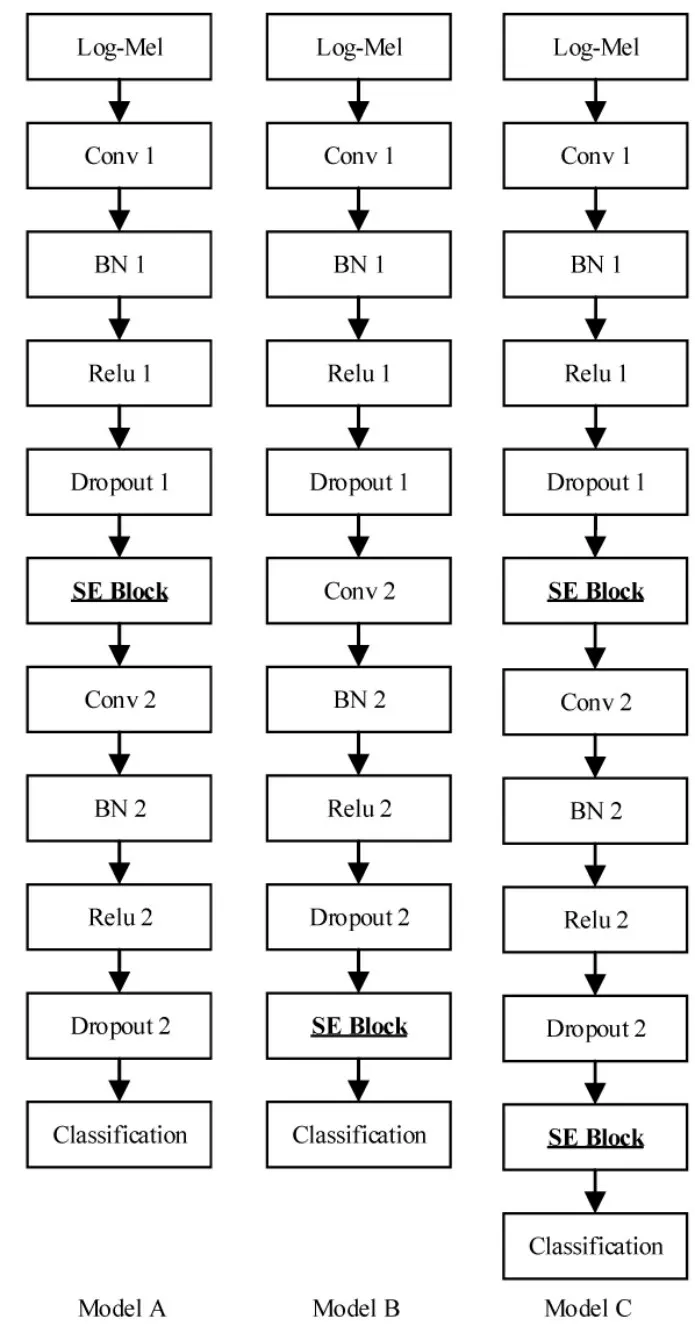

實(shí)驗(yàn)的網(wǎng)絡(luò)結(jié)構(gòu)如圖4 所示,Model A 和Model B在基線系統(tǒng)的conv Block_1 和conv Block_2 兩個(gè)卷積塊之后分別添加SE 模塊;Model C 在基線系統(tǒng)的基礎(chǔ)上,在conv Block_1 和conv Block_2 兩個(gè)卷積塊之后同時(shí)添加SE 模塊。基線系統(tǒng)分別與Model A 和Model B 進(jìn)行對(duì)比可以獲取是否添加SE 模塊的性能變化情況及添加SE 模塊的位置對(duì)網(wǎng)絡(luò)性能的影響;將Model A、Model B 和Model C 進(jìn)行對(duì)比可以得到添加SE 模塊數(shù)量對(duì)網(wǎng)絡(luò)性能的影響。

圖4 實(shí)驗(yàn)中的模型結(jié)構(gòu)圖

2 實(shí)驗(yàn)數(shù)據(jù)和設(shè)置

2.1 實(shí)驗(yàn)數(shù)據(jù)

實(shí)驗(yàn)數(shù)據(jù)選擇DCASE2019 中task1a的開(kāi)發(fā)數(shù)據(jù)集[16-18]。數(shù)據(jù)采用的是雙聲道采樣率為48 kHz,分辨率為24 Bit的設(shè)備進(jìn)行采集。這些音頻是在歐洲的阿姆斯特丹、巴塞羅那和倫敦等12 個(gè)城市進(jìn)行錄制的。整個(gè)數(shù)據(jù)集有14 400 個(gè)長(zhǎng)度為10 s的音頻數(shù)據(jù),包括了飛機(jī)場(chǎng)、地鐵站和廣場(chǎng)等10 個(gè)音頻場(chǎng)景。文中采用7∶3的比例劃分訓(xùn)練集和測(cè)試集,同時(shí)訓(xùn)練集中30%的數(shù)據(jù)用于驗(yàn)證。

2.2 實(shí)驗(yàn)設(shè)置

首先,將10 s的原始音頻信號(hào)轉(zhuǎn)成單通道的音頻,其次,對(duì)音頻幀長(zhǎng)為1 920 且?guī)茷?60 進(jìn)行分幀并使用漢寧窗,同時(shí)采用2 048 點(diǎn)的STFT 將信號(hào)轉(zhuǎn)變到頻域,得到語(yǔ)譜圖,最后,對(duì)40 個(gè)梅爾濾波器組取對(duì)數(shù)得到音頻的對(duì)數(shù)梅爾譜圖。以上的特征均采用Python 音頻處理的librosa 工具進(jìn)行提取。最終,得到尺寸為40×500×1的對(duì)數(shù)梅爾譜圖,并且將特征輸入到CNN網(wǎng)絡(luò)中進(jìn)行進(jìn)一步的深度特征提取。

實(shí)驗(yàn)硬件環(huán)境為Intel i7-9700K CPU、Nvidia GTX 1080Ti GPU 和16GB 內(nèi)存。軟件環(huán)境為Python 3.6、Tensorflow 1.12.0 和Keras 2.2.4。

3 實(shí)驗(yàn)結(jié)果與分析

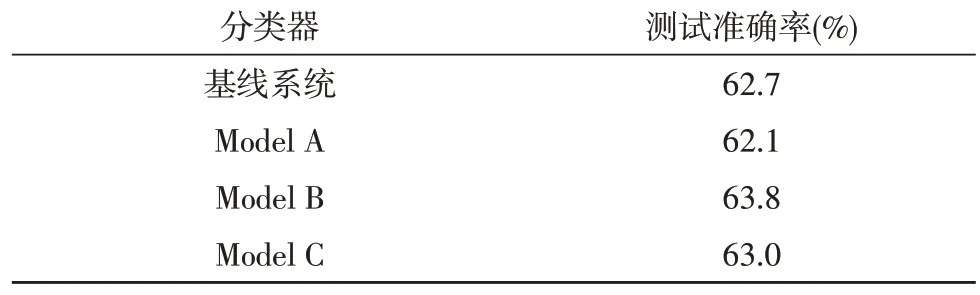

文中通過(guò)相同的方式對(duì)上述的4 個(gè)網(wǎng)絡(luò)進(jìn)行訓(xùn)練,并利用測(cè)試數(shù)據(jù)測(cè)試模型的性能,具體的實(shí)驗(yàn)結(jié)果如表1 所示。根據(jù)表1 可知,基線系統(tǒng)的Model A準(zhǔn)確率最低為62.1%,相較于基線系統(tǒng)準(zhǔn)確率降低了0.6%;Model B的準(zhǔn)確率最高為63.8%,相較于基線系統(tǒng)準(zhǔn)確率提升了1.1%,相較于Model A 準(zhǔn)確率提升了1.7%;Model C的準(zhǔn)確率為63.0%,介于基線系統(tǒng)與Model B的準(zhǔn)確率之間。

表1 不同模型的測(cè)試準(zhǔn)確率

Model A 效果沒(méi)有提升反而下降,究其原因或是加入SE 模塊的位置過(guò)于靠前,通道數(shù)量不足而導(dǎo)致通道間的信息較少。而Model B的輸入特征通道數(shù)量有明顯增加,測(cè)試效果提升較大。Model C 中包含兩個(gè)SE 模塊,相較于Model B 性能有所下降,由此可見(jiàn),并不是增加SE 模塊的數(shù)量就能改善模型的分類(lèi)性能,而相較于基線系統(tǒng)性能亦有所提升,再次證明了SE 模塊能夠提升網(wǎng)絡(luò)的性能。

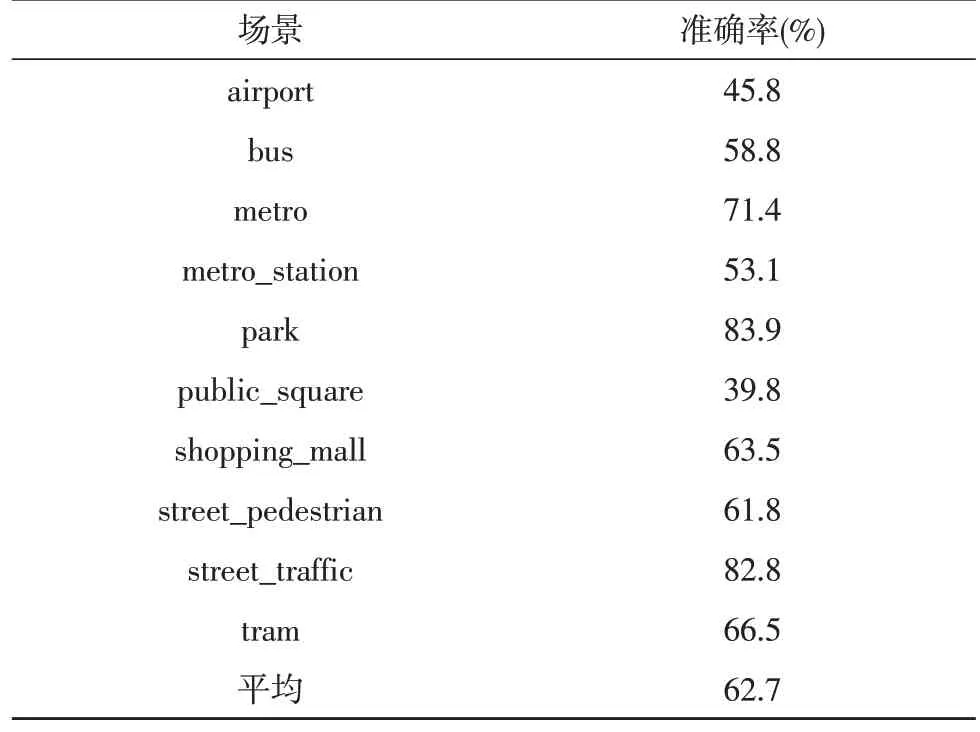

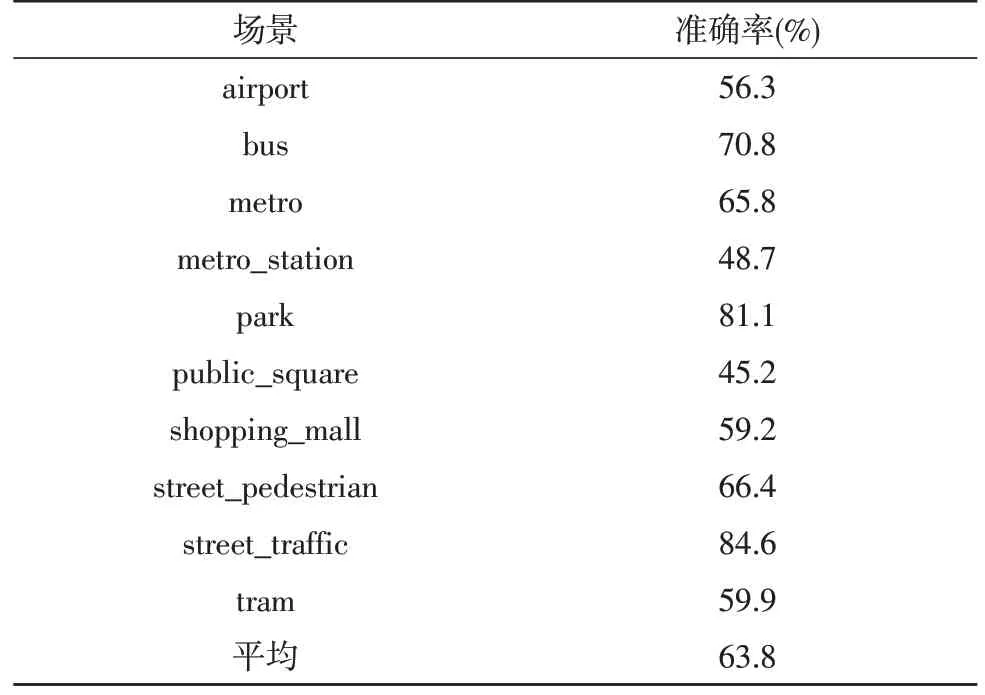

為了更詳細(xì)地展現(xiàn)添加SE 模塊后的模型分類(lèi)效果提升,基線系統(tǒng)和Model B的詳細(xì)分類(lèi)結(jié)果分別如表2 和表3 所示。在基線系統(tǒng)中公園(記為park)場(chǎng)景的分類(lèi)準(zhǔn)確率最高為0.839,而Model B 中繁忙的街道場(chǎng)景(記為street_traffic)的分類(lèi)準(zhǔn)確率最高為0.846;在基線系統(tǒng)和Model B 中,分類(lèi)準(zhǔn)確率最低的場(chǎng)景均是公共廣場(chǎng)(記為public_square),其中基線系統(tǒng)分類(lèi)準(zhǔn)確率為0.398,而Model B 中的分類(lèi)準(zhǔn)確率為0.452。

表2 基線系統(tǒng)分類(lèi)結(jié)果

表3 Model B的分類(lèi)結(jié)果

通過(guò)對(duì)比基線系統(tǒng)與Model B的分類(lèi)結(jié)果可知,在飛機(jī)場(chǎng)、大巴、公共廣場(chǎng)、步行街和繁忙街道5 個(gè)場(chǎng)景中,Model B的分類(lèi)效果均優(yōu)于基線系統(tǒng);而在地鐵、地鐵站、公園、購(gòu)物中心和電車(chē)5 個(gè)場(chǎng)景中,基線系統(tǒng)的分類(lèi)準(zhǔn)確率高于Model B。

上述分析表明,相較于基線系統(tǒng),添加SE 模塊在某些場(chǎng)景下的分類(lèi)效果會(huì)下降,而在另外的場(chǎng)景下分類(lèi)效果會(huì)得到較高的提升,總體上分類(lèi)效果得到提高,且在通道數(shù)較多時(shí)添加SE 模塊能更明顯提升網(wǎng)絡(luò)的分類(lèi)效果。

4 結(jié)論

文中搭建了一個(gè)性能良好的音頻場(chǎng)景分類(lèi)系統(tǒng),在基本的CNN 網(wǎng)絡(luò)中加入SE 模塊,充分地考慮了特征的不同通道間的信息,并對(duì)SE 模塊在網(wǎng)絡(luò)中的位置和數(shù)量進(jìn)行了探究。通過(guò)實(shí)驗(yàn)對(duì)比可知加入SE 模塊與普通的CNN 網(wǎng)絡(luò)以及SE 模塊添加位置和數(shù)量對(duì)整個(gè)模型分類(lèi)效果的影響,驗(yàn)證了在通道數(shù)比較多時(shí),加入通道間的信息能夠提升模型的場(chǎng)景分類(lèi)性能。