融合子圖結構的神經推理式知識庫問答方法

陳子陽,廖勁智,趙 翔,陳盈果

國防科技大學 信息系統工程重點實驗室,長沙 410073

問答系統(question answering,QA)是自然語言處理(natural language processing,NLP)主要的研究領域之一,旨在讓計算機能夠理解自然語言形式的問題,并且自動地給出答案[1]。近年來,隨著知識圖譜(knowledge graph,KG)技術的不斷發展,出現了以Freebase[2]、DBpedia[3]、CN-DBpedia[4]為代表的大規模知識圖譜。知識圖譜通過將現實中的知識結構化為實體與實體間關系,利用(h,r,t)的三元組形式進行表示,其中h、r、t分別代表頭實體(head)、關系(relation)和尾實體(tail),這種組織形式更有利于研究者發現、探索知識之間的關聯關系。因此,綜合問答系統優勢與知識庫特性的知識庫問答(knowledge base question answering,KBQA)受到了學術界和工業界的廣泛關注[5-6]。

知識庫問答旨在通過知識庫中結構化的知識回答自然語言問題。目前主流的研究工作大致可分為兩類:(1)基于語義解析(semantic parsing,SP)的方法,利用模板和標注信息對問題進行解析,將其轉化為一個圖查詢語句,通過執行該查詢語句來獲取答案;(2)基于神經推理(neural reasoning,NR)的方法,通過從問題和答案中提取出對應的特征,設計相應的打分函數以評價候選答案和問題的語義相關性,最終得分最高的候選答案被作為模型預測的答案輸出。

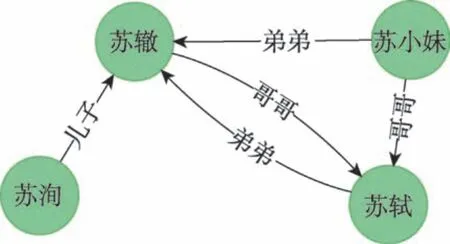

基于語義解析的代表性工作QUINT(自動化模板生成模型)[7]通過自動從問題語句的組成部分和KG 查詢的對齊中學習語句-查詢模板,解決了傳統SP 工作中對人工模板的依賴問題。然而,由于知識圖譜通常存在鏈接缺失問題,如DBpedia 和Freebase中分別有66%和71%的人物實體缺少出生地信息[8],導致了QUINT 無法通過簡單的查詢獲得預期的結果。舉例而言,圖1 展示的是蘇軾相關的知識圖譜,其中蘇軾和蘇洵之間缺失了相應的關系。針對這個圖譜,如果提出問題“蘇軾的父親是誰?”,即使其正確解析了問題,并且給出了合理的圖查詢語句,該模型也是難以給出正確答案的,因為其無法在知識庫中尋找到<蘇軾,父親,?>這條知識。

Fig.1 Knowledge graph related to Su Shi圖1 蘇軾相關圖譜

基于神經推理的代表性工作MCCNNs(multicolumn convolutional neural networks)[9]通過引入多列卷積神經網絡來對問句的三個方面(答案關系路徑、答案上下文和答案類型)進行理解和分布式表征學習,再通過評分函數對候選答案進行排序輸出。利用語義相關性,MCCNNs 能夠一定程度上避免知識圖譜鏈接缺失問題。然而,由于MCCNNs 需預先對圖譜中實體進行訓練,基于獲得的表示向量進行后續操作,這導致了其無法處理動態場景下新出現實體(冷啟動)相關的問題。譬如,當圖1 中的圖譜添加新的鏈接<蘇軾,好友,黃庭堅>后,針對問題“蘇軾的好友是誰?”,因缺失新實體“黃庭堅”的語義向量,模型無法進行推理。

針對上述問題,本文提出了一種融合子圖結構的神經推理式知識庫問答模型(incorporating subgraph structure via neural reasoning,ISS-NR),通過綜合知識圖譜中的子圖結構信息以及問句和實體的語義信息進行推理,解決了圖上鏈接缺失與實體冷啟動問題。具體來說,為克服知識圖譜中的鏈接缺失問題,ISS-NR 借鑒了神經推理式模型中對圖譜進行預訓練的思想,在對實體向量的表示過程中引入了預訓練過程,以實現在鏈接缺失的情況下,仍能利用語義相關性對問題進行推理預測。針對實體冷啟動問題,本文設計了利用子圖結構信息增強實體向量表示的模塊,包括子圖構建、子圖信息表示及信息融合等,實現了利用新實體的子圖結構信息對其進行編碼表示更新,使得模型具備了優良的泛化能力。本文主要有如下三個貢獻:

(1)提出了一種融合子圖結構的神經推理式知識庫問答模型,在問答過程中兼顧實體的子圖結構信息及其語義信息,使其具有更強的推理能力。

(2)針對當前神經表示中新實體冷啟動問題,設計了相關子圖匹配、抽取與表示融入模塊,利用子圖結構信息編碼表示新實體。

(3)利用WebQuestionsSP 數據集驗證了本文方法的有效性,實驗結果也證實了本文提出的模型取得了當前最好的效果。

1 相關工作

知識庫問答是一種利用知識庫中結構化的知識對自然語言問題進行推理回答的任務。目前主流的知識庫問答有兩類,分別是基于語義解析的方法和基于神經推理的方法。

1.1 基于語義解析的知識庫問答

基于語義解析的方法通過模板和標注信息對問題進行解析,并且轉化為一個圖查詢語句,在知識庫中執行該查詢語句來獲取答案。為了更好地理解自然語言形式的問題,許多方法依賴于句法分析,例如依存關系[10-11]。文獻[12]提出了一個STAGG(staged query graph generation)框架,首先定義一個可以直接轉化為Lambda 演算的查詢圖,然后將語義解析的過程演變為查詢圖生成過程。利用圖譜信息對語義解析空間進行了裁剪,簡化了語義匹配的難度。對于人工模板的依賴問題,文獻[7]提出了一種自動生成模板的QUINT 模型,能夠自動從問題語句的組成部分和KG 查詢之間的對齊中學習語句-查詢模板。

但是,知識圖譜上往往存在鏈接缺失問題,為語義解析方法帶來了額外的挑戰。若問題所要查詢的關系鏈接恰好缺失,那么即使模型對問題的解析是正確的,查詢時也無法產生正確的答案。同時,這個問題也增大了模型在訓練過程中學習到錯誤模式的概率,導致性能下降。

1.2 基于神經推理的知識庫問答

基于神經推理的方法主要利用語義相關性,設計相應的打分函數對候選實體進行打分,選取得分最高的作為答案。文獻[13]是該類方法的基礎模型。文章首先對問句進行句法分析,并提取特征詞匯,將其轉化為問句特征圖;然后在KG 內提取相關候選答案的特征圖;最后將問句中的特征與候選特征圖中的特征進行組合,直接通過分類器來學習。

為了豐富問答時的支撐信息,部分工作[14-15]提出用額外的問題相關文本語句(例如維基百科中與問題相關的文本語料)等非結構化知識來補充從知識庫中提取的子圖,形成一個異構圖,并在其上進行推理,取得了效果的提升。

除了額外的文本語料庫外,文獻[16]采用了知識庫嵌入的方法,通過進行缺省鏈接預測來緩解知識庫的稀疏性。MCCNNs[9]通過多列卷積神經網絡來對問句的三個方面(答案關系路徑、答案上下文和答案類型)進行理解和分布式表征學習,獲取更多有效的特征,取得了優異的效果。

但是,由于該類方法需預先對圖譜中實體進行訓練,在獲得的表示向量的基礎上開展研究,這導致了其無法回答動態場景下新出現實體(冷啟動)相關的問題。

2 方法與模型

本章首先給出了知識庫問答的任務定義,其次詳細介紹了模型的原理和訓練預測流程。

定義1(知識庫問答任務)知識庫問答的目標就是給定自然語言問題Q,通過對知識庫G中的結構化信息進行查詢和推理,從而得到實體集A作為問題的答案。

例如,針對問題“蘇軾的父親是誰?”,可以通過知識圖譜中的<蘇軾,父親,蘇洵>這個三元組得到答案。對于更為復雜的問題,可以利用多個三元組進行推理得到答案。例如,對于問題“錢學森的妻子曾任職于哪個單位?”,可以通過<錢學森,妻子,蔣英>和<蔣英,任職,中央音樂學院>兩個三元組推理進行回答。

2.1 模型總覽

本文提出了融合子圖結構的神經推理式知識庫問答模型ISS-NR,同時利用實體的子圖結構信息與語義信息完成自然語言形式的多跳推理問答。模型的總體框架如圖2 所示,主要包括三個模塊:

(1)問題編碼:對自然語言形式的問題進行編碼,將其轉換為包含語義信息的向量形式,以作為后續相關操作的基礎輸入。

(2)子圖信息抽取:為充分利用知識圖譜的結構和語義信息,首先針對查詢中的主實體從知識圖譜中抽取其k階子圖,其次利用圖神經網絡捕捉結構信息,最后融合結構向量表示與神經推理中預訓練得到的向量表示,為下一步的推理問答提供充分的支撐信息。

(3)答案評分:利用全連接網絡對候選答案集進行評分排序,輸出最后的預測結果。

2.2 問題編碼模塊

本模塊旨在將自然語言形式的問題q編碼為固定維度的向量eq,便于模型后續的處理和使用。為了讓問句的編碼具有泛化能力,不局限于某個具體實體的預測,在編碼過程中,將實體信息從問句中刪除,保留剩余部分作為編碼的主體。具體而言,對于給定的問題q和問句中涉及的主實體h,首先將實體從問句中剔除,只保留不含實體的問句q′,再通過預訓練模型RoBERTa(robustly optimized BERT approach)[17]將自然語言形式的問句轉化為768 維的向量。

2.3 子圖構建

存在語義關系的兩個實體一般在結構關系上也會相近,因此ISS-NR 選取子圖作為模型推理的范圍。為方便表述,給出以下定義:

定義2(k階問答子圖)對于問題主題實體u和答案實體v,將u到v所有長度小于等于k的路徑集合所構成的圖稱為實體u和v的k階問答子圖。

通過Dijkstra 算法實現對目標節點問答子圖的抽取。Dijkstra 算法[18]是經典的最短路徑算法,能夠在圖網絡上計算一個節點到其他節點的最短路徑。它的核心思想就是以起始點為中心向外逐層擴展,同時不斷更新起始點到其他節點的最短路徑長度,直到擴展到終點為止。問答子圖抽取的具體流程可以歸納為五個步驟:

(1)選定目標節點u和v;

(2)分別選取u和v周圍距離k以內的鄰居節點和邊,記為Nk(u)和Nk(v);

(3)計算Nk(u)和Nk(v)的交集Nk(u)?Nk(v);

(4)去除孤立節點;

(5)利用Dijkstra 算法計算每個節點到u和v的距離,保留到u和v的距離都小于k的節點,構成最終的關系子圖。

問答子圖中包含了問題實體u到答案實體v推理所需的路徑和結構信息,為之后的模型步驟提供了充分的信息來源,同時也去除了無用信息,減少了模型推理的范圍。

Fig.2 Framework of ISS-NR圖2 ISS-NR 模型框架

2.4 子圖信息學習

推理的前提是擁有充分且可使用的信息,為了讓復雜的圖結構轉化為計算機能夠處理運算的形式,ISS-NR 使用圖神經網絡對子圖的結構進行嵌入學習。

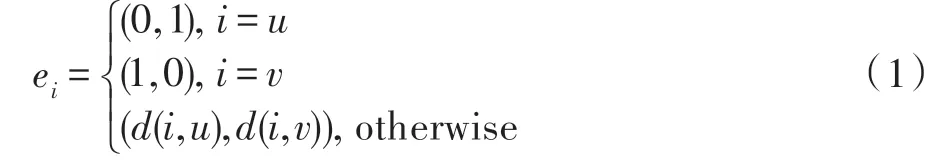

其中,u為起始節點;v為末尾節點;d(i,u)表示節點i和u的最短距離;d(i,v)表示節點i和v的最短距離。

通過使用距離的獨熱向量來對節點進行標注,節點的表示能夠充分包含關系子圖上節點的結構拓撲信息,為之后的評分提供了信息基礎。

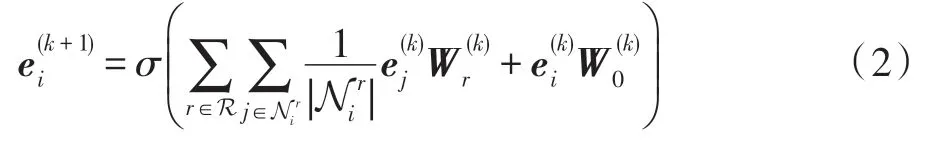

標記完節點后,得到一個具有初始表示的關系子圖,但是各個節點信息不夠完善,缺失了重要的鄰居節點和邊的信息,無法直接進行推理。因此,需要在圖嵌入模塊使用圖神經網絡對節點的表示進行更新迭代,使得各個節點的嵌入表示能夠蘊含鄰居和邊的信息,為推理提供充分的信息來源。ISS-NR 使用R-GCN(relational graph convolutional networks)[19]對子圖的信息進行聚合,以更新各個節點的表示,為其增加鄰居和邊的信息,同時獲取圖G(u,rt,v)的嵌入表示。

R-GCN 將節點表示與鄰居表示進行聚合,實現節點表示的迭代更新。更新的節點表示可以用下式進行計算:

在多次迭代更新后,節點的表示向量能夠充分獲取子圖上的結構信息,而這些結構信息中則蘊含了問題的推理過程。

對各個節點的表示向量求和取平均值作為該子圖的表示。假設R-GCN 網絡的層數為L,則對于u和v的關系子圖G(u,rt,v)可以用下式計算其嵌入表示:

其中,VG(u,rt,v)表示G(u,rt,v)中節點的集合。

通過使用R-GCN 對子圖進行圖嵌入學習,能夠獲得子圖的表示向量和各個節點的表示向量,其中包含了豐富的圖結構信息,為推理任務提供了信息基礎。

2)建筑物縱橫墻等交接處的兩側,不同地質條件、不同荷載分布、不同基礎類型、不同基礎埋深、不同上部結構的兩側,沉降監測點選取在建筑物拐角,并且容易進行測量的位置。監測點要牢固,容易保存,以便進行多次測量。

2.5 表示信息融合

為克服知識圖譜中的鏈接缺失問題,ISS-NR 融合了知識表示模型ComplEx(complex embeddings)[20]訓練得到的節點向量,以實現存在缺失的情況下,仍能利用語義相關性對問題進行推理預測。ComplEx能夠將知識圖譜中的關系和實體映射到復數空間中。

首先為知識庫中每個實體隨機賦值初始值,同時構建正樣本集合和負樣本集合,通過梯度下降法進行多次迭代訓練,使真實樣本更滿足ComplEx 的約束條件,錯誤樣本更遠離約束條件,最終獲得每個節點的ComplEx 表示向量。

2.6 答案評分

經過以上步驟獲取了問題的語義向量eq,問答子圖G(u,rt,v)的嵌入、問題主實體嵌入和答案實體嵌入,這些嵌入向量中包含了u到v推理所需的信息。

為了將向量中蘊含的信息進行提取輸出,首先對獲取的4 個嵌入表示進行聚合,將4 個嵌入直接拼接作為聚合向量進行后續的計算。

接下來使用線性層對聚合向量進行評分:其中,WT是線性層的權重系數矩陣。根據得分的高低來判斷候選答案的可信度,得分越高代表答案正確的可能性越大。

2.7 訓練與預測

2.7.1 模型訓練

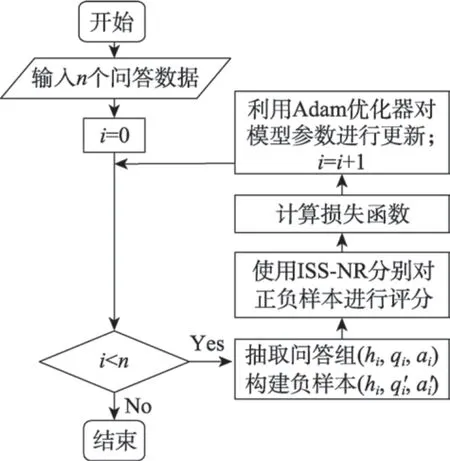

對于給定的問答訓練集,將訓練集中問題的正確答案作為正樣本,然后隨機替換答案構建負樣本,通過給正樣本打更高的分數來實現對模型權重參數的學習,其損失函數為:

其中,E 是訓練集中所有三元組的集合;pi和ni分別指正樣本和負樣本;γ是邊距超參數。使用Adam優化器[21]來實現對模型參數的學習。Adam 優化器是對隨機梯度下降法的擴展,可以更有效地更新網絡權重。模型訓練的流程如圖3 所示。

Fig.3 Training flowchart圖3 訓練流程圖

2.7.2 模型預測

通過模型訓練,可以得到所需的模型參數,實現對候選答案的問答子圖進行評分,分數越高代表該候選答案為真的可能性越大。基于這樣的模型結構,在對缺失的知識進行預測推理時,可以遍歷G 中的所有實體,構建可能的候選實體列表:

對于列表中的三元組,使用訓練好的模型對其進行可能性評分,選取評分最高的實體作為預測結果:

在絕大部分情況下推理預測的結果都是問題主實體head 兩跳內的節點,因此,為了兼顧性能和準確度,在實際預測中,模型選取head 兩跳內的節點作為候選答案進行評分,以獲取更快的推理速度。

3 實驗及分析

本章對ISS-NR 模型進行了實驗測試,并且和傳統方法進行了對比分析。

3.1 實驗設定

3.1.1 實驗數據集

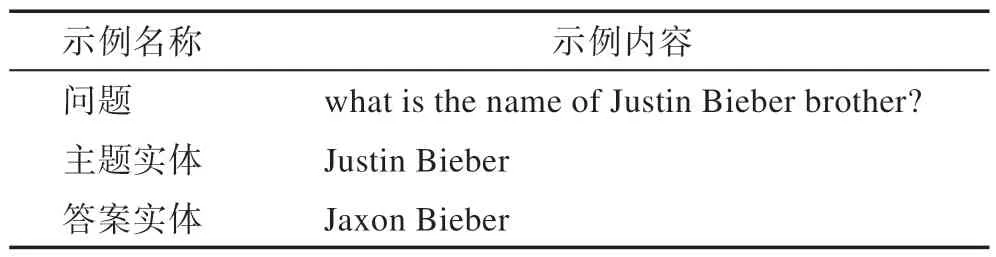

本文使用WebQuestionsSP[22](https://www.microsoft.com/en-us/download/details.aspx?id=52763)作 為實驗數據集驗證模型效果。WebQuestionsSP 是為了解決真實問題構造的數據集,其中的問題來源于Google Suggest API,是目前使用最廣泛的問答數據集之一。數據集包含訓練數據2 998 條,測試數據1 639 條,數據樣例如表1 所示。

Table 1 Example of dataset content表1 數據集內容示例

此外,由于WebQuestionsSP中的實體均在Freebase(http://www.freebase.com)中出現,本文選用Freebase的子集作為背景知識庫進行實體預訓練。Freebase是一個大型的知識庫,含有超過26 億條三元組和4 600 萬個實體。由于原始知識庫過于龐大且問答數據集中只包含知識庫中部分實體和關系,本文對Freebase 進行篩選。考慮到WebQuestionsSP 中的大部分問題能夠在兩跳范圍內推理解答,本文保留問答數據集中每個實體兩跳范圍內的節點。縮減后的知識庫包含180萬個實體和570萬條三元組數據。

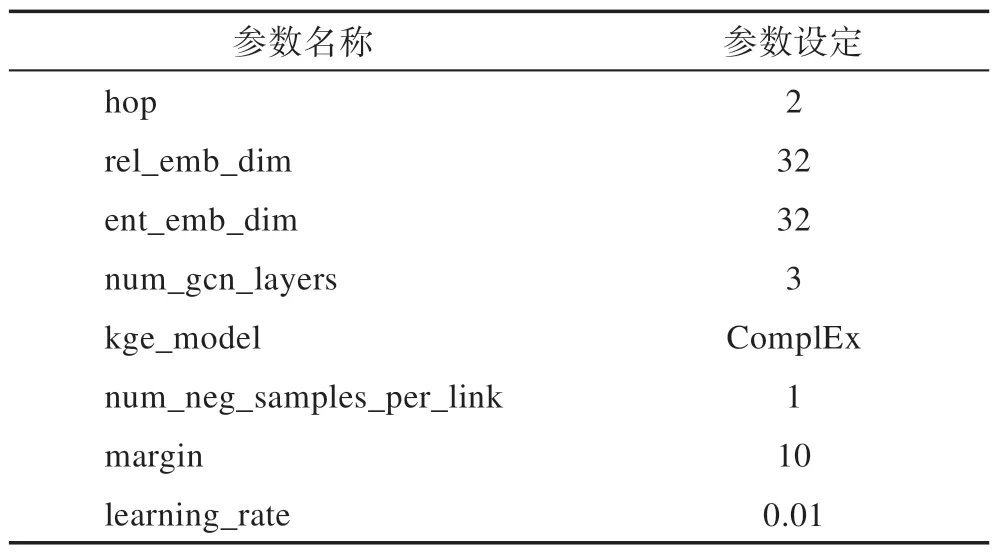

3.1.2 實驗參數設定

實驗中,模型的參數為:問答子圖的階數設置為2,階數越大,問答子圖的規模越大。模型也能夠推斷更復雜的信息,但是訓練復雜度也會上升。對于實驗數據集,跳數設置為2 較為合適。rel_emb_dim(關系嵌入的維數)設置為32,即對于知識庫中的每個關系,將其編碼為一個長度為32 維的向量。ent_emb_dim(實體嵌入的層數)設置為32,即對于知識庫中的每個實體,將其編碼為一個長度為32 維的向量。num_gcn_layers(GCN 的層數)設置為3。kge_model(嵌入的表示模型種類)設置為ComplEx。模型能夠嵌入不同的表示模型,對于本次實驗,選取ComplEx作為嵌入模型,向量維度設置為256 維。num_neg_samples_per_link(負樣本抽取數量)設置為1,對于每個正樣本。隨機替換其頭實體(或尾實體)構建1 個負樣本。margin(間隔超參數)設為10。learning_rate(訓練的學習率)設為0.01。參數設置如表2 所示。

Table 2 Model parameters表2 模型參數

3.1.3 對比模型與評價指標

為了驗證本文模型的有效性,實驗對比了當前主流的基準模型:

(1)KV-Mem(key-value memory networks)[23]是最早嘗試在知識庫問答任務中引入文本信息的模型之一,通過使用鍵值對的形式,將知識庫中的事實和相關文本信息存儲在一個內存表中,以供檢索使用。

(2)STOP+KVQU+SQ(鍵值對增強模型)[24]在KV-Mem 的基礎上進行了增強,加入STOP 模塊和結構化查詢方法。

(3)QUINT[7]利用問答對和依存樹,能夠自動從問題語句的組成部分和KG 查詢之間的對齊中學習語句-查詢模板,實現對復雜問題的回答。

(4)STAGG[13]定義了一個可以直接轉化為Lambda 演算的查詢圖,將語義解析的過程演變為查詢圖生成過程。

(5)MCCNNs[9]使用多列卷積神經網絡來對問句進行多方面的表征學習,通過評分函數對候選答案進行排序輸出。

本文選取準確率(accuracy,ACC)作為性能評價指標。準確率用于衡量預測得分最高的實體是否在真實答案之中,該項數值越大表明模型越好,計算方式如下:

其中,Q表示問句數量;ET為問題Q的實際答案集合;P為模型預測得分最高的實體;函數E表示元素是否在集合中,其值域為{0,1}。

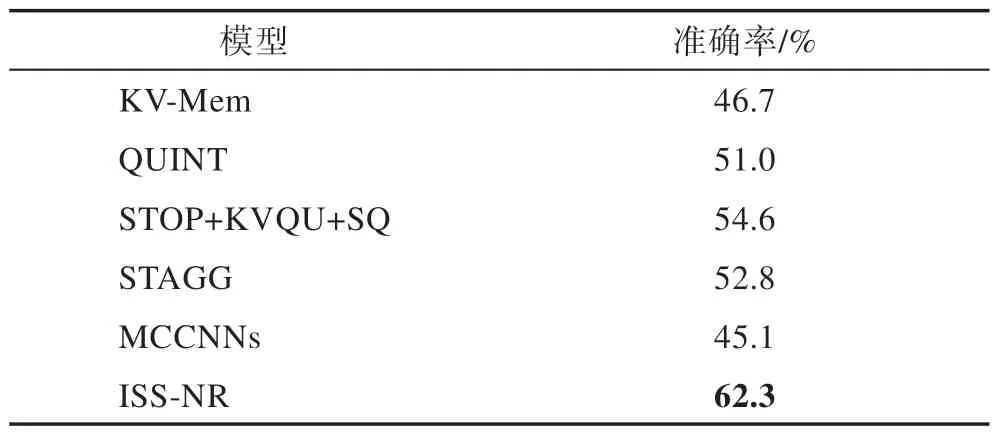

3.2 總體結果

為比較本文模型和基準方法的效果差異,本文在WebQuestionsSP 數據集上將ISS-NR 與上述基準模型進行了對比測試,實驗結果如表3所示,ISS-NR的性能相對于基準方法有著顯著的提升。STOP+KVQU+SQ在KV-Mem 的基礎上進行了增強,同時引入了額外的文本信息,成為當前最優的基準模型。而ISS-NR通過充分提取知識庫中相關實體的結構和語義信息進行問答推理,在不引入外部文本的情況下,準確率相對于最優基準模型提升了7.7 個百分點,說明ISSNR 能夠更有效地利用知識庫中的信息,顯示出本文模型的優勢。

Table 3 Comparison with baseline methods表3 ISS-NR 與基準方法結果比較

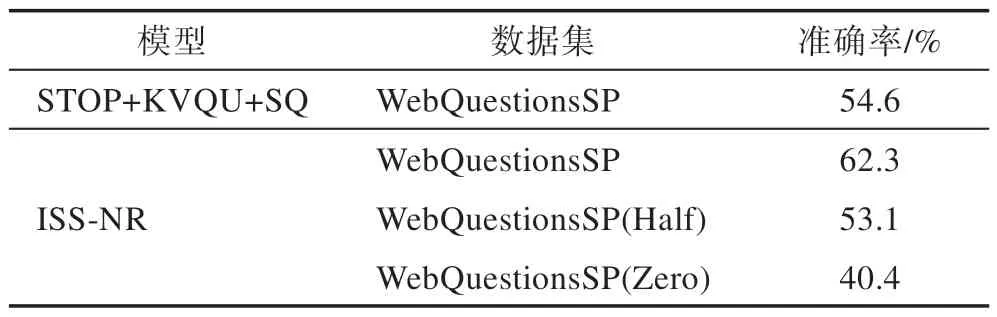

3.3 實體冷啟動實驗

在WebQuestionsSP 數據集中,訓練集和測試集使用相同的知識庫,因此模型訓練時能夠獲取所有的實體信息,不存在實體冷啟動的情況。為了驗證模型解決實體冷啟動問題的效果,本文在Web-QuestionsSP 數據集的基礎上提出了兩個新的數據集WebQuestionsSP(Half)和WebQuestionsSP(Zero)。其中WebQuestionsSP(Half)訓練使用的知識庫是預測時的子集,確保測試集中問題的答案實體不會在訓練中的知識庫出現,通過這樣的方式模擬新增實體導致的冷啟動問題;WebQuestionsSP(Zero)訓練和預測時的知識庫不存在交集,即預測步驟在模型完全未見過的知識庫上進行,以模擬極端情況下的實體冷啟動問題。在新的數據集上進行實驗,結果如表4 所示,ISS-NR 在Half 和Zero 數據集上分別取得了53.1%和40.4%的準確率,其中ISS-NR 在Half 數據集上的效果接近了最優基準方法STOP+KVQU+SQ在完整數據集上的效果。說明ISS-NR 能夠充分利用泛化的子圖結構信息在從未見過的實體上進行推理問答,不會受到具體實體的限制,有效避免了實體冷啟動問題。

Table 4 Results of cold start experiments表4 冷啟動實驗結果

3.4 消融實驗

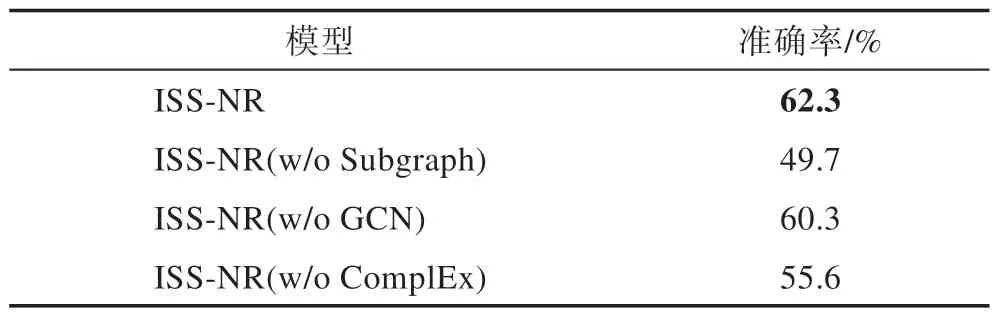

為了驗證ISS-NR 各個模塊的作用,本文使用消融實驗的方法,在模型中剔除或改變某個結構測試效果,以驗證該結構對模型的有效程度。

變種1ISS-NR(w/o Subgraph)。使用常規的子圖替換原模型的問答子圖模塊。ISS-NR 使用的是問題主實體和答案實體之間的路徑集合作為子圖,同時將其余不構成路徑的無關節點進行剪枝剔除,減少了無關信息的干擾。為了驗證路徑作為子圖的有效性,將該模塊修改為常規的子圖抽取模式,即選取主實體和答案實體周圍k跳范圍內的節點集合作為子圖。實驗結果如表5 所示,ISS-NR(w/o Subgraph)在測試集上的效果明顯弱于ISS-NR,說明多余的嘈雜信息對模型的影響較大,驗證了子圖抽取模式的作用。

變種2ISS-NR(w/o GCN)。使用常規的子圖替換原模型的問答子圖模塊。在圖嵌入模塊,ISS-NR使用了R-GCN 對各個節點進行迭代更新,更新后的節點表示能夠具有鄰居節點的信息,為之后的推理提供信息基礎。通過將R-GCN 的層數減少為一層,減弱模型獲取鄰居信息的能力,以驗證該模塊的效果。實驗結果如表5 所示,ISS-NR(w/o GCN)在測試集上的效果略弱于ISS-NR。

變種3ISS-NR(w/o ComplEx)。在表示向量融合模塊中,ISS-NR 將ComplEx 模型訓練好的向量融合到了相應節點的表示上。為了驗證融合表示模型的效果,直接去除ComplEx 模塊進行測試。實驗結果如表5 所示,ISS-NR 的效果要顯著優于剔除融合模塊的ISS-NR(w/o ComplEx),突出了融合的有效性。

Table 5 Results of ablation experiments表5 消融實驗結果

4 總結

本文提出了一種融合子圖結構的神經推理式知識庫問答方法ISS-NR,實現了在問答推理過程中兼顧實體的語義與結構信息,以增強問答效果。實驗結果表明,ISS-NR 在WebQuestionsSP 數據集上表現出較好的結果,同時有效避免了實體冷啟動問題。最后,通過消融實驗,驗證了模型各模塊的有效性。

ISS-NR 運用的結構信息來源于問答子圖的抽取,但是抽取子圖時需要多次使用最短路徑算法,在實體鏈接稠密的知識庫中耗時較長,影響了模型的訓練和預測性能。下一步,計劃對本文方法以及模型進行改進,優化問答子圖的抽取過程,尋求模型的性能提升。同時,本文驗證了模型在未見過的知識庫實體上進行推理問答的能力,但是對于在知識庫中未見過的關系進行訓練則無法發揮作用,如何在新的關系上進行推理問答也是下一步的研究方向之一。