改進(jìn)YOLOv3的快速遙感機(jī)場區(qū)域目標(biāo)檢測

韓永賽,馬時(shí)平,何林遠(yuǎn),李承昊,朱明明,張 飛

(1.空軍工程大學(xué) 航空工程學(xué)院,陜西 西安 710038;2.空軍工程大學(xué) 研究生院,陜西 西安 710038)

目標(biāo)檢測目前為計(jì)算機(jī)視覺和數(shù)字圖像處理的一個(gè)熱門方向。它被用于機(jī)器自主識(shí)別所需要被檢測的目標(biāo),對(duì)減少人力資源的消耗有著重要意義[1]。而隨著衛(wèi)星遙感圖像的分辨率越來越高,其蘊(yùn)含的信息量也越來越大,促進(jìn)了遙感檢測的大跨步發(fā)展。同時(shí)機(jī)場因?yàn)槠滠娪煤兔裼玫奶厥庖饬x,成為了目標(biāo)檢測領(lǐng)域研究的“寵兒”。如何從大數(shù)據(jù)量、高分辨率的遙感圖像中快速、精確地檢測出機(jī)場以及機(jī)場內(nèi)典型目標(biāo),具有很大的現(xiàn)實(shí)意義。

許多人員對(duì)這一問題進(jìn)行了深入的研究,并做出了具有一定價(jià)值的貢獻(xiàn)。基于傳統(tǒng)的方法有:文獻(xiàn)[2]等提出了線段檢測器與支持向量機(jī)相結(jié)合的方法,先對(duì)圖像進(jìn)行邊緣檢測,然后用線段檢測器提取直線,利用機(jī)場的細(xì)長直線特征來檢測機(jī)場。文獻(xiàn)[3]等提出了Hough變換與支持向量機(jī)相結(jié)合的方法,在對(duì)圖像進(jìn)行邊緣檢測后,進(jìn)行Hough變換來提取直線,同樣利用機(jī)場的細(xì)長直線特征來進(jìn)行機(jī)場的分類。它們的檢測速度快、算法復(fù)雜度低,但是卻極易受到周圍形似物的干擾,如同樣具有細(xì)長直線特征的長公路以及海岸線等,因此檢測率偏低。文獻(xiàn)[4]等結(jié)合視覺顯著性和特征對(duì)稱性的方法對(duì)飛機(jī)類目標(biāo)進(jìn)行分類和定位。文獻(xiàn)[5]等基于稀疏編碼和約束池化相結(jié)合的方法進(jìn)行飛機(jī)類目標(biāo)特征的表達(dá),進(jìn)而進(jìn)行后續(xù)的分類和定位任務(wù)。此類方法的檢測精度較高,但是較為依賴人工特征的設(shè)計(jì),特征的魯棒性不高,模型的泛化能力偏弱。隨著深度學(xué)習(xí)的發(fā)展,基于卷積神經(jīng)網(wǎng)絡(luò)的目標(biāo)檢測逐漸成為該領(lǐng)域的“標(biāo)配”[6]。文獻(xiàn)[7]等基于機(jī)場線性分布的先驗(yàn)知識(shí)來進(jìn)行更為合理的區(qū)域建議,并結(jié)合遷移學(xué)習(xí)的思想進(jìn)行有限樣本下的卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練來提取深層特征進(jìn)行機(jī)場檢測。文獻(xiàn)[8]從幾何與局部顯著性相結(jié)合的顯著圖上建議感興趣區(qū)域,并利用殘差網(wǎng)絡(luò)確定感興趣區(qū)域進(jìn)行機(jī)場分類檢測等。上述方法都發(fā)揮了卷積神經(jīng)網(wǎng)絡(luò)強(qiáng)大的特征提取能力,但普遍采用遍歷滑動(dòng)窗口法來進(jìn)行檢測有很大的時(shí)間復(fù)雜度,達(dá)不到快速檢測的標(biāo)準(zhǔn)。針對(duì)此類問題,以更快的區(qū)域卷積神經(jīng)網(wǎng)絡(luò)(Faster Region Convotutional Neural Network,F(xiàn)aster R-CNN)[9]系列為代表的“兩步法”和以YOLO[10]系列為代表的“一步法”檢測網(wǎng)絡(luò)逐漸成為目標(biāo)檢測領(lǐng)域的主流網(wǎng)絡(luò),并對(duì)各式檢測任務(wù)做出了巨大的貢獻(xiàn),取得了很好的檢測效果。在這兩類代表網(wǎng)絡(luò)的基礎(chǔ)上,文獻(xiàn)[11]使用遷移學(xué)習(xí)結(jié)合難分樣本挖掘的方法針對(duì)機(jī)場的檢測進(jìn)行了改進(jìn)。文獻(xiàn)[12]結(jié)合卷積神經(jīng)網(wǎng)絡(luò)與顯著性特性對(duì)機(jī)場目標(biāo)的檢測進(jìn)行了改進(jìn)。文獻(xiàn)[13]在檢測網(wǎng)絡(luò)基礎(chǔ)上提出了視覺顯著性指導(dǎo)的紅外與可見光圖像的融合算法。上述方法通過在網(wǎng)絡(luò)上進(jìn)行改進(jìn),更好地發(fā)揮了網(wǎng)絡(luò)的性能,獲得了較高的目標(biāo)檢測率。但眾多實(shí)驗(yàn)多是對(duì)單類目標(biāo)的檢測,同時(shí)在檢測率與檢測時(shí)間的權(quán)衡方面還有待提高。

該文由大范圍遙感機(jī)場區(qū)域目標(biāo)快速精確檢測任務(wù)出發(fā),以一種快速和準(zhǔn)確的實(shí)時(shí)對(duì)象檢測算法,(You Only Look Once,YOLOv3)[14]網(wǎng)絡(luò)為基礎(chǔ)檢測網(wǎng)絡(luò),自主構(gòu)建了復(fù)雜背景、小目標(biāo)、多目標(biāo)、不同視角下的含有機(jī)場區(qū)域六類典型目標(biāo)的遙感圖像數(shù)據(jù)集,并針對(duì)具體任務(wù)做出了部分改進(jìn)。主要?jiǎng)?chuàng)新點(diǎn)如下:

(1)由遙感機(jī)場區(qū)域目標(biāo)檢測任務(wù)出發(fā),構(gòu)建了一個(gè)更加符合任務(wù)的,包含六類典型目標(biāo)(機(jī)場、民航飛機(jī)、戰(zhàn)斗機(jī)、直升機(jī)、運(yùn)輸機(jī)、油罐)的較為完備的遙感數(shù)據(jù)集,為模型在訓(xùn)練過程中得到更多的深層次區(qū)分性特征,從而獲得更好的預(yù)測能力奠定了基礎(chǔ)。

(2)相比傳統(tǒng)的硬采樣均衡樣本分布問題以及數(shù)據(jù)增強(qiáng)方法,應(yīng)用生成對(duì)抗網(wǎng)絡(luò)實(shí)現(xiàn)數(shù)據(jù)增強(qiáng),來補(bǔ)充用于訓(xùn)練的數(shù)據(jù)集,從數(shù)據(jù)集本身進(jìn)行樣本分布均衡,并降低采集樣本的開發(fā)成本。

(3)采用改進(jìn)的特征融合部件DWFPN來進(jìn)行更加魯棒的特征融合以及更加精確的末端檢測。

1 基于YOLOv3的機(jī)場區(qū)域目標(biāo)檢測原理與改進(jìn)

1.1 遙感機(jī)場區(qū)域目標(biāo)檢測原理

針對(duì)遙感機(jī)場區(qū)域目標(biāo)檢測任務(wù),文獻(xiàn)[15]從Google Earth上截取的相關(guān)遙感監(jiān)測圖相比不同的遙感監(jiān)測器已有較好的分辨率特性以及泛化性能,因此在遙感機(jī)場區(qū)域目標(biāo)檢測任務(wù)中,以從Google Earth上針對(duì)不同機(jī)場區(qū)域、不用拍攝高度、不同拍攝視角得到的包含所需檢測目標(biāo)的遙感圖片作為輸入,將改進(jìn)的YOLOv3網(wǎng)絡(luò)作為檢測器,通過訓(xùn)練得到相關(guān)知識(shí)模型,并輸出帶有精確位置信息以及類別示意的檢測圖。其原理示意如圖1所示。

圖1 遙感機(jī)場區(qū)域目標(biāo)檢測原理示意圖

1.2 數(shù)據(jù)集的構(gòu)建

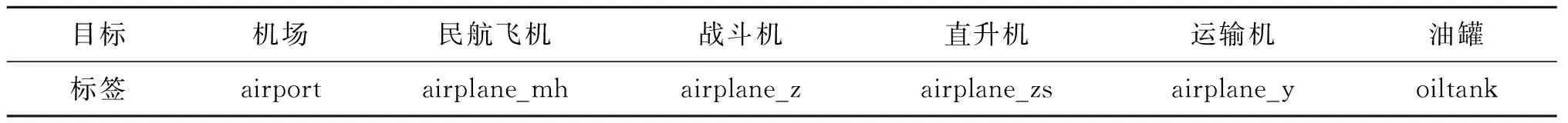

目前公開的用于遙感機(jī)場區(qū)域目標(biāo)檢測任務(wù)的數(shù)據(jù)集較少或較小,尚不足以訓(xùn)練一個(gè)泛化性很強(qiáng)的特定任務(wù)網(wǎng)絡(luò),因此需要人為構(gòu)建一個(gè)用于訓(xùn)練的較為完備的數(shù)據(jù)集。為了方便網(wǎng)絡(luò)的訓(xùn)練,以VOC2007[16]數(shù)據(jù)集格式進(jìn)行數(shù)據(jù)集的構(gòu)建工作,通過應(yīng)用Google Earth Pro軟件從不同衛(wèi)星拍攝高度、不同視角分別對(duì)近200個(gè)機(jī)場區(qū)域進(jìn)行了圖像采集,每個(gè)機(jī)場區(qū)域根據(jù)其實(shí)際包含的目標(biāo)分布,分別采集了10~50張不等的圖像。最終形成的原始數(shù)據(jù)集包含6 681張含有各類目標(biāo)的有效圖片,其中含有各類目標(biāo)的圖片數(shù)量如表1所示。目標(biāo)與標(biāo)簽對(duì)應(yīng)關(guān)系如表2所示。數(shù)據(jù)集示意如圖2所示。

表1 原始數(shù)據(jù)集各類目標(biāo)對(duì)應(yīng)圖片數(shù)量匯總表

表2 目標(biāo)—標(biāo)簽對(duì)應(yīng)表

圖2 數(shù)據(jù)集示意圖

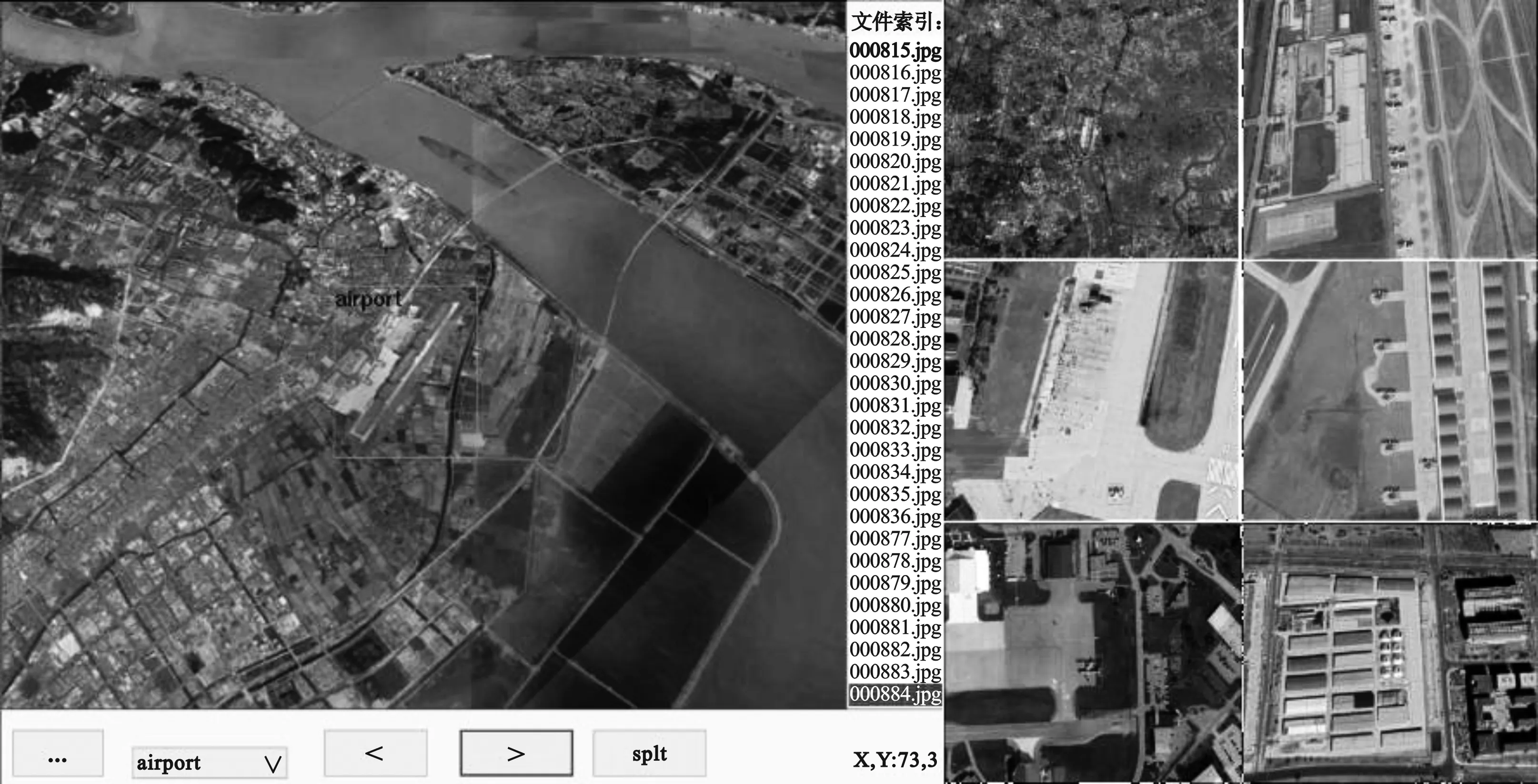

標(biāo)簽示例如圖3所示。

圖3 標(biāo)簽示意圖

1.3 YOLOv3網(wǎng)絡(luò)以及改進(jìn)

1.3.1 YOLOv3網(wǎng)絡(luò)

YOLOv3是“一步法”的代表作。它可以依托眾多主流框架,其中該文使用的為darknet框架,本框架沒有任何依賴項(xiàng),易于安裝與移植,結(jié)構(gòu)清晰簡明,并提供python接口,可在python環(huán)境下運(yùn)行YOLOv3模型,并且易于更改模型參數(shù)以及結(jié)構(gòu)。其算法框架如圖4所示,其中Concatenate代表特征圖拼接操作。

圖4 YOLOv3算法框架圖

圖4中各層對(duì)應(yīng)的參數(shù)如表3所示。

表3 層級(jí)參數(shù)對(duì)照表

YOLOv3采用“全局檢測”策略進(jìn)行目標(biāo)檢測,而不再是由眾多分組步驟組成的檢測系統(tǒng),它可以直接學(xué)習(xí)到圖像的全局信息并做回歸預(yù)測,因此它的檢測速度非常快。它通過將整幅圖片分成S×S個(gè)預(yù)測網(wǎng)格,然后對(duì)每個(gè)預(yù)測網(wǎng)格都預(yù)測B個(gè)預(yù)測框,并預(yù)測每個(gè)預(yù)測框的N個(gè)類別的概率,然后計(jì)算出每個(gè)網(wǎng)格中預(yù)測框的置信度得分,采用非極大值抑制算法選出置信度得分最高的預(yù)測框來實(shí)現(xiàn)目標(biāo)的粗定位與分類,再利用損失函數(shù)訓(xùn)練對(duì)各類誤差進(jìn)行極小值尋優(yōu),最終完成對(duì)目標(biāo)的精確定位與分類。通常各式檢測算法只是選取最后一層卷積特征圖來進(jìn)行預(yù)測。顯而易見,最后一層卷積特征圖尺度通常會(huì)很小,對(duì)小目標(biāo)的表征能力很弱,算法很難從其中學(xué)到區(qū)分性的特征,因此這樣會(huì)使得算法對(duì)小目標(biāo)不敏感,對(duì)小目標(biāo)的檢測能力偏弱。針對(duì)這個(gè)問題,YOLOv3的多尺度預(yù)測(如圖4所示)顯得尤能可貴,其主要在13×13、26×26和 52×52三種特征圖尺度上進(jìn)行預(yù)測,進(jìn)而很好地解決了一步檢測網(wǎng)絡(luò)顆粒度粗、對(duì)小目標(biāo)檢測能力差的問題。其訓(xùn)練損失函數(shù)可表示為

Ltotal=lxy+lwh+lconf+lclass,

(1)

(2)

(3)

(4)

(5)

其中,

M(a,b,c,d)=(a-c)2+(b-d)2,

(6)

B(a,b)=alog(b)+(1-a)log(1-b) ,

(7)

1.3.2 網(wǎng)絡(luò)的改進(jìn)

針對(duì)數(shù)據(jù)側(cè),該文通過生成的方法來對(duì)傳統(tǒng)的硬采樣改善類別不平衡問題的思路進(jìn)行改進(jìn),使用生成對(duì)抗網(wǎng)絡(luò)來進(jìn)行數(shù)據(jù)集中少類目標(biāo)的擴(kuò)充來優(yōu)化類間數(shù)據(jù)分布不平衡問題。

傳統(tǒng)的硬采樣思路通過設(shè)置正負(fù)樣本的比例來主要改善前景和后景的數(shù)量不平衡問題。此方法一般不對(duì)前景進(jìn)行采樣操作,而對(duì)后景進(jìn)行隨機(jī)或條件隨機(jī)(如重新制定負(fù)樣本閾值)欠采樣,可以在一定程度上緩解前景與后景間的類別不平衡問題。

其中生成對(duì)抗網(wǎng)絡(luò)[17]是一種二人零和博弈模型,其思想如下:通過構(gòu)建一個(gè)深度神經(jīng)網(wǎng)絡(luò)組成的生成器以及判別器的對(duì)抗系統(tǒng),使得生成器可以生成越來越真的目標(biāo)樣本。文中使用的生成對(duì)抗網(wǎng)絡(luò)框架示意如圖5所示。

圖5 該文使用的生成對(duì)抗網(wǎng)絡(luò)框架示意圖

其判別器以及生成器的訓(xùn)練目標(biāo)函數(shù)如下:

(8)

(9)

αy=Ey=tr[logD(y)] ,

(10)

βy=Ey=G(x)[log(1-D(y))] ,

(11)

其中,αy為當(dāng)輸入為真實(shí)圖像時(shí),判別器的輸出期望值;βy為當(dāng)輸入為生成圖像時(shí),判別器的輸出期望值。

從式(8)可以看出,判別器的優(yōu)化目標(biāo)為提高鑒別能力;從式(9)可以看出,生成器的優(yōu)化目標(biāo)為使得判別器的鑒別能力盡可能低。兩者相互對(duì)抗,當(dāng)達(dá)到納什均衡時(shí)達(dá)到最終的優(yōu)化目標(biāo)。

文中生成對(duì)抗網(wǎng)絡(luò)的訓(xùn)練步驟如下:

(1)在進(jìn)行訓(xùn)練時(shí),參照目標(biāo)檢測網(wǎng)絡(luò)的預(yù)訓(xùn)練模式,沿用模型遷移學(xué)習(xí)[18]的方法,使用已在ImageNet訓(xùn)練過的網(wǎng)絡(luò)參數(shù)初始化生成對(duì)抗網(wǎng)絡(luò)的訓(xùn)練權(quán)重,以達(dá)到更快更好的收斂效果。

(2)在進(jìn)行每一輪判別器判別訓(xùn)練前,先對(duì)生成樣本以及真實(shí)樣本進(jìn)行批歸一化至[-1,1],以消除奇異樣本帶來的不良影響,同時(shí)保持生成樣本和真實(shí)樣本數(shù)據(jù)在同一量綱。

(3)訓(xùn)練中判別器判別的噪聲作為“知識(shí)”進(jìn)入生成器繼續(xù)訓(xùn)練。

(4)各類目標(biāo)圖片的生成權(quán)重比為:機(jī)場∶民航飛機(jī)∶戰(zhàn)斗機(jī)∶直升機(jī)∶運(yùn)輸機(jī)∶油罐=0.45∶0.05∶0.24∶0.08∶0.15∶0.03。

應(yīng)用生成對(duì)抗網(wǎng)絡(luò)進(jìn)行數(shù)據(jù)增強(qiáng)的優(yōu)點(diǎn)如下:

(1)通過生成對(duì)抗網(wǎng)絡(luò)強(qiáng)大的學(xué)習(xí)推理能力,可以重新生成新的前景樣本,在改善前景與后景類別不平衡的同時(shí),可以通過設(shè)置合理的生成圖片數(shù)量權(quán)重來改善前景不同目標(biāo)間的類別不平衡問題。

(2)生成對(duì)抗網(wǎng)絡(luò)在生成新樣本時(shí),可以引入完全不同的樣本背景,使得生成的樣本更具多樣性,有助于網(wǎng)絡(luò)后續(xù)提取更具區(qū)分力以及領(lǐng)域不變性的特征,提高檢測任務(wù)的穩(wěn)定性。

(3)生成的方法將大大減少收集數(shù)據(jù)等構(gòu)建數(shù)據(jù)集時(shí)人力資源的消耗,極大提高訓(xùn)練準(zhǔn)備工作的效率。

構(gòu)建新型特征融合檢測網(wǎng)絡(luò)DWFPN以進(jìn)行更加魯棒的特征融合,使得網(wǎng)絡(luò)提取到深層次區(qū)分性特征,進(jìn)一步提高網(wǎng)絡(luò)的分類以及定位能力。

YOLOv3網(wǎng)絡(luò)的末端檢測部分如圖4所示,因?yàn)闅埐顗K1和2的特征尺寸較大,所包含的語義信息不足,所以網(wǎng)絡(luò)應(yīng)用殘差塊3、4、5進(jìn)行特征融合,并用于后續(xù)檢測。這樣可以使得在進(jìn)行檢測時(shí)用到網(wǎng)絡(luò)各層級(jí)提取的融合特征,尤其對(duì)于小目標(biāo)檢測的提升效果最好,因?yàn)槠鋺?yīng)用了3個(gè)殘差塊卷積得到的融合特征進(jìn)行檢測,在保留較強(qiáng)的分辨率信息的同時(shí),融合了最高層很強(qiáng)的語義信息。然而由圖4也可以看出,進(jìn)行中目標(biāo)檢測時(shí)其未很好地融合殘差塊3的特征信息,同時(shí)進(jìn)行大目標(biāo)檢測時(shí)未進(jìn)行特征融合,同時(shí)進(jìn)行融合的部分權(quán)重設(shè)置也是相同的,未進(jìn)行較為細(xì)致的融合權(quán)重設(shè)置。基于此,文中提出如圖6所示DWFPN改進(jìn)融合方式,以更好地進(jìn)行殘差塊提取特征之間的融合。圖6中Sofcmax為分類函數(shù),Conv代表進(jìn)行卷積操作,Concat代表進(jìn)行特征圖拼接操作,maxpooling、Stride表示最大值池化的步長。

圖6 DWFPN結(jié)構(gòu)示意圖

則融合特征公式如下:

(12)

(13)

(14)

(15)

2 實(shí)驗(yàn)以及結(jié)果分析

2.1 實(shí)驗(yàn)環(huán)境以及參數(shù)設(shè)置

(1)實(shí)驗(yàn)環(huán)境:服務(wù)器系統(tǒng)ubuntu 14.06,GPU GTX 1060Ti,RAM 16 GB。

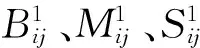

(2)參數(shù)設(shè)置見表4。

表4 參數(shù)設(shè)置表

用K均值聚類算法對(duì)構(gòu)建的數(shù)據(jù)集內(nèi)數(shù)據(jù)進(jìn)行錨框的聚類初始化結(jié)果如下:

(13,15);(23,14);(13,32);(34,36);(68,33);(56,120);(180,92);(210,304);(342,380)。

2.2 針對(duì)改進(jìn)部分的結(jié)果分析

在相同的實(shí)驗(yàn)環(huán)境以及參數(shù)設(shè)置下,進(jìn)行改進(jìn)前后的對(duì)比實(shí)驗(yàn)(其中YOLOv3的基礎(chǔ)網(wǎng)絡(luò)選用相比原網(wǎng)絡(luò)中Darknet-53對(duì)特征表達(dá)能力更強(qiáng)的密集連接結(jié)構(gòu)DenseNet[19],且沿用模型遷移學(xué)習(xí)的方法,用imagenet_models對(duì)網(wǎng)絡(luò)進(jìn)行預(yù)訓(xùn)練)。實(shí)驗(yàn)結(jié)果如表5~7所示,其中T1代表已使用生成對(duì)抗網(wǎng)絡(luò),T2代表已使用DWFPN。

表5 改進(jìn)前后檢測性能(AP)對(duì)比匯總表

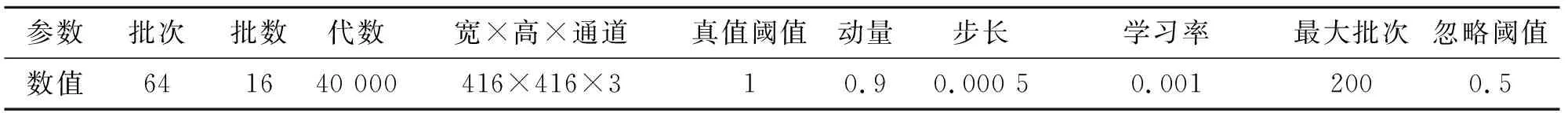

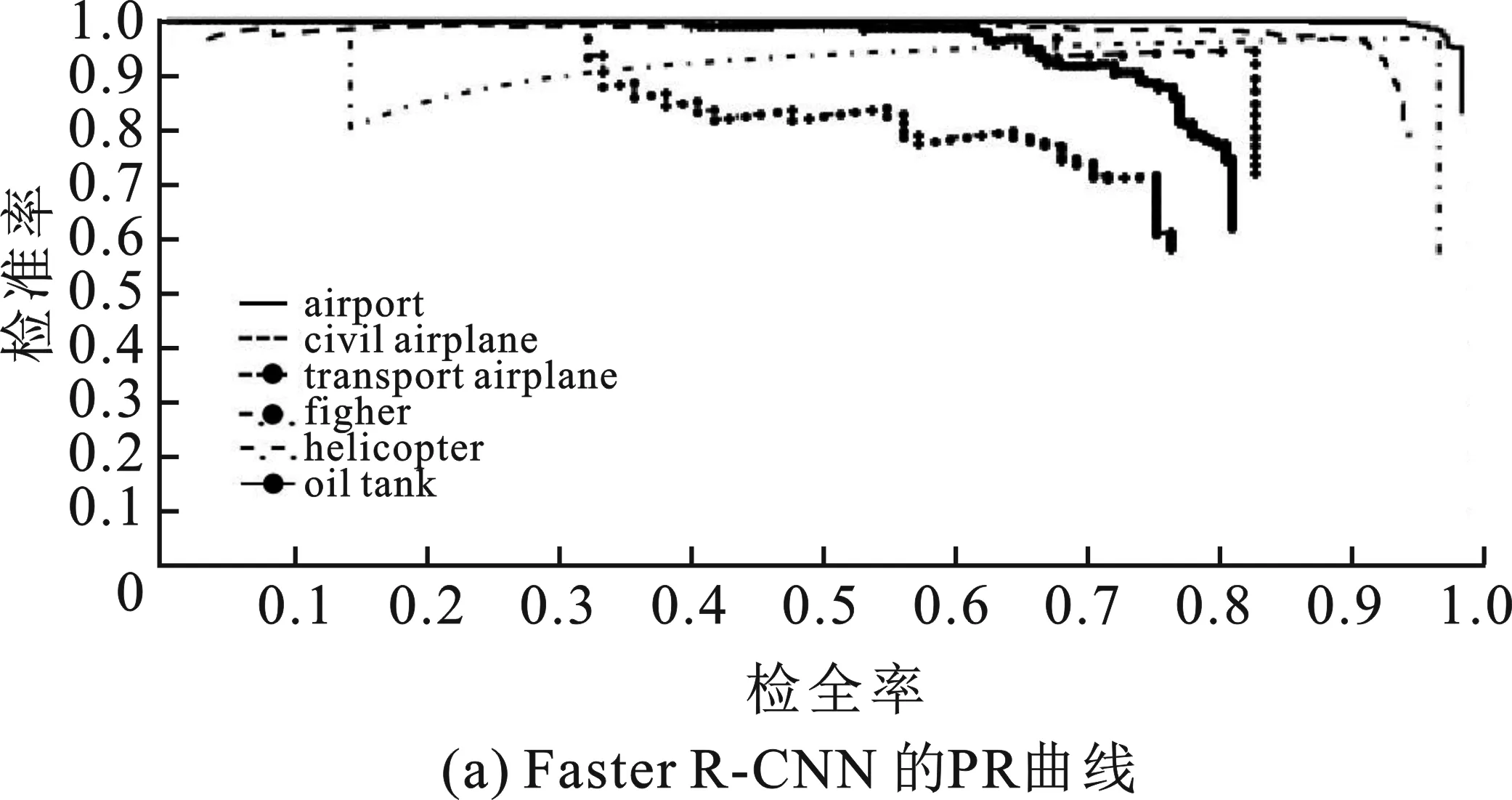

可視化Precision-Recall曲線如圖7所示。

圖7 PR曲線示意圖

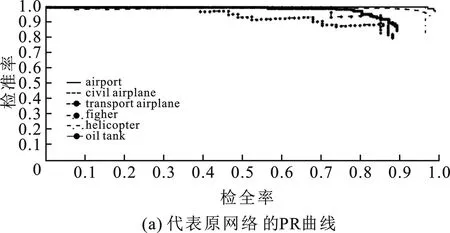

表5實(shí)驗(yàn)結(jié)果顯示,改進(jìn)網(wǎng)絡(luò)相比原網(wǎng)絡(luò)增加了4.98%的多類目標(biāo)平均檢測精度以及8.33%的平均交并比,證明了改進(jìn)網(wǎng)絡(luò)取得了更好的分類以及定位效果。同時(shí)根據(jù)檢測PR曲線可以得到,改進(jìn)網(wǎng)絡(luò)的曲線更加貼近上坐標(biāo)軸,各目標(biāo)的PR曲線與Precision和Recall坐標(biāo)軸正向所包圍的面積更大,表明改進(jìn)網(wǎng)絡(luò)在平衡檢測精確率以及檢全率方面有了更好的性能。同時(shí)構(gòu)建的原始數(shù)據(jù)集中搜集到的戰(zhàn)斗機(jī)、直升機(jī)以及運(yùn)輸機(jī)的圖片較少,且每張相關(guān)圖片所包含的目標(biāo)數(shù)較少,通常為1~8個(gè)有效目標(biāo)。因此,在通過生成對(duì)抗網(wǎng)絡(luò)進(jìn)行重點(diǎn)數(shù)據(jù)增強(qiáng)擴(kuò)充操作后,結(jié)合DWFPN末端檢測網(wǎng)絡(luò)使得平均檢測精度值有了較大的提升,增量分別達(dá)到了9.31%、8.97%、6.51%。通過實(shí)驗(yàn)證明了改進(jìn)網(wǎng)絡(luò)的有效性。同時(shí),通過表6、表7可以得到,改進(jìn)網(wǎng)絡(luò)相比原網(wǎng)絡(luò)平均降低了4.99%的漏警概率以及4.97%的虛警概率,分別達(dá)到了5.94%的平均漏警概率以及11.95%的平均虛警概率,由此證明了改進(jìn)網(wǎng)絡(luò)針對(duì)各個(gè)待檢測的目標(biāo)的漏警以及虛警問題都得到了一定的改善,并取得了較低的漏警和虛警概率。證明了改進(jìn)網(wǎng)絡(luò)針對(duì)機(jī)場區(qū)域目標(biāo)檢測任務(wù)中性能的整體提高。

表6 改進(jìn)前后漏警概率(MA)對(duì)比匯總表

表7 改進(jìn)前后虛警概率(FA)對(duì)比匯總表

2.3 可視化檢測結(jié)果示意

圖8給出了可視化檢測的結(jié)果。其中圖(K-1)表示YOLOv3網(wǎng)絡(luò)的檢測結(jié)果,圖(K-2)以及圖(9)、(10)、(11)表示改進(jìn)網(wǎng)絡(luò)在相同實(shí)驗(yàn)環(huán)境下的檢測結(jié)果,K=1,2,…,8。從檢測圖例可以直觀地看出,改進(jìn)網(wǎng)絡(luò)對(duì)6類機(jī)場區(qū)域典型目標(biāo)都有較好的檢測效果,主要表現(xiàn)在分類準(zhǔn)確度高以及定位框與真實(shí)目標(biāo)的貼合度高。通過對(duì)比圖(1-1)、(1-2),(2-1)、(2-2),(4-1)、(4-2)和圖(7-1)、(7-2)可以得出,改進(jìn)網(wǎng)絡(luò)對(duì)小目標(biāo)的檢測有更好的檢全率以及更低的誤檢率,主要表現(xiàn)在改進(jìn)網(wǎng)絡(luò)對(duì)原網(wǎng)絡(luò)將圖(1-1)左下角類似形狀物檢測為民航飛機(jī)進(jìn)行了修正,以及對(duì)圖(2-1)左側(cè)、圖(4-1)左側(cè)和右側(cè)以及圖(7-1)漏檢的目標(biāo)進(jìn)行了檢全,這主要得益于DWFPN檢測器的自下而上融合特征時(shí)的權(quán)重矩陣組的設(shè)置,使得圖像特征尤其是邊緣特征在進(jìn)行方向傳播時(shí),可以進(jìn)行對(duì)應(yīng)權(quán)重加強(qiáng)(相對(duì)正樣本)或減弱(相對(duì)負(fù)樣本),加強(qiáng)了融合的效果使特征更加魯棒。對(duì)比圖(3-1)、(3-2),(5-1)、(5-2)和(6-1)、(6-2)可以得出,改進(jìn)網(wǎng)絡(luò)對(duì)大、中目標(biāo)進(jìn)行了更加精確的定位,表現(xiàn)在最終的定位框與真實(shí)目標(biāo)的邊界貼合度的提高,主要得益于DWFPN檢測器自下而上進(jìn)行更好的特征融合以及后續(xù)自上而下進(jìn)行特征融合時(shí)引入了更好的分辨率特征信息。對(duì)比圖(8-1)和(8-2)可以得出,改進(jìn)網(wǎng)絡(luò)相比原網(wǎng)絡(luò)有更好的泛化性能,可以在一定程度上檢測特殊背景、特殊形狀的機(jī)場,這主要得益于生成對(duì)抗網(wǎng)絡(luò)對(duì)樣本的生成擴(kuò)充以及DWFPN較強(qiáng)的融合深層次可區(qū)分性特征的能力。

圖8 可視化結(jié)果示意圖

2.4 對(duì)比實(shí)驗(yàn)

使用高度一致的實(shí)驗(yàn)環(huán)境以及共享參數(shù)用該文數(shù)據(jù)集對(duì)目前主流的目標(biāo)檢測算法進(jìn)行對(duì)比實(shí)驗(yàn),實(shí)驗(yàn)結(jié)果如表8所示。

表8 不同目標(biāo)檢測網(wǎng)絡(luò)對(duì)比實(shí)驗(yàn)結(jié)果匯總表

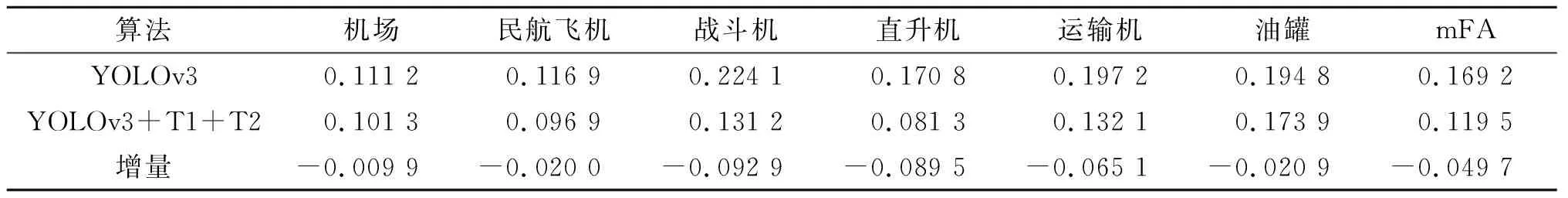

對(duì)比網(wǎng)絡(luò)的可視化Precision-Recall曲線如圖9所示。通過對(duì)比實(shí)驗(yàn)表明,改進(jìn)網(wǎng)絡(luò)在檢測精確率方面相比目前幾大主流網(wǎng)絡(luò)取得了較大的提升,基本達(dá)到了與RetinaNet-101[20]持平的多類目標(biāo)檢測精確率,相比Faster R-CNN、R-FCN[21]、DSSD[22]分別提高了11.73%、6.05%、7.82%。相比YOLOv3原網(wǎng)絡(luò),改進(jìn)網(wǎng)絡(luò)提高了4.98%的多類目標(biāo)平均檢測精確率。同時(shí),由于原YOLOv3網(wǎng)絡(luò)出色的一步回歸全局檢測設(shè)計(jì),使得改進(jìn)網(wǎng)絡(luò)在平均檢測時(shí)間方面也保留了較為突出的性能,達(dá)到了0.062 5 s的平均檢測時(shí)間。相比原網(wǎng)絡(luò)增加了0.004 3 s的時(shí)間成本,主要為在網(wǎng)絡(luò)的改進(jìn)中增加了自下而上融合過程中的權(quán)重矩陣組以及自上而下融合的過程,所以相比原網(wǎng)絡(luò)增加了少許檢測時(shí)間,但依舊保持了較高的檢測速度。其檢測速度相比Faster R-CNN、R-FCN、DSSD平均提速約1.9倍,比RetinaNet-101提速約5.3倍。

圖9 PR曲線示意圖

3 結(jié)束語

在快速遙感機(jī)場區(qū)域目標(biāo)精確檢測任務(wù)中,通過使用生成對(duì)抗網(wǎng)絡(luò)對(duì)原始數(shù)據(jù)集進(jìn)行針對(duì)性擴(kuò)充以及在YOLOv3快速檢測神經(jīng)網(wǎng)絡(luò)中加入改進(jìn)的DWFPN特征融合檢測部件,改進(jìn)網(wǎng)絡(luò)實(shí)現(xiàn)了數(shù)據(jù)集中類別目標(biāo)數(shù)據(jù)之間較為均衡的分布以及深層次可區(qū)分的更加魯棒特征的融合提取,在僅增加少許檢測時(shí)間的基礎(chǔ)上為模型帶來了4.98%的多類目標(biāo)平均檢測精確率以及8.33%的平均交并比的提升,達(dá)到了89.07%的多類目標(biāo)平均檢測精確率以及61.97%的平均交并比,且平均檢測時(shí)間為0.062 5 s,相比部分目前主流檢測網(wǎng)絡(luò)取得了較好的檢測效果,表明了改進(jìn)網(wǎng)絡(luò)針對(duì)快速遙感機(jī)場區(qū)域目標(biāo)精確檢測任務(wù)有較大的實(shí)際意義。在下一步的工作中,將著眼于多模態(tài)的特征融合以及進(jìn)一步提高網(wǎng)絡(luò)的檢測性能研究。