面向輕量化網絡的改進雙通道注意力機制圖像分類方法

宋泰年 秦偉偉 梁卓 王魁 劉剛

摘 要:為解決彈載終端環境下深度卷積神經網絡模型體積較大、 運算硬件要求高的問題, 構建了一種基于改進雙通道注意力機制的輕量化網絡結構。 針對網絡輕量化會犧牲分類準確率的問題, 以輕量化網絡結構MobileNetV2為基準網絡架構, 引入自主設計的注意力模塊, 設計了基于SPP-DCAM模塊的MobileNetV2網絡架構, 使卷積層學習的顯著特征圖的權重增加, 以提升其分類準確率; 設計的空間信息與通道信息并聯輸入, 通過定義1×1和3×3的小卷積在保證結構輕量化的基礎上減少了計算量和計算復雜度。 最后, 在cifar-100圖像分類數據集進行實驗對比。 結果表明: 相對于改進MobileNetV2, 在參數量和計算復雜度基本不變的基礎上, 分類精度優于傳統的VGG16, ResNet18和DenseNet卷積網絡, 綜合性能更強, 更適合彈載計算資源有限情況下的快速分類。

關鍵詞: MobileNetV2; 注意力機制; 圖像分類; 卷積神經網絡;? 輕量化網絡; 人工智能

中圖分類號: TJ760; TP183? 文獻標識碼:??? A? 文章編號: 1673-5048(2021)05-0081-05

0 引? 言

近年來, 卷積神經網絡發展迅猛, 取得了豐碩的成果。 在軍事應用方面, 卷積神經網絡被用來識別并檢測軍事目標, 但是在彈載終端環境中, 對于網絡以及硬件的要求較高, 需要網絡在保證識別準確率的基礎上保持輕量化且嵌入性能好。 隨著AlexNet[1]在ImageNet大型數據集上的分類準確率實現質的飛越后, 卷積神經網絡朝著復雜化趨勢發展, 卷積層數也越來越多。 代表性網絡有2014年提出的VGG[2]和GoogLeNet[3], 兩者分別增加卷積神經網絡的深度和寬度以提升網絡性能。 2015年, 何愷明團隊創新性地提出ResNet網絡[4], 首次引入殘差的概念, 利用殘差來傳遞信息, 有效緩解了網絡因深度增加而導致的過擬合以及梯度消失問題, 這一網絡也為后續輕量化的發展提供了思路。 隨后, 研究人員將注意力機制引入卷積神經網絡中, 2017年的SENet[5]借鑒注意力機制的思想, 賦予不同特征圖以不同的權重, 提升了網絡的學習能力。 后來提出的注意力模塊都借鑒了這一思想并在SENet的基礎上加以改進研究。 如CBAM模塊[6]在通道注意力的基礎上又對空間注意力加以研究, 使得網絡設計趨向于簡單、 快捷、 可移植。 輕量化研究方面的典型網絡MobileNetV2[7]在逐點卷積和深度卷積的基礎上, 引入倒殘差結構和線性瓶頸結構, 使得網絡結構大幅減小, 速度也進一步提升。 李慧慧等人將MobileNetV2網絡模型與傳統的Hough變換相結合, 在識別任務中表現較優, 能夠在擁有較低參數量和計算量的情況下提高準確率[8]。 楊國亮等人在MobileNetV2網絡的基礎上, 借鑒DenseNet密集連接的思想, 利用特征復用的特點, 在提高網絡性能的同時縮減網絡規模[9]。 畢鵬程等人在MobileNetV2瓶頸層的基礎上改進步長模塊, 使得網絡準確率提升的情況下復雜度和計算量進一步減小[10]。 任坤等人選擇MobileNetV2網絡作為目標檢測的骨干網絡, 并引入通道注意力機制, 實現特征增強, 在保證算法輕量化的同時有效提升網絡的檢測性能[11]。

本文以MobileNetV2輕量化網絡為基礎,? 設計了一種通道空間雙協同注意力模塊, 通過賦予提取的特征以更大的權重, 在保證網絡輕量化的基礎上增加其識別準確率。 在cifar-100標準數據集上, 通過對比不同典型卷積神經網絡和不同注意力模塊來驗證網絡的有效性。

1 MobileNetV2網絡及注意力機制介紹

1.1 MobileNetV2網絡

隨著卷積神經網絡的飛速發展, 其結構越來越復雜, 體積越來越大, 計算量也日益變大, 對硬件資源的需求逐漸變多。 在資源受限的平臺上無法部署訓練, 所以研究方向為輕量化、 高速化[12]。 一種方法是將訓練好的網絡進行壓縮, 得到相對小的模型; 另一種方法是設計小型模型進行訓練, 而MobileNetV2網絡就是具有代表性的輕量型網絡。

航空兵器 2021年第28卷第5期

宋泰年, 等: 面向輕量化網絡的改進雙通道注意力機制圖像分類方法

MobileNetV2在網絡中引入了倒殘差結構和線性瓶頸結構。? 傳統的殘差結構是先降低維度再將其升高, 而倒殘差結構采用相反的順序, 先利用一層1×1的逐點卷積提升維度, 再利用3×3的深度卷積來代替3×3標準卷積, 能夠將計算量大幅降低, 進而提升網絡模型的效果。 線性瓶頸結構是設計1×1逐點卷積降低維度并同輸入相加, 去除最后一層的激活函數ReLU, 用線性激活函數來替代, 以改進信息損失嚴重的問題。 此外, 在網絡中引入了擴張系數用于控制網絡的大小。 其瓶頸結構如圖1所示。

表1為圖1中瓶頸圖上每一層的輸入輸出關系, 其中: k為輸入通道數; h, w分別為輸入的高和寬; s為步長; t為擴張系數; ?k′ 為輸出通道數。

1.2 注意力機制

當增加深度和寬度在卷積神經網絡中的改進效果已經不明顯時, 研究者們把研究方向放在注意力機制上。 注意力機制首先應用于自然語言處理中。 在圖像分類中, 注意力機制通過增加部分特征圖的權重, 讓卷積神經網絡選擇性地重視一些特征圖, 抑制一些特征圖。 目前, 在這方面已經開展大量研究。 SENet注意力設計了一種通道模塊, 引入壓縮和激勵兩個過程, 利用全局平均池化將空間壓縮為1×1×C的特征圖, 再經過兩個全連接層對不同特征圖賦予不同權重。 CBAM模塊在通道注意力的基礎上關注了空間注意力, 在通道和空間注意力上利用全局平均池化和全局最大池化進行權重重置, 結果證明比單通道注意力機制效果更好。 除此之外, CBAM還探索了通道空間注意力的排列順序對分類效果的影響。 最近提出的ECANet模塊[13]在SENet模塊的基礎上, 避免了通道維度的降低, 同時通過增加一維卷積的數量, 實現了局部跨信道交互的覆蓋率, 分類準確率有一定提升。

2 基于SPP-DCAM模塊的MobileNetV2網絡架構

2.1 改進的網絡結構

針對彈載終端環境下對于深度卷積神經網絡輕量化和準確率兩方面的要求, 以MobileNetV2為基準, 在保證其輕量化的基礎上加入自主設計的注意力機制結構來提升網絡的分類準確率。 在通道注意力及空間注意力的設計過程中, 采用小卷積塊來保證網絡對于計算量的要求, 并且設計不同尺寸的卷積塊來提取特征圖的多尺度信息, 設計空洞率不同的卷積塊使網絡注意全局特征, 將設計好的注意力模塊加入MobileNetV2網絡結構中。

本文提出了一種新的通道和空間注意力模塊SPP-DCAM, 其構成如圖2所示。 首先, 輸入卷積層提取的特征圖, 并行進入通道和空間模塊; 然后, 在通道注意力模塊里經過空間金字塔池化層[14], 提取多尺度語義信息, 進入多層感知機, 在激活函數的作用下, 得到重新分配權重后的特征圖; 在空間注意力模塊中, 設計不同尺度的空洞卷積增大感受野, 得到語義全面的空間特征圖; 最后, 將兩個模塊生成的特征圖融合生成提取特征圖。

由于MobileNetV2引入倒殘差結構和線性瓶頸結構, 使其計算量大大降低。 本文引入自主設計的注意力模塊來提升其分類準確率。 改進后的網絡結構如表2所示。 將設計好的注意力模塊融入網絡結構的第3,? 5,? 6,? 7層, 在保證網絡尺寸及計算量不改變的基礎上增加識別準確率。

2.2 通道注意力增強模塊

通道注意力如圖3所示, 當輸入的特征圖為XK∈RH×W×C 時, 經過空間金字塔池化對全局信息在空間維度進行H×W壓縮, 壓縮為1×1×C的通道特征圖, 映射生成相對應的權重信息。 空間金字塔結構自適應平均地將輸入特征圖存入3個尺度。 將3個通道的輸出重新調整為3個1維向量, 融合后生成1維注意圖。

在空間金字塔池化層中提取1維注意力圖之后, 為了賦予不同通道以不同權重。 在后面接兩個全連接層, 采用sigmoid函數將輸出歸一化到(0, 1)的范圍。 經過SPP池化層和兩個全連接層后的輸出為

M~=sig(W2ρ(W1M)) (1)

式中: M~為經過SPP池化層和兩個全連接層后的輸出; W1和W2分別為第1層和第2層全連接層; M代表經過SPP層后生成的1維特征圖; ?ρ 表示ReLU函數出; ?sig ()為sigmoid函數。

空間通道注意力機制的輸出為

XK=XK M~ (2)

SPP本質上是多個平均池化層, 對于不同尺寸的a×a的特征圖, 通過調整滑窗大小及步長, 生成固定大小的輸出n×n。 如圖4中由3個平均池化層組成, 對于任意大小的輸入, 提取4×4, 2×2, 1×1的特征向量, 經過特征融合統一輸出21維的特征向量。 使輸入圖像的尺寸在不會受到限制的同時又能提取多尺度的語義特征。

2.3 空間注意力增強模塊

為了在增加感受野的基礎上, 突出顯著空間特征, 抑制不重要的特征, 提升網絡的分類準確率, 設計了空間信息與通道信息并聯輸入, 空間注意力模塊是由2個3×3的空洞卷積和2個1×1卷積組成。

其中, 空間注意力模塊如圖5所示。 首先, 特征圖在經過壓縮后分別經過2個空洞率為2和3的空洞卷積層,

最后經過壓縮生成1維特征圖。 選擇2個空洞卷積層的原因是盡可能增大感受野, 但如果僅選擇空洞率大的卷積塊, 會出現特征語義在空間上不連續、 提取的特征過于分散的情況, 導致分類準確率不增反降。 因而, 選擇空洞率為2和3的2個尺寸為3×3的空洞卷積塊, 經過疊加后可以增加感受野大小, 也能提取到連續的特征語義。 2個空洞卷積實際感受野的大小為

Fi+1=Fi+(K-1)×Si (3)

式中: Fi+1 為當前層的感受野; Fi 為上一層的感受野; ?Si 為之前所有層的步長的乘積(不包括本層); K為卷積核的大小。 經計算可得實際感受野大小為12×12, 用 f 12×12表示。 空間注意力模塊的輸出為

X″K=XK V~ (4)

式中: V~=( f12×12(Aavg ))avg為經過空洞卷積之后生成的注意力圖,

Aavg為輸入特征圖經過1×1卷積后的輸出。

3 實驗與分析

本文算法的驗證平臺是戴爾R740服務器, 深度學習框架采用pytorch, 驗證環境為pycharm+anaconda。

利用的數據集為cifar-100基準數據集, 此數據集被廣泛應用在分類算法中以驗證算法的有效性。 數據集中有60 000張尺寸為32×32的彩色圖片, 分為100類, 每類包含600張圖片, 這100類從屬于20個超類。 其中, 50 000張用來訓練, 10 000張用來測試。 試驗參數設置為: 優化算法選擇梯度下降法; 批大小為512; 學習初始率為0.1; 訓練批次設定為100; 動量設定為0.9; 迭代次數設定為300; 權重衰減為0.000 5。

3.1 與不同卷積神經網絡的對比

為驗證設計的網絡性能, 將提出的基于SPP-DCAM模塊的MobileNetV2(SPP-DCAM- MobileNetV2)與不同的經典卷積神經網絡進行對比。 試驗選取典型的神經網絡, 分別為代表增加深度以提升分類效果的VGG16典型網絡; 代表殘差網絡的ResNet18典型網絡; 代表稠密連接網絡的DenseNet[15]卷積網絡。 分類效果及提升效果如表3所示。

由表3可知, 所提出的SPP-DCAM- MobileNetV2卷積神經網絡在分類效果上取得良好效果, 準確率有大幅度提升。 在4種網絡中平均提升幅度為0.995%。

3.2 與不同注意力模塊的對比

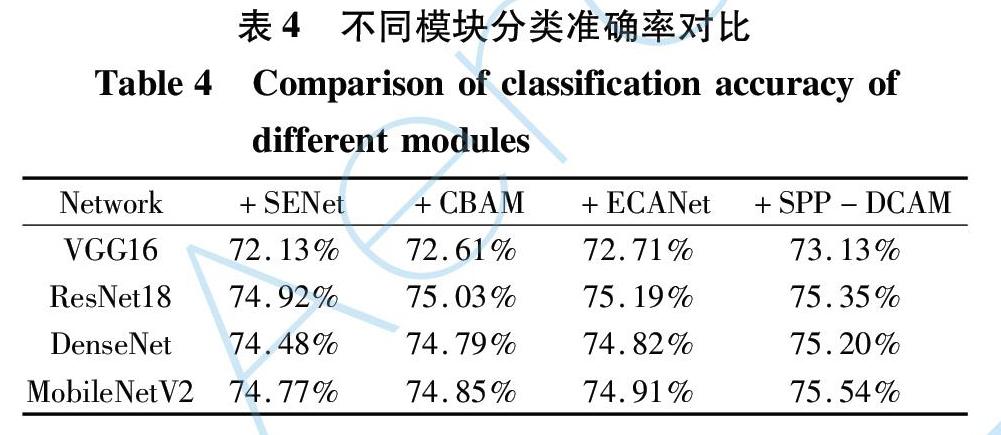

通過對比在圖像分類方面取得優秀成績的SENet和CBAM注意力模塊, 以及最近提出的ECANet模塊來檢驗本文算法的有效性和改進效果。 分類準確率如表4所示。

由表4可知, 在不同卷積神經網絡中, 雙注意力機制的CBAM模塊的分類效果要好于單注意力的SENet注意力模塊, 最新提出的ECANet模塊的分類準確率高于CBAM模塊, 而本文提出的SPP-DCAM又比ECANet模塊分類效果更好。

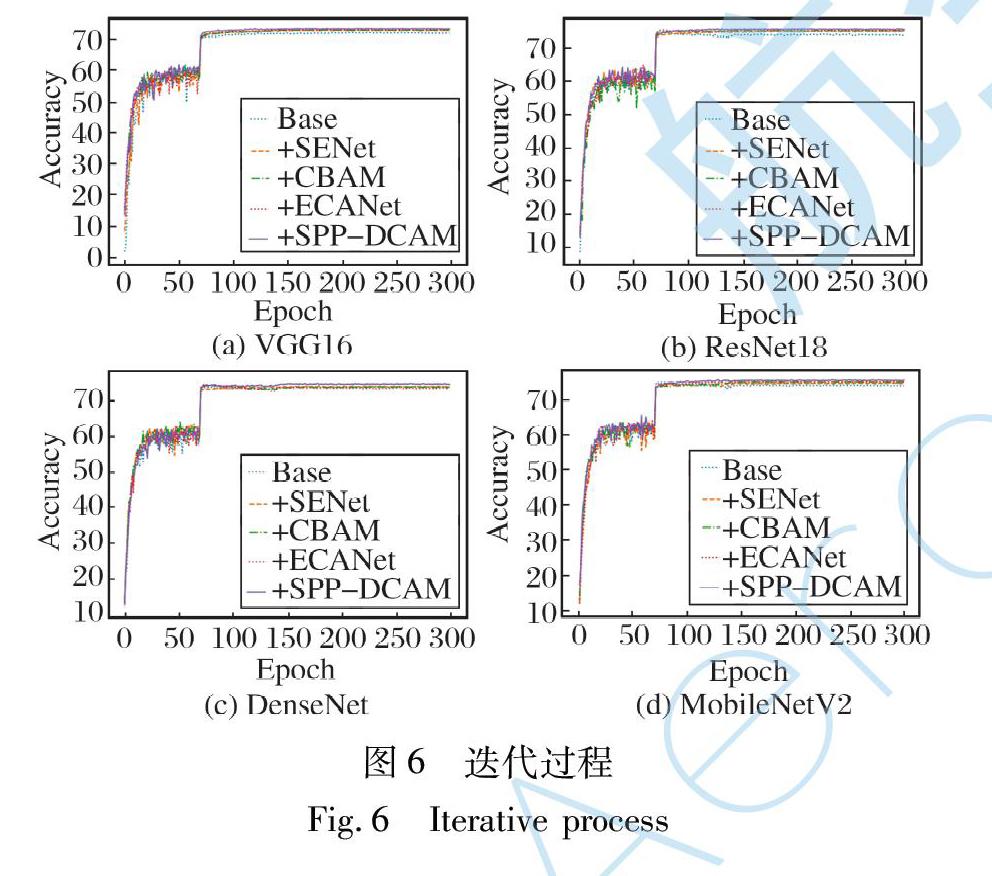

在300次迭代過程中, 4種注意力模塊在4種卷積神經網絡中的準確率變化如圖6所示。 可以看出, SPP-DCAM模塊在迭代過程中優于其他模塊。

綜合數據分析, 證明了SPP-DCAM-MobileNetV2卷積神經網絡的有效性和優越性, 特別是在分類準確率上有了較大提升。 其主要原因包括兩個方面: 一是通道注意力打破了全局平均池化和全局最大池化的束縛, 將SPP引入了模塊, 提取的特征層次性更強, 權重分配更加合理, 特征表征能力優化明顯; 二是在空間注意力中設計了空洞卷積, 合理選擇了池化塊大小和空洞率大小。 相比于傳統的空間注意力模塊, SPP-DCAM能夠增大感受野, 提取范圍進一步擴大并且兼顧語義連續性的問題, 達到了一個很好的動態平衡, 提取的顯著特征圖更加合理。 兩方面的優化效果疊加使得本文提出的網絡的分類準確率提升明顯。

3.3 算法復雜度對比

為進一步檢驗本文算法在輕量化網絡方面的優勢, 將所提出的網絡結構在cifar-100數據集上進行參數量和計算復雜度對比, 結果如表5所示。 可以看到, 在增加了注意力模塊的情況下, 既能夠提高分類準確率, 同時也能夠保證網絡參數量以及計算復雜度變化較小, 使網絡保持輕量化。

參考文獻:

[1] Krizhevsky A,? Sutskever I,? Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks[J]. Communications of the ACM,? 2017,? 60(6): 84-90.

[2] Simonyan K,? Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[EB/OL]. (2015-04-10)[2020-12-20].https:∥arxiv.org/pdf/1409.1556.pdf.

[3] Szegedy C,? Liu W,? Jia Y Q,? et al. Going Deeper with Convolutions[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR),? 2015: 1-9.

[4] He K M,? Zhang X Y,? Ren S Q,? et al. Deep Residual Learning for Image Recognition[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR),? 2016: 770-778.

[5] Hu J,? Shen L,? Albanie S,? et al. Squeeze-and-Excitation Networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,? 2020,? 42(8): 2011-2023.

[6] Woo S,? Park J,? Lee J Y,? et al. CBAM: Convolutional Block Attention Module[C]∥ European Conference on Computer Vision,? 2018: 3-19.

[7] Sandler M,? Howard A,? Zhu M L,? et al. MobileNetV2: Inverted Residuals and Linear Bottlenecks[J].? IEEE/CVF Conference on Computer Vision and Pattern Recognition,? 2018: 4510-4520.

[8] 李慧慧,? 閆坤,? 張李軒,? 等. 基于MobileNetV2的圓形指針式儀表識別系統[J]. 計算機應用, 2021, 41(4): 1214-1220.

Li Huihui,? Yan Kun,? Zhang Lixuan,? et al. Circular Pointer Instrument Recognition System Based on MobileNetV2[J]. Journal of Computer Applications,? 2021, 41(4): 1214-1220. (in Chinese)

[9] 楊國亮,? 李放,? 朱晨,? 等. 改進MobileNetV2網絡在遙感影像場景分類中的應用[J]. 遙感信息,? 2020,? 35(1): 1-8.

Yang Guoliang,? Li Fang,? Zhu Chen,? et al. Application of Improved MobileNetV2 Network in Remote Sensing Image Classification[J]. Remote Sensing Information,? 2020,? 35(1): 1-8.(in Chinese)

[10] 畢鵬程,? 羅健欣,? 陳衛衛,? 等. 面向移動端的輕量化卷積神經網絡結構[J]. 信息技術與網絡安全,? 2019,? 38(9): 24-29.

Bi Pengcheng,? Luo Jianxin,? Chen Weiwei,? et al. Lightweight Convolutional Neural Network Structure for Mobile[J]. Information Technology and Network Security,? 2019,? 38(9): 24-29.(in Chinese)

[11] 任坤,? 黃瀧,? 范春奇,? 等. 基于多尺度像素特征融合的實時小交通標志檢測算法[J]. 信號處理,? 2020,? 36(9): 1457-1463.

Ren Kun,? Huang Long,? Fan Chunqi,? et al. Real-Time Small Traffic Sign Detection Algorithm Based on Multi-Scale Pixel Feature Fusion[J]. Journal of Signal Processing,? 2020,? 36(9): 1457-1463.(in Chinese)

[12] 崔洲涓,? 安軍社,? 張羽豐,? 等. 面向無人機的輕量級Siamese注意力網絡目標跟蹤[J]. 光學學報,? 2020,? 40(19): 132-144.

Cui Zhoujuan,? An Junshe,? Zhang Yufeng,? et al. Light-Weight Siamese Attention Network Object Tracking for Unmanned Aerial Vehicle[J]. Acta Optica Sinica,? 2020,? 40(19): 132-144.(in Chinese)

[13] Wang Q L,? Wu B G,? Zhu P F,? et al. ECA-Net: Efficient Channel Attention for Deep Convolutional Neural Networks[C]∥ IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR),? 2020: 11531-11539.

[14] He K M,? Zhang X Y,? Ren S Q,? et al. Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,? 2015,? 37(9): 1904-1916.

[15] Huang G,? Liu Z,? van der Maaten L,? et al. Densely Connected Convolutional Networks[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR),? 2017: 2261-2269.

Improved Dual-Channel Attention Mechanism Image

Classification Method for Lightweight Network

Song Tainian1,? Qin Weiwei1*,? Liang Zhuo2,? Wang Kui1,? Liu Gang1

(1. Rocket Force University of Engineering,? Xian 710025,? China;

2. China Academy of Launch Vehicle Technology,? Beijing 100076,? China)

Abstract: In order to solve the problems of large volume and high hardware requirements of deep convolutional neural network model in missile-borne terminal environment,? a lightweight network structure based on improved dual-channel attention mechanism is constructed. Aiming at the problem that the network lightweight will sacrifice the classification accuracy,? taking the MobileNetV2? lightweight network as the? network basic structure,? the self-designed attention module is introduced,? and the MobileNetV2 network architecture based on SPP-DCAM module is designed to increase the weight of the significant feature map of convolutional layer learning,? so as to improve the classification accuracy. The designed spatial information is input in parallel with channel information. By defining 1×1 and 3×3 small convolution,? the computation amount and computational complexity are reduced on the basis of ensuring the lightweight of the structure. Finally,? an experimental comparison is conducted on the cifar-100 image classification dataset. The results show that?? the classification accuracy of

improved MobileNetV2? is better than that of the traditional VGG16,? ResNet18 and DenseNet convoluted networks with the same number of parameters and computational complexity,? and the comprehensive performance is stronger,? which is more suitable for rapid classification under the condition of limited onboard computational resources.

Key words: MobileNetV2; attention mechanism; image classification; convolutional neural network; lightweight network; artificial intelligence