人工智能輔助下人機交互隔空手勢識別模型

陳 瑩,黃永彪*,謝 瑾

(1.廣西民族大學,廣西 南寧 530006;2.武漢大學計算機學院,湖北 武漢 430072)

1 引言

人機交互的形式隨著生活水平的日益提升與智能設備的普及,逐漸進入大眾的日常生活,其中,應用最多、最常見的手勢識別技術,引發了眾多相關研究學者的熱烈討論。針對手勢背景復雜性與形態多樣性,石雨鑫等[1]提出一種基于卷積神經網絡與隨機森林的識別方法,經過分割靜態手勢圖像,采用卷積神經網絡對特征向量進行提取,通過森林分類器完成特征向量劃分。孫玉等[2]在研究中采用Leap Motion傳感器收集手部的三維坐標數據,并獲得含有手指動作與手掌位移的動態手勢特征序列,通過與長短期記憶網絡模型的結合,實現手勢識別。而彭玉青等[3]研究得出的手勢識別方法,則應用了改進的TOLO算法來檢測手勢,根據空間金字塔池化,避免卷積神經網絡的多尺度輸入,從復雜的背景中識別手勢。

為進一步提高人機交互手勢識別準確度,提出一種人工智能輔助下人機交互隔空手勢識別模型。根據人機交互隔空手勢識別的原理,添加語義反饋與交互通道信息整合機制,設計支持隔空手勢識別。在色彩空間中,架構高斯混合的顏色分布模型,采用最大類間方差法,對相似度圖像實施二值化處理,完成手勢姿態分割。構建相對深度直方圖及其歸一化圖像,通過級聯分類器獲取最終的手勢動作,實現隔空手勢識別。

2 人機交互隔空手勢識別分析

隔空的人機交互模式作為具有未來感的方式,具有廣闊的應用前景。Norman模型是人機交互里最具影響力的模型之一,其與人機之間的直觀認知非常接近[4]。交互系統共有四個部分構成,分別為用戶、系統、輸入與輸出。在識別隔空手勢過程中,需要采用“懸停”等特殊動作表示用戶對命令的選取。若靜止時長達到設定的時間閾值,則觸發選中命令,但若靜止時間長度不足預設閾值,那么將重新計時。觸發選中命令流程如圖1所示。

圖1 觸發選中命令流程圖

用戶發出隔空手勢動作,利用Kinect動作跟蹤手勢并采集手部圖像數據,當判斷手勢懸空靜止時間未超過閾值,則返回至動作跟蹤;當判斷手勢懸空靜止時間超過閾值,則觸發選中操作。基于上述手勢識別分析過程,為計算機輔助下隔空手勢識別模型的設計提供依據。

3 人機交互隔空手勢識別模型設計

3.1 計算機輔助下隔空手勢識別整體框架

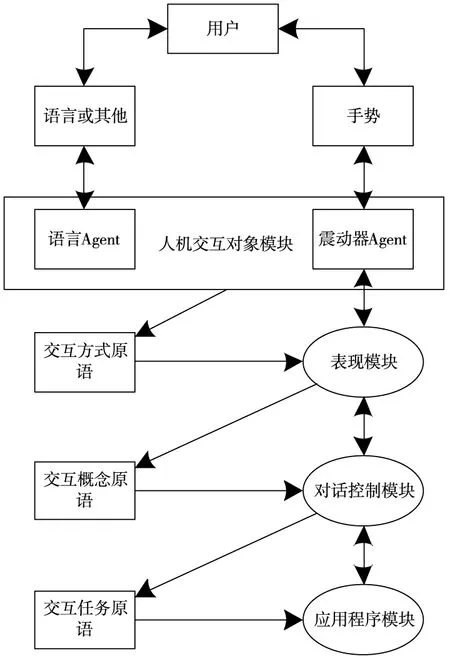

多通道交互技術的逐漸成熟,當今的網絡環境逐漸演變為一個無處不在的服務供應平臺,而且添加了相對自然的交互方式。因為軟、硬件不斷地更新換代,使人機交互領域出現了隔空手勢識別的新型技術。該模型通過引入較強的語義反饋與交互通道信息整合機制,實現手勢識別模型的架構,其整體框架如圖2所示。

圖2 隔空手勢識別模型結構示意圖

識別模型的組成部分共有五個,分別是用戶模塊、人機交互對象模塊、表現模塊、對話控制模塊以及應用程序模塊。各部分的相應性能描述如下:

1)用戶模塊:采用交互對象庫里的各類交互工具與設備,對信息進行輸入,利用反饋設備,完成相應信息的獲取;

2)人機交互對象模塊:控制管理輸入與輸出設備,將用戶的手勢動作轉換成交互方式的原語,并放入交互原語的隊列里,且該模塊可以對表現模塊的驅動進行接收,把處理結果傳輸至用戶。由于抽象化手勢姿態可以得到交互原語,因此,所有級別的原語均與設備具有一定的關聯性,而各模塊則是以增刪變更設備、確保通道完整性為目的而創建的;

3)表現模塊:對交互對象庫里的交互原語進行抽象化處理,得到交互概念原語,與此同時,完成對話控制模塊返回信息的接收,其概念原語用于處理人機交互對象模塊的信息,而對象顯示的處理目標則是對話控制模塊;

4)對話控制模塊:通過整合用戶的所有交互信息,解析交互意圖[5],從而組建成交互任務原語,并放入原語隊列,該模塊對應用程序發送的應用反饋進行接收后,經過表現模塊,將其發送給用戶;

5)應用程序模塊:對用戶提交的任務進行處理后,把結果發送至對話控制模塊,該模塊由多個處理任務的非交互式計算部分構成[6]。其運算結果儲存區域為相應用戶界面內的抽象部分里,最終經過用戶界面發送至用戶。

3.2 手勢分割

基于MCG-Skin數據庫,采用分量Cr與Cb,在YCrCb的色彩空間內,架構如式(1)所示的顏色分布表達式

Pc(x)=αCrg(x,μCr,σCr)+αCbg(x,μCb,σCb)

(1)

式(1)中,α表示顏色分量系數,g表示顏色過濾值,μ表示均勻量化系數。

根據顏色分布公式,在深度圖像中手勢識別時,通過背景去除實現兩個獨立高斯模型的合并搭建,采用下列表達式對所得的高斯混合模型進行描述

Pd(x)=αhg(x,μh,σh)+αfg(x,μf,σf)

(2)

式(2)中,(αh,αf,μh,μf,σh,σf)是該概率密度函數的參數,且αh與αf之間存在下列關系式

αh+αf=1

(3)

因為在人機交互的過程中,手勢姿態一直位于身體的前部,所以,將高斯混合模型Pd(x)的μh設定成手勢的深度值,身體深度值用μf來表示,則深度閾值表達式如式(4)所示

(4)

在顏色分布模型Pc(x)里輸入經過閾值處理的圖像像素點,對所有像素對應的顏色點概率進行獲取,通過將其映射至灰度范圍[0,255]中,完成含有256灰度等級的膚色相似度圖像重建,相似度隨著各像素灰度值的增加而提升。依據最大類間方差法對相似度圖像實施二值化處理[7],膚色點用灰色像素表示,其余點則為黑色像素,令手勢姿態得到理想的分割。

3.3 手勢跟蹤

建立相對深度直方圖時,選用下列離散函數來指代灰度范圍是[0,L-1]的圖像直方圖

h(rk)=nk

(5)

式(5)中,第k級灰度表示為rk,圖像含有rk灰度級的像素數量是nk,且k=0,1,…,L-1。

對手勢跟蹤的重要前提是對圖像信息進行歸一化處理,使之變換為一固定標準形式的過程,因此歸一化直方圖的推算公式如式(6)所示

(6)

式(6)中,rk灰度級的出現概率預估值為P(rk)。根據式(6)可以得出,把歸一化直方圖的各區域相加,得到的總和是1。

通過所有像素的絕對深度值,求取其相對極小深度值的絕對深度,從而設定相對深度的取值區間是[0,D-1]。若采用式(5)表示相對深度直方圖,則第k級相對深度表示為rk,圖像含有rk深度級的像素數量是nk,且k=0,1,…,D-1,其歸一化相對深度直方圖的構建方法同灰度直方圖。

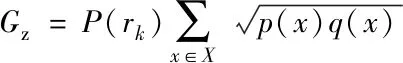

選用常用的概率分布相似性評估方法對相對深度直方圖的相似度進行判定,則基于離散概率分布條件的巴氏距離定義域X界定公式如(7)所示

DB(p,q)=-ln(Bs(p,q))

(7)

式(7)中,巴氏系數表示為Bs(p,q)。在巴氏距離計算的基礎上,計算手勢跟蹤公式為

(8)

式(8)中,x表示手勢運動速度。至此實現了隔空手勢的跟蹤,為手勢準確識別做鋪墊。

3.4 手勢識別

鑒于隔空手勢識別的難度,需要引入一組級聯式的學習器,通過不同階段學習器對姿勢內在模式的學習,精準、快速識別隔空手勢。該方法的流程圖如圖3所示。

圖3 級聯式手勢識別流程示意圖

用hi表示第i級學習器,在姿勢樣本x進行至第i級時,如果學習器hi無法完成高置信度的識別,那么,將識別任務交予下一級學習器,待取得最終的識別結果,任務結束。因為級聯的建立理念可以令各級學習器學習各種姿勢模式,讓前兩級學習器精準識別難度較低的非控制姿勢,而難以區分的控制姿勢則由偏后的學習器負責識別,使其不被非控制姿勢識別階段所影響。

級聯結構逐級識別非控制姿態的過程中,級數的遞增有效緩解了控制姿態與非控制姿態的類別不平衡性[8]。將后續學習器的關注點著重放在兩種姿態的差異模式上,因為級聯靠前的學習器識別對象只有非控制姿態,所以,樣本不平衡并不會影響識別效果。

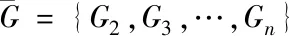

假設隔空手勢動作集合的表達式如式(9)所示

G={G1,G2,…,Gn}

(9)

式(9)中,姿勢種類數量表示為n。

(10)

從各姿勢種類中采集一組樣本作為訓練數據,其集合表達式如(11)所示

G1={xi1,xi2,…,xim}

(11)

式(11)里,第i種姿勢的樣本數量是m。

隨機選擇一組級聯分類器,采用下列公式對其進行描述

T={(M1,F1),(M2,F2),…,(Mi,Fi)}

(12)

式(12)里,第i層分類器為Mi,對應特征則為Fi。所以,得到如下特征集合表達式

F={F1,F2,…,Fi}

(13)

手勢識別的具體流程描述如下:

(14)

4)在級聯分類器T內加入(Mi,Fi),其中,i應自加1;

5)返回級聯分類器T。

隔空手勢識別是一種更自然、更易于理解與應用的人機交互形式,只有精準識別出隔空手勢,才能進行理想的人機交互。

4 實驗分析

實驗應用Kinect軟件對手勢動作進行采集,并隨機選取實驗11k Hands數據集中100幅像素為50×50的圖像作為實驗對象,計算機配置為奔騰2.8GHz雙核E5500處理器,運行內存為6GB。

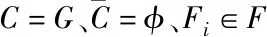

分別采用自學習稀疏表示法與本文模型,對實驗者的“抓”“放”手勢實施識別,效果評估參數選用的是F1,該指標數值越高,表示手勢識別準確率越高,識別效果越好,其表達式如(15)所示

(15)

式(15)中,precision表示精準率,recall表示召回率[10],對應的計算公式分別如下

(16)

(17)

式(16)、(17)中,準確預估的樣本數量為tp,錯判的樣本數量為fp,當前類別被預估成其它類別的樣本數量是fn。

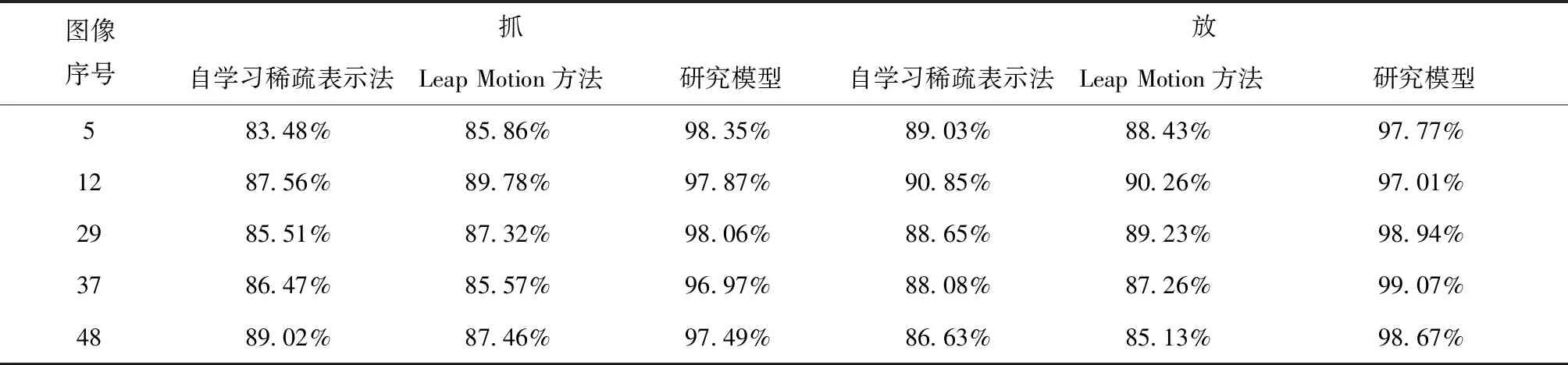

如表1所示為各方法得出的手勢識別F1指標數統計表。

表1 手勢識別F1指標數統計表

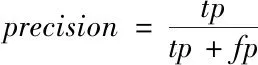

為了使三種方法的對比更加直觀,將表中數據用下列折線圖(圖4)進行展示。

根據表1、圖4中數據可以看出,研究模型比自學習稀疏表示法具有更加理想的識別效果,評估指標F1的識別數值高于95%,自學習稀疏表示法的評估指標F1的識別數值均不滿90%,最高只有90.85%,Leap Motion方法的最高評估指標F1的識別數值為90.26%,無法滿足實際的精度需求。

5 結論

為優化人機交互的手勢識別方法,提出一種人工智能輔助下人機交互隔空手勢識別模型。依據隔空手勢識別原理,構建語義反饋與交互通道信息相結合的手勢識別模型。通過膚色數據庫與色彩空間,對高斯混合的顏色分布模型進行架構。采用計算得到的深度閾值,獲取顏色點概率,利用最大類間方差法對經過重建的相似度圖像進行二值化處理。基于相對深度直方圖,采用巴氏距離進行判定,通過各級聯學習器對動作內在模式的學習,使隔空手勢識別得以實現。該模型為未來的相關研究提供了良好的數據支持,具有重要的現實價值與現實意義。

圖4 評估指標數值對比圖