加權HOG 與特征融合行為識別方法研究

宋 琳,劉永濤

(南京郵電大學通信與信息工程學院,江蘇南京 210003)

0 引言

視頻中的人體行為識別作為計算機視覺領域一個主要研究方向,在智能監控、醫療輔助、人機交互以及基于內容的視頻分析等領域都發揮著重要作用[1-4]。在智能監控領域,在技術方面,不僅要使監控系統能夠識別出異常或危險行為,而且要根據不同行為發出不同警報,警示人們作好準備;在經濟方面,要求在敏感活動區域內能夠實施無人監控,避免配備大量安保裝置與安保人員,從而大幅降低人力和物力成本。光流通常用于表達人體行為的運動信息,例如:Jagadeesh 等[5]提出基于光流與SVM 分類器的人體動作檢測與識別方法;魯統偉等[6]將基于光流的人體行為識別算法應用于教室內學生站立與坐下動作識別;薄思宇[7]提出結合光流法與ViBe 算法對視頻中的運動目標進行準確檢測,以及利用多特征融合方法對人體運動視頻進行有效的分類識別。在靜態信息表達方面,Dalal 等[8]提出基于方向梯度直方圖(Histogram of Oriented Gradient,HOG)的人體檢測方法用于表達紋理特征;Ali 等[9]提出基于尺度不變特征變換(Scale-Invariant Feature Transform,SIFT)與視覺詞袋的人體行為識別算法用于表達興趣點特征;Scovanner 等[10]進一步提出將3D SIFT 用于描述視頻,并介紹其在行為識別領域的應用。在特征融合方面,韓欣欣等[11]提出將SIFT 與HOG 特征融合的人體行為識別方法,以彌補單一特征的不足。

SIFT 與HOG 特征融合可以很好地表達人體目標的靜態外觀信息,并且對光照等外部因素的影響也有很好的適應性,但缺乏對動態信息的表述。光流表達了圖像變化,包含了目標運動信息,因此本文提出一種將光流強度加權HOG 特征與SIFT 特征進行融合得到改進的融合特征,最后通過SVM 完成分類識別的算法。

1 算法原理

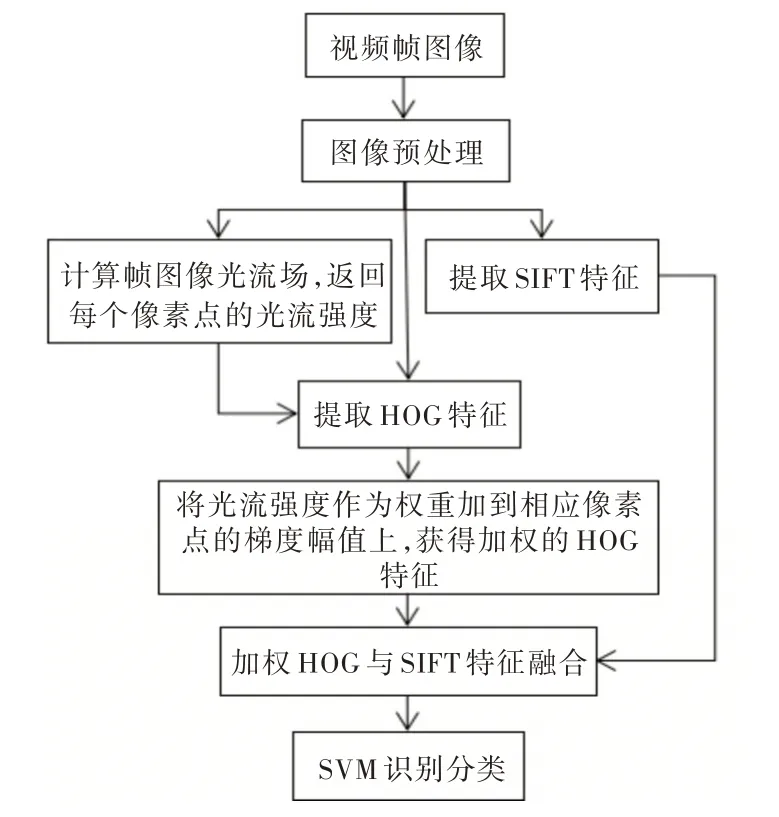

該算法具體步驟為:目標檢測、光流場計算、HOG 特征提取、SIFT 特征提取、加權HOG 與SIFT 特征融合、SVM 分類識別。從KTH 人體行為數據庫中選取視頻,首先對視頻幀進行預處理,對彩色圖像依次進行灰度化、亮度歸一化、濾波,從而增強圖像對比度、降低噪聲;然后對預處理后的視頻幀計算幀間光流,返回光流強度,同時提取HOG 特征與SIFT 特征;接下來用光流強度對HOG 特征進行加權,并與SIFT 特征進行融合;最后通過SVM 完成分類識別。算法流程如圖1 所示。

Fig.1 Algorithm flow圖1 算法流程

1.1 光流

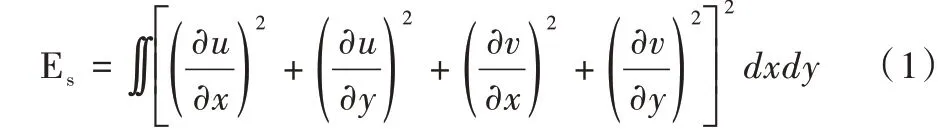

本文采用Horn-Schunck 光流算法用于估計稠密光流[12]。HS 光流法的提出基于兩個假設:①假設在短時間內運動物體灰度值不變;②假設像素點在給定鄰域內的移動速度非常緩慢。所以,HS 光流法基于光流約束方程和全局光流平滑約束兩個條件。其中,光流平滑約束條件如式(1)所示,u為水平光流矢量,v為垂直光流矢量。

根據光流約束方程Ixu+Iy v+It=0,對Es進行極小值化,可將求解光流場轉變為對式(2)的求解:

其中,λ為權重,代表約束條件以及圖像數據置信度。λ的值取決于圖片質量,若質量高,Ix、Iy和It增加權重值,反之則降低權重值。

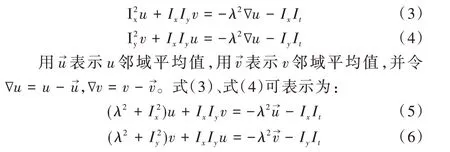

對式(2)中的u、v分別求導,可得:

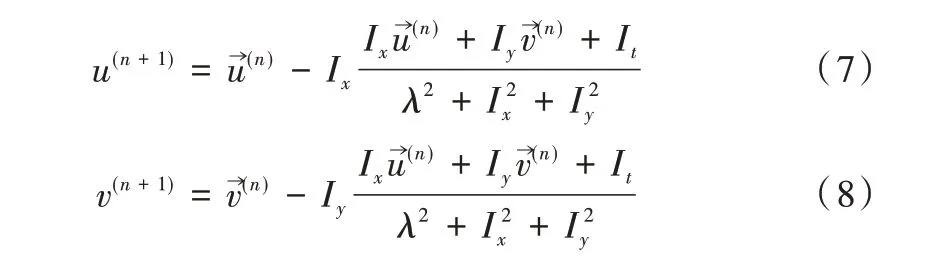

聯立式(5)、式(6),并引入松弛迭代法得到u、v的迭代公式如下:

在式(7)、式(8)中,光流矢量初始值為(0,0),依次計算兩個相鄰迭代光流值的差值。若迭代次數大于指定迭代次數(一般設為20 次),或計算的差值小于設定的誤差閾值,則計算結束。

根據上述過程,計算視頻序列里所有幀圖像的光流場F(x,y)。每個像素點的光流包括水平u(x,y)和垂直v(x,y)分量,由此得出運動強度及方向:

1.2 加權方向梯度直方圖

方向梯度直方圖特征由Dalai 等[13]最先提出,作為計算機視覺中的一種特征被廣泛應用于圖像分類、目標檢測與跟蹤等領域,在行人檢測中也取得了一定成果。在一幅視頻幀中,為表達出目標形狀和表面的一些信息,需要計算邊緣的方向密度分布或梯度等特征。其中,梯度角度表明了運動目標的運動方向,梯度幅值表明了鄰域像素點灰度值變化。

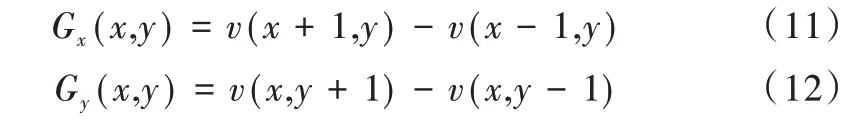

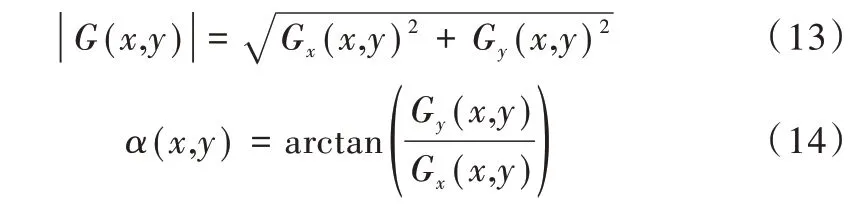

通過以下差分公式計算圖像中每個像素點(x,y)的水平方向梯度Gx(x,y)與垂直方向梯度Gy(x,y):

其中,ν(x,y)為像素點(x,y)的灰度值。梯度幅值和梯度方向分別為:

將光流場中對應像素點的光流強度作為權重加到梯度幅值上,得到加權的HOG 特征如下:

實驗中對樣本視頻幀圖像提取加權HOG 特征,首先對圖像進行分塊處理,分塊標準為:每個細胞單元大小為16 ×16 像素,每個區間塊大小為2 × 2 個細胞單元;然后在0~180°上劃分9 個區間,每個區間包含20°,對于每個細胞單元內的所有像素點,按照由光流強度加權的梯度幅值與梯度方向進行直方圖統計,得到一個9 維的特征向量,并將區間塊中所有細胞單元的特征串聯,得到一個區間塊的特征向量,維度為4 × 9=36;最后將所有區間塊特征串聯起來,得到該視頻幀的加權HOG 特征。

1.3 尺度不變特征變換

SIFT 由Lowe 等[14-15]首次提出并加以完善,是一種廣泛應用于圖像處理領域的局部性質特征描述子,可在尺度空間中提取極值點位置、方向等信息。該描述子不因拍攝角度、尺度縮放等因素而發生變化,還可與其它特征向量聯合生成新特征。SIFT 算法主要包括以下幾個步驟:

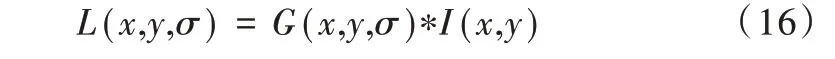

(1)尺度空間極值點檢測。首先構建尺度空間L(x,y),由序列幀圖像I(x,y)與高斯卷積核進行卷積得到:

其中,G(x,y,σ)是高斯函數且尺度可變,σ是尺度空間因子,σ值越大,包含細節特征越少,反之亦然。

然后,構造高斯差分空間(DOG):

對比相鄰兩個尺度的圖像,初步獲取極值點。將每個采樣點與相鄰的26 個(上下鄰近尺度對應的18 個以及同尺度的8 個)像素點作對比,當該采樣點數據在這27 個數據中是最大或最小值時,則判斷該采樣點為當前尺度下的極值點。

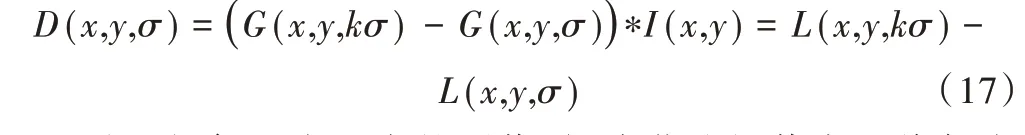

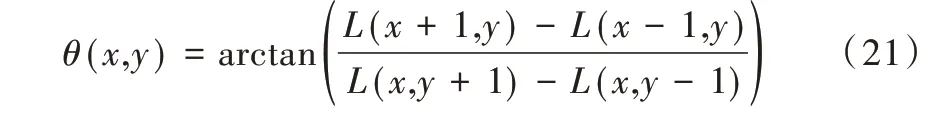

(2)極值點精確定位。為減少邊緣效應的影響,需要去除不穩定的極值點。對上述步驟得到的極值點采用擬合三維二次函數方法,并通過Hessian 矩陣進一步判斷是否為需要的關鍵點。當極值點滿足下列不等式時,表明該點為穩定的邊緣響應點,將其保留,否則剔除:

其中,H為像素點(x,y)的Hessian 矩陣,r為H較大特征值與較小特征值的比值。

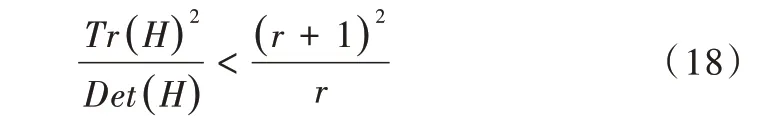

(3)關鍵點幅值與方向。利用關鍵點領域像素的梯度方向分布特性計算該點的梯度幅值與方向,具體公式如下:

實驗中對樣本圖像提取SIFT 特征,根據上述步驟構造高斯尺度空間并檢測空間的關鍵點,獲取關鍵點幅值與方向。將0~360°的方向范圍分為8 個柱,每柱45°,利用直方圖對關鍵點領域內像素對應的梯度方向與幅值進行統計,具體步驟為:把坐標系旋轉到關鍵點的主方向,以主方向為中心取8 × 8 的窗口,對窗口進行4 × 4 劃分得到4 × 4 個子區域,對每個子區域統計8 個方向上的梯度信息形成一個種子點,對應一個8 維特征向量。一個興趣點包含4 × 4個種子點,最終得到4 × 4 × 8=128 維向量,即為關鍵點特征描述。

2 算法步驟

本文算法主要步驟如下:首先讀取視頻幀,選取含有運動目標的視頻幀組成幀序列作為輸入,對幀序列依次進行灰度化、歸一化等預處理,從而增強圖像對比度,降低噪聲;然后提取幀序列的稠密光流特征、HOG 特征與SIFT 特征,利用光流強度對HOG 特征進行加權,得到加權HOG 特征,并與SIFT 特征進行串聯融合得到融合特征,之后采用PCA+Pearson[16]相關系數法對融合特征進行選擇與降維;最后使用SVM 分類器進行分類識別。

3 實驗結果與分析

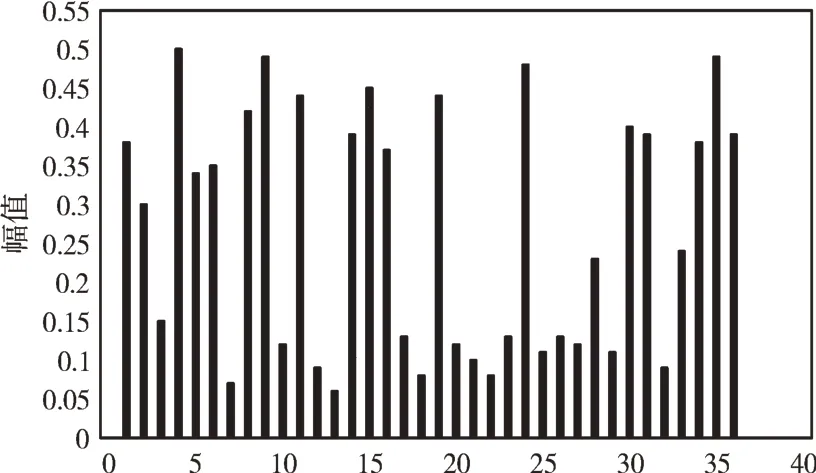

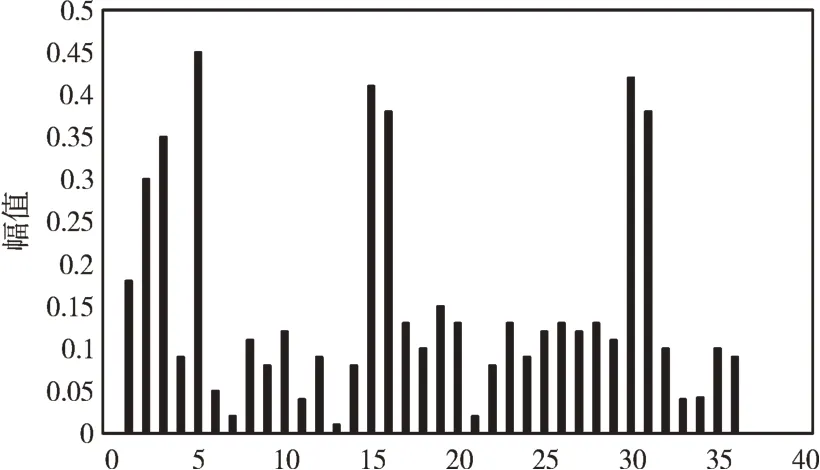

本實驗采用MATLAB 進行仿真,SVM 分類器采用RBF核函數。選取KTH 人體行為數據庫驗證該算法的有效性,該數據庫包括6 種人體行為(散步、慢跑、跑步、拳擊、鼓掌、揮手),共600 段視頻。對數據庫中的視頻進行劃分,篩選出162 個視頻,每類動作27 個視頻。從每類動作中隨機選出60 幀視頻圖像,其中50 幀作為訓練集,剩下的作為測試集[11],把對應的融合特征向量分別輸入SVM 多分類器模型進行訓練與分類識別,實驗結果如圖2、圖3 所示。其中,圖2 是原始方向梯度直方圖向量,圖3 是由光流強度加權并歸一化的方向梯度直方圖向量。

由圖2、圖3 可以看出,梯度幅值經光流強度加權后,運動目標特征保留了圖像空間信息,突出了運動部分,并弱化了不相關信息,使得不同動作之間的特征向量區別明顯。

Fig.2 Original HOG feature圖2 原始HOG 特征

Fig.3 Weighted HOG feature圖3 加權HOG 特征

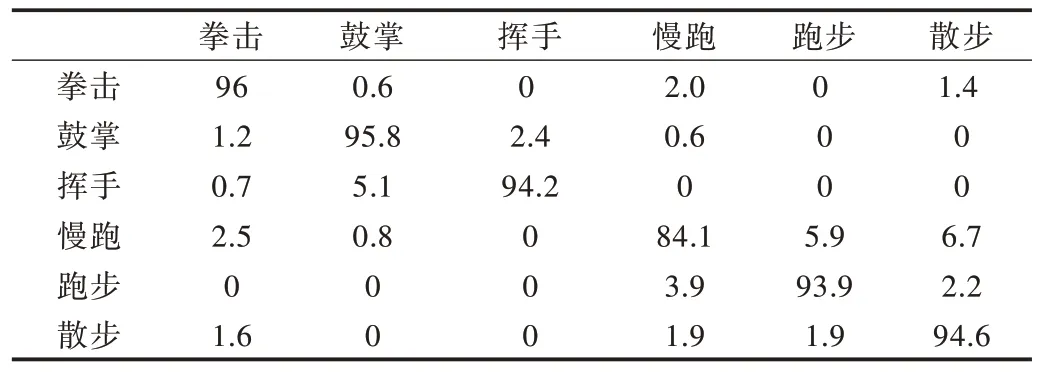

表1 為SVM 識別混淆矩陣,其平均識別率為93.1%。

Table 1 Confusion matrix of SVM recognition表1 SVM 識別混淆矩陣 單位:%

從表1 可以看出,因為拳擊動作類與其他動作類之間有明顯區別,所以誤識率最低,識別率最高,準確率達到96%;識別效果最差的動作類是慢跑,識別準確率為84.1%,這是由于慢跑與跑步、散步在基礎動作上基本一致,尤其是腿部動作很相似,導致誤識率較高,而且慢跑與拳擊在上肢部分的動作也有相似之處,所以識別時會出現一定程度的混淆。

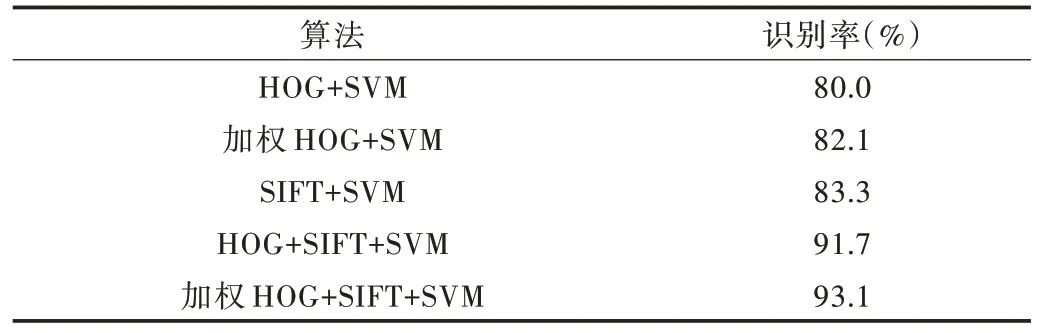

將本文算法與單一特征算法及其他融合特征算法進行比較,結果如表2 所示。

Table 2 Recognition rate of different features on the KTH表2 各特征在KTH 數據集上的識別率

從表2 可以看出,本文算法在KTH 數據集上的識別率達到93.1%,與單一特征算法相比,準確率提高了10%以上;與未經光流強度加權的融合特征算法相比,識別率由91.7%提高到93.1%,增加了1.4%左右。另外在單一特征算法中,加權HOG 的特征識別率為82.1%,與未加權HOG的特征識別率80%相比,準確率提高了2.1%左右,說明光流強度加權HOG 對提高識別率有一定幫助,證明了該算法的有效性。

4 結語

本文從豐富行為特征表達,從而提高行為識別準確率出發,提出使用光流強度加權的HOG 特征并將多特征進行融合,在運動目標靜態外觀信息基礎上添加了動態信息,豐富了運動目標的特征表達。在KTH 數據集上的實驗結果表明,與單一特征的傳統算法相比,本文算法的識別率顯著提升,與未加權的融合特征算法相比也有一定改進,驗證了本文算法的有效性。但當運動目標上有遮擋物時,識別效果仍不太理想,提取稠密光流特征也會使運算速度降低。因此,下一步研究方向是通過優化參數,在提高識別準確率的同時,確保算法的高效性。