基于卷積神經網絡和遷移學習的服裝圖像分類

高櫻萍,宋 丹,陳玉婷

(湖南工程學院,湖南 湘潭 411100)

隨著服裝電子商務的發展,越來越多的人選擇網絡進行線上購物,人們對服裝圖像識別技術的準確率的要求也在不斷提高。如何更好地實現快速、準確的服裝圖像的分類成為當前服裝研究的一個熱點。傳統的服裝圖像分類方法主要依據文本描述進行分類,提取圖像的顏色、紋理、邊緣等低級特征,花費了大量的人力物力且分類精度較低。

近年來,深度學習的發展為圖像處理領域提供了一種新的思路,在機器學習中,圖像分類的實質是對提取的圖像特征進行分析,并利用神經網絡將其分類的過程。卷積神經網絡(Convolutional Neural Network,CNN)是目前最流行的深度神經網絡學習算法之一,經過訓練的卷積神經網絡能夠學習到圖像中的特征,并且完成對圖像特征的提取和分類。目前,使用卷積神經網絡解決圖像分類中的問題逐漸成為主流。

白琮等[1]提出了一種基于深度卷積神經網絡Alex Net的二值化哈希圖像分類方法,主要對原有的Alex Net網絡模型進行了改進,在池化階段采用最大-均值池化,并在全連接層采用最大值激活輸出,使網絡表達更精確的圖像特征信息,同時在全連接層引入隱層來學習哈希編碼,提高分類效率,該文提出的優化方法可以明顯地提升深度卷積網絡在大規模圖像分類任務上的性能。高妍等[2]針對圖像分類中網絡訓練時間長、形變服裝圖像識別率低的問題,提出了一種改進HSR-FCN 的服裝圖像識別分類算法,將R-FCN 中的區域建議網絡和Hyper Net網絡結合,使得HSRFCN 可以在更短的訓練時間內達到更高的準確率。

Liu等[3]提出了一個數據量大且標注完整的服裝數據集Deep Fashion,并在此基礎上提出了一種新的模型即Fashion Net,該模型通過共同預測服裝屬性和標簽來學習服裝特征,通過大量的試驗證明了Fashion-Net的有效性和Deep Fashion的實用性。謝小紅等[4]為了提高服裝圖像的分類性能,提出了一種基于遷移學習的卷積神經網絡服裝圖像分類方法,選取了VGG16、VGG19、Inception_v3等6種經典的卷積神經網絡在Deep Fashion數據集上進行試驗,結果表明,該方法能夠提高模型的分類精度和時效性。

為了提高服裝圖像分類的準確率,提出了一種基于VGG16和遷移學習的服裝圖像分類方法,使用在ImageNet數據集上進行預訓練的VGG16網絡,然后采用遷移學習的方法,將模型遷移到對服裝圖像分類的問題中,并對網絡進行微調,實現更高的準確率。

1 卷積神經網絡VGG16

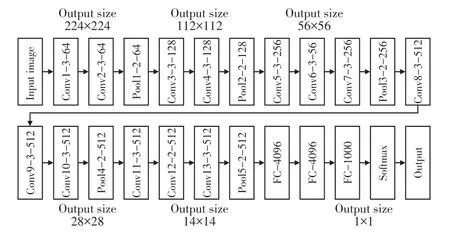

VGG16 是牛津大學在2014 年提出的一個模型[5],它是一個比Alex Net網絡更深層次的網絡,在對圖像進行識別與分類的時候,可以更準確地表達數據集的特征。VGG16的基本結構包括輸入層、卷積層、池化層、全連接層和輸出層,卷積層利用卷積核進行卷積操作,提取輸入圖像的特征;池化層進行特征降維,降低網絡復雜度,最后的全連接層和輸出層對結果進行分類,VGG16網絡架構如圖1所示。

圖1 VGG16網絡結構及參數

圖像經過預處理后進入卷積層,卷積層輸入的圖像尺寸為224×224×3,在第一次卷積層時經64個3×3的卷積核作兩次卷積后尺寸變為224×224×64,池化層對輸入的圖片進行壓縮,池化后的尺寸為112×112×64,接著繼續作卷積以及池化操作,后面幾層卷積核的數量分別為128、256、512、512,最后得到7×7×512的特征圖輸入到全連接層。與Ale×Net網絡不同的是VGG16使用的是三個3×3的卷積層,一方面,用三個非線性單元代替前一個單元,使決策函數更具判別性;另一方面,這樣可以減少訓練參數。

2 基于VGG16和遷移學習的服裝圖像分類

2.1 數據增強

在神經網絡中,訓練過程中分配的數據集是決定神經網絡性能的因素之一,當分配的數據集數量較少時,此時神經網絡的精度要低于使用大量數據集訓練的神經網絡。因此需要對現有的數據集進行數據增強,以增加多樣性。數據增強是一種重要的圖像預處理技術,主要用來產生更多的訓練數據以及減少模擬過擬合[6]。數據增強可以表示為:

其中X 為原始訓練集,Y 為X 的增廣集,通過數據增強后的訓練集可以表示為:

其中X'包含原始訓練集和經過數據增強后得到的數據集。

數據增強的方式主要有翻轉、平移、旋轉、噪聲注入等,考慮到服裝圖像的特性,本文主要采用水平翻轉和注入高斯噪聲兩種數據增強方式。

2.1.1 翻轉

在對圖像的處理中,對圖像進行翻轉是最常用的方法之一,這種增強是最容易實現的,并且已經證明在CIFAR-10和ImageNet等數據集上很有用。翻轉分為水平翻轉與垂直翻轉,較為常用的是水平翻轉,水平翻轉一般不會大幅度改變檢測目標的整體結構。對圖像進行水平翻轉操作,效果圖如圖2所示。

圖2 水平翻轉

2.1.2 噪聲注入

訓練神經網絡時,如果數據集比較少,往往會出現過擬合,因此可以通過在訓練期間添加噪聲提高模型的泛化能力和容錯率。噪聲注入就是在原圖中引入噪聲,生成新的圖片,Moreno-Barea等對UCI存儲庫[7]中的9個數據集注入噪聲進行測試,試驗結果證明向圖像中添加噪聲可以幫助神經網絡學習更穩健的特征。對圖像注入高斯噪聲,效果圖如圖3所示。

圖3 加入高斯噪聲

2.2 遷移學習

VGG16網絡在圖像分類中具有較好的分類能力,但在模型訓練過程中耗時較長,在小數據集中獲得的準確率不高,而遷移學習的應用可以有效地解決這一問題。

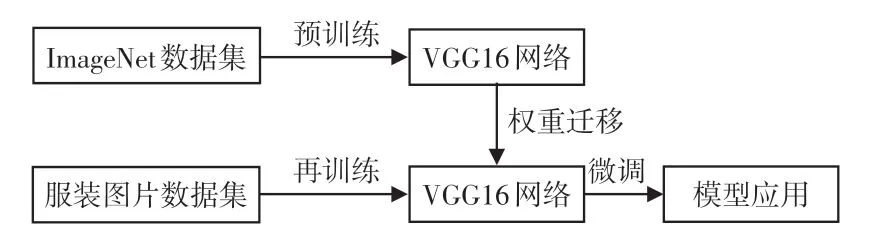

遷移學習(Transfer Learning)是機器學習領域的一個重要分支,其工作原理是在ImageNet這樣的大數據集上訓練網絡,然后在新的分類任務中使用這些權重作為初始權重,簡單來說就是把已訓練好的模型的參數遷移到新的模型上來幫助訓練新模型。采用遷移學習的方法可以減少對數據的依賴,提高模型的泛化能力。遷移學習的過程如圖4所示。

圖4 遷移學習過程

文中使用的遷移學習模型分為兩部分:預訓練網絡和遷移網絡。預訓練模型的參數從ImageNet數據集中獲取,然后遷移到服裝圖像分類任務中。預訓練模型的網絡層主要用于特征提取和數據獲取,幫助訓練收斂,減少訓練時間。

2.3 VGG16網絡優化

雖然VGG16網絡模型具有識別準確的優點,但隨著網絡結構的加深,訓練過程中模型參數的數量和計算的復雜性也增加了,導致訓練時間長,訓練效率低。為了保持模型提取的主要特征,提高模型的訓練率,減少模型的訓練時間,主要采用以下方法對VGG16模型進行改進。

深層神經網絡的訓練過程中,隨著前一層參數的變化,每一層輸入的分布也會發生變化,訓練速度會變慢,并使訓練帶有飽和非線性的模型變得非常困難,而在網絡中加入BN(Bath Normalization)層可以解決這個問題[9]。

BN 層是一種規范化神經網絡的激活方法,該方法可以加快網絡的收斂速度,使網絡訓練變得容易。BN是對同一層的輸入信號進行歸一化,即對與每個神經元做歸一化處理,公式如式(2)所示。

3 試驗和分析

3.1 數據集

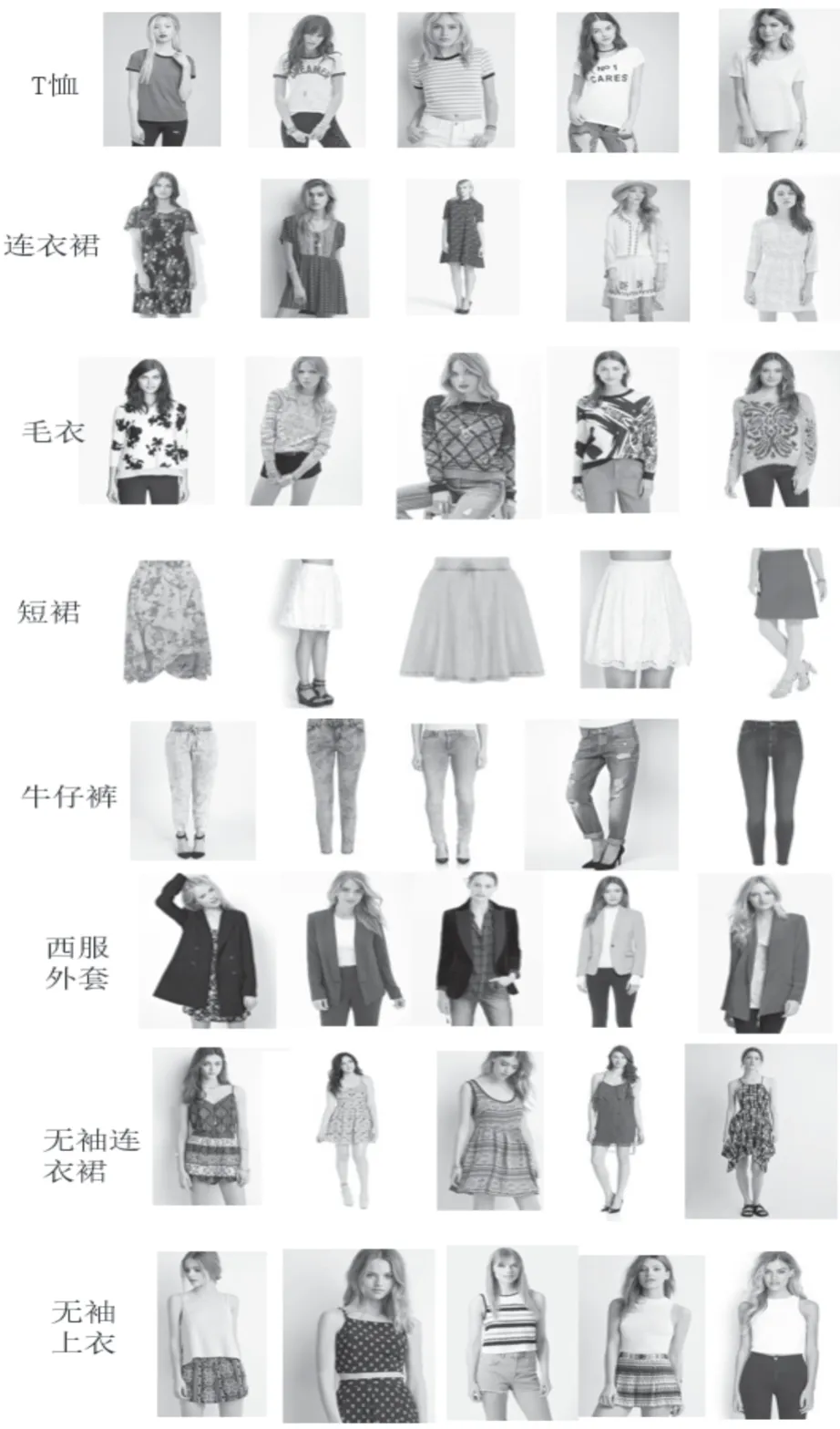

本試驗中使用的服裝圖片均來自香港中文大學的Deep Fashion數據集,從中選取了640張包含8類服裝類型的服裝圖片制作自己的數據集,包含的服裝類型標簽為T 恤、連衣裙、毛衣、短裙、牛仔褲、西服外套、無袖連衣裙、無袖上衣,每類各80張。為了減少訓練階段圖像集的過擬合,采用水平翻轉以及添加高斯噪聲對原始圖像進行處理,使得最后每種類型的樣本集擴展到240張,總樣本集為2 560張,其中80%的數據集被劃分到訓練集,用于模型訓練和參數學習,20%作為驗證數據集,用于對模型進行優化。隨機選取的部分數據集中的圖片如圖5所示。

圖5 試驗用到的數據集中的部分圖片

3.2 對比試驗結果

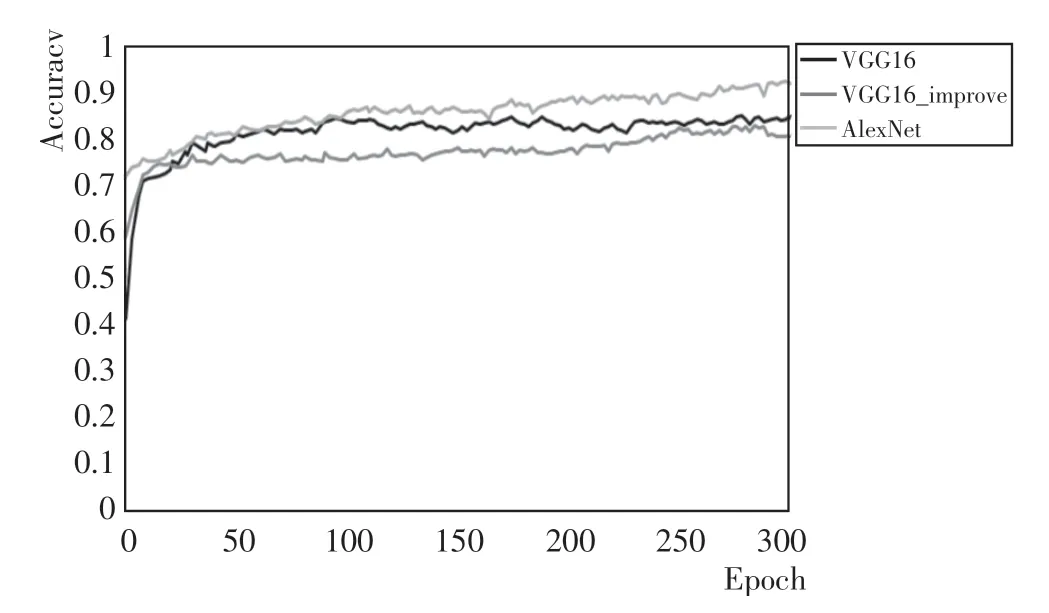

本次試驗主要是基于VGG16網絡模型,采用遷移學習的方法,利用在ImageNet上訓練完成的VGG16模型進行訓練。為了驗證提出的模型的有效性,對試驗中選取的VGG16網絡模型以及Alex Net模型進行對比,3個模型在文中的服裝圖像數據集中進行訓練,將訓練數據保存并繪制成如圖6所示的曲線。3個模型的平均精確度見表1。

表1 VGG16、VGG16_improve、Alex Net模型的平均精確度

圖6 VGG16、VGG16_improve、Alex Net模型精度比較

從圖6 中可以看出,Alex Net 模型與改進的VGG16模型初始精度較高,隨著訓練的開始,準確度開始呈現上升趨勢。進行遷移學習的VGG16_improve模型的準確率最高,其次是VGG16模型,Alex-Net模型的準確度最低。從表1 中可以看出,未進行遷移學習的模型在數據集上的準確率低于90%,而進行遷移學習的VGG16_improve模型的準確率達到了93.02%。

3.3 測試結果

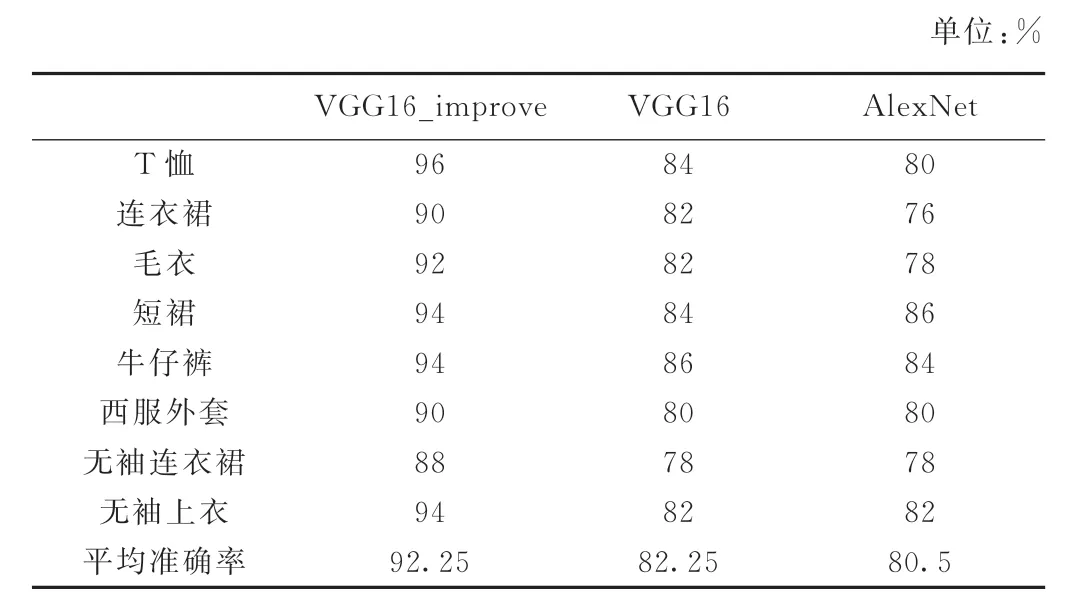

為了進一步測試該模型的準確率,從Deep Fashion數據集中另外選取400張圖片組成測試集,每類圖片50張,將測試集分別用VGG16_improve、VGG16、Alex Net進行測試,測試結果見表2。從表中可以看出,VGG16_improve模型的泛化能力在3個模型中是最好的,平均準確率達到了92.25%。

表2 不同網絡模型對不同類別的分類的準確度

從表2 中我們可以看出,在8 類服裝圖像中,VGG16_improve均取得了最好的分類準確率,其中有7類服裝圖像的分類準確度都達到了90%以上。VGG16與Alex Net兩個模型中,分類效果較好的是VGG16模型,有四個類別的分類準確度都比Alex Net模型高,另外有三類服裝圖像的分類準確率表現相當。

4 結語

針對傳統服裝圖像分類方法效率低、準確度不高的問題,提出了一種基于VGG16和遷移學習的服裝圖像分類方法。用遷移學習的方法把在ImageNet數據集上訓練的VGG16網絡遷移到自己的數據集上進行微調,并通過數據增強、在網絡中添加BN 層來防止模型過擬合,提高模型的泛化能力。通過對比試驗表明,文中提出的模型的平均準確率達到93.02%,能夠對服裝圖像進行有效分類。