基于混合生成對抗網絡的多視角圖像生成算法

衛 星 李 佳 孫 曉 劉邵凡 陸 陽

多視角圖像生成指的是基于某個視角的圖像生成其他視角的圖像,該問題在實際生活中具有很多應用,例如:電商網站上商品的多視角展示、虛擬現實中的目標建模和和數據集擴充等.目前多視角圖像生成已經吸引了來自計算機視覺、虛擬現實等眾多領域研究人員的興趣,并取得了一定的進展[1?5].

早期工作中,研究人員嘗試使用變分自編碼器(Variational autoencoder,VAE)[6]生成多視角圖像.變分自編碼器采用變分推斷和深度表示學習來得到一個復雜的生成模型,從而擺脫了傳統耗時的采樣過程.但變分自編碼器并不能很好地補充生成圖像中的細節.此外,研究人員[7?8]還嘗試先建立目標的3D 模型,再生成目標視角的圖像,但這種方法的靈活性較弱,只適合于合成椅子、杯子等簡單物體的圖像.

近年來,有研究人員提出使用生成對抗網絡(Generative adversarial network,GAN)[9]來生成多視角圖像.在文獻[4]中,研究人員將變分自編碼器與生成對抗網絡相結合,提出了一種面向服裝的多視角圖像生成模型VariGANs.VariGAN 模型將圖像生成分為兩步,采用由粗到精的方式生成高分辨率的多視角圖像,本文模型也參考了這種由粗到精的生成方式.但VariGAN 模型局限于服裝的多視角圖像生成,并不能有效遷移至其他領域.

在文獻[2]中,研究人員嘗試在圖像生成中引入語義指導,提出了兩種多視角圖像生成模型X-Fork和X-Seq.這兩個模型將已知視角的圖像與目標視角的語義分割圖共同輸入模型,填補了生成圖像中的語義結構,使得生成的圖像更加真實.受到文獻[2]中工作的啟發,文獻[5]中的研究人員提出了一種基于多通道注意力機制的SelectionGAN 模型.SelectionGAN 模型將語義生成空間進一步擴大,模型通過參考生成的中間結果,進一步完善了圖像中的語義細節,在衛星圖與地面圖的翻譯任務中取得了很好的成績.但以上的工作對于多視角生成任務中其他場景的兼容性較差,因為并不是所有場景下都有充足的語義分割圖來進行訓練模型.

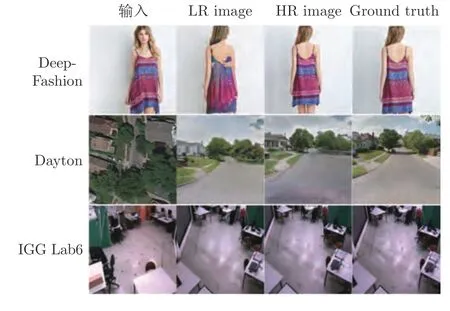

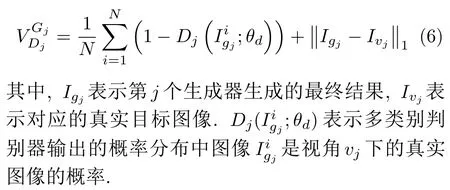

為解決上述問題,本文提出了一種基于混合生成對抗網絡的多視角圖像生成模型ViewGAN,該模型可以靈活遷移至多視角生成任務中的各個場景.ViewGAN 包含多個生成器和一個多類別判別器,每一個生成器負責生成某一視角的圖像.如圖1 所示,模型分兩步生成圖像:1) 模型運用粗粒度模塊(Coarse image module) 生成低分辨率(Low resolution,LR)下的目標圖像;2) 在低分辨率目標圖像的基礎上,模型運用細粒度模塊(Fine image module)完善圖像的語義結構,生成高分辨率(high resolution,HR)下的目標圖像.

圖1 本文模型ViewGAN 在DeepFashion、Dayton 和ICG Lab6 數據集上的測試樣例Fig.1 Examples of ViewGAN on three datasets,i.e.,DeepFashion,Dayton and ICG Lab6

本文的ViewGAN 模型與以往工作的不同之處在于:1) ViewGAN 包含多個生成器和一個判別器,每一個生成器負責生成某一視角的圖像,這保證了ViewGAN 模型可以靈活遷移至各種多視角生成任務中,甚至還可以運用到圖像翻譯的其他領域,例如風格轉換等;2) 為了加強圖像生成過程中的語義約束,本文使用蒙塔卡羅搜索方法(Monte Carlo search,MCS)[10]對低分辨率目標圖像進行多次采樣,并根據采樣結果計算相應的懲罰值,懲罰機制可以迫使每個生成器生成語義更加豐富的圖像,避免出現模式崩塌(Mode collapse)[11];3) 模型中的多類別判別器使每個生成器更加專注于生成它們指定視角的圖像,避免生成與其他視角相似的圖像,從而進一步完善了圖像的語義結構;4) 本文將ViewGAN模型與目前主流的圖像生成模型(例如:Pix2Pix[12],VariGAN[4],X-Fork 和X-Seq[2],SelectionGAN[5])進行了對比,并在3 個公開數據集上進行了大量的實驗,實驗結果表明:本文模型在3 個數據集上都取得了最好成績,這表明了本文模型的靈活性和生成圖像的高質量.

綜上所述,本文的主要貢獻總結如下:

1) 提出了一種基于混合生成對抗網絡的多視角圖像生成模型ViewGAN,該模型包括多個生成器和一個判別器,采用由粗到精的方式生成不同視角下的高質量圖像.

2) 提出了一種基于蒙特卡洛搜索的懲罰機制來加強圖像生成過程中的約束,這使得每個生成器能夠獲得更充足的語義指導,在對應視角的圖像中增加更多的語義細節.

3) 在3 個數據集上與目前的主流模型進行了大量的對比實驗,實驗結果證明了ViewGAN 在各種場景下的有效性與靈活性.

1 相關工作

1.1 圖像生成

隨著深度學習技術的發展,圖像生成已經變成了一個熱門的話題.變分自編碼器(VAE)[6]是一種基于概率圖模型的生成模型.在文獻[13]中,研究人員提出了一種可由視覺特征生成圖像的Attribute2Image 模型,該模型通過合成前景和背景來建模圖像.之后研究人員[14]嘗試在VAE 中引入注意力機制,提出了一種DRAW 模型,該模型在一定程度上提升了圖像的質量.

近年來,研究人員在采用生成對抗網絡[9]在圖像生成方向取得了不錯的成績,生成器被訓練生成圖像來欺騙判別器,判別器被訓練區分真實圖像和虛假圖像.之后大量基于GAN 的變體相繼提出,例如條件生成對抗網絡(Conditional GANs)[15]、Bi-GANs[16]、InfoGANs[17]等.GANs 還可以基于標簽[15],文本[18?19]或者圖[12,20?22]來生成圖像.

但上述模型生成的圖像普遍存在模糊、失真等問題,模型并沒有學會如何生成圖像,而是簡單地重復訓練集中圖像的內容.本文模型也是一種基于輸入圖像的條件生成對抗網絡,但本文模型憑借新穎的懲罰機制引入了更充足的語義指導,進一步完善了圖像的語義結構,在一定程度上克服了圖像失真的問題.

1.2 多視角圖像生成

早期的研究人員通過對物體進行3D 建模來合成不同視角的圖像[7?8,23].在文獻[8]中,研究人員提出一種3D?2D 映射機制,從而使模型可以從2D 數據中學習到3D 特征.之后有研究人員[23]提出一種3D-GAN 模型,該模型可以依據復雜的概率空間生成3D 物體.

在文獻[2]中,研究人員嘗試使用圖像翻譯的方法進行多視角生成,使用條件生成對抗網絡在衛星圖-街景圖轉換任務中取得了不錯的成績.之后在文獻[4]中,研究人提出了一種面向服裝的多視角圖像生成模型VariGANs.VariGAN 模型將圖像生成分為兩步,采用由粗到精的方式生成高分辨率的多視角圖像.受到上述工作的啟發,文獻[5]中的研究人員提出了一種基于多通道注意力機制的SelectionGAN 模型.SelectionGAN 模型將語義生成空間進一步擴大,模型通過充分參考生成的中間結果,進一步完善了圖像中的語義細節,在衛星圖與街景圖的翻譯任務中取得了很好的成績.

但上述模型對于數據的要求極為嚴格,模型需要大量的數據或者輔助的語義分割圖進行訓練,這大大限制了模型的靈活性和兼容性.為解決這個問題,本文提出了一種基于混合生成對抗網絡的多視角圖像生成模型,本文模型包括多個生成器和一個判別器,這使得模型可以同時訓練生成多個視角的圖像.大量實驗結果證明,在不需要大量的數據或者語義分割圖輔助訓練的前提下,本文模型在3 個數據集上都取得了不錯的成績.

2 GAN 的相關背景

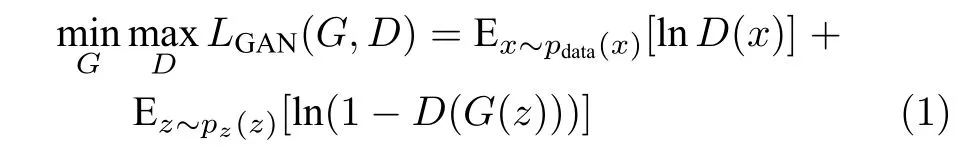

生成對抗網絡(GAN)[9]包括兩個對抗學習的子網絡:一個生成器和一個判別器,它們基于最大?最小博弈理論同時進行訓練.生成器G的目的在于將一個d維的噪聲向量映射成一幅圖像,并盡可能地使生成的圖像接近真實圖像;另一方面,判別器D用來鑒別圖像是來自于生成器的虛假圖像還是來自真實數據的真實圖像.整個生成對抗網絡的目標函數可表示為

其中,x表示由真實數據pdata采樣得到的真實數據,z表示從高斯分布pz采樣得到的d維噪聲向量.

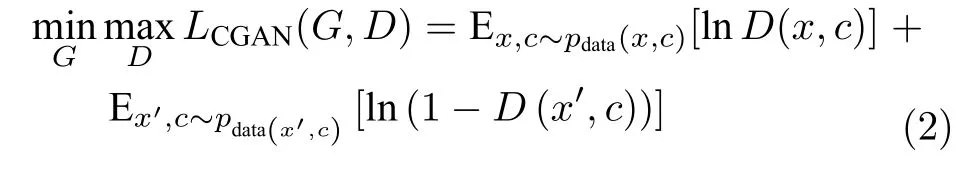

條件生成對抗網絡(Conditional GANs)[15]通過引入輔助變量來控制模型的生成結果.在條件生成對抗網絡中,生成器基于輔助信息生成圖像,判別器基于輔助信息和圖像(虛假圖像或者真實圖像)做出判斷.整個網絡的目標函數可表示為

其中,c表示引入的輔助變量,x′=G(z,c) 表示生成器生成的圖像.

除對抗損失外,以往的工作[20?21]還嘗試最小化真實圖像和虛假圖像之間的L1 或者L2 距離,這能夠幫助生成器合成與真實圖像更加相似的圖像.以往工作證明:相比于最小化L2 距離,最小化L1 距離更能夠幫助模型減少圖像中的模糊和失真,因此我們在本文模型中也使用了L1 距離.最小化L1 距離可表示為

因此這類條件生成對抗網絡的目標函數就是式(2)和式(3)之和.

3 ViewGAN 模型

3.1 任務定義

這里首先對多視角生成任務進行簡短的定義.假設有一個多視角集合其中vi對應某一具體視角,例如正面或者側面.一個物體在視角vi下的圖像定義為給定某個視角的圖像,多視角圖像生成任務是指生成其他不同視角的圖像,其中vj ∈V,ji.

3.2 整體框架

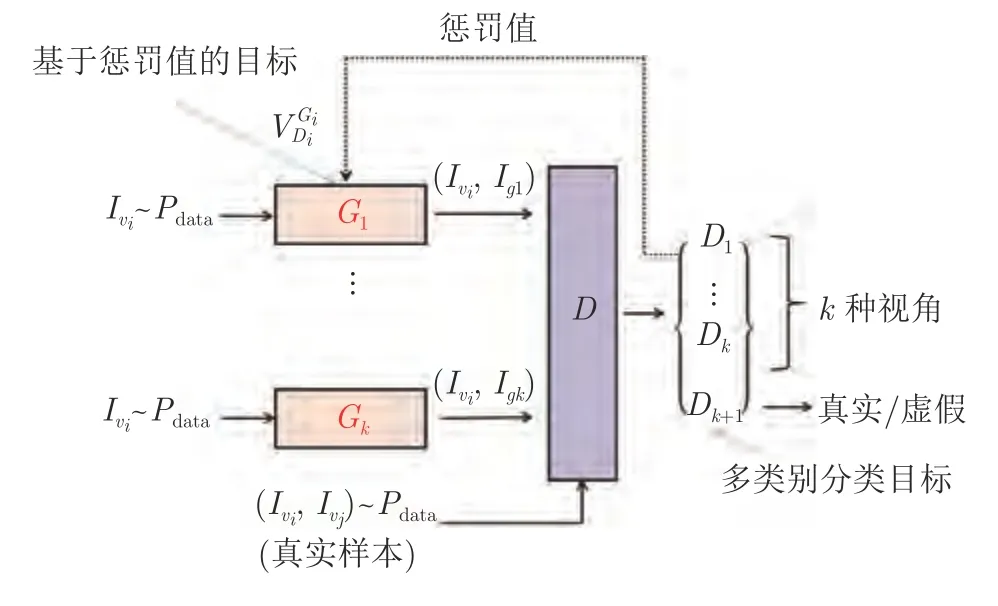

本文提出的ViewGAN 模型的整體框架如圖2所示.假設我們要生成k種不同視角的圖像(例如:正面、側面和背面三種視角),我們使用k個生成器和一個判別器,其中分別表示第i個生成器和判別器的網絡參數.表示從真實數據分布中采樣得到的某一視角的圖像,表示第i個生成器Gi生成的圖像.

圖2 ViewGAN 模型的整體框架Fig.2 The framework of ViewGAN

整個模型的訓練可以分為兩個對抗學習過程:生成器的學習和判別器的學習.第i個生成器Gi的目標是生成視角vi下的圖像,并使得生成的圖像能夠欺騙判別器.換句話說,生成器的目標在于最小化合成圖像與真實圖像之間的距離.與之相反,判別器的目的在于盡可能的區分k種視角下的虛假圖像和真實圖像,并針對虛假圖像計算出準確的懲罰值.

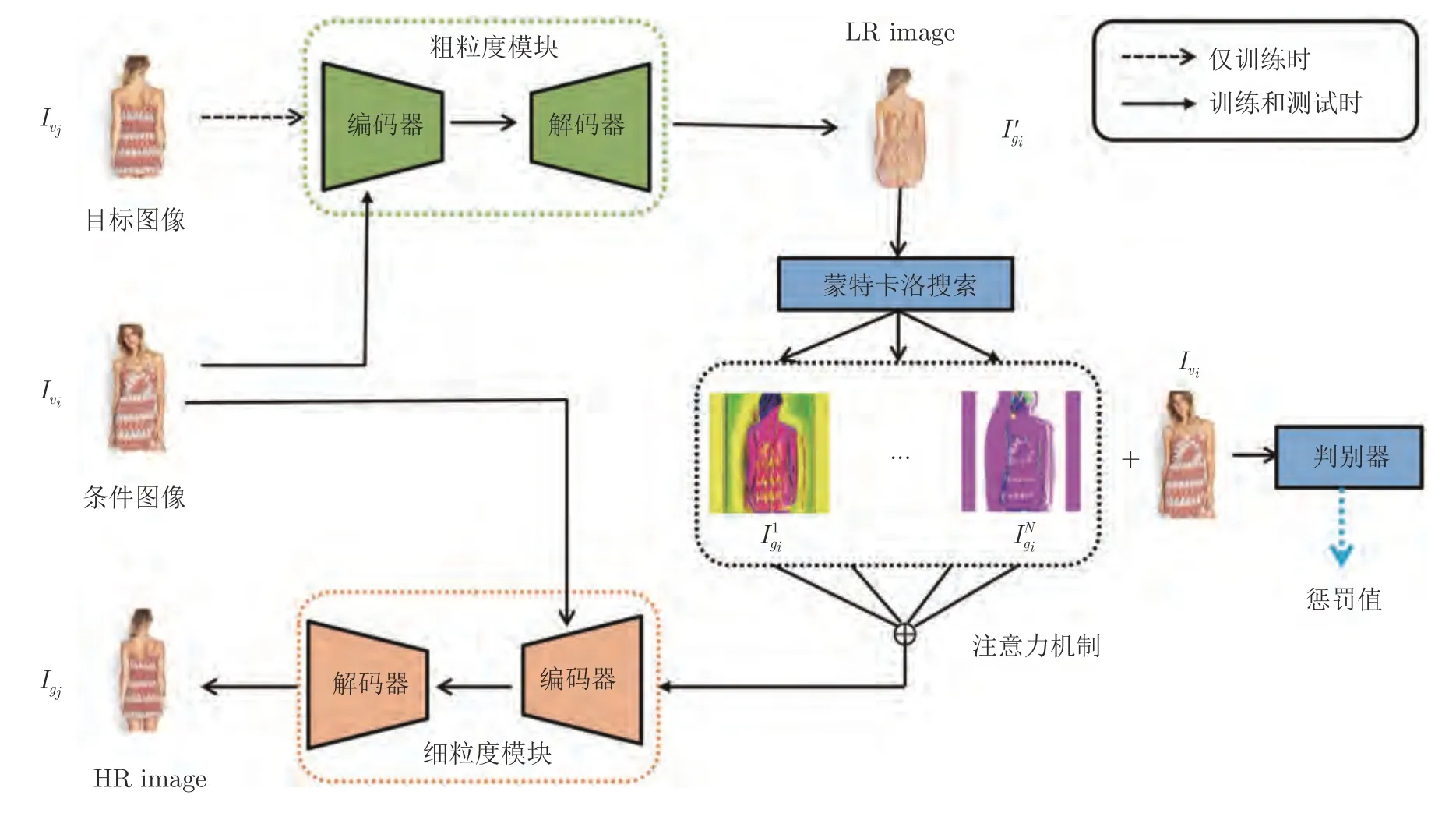

3.3 多粒度生成器

生成器的整體框架如圖3 所示,圖中展示的是第j個生成器.訓練時中生成圖像的過程分為3 步:1) 輸入已知視角vi下的圖像和目標視角vj下的圖像,生成器首先使用粗粒度生成模塊生成低分辨率的目標圖像2)采用蒙特卡洛搜索策略對低分辨率目標圖像進行N次采樣,從而得到N幅中間結果圖像;3) 引入注意力機制提取N幅中間結果圖像的特征,并將注意力機制的輸出與已知視角vi下的圖像輸入到細粒度生成模塊中,細粒度生成模塊生成最終結果,即高分辨率的目標圖像.

圖3 生成器 ( Gj) 的整體框架Fig.3 The framework of the generator Gj

3.3.1 懲罰機制

為加強圖像生成過程中的語義約束,進一步完善圖像中的語義細節,我們提出了一種基于蒙特卡洛搜索策略的懲罰值機制.它使混合生成對抗網絡中每個生成器更加專注于生成相應視角的圖像.

之后,我們將N張中間結果圖像和已知視角的圖像送入判別器,根據判別器的輸出結果計算懲罰值.計算過程可表示為

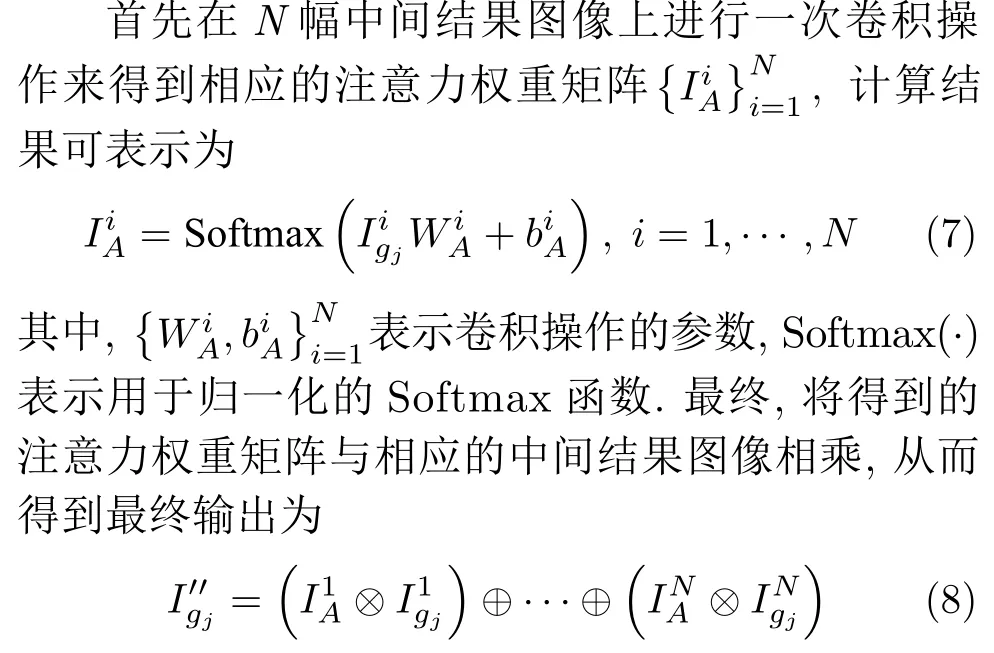

3.3.2 注意力機制

通過采樣得到N幅中間結果圖像后,我們希望參考中間結果圖像為下一步的生成提供充足的語義指導.因此我們提出一種基于多通道的注意力機制,區別于以往工作中合成圖像僅從RGB 三通道空間中生成的方法,我們將采樣得到的N幅中間結果作為特征集來構建更大的語義生成空間,模型通過參考不同通道的信息來提取更加細粒度的信息.并將計算結果輸入到細粒度生成模塊中,從而得到高分辨率目標圖像.

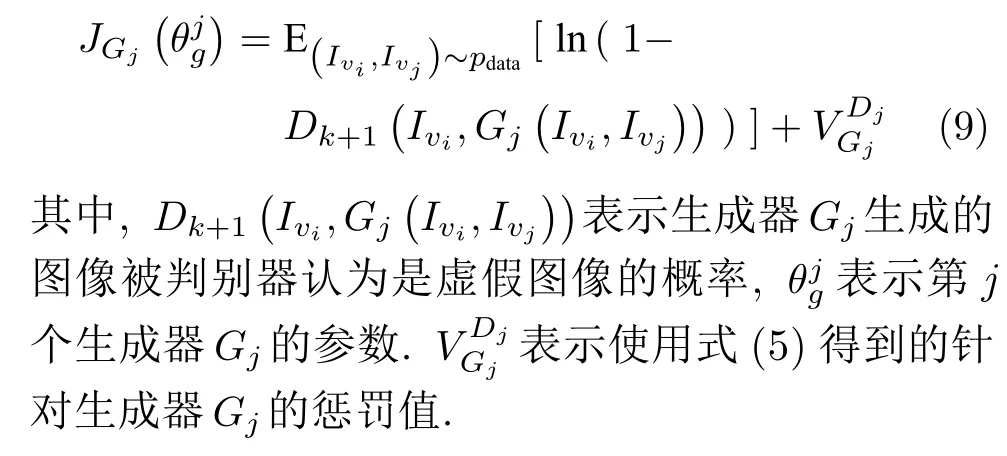

3.3.3 目標函數

綜上所述,生成器通過最小化以下目標函數來不斷優化

3.4 多類別判別器

參考文獻[24]中有關半監督學習的工作,我們使用了一種多類別判別器用來區分不同視角下的真實圖像和虛假圖像,判別器的輸入包括已知視角的圖像和目標視角的圖像.

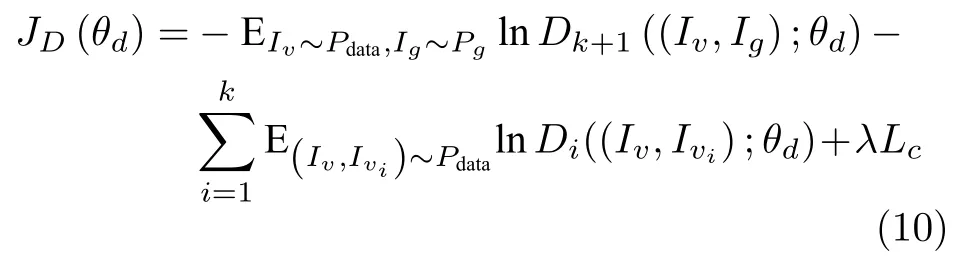

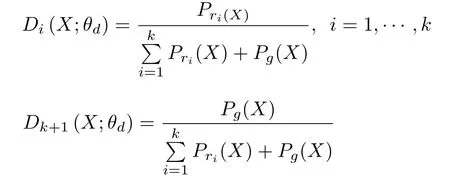

3.4.1 目標函數

模型中包含k個生成器,每個生成器負責生成某一視角下的圖像,所以判別器要輸出k+1 種類的概率分布.前k個類別的概率值Di(i ∈1,···k)分別表示輸入圖像屬于第i種視角的概率,第k+1個類別的概率值表示輸入圖像是虛假圖像的概率.判別器通過最小化以下目標來進行優化

其中,Pg表示生成器生成的圖像,Pdata表示真實數據分布.Iv表示任一視角的真實圖像,Ig表示以Iv作為輸入時生成器生成的圖像,表示視角vi下的真實圖像,Di(·) 表示判別器輸出結果中第i個類別的概率值,Lc表示類內損失.下面詳細闡述類內損失的含義,參數λ用于控制兩種損失的平衡.

下面詳細論述多類別判別器是如何協助每個生成器更專注于生成指定視角的圖像,避免出現圖像模糊或者模式崩塌現象.為了便于描述,這里使用X表示采樣得到的圖像對,例如虛假圖像對(Iv,Ig)或者真實圖像對

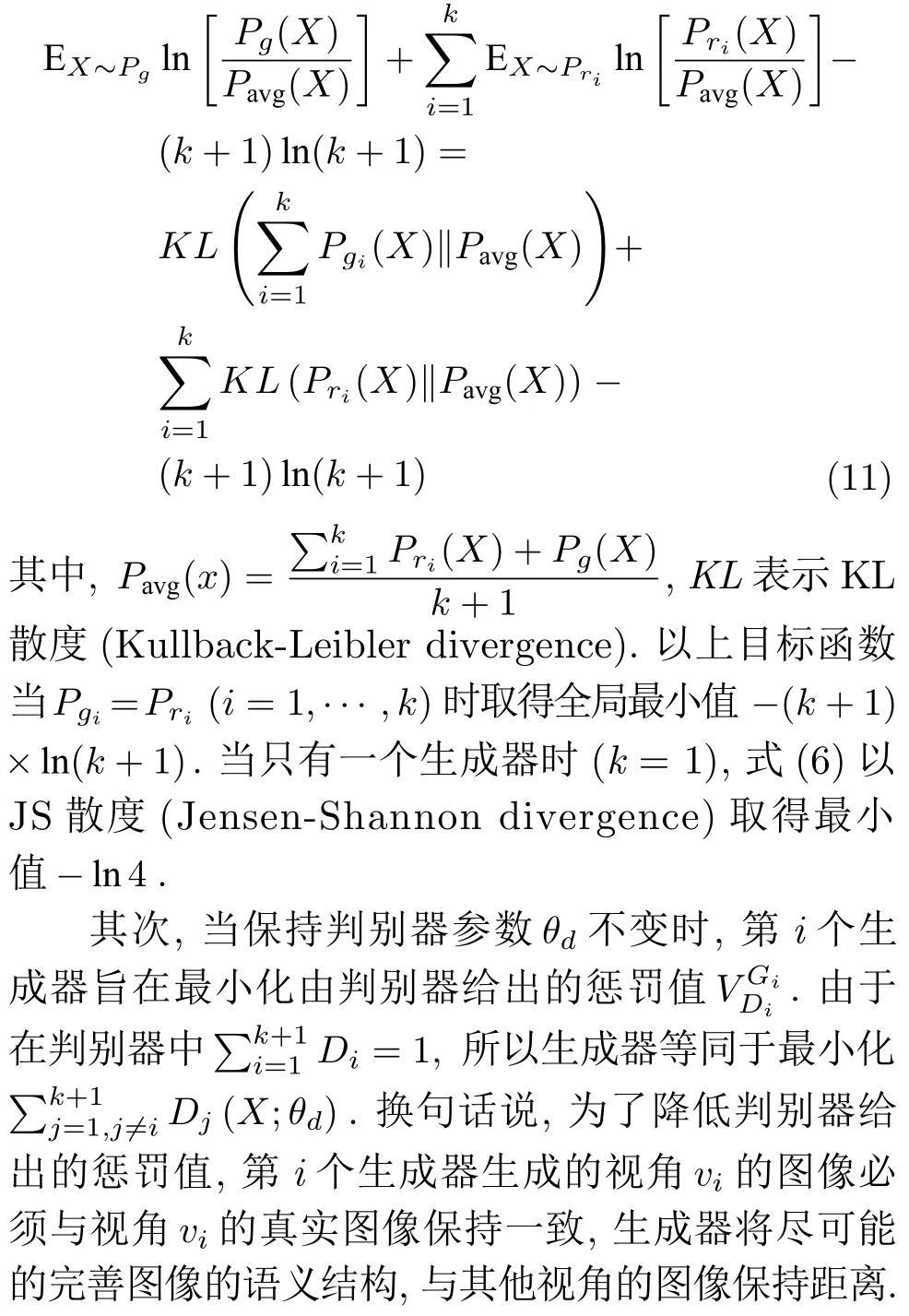

首先,理想情況下第i個生成器可以學習到視角vi下圖像的真實分布.判別器的目標函數如式(9)所示,且=1,Di ∈[0,1],?i.由此可以得到判別器學習到的最優分布:

基于式(5),生成器的目標是最小化以下等式:

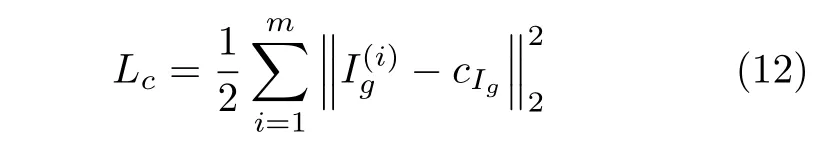

3.4.2 類內損失

判別器要對多個生成器生成的視角圖像進行判斷,而每個視角的圖像之間具有一定的重合部分,僅采用GAN 網絡對抗損失進行監督學習容易導致圖像的視角類別預測錯誤,因此我們在對抗損失的基礎上引入了類內損失用于減小類內特征差異,并增加類間差異.類內損失可表示為

其中,δ(·) 是條件表達式,當vi=vj即當前圖像屬于視角vj時,條件δ(vi=vj) 為1,其他情況下條件δ(vi=vj)為0.

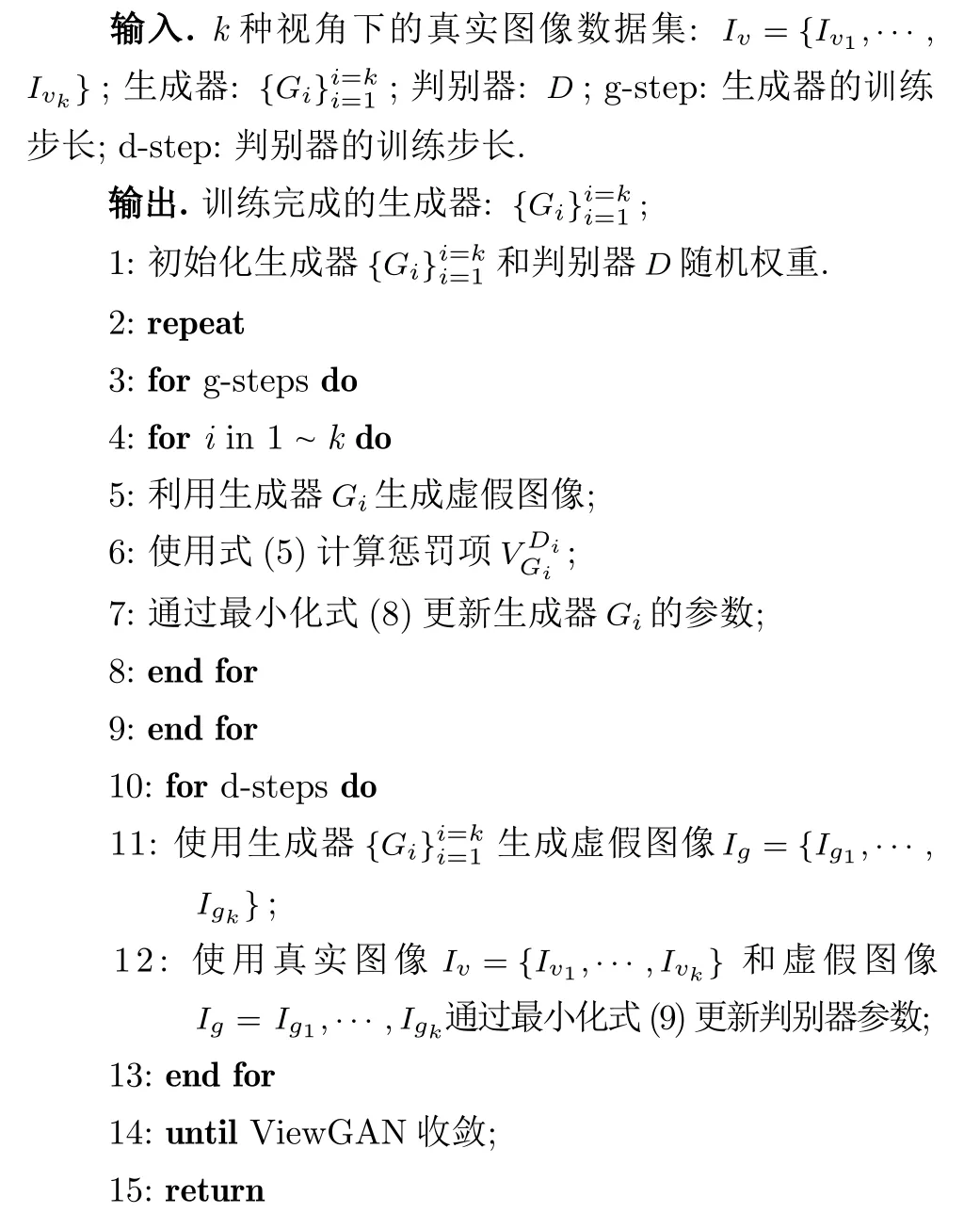

訓練時將k個生成器與多類別判別器進行對抗學習,并交替訓練它們,優化算法如算法1 所示.

算法1.ViewGAN 的對抗學習過程

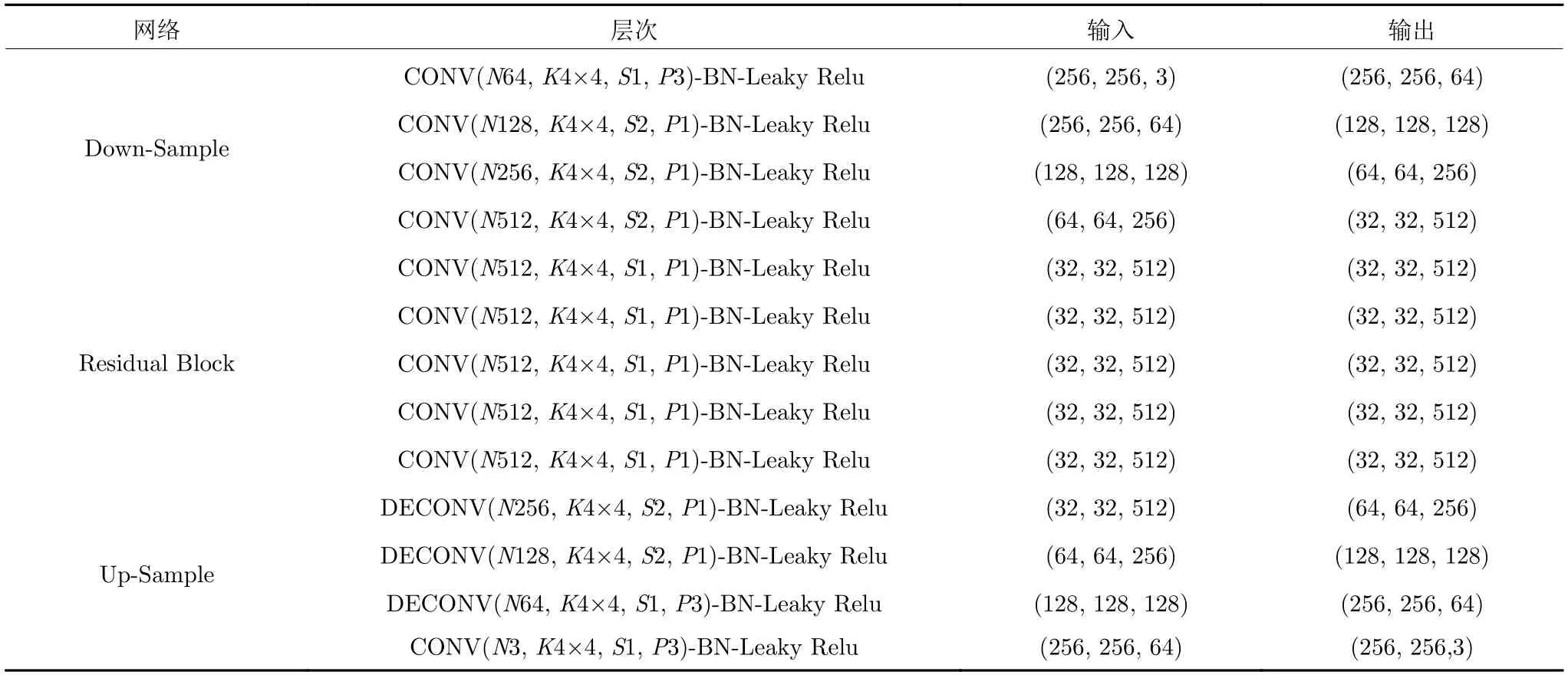

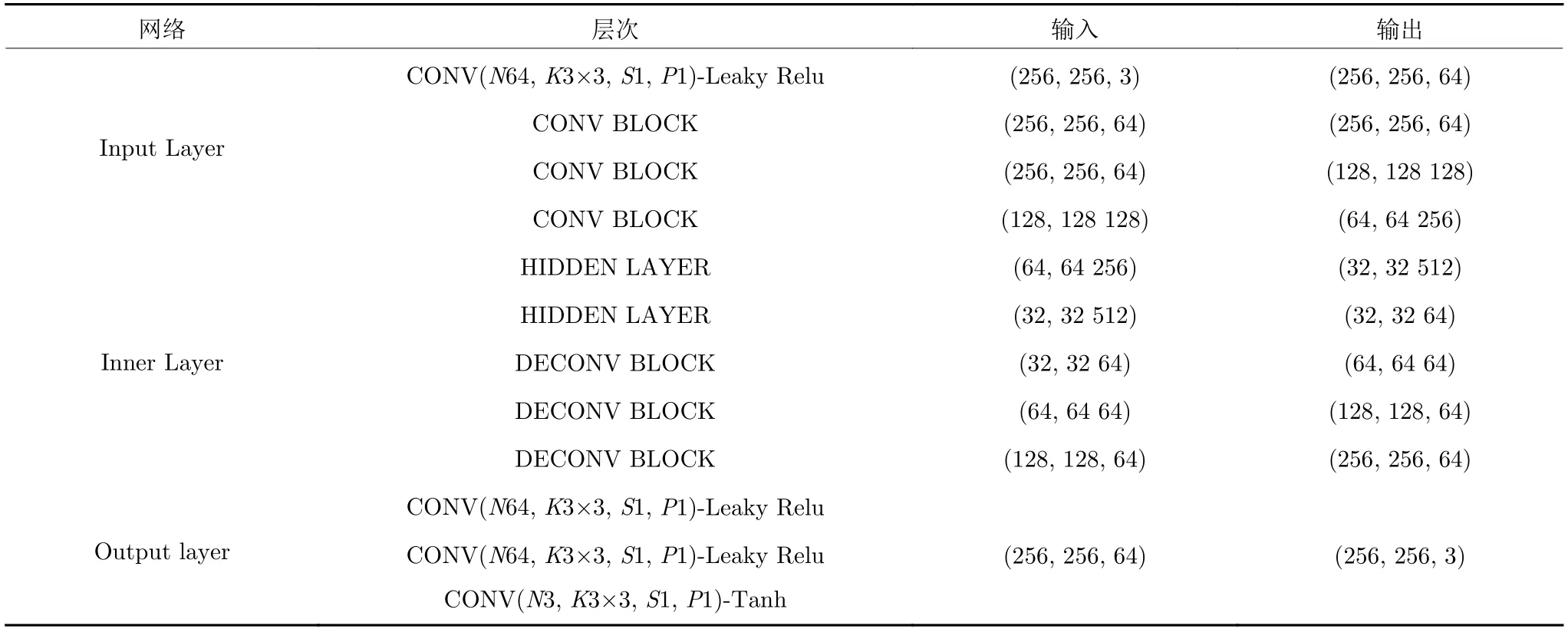

3.5 網絡結構

對于多視角生成問題,輸入和輸出之間存在大量底層特征共享,應該直接將特征在網絡之間傳遞.為了解決網絡特征傳遞問題,我們采用U-Net[25]作為生成器和判別器的基礎結構并使用Conv-BNReLu 模塊作為中間結構,網絡結構如表1 和表2所示.其中CONV BLOCK 卷積塊由3 個串聯的卷積核大小為3 的卷積層和濾波器大小為2 的平均池化層組成,其中卷積層的步長等于1 并采用1 個像素填充;DECONVBLOCK 由2 個串聯的卷積核大小為3 的卷積層和濾波器大小為2 的上采樣層組成,卷積層的設置與CONV BLOCK 相同;HIDDEN LAYER 由1 個大小為3 的卷積核的卷積層組成.

表1 生成器網絡結構Table 1 Generator network architecture

表2 判別器網絡結構Table 2 Discriminator network architecture

U-Net 是一種在編碼器和解碼器之間具有跳躍連接的網絡,這種網絡結構允許更多的原圖像紋理的信息在高層特征層中進行傳播.對于每個生成器Gi,編碼器第一層卷積層濾波器大小為64,解碼器最后一層卷積層用于將通道數映射為輸出圖片通道數(彩色圖片為3 通道,黑白圖片為2 通道).除了編碼器的第一層卷積層,其余所有卷積層后都連接BatchNorm 層進行特征歸一化.

4 實驗與分析

4.1 數據集

1) DeepFashion[26].該數據集包含8697 幅服飾的多視角圖像,每件服飾具有三個視角:正面、側面和背面.從中挑選出6000 幅圖像作為訓練集,2000幅圖像作為測試集,圖像尺寸為256×256 像素.

2) Dayton[27].該數據集包含超過13 萬幅街道視角?鳥瞰視角的圖像,從中挑選出55000 幅圖像作為訓練集,5000 幅圖像作為測試集.圖像的原始尺寸為354×354 像素,我們將圖像尺寸調整為256×256 像素.

3) ICG Lab6[28].該數據集包含6 名人員的室內場景活動圖,共使用4 個不同方位的靜態攝像頭進行拍攝.從中挑選6000 幅圖像作為訓練集,1500幅圖像作為測試集.圖像的原始尺寸為1024×768像素,我們將圖像尺寸調整為256×256 像素.

4.2 基線模型

我們將本文模型與目前主流的多視角圖像生成、圖像翻譯模型進行對比.

1) Pix2Pix[12].采用對抗損失學習從x∈X到y ∈Y的映射,其中,x和y分別表示不同域X和Y中的圖像,在圖像翻譯任務上取得了較好成績.

2) X-Fork[2].與Pix2Pix 結構類似,生成器通過學習映射:G:{Ia}→{Ib,Sb}來生成多視角圖像.其中Ia,Ib分別表示視角a和視角b下的圖像,Sa表示視角b下的語義分割圖.

3) X-Seq[2].兩個CGAN(G1,G2)的組合模型,其中G1 合成目標視角的圖像,G2 基于G1 的輸出圖像合成目標視角的語義分割圖.兩個生成器之間的輸入?輸出依賴約束了生成的圖像和語義分割圖,有效地提升了圖像的質量.

4) VariGAN[4].變分自編碼器和GAN 網絡的組合模型,采用由粗到精的方法生成高分辨率的多視角圖像,在DeepFashion 等服飾數據集上取得了較好的結果.

5) SelectionGAN[5].在X-Seq 模型的基礎上引入了一種多通道注意力機制來選擇性地學習模型的中間結果,從而實現了一種由粗到精的級聯式語義指導,使合成圖像具有更豐富的語義細節.

4.3 定量評估

在定量實驗中,我們采用Inception score[24],Top-k預測準確率指標從高層特征空間的角度來評估合成圖像.此外,我們還采用一些像素級別的相似度指標來衡量生成的圖像,包括:結構相似性(Structural similarity,SSIM)、峰值信噪比(Peak signal-to-noise ratio,PSNR)和SD (Sharpness difference).

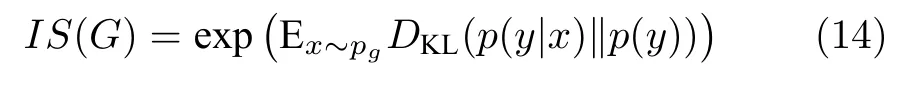

4.3.1 Inception score 和Top-k 預測準確率

1) Inception score 指標.Inception score (IS)是一種面向生成模型的常見定量指標,它可以衡量模型生成的圖像是否清晰、生成的圖像是否多樣.其計算式為

其中,G表示生成器,x表示生成的圖像,y表示合成圖像的預測標簽.

因為Dayton 數據集和DeepFashion 數據集中包含了ImageNet 數據集[29]中未標注的戶外物體類別和服裝類別,所以不能直接使用預訓練的Inception 模型.對于Dayton 數據集,使用在Places數據集[30]上訓練的AlexNet 模型[31]進行評分;對于DeepFashion 數據集,使用預訓練的PaperDoll[32]模型進行評分;對于ICG Lab6 數據集,采用在ImageNet 數據集上訓練的Inception 模型進行評分.

同時我們注意到:這些預訓練模型針對合成圖像輸出的置信度分數較為分散,合成圖像并沒有包含所有類別的目標.因此我們只在Top-1 和Top-5類別上計算Inception score,其中 “Top-1”表示每幅圖像的預測標簽中概率最大的k個標簽不變,其余標簽的概率進行平滑處理.

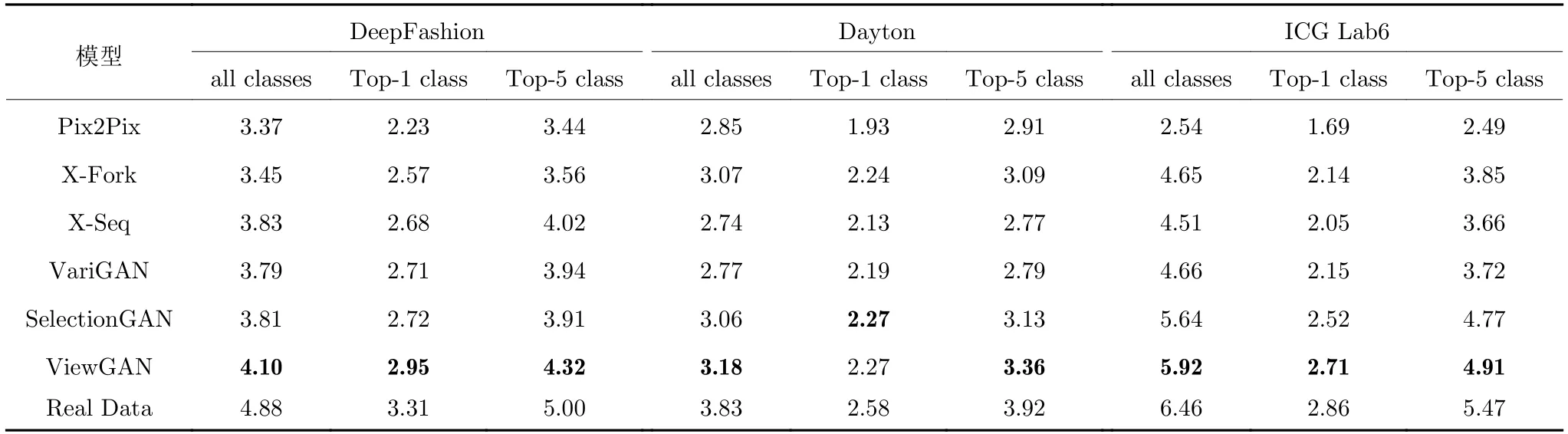

2) Inception score 評估結果.基于Inception score 的實驗結果如表3 所示.從實驗結果可以看出:本文模型ViewGAN在DeepFashion 數據集和ICG Lab6 數據集上均優于基線模型.其中Deep-Fashion 數據集的圖像風格、服裝樣式等變化較大,以往模型很難生成這種多樣性較強的圖像,而本文模型通過采用分布式生成的方法,使模型有足夠的內存來學習如何生成各種樣式的服裝以及同一服裝不同視角下的變化.ICG Lab6 數據集的圖像取自復雜的室內環境,對圖像分辨率的要求較高.以往模型缺乏對圖像細節的補充,導致生成模糊、失真的圖像,而本文模型采用懲罰機制加強了對圖像語義細節的約束,能夠生成更加清晰的高質量圖像.

表3 各模型Inception score 統計表,該指標越高表明模型性能越好Table 3 Inception score of different models (For this metric,higher is better)

同時我們注意到ViewGAN 在Dayton 數據集下Top-1 類別的得分僅次于SelectionGAN.這主要是因為Dayton 數據集中的多視角圖像是區別較大的戶外圖像,這種多視角圖像生成任務具有較大的難度,SelectionGAN 中引入了目標圖像的語義分割圖來輔助生成,本文模型卻沒有引入外部知識.因此本文模型生成的圖像具有一定的不確定性,從而導致圖像中存在模糊的區域,但ViewGAN 的得分與SelectionGAN 的得分很接近,這也表明了本文模型的潛力.

3) Top-k指標.此外,我們還計算了真實圖像和合成圖像的Top-k預測準確率.我們使用與Inception score 同樣的與訓練模型來獲得真實圖像的標注和合成圖像的預測標簽.實驗計算了Top-1 預測準確率和Top-5 預測準確率.每種準確率的計算方法有兩種方法:a)考慮所有的測試圖像;b)只考慮那些預測標簽概率值超過0.5 的測試圖像.

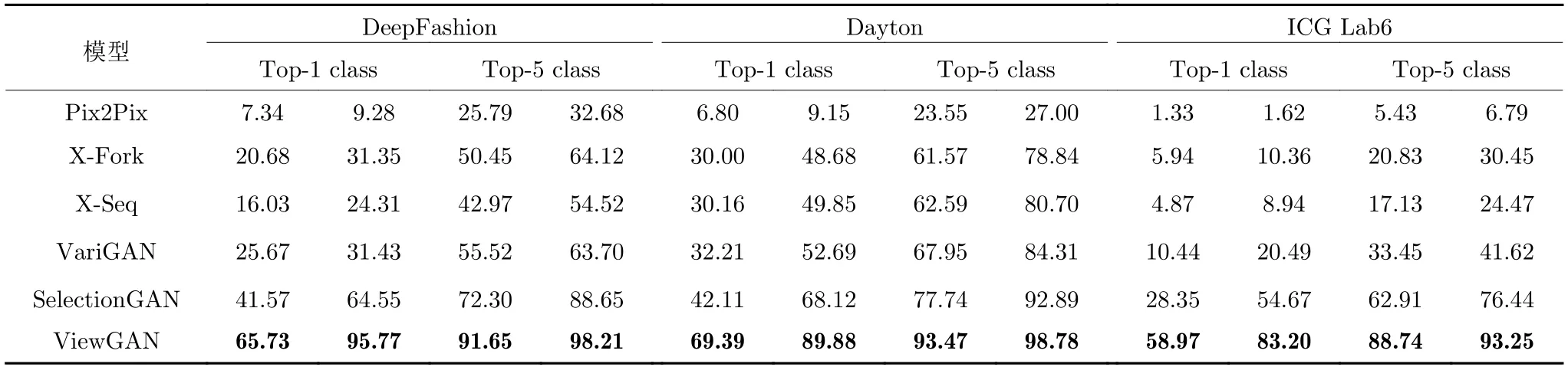

4) Top-k評估結果.基于Top-k的實驗結果如表4 所示.由實驗結果可知:本文模型在3 個數據集上的性能均優于基線模型,顯著提升了預測準確率.這說明本文模型生成圖像具有較高的清晰度、豐富的語義細節,在復雜多變的DeepFashion 數據集和Dayton數據集上表現出了較強的魯棒性.

表4 各模型Top-k 預測準確率統計表,該指標越高表明模型性能越好Table 4 Accuracies of different models (For this metric,higher is better)

值得注意的是,本文模型在ICG Lab6 數據集上的準確率要略低于在其他兩個數據集的準確率.這主要是因為ICG Lab6 數據集中的圖像包含較多小目標物體,這對合成清晰圖像來說本身就是一個很大的挑戰,因此以往模型最高只達到了76.44%的準確率.而本文模型引入基于蒙特卡洛搜索的懲罰機制,充分利用了模型的中間結果,保證了圖像具有更細致的語義細節,最高達到了93.25%的準確率.

4.3.2 結構相似性、峰值信噪比和Sharpness difference

1) 指標.參考文獻[33?34]中的工作,我們利用結構相似性、峰值信噪比和SD (Sharpness difference)指標來衡量合成圖像與真實圖像之間的像素級相似度.

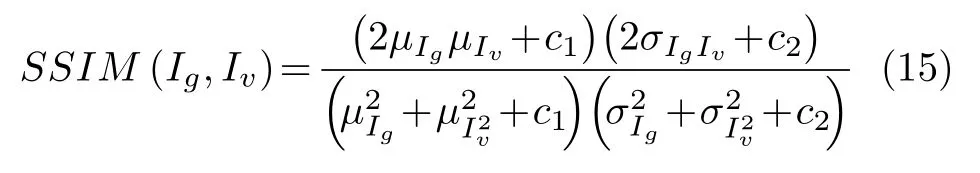

2) 結構相似性(SSIM).基于圖像的亮度、對比度等屬性評估圖像之間的相似度,其取值范圍為[?1,1],值越大則圖像之間的相似度越高.結構相似性的計算式為

其中,μIg,μIv分別表示合成圖像Ig和真實圖像Iv的均值,,分別表示圖像Ig和的標準差.c1,c2是為了避免分母為0 而引入的常數.

3) 峰值信噪比(PSNR).通過測量到達噪音比率的頂點信號來評估合成圖像相對于真實圖像的質量.峰值信號比越大,合成圖像的質量越高.峰值信噪比的計算式為

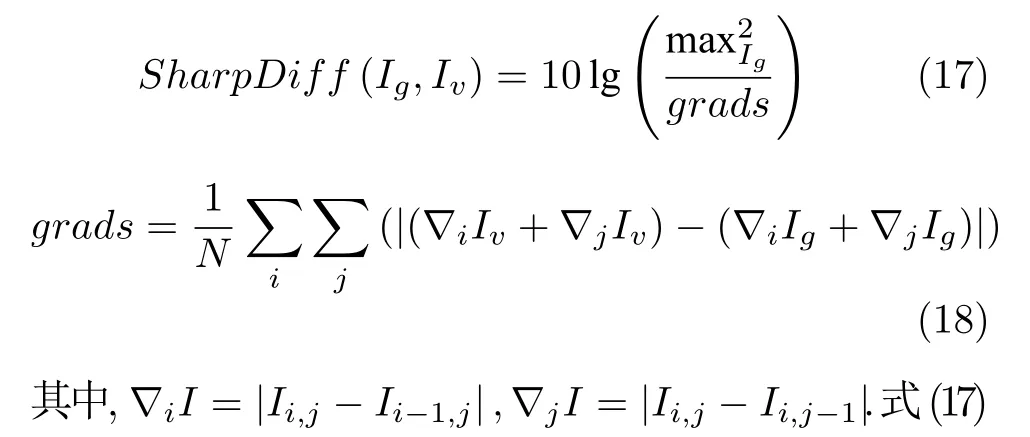

4) SD (Sharpness difference)測量圖像生成過程中清晰度的損失,為了計算合成圖像和真實圖像之間的清晰度差異,我們參考文獻[35]中的思路,計算圖像之間的梯度變化

中的SharpDiff可看作是梯度的倒數,我們希望圖像之間的梯度盡量小,所以SharpDiff就應該盡量大.

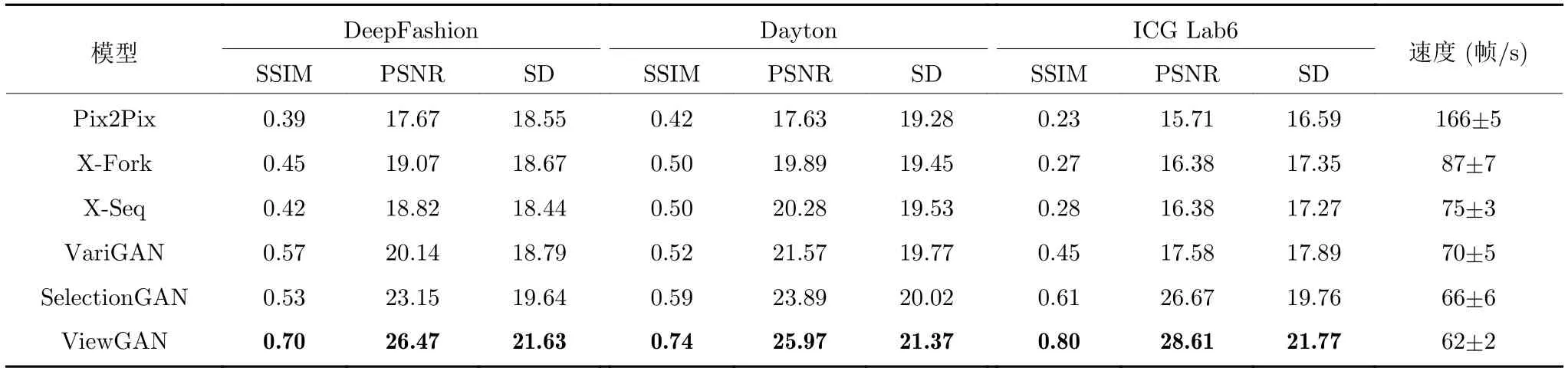

5) 結果.基于SSIM,PSNR,SD 的實驗結果如表5所示.由實驗結果可以看出:本文模型ViewGAN在3 個數據集上的得分均高于基線模型的得分.相比于目前主流的SelectionGAN 模型,本文模型ViewGAN 在ICG Lab6 數據集上的SSIM 分數提升了32.29%,SD 分數提升了10.18%,在DeepFashion數據集上的PSNR 得分提升了14.32%.

表5 各模型SSIM,PSNR,SD 和速度統計表,其中FPS 表示測試時每秒處理的圖像數量,所有指標得分越高表明模型性能越好Table 5 SSIM,PSNR,SD of different models.FPS is the number of images processed per second during testing(For all metrics,higher is better)

上述定量實驗結果證明:面向室內、室外等復雜環境,本文模型能夠學會如何生成高質量多視角圖像,而不是簡單地重復訓練集中的圖像.這種分布式的生成方式使每個生成器專注于學習固定視角的圖像,提出的懲罰機制能夠進一步完善圖像的語義細節,使得生成的圖像更加逼真,顯著地化解了圖像中的人工痕跡.

6) 速度對比實驗.為驗證各個模型在速度上的差異,我們在Dayton 數據集上對各個模型測試時的速度進行了對比實驗.實驗結果如表5 所示,從實驗結果看出:ViewGAN 的測試速度低于所有基線模型,這要是因為采用由粗到精的兩階段生成方法勢必會造成計算量的增加,此外蒙特卡洛搜索耗時較多.但事實上,ViewGAN 和SelectionGAN 的速度差距不大,且62 幀/s 可以滿足實際應用中的需要.

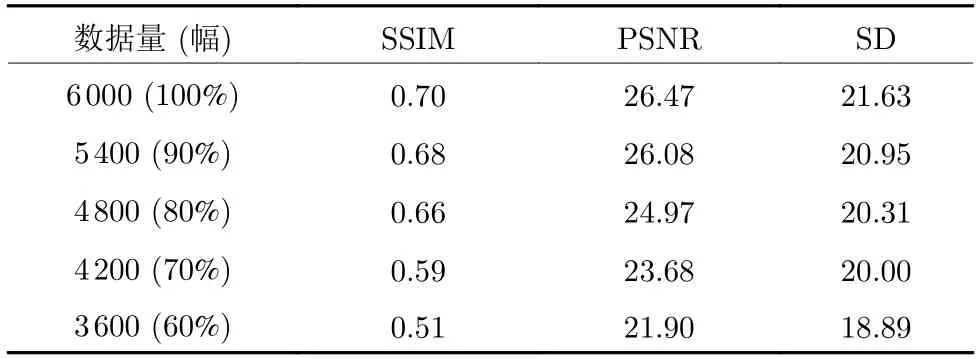

7) 最小數據量實驗.為了驗證訓練集規模對于模型性能的影響,我們在DeepFashion 數據集上對ViewGAN 的最小訓練樣本量進行了探究實驗.實驗結果如表6 所示,從實驗結果可以看出:隨著訓練集規模的縮小,ViewGAN 的性能下降較為緩慢.直至訓練集規模縮小至60%時,ViewGAN 在各指標上的得分才低于基線模型SelectionGAN 在完整數據集上的得分,這表明ViewGAN 具有較強的魯棒性,即使在小規模數據集上仍能學習到關鍵的特征信息,在一定程度上克服了以往模型泛化能力不強的缺點.

表6 最小數據量實驗結果Table 6 Minimum training data experimental results

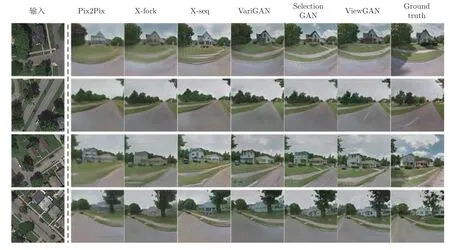

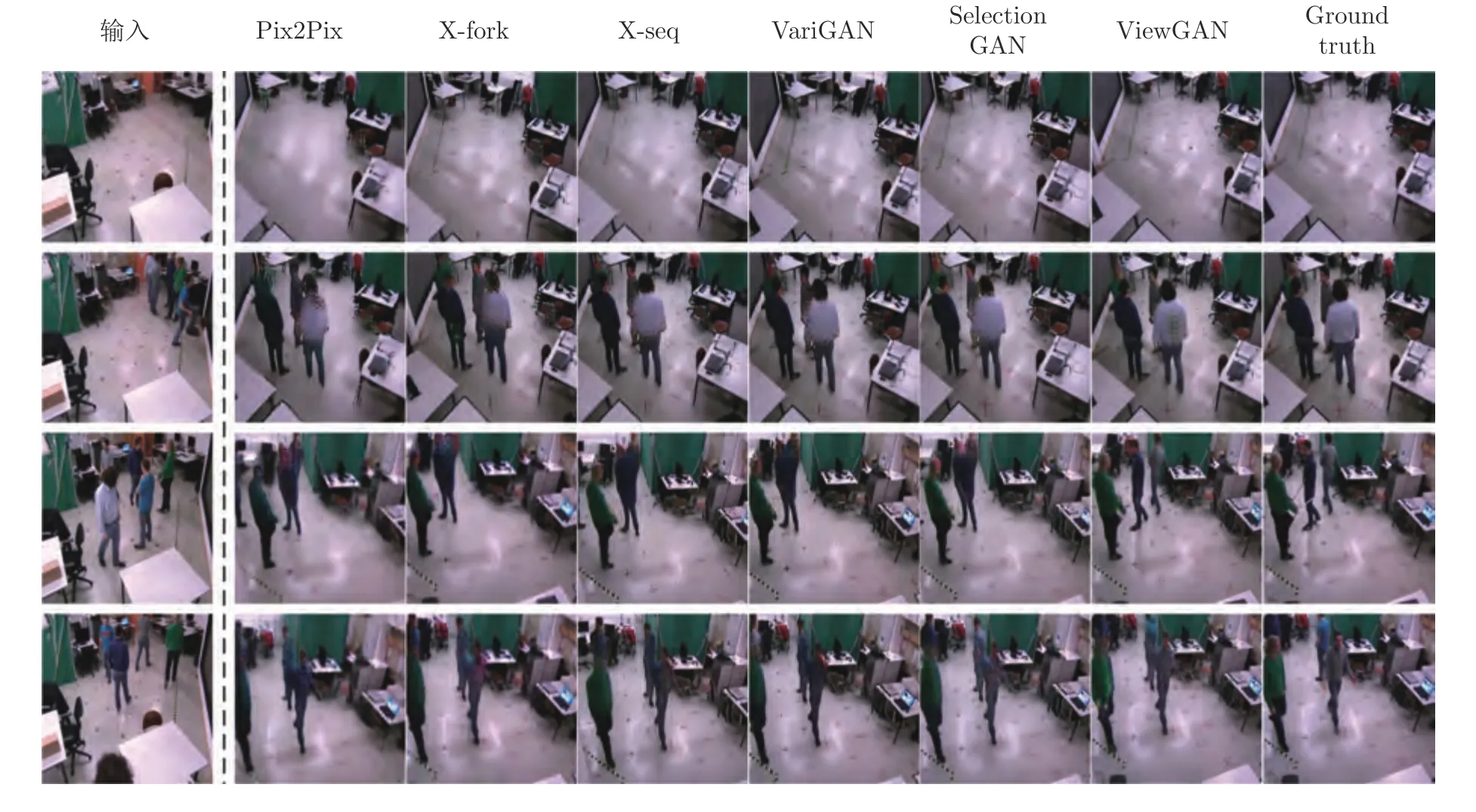

4.4 定性評估

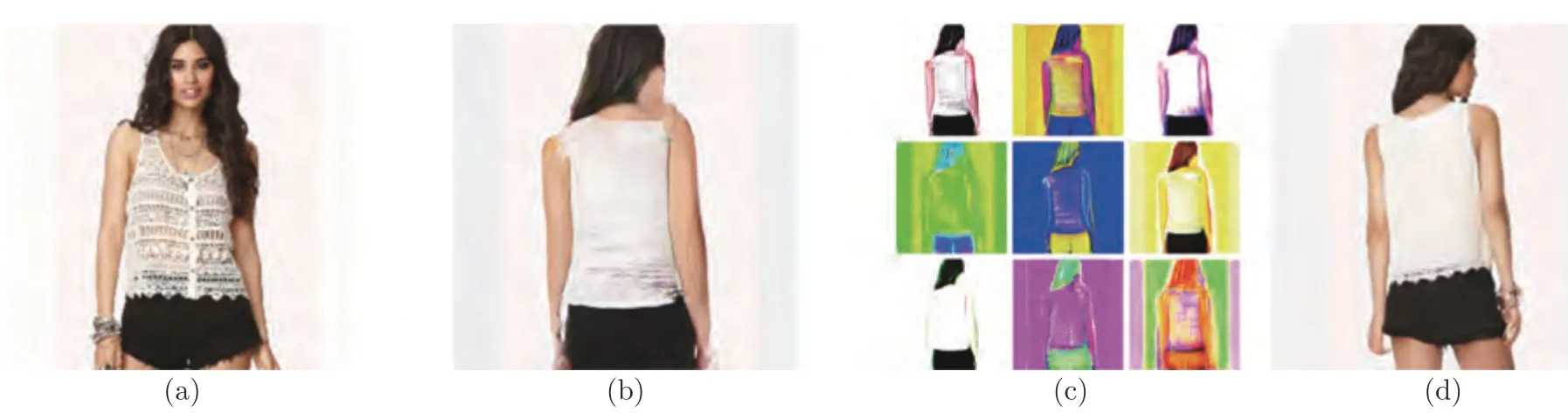

在3 個數據集上的定性評估結果如圖4~ 6 所示,測試圖像的分辨率均為256×256 像素.從實驗結果可以看出:本文模型ViewGAN 生成的圖像更加清晰,有關物體或場景的細節更豐富.在Deep-Fashion 數據集中,以往模型易生成模糊失真的圖像,ViewGAN 學會了如何生成多樣性強的服飾圖像,在服飾的圖案、人物的姿態上具有更多的語義細節.在Dayton 數據集中,ViewGAN 能夠生成更加自然的圖像,圖像中的房屋、草木和汽車都更符合實際,減輕了圖像中的人工痕跡.在ICG Lab6數據集中,ViewGAN 在面對復雜環境時仍表現出較好的性能,圖像中的桌椅、電腦等小目標都十分逼真,在清晰度方面非常接近真實圖像.

圖4 各模型在DeepFashion 數據集上的測試樣例Fig.4 Results generated by different models on DeepFashion dataset

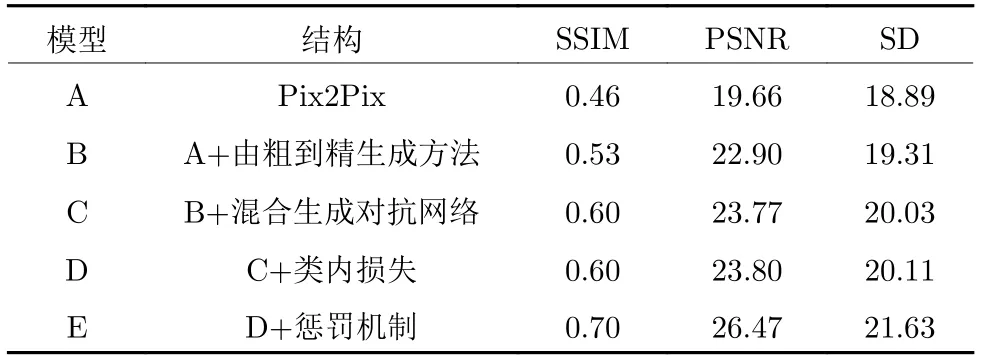

4.5 消融分析

為了分析本文模型中不同組件的功能,我們在DeepFashion 數據集上進行了消融分析實驗.實驗結果如表7 所示.由實驗結果可知:相比于模型A,模型B 的性能更好,這表明由粗到精的兩階段生成方法能夠更好地提升圖像的清晰度.模型C 的性能得到進一步的提升,這是因為本文模型采用的混合生成對抗網絡有效地擴充模型的內存容量,使得每個生成器更擅長生成指定視角的圖像.模型D 通過引入類內損失促進了每個生成器的學習,在提升系統穩定性的同時提升了圖像的質量.而模型E 的得分表明:而本文提出的懲罰機制顯著提升了模型的性能,使模型在生成過程中得到了充足的語義約束,這大大增強了合成圖像的清晰度和真實感.

表7 消融分析實驗結果Table 7 Ablations study of the proposed ViewGAN

圖5 各模型在Dayton 數據集上的測試樣例Fig.5 Results generated by different models on Dayton dataset

為進一步探索本文提出的基于蒙特卡洛搜索的懲罰機制,我們將ViewGAN 生成圖像的過程進行了可視化,如圖7 所示.從圖中可以看出,低分辨率目標圖像僅僅畫出了人物的基本輪廓,缺乏服飾的細節.而利用蒙特卡洛搜索進行多次挖掘后,提取出了不同層次的語義信息,如服飾的蕾絲邊、手臂的輪廓等,之后調用細粒度模塊將這些語義信息填補到目標圖像中,從而得到最終逼真的高分辨率目標圖像.

圖6 各模型在ICG Lab6 數據集上的測試樣例Fig.6 Results generated by different models on ICG Lab6 dataset

圖7 ViewGAN 生成圖像的可視化過程((a)輸入圖像;(b)粗粒度模塊合成的低分辨率目標圖像;(c)蒙特卡洛搜索的結果;(d)細粒度模塊合成的高分辨率目標圖像)Fig.7 Visualization of the process of ViewGAN generating images ((a) The input image;(b) The LR image generated by coarse image module;(c) Intermediate results generated by Monte Carlo search module;(d) The HR image generated by fine image module)

5 總結與未來方向

本文提出了一種多視角圖像生成模型ViewGAN,它可基于不同視角的圖像合成新視角的圖像.模型首先利用粗粒度模塊生成低分辨率目標圖像,之后利用蒙特卡洛搜索挖掘中間結果的語義信息,細粒度模塊基于搜索結果合成高分辨率目標圖像.在3個公開數據集DeepFashion,Dayton 和ICG Lab6上的定量實驗與定性實驗證明:相比于目前的主流模型,本文模型能夠生成更加清晰的、多樣性的目標圖像.其中消融分析實驗證明了本文提出的基于蒙塔卡羅搜索的懲罰機制顯著提升了圖像的質量.此外,本文模型可靈活遷移至多視角生成的各個場景,未來我們將進一步探索該方法在圖像風格遷移、圖像翻譯等領域的應用.